| Navigationslinks �berspringen | |

| Druckansicht beenden | |

|

Oracle Solaris 10 8/11 Installationshandbuch: Solaris Live Upgrade und Planung von Upgrades |

| Navigationslinks �berspringen | |

| Druckansicht beenden | |

|

Oracle Solaris 10 8/11 Installationshandbuch: Solaris Live Upgrade und Planung von Upgrades |

Teil I Ausführen eines Upgrades mit Solaris Live Upgrade

1. Informationen zur Planung einer Solaris-Installation

2. Solaris Live Upgrade (Übersicht)

3. Solaris Live Upgrade (Planung)

4. Erstellen einer Boot-Umgebung mit Solaris Live Upgrade (Vorgehen)

5. Ausführen eines Upgrades mit Solaris Live Upgrade (Vorgehen)

6. Wiederherstellen nach Fehler: Zurückgreifen auf die ursprüngliche Boot-Umgebung (Vorgehen)

7. Verwalten von Solaris Live Upgrade-Boot-Umgebungen (Vorgehen)

9. Solaris Live Upgrade (Beispiele)

10. Solaris Live Upgrade (Befehlsreferenz)

11. Solaris Live Upgrade und ZFS (Überblick)

Neuerungen bei Oracle Solaris 10 8/11

Neuerungen bei Oracle Solaris 10 10/09

Einführung in die Verwendung von Solaris Live Upgrade mit ZFS

Migration von einem UFS-Dateisystem auf einen ZFS-Root-Pool

Migration von einem UFS-Root-Dateisystem (/) auf einen ZFS-Root-Pool

Erstellen einer neuen Boot-Umgebung aus einem ZFS-Root-Pool

Erstellen einer neuen Boot-Umgebung innerhalb des gleichen Root-Pools

Erstellen einer neuen Boot-Umgebung in einem anderen Root-Pool

Erstellen einer neuen Boot-Umgebung von einem anderen System als dem aktuell laufenden System

Erstellen einer ZFS-Boot-Umgebung auf einem System mit installierten nicht-globalen Zonen

12. Solaris Live Upgrade für ZFS (Planung)

13. Erstellen einer Boot-Umgebung für ZFS-Root-Pools

14. Solaris Live Upgrade für ZFS mit installierten nicht-globalen Zonen

B. Zusätzliche SVR4-Packaging-Anforderungen (Referenz)

C. Verwenden des Patch Analyzers beim Durchführen von Upgrades (Vorgehen)

Wenn Sie vom aktuell laufenden System eine Boot-Umgebung erstellen, kopiert der Befehl lucreate das UFS-Root-Dateisystem (/) in einen ZFS-Root-Pool. Je nach System kann der Kopiervorgang einige Zeit in Anspruch nehmen.

Bei der Migration von einem UFS-Dateisystem kann die Quell-Boot-Umgebung ein UFS-Root-Dateisystem (/) auf einem Festplattenbereich sein. Boot-Umgebungen können nicht auf UFS-Dateisystemen von einer Quell-Boot-Umgebung auf einem ZFS-Root-Pool erstellt werden.

Die folgenden Befehle erstellen einen ZFS-Root-Pool und eine neue Boot-Umgebung von einem UFS-Root-Dateisystem (/) in einem ZFS-Root-Pool. Vor der Ausführung des Befehls lucreate muss ein ZFS-Root-Pool vorhanden und mit Bereichen statt auf einer gesamten Festplatte erstellt worden sein, damit es upgrade- und bootfähig ist. Die Festplatte darf kein EFI-Label, sondern muss ein SMI-Label haben. Weitere Einschränkungen sind in Systemvoraussetzungen und Einschränkungen für die Verwendung von Solaris Live Upgrade beschrieben.

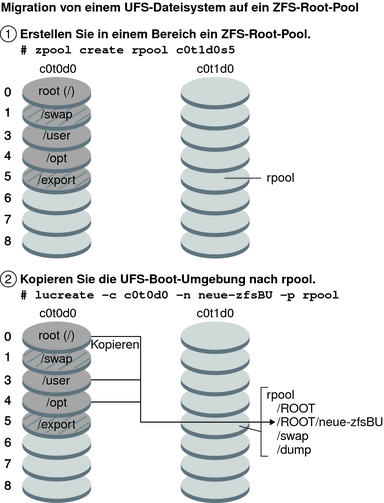

Abbildung 11-1 zeigt den Befehl zpool, der den Root-Pool rpool auf dem separaten Bereich c0t1d0s5 erstellt. Der Festplattenbereich c0t0d0s0 enthält ein UFS-Root-Dateisystem (/). Im Befehl lucreate gibt die Option -c das aktuell laufende System (c0t0d0 ) an, das ein UFS-Root-Dateisystem (/) ist. Die Option -n weist der neu zu erstellenden Boot-Umgebung den Namen neue-zfsBU zu. Die Option -p legt fest, wo die neue Boot-Umgebung rpool angelegt werden soll. Das UFS-Dateisystem /export und das Volume /swap werden nicht in die neue Boot-Umgebung kopiert.

Abbildung 11-1 Migration von einem UFS-Dateisystem auf einen ZFS-Root-Pool

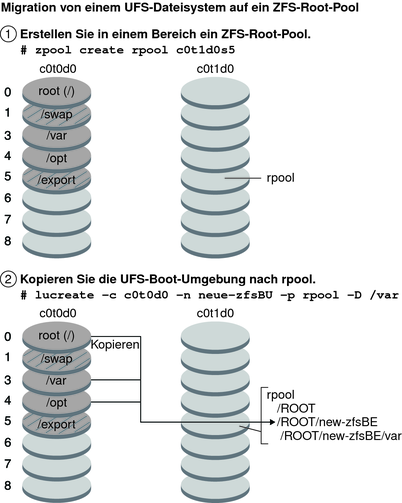

Um ein separates Dataset für /var in einer alternativen Boot-Umgebung zu erstellen, verwenden Sie die Option -D des Befehls lucreate.

lucreate -c c0t0d0 -n new-zfsBE -p rpool -D /var

Das folgende Diagramm zeigt die Datasets, die in diesem Beispiel für den Befehl lucreate in rpool erstellt werden.

Abbildung 11-2 Migration von einem UFS-Dateisystem auf einen ZFS-Root-Pool

Wenn Sie den Befehl lucreate ohne die Option -D /var angeben, wird kein separates Dataset für /var in der alternativen Boot-Umgebung erstellt, auch wenn /var ein separates Dateisystem in der Quell-Boot-Umgebung ist.

Beispiel 11-1 Migration von einem UFS-Root-Dateisystem (/) auf einen ZFS-Root-Pool

Dieses Beispiel zeigt die gleichen Befehle wie in Abbildung 11-1. Diese Befehle erstellen den neuen Root-Pool rpool und legen in diesem Pool eine neue Boot-Umgebung von einem UFS-Root-Dateisystem (/) an. In diesem Beispiel zeigt der Befehl zfs list den mit dem Befehl zpool erstellten ZFS-Root-Pool an. Der nächste Befehl zfs list zeigt die vom Befehl lucreate erstellten Datasets an.

# zpool create rpool c0t1d0s5 # zfs list NAME USED AVAIL REFER MOUNTPOINT rpool 5.97G 23.3G 31K /rpool

# lucreate -c c0t0d0 -n new-zfsBE -p rpool # zfs list NAME USED AVAIL REFER MOUNTPOINT rpool 5.97G 23.3G 31K /rpool rpool/ROOT 4.42G 23.3G 31K legacy rpool/ROOT/new-zfsBE 4.42G 23.3G 4.42G / rpool/dump 1.03G 24.3G 16K - rpool/swap 530M 23.8G 16K -

Der folgende Befehl zfs list zeigt das separate Dataset an, das für /var mithilfe des Befehls lucreate und der Option -D /var erstellt wurde.

# lucreate -c c0t0d0 -n new-zfsBE -p rpool -D /var # zfs list NAME USED AVAIL REFER MOUNTPOINT rpool 5.97G 23.3G 31K /rpool rpool/ROOT 4.42G 23.3G 31K legacy rpool/ROOT/new-zfsBE 4.42G 23.3G 4.42G / rpool/ROOT/new-zfsBE/var 248MG 23.3G 248M /var rpool/dump 1.03G 24.3G 16K - rpool/swap 530M 23.8G 16K -

Die neue Boot-Umgebung ist new-zfsBE. Die Boot-Umgebung neue-zfsBU kann jetzt aktualisiert und aktiviert werden.

Sie können ein UFS-Dateisystem migrieren, wenn auf Ihrem System Solaris Volume Manager-Volumes (SVM) vorhanden sind. Um eine UFS-Boot-Umgebung aus einer vorhandenen SVM-Konfiguration zu erstellen, müssen Sie zunächst aus dem aktuell laufenden System eine neue Boot-Umgebung erstellen. Dann können Sie die ZFS-Boot-Umgebung aus der neuen UFS-Boot-Umgebung erstellen.

Überblick über Solaris Volume Manager (SVM). ZFS nutzt zur Verwaltung physischer Datenträger das Konzept von Speicherpools. Früher setzten Dateisysteme auf einem einzigen physischen Datenträger auf. Damit mehrere Datenträger adressiert werden können und Datenredundanz erreicht wird, wurde das Konzept des Volume Managers eingeführt, der ein „Abbild“ eines einzigen Datenträgers ermöglicht. So mussten Dateisysteme nicht modifiziert werden, damit sie die Vorteile mehrerer Datenträger nutzen können. Dieses Design fügte jedoch eine weitere Komplexitätsebene hinzu. Diese Komplexität verhinderte letztendlich die Nutzung bestimmter Dateisystemweiterentwicklungen, da ein Dateisystem keine Kontrolle über die physische Speicherung von Daten auf virtualisierten Volumes·hatte.

ZFS-Speicherpools lösen SVM ab. Mit ZFS wird die Notwendigkeit der Verwaltung von Datenträgern komplett eliminiert. Sie müssen bei ZFS keine virtualisierte Volumen·erstellen, sondern Datenträger werden in einem Speicherpool gruppiert. Der Speicherpool beschreibt die physischen Eigenschaften von Datenträgerstruktur und Datenredundanz und dient als flexible·Datenablage, aus der Dateisysteme erstellt werden können. Dateisysteme sind nicht mehr an einzelne Datenträger gebunden, sodass sie Speicherplatz gemeinsam mit allen Dateisystemen im Pool nutzen können. Sie müssen die Größe eines Dateisystems nicht mehr vorher festlegen, da Dateisysteme im Rahmen des dem Pool zugewiesenen Speicherplatzes·automatisch vergrößert werden können. Wenn ein Pool um neuen Speicherplatz erweitert wird, können alle Dateisysteme dieses Pools diesen neuen Speicherplatz sofort nutzen, ohne dass dafür Konfigurationen geändert werden müssen. Ein Speicherpool verhält sich in vielerlei Hinsicht wie ein virtuelles Speichersystem. Wenn ein System um neue DIMM-Speicherchips erweitert wird, brauchen Sie auf Betriebssystemebene keine Befehle einzugeben, mit denen dieser neue Speicher konfiguriert und zu einzelnen Prozessen zugewiesen werden muss. Alle Prozesse im System nutzen automatisch den zusätzlichen Speicher.

Beispiel 11-2 Migration von einem UFS-Root-Dateisystem (/) mit SVM-Volumes auf einen ZFS-Root-Pool

Bei der Migration eines Systems mit SVM-Volumes werden die SVM-Volumes ignoriert. Sie können im Root-Pool Mirrors einrichten (siehe folgendes Beispiel).

In diesem Beispiel erstellt der Befehl lucreate mit der Option -m aus dem aktuell laufenden System eine neue Boot-Umgebung. Der Festplattenbereich c1t0d0s0 enthält ein mit SVM-Volumes konfiguriertes UFS-Root-Dateisystem ( /). Der Befehl zpool erstellt den Root-Pool c1t0d0s0 und das RAID-1-Volume c2t0d0s0 (Mirror). Im zweiten lucreate-Befehl weist die Option -n der neu zu erstellenden Boot-Umgebung den Namen neuer-zfsBU-Name zu. Die Option -s identifiziert das Dateisystem UFS-Root (/). Die Option -p legt fest, wo die neue Boot-Umgebung rpool angelegt werden soll.

# lucreate -n ufsBE -m /:/dev/md/dsk/d104:ufs # zpool create rpool mirror c1t0d0s0 c2t1d0s0 # lucreate -n c0t0d0s0 -s ufsBE -p zpool

Die Boot-Umgebung c0t0d0s0 kann jetzt aktualisiert und aktiviert werden.