| ナビゲーションリンクをスキップ | |

| 印刷ビューの終了 | |

|

Oracle Solaris 10 8/11 インストールガイド (Solaris Live Upgrade とアップグレードの計画) Oracle Solaris 10 8/11 Information Library (日本語) |

| ナビゲーションリンクをスキップ | |

| 印刷ビューの終了 | |

|

Oracle Solaris 10 8/11 インストールガイド (Solaris Live Upgrade とアップグレードの計画) Oracle Solaris 10 8/11 Information Library (日本語) |

パート I Solaris Live Upgrade によるアップグレード

4. Solaris Live Upgrade によるブート環境の作成 (作業)

5. Solaris Live Upgrade によるアップグレード (作業)

6. 障害回復: 元のブート環境へのフォールバック (作業)

7. Solaris Live Upgrade ブート環境の管理 (作業)

8. 非大域ゾーンがインストールされているシステムにおける Oracle Solaris OS のアップグレード

Solaris Live Upgrade によるアップグレードの例

Solaris Live Upgrade を使用するための準備

既存のボリュームから Solaris ボリュームマネージャー RAID-1 ボリュームへ移行する例

空のブート環境を作成して Solaris フラッシュアーカイブをインストールする例

新しいブート環境へ Solaris フラッシュアーカイブをインストールする方法

10. Solaris Live Upgrade (コマンドリファレンス)

パート II Solaris Live Upgrade を使った ZFS ルートプールのアップグレードと ZFS ルートプールへの移行

11. Solaris Live Upgrade と ZFS (概要)

12. ZFS の Solaris Live Upgrade (計画)

新しいブート環境に RAID-1 ボリューム (ミラー) を作成します

ミラーの一方を切り離し、アップグレードします

ミラー (連結) の他方を新しいミラーに接続します

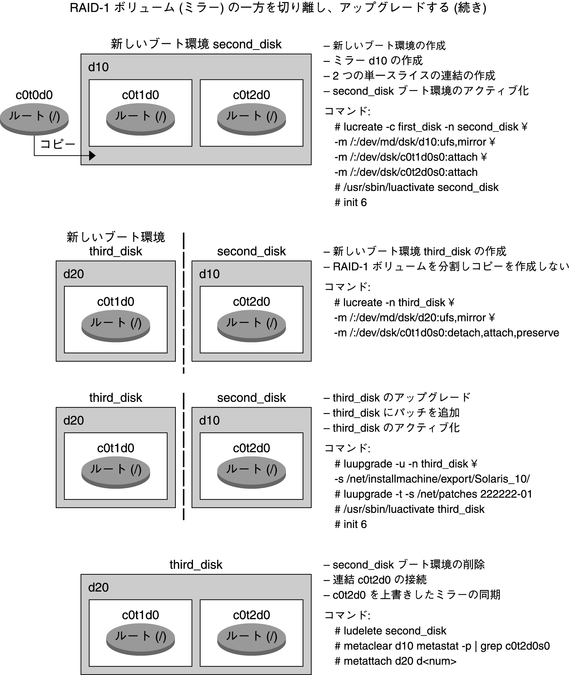

図 9-1 は、3 つの物理ディスクから成る現在のブート環境を示します。

図 9-1 RAID-1 ボリューム (ミラー) の一方を切り離し、アップグレードする

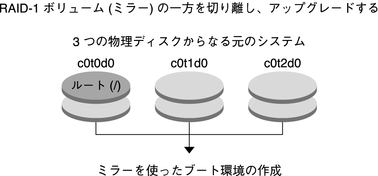

ミラーを持つ新しいブート環境 second_disk を作成します。

次のコマンドは、次のような処理を実行します。

lucreate コマンドにより、ルート (/) マウントポイントの UFS ファイルシステムが構成されます。d10 というミラーが作成されます。このミラー d10 に、現在のブート環境のルート (/) ファイルシステムがコピーされます。ミラー d10 にあるデータはすべて上書きされます。

2 つのスライス c0t1d0s0 および c0t2d0s0 は、サブミラーとして指定されています。これら 2 つのサブミラーは、ミラー d10 に接続されます。

# lucreate -c first_disk -n second_disk \ -m /:/dev/md/dsk/d10:ufs,mirror \ -m /:/dev/dsk/c0t1d0s0:attach \ -m /:/dev/dsk/c0t2d0s0:attach

ブート環境 second_disk をアクティブにします。

# /sbin/luactivate second_disk # init 6

別のブート環境 third_disk を作成します。

次のコマンドは、次のような処理を実行します。

lucreate コマンドにより、ルート (/) マウントポイントの UFS ファイルシステムが構成されます。d20 というミラーが作成されます。

スライス c0t1d0s0 が現在のミラーから切り離され、ミラー d20 に追加されます。このサブミラーの内容であるルート (/) ファイルシステムは保持され、コピー処理は発生しません。

# lucreate -n third_disk \ -m /:/dev/md/dsk/d20:ufs,mirror \ -m /:/dev/dsk/c0t1d0s0:detach,attach,preserve

新しいブート環境 third_disk をアップグレードします。

# luupgrade -u -n third_disk \ -s /net/installmachine/export/Solaris_10/OS_image

アップグレードされたブート環境にパッチを追加します。

# luupgrade -t n third_disk -s /net/patches 222222-01

ブート環境 third_disk をアクティブにして、このブート環境からシステムを実行します。

# /sbin/luactivate third_disk # init 6

ブート環境 second_disk を削除します。

# ludelete second_disk

次のコマンドは、次のような処理を実行します。

ミラー d10 を消去します。

c0t2d0s0 の連結の数を調べます。

metastat コマンドで見つけた連結を、ミラー d20 に接続します。metattach コマンドは、新しく接続した連結と、ミラー d20 の連結とを同期します。連結にあるデータはすべて上書きされます。

# metaclear d10 # metastat -p | grep c0t2d0s0 dnum 1 1 c0t2d0s0 # metattach d20 dnum

metastat コマンドで見つかった連結の数。

これで、新しいブート環境 third_disk がアップグレードされ、この環境からシステムが実行されます。third_disk には、ミラー化されたルート (/) ファイルシステムが含まれています。

図 9-2 は、前の例のコマンドでミラーを切り離してアップグレードする手順の全体を示しています。

図 9-2 RAID-1 ボリューム (ミラー) の一方を切り離し、アップグレードする (続き)