7 Instalación y configuración de ACSLS HA 8.4

El paquete SUNWscacsls contiene un software de agentes ACSLS que se comunica con Oracle Solaris Cluster. Incluye parches y archivos de configuraciones especiales que garantizan la operación adecuada entre ACSLS y Solaris Cluster.

Procedimiento de instalación básico

-

Descomprima el archivo descargado

SUNWscacsls.zipen /opt.# cd /opt # unzip SUNWscacsls.zip

-

Instale el paquete

SUNWscacsls.# pkgadd -d .

-

Repita los pasos 1 y 2 en el nodo adyacente.

-

Verifique que

acslspoolpermanezca montado en uno de los dos nodos.# zpool status acslspool

Si

acslspoolno está montado, revise el otro nodo.Si

acslspoolno está montado en ningún nodo, impórtelo en el nodo actual de la siguiente manera:# zpool import -f acslspool

Verifíquelo con

zpool status. -

Vaya al directorio

/opt/ACSLSHA/utilen el nodo que poseeacslspooly ejecute la secuencia de comandoscopyUtils.sh. Esta operación actualiza o copia los archivos esenciales en ubicaciones adecuadas en ambos nodos. No es necesario repetir esta operación en el nodo adyacente.# cd /opt/ACSLSHA/util # ./copyUtils.sh

-

En el nodo donde

acslspoolestá activo, como usuarioacsss, inicie la aplicación ACSLS (acsssenable) y verifique que esté en funcionamiento. Resuelva los problemas que encuentre. Los problemas principales se pueden resolver mediante la eliminación y la reinstalación del paquete STKacsls en el nodo.Si debe volver a instalar el paquete STKacsls, ejecute la secuencia de comandos

/opt/ACSLSHA/util/copyUtils.shdespués de instalar el paquete. -

Cierre

acsls.# su - acsss $ acsss shutdown $ exit #

-

Exporte

acslspooldel nodo activo.# zpool export acslspool

Nota:

Esta operación falla si el usuarioacsssha iniciado sesión, si hay un shell de usuario activo en algún lugar deacslspoolo si algún servicioacssscontinúa activo. -

Importe

acslspooldel nodo adyacente.# zpool import acslspool

-

Inicie la aplicación ACSLS en este nodo y verifique la operación correcta de la biblioteca. Resuelva los problemas que encuentre. Los problemas principales se pueden resolver mediante la eliminación y la reinstalación del paquete STKacsls en el nodo.

Si debe volver a instalar el paquete STKacsls, ejecute la secuencia de comandos

/opt/ACSLSHA/util/copyUtils.shdespués de instalar el paquete.

Configuración de ACSLS HA

Este paso crea tres recursos ACSLS que, luego, gestiona y controla Solaris Cluster:

-

acsls-rses la aplicación ACSLS en sí. -

acsls-storagees el sistema de archivos ZFS en el cual reside ACSLS. -

<logical host>es la dirección IP virtual (la identidad de red común para ambos nodos). Consulte Configuración de archivo /etc/hosts.

Una vez que estos controles de recursos se crean, se asignan a un grupo de recursos común con el nombre acsls-rg.

Para configurar estos recursos, primero, verifique que acslspool esté montado (zpool list) y, luego, vaya al directorio /opt/ACSLSHA/util y ejecute acsAgt configure:

# cd /opt/ACSLSHA/util # ./acsAgt configure

La utilidad solicita el nombre del host lógico. Asegúrese de que el host lógico esté definido en el archivo /etc/hosts y que las direcciones IP correspondientes estén asignadas en el grupo ipmp definido en el capítulo Configuración del sistema Solaris para ACSLS HA. Además, antes de ejecutar acsAgt configure, use zpool list para confirmar que acslspool esté montado en el nodo de servidor actual.

Este paso de configuración puede tardar un minuto o más en terminar. Una vez que los controles de recurso se han creado, la operación intenta iniciar la aplicación ACSLS.

Supervisión de la operación del cluster de ACSLS

Hay varios puntos de vista desde los cuales se puede analizar la operación del cluster de ACSLS. Cuando Solaris Cluster sondea la aplicación ACSLS a cada minuto, puede resultar útil ver los resultados de los sondeos a medida que se obtienen. Cuando un sondeo devuelve un estado que dispara un evento de switchover del nodo, resulta útil ver la actividad de cierre en un nodo y la actividad de inicio en el nodo adyacente. En general, resulta útil tener una vista del estado operativo de la aplicación ACSLS a lo largo del tiempo.

El punto de vista operativo principal corresponde a la perspectiva de ACSLS. El final del archivo acsss_event.log puede brindar la mejor indicación del estado general del sistema en todo momento.

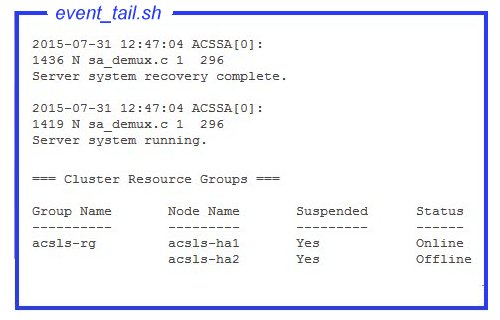

La herramienta event_tail.sh en el directorio /opt/ACSLSHA/util/ brinda acceso directo a acsss_event.log desde cualquier nodo. La vista que se obtiene desde esta herramienta permanece activa, incluso cuando el control conmuta de un nodo a otro. Esta herramienta no solo realiza un seguimiento dinámico de la actividad normal de ACSLS, sino también de todos los cambios de estado del grupo de recursos del cluster de ACSLS (acsls-rg) y, de esa manera, permite obtener una vista en tiempo real del momento en el que un nodo se desconecta y el otro se conecta. Confirme esta herramienta desde el shell, como se muestra a continuación:

# /opt/ACSLSHA/util/event_tail.sh

Para ver la actividad de inicio y detención desde la perspectiva de un solo nodo, consulte start_stop_log desde ese nodo, como se muestra a continuación:

# tail -f /opt/ACSLSHA/log/start_stop_log

Para ver los resultados de los sondeos periódicos en el nodo activo:

# tail -f /opt/ACSLSHA/log/probe_log

El agente de Solaris Cluster y del cluster de ACSLS envía detalles de los eventos importantes al log del sistema Solaris (var/adm/messages). Para ver el log del sistema en un nodo determinado, se proporciona un enlace en el directorio /opt/ACSLSHA/log:

# tail -f /opt/ACSLSHA/log/messages

Utilidad ha_console.sh

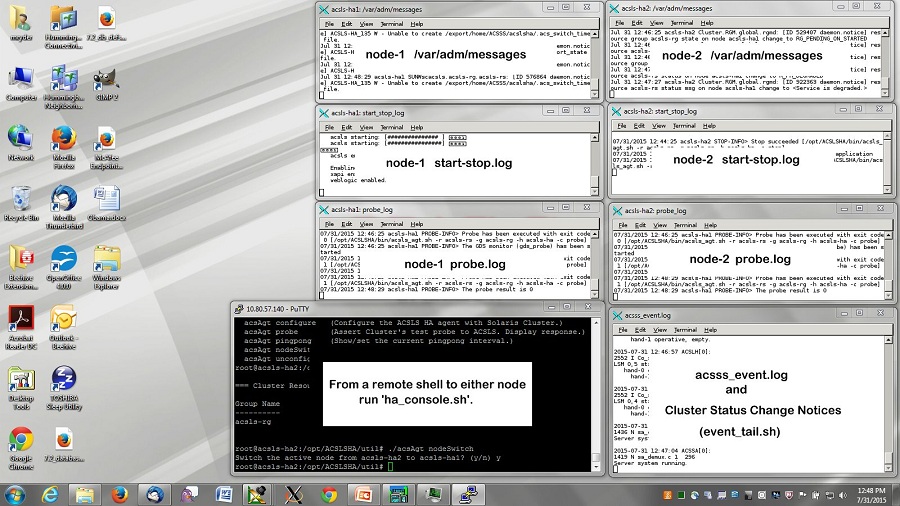

Dados los diferentes puntos de vista de una configuración en cluster y la migración del control del cluster de un nodo al otro a lo largo del tiempo, seguir la actividad operativa del sistema en todo momento desde una única perspectiva puede ser un verdadero desafío. La utilidad ha_console.sh permite ofrecer con más facilidad una vista completa.

Inicie sesión en cada nodo del sistema ACSLS HA desde el escritorio remoto y ejecute

ha_console.shwho am i) para determinar dónde enviar DISPLAY. Para ver la pantalla, inicie sesión directamente desde la consola local o el sistema del escritorio en el nodo HA. Si se presenta algún problema, busque los mensajes en gnome-terminal.log en el directorio /opt/ACSLSHA/log.

# /opt/ACSLSHA/util/ha_console.sh

Esta utilidad supervisa todos los logs mencionados en esta sección desde ambos nodos. Inicia siete ventanas de terminal Gnome en la pantalla de la consola local. Puede resultar útil organizar las ventanas en la pantalla de la siguiente manera:

En una sola pantalla del terminal, se muestra una vista completa de todo el complejo de clusters ACSLS.

Dado que el sistema remoto envía datos de la pantalla a la pantalla local, abra el acceso X-11 en el sistema local. En el caso de los sistemas UNIX, el comando que permite realizar esto es xhost +. En un sistema Windows, se debe instalar un software cliente X-11, como xming o exceed.

Si tiene alguna dificultad para usar ha_console.sh, se pueden abrir varias sesiones de inicio de sesión desde el sistema local en cada nodo para ver los diferentes logs mencionados en esta sección.

Verificación de la operación del cluster

-

Cuando

acslshase haya iniciado y se haya registrado en Solaris Cluster, utilice los comandos del cluster para comprobar el estado del grupo de recursos ACSLS y sus recursos asociados.# clrg status === Cluster Resource Groups === Group Name Node Name Suspended Status ---------- --------- --------- ------ acsls-rg node1 No Online node2 No Offline # clrs status === Cluster Resources === Resource Name Node Name State Status Message ------------- --------- ----- -------------- acsls-rs node1 Online Online node2 Offline Offline acsls-storage node1 Online Online node2 Offline Offline <logical host> node1 Online Online node2 Offline Offline -

Suspenda de manera temporal la preparación de failover del cluster para facilitar las pruebas iniciales.

# clrg suspend acsls-rg # clrg status

-

Pruebe la operación de conmutación del cluster del nodo activo al nodo en espera.

# cd /opt/ACSLSHA/util # ./acsAgt nodeSwitch

La actividad de switchover se puede supervisar desde varias perspectivas mediante los procedimientos descritos en la sección anterior.

-

Verifique la conectividad de red del sistema cliente ACSLS mediante el nombre de host lógico del servidor ACSLS.

# ping acsls_logical_host # ssh root@acsls_logical_host hostname passwd:

Esta operación debe devolver el nombre de host del nodo activo.

-

Verifique la operación de ACSLS.

# su acsss $ acsss status

-

Repita los pasos 3, 4 y 5 del nodo opuesto.

-

Reanude la preparación de failover del cluster.

# clrg resume acsls-rg # clrg status

-

La siguiente serie de pruebas incluye la verificación del comportamiento de failover del nodo.

Para ejecutar varios escenarios de failover en secuencia, reduzca el intervalo de pingpong por defecto de veinte minutos a cinco minutos. (Para obtener más información, consulte el capítulo Ajuste de ACSLS HA). Para realizar pruebas, es conveniente reducir la configuración por defecto.

Para cambiar el intervalo de pingpong, vaya al directorio

/opt/ACSLSHA/utily ejecuteacsAgt pingpong.# ./acsAgt pingpong Pingpong_interval current value: 1200 seconds. desired value: [1200] 300 Pingpong_interval : 300 seconds

-

Reinicie el nodo activo y supervise la operación desde las dos consolas del sistema y desde los puntos de vista sugeridos en Supervisión de la operación del cluster de ACSLS. Verifique la operación de failover automática en el nodo en espera.

-

Verifique el acceso de red al host lógico desde el sistema cliente como se indica en el paso 4.

-

Cuando la operación de ACSLS esté activa en el nuevo nodo, reinicie el nodo y observe la acción de failover en el nodo opuesto.

Si se supervisa la operación mediante

ha_console.sh, se puede ver que las ventanas asociadas con el nodo que se reinicia desaparecen. Cuando el nodo esté nuevamente activo, ejecute el comandoha_console.shuna vez más en alguno de los nodos para restaurar las ventanas del nodo recién reiniciado. -

Repita la verificación de la red como se indica en el paso 4.

En Operación del cluster de ACSLS, se proporciona un conjunto completo de escenarios de failover. Se puede probar cualquier cantidad de estos escenarios antes de colocar el sistema ACSLS HA en producción. Antes de regresar el sistema a producción, restaure la configuración recomendada del intervalo de pingpong para evitar que la actividad de failover se repita constantemente.