Lineare Regression

Die Durchschnitts- und Höchstwerte befinden sich je nach globalem Zeitkontext entweder über täglichen oder stündlichen Rohdaten, wobei Folgendes gilt: Stündliche Aggregate werden verwendet, wenn der Zeitraum innerhalb der letzten sieben Tage liegt. Andernfalls werden tägliche Aggregate verwendet.

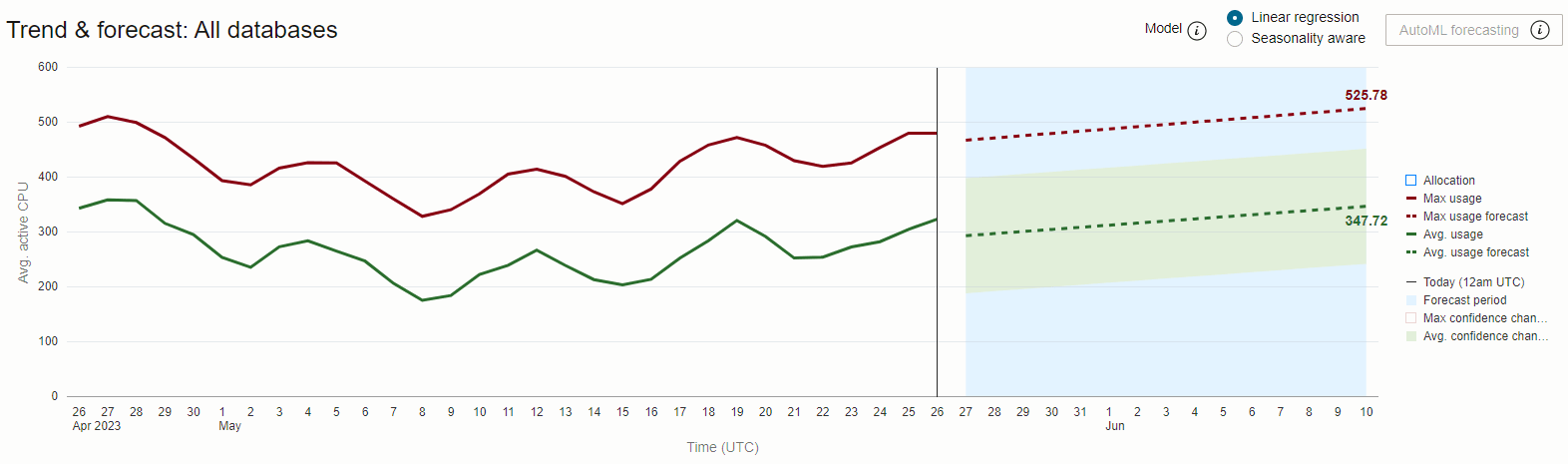

Prognoseperioden werden auf die Hälfte der Länge des Trendzeitraums festgelegt. Beispiel: 30-Tage-Trends werden 15 Tage im Voraus prognostiziert und 90-Tage-Trends 45 Tage.

Das obige Diagramm zeigt die tägliche durchschnittliche und maximale CPU-Auslastung über 30 Tage für die HR-Dev-Datenbank. Zu sehen ist eine konsistente und erhebliche Lücke zwischen den Datenreihen "Durchschn. Auslastung" und "Max. Auslastung", was auf eine hohe Variabilität des CPU-Bedarfs im Tagesverlauf hinweist.

Der Trend und die Prognose für "Max. Auslastung" sind fast deckungsgleich mit "Max. Zuweisung" für die Datenbank bzw. berühren sie. Dies weist auf das Risiko einer Kapazitätserschöpfung hin, falls der Bedarf zunimmt oder ein neuer Workload eingeführt wird.

Die Differenz zwischen "Max. Auslastung - Prognose" (~29 Durchschn. aktive CPU) und "Durchschn. Auslastung - Prognose" (~15 Durchschn. aktive CPU) gibt hier die Differenz zwischen der zur Ausführung der gesamten Arbeit erforderlichen CPU und der zur Erledigung der gesamten Arbeit tatsächlich benötigten CPU an. Wenn CPU-Ressourcen den Datenbanken fest zugewiesen sind, stellt diese Differenz die zu bezahlende Ressourcenmenge abzüglich der verwendeten Ressourcenmenge dar. Sie ist daher Opportunitätskosten, da sie durch einen sehr variablen CPU-Bedarf verursacht wird.

Eine Möglichkeit, diese unterstellten Kosten der Variabilität zu mindern, besteht darin, CPU-Ressourcen für mehrere Datenbanken freizugeben und durch eine dynamische Ressourcenzuweisung unter ihnen zu ermöglichen, auf eine sich ändernde Nachfrage zu reagieren.

Oracle Autonomous AI Database mit aktiviertem Autoscaling bietet genau eine solche Lösung.