Hinweis:

- Dieses Tutorial ist in einer von Oracle bereitgestellten kostenlosen Übungsumgebung verfügbar.

- Es verwendet Beispielwerte für Oracle Cloud Infrastructure-Zugangsdaten, -Mandanten und -Compartments. In der Übung ersetzen Sie diese Werte durch die Werte, die für Ihre Cloud-Umgebung spezifisch sind.

KI-Assistent mit Oracle Cloud Native Environment verwenden

Einführung

Oracle Cloud Native Environment-(Oracle CNE-)AI-Assistent ist ein Plug-in, das mit der Oracle CNE-Benutzeroberfläche (UI) bereitgestellt wird. AI Assistant unterstützt Benutzer bei der Verwaltung und Gewinnung von Einblicken in den Status ihres Kubernetes-Clusters in natürlicher Sprache (derzeit nur Englisch). Sie ist kontextbezogen, d.h. ihre Antworten sind für den Status des Clusters und den Speicherort in der Oracle CNE-UI relevant, wenn eine Interaktion mit dem KI-Assistenten gestartet wird. Beispiel: Wenn ein Benutzer sich nicht sicher ist, wie viele Knoten in dem Cluster vorhanden sind, fragen Sie den AI-Assistenten"Wie viele Knoten sind in meinem Cluster enthalten?", und er bestätigt die Anzahl der Knoten in dem Cluster. Weitere Prompts können gepostet werden, sodass der Benutzer einen Konversationsfluss mit dem AI-Assistenten starten kann. Zu den wichtigsten Features des AI-Assistenten gehören:

-

Conversational Kubernetes Experience: Ermöglicht sowohl erfahrenen als auch unerfahrenen Benutzern die dialogorientierte Interaktion mit dem Cluster in natürlicher Sprache, um Fragen zum Cluster zu stellen, ohne dass umfangreiche Kenntnisse über Kubernetes erforderlich sind.

-

Kontextbezogener Support: Der AI-Assistent weiß, was der Benutzer beim Senden einer Anforderung anzeigt, und gibt Antworten an, die für diesen Startkontext geeignet sind.

- Multi-Provider-Support: AI Assistant unterstützt mehrere KI-Provider (weitere Informationen finden Sie unter Upstream).

Hinweis: Sie müssen einen eigenen API-Schlüssel angeben, um auf den ausgewählten Provider zugreifen zu können.

-

Konfigurierbare Tools: Kann für die Verwendung von Kubernetes-APIs zum Abfragen von Clusterinformationen konfiguriert werden.

-

Ressourcengenerierung: Benutzer können den KI-Assistenten bitten, Kubernetes-YAML zu generieren.

- Detaillierte Analyse: Unterstützt Benutzer bei der Verwaltung des Clusters. Beispiel: Probleme diagnostizieren, Protokolle sammeln und interpretieren usw.

In diesem Tutorial wird gezeigt, wie Sie das AI Assistant-Plug-in konfigurieren, das in der Oracle CNE-UI mit einer lokal gehosteten AI-Instanz (Ollama) enthalten ist.

Ziele

In diesem Tutorial werden folgende Themen behandelt:

- Konfiguration und Verwendung des in der Oracle CNE-UI enthaltenen AI-Assistenten.

Voraussetzungen

- Installation von Oracle Cloud Native Environment

Oracle Cloud Native Environment bereitstellen

Hinweis: Wenn Sie in Ihrem eigenen Mandanten ausgeführt werden, lesen Sie das Projekt linux-virt-labs GitHub README.md, und schließen Sie die Voraussetzungen ab, bevor Sie die Übungsumgebung bereitstellen.

-

Öffnen Sie ein Terminal auf Luna Desktop.

-

Klonen Sie das Projekt

linux-virt-labsGitHub.git clone https://github.com/oracle-devrel/linux-virt-labs.git -

Wechseln Sie in das Arbeitsverzeichnis.

cd linux-virt-labs/ocne2 -

Installieren Sie die erforderlichen Sammlungen.

ansible-galaxy collection install -r requirements.yml -

Bereitstellen der Übungsumgebung.

ansible-playbook create_instance.yml -e localhost_python_interpreter="/usr/bin/python3.6" -e install_ocne_rpm=true -e create_ocne_cluster=true -e "ocne_cluster_node_options='-n 1 -w 1'"Die kostenlose Übungsumgebung erfordert die zusätzliche Variable

local_python_interpreter, dieansible_python_interpreterfür Wiedergaben festlegt, die auf localhost ausgeführt werden. Diese Variable ist erforderlich, da die Umgebung das RPM-Package für das Oracle Cloud Infrastructure-SDK für Python installiert, das sich unter den python3.6-Modulen befindet.Die Standard-Deployment-Ausprägung verwendet AMD-CPU und Oracle Linux 8. Um eine Intel CPU oder Oracle Linux 9 zu verwenden, fügen Sie dem Deployment-Befehl

-e instance_shape="VM.Standard3.Flex"oder-e os_version="9"hinzu.Wichtig: Warten Sie, bis das Playbook erfolgreich ausgeführt wird, und erreichen Sie die Unterbrechungsaufgabe. In dieser Phase des Playbooks ist die Installation der Oracle Cloud Native Environment abgeschlossen, und die Instanzen sind bereit. Notieren Sie sich die vorherige Wiedergabe, in der die öffentlichen und privaten IP-Adressen der bereitgestellten Knoten und alle anderen Deployment-Informationen gedruckt werden, die während der Ausführung der Übung erforderlich sind.

Anzahl der Knoten bestätigen

Es hilft, die Anzahl und Namen der Knoten in Ihrem Kubernetes-Cluster zu kennen.

-

Öffnen Sie ein Terminal, und verbinden Sie sich über SSH mit der OCNE-Instanz.

ssh oracle@<ip_address_of_node> -

Listen Sie die Knoten im Cluster auf.

kubectl get nodesIn der Ausgabe werden die Control-Plane und die Worker-Knoten mit dem Status

Readyzusammen mit der aktuellen Kubernetes-Version angezeigt.

Zugriffstoken erstellen

Oracle Cloud Native Environment stellt die UI mit einem Deployment und Service namens UI im Kubernetes-Cluster bereit, mit dem Sie darauf zugreifen können. Deployment und Service werden im Namespace ocne-system bereitgestellt. Um eine Verbindung zum Service herzustellen, müssen Sie ein Zugriffstoken generieren.

-

Generieren Sie ein Zugriffstoken.

kubectl --namespace ocne-system create token uiBeispielausgabe:

> [oracle@ocne ~]$ kubectl --namespace ocne-system create token ui > eyJhbGciOiJSUzI1NiIsImtpZCI6IjhfRWczUG13VWRfWjFkWDIxdkp6UUZlRzEwU2QxaExkbm9TME1CcS1rVFEifQ.eyJhdWQiOlsiaHR0cHM6Ly9rdWJlcm5ldGVzLmRlZmF1bHQuc3ZjLmNsdXN0ZXIubG9jYWwiXSwiZXhwIjoxNzI4Mzg3MTgwLCJpYXQiOjE3MjgzODM1ODAsImlzcyI6Imh0dHBzOi8va3ViZXJuZXRlcy5kZWZhdWx0LnN2Yy5jbHVzdGVyLmxvY2FsIiwianRpIjoiYzlmMWViZTctYzA1ZC00MTYxLTg2MzctOWNiZGFlNTI5MzFiIiwia3ViZXJuZXRlcy5pbyI6eyJuYW1lc3BhY2UiOiJvY25lLXN5c3RlbSIsInNlcnZpY2VhY2NvdW50Ijp7Im5hbWUiOiJ1aSIsInVpZCI6IjdjY2RjZGZlLTAzNzMtNGUwZS1hMzViLTc5MzdhM2NiZmYzMyJ9fSwibmJmIjoxNzI4MzgzNTgwLCJzdWIiOiJzeXN0ZW06c2VydmljZWFjY291bnQ6b2NuZS1zeXN0ZW06dWkifQ.WSLZFste1ggkE2GtjJ2cBrORNFgCzHOlALNXD_-6vLA9kIiDJHp44HshUcXvUFH1XdFM1SGbiCvITOwT8Y5_93IKVZLu1NRyGPZlo5l4JqwnJtqLn7J6e39OlC2SXqex6vLBCU-sBqiw_P9xksNa7fO_MzsryEo-5oMgsVVo9oJr9wv4LYLv2Obd8U5ukKjBeiRiwTu9MTK0r_GlhmZ9d7GHrYrgF1MJGMgzvqyTyviyIynD2F0OkKARIThghpEL6aou4F_DFFMy8t0qjiJG3rBTXL6fXxZ-3WxZUGdx920ZSHcqG2XOaLY7txRkKYbudIjyt-gODeR-FZCIthw5kw >Sie verwenden das angezeigte Token zur Authentifizierung, wenn Sie eine Verbindung zur UI herstellen.

Portweiterleitung zum Bereitstellen der UI erstellen

Die Portweiterleitung bietet eine schnelle und einfache Möglichkeit, den UI-Service auf Ihrem lokalen System bereitzustellen, sodass Sie damit Ihre Entwicklungsumgebung überwachen, Fehler beheben und gegebenenfalls debuggen können.

Wichtig: Oracle empfiehlt nicht, die Benutzeroberfläche für eine Produktionsumgebung mit Portweiterleitung bereitzustellen.

-

Portweiterleitung einrichten

kubectl port-forward --namespace ocne-system service/ui 8443:443Beispielausgabe:

> [oracle@ocne ~]$ kubectl port-forward --namespace ocne-system service/ui 8443:443 > Forwarding from 127.0.0.1:8443 -> 4466 > Forwarding from [::1]:8443 -> 4466 >Hinweis: Der Befehl

kubectl port-forwardwird weiterhin im Vordergrund ausgeführt. Lassen Sie es weitergehen, während Sie auf die UI zugreifen.

Ollama installieren

-

Öffnen Sie ein neues Terminal, und verbinden Sie sich über SSH mit der OCNE-Instanz.

ssh oracle@<ip_address_of_node> -

Installieren Sie eine erforderliche Abhängigkeit.

sudo dnf install -y zstd -

Installieren Sie Ollama.

curl -fsSL https://ollama.com/install.sh | sh -

Starten Sie ein Modell.

ollama run llama3.2 -

Öffnen Sie ein neues Terminal, und erstellen Sie einen SSH-Tunnel.

ssh -L 11434:127.0.0.1:11434 -L 9898:127.0.0.1:8443 oracle@<ip_address_of_node>Der Tunnel ermöglicht den Zugriff von einem Browser auf Ihrem lokalen System auf einen bestimmten Port auf das Remotesystem, auf dem das Kubernetes-Cluster ausgeführt wird. Sie müssen keinen Tunnel generieren, wenn sich beide auf demselben System befinden. Wenn Sie auf demselben System ausgeführt werden, können Sie mit

https://127.0.0.1:8443und Ollama überhttp://127.0.0.1:11434auf die UI zugreifen. -

Öffnen Sie einen Browser auf dem Luna Desktop und geben Sie die URL ein, um zu bestätigen, dass Ollama ausgeführt wird.

http://127.0.0.1:11434Der Browser sollte eine ähnliche Textnachricht anzeigen:

Ollama is running.

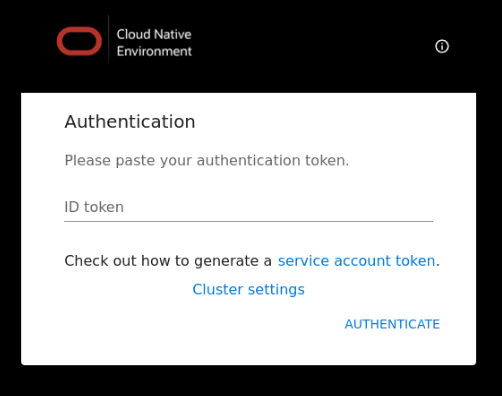

Bei der Benutzeroberfläche anmelden

-

Öffnen Sie einen Browser auf dem Luna Desktop und geben Sie die URL ein.

https://127.0.0.1:9898Genehmigen Sie die Sicherheitswarnung je nach verwendetem Browser. Klicken Sie für Chrome auf die Schaltfläche

Advancedund dann auf den LinkAccept the Risk and Continue. -

Geben Sie das Zugriffstoken an.

Geben Sie das zuvor erstellte Zugriffstoken ein, und klicken Sie auf den Link

Authenticate.

-

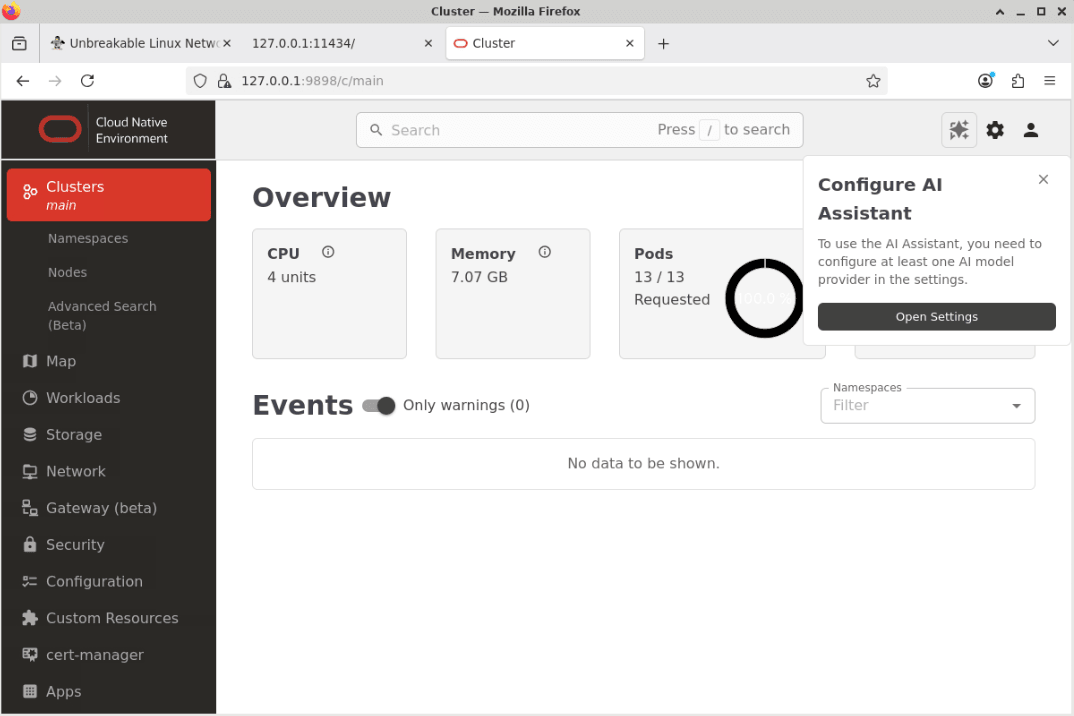

Die Seite "UI-Überblick" wird angezeigt.

Klicken Sie im Popup-Fenster KI-Assistent konfigurieren auf die Schaltfläche Einstellungen öffnen.

Hinweis: Im Abschnitt Ereignis der Landingpage werden möglicherweise einige Warnungen aufgeführt. Dieses Verhalten ist normal und wird nach einigen Minuten gelöscht.

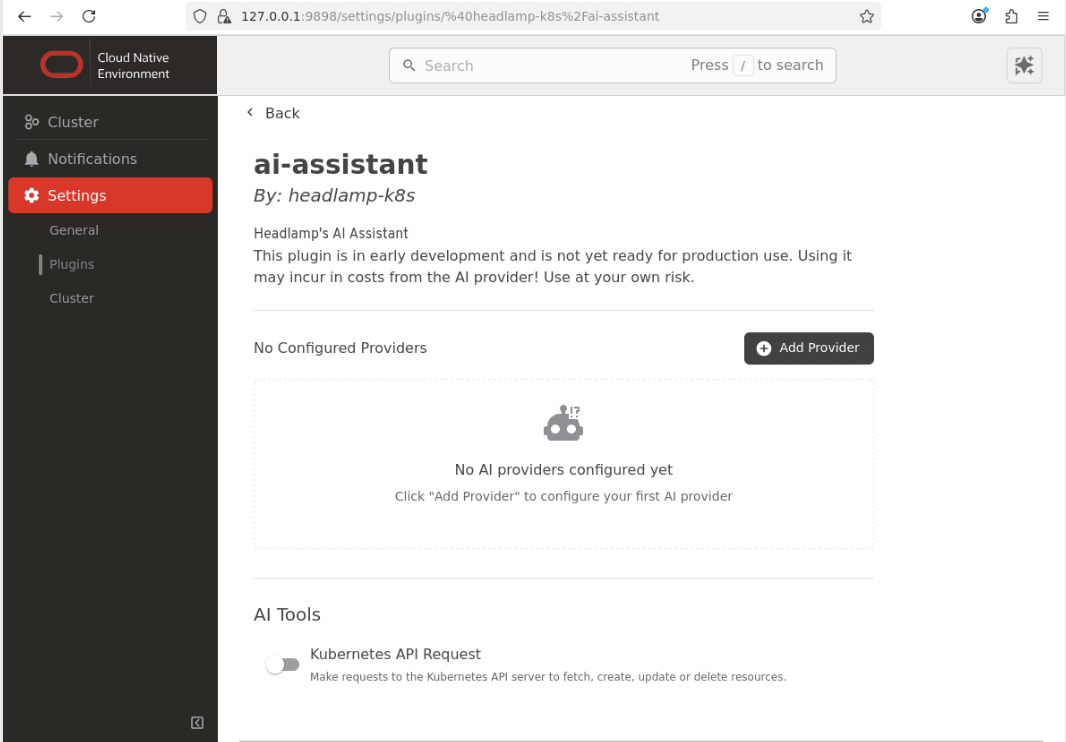

-

Dadurch wird die Konfigurationsseite für den ai-assistant im Abschnitt Einstellungen geöffnet.

Hinweis: Deaktivieren Sie die Schaltfläche Kubernetes-API-Anforderung im Abschnitt KI-Tools.

Lokalen Provider konfigurieren

-

Klicken Sie auf die Schaltfläche

Add Provider.

-

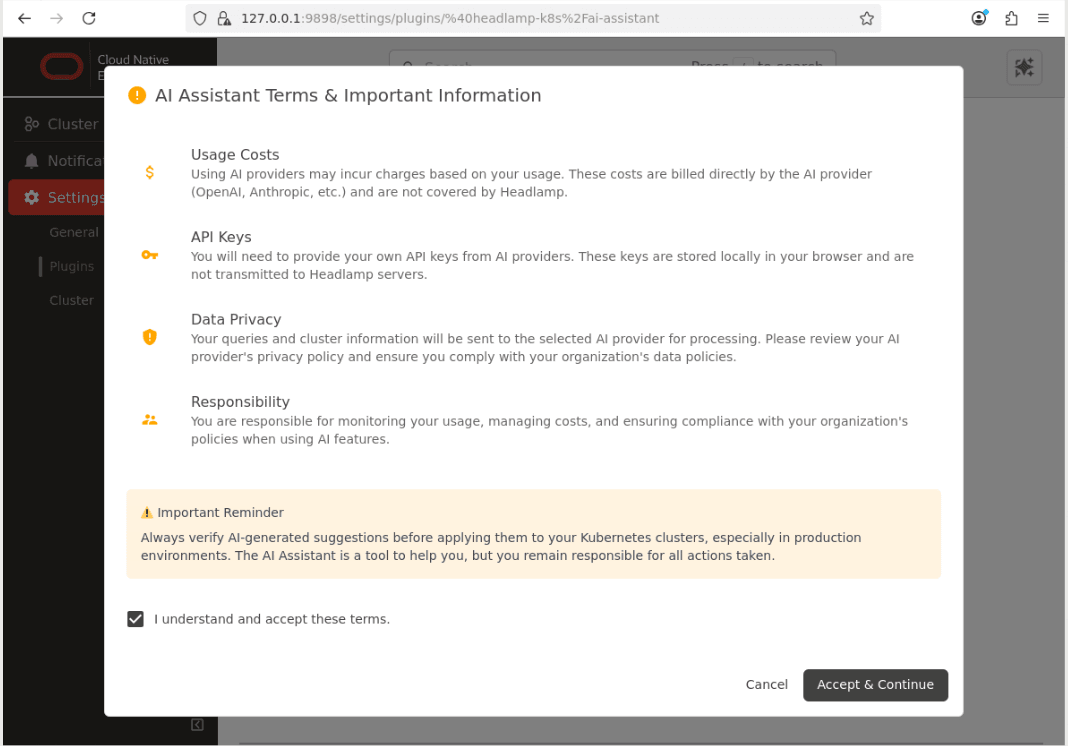

Bestätigen Sie das Dialogfeld Bedingungen und wichtige Informationen.

-

Klicken Sie auf die Menüoption

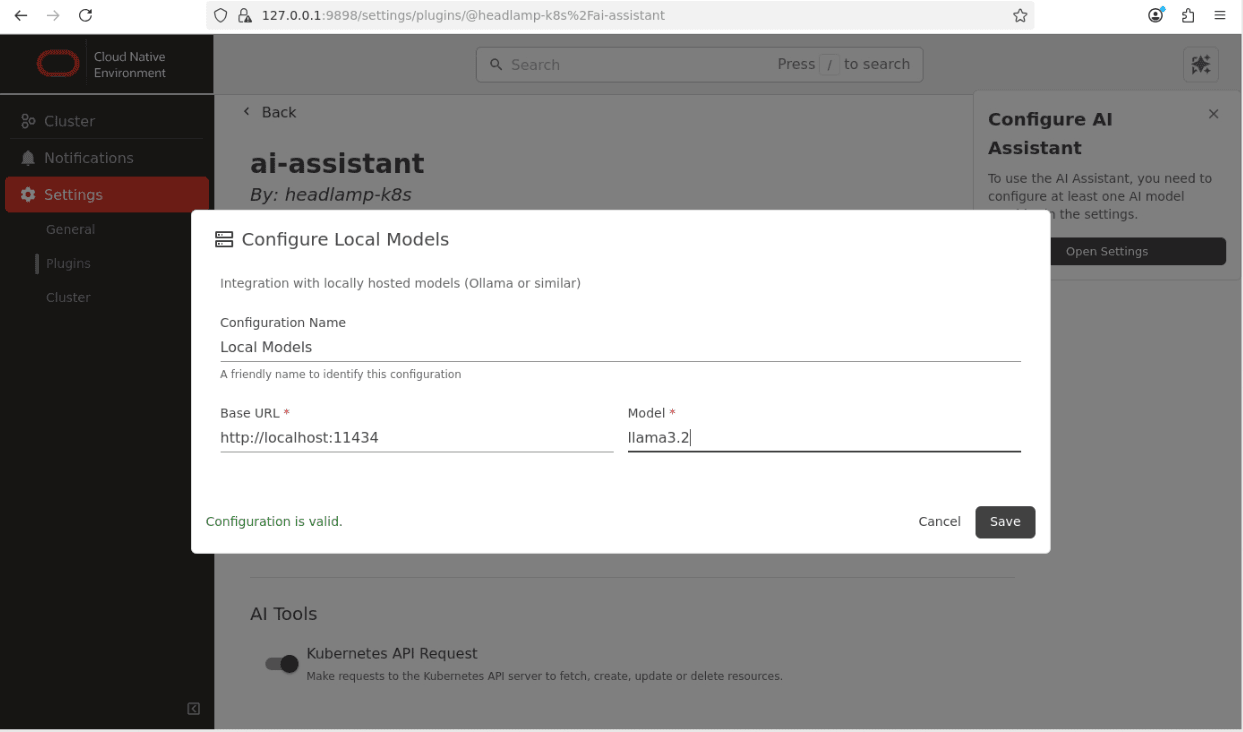

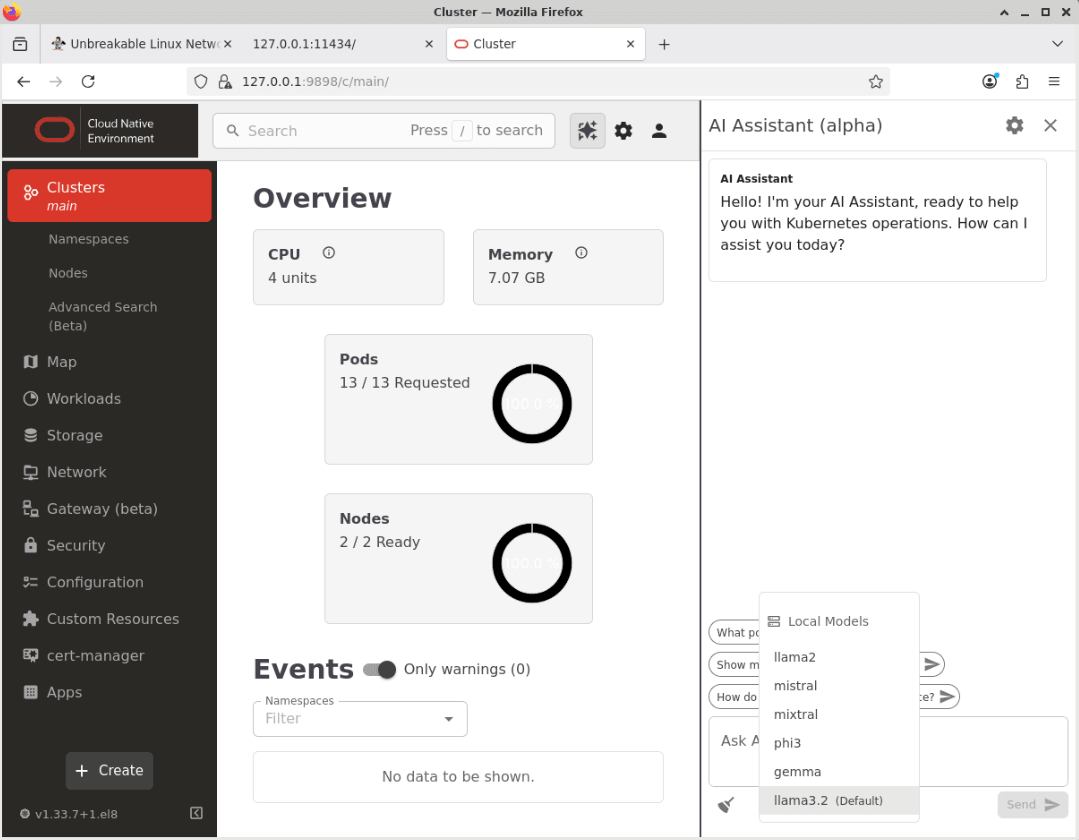

Clusterund dann auf den LinkLocal Models.

Hinweis: Geben Sie die korrekten Details für das lokale Ollama-Modell ein, das Sie verwenden. Dieses Beispiel zeigt das zuvor eingerichtete Modell

llama3.2. -

Klicken Sie auf das Symbol

Save, um die Providereinstellungen zu speichern.Der AI-Assistent ist jetzt konfiguriert und kann jetzt verwendet werden.

Bestätigen Sie, dass der AI-Assistent funktioniert.

-

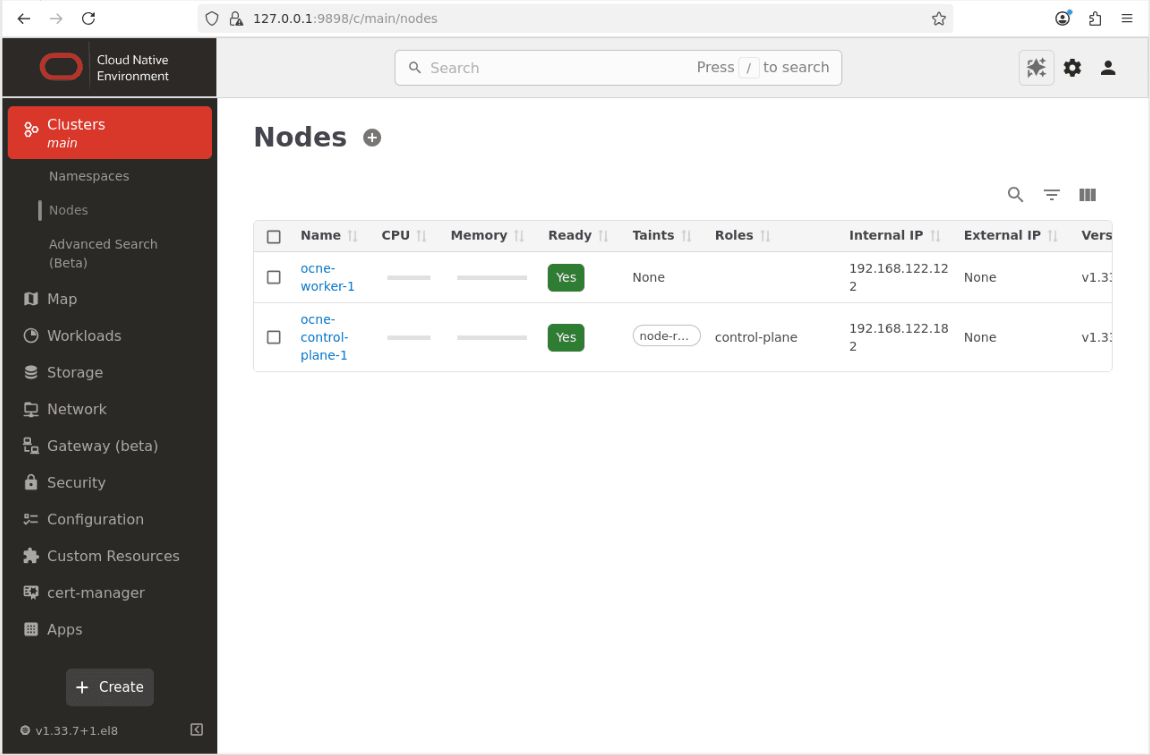

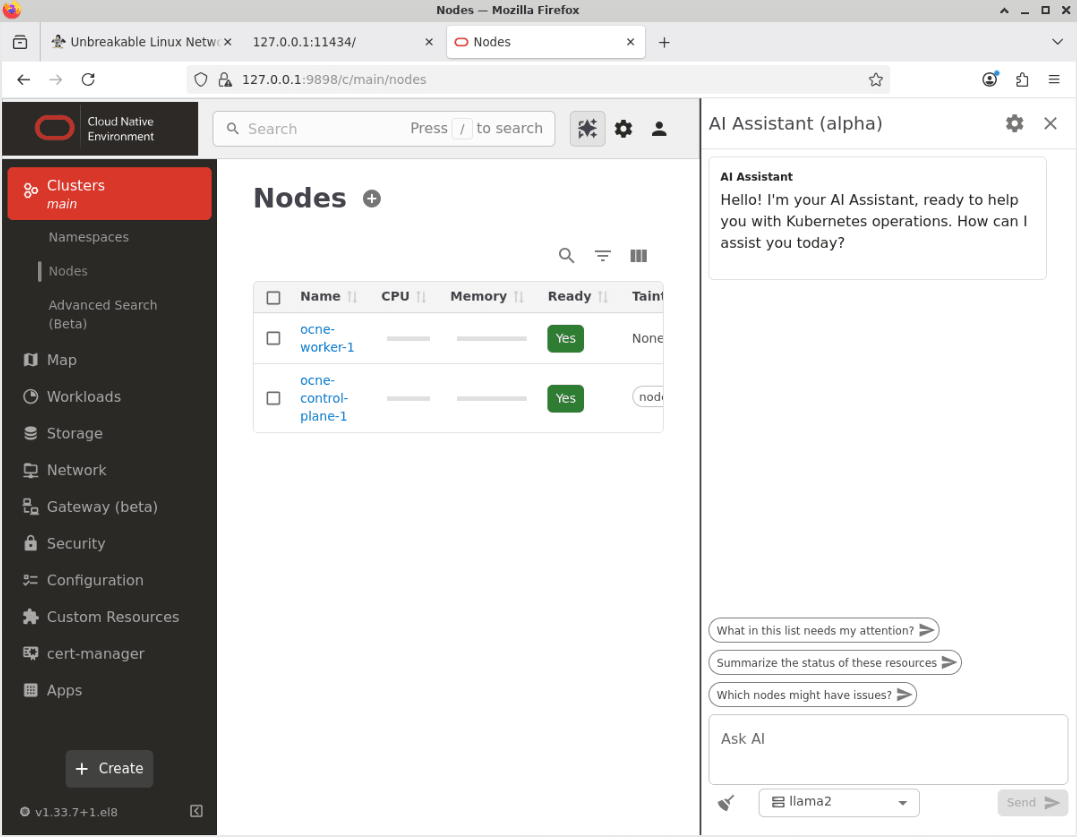

Klicken Sie auf die Menüoption Cluster und dann auf Knoten, um zur Seite Knoten zu gelangen.

-

Klicken Sie auf die Schaltfläche AI Assistant oben rechts auf dem Hauptbildschirm.

-

Das Fenster "AI-Assistent" wird angezeigt.

-

Klicken Sie auf das Dropdown-Listenfeld, um das Modell von der Standardoption (llama2) in das neu konfigurierte lokale Modell (llama3.2) zu ändern.

-

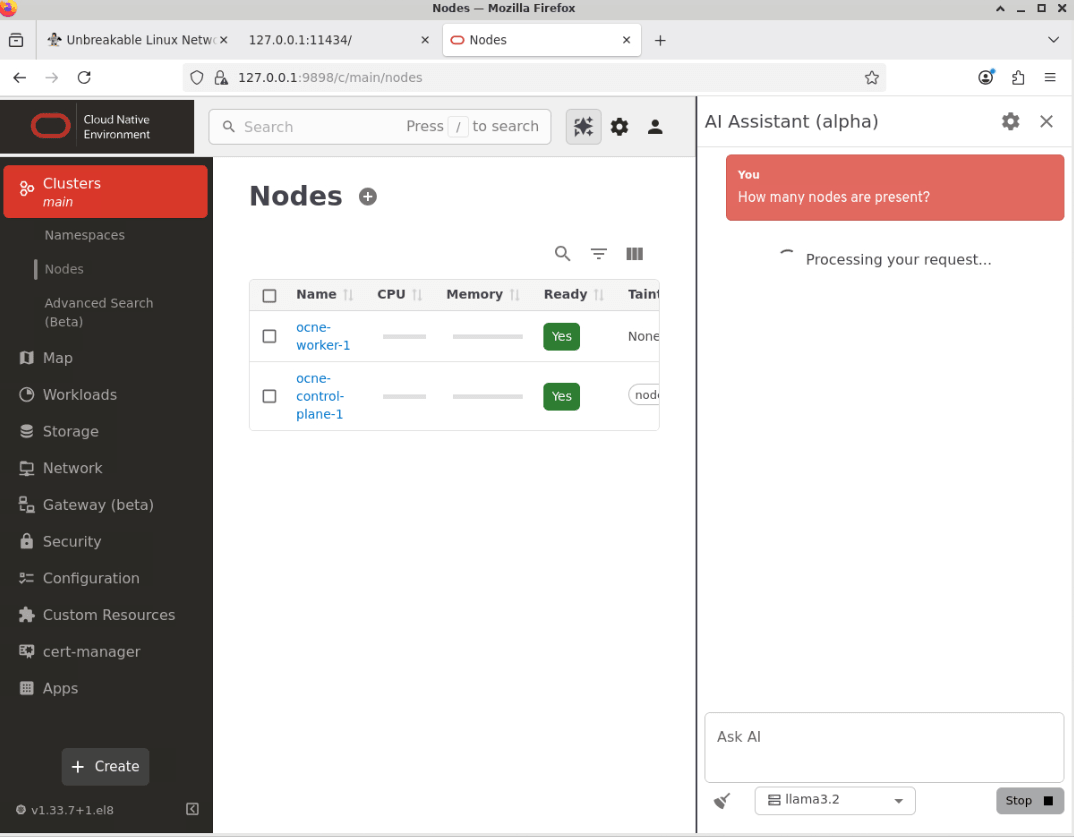

Stellen Sie dem KI-Assistenten eine Frage im Textfeld "Ask AI".

Fügen Sie dieses Beispiel in das Textfeld Ask AI ein.

How many nodes are present? -

Klicken Sie auf die Schaltfläche Senden, um die Frage weiterzuleiten.

Hinweis: Die Zeit, die der KI-Assistent benötigt, um zu reagieren, hängt von mehreren Faktoren ab, wie den Ressourcen, die für das konfigurierte LLM-Modell verfügbar sind, und der Komplexität der Frage, die gestellt wird.

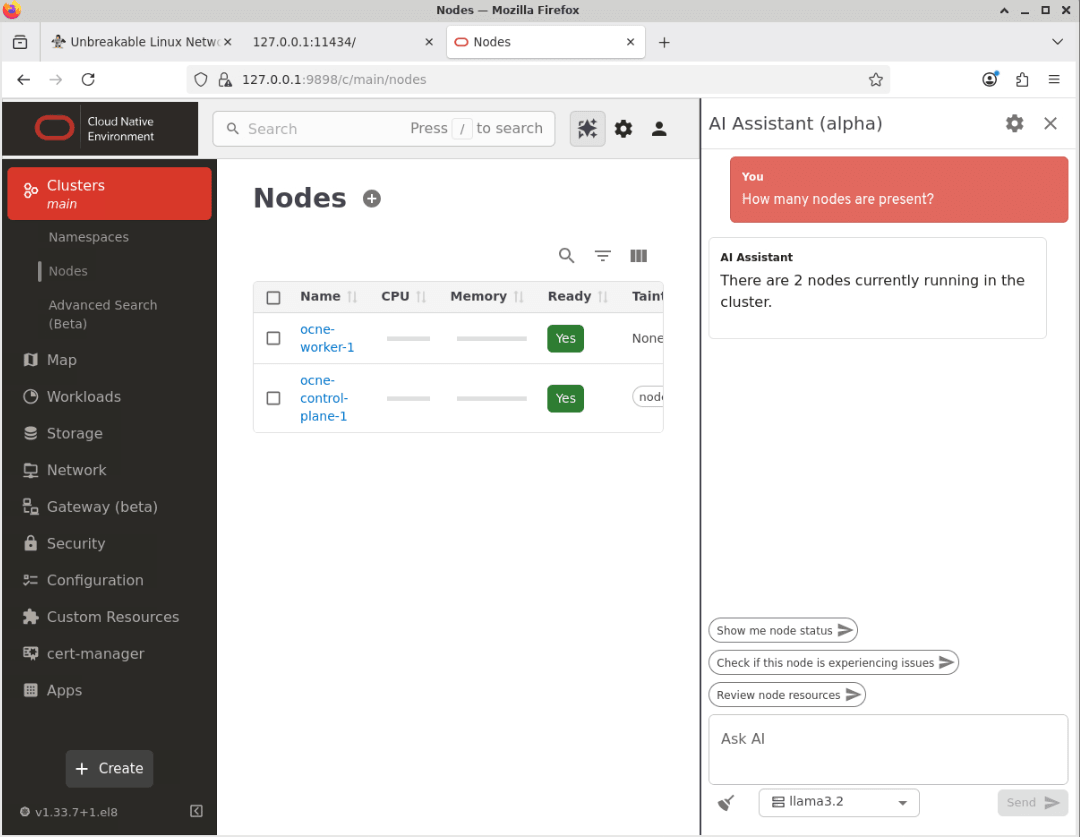

-

Der KI-Assistent gibt eine Antwort zurück.

Hinweis: Der genaue Wortlaut, der in der Antwort verwendet wird, kann zwischen Anforderungen leicht variieren.

-

Dies bestätigt, dass der KI-Assistent funktioniert.

Nächste Schritte

Durch diese Schritte wissen Sie jetzt, wie Sie den Zugriff auf die Oracle Cloud Native Environment-Benutzeroberfläche (UI) aktivieren und für die Verwendung eines LLM konfigurieren. Sie können die vielen Funktionen und Funktionen erkunden, die wir in zukünftigen Tutorials behandeln werden.

Verwandte Links

- Oracle Cloud Native Environment-Dokumentation

- Oracle Cloud Native Environment-Track

- Oracle Linux-Schulungsstation

Weitere Lernressourcen

Sehen Sie sich weitere Übungen zu docs.oracle.com/learn an, oder greifen Sie auf weitere kostenlose Lerninhalte im Oracle Learning YouTube-Kanal zu. Besuchen Sie außerdem education.oracle.com/learning-explorer, um ein Oracle Learning Explorer zu werden.

Die Produktdokumentation finden Sie im Oracle Help Center.

Use AI Assistant with Oracle Cloud Native Environment

G50306-01