Hinweis:

- Dieses Tutorial ist in einer von Oracle bereitgestellten kostenlosen Übungsumgebung verfügbar.

- Es verwendet Beispielwerte für Oracle Cloud Infrastructure-Zugangsdaten, -Mandanten und -Compartments. Ersetzen Sie diese Werte nach Abschluss der Übung durch Werte, die für Ihre Cloud-Umgebung spezifisch sind.

Oracle Linux Automation Manager zu einem geclusterten Deployment migrieren

Einführung

Unabhängig davon, ob Sie ein Upgrade von einem früheren Release ausführen oder mit einer einzelnen Hostinstallation beginnen, können beide Umgebungen zu einem geclusterten Deployment migrieren. Administratoren müssen ihre Topologie vor der Migration planen, da das Cluster aus einer Kombination von Control-Plane-, Ausführungs- und Hop-Knoten und einer Remote-Datenbank bestehen kann.

Nach diesem Tutorial erfahren Sie, wie Sie eine einzelne Hostinstallation in ein geclustertes Deployment mit einer Remote-Datenbank migrieren.

Ziele

In diesem Tutorial erfahren Sie, wie Sie:

- Remote-Datenbank einrichten

- Zu einem geclusterten Deployment migrieren

Voraussetzungen

-

Ein System mit installiertem Oracle Linux Automation Manager.

Einzelheiten zum Installieren von Oracle Linux Automation Manager finden Sie im Oracle Linux Automation Manager - Installationshandbuch.

Oracle Linux Automation Manager bereitstellen

Hinweis: Wenn Sie in Ihrem eigenen Mandanten ausgeführt werden, lesen Sie das Projekt linux-virt-labs GitHub README.md, und schließen Sie die Voraussetzungen ab, bevor Sie die Übungsumgebung bereitstellen.

-

Öffnen Sie ein Terminal auf dem Luna Desktop.

-

Klonen Sie das Projekt

linux-virt-labsGitHub.git clone https://github.com/oracle-devrel/linux-virt-labs.git -

Wechseln Sie in das Arbeitsverzeichnis.

cd linux-virt-labs/olam -

Installieren Sie die erforderlichen Sammlungen.

ansible-galaxy collection install -r requirements.yml -

Aktualisieren Sie die Oracle Linux-Instanzkonfiguration.

cat << EOF | tee instances.yml > /dev/null compute_instances: 1: instance_name: "olam-node" type: "control" 2: instance_name: "exe-node" type: "execution" 3: instance_name: "db-node" type: "db" passwordless_ssh: true add_cluster_ports: true EOF -

Stellen Sie die Übungsumgebung bereit.

ansible-playbook create_instance.yml -e ansible_python_interpreter="/usr/bin/python3.6" -e "@instances.yml" -e olam_single_host=trueFür die kostenlose Übungsumgebung ist die zusätzliche Variable

ansible_python_interpretererforderlich, weil das RPM-Package für das Oracle Cloud Infrastructure-SDK für Python installiert wird. Der Speicherort für die Installation dieses Pakets befindet sich unter den python3.6-Modulen.Die Standard-Deployment-Ausprägung verwendet die AMD-CPU und Oracle Linux 8. Um eine Intel-CPU oder Oracle Linux 9 zu verwenden, fügen Sie dem Deployment-Befehl

-e instance_shape="VM.Standard3.Flex"oder-e os_version="9"hinzu.Wichtig: Warten Sie, bis die Arbeitsmappe erfolgreich ausgeführt wurde, und erreichen Sie die Aufgabe "Unterbrechen". Die Installation von Oracle Linux Automation Manager ist in dieser Phase des Spiels abgeschlossen, und die Instanzen sind bereit. Beachten Sie die vorherige Wiedergabe, in der die öffentlichen und privaten IP-Adressen der bereitgestellten Knoten gedruckt werden.

Melden Sie sich bei der WebUI an.

-

Öffnen Sie ein Terminal, und konfigurieren Sie einen SSH-Tunnel zu Oracle Linux Automation Manager.

ssh -L 8444:localhost:443 oracle@<hostname_or_ip_address>Verwenden Sie in der freien Laborumgebung die externe IP-Adresse der olam-node-Instanz.

-

Öffnen Sie einen Webbrowser, und geben Sie die URL ein.

https://localhost:8444Hinweis: Genehmigen Sie die Sicherheitswarnung basierend auf dem verwendeten Browser. Klicken Sie bei Chrome auf die Schaltfläche **Erweitert und dann auf den Link Weiter zu localhost (unsicher).

-

Melden Sie sich bei Oracle Linux Automation Manager mit dem Benutzernamen

adminund dem Kennwort vonadminan, das beim automatisierten Deployment erstellt wurde.

-

Nach der Anmeldung wird WebUI angezeigt.

Zu Cluster-Deployment migrieren

Während Oracle Linux Automation Manager als Einzelhost-Deployment ausgeführt wird, wird auch die Ausführung als Cluster mit einer Remote-Datenbank und separaten Control Plane- und Ausführungsknoten unterstützt. Die Einzelhostinstanz wird bei der Installation als hybrid-Knoten konfiguriert. Der erste Schritt bei der Migration zu einem Cluster-Deployment besteht darin, diese Instanz in einen control plane-Knoten zu konvertieren.

For more information on different installation topologies, see the Planning the Installation chapter of the Oracle Linux Automation Manager Installation Guide documentation.

Control-Plane-Knoten vorbereiten

-

Wechseln Sie zum Terminal, das mit der olam-node-Instanz verbunden ist, auf der Oracle Linux Automation Manager ausgeführt wird.

Hinweis: Ab sofort wird diese Instanz als Control-Plane-Knoten bezeichnet.

-

Stoppen Sie den Oracle Linux Automation Manager-Service.

sudo systemctl stop ol-automation-manager -

Erstellen Sie ein Backup der Datenbank.

sudo su - postgres -c 'pg_dumpall > /tmp/olamv2_db_dump'

Remote-Datenbank installieren

-

Kopieren Sie das Datenbankbackup vom Control-Plane-Knoten auf den neuen Remote-Datenbankhost.

scp /tmp/olamv2_db_dump oracle@db-node:/tmp/Der Befehl

scpkommuniziert über eine SSH-Verbindung zwischen den Knoten. Diese Verbindung ist möglich, da die kostenlose Übungsumgebung passwortlose SSH-Anmeldungen zwischen den Instanzen konfiguriert. -

Stellen Sie eine SSH-Verbindung zur Instanz db-node her.

ssh oracle@db-node -

Aktivieren Sie den Datenbankmodulstream.

Oracle Linux Automation Manager ermöglicht die Verwendung von Postgresql-Datenbankversion 12 oder 13. Wir verwenden und aktivieren den Modulstream der Version 13 in diesem Tutorial.

sudo dnf -y module reset postgresql sudo dnf -y module enable postgresql:13 -

Installieren Sie den Datenbankserver.

sudo dnf -y install postgresql-server -

Fügen Sie die Datenbankfirewallregel hinzu.

sudo firewall-cmd --add-port=5432/tcp --permanent sudo firewall-cmd --reload -

Initialisieren Sie die Datenbank.

sudo postgresql-setup --initdb -

Legen Sie den Standardspeicheralgorithmus der Datenbank fest.

sudo sed -i "s/#password_encryption.*/password_encryption = scram-sha-256/" /var/lib/pgsql/data/postgresql.confWeitere Informationen zu dieser Datenbankfunktion finden Sie unter Kennwortauthentifizierung in der Upstreamdokumentation.

-

Aktualisieren Sie die hostbasierte Authentifizierungsdatei der Datenbank.

echo "host all all 0.0.0.0/0 scram-sha-256" | sudo tee -a /var/lib/pgsql/data/pg_hba.conf > /dev/nullDiese zusätzliche Zeile führt die SCRAM-SHA-256-Authentifizierung durch, um das Passwort eines Benutzers bei der Verbindung mit einer beliebigen IP-Adresse zu überprüfen.

-

Aktualisieren Sie den Wert listen_address, auf dem die Datenbank auf Verbindungen horcht.

sudo sed -i "/^#port = 5432/i listen_addresses = '"$(hostname -s)"'" /var/lib/pgsql/data/postgresql.confSie können entweder die IP-Adresse oder den Hostnamen für diesen Wert auswählen. Im Tutorial wird

hostname -sverwendet, um den Hostnamen auszuwählen. -

Starten und aktivieren Sie den Datenbankservice.

sudo systemctl enable --now postgresql -

Importieren Sie die Datenbank-Dumpdatei.

sudo su - postgres -c 'psql -d postgres -f /tmp/olamv2_db_dump' -

Legen Sie das Kennwort des Oracle Linux Automation Manager-Datenbankbenutzeraccounts fest.

sudo su - postgres -c "psql -U postgres -d postgres -c \"alter user awx with password 'password';\""Mit diesem Befehl wird das

awx-Kennwort aufpasswordgesetzt. Wählen Sie ein sichereres Passwort, wenn Sie diesen Befehl außerhalb der kostenlosen Übungsumgebung ausführen. -

Schließen Sie die SSH-Session, die mit der db-node-Instanz verbunden ist, da damit die erforderlichen Schritte zum Einrichten der Remotedatenbank ausgeführt werden.

exit

Remote-Datenbankeinstellungen hinzufügen

-

Bestätigen Sie die Verbindung zur olam-node-Instanz, indem Sie den Terminal-Prompt prüfen.

-

Stellen Sie sicher, dass der Host mit der Remotedatenbank kommunizieren kann.

pg_isready -d awx -h db-node -p 5432 -U awxDas postgresql-Package enthält den Befehl

pg_isready. Dieses Paket ist Teil der ursprünglichen Single-Host-Installation. Wenn dieser Befehl nicht funktioniert, haben Sie wahrscheinlich einen Schritt oben übersprungen oder keinen Ingress-Zugriff auf Port 5432 im Netzwerk. -

Fügen Sie die Remote-Datenbankeinstellungen zu einer neuen benutzerdefinierten Konfigurationsdatei hinzu.

cat << EOF | sudo tee /etc/tower/conf.d/db.py > /dev/null DATABASES = { 'default': { 'ATOMIC_REQUESTS': True, 'ENGINE': 'awx.main.db.profiled_pg', 'NAME': 'awx', 'USER': 'awx', 'PASSWORD': 'password', 'HOST': 'db-node', 'PORT': '5432', } } EOFVerwenden Sie dasselbe zuvor für den Datenbankbenutzeraccount

awxfestgelegte Kennwort. -

Stoppen und deaktivieren Sie die lokale Datenbank auf dem Control-Plane-Knoten.

sudo systemctl stop postgresql sudo systemctl disable postgresql -

Maskieren Sie den lokalen Datenbankservice.

sudo systemctl mask postgresqlDieser Schritt verhindert, dass der lokale Datenbankservice beim Starten des Oracle Linux Automation Manager-Service gestartet wird.

-

Starten Sie Oracle Linux Automation Manager.

sudo systemctl start ol-automation-manager -

Prüfen Sie, ob Oracle Linux Automation Manager eine Verbindung zur Remote-Datenbank herstellt.

sudo su -l awx -s /bin/bash -c "awx-manage check_db"Die Ausgabe gibt die Versionsdetails der Remotedatenbank zurück, wenn eine Verbindung erfolgreich hergestellt wurde.

Lokale Datenbankinstanz entfernen

Das Entfernen der ursprünglichen lokalen Datenbank ist sicher, nachdem die Verbindung zur Remote-Datenbank bestätigt wurde.

-

Entfernen Sie die Datenbankpackages.

sudo dnf -y remove postgresql -

Entfernen Sie das Verzeichnis

pgsqlmit den alten Datenbankdatendateien.sudo rm -rf /var/lib/pgsql

Knotentyp des Control-Plane-Knotens ändern

Bei der Konvertierung in ein geclustertes Deployment wechseln Sie die Single-Host-Instanz node_type von hybrid in control.

-

Bestätigen Sie den aktuellen Knotentyp des Control-Plane-Knotens.

sudo su -l awx -s /bin/bash -c "awx-manage list_instances"Die Ausgabe zeigt, dass

node_typeauf den Werthybridgesetzt ist. -

Entfernen Sie die Standardinstanzgruppe.

sudo su -l awx -s /bin/bash -c "awx-manage remove_from_queue --queuename default --hostname $(hostname -i)" -

Definieren Sie die neue Instanz und Queue.

sudo su -l awx -s /bin/bash -c "awx-manage provision_instance --hostname=$(hostname -i) --node_type=control" sudo su -l awx -s /bin/bash -c "awx-manage register_queue --queuename=controlplane --hostnames=$(hostname -i)" -

Fügen Sie die Standardwerte für den Queuenamen in der Datei mit den benutzerdefinierten Einstellungen hinzu.

cat << EOF | sudo tee -a /etc/tower/conf.d/olam.py > /dev/null DEFAULT_EXECUTION_QUEUE_NAME = 'execution' DEFAULT_CONTROL_PLANE_QUEUE_NAME = 'controlplane' EOF -

Receptor-Einstellungen aktualisieren.

cat << EOF | sudo tee /etc/receptor/receptor.conf > /dev/null --- - node: id: $(hostname -i) - log-level: info - tcp-listener: port: 27199 - control-service: service: control filename: /var/run/receptor/receptor.sock - work-command: worktype: local command: /var/lib/ol-automation-manager/venv/awx/bin/ansible-runner params: worker allowruntimeparams: true verifysignature: false EOF -

Oracle Linux Automation Manager neu starten

sudo systemctl restart ol-automation-manager

Die Konvertierung des Single-Host-Hybridknotens in einen Control-Plane-Knoten mit einer Remote-Datenbank ist abgeschlossen. Jetzt fügen wir einen Ausführungsplane-Knoten hinzu, um dieses Cluster voll funktionsfähig zu machen.

Ausführungsplanknoten zum Cluster hinzufügen

Bevor das Cluster voll funktionsfähig ist, fügen Sie einen oder mehrere Ausführungsknoten hinzu. Ausführungsknoten führen Standardjobs mit ansible-runner aus, der Playbooks in einer auf OLAM EE Podman-Containern basierenden Ausführungsumgebung ausführt.

Ausführungsplanknoten vorbereiten

-

Stellen Sie eine SSH-Verbindung zur Instanz *exe-node her.

ssh exe-node -

Installieren Sie das Oracle Linux Automation Manager-Repository-Package.

sudo dnf -y install oraclelinux-automation-manager-release-el8 -

Deaktivieren Sie das Repository für das ältere Release.

sudo dnf config-manager --disable ol8_automation ol8_automation2 -

Aktivieren Sie das Repository des aktuellen Release.

sudo dnf config-manager --enable ol8_automation2.2 -

Installieren Sie das Oracle Linux Automation Manager-Package.

sudo dnf -y install ol-automation-manager -

Fügen Sie die Receptor-Firewallregel hinzu.

sudo firewall-cmd --add-port=27199/tcp --permanent sudo firewall-cmd --reload -

Bearbeiten Sie die Redis-Socket-Konfiguration.

sudo sed -i '/^# unixsocketperm/a unixsocket /var/run/redis/redis.sock\nunixsocketperm 775' /etc/redis.conf -

Kopieren Sie den Secret Key vom Control-Plane-Knoten.

ssh oracle@olam-node "sudo cat /etc/tower/SECRET_KEY" | sudo tee /etc/tower/SECRET_KEY > /dev/nullWichtig: Jeder Clusterknoten benötigt denselben Secret Key.

-

Erstellen Sie eine benutzerdefinierte Einstellungsdatei mit den erforderlichen Einstellungen.

cat << EOF | sudo tee /etc/tower/conf.d/olamv2.py > /dev/null CLUSTER_HOST_ID = '$(hostname -i)' DEFAULT_EXECUTION_QUEUE_NAME = 'execution' DEFAULT_CONTROL_PLANE_QUEUE_NAME = 'controlplane' EOFCLUSTER_HOST_IDist eine eindeutige ID des Hosts im Cluster. -

Erstellen Sie eine benutzerdefinierte Einstellungsdatei mit der Remote-Datenbankkonfiguration.

cat << EOF | sudo tee /etc/tower/conf.d/db.py > /dev/null DATABASES = { 'default': { 'ATOMIC_REQUESTS': True, 'ENGINE': 'awx.main.db.profiled_pg', 'NAME': 'awx', 'USER': 'awx', 'PASSWORD': 'password', 'HOST': 'db-node', 'PORT': '5432', } } EOF -

Stellen Sie die Ausführungsumgebung "ansible-runner" bereit.

-

Öffnen Sie eine Shell als Benutzer

awx.sudo su -l awx -s /bin/bash -

Migrieren Sie vorhandene Container auf die neueste Podman-Version, während die nicht privilegierten Namespaces am Leben bleiben.

podman system migrate -

Rufen Sie die Oracle Linux Automation Engine-Ausführungsumgebung für Oracle Linux Automation Manager ab.

podman pull container-registry.oracle.com/oracle_linux_automation_manager/olam-ee:2.2 -

Beenden Sie die Benutzershell

awx.exit

-

-

Generieren Sie die SSL-Zertifikate für NGINX.

sudo openssl req -x509 -nodes -days 365 -newkey rsa:2048 -keyout /etc/tower/tower.key -out /etc/tower/tower.crtGeben Sie die angeforderten Informationen ein, oder drücken Sie einfach die Taste

ENTER. -

Ersetzen Sie die NGINX-Standardkonfiguration durch die folgende Konfiguration.

cat << 'EOF' | sudo tee /etc/nginx/nginx.conf > /dev/null user nginx; worker_processes auto; error_log /var/log/nginx/error.log; pid /run/nginx.pid; # Load dynamic modules. See /usr/share/doc/nginx/README.dynamic. include /usr/share/nginx/modules/*.conf; events { worker_connections 1024; } http { log_format main '$remote_addr - $remote_user [$time_local] "$request" ' '$status $body_bytes_sent "$http_referer" ' '"$http_user_agent" "$http_x_forwarded_for"'; access_log /var/log/nginx/access.log main; sendfile on; tcp_nopush on; tcp_nodelay on; keepalive_timeout 65; types_hash_max_size 2048; include /etc/nginx/mime.types; default_type application/octet-stream; # Load modular configuration files from the /etc/nginx/conf.d directory. # See http://nginx.org/en/docs/ngx_core_module.html#include # for more information. include /etc/nginx/conf.d/*.conf; } EOF -

Aktualisieren Sie die Receptor-Konfigurationsdatei.

cat << EOF | sudo tee /etc/receptor/receptor.conf > /dev/null --- - node: id: $(hostname -i) - log-level: debug - tcp-listener: port: 27199 - tcp-peer: address: $(ssh olam-node hostname -i):27199 redial: true - control-service: service: control filename: /var/run/receptor/receptor.sock - work-command: worktype: ansible-runner command: /var/lib/ol-automation-manager/venv/awx/bin/ansible-runner params: worker allowruntimeparams: true verifysignature: false EOFnode:idist der Hostname oder die IP-Adresse des aktuellen Knotens.tcp-peer:addressist der Hostname oder die IP-Adresse und der Port des Receptor Meshs auf dem Control-Plane-Knoten.

-

Starten und aktivieren Sie den Oracle Linux Automation Manager-Service.

sudo systemctl enable --now ol-automation-manager.service -

Schließen Sie die SSH-Session, die mit der Instanz exe-node verbunden ist, da damit die erforderlichen Schritte zum Einrichten des Ausführungsknotens abgeschlossen werden.

exit

Ausführungsplanknoten bereitstellen

-

Bestätigen Sie die Verbindung zur olam-node-Instanz, indem Sie den Terminal-Prompt prüfen.

Sie müssen den Provisioning-Schritt auf einem der Control-Plane-Knoten des Clusters ausführen und auf alle geclusterten Instanzen von Oracle Linux Automation Manager anwenden.

-

Definieren Sie die Ausführungsinstanz und die Queue.

sudo su -l awx -s /bin/bash -c "awx-manage provision_instance --hostname=$(ssh exe-node hostname -i) --node_type=execution" sudo su -l awx -s /bin/bash -c "awx-manage register_default_execution_environments" sudo su -l awx -s /bin/bash -c "awx-manage register_queue --queuename=execution --hostnames=$(ssh exe-node hostname -i)"register_queueverwendet einequeuenamezum Erstellen/Aktualisieren und eine Liste mit durch Komma getrenntenhostnames, in denen Jobs ausgeführt werden.

-

Registrieren Sie die Service-Mesh-Peer-Beziehung.

sudo su -l awx -s /bin/bash -c "awx-manage register_peers $(ssh exe-node hostname -i) --peers $(hostname -i)"

Knotenregistrierung der Ausführungsebene prüfen

-

Stellen Sie eine SSH-Verbindung zur Instanz *exe-node her.

ssh exe-node -

Prüfen Sie, ob der Oracle Linux Automation Manager-Mesh-Service ausgeführt wird.

sudo systemctl status receptor-awx -

Prüfen Sie den Status des Service-Mesh.

sudo receptorctl --socket /var/run/receptor/receptor.sock statusBeispielausgabe:

[oracle@execution-node ~]$ sudo receptorctl --socket /var/run/receptor/receptor.sock status Node ID: 10.0.0.62 Version: +g System CPU Count: 2 System Memory MiB: 15713 Connection Cost 10.0.0.55 1 Known Node Known Connections 10.0.0.55 10.0.0.62: 1 10.0.0.62 10.0.0.55: 1 Route Via 10.0.0.55 10.0.0.55 Node Service Type Last Seen Tags 10.0.0.62 control Stream 2022-11-06 19:46:53 {'type': 'Control Service'} 10.0.0.55 control Stream 2022-11-06 19:46:06 {'type': 'Control Service'} Node Work Types 10.0.0.62 ansible-runner 10.0.0.55 localWeitere Details zum Rezeptor finden Sie in der Upstream-Dokumentation.

-

Prüfen Sie die ausgeführten Clusterinstanzen, und zeigen Sie die verfügbare Kapazität an.

sudo su -l awx -s /bin/bash -c "awx-manage list_instances"Die Ausgabe wird

greenangezeigt, sobald das Cluster die Kommunikation über alle Instanzen hinweg herstellt. Wenn die Ergebnisseredangezeigt werden, warten Sie 20-30 Sekunden, und führen Sie den Befehl erneut aus.Beispielausgabe:

[oracle@control-node ~]$ sudo su -l awx -s /bin/bash -c "awx-manage list_instances" [controlplane capacity=136] 10.0.0.55 capacity=136 node_type=control version=19.5.1 heartbeat="2022-11-08 16:24:03" [default capacity=0] [execution capacity=136] 10.0.0.62 capacity=136 node_type=execution version=19.5.1 heartbeat="2022-11-08 17:16:45"

Damit ist die Migration von Oracle Linux Automation Manager zu einem geclusterten Deployment abgeschlossen.

(Optional) Prüfen Sie, ob das Cluster funktioniert

-

Aktualisieren Sie das Webbrowserfenster, in dem das vorherige WebUI angezeigt wird, oder öffnen Sie ein neues Webbrowserfenster, und geben Sie die URL ein.

https://localhost:8444Der in der URL verwendete Port muss mit dem lokalen Port des SSH-Tunnels übereinstimmen.

Hinweis: Genehmigen Sie die Sicherheitswarnung basierend auf dem verwendeten Browser. Klicken Sie bei Chrome auf die Schaltfläche Erweitert und dann auf den Link Weiter zu localhost (unsicher).

-

Melden Sie sich erneut bei Oracle Linux Automation Manager mit dem USERNAME

adminund dem Kennwortadminan.

-

Nach der Anmeldung wird WebUI angezeigt.

-

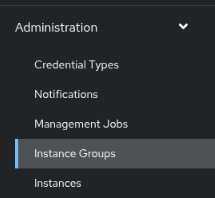

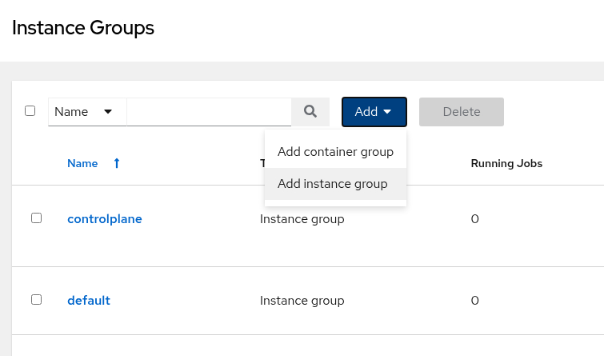

Klicken Sie im Navigationsmenü auf der linken Seite im Abschnitt Administration auf Instanzgruppen.

-

Klicken Sie im Hauptfenster auf die Schaltfläche Hinzufügen, und wählen Sie Instanzgruppe hinzufügen aus.

-

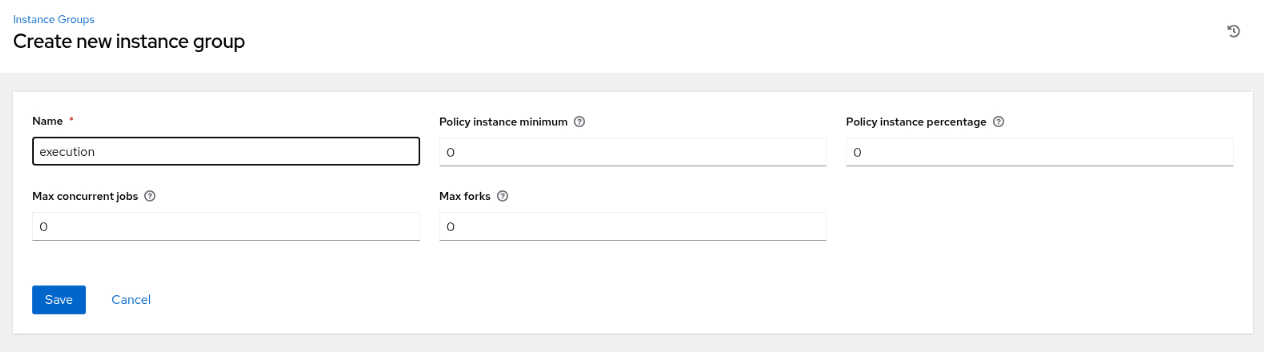

Geben Sie die erforderlichen Informationen auf der Seite Neue Instanzgruppe erstellen ein.

-

Klicken Sie auf die Schaltfläche Speichern.

-

Klicken Sie auf der Übersichtsseite Details auf die Registerkarte Instanzen.

-

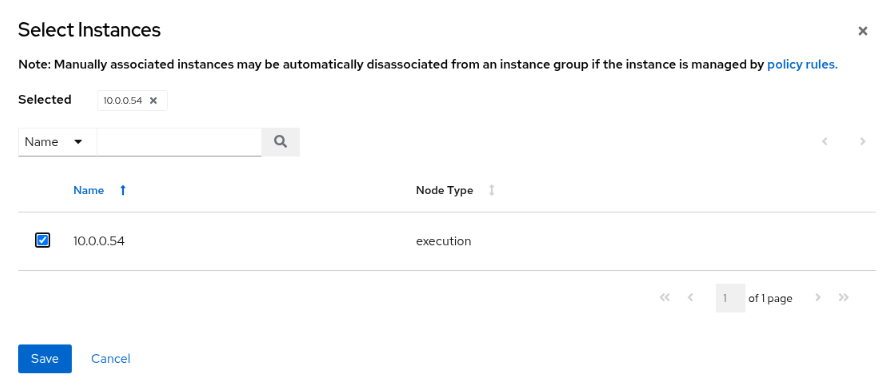

Klicken Sie auf der Seite Instanzen auf die Schaltfläche Verknüpfen.

-

Klicken Sie auf der Seite Instanzen auswählen auf das Kontrollkästchen neben dem Ausführungsknoten.

-

Klicken Sie auf die Schaltfläche Speichern.

-

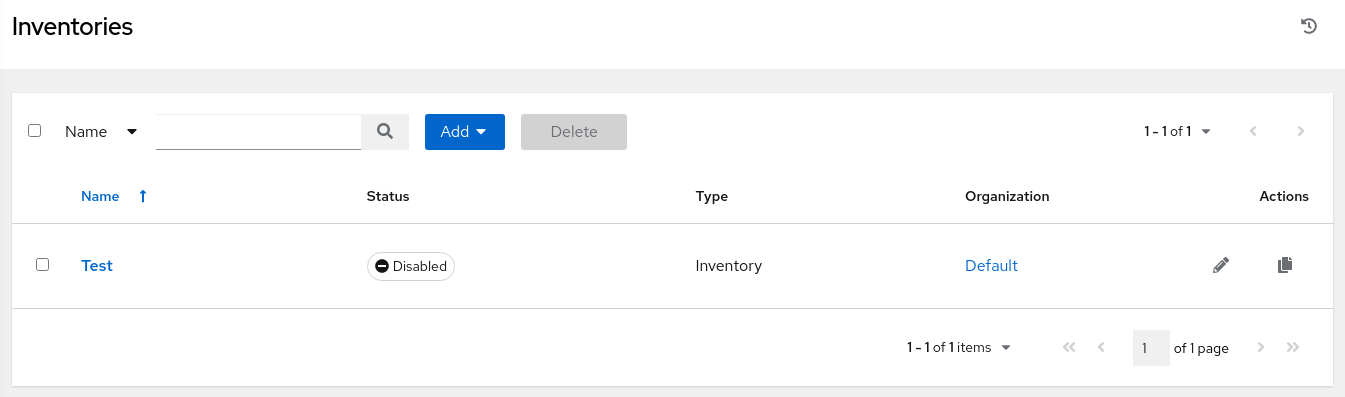

Klicken Sie im Navigationsmenü auf der linken Seite im Abschnitt Ressourcen auf Bestände.

-

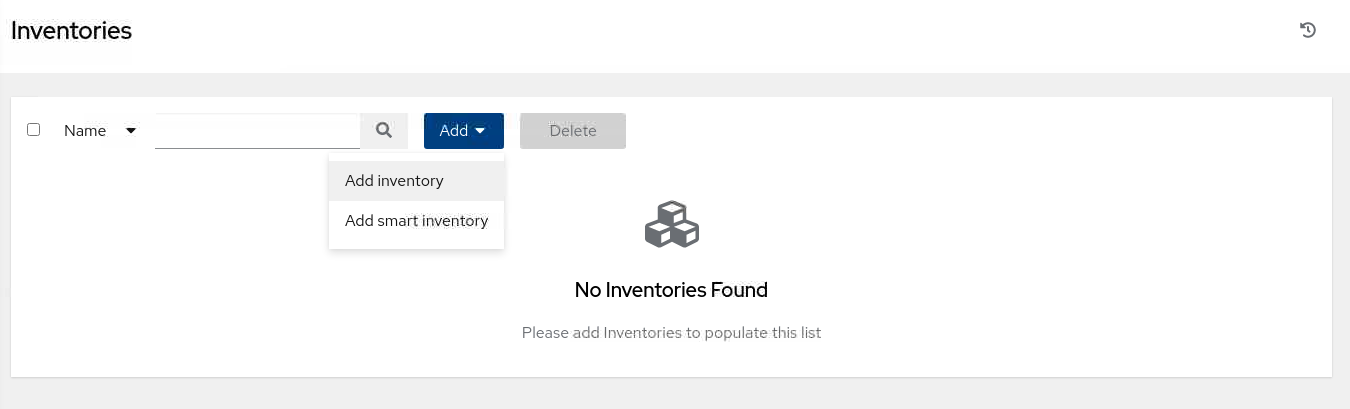

Klicken Sie im Hauptfenster auf die Schaltfläche Hinzufügen, und wählen Sie Bestand hinzufügen aus.

-

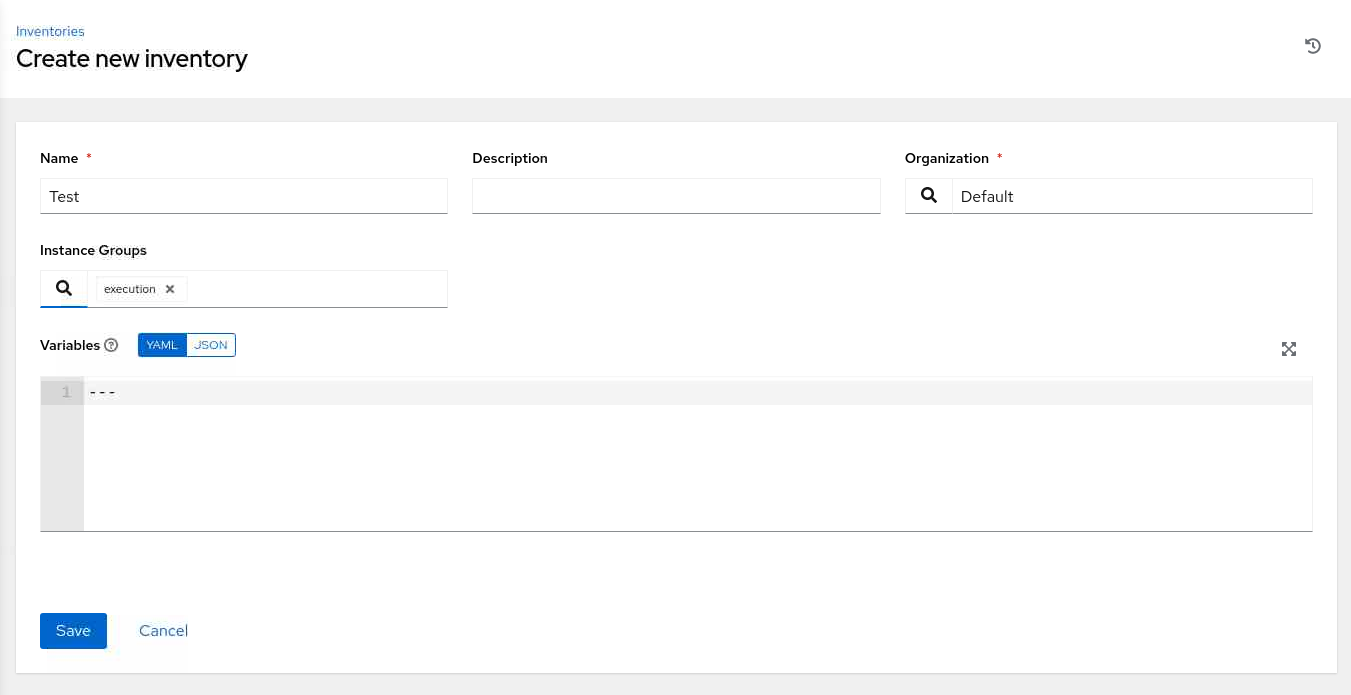

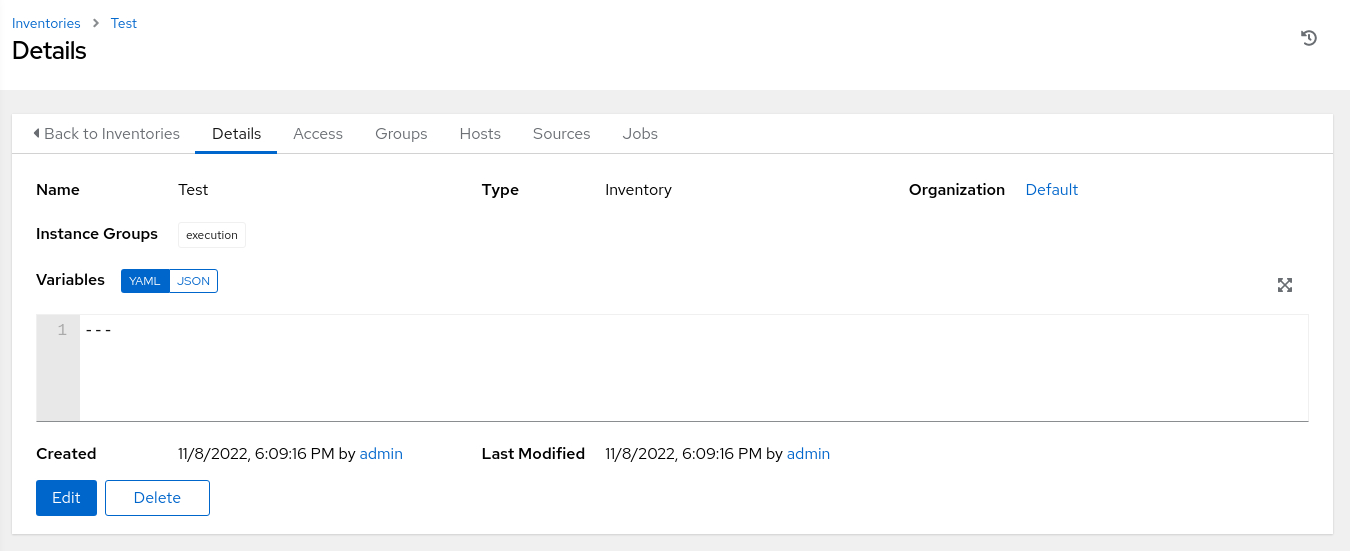

Geben Sie die erforderlichen Informationen auf der Seite Neuen Bestand erstellen ein.

Wählen Sie unter Instanzgruppen das Suchsymbol aus, um das Popup-Dialogfeld Instanzgruppen auswählen anzuzeigen. Klicken Sie auf das Kontrollkästchen neben der Gruppe Ausführung und dann auf die Schaltfläche Auswählen.

-

Klicken Sie auf die Schaltfläche Speichern.

-

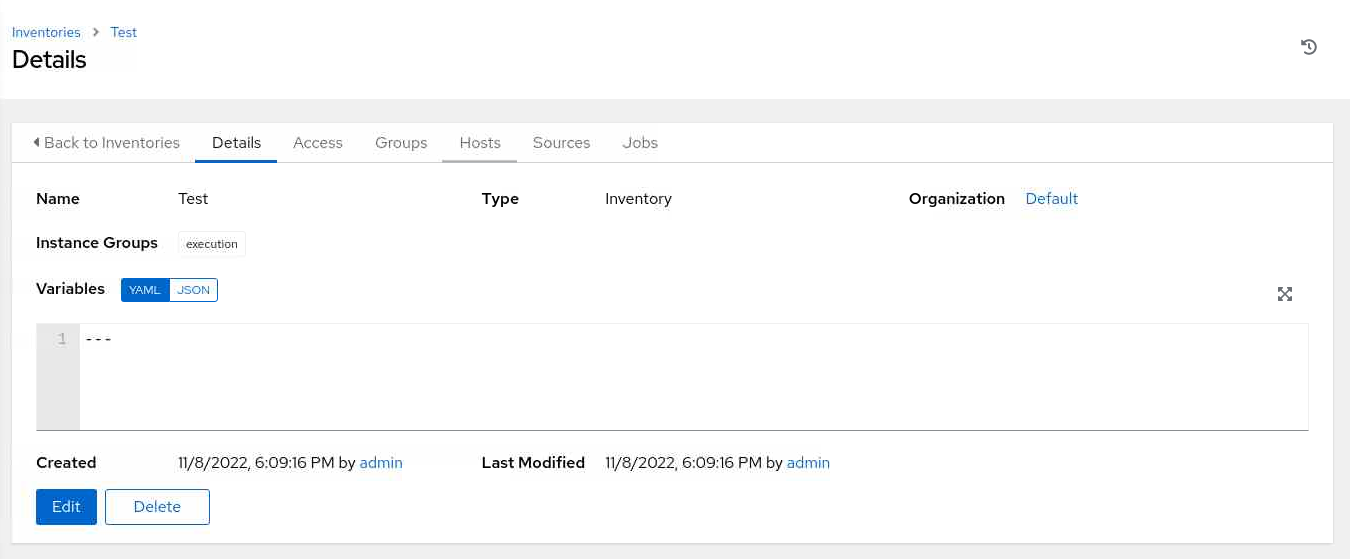

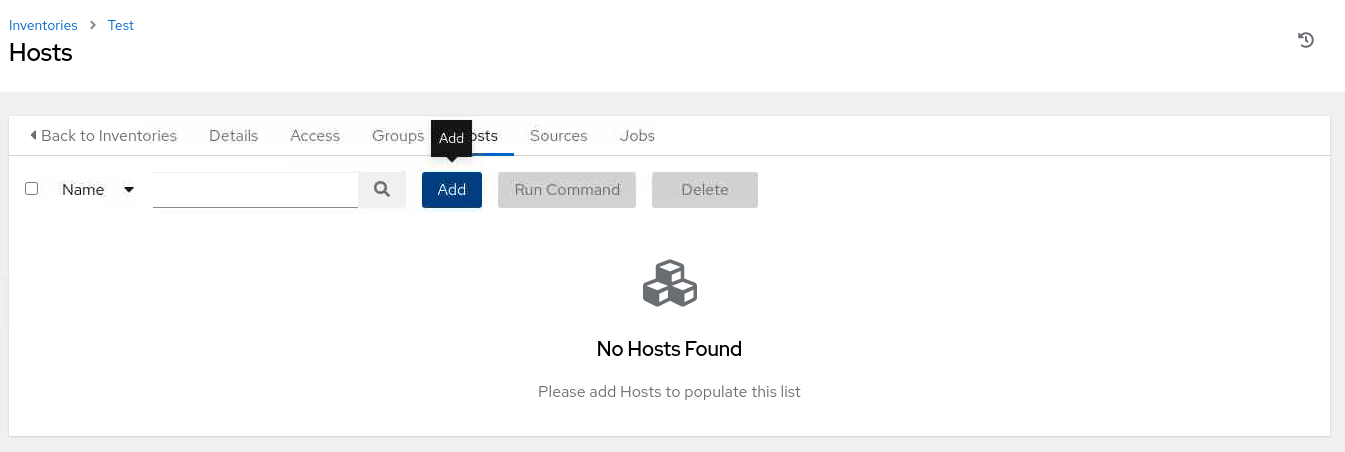

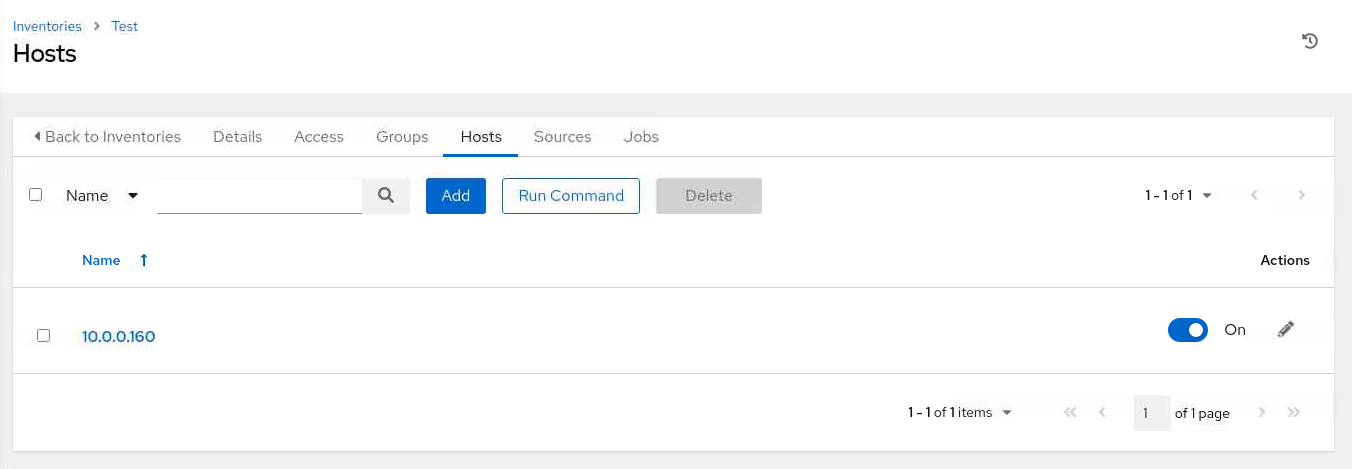

Klicken Sie auf der Übersichtsseite Details auf die Registerkarte Hosts.

-

Klicken Sie auf der Seite Hosts auf die Schaltfläche Hinzufügen.

-

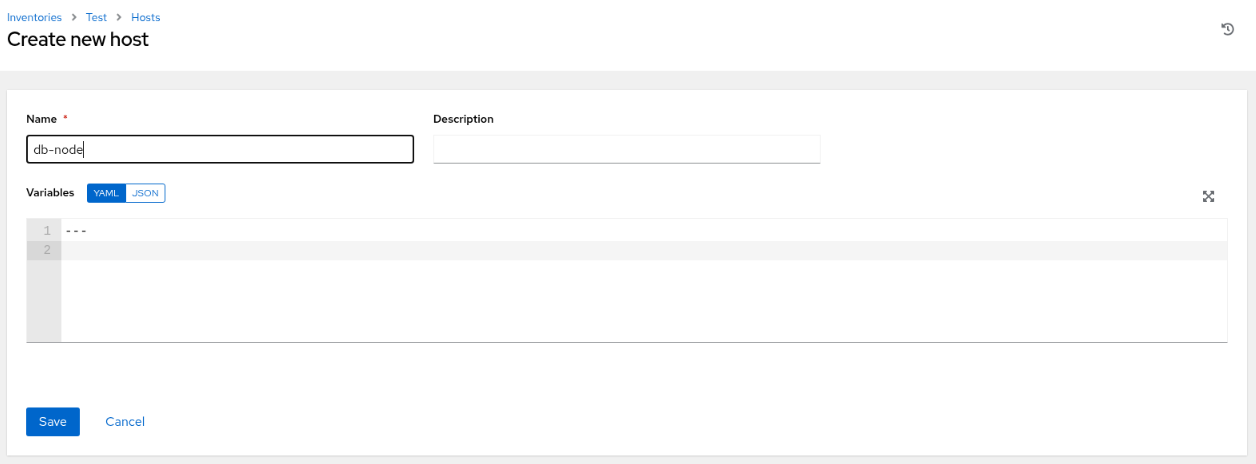

Geben Sie auf der Seite Neuen Host erstellen die IP-Adresse oder den Hostnamen einer verfügbaren Instanz ein.

In der kostenlosen Übungsumgebung verwenden wir db-node, den Hostnamen der Remote-Datenbankinstanz.

-

Klicken Sie auf die Schaltfläche Speichern.

-

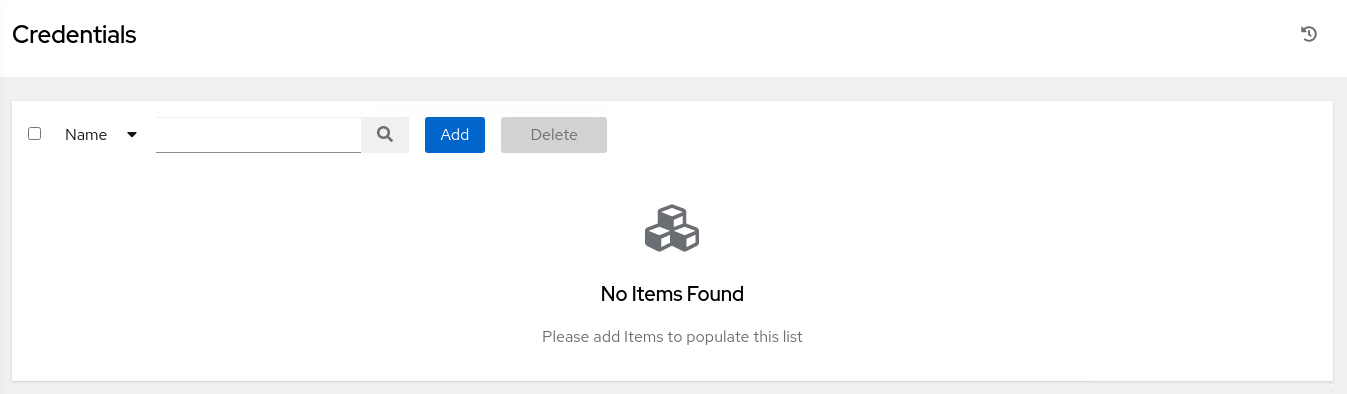

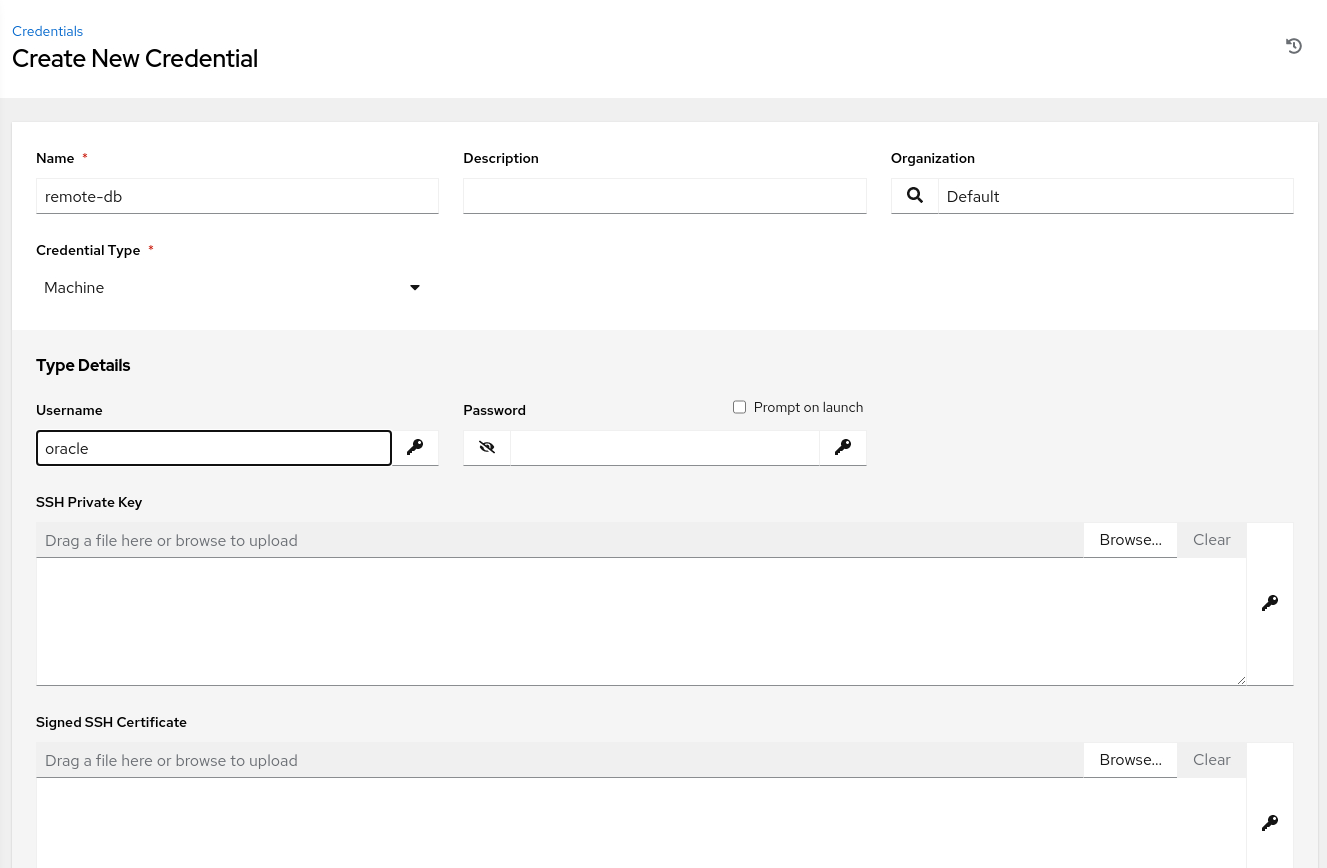

Navigieren Sie zum Menü auf der linken Seite, und klicken Sie auf **Zugangsdaten".

-

Klicken Sie auf der Seite Zugangsdaten auf die Schaltfläche Hinzufügen.

-

Geben Sie die erforderlichen Informationen auf der Seite Neue Zugangsdaten erstellen ein.

Klicken Sie für den Zugangsdatentyp auf das Dropdown-Menü, und wählen Sie Maschine aus. Dadurch werden die Typdetails der Zugangsdaten angezeigt.

Geben Sie einen Benutzernamen von

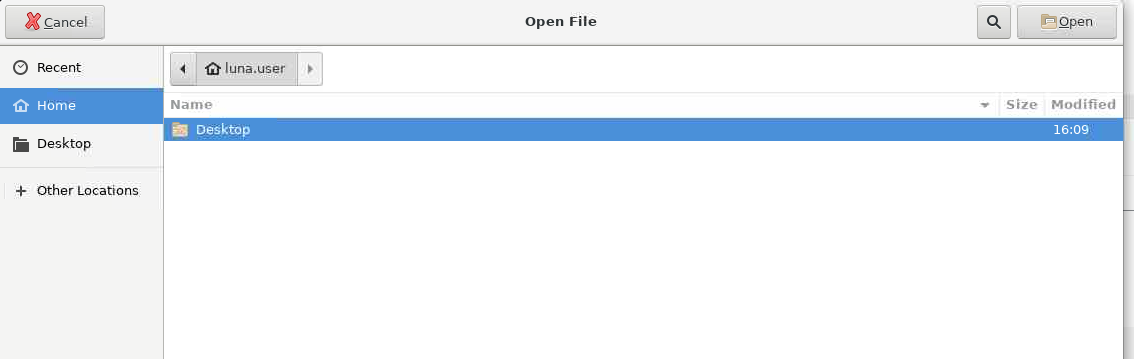

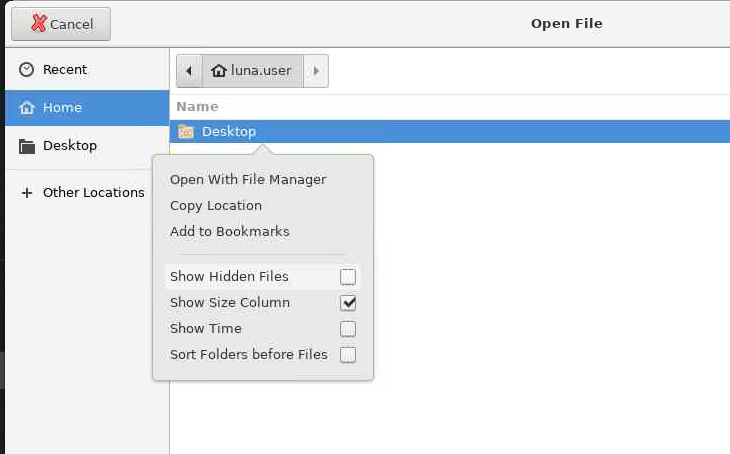

oracleein, und suchen Sie nach dem SSH-Private Key. Wenn Sie auf die Schaltfläche Durchsuchen... klicken, wird das Dialogfeld Datei öffnen angezeigt.

Klicken Sie mit der rechten Maustaste auf das Hauptfenster dieses Dialogfelds, und wählen Sie Ausgeblendete Dateien anzeigen aus.

Wählen Sie dann den Ordner

.sshund die Dateiid_rsaaus. Wenn Sie auf die Schaltfläche Open klicken, wird der Inhalt der Private-Key-Datei in das Dialogfeld SSH Private Key kopiert. Scrollen Sie nach unten, und klicken Sie auf Speichern. -

Navigieren Sie zum Menü auf der linken Seite, und klicken Sie auf Bestände.

-

Klicken Sie auf der Seite Bestände auf den Bestand Testen.

-

Klicken Sie auf der Übersichtsseite Details auf die Registerkarte Hosts.

-

Klicken Sie auf der Seite Hosts auf das Kontrollkästchen neben dem Host

db-node.

Klicken Sie anschließend auf die Schaltfläche Befehl ausführen.

-

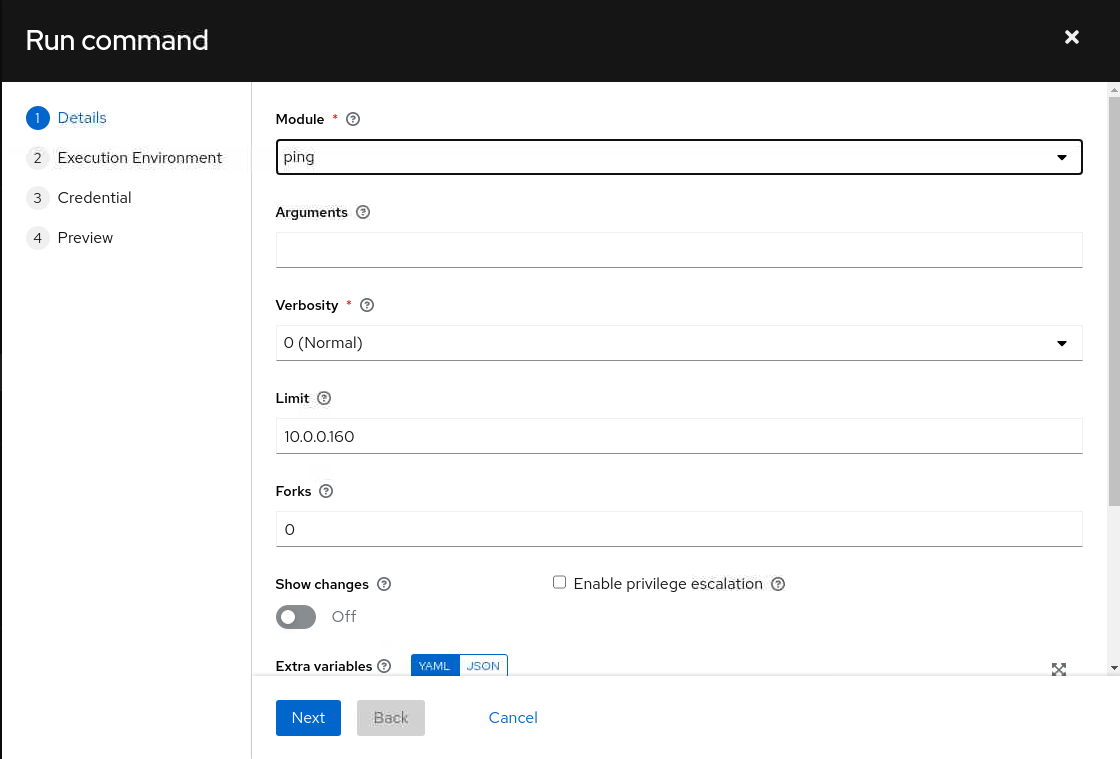

Wählen Sie im Dialogfeld Befehl ausführen das Modul

pingaus der Werteliste Module, und klicken Sie auf die Schaltfläche Weiter.

-

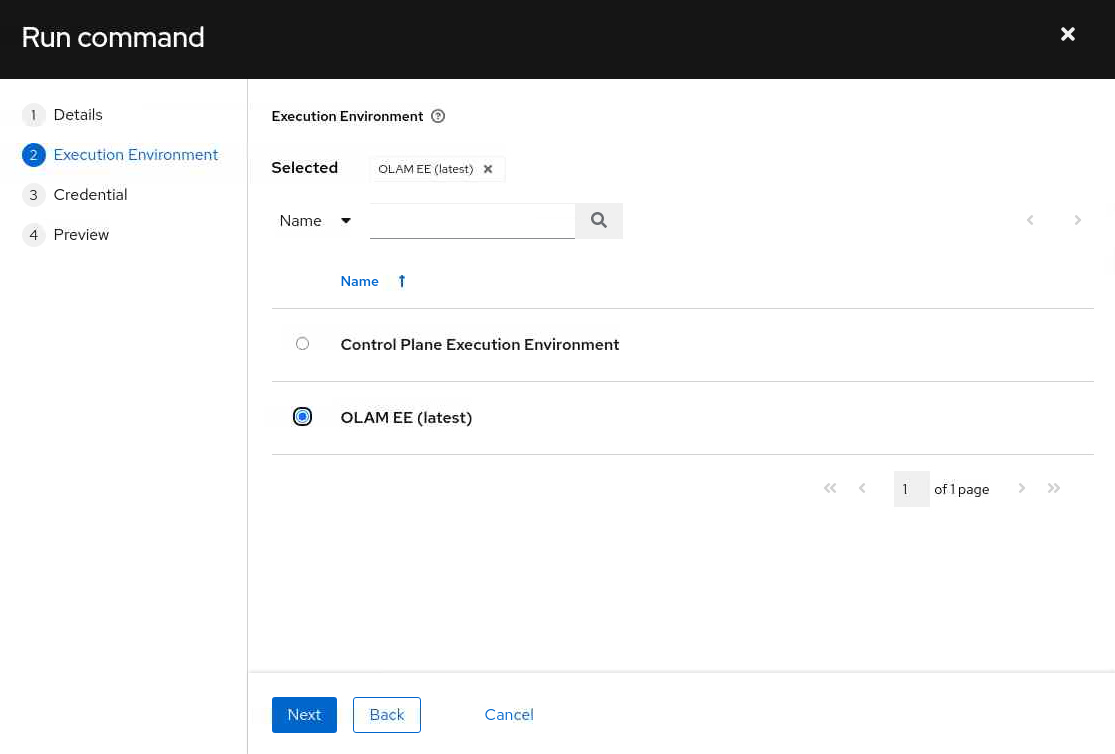

Wählen Sie die Ausführungsumgebung OLAM EE (2.2) aus, und klicken Sie auf die Schaltfläche Weiter.

-

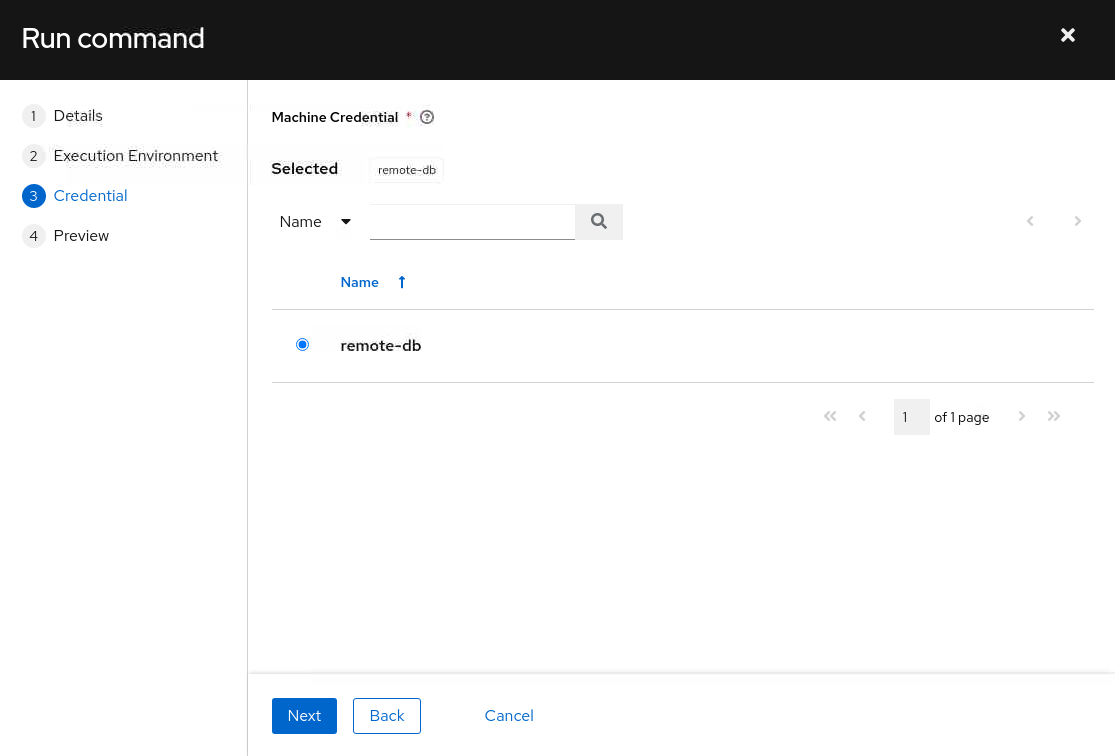

Wählen Sie die Zugangsdaten des Rechners db-node, und klicken Sie auf die Schaltfläche Weiter.

-

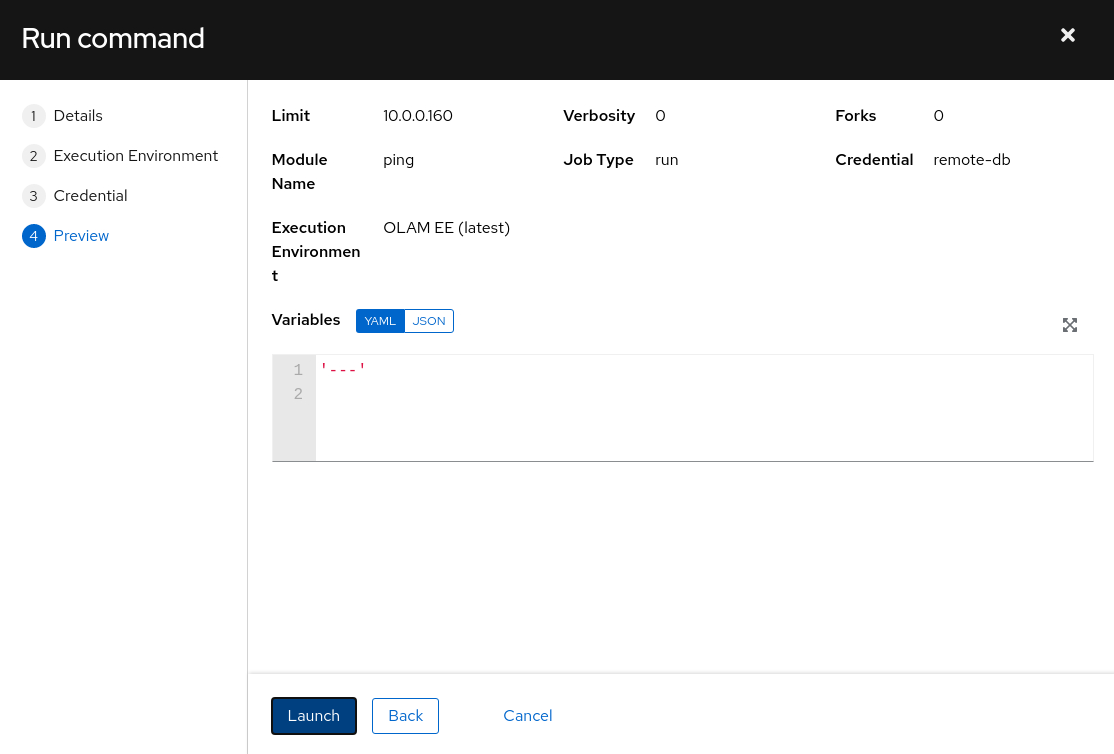

Der Bereich wird aktualisiert und zeigt eine Vorschau des Befehls an.

Nachdem Sie die Details geprüft haben, klicken Sie auf die Schaltfläche Starten.

-

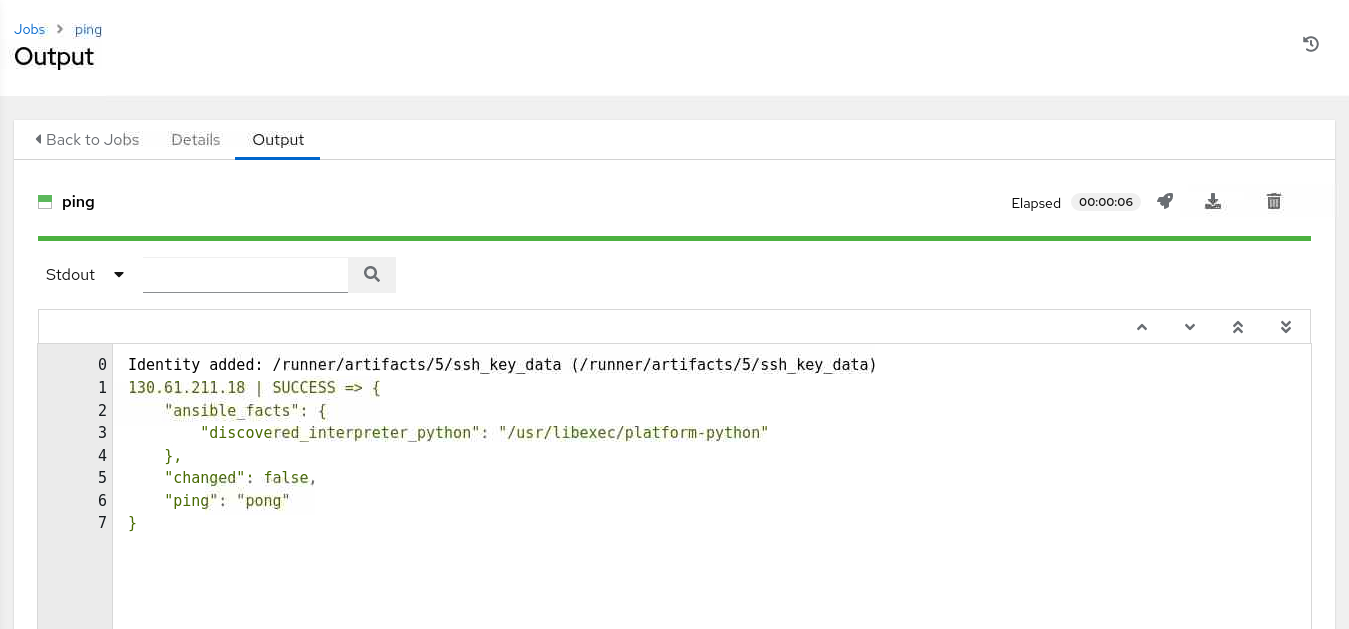

Der Job wird gestartet und zeigt die Seite Ausgabe des Jobs an.

Wenn alles erfolgreich ausgeführt wurde, zeigt die Ausgabe eine

SUCCESS-Nachricht an, dass der Ausführungsknoten mit dem Ansible-Modulpingdiedb-node-Instanz kontaktiert hat. Wenn die Ausgabe nicht angezeigt wird, aktualisieren Sie die Seite, indem Sie auf die Registerkarte Details klicken und zur Registerkarte Ausgabe zurückkehren.

Nächste Schritte

Die Ausgabe in WebUI bestätigt, dass Sie über eine funktionierende Clusterumgebung für Oracle Linux Automation Manager verfügen. Erweitern Sie weiter Ihre Fähigkeiten, und sehen Sie sich unsere anderen Oracle Linux Automation Manager-Schulungen in der Oracle Linux-Schulungsstation an.

Verwandte Links

Oracle Linux Automation Manager-Dokumentation

Oracle Linux Automation Manager-Schulung

Oracle Linux-Schulungsstation

Weitere Lernressourcen

Sehen Sie sich andere Übungen zu docs.oracle.com/learn an, oder greifen Sie im Oracle Learning YouTube-Channel auf weitere kostenlose Lerninhalte zu. Besuchen Sie außerdem education.oracle.com/learning-explorer, um Oracle Learning Explorer zu werden.

Die Produktdokumentation finden Sie im Oracle Help Center.

Migrate Oracle Linux Automation Manager to a Clustered Deployment

F74652-02

Copyright ©2022, Oracle and/or its affiliates.