Planung der Bereitstellung

Stellen Sie diese Architektur mithilfe der folgenden grundlegenden Schritte bereit:

- Architekturbausteine Oracle Cloud Infrastructure-Services zuordnen

- Planung der ersten Implementierung mit Schwerpunkt auf der Agent-Orchestrierung

- Verbessern Sie die anfängliche Implementierung, indem Sie Agents hinzufügen und erweiterte LLM-Grundlagen integrieren

OCI-Services zuordnen

Oracle Cloud Infrastructure (OCI) stellt alle Bausteine bereit, die für die cloudnative, skalierbare Implementierung dieses Systems erforderlich sind.

Ordnen Sie jede Komponente wie folgt OCI-Services zu.

- Orchestratorimplementierung

Sie können den MCP-Orchestrator auf einer OCI Compute-Instanz auf einer virtuellen Oracle Linux-Maschine (VM) oder als Container auf der OCI Kubernetes Engine ausführen. Der Orchestrator hostet den Toolbox-basierten Server GenAI, der auf Agent-Anforderungen horcht und diese an Tools weiterleitet. Die Skalierbarkeit von OCI stellt sicher, dass der Orchestrator mehrere gleichzeitige Betrugsuntersuchungen durchführen kann. Optional können Sie mit OCI API Gateway einen sicheren REST-Endpunkt für den Orchestrator bereitstellen, damit externe Systeme oder Democlients den Workflow initiieren können.

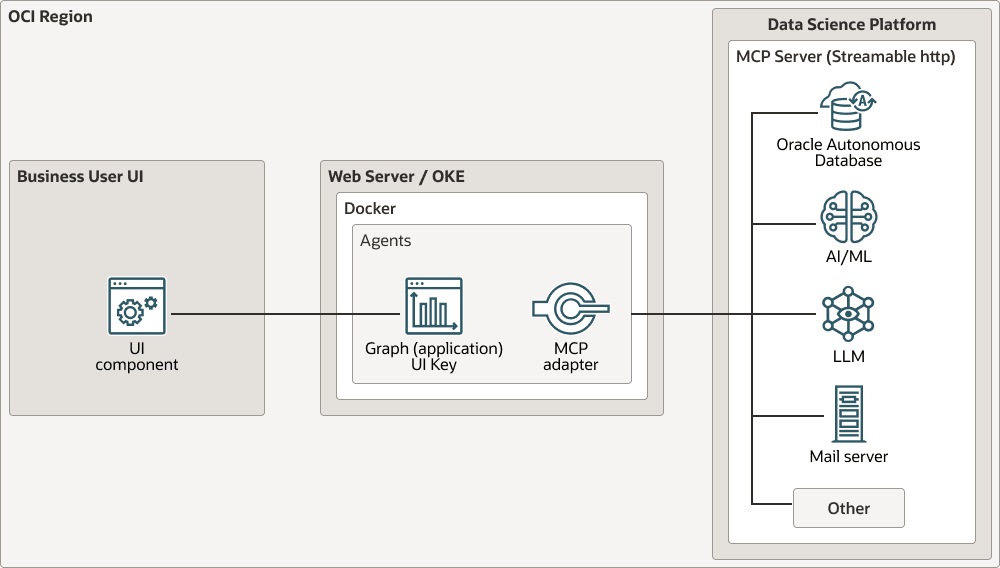

Der Orchestrator hostet alle Agents, die mit der UI verbunden sind, und stellt auch Routing zu Tools bereit. Sie können den MCP-Server auch in Oracle Cloud Infrastructure Data Science hosten, wo Tools mit dem streambaren HTTP-Protokoll bereitgestellt werden.

- Agents als serverlose Funktionen

Die Logik jedes Agents kann als OCI-Funktion (serverloser Microservice) oder als Lightweight-Container bereitgestellt werden. Beispiel: Der Datenabruf-Agent kann eine OCI-Funktion sein, die Parameter (IDs, Abfragetyp) akzeptiert und JSON-Daten aus Autonomous Database zurückgibt. Der Betrugsanalysator könnte eine weitere Funktion sein, die Daten annimmt und eine Punktzahl und Nachricht zurückgibt. Die Verwendung von OCI Functions für Agents vereinfacht das Deployment und bietet Elastizität zur automatischen Skalierung, wenn viele Betrugsanalysen parallel ausgeführt werden. Der MCP-Orchestrator ruft REST-Endpunkte dieser Funktionen entweder mit OCI API Gateway oder mit internen Aufrufen auf. In Phase 1 wird die Toolausführung vereinfacht, indem die Tools im Orchestratorprozess ausgeführt werden (wie GenAI Toolbox), sodass der Orchestrator selbst die Datenbankabfrage-Tools ausführen kann. Der Entwurf von Agents als unabhängige OCI-Funktionen bietet jedoch Modularität und hilft bei Demonstrationen, indem jede Funktion nacheinander ausgelöst wird.

- Datenspeicherung und -verarbeitung

Oracle Autonomous Transaction Processing (ATP) ist das sichere Repository für alle relevanten Finanzdaten, wie Transaktionsprotokolle, Kontodaten, Policy-Informationen und historische Betrugsfälle. Autonomous Database bietet integrierte Analysefunktionen für Autoscaling, Verschlüsselung und strukturierte Abfragesprachen (SQL), die alle für reale Finanzdienstleistungs-Workloads von entscheidender Bedeutung sind. Der Data Agent verwendet SQL und eine Oracle-Client- oder REST-API (Data Application Programming Interface), um Daten aus der Datenbank abzurufen. Sie können auch Tools wie Oracle Machine Learning für die erweiterte Bewertung nutzen, wenn das Betrugsmodell datenbankintern trainiert wird. Für das Streaming von Transaktionsdaten können Sie OCI Streaming oder Oracle GoldenGate verwenden, um Daten in das System einzuspeisen. Für ein Demonstrationsszenario reicht eine einfache direkte Abfrage aus.

- KI- und ML-Services

Zur Implementierung der Betrugserkennungslogik bietet OCI mehrere Optionen. In Phase 1 werden Regeln oder Anomalieerkennung direkt codiert. Phase 2 implementiert Oracle AI-Services:

- OCI Generative AI bietet Zugriff auf große Sprachmodelle für die narrative Generierung und Argumentation des Betrugsanalyseagenten. OCI Generative AI ist ein vollständig verwalteter Service, der vortrainierte LLMs anbietet, die einfach in Anwendungen integriert werden können. Der Betrugsanalysator kann diesen Service aufrufen, indem er sein Software Development Kit (SDK) und seine API mit einer Eingabeaufforderung mit den Transaktionsdaten verwendet und als Antwort einen Text zur Betrugserklärung erhält.

- OCI Anomaly Detection bewertet Transaktionen in Echtzeit auf Anomalien mit einer hohen Punktzahl, die auf potenziellen Betrug hinweist. Zuerst anhand historischer Transaktionsdaten trainiert, ruft der Betrugsanalyse-Agent einfach die Anomalieerkennungs-API auf, um einen Anomaliescore für eine bestimmte Transaktion zu erhalten. In ähnlicher Weise bietet OCI Data Science und Oracle Machine Learning für das Training benutzerdefinierter Betrugsmodelle wie Farbverlaufssteigerung oder Diagrammalgorithmen für Betrug. Sie können Modelle, wie ein XGBoost-Modell für Betrug, als Endpunkte mit dem Data Science-Modell-Deployment bereitstellen, damit sie von einem Agent aufgerufen werden können. Um die Demonstration zu vereinfachen, können Sie das komplexe Modell umgehen und eine kleine Regelgruppe oder synthetische Scoringfunktion direkt verwenden. Die Architektur unterstützt den Austausch in einem ausgeklügelten Modell für maschinelles Lernen später, ohne die Orchestrierung zu ändern.

- Oracle Cloud Infrastructure Language bietet Textanalysen in Fällen, in denen Sie auch unstrukturierte Notizen oder Mitteilungen in einem Betrugsfall analysieren müssen. Für unseren primären Anwendungsfall bieten jedoch strukturierte Daten und LLM die erforderliche Funktionalität.

- Vernetzung und Integration

Die Konfiguration des virtuellen Cloud-Netzwerks (VCN) und ein OCI-Servicegateway stellen sicher, dass der Orchestrator und die Agents, die OCI Functions- und OCI Compute-Instanzen verwenden, sicher mit der Datenbank und den KI-Services kommunizieren können, ohne Daten über das öffentliche Internet verfügbar zu machen. OCI Identity and Access Management (IAM) kontrolliert den Zugriff, sodass nur der Orchestrator und Agents die APIs des anderen aufrufen und auf die Datenbank zugreifen können. Dies ist wichtig für die Aufrechterhaltung der Sicherheit, insbesondere im finanziellen Kontext. Zu Demonstrationszwecken können Sie das Monitoring auch einrichten, indem Sie OCI Logging verwenden, um Agent-Funktionsausführungen zu verfolgen, und OCI Application Performance Monitoring-Traces, um die End-to-End-Flow-Latenz anzuzeigen.

- Clientschnittstelle

Der Benutzer interagiert mit dem System, indem er ein einfaches Web- oder mobiles Frontend verwendet, um das OCI-API-Gateway aufzurufen und eine Analyse auszulösen, oder indem er eine Oracle Digital Assistant-(Chatbot-)Schnittstelle für eine interaktivere Demonstration verwendet. Beispielsweise könnte ein Analyst mit dem Betrugsanalyse-Agent interagieren, indem er einen Chatbot-Prompt wie "Transaktion #123 untersuchen" bereitstellt, und das System reagiert mit der Analyse. Oracle Digital Assistant kann eine optionale Ergänzung sein, um ein dialogorientiertes Frontend zu präsentieren. Im Kernanwendungsfall werden jedoch möglicherweise einfach die Ergebnisse in einem Dashboard angezeigt oder ein E-Mail-Alert mit OCI-Benachrichtigungen gesendet.

Phase 1: Orchestrierung mit MCP implementieren

Bei der ersten Implementierung soll sichergestellt werden, dass das System mehrere Agents orchestrieren und in Oracle-Systeme integriert werden kann, bevor komplexe KI-Logik hinzugefügt wird.

Um dieses Ziel zu erreichen, hebt der Plan die Agent-Orchestrierungsmechanik hervor und nutzt Google MCP Toolbox for Databases (auch als Gen AI Toolbox bezeichnet) als Ausgangspunkt für den Model Context Protocol-(MCP-)Orchestrator. Die Toolbox, eine Open-Source-Codebasis auf GitHub, ist ein MCP-Server für Datenbanken, die LLM-basierte Agents mit SQL-Datenbanken verbinden sollen. Diese Architektur passt die Toolbox für Oracle Cloud Infrastructure (OCI) an, indem Oracle-spezifische Tools integriert und auf OCI bereitgestellt werden.

Phase 1 dieses Plans erstellt ein funktionierendes Orchestrierungs-Backbone auf OCI, das sich erfolgreich in eine Oracle-Datenbank integrieren lässt und einen zentralen MCP-Server (Gen AI Toolbox) umfasst, der mindestens zwei Agents orchestriert (Datenabruf und -analyse). Phase 2 dieses Plans führt fortgeschrittenere Argumentation ein.

- Tooldefinitionen

In Gen AI Toolbox ist ein Tool eine Aktion, die ein Agent ausführen kann, z. B. eine bestimmte SQL-Abfrage. Ein Tool wird deklarativ definiert, beispielsweise mit YAML, und über den MCP-Server aufgerufen. Im aktuellen Anwendungsfall wird eine ähnliche Tool-Registry für Aktionen wie "Aktuelle Transaktionen für Benutzer abrufen" oder "Policy-Details abrufen" erstellt, wobei jede Aktion einer Oracle-Datenbankabfrage oder einem OCI-Funktionsaufruf zugeordnet ist. Mit der Registry kann ein Agent diese Tools nach Namen aufrufen. Der Vorteil eines konfigurationsgesteuerten Ansatzes ist Flexibilität: Sie können neue Tools aktualisieren oder hinzufügen, ohne die gesamte App erneut bereitzustellen. Zu Demonstrationszwecken kann die Orchestrierung in Phase 1 mehr skriptbasiert werden, wobei Tools nacheinander aufgerufen werden, aber die Architektur legt die Grundlage für Phase 2, in der der Agent dynamisch entscheiden kann, welche Tools verwendet werden sollen.

- Orchestrator-Framework

Die Gen AI Toolbox arbeitet mit Agent-Orchestrierungs-Frameworks wie LangChain/Langraph und LlamaIndex AgentWorkflow zusammen. In dieser Implementierung koordiniert der MCP-Server die Reihenfolge der Agent-Aufrufe. Sie können ein Skript für die Orchestrierung erstellen, indem Sie einen einfachen Workflow verwenden, wie den Data Agent aufrufen, dann den Betrugs-Agent aufrufen und dann die Entscheidung angeben. Sie können dies mit benutzerdefiniertem Code oder mit einer vorhandenen Workflow-Library tun. Es ist nützlich, alle Gen AI Toolbox-Clientbibliotheken oder -Muster für die Kontextverwaltung zu nutzen. Der Orchestrator verwendet das Ergebnis des Data Agent als Eingabe für die Prompt-/Eingabestruktur des Betrugs-Agents. Phase 1 stellt sicher, dass der Workflow ordnungsgemäß funktioniert und der Kontext zwischen den Schritten korrekt beibehalten wird. Das Ergebnis ist ein Orchestrierungslayer, der die Ausführung eines Systems aus einem oder mehreren Agents vereinfacht, den Kontext über mehrere Schritte hinweg verwaltet und Multi-Agent-Workflows unterstützt, wie für AgentWorkflow beschrieben, in diesem Fall jedoch mit OCI-Services implementiert.

- Beobachtbarkeit und Logging

Die Gen AI Toolbox bietet integrierte OpenTelemetry-Unterstützung für die Überwachung der Toolnutzung. OCI Logging bietet Logging für jeden Agent- und Toolaufruf, um das Debugging zu unterstützen und Sichtbarkeit für die Aktionen der einzelnen Agents bei Demonstrationen bereitzustellen. Phase 1 kann die OCI-Konsole oder -Logs verwenden, um zu zeigen, wie der Orchestrator eine Funktion zum Abfragen der Datenbank aufruft, was zurückgegeben wurde und wie die Betrugsanalyse durchgeführt wurde. Diese Transparenz spricht Stakeholder an und trägt dazu bei, Vertrauen in die KI-Entscheidungen aufzubauen.

Phase 2: Erweiterte LLM Intelligence implementieren

In der zweiten Phase dieses Plans werden fortgeschrittene Large Language Model-(LLM-)Grundlagen und zusätzliche Agents integriert, um das System autonomer und aufschlussreicher zu machen.

Die grundlegende Architektur bleibt weitgehend die gleiche wie in Phase 1, aber Sie ersetzen oder erweitern einfach die Einbauten von Agenten und fügen neue hinzu. Der MCP-Server ist weiterhin der Integrationskleber, der zwischen dem LLM-Agent und der OCI-Datenbank, den Funktionen usw. vermittelt. Dieser phasenweise Ansatz zeigt inkrementelle Fortschritte, indem zunächst das Rückgrat in OCI mit einfacher Logik demonstriert und dann ein leistungsstarkes LLM integriert wird, um das System bei der Erklärung und Behandlung von Betrugsfällen viel intelligenter zu machen.

- LLM-gesteuerte Agent-Begründung

Anstatt Aktionen in einer festen Reihenfolge auszuführen, verwendet der Betrugsanalyse-Agent in Phase 2 OCI Generative AI und ein LLM, um dynamisch zu entscheiden, welche Tools wann aufgerufen werden sollen. Beispiel: Bei einer unbefristeten Anweisung ("Untersuchen Sie diesen Betrugsanspruch"), könnte die Eingabeaufforderung des Agenten verfügbare Tools (Datenbankabfragen, Sanktionsprüfung usw.) auflisten, und das LLM könnte eine Abfolge von Aufrufen planen. Dies ist vergleichbar mit einem Agent im ReAct-Stil oder mit den Planungsfähigkeiten von LangChain. Der MCP-Orchestrator erleichtert diese Agent-to-Tool-Interaktionen, indem er die Entscheidungen des LLM durch Toolausführungen durchläuft und Ergebnisse zurückgibt. Der Oracle Cloud Infrastructure Generative AI Agents-Service betont die Toolorchestrierung, um komplexe Workflows zu verarbeiten. In der aktuellen Architektur implementieren wir dieses Konzept, indem wir den Ansatz der Gen AI Toolbox mit dem LLM von OCI kombinieren. Sie können Frameworks wie LangChain (unterstützt in Oracle Cloud Infrastructure Data Science) integrieren, um Prompts wie "Tool: GetRecentTransactions(user_id=123)" zu verwalten und LLM-Ausgaben zu parsen, die der Orchestrator ausführen kann. Diese Fähigkeit macht den Betrugsanalysator zu einem kognitiven Agenten, der in der Lage ist, mehrstufige Argumentation zu ermöglichen, die komplexere Dialoge zur Betrugsuntersuchung ermöglicht.

- Zusätzliche Agenten und Tools

Sie können zusätzliche Agents einführen, um die Systemfunktionen zu erweitern. Beispielsweise könnte ein Diagrammanalyse-Agent Netzwerkanalysen wie eine Diagrammdatenbank oder ein ML-Modell verwenden, um Beziehungen zwischen Entitäten zu finden, wie z. B. allgemeine E-Mails oder Geräte über Konten hinweg, die von Betrugsringen verwendet werden. Ein weiterer kann ein Erklärungs-Agent sein, der die Ausgaben speziell auf Compliance prüft oder die Sprache für eine kundenorientierte Erklärung vereinfacht. Jeder Agent verwendet einen bestimmten OCI-Service: Ein Graph-Agent kann Oracle Graph oder eine Netzwerkanalyse-Library in Data Science verwenden. Der MCP-Orchestrator kann diese Agents je nach Bedarf parallel oder nacheinander koordinieren. Beispiel: Nachdem der Betrugsanalyse-Agent abgeschlossen ist, kann der Orchestrator einen Benachrichtigungs-Agent auslösen, der OCI Email Delivery oder OCI Notifications verwendet, um einen Bericht an Ermittler zu senden. Der Orchestrator fungiert als Dirigent: Das Hinzufügen weiterer Agents bereichert das Analyseorchester, ohne dass die Kernlogik neu geschrieben werden muss.

- Feedbackschleife für maschinelles Lernen

Phase 2 kann das Lernen im Laufe der Zeit integrieren. Alle Ergebnisse, unabhängig davon, ob Betrug bestätigt wurde oder nicht, können in ein Oracle Autonomous Data Warehouse eingespeist und mithilfe von Data Science-Pipelines zum Nachtrainieren von Modellen genutzt werden. Obwohl sie nicht Teil der Echtzeit-Agent-Orchestrierung ist, schließt sie die Schleife im Lebenszyklus der Lösung. Indem Sie zeigen, dass OCI nicht nur die Erkennung durchführen, sondern sie auch verbessern kann, indem Sie historische Daten mit AutoML oder Oracle Machine Learning verwenden, können Sie Stakeholdern eine kontinuierliche Verbesserung zeigen.