HPC-Clusterstack aus Oracle Cloud Marketplace konfigurieren

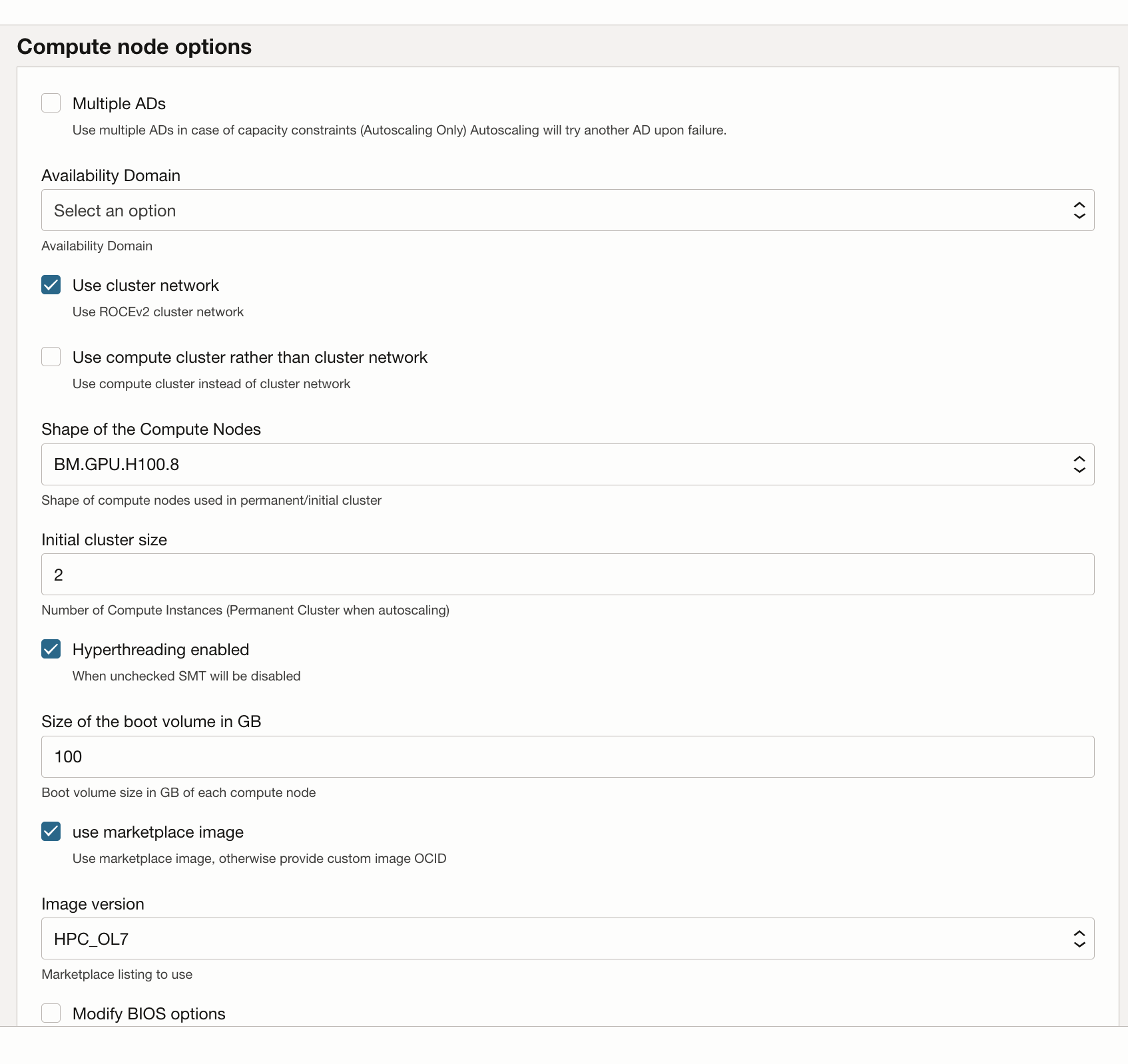

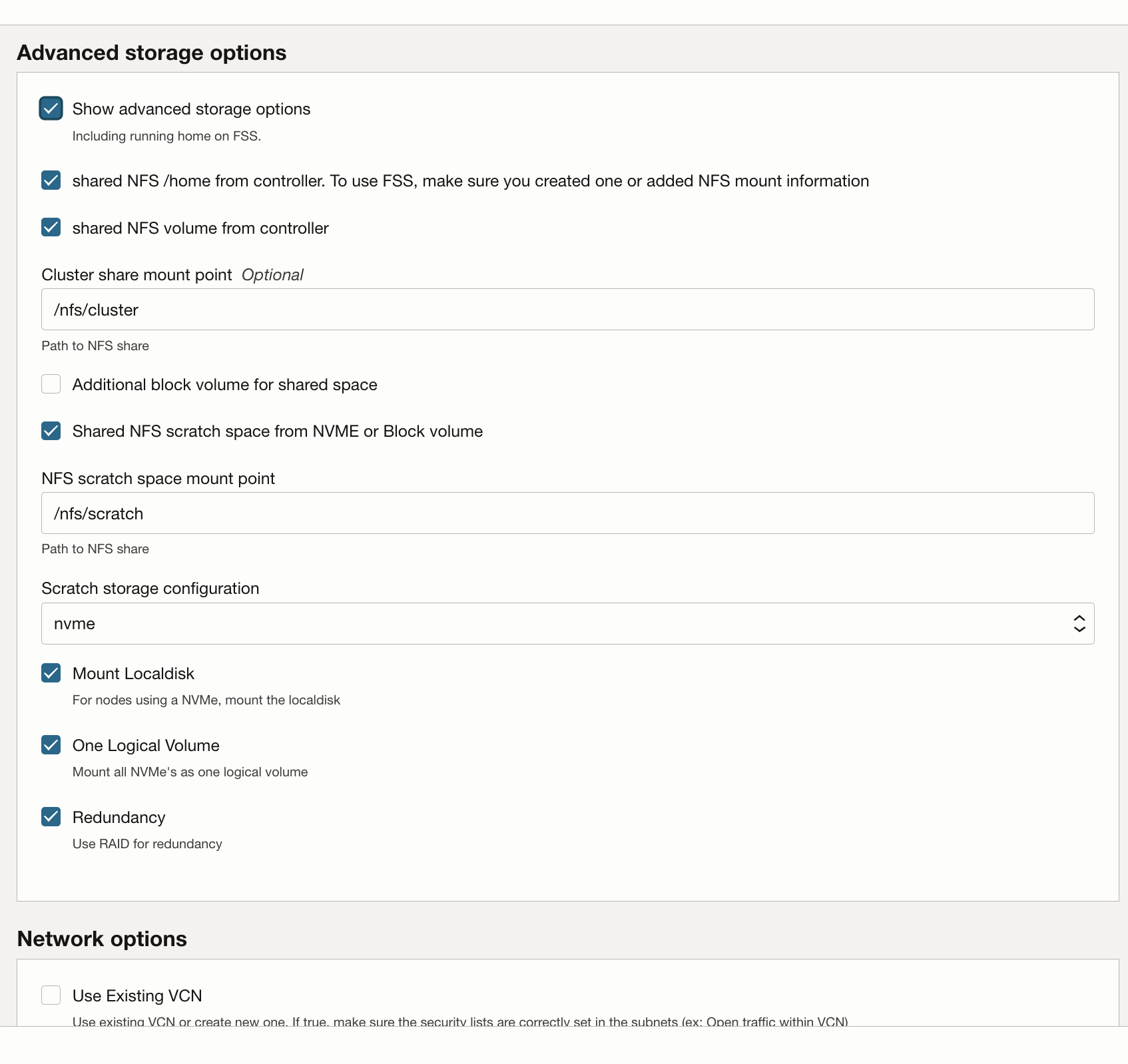

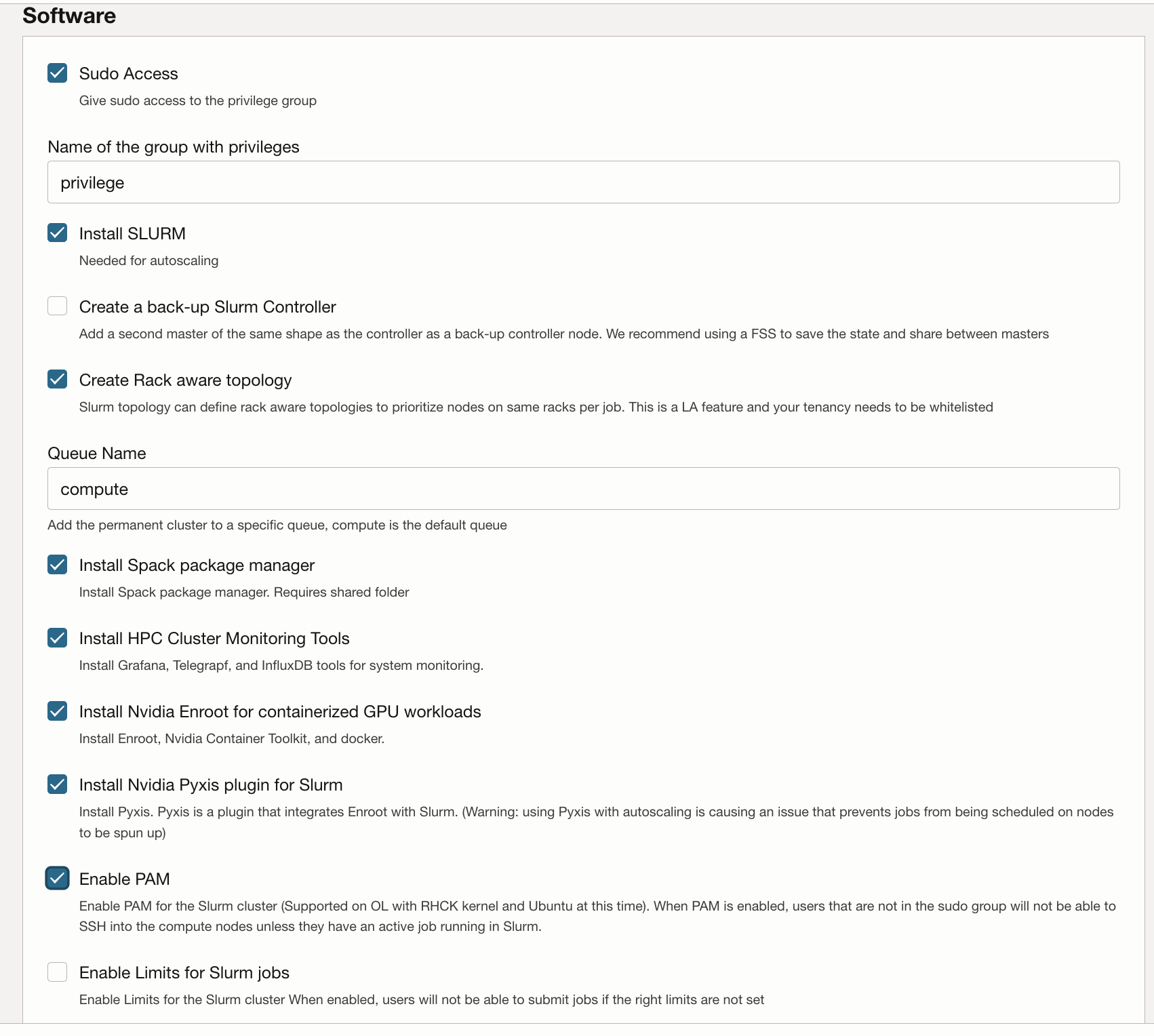

Der HPC-Clusterstack verwendet Terraform, um Oracle Cloud Infrastructure-Ressourcen bereitzustellen. Der Stack erstellt GPU-Knoten, Speicher, Standardnetzwerke und Hochleistungsclusternetzwerke sowie einen Bastion-/Kopfknoten für den Zugriff auf und die Verwaltung des Clusters.

GPU-Cluster bereitstellen

Ihr Oracle Cloud-Account muss zu einer Gruppe mit der Berechtigung zum Deployment und zur Verwaltung dieser Ressourcen gehören. Weitere Informationen zu Policy-Anforderungen finden Sie unter Verwendungsanweisungen für HPC-Cluster.

Sie können den Stack in einem vorhandenen Compartment bereitstellen. Möglicherweise ist er jedoch sauberer, wenn Sie ein Compartment speziell für das Cluster erstellen.

Hinweis:

Die Verwendung des Marketplace-Stacks für das Provisioning einer Umgebung ist zwar kostenlos, die bereitgestellten Ressourcen werden jedoch beim Starten des Stacks in Rechnung gestellt.- Erstellen Sie ein Compartment für Ihren Mandanten und Ihre Region, und prüfen Sie, ob Policys verfügbar sind.

- Verwenden Sie den HPC-Clusterstack, um das GPU-Cluster bereitzustellen.