Für Disaster Recovery konfigurieren

Mit den in diesem Lösungs-Playbook bereitgestellten Skripten können Sie einen YAML-Snapshot in einem primären Kubernetes-Cluster erstellen und in einem anderen (sekundären) Kubernetes-Cluster wiederherstellen. Es ist wichtig, die Konfiguration zu planen und die Anforderungen zu verstehen, bevor Sie den YAML-Snapshot herunterladen und mithilfe der Skripte konfigurieren.

Hinweis:

Bei dieser Lösung wird davon ausgegangen, dass beide Kubernetes-Cluster, einschließlich des Kontrollplans und der Worker-Knoten, bereits vorhanden sind.Konfiguration planen

Planen Sie die Ressourcen und die Konfiguration auf dem sekundären System basierend auf dem primären System. Die Skripte erfordern, dass beide Kubernetes-Cluster bereits vorhanden sind. Sie müssen mit dem Kubernetes-Befehlszeilentool

kubectl auf beide Cluster zugreifen können, um Befehle für sie auszuführen.

Hinweis:

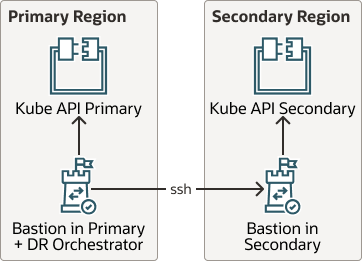

Bei dieser Lösung wird davon ausgegangen, dass beide Kubernetes-Cluster, einschließlich des Kontrollplans und der Worker-Knoten, bereits vorhanden sind. Die in diesem Handbuch bereitgestellten Empfehlungen und Skripte prüfen keine Ressourcen, Control Plane oder Worker-Knotenkonfiguration.Das folgende Diagramm zeigt, dass Sie den Artefakt-Snapshot bei der Konfiguration in völlig anderen Kubernetes-Clustern wiederherstellen können.

Beschreibung der Abbildung kube-api-dr.png

Befolgen Sie die folgenden Anforderungen für Restore bei der Konfigurationsplanung:

Verifizieren

Nachdem Sie das Skript

maak8DR-apply.sh ausgeführt haben, prüfen Sie, ob alle Artefakte, die im primären Cluster vorhanden waren, im sekundären Cluster repliziert wurden. Prüfen Sie das sekundäre Cluster, und prüfen Sie, ob die Pods auf der sekundären Site fehlerfrei ausgeführt werden.

Wenn Sie das Skript maak8DR-apply.sh ausführen, erstellt das Framework das Verzeichnis working_dir als /tmp/backup.date. Wenn Sie die Skripte maak8-get-all-artifacts.sh und maak8-push-all-artifacts.sh einzeln ausführen, wird das Arbeitsverzeichnis jeweils als Argument in der Befehlszeile bereitgestellt.