Data Lakehouse planen

Berücksichtigen Sie bei der Planung des Data Lakehouse die folgenden relevanten Anwendungsfälle für Banken, Broker und Finanzdienstleistungen mit Milliarden von Datensätzen:

- Erstellen Sie einen unternehmensweiten Data Hub, der aus einem Data Warehouse für strukturierte Daten und einem Data Lake für halbstrukturierte und unstrukturierte Daten besteht. Dieses Data Lakehouse wird zur Single Source of Truth für Ihre Daten.

- Integrieren Sie relationale Datenquellen mit anderen unstrukturierten Datasets mithilfe von Big Data-Verarbeitungstechnologien.

- Vereinfachen Sie die Datenanalyse mit semantischen Modellierungs- und leistungsstarken Visualisierungstools.

Business-Anwendungsfälle verstehen

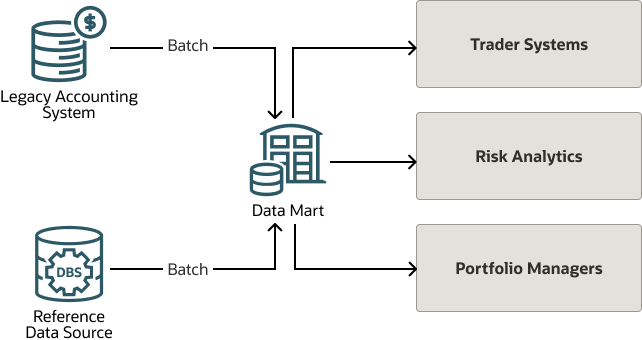

Im Folgenden wird die allgemeine Ansicht eines Fondsauswertungssystems dargestellt, das ein Legacy-Rechnungssystem verwendet, um die Bewertungsdaten in Batches für einen Data Mart bereitzustellen.

Der Data Mart ruft auch Batchreferenzdaten aus anderen Referenzdatenquellen ab. Der Data Mart überträgt die Fondsbewertungsdaten in Batches an die nachgelagerten Systeme im Workflow.

Da die Preisgestaltung statisch erfolgt, normalerweise am Ende des Tages, ist das Legacy-System, selbst wenn alle Systeme in Ordnung sind, nicht so responsiv, wie es die Benutzer benötigen.

Zum Beispiel waren im zweiten Quartal 2022 alle Benutzergruppen auf hohem Niveau, und alle wollten den neuesten Preis und Marktwert kennen, damit sie die Haltepositionen des ganzen Tages identifizieren konnten. Die Erfassung des aktuellen Preises und die Erzielung des Marktwerts in Echtzeit war eine große Bitte um ein traditionelles Fondsbewertungssystem.

Um den aktuellen Preis zu erfassen und den Marktwert in Echtzeit zu erhalten, muss das Legacy-Rechnungssystem den aktuellen Preis erfassen, die Daten in den Data Mart übertragen und die Batchworkflows mehrmals täglich wiederholen, was weder reaktionsfähig noch nachhaltig ist.

Die Lösung verstehen

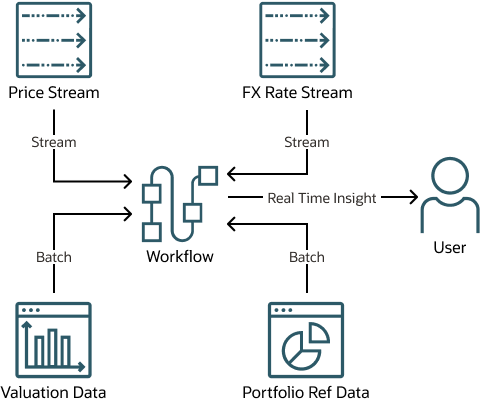

Für die Lösung sind keine Änderungen am Legacy-System erforderlich, die weiterhin Batchbewertungsdaten wie immer veröffentlichen.

Echtzeitpreise und Wechselkurse werden aus den jeweiligen Streams erfasst und auf die Preise angewendet, um den Marktwert in verschiedenen Währungen zu finden.

Eine serverlose Oracle Cloud Infrastructure-Architektur unterstützt Batch- und Echtzeitdaten. Batchdaten umfassen einen Snapshot-Ablauf für Portfolioreferenzdaten, inkrementelles Delta und Change Data Capture-(CDC-)Ablauf für Bewertungsdaten. Echtzeitdaten umfassen Preis- und Wechselkursströme. Die Architektur umfasst einen Prozess zum Sortieren von Batch- und Echtzeitdaten, um den Echtzeitpreis, den Marktwert in der Basiswährung und den Marktwert in Fremdwährungen zu erhalten.

Beispielarchitektur

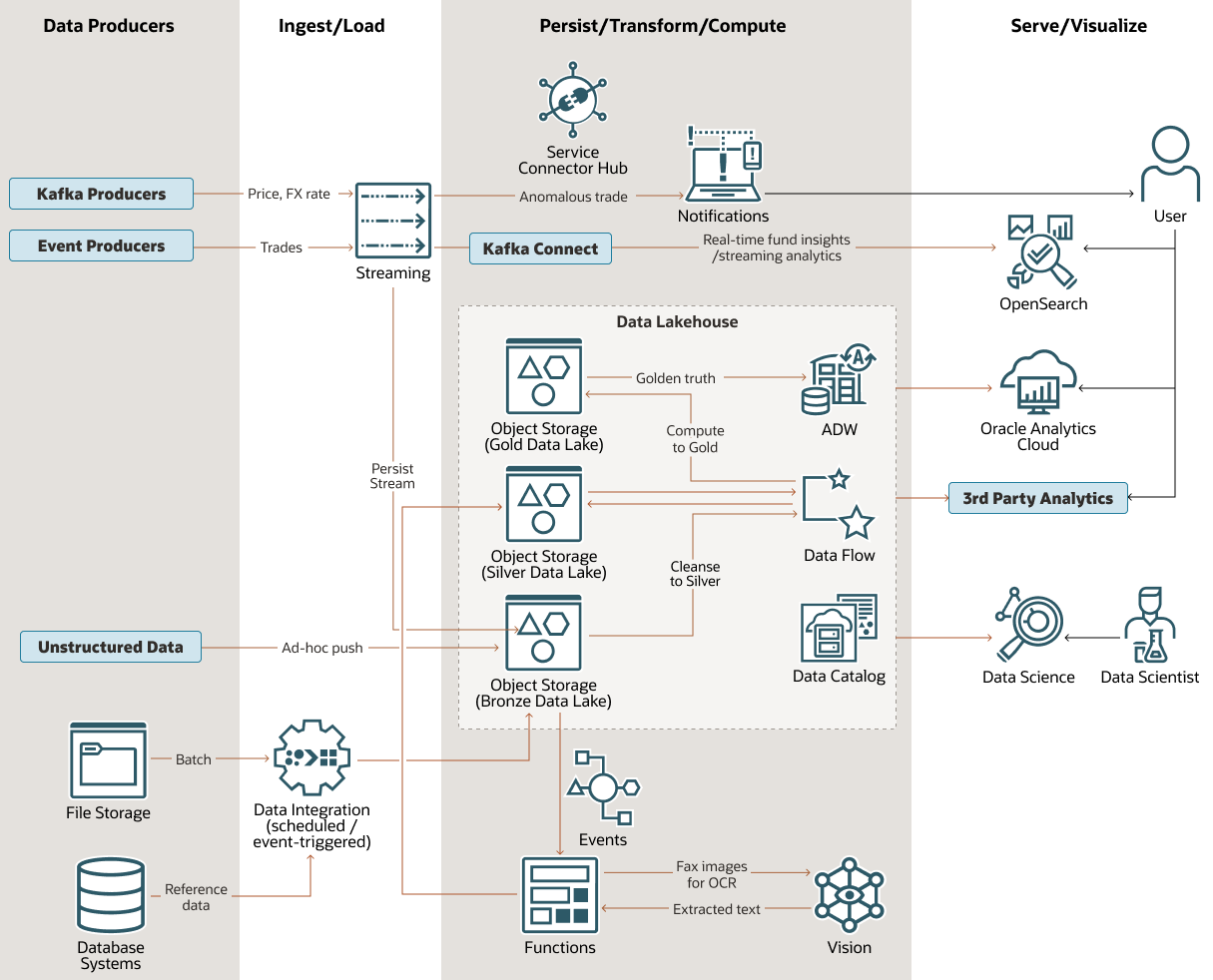

Das folgende Diagramm zeigt eine vom Kunden inspirierte, moderne Datenplattformarchitektur auf Oracle Cloud Infrastructure (OCI).

Diese Architektur kann für finanzielle Anwendungsfälle verwendet werden, beispielsweise für das Gewinnen von Echtzeit-Fondseinblicken, das Erkennen ungewöhnlicher Trades sowie für allgemeine Finanzdatenbereinigung, Aggregation und Visualisierung.

OCI-Fund-lakehouse-arch-oracle.zip

Eines der zentralen Features dieser Architektur ist das mehrstufige Data Lakehouse. Sie besteht aus drei verschiedenen Ebenen der Datenverarbeitung im Data Lake, Oracle Autonomous Data Warehouse (ADW) für strukturiertes Warehousing, Oracle Cloud Infrastructure Data Catalog für Metadaten und Governance und Data Flow für Big Data-Verarbeitung und -Transformation mit Spark-Jobs.

Der Bronzedatensee ist das erste Ziel für Daten in einem Format, das oft roh oder in der Nähe ist. Dazu gehören Daten aus OCI und Daten aus externen Plattformen. Oracle Data Integration (ODI) ist eines der Tools, die für diese Integration verwendet werden.

Die Datenflussanwendung verarbeitet die meisten Datentransformationen und Bereinigungen von bronze-zu-silver. Oracle Cloud Infrastructure Vision extrahiert Text aus Faxbildern mit OCR-Technologie (Optical Character Recognition). Die Ausgabedaten (Text) von Vision werden mit Hilfe von Oracle Functions vom Bronze-See an den Silbersee gesendet.

Data Flow führt eine zusätzliche Datentransformation von der Silbersee-Tier zum Gold-Data Lake durch, in den die Daten in ADW geladen werden, was wiederum Oracle Analytics Cloud- und 3rd-Party-Analysen und Visualisierungstools bereitstellt.

Die Architektur umfasst die folgenden zusätzlichen Features:

- Anomale Handelsbenachrichtigungen werden mit OCI Streaming- und OCI-Benachrichtigungen bereitgestellt, die mit OCI Service Connector Hub integriert sind.

- Streaminganalysen werden mit Kafka Connect für Echtzeit-Fondseinblicke bereitgestellt, indem OCI Streaming-Daten mit OpenSearch an OCI Search Service gesendet werden. OpenSearch Dashboards, eine integrierte Komponente des OCI-Suchservice, können eine direkte Visualisierung von OpenSearch-Daten ermöglichen.

- Data Scientists können das Data Lakehouse mit OCI Data Science untersuchen, einer vollständig verwalteten und serverlosen Plattform, mit der Sie ADW, Object Storage, Drittanbieter-Clouds und ordnungsgemäß verbundene On-Premise-Systeme abfragen können.