Implementierung der Oracle Modern Data Platform für Geschäftsberichte und Prognosen

In diesem Abschnitt wird beschrieben, wie Sie OCI-Services bereitstellen, den Anwendungsfall implementieren, Daten visualisieren und Prognosen erstellen.

OCI-Services bereitstellen

Im Folgenden werden die wichtigsten Schritte zum Provisioning von Ressourcen für eine einfache Demo dieses Anwendungsfalls erläutert.

Implementieren Sie den Anwendungsfall Oracle Modern Data Platform

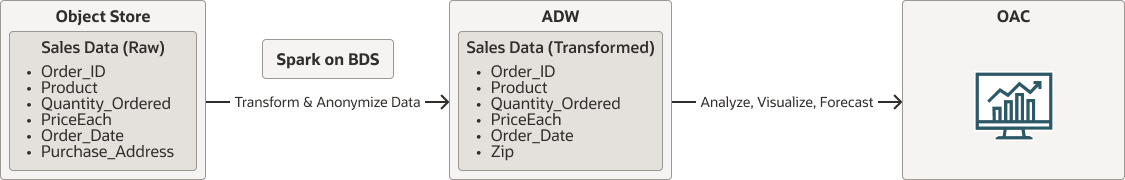

Bevor wir uns mit den Implementierungsdetails befassen, betrachten wir den gesamten Ablauf.

- Rohdaten befinden sich in OCI Object Storage.

- Spark, das nativ in Oracle Big Data Service ausgeführt wird, liest Daten aus OCI Object Storage. Es bereinigt, transformiert und anonymisiert Daten und persistiert Daten schließlich in Autonomous Data Warehouse.

- Benutzer können mit Oracle Analytics Cloud Daten visualisieren und Prognosen erstellen.

oci-modern-data-reporting-flow-oracle.zip

Hinweis:

Der gewählte Datenfluss ist ein vereinfachtes Beispiel, tatsächliche Geschäftsanwendungsfälle können mit größerer Beteiligung erwartet werden.Im folgenden Abschnitt wird beschrieben, wie Sie Beispieldaten hochladen, OCI Object Storage und Oracle Big Data Service konfigurieren und einen einfachen Spark-Scala-Job aufrufen, um Daten zu transformieren und in Autonomous Data Warehouse zu verschieben