-

En la consola, vaya a la página Aplicaciones de Data Flow.

-

Seleccione Iniciar editor de código.

Se abre el editor de códigos.

-

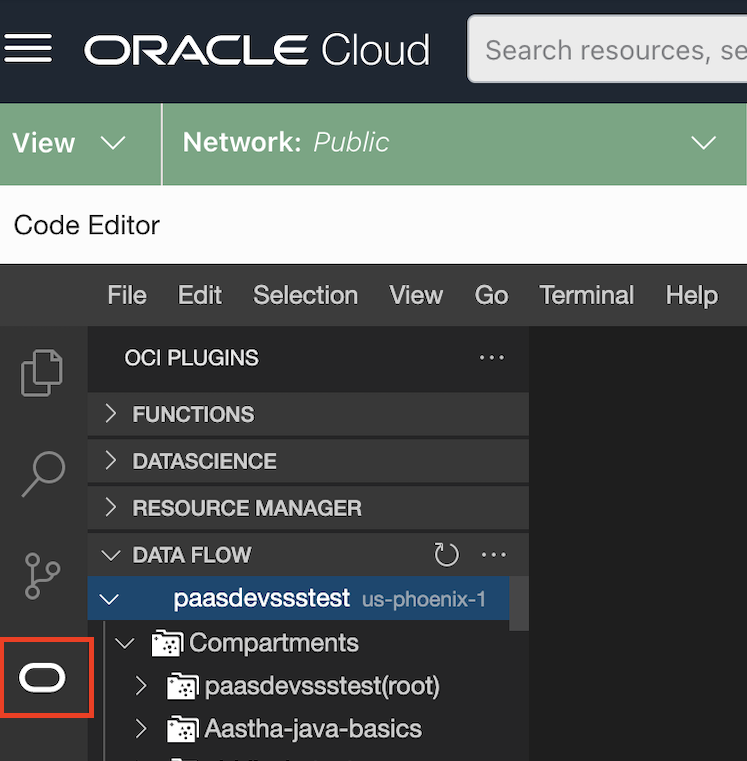

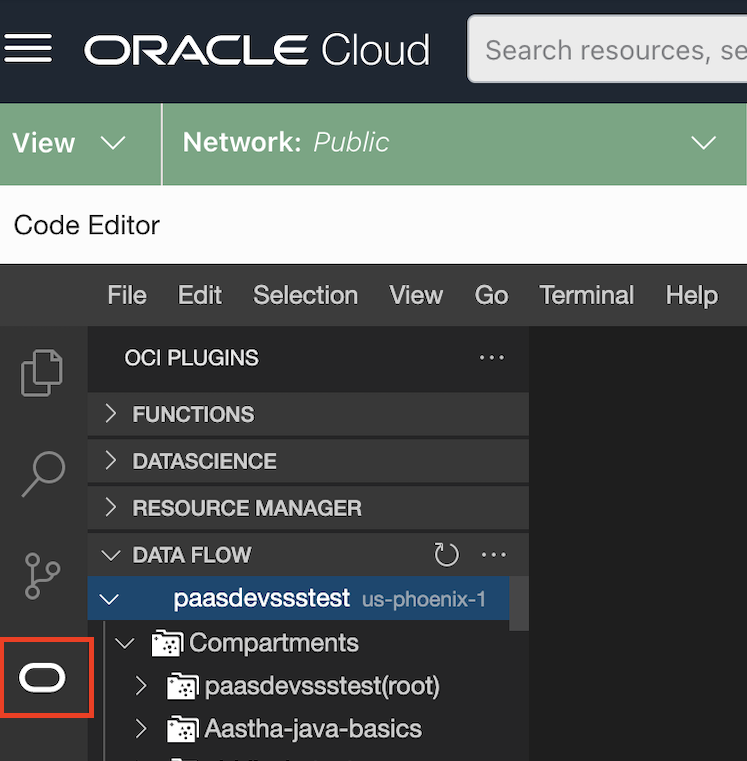

Seleccione el logotipo de Oracle O.

Se muestra una lista de plugins disponibles.

-

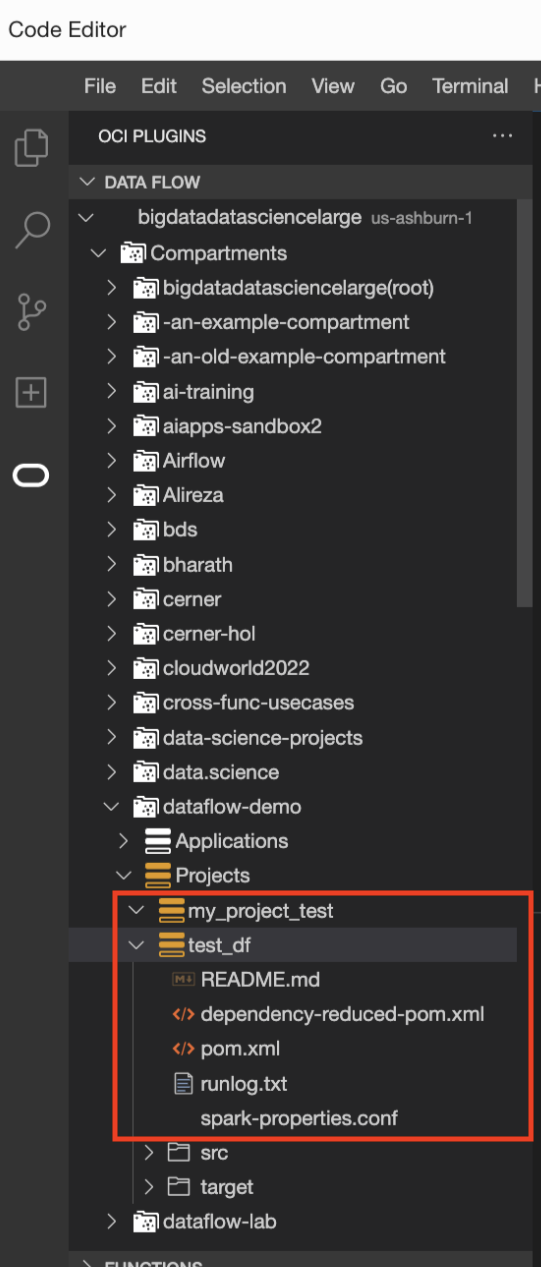

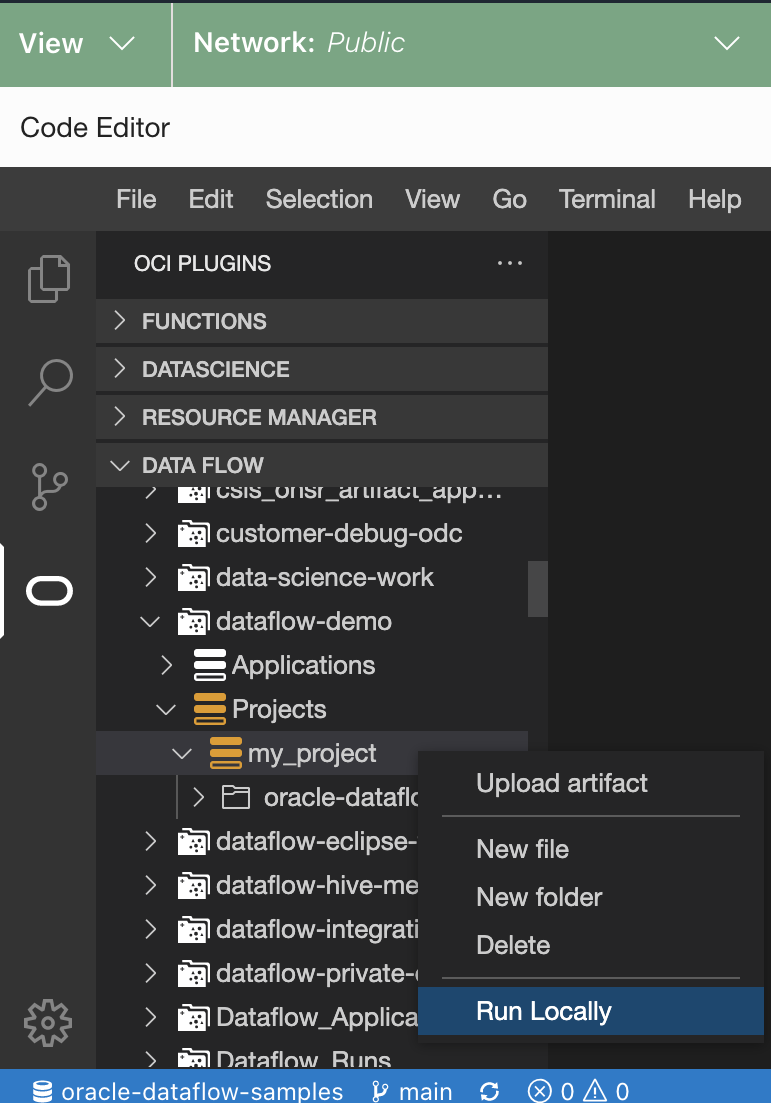

Seleccione el plugin DATA FLOW.

Se amplía para mostrar todos los compartimentos y proyectos que contiene.

-

Vaya a la ubicación en la que se almacenan las aplicaciones. Puede ser un repositorio local o de red.

-

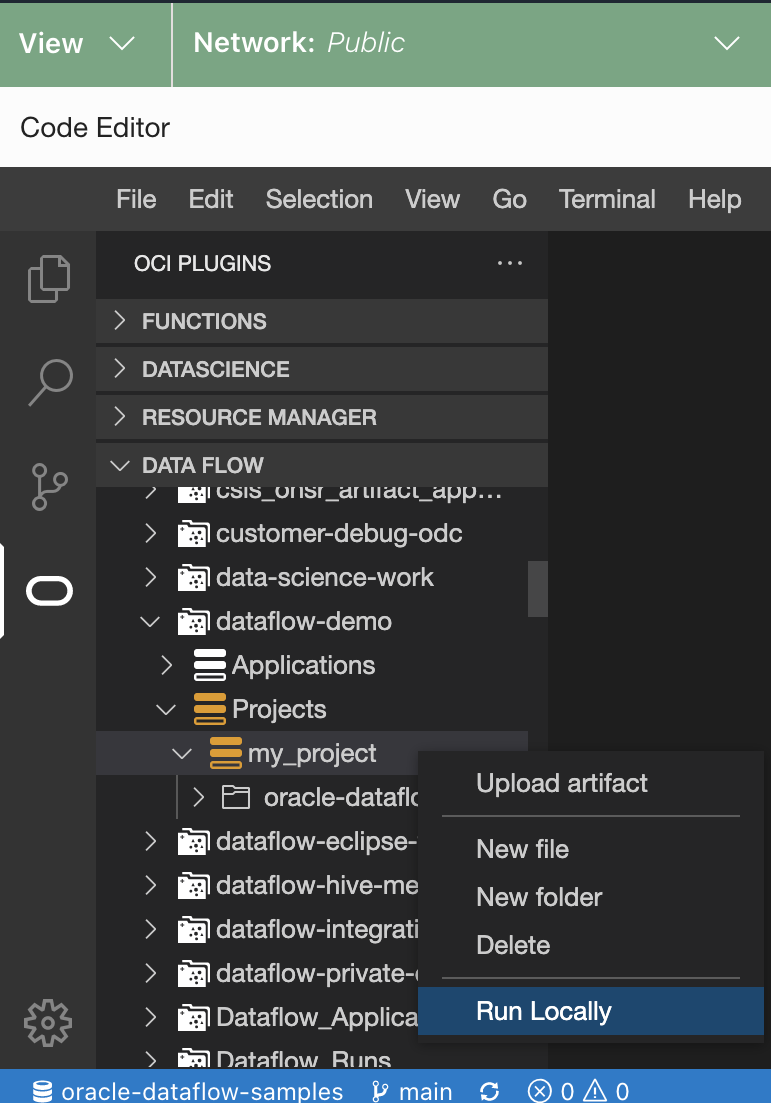

Haga clic con el botón derecho en el proyecto que desea ejecutar y seleccione Ejecutar localmente.

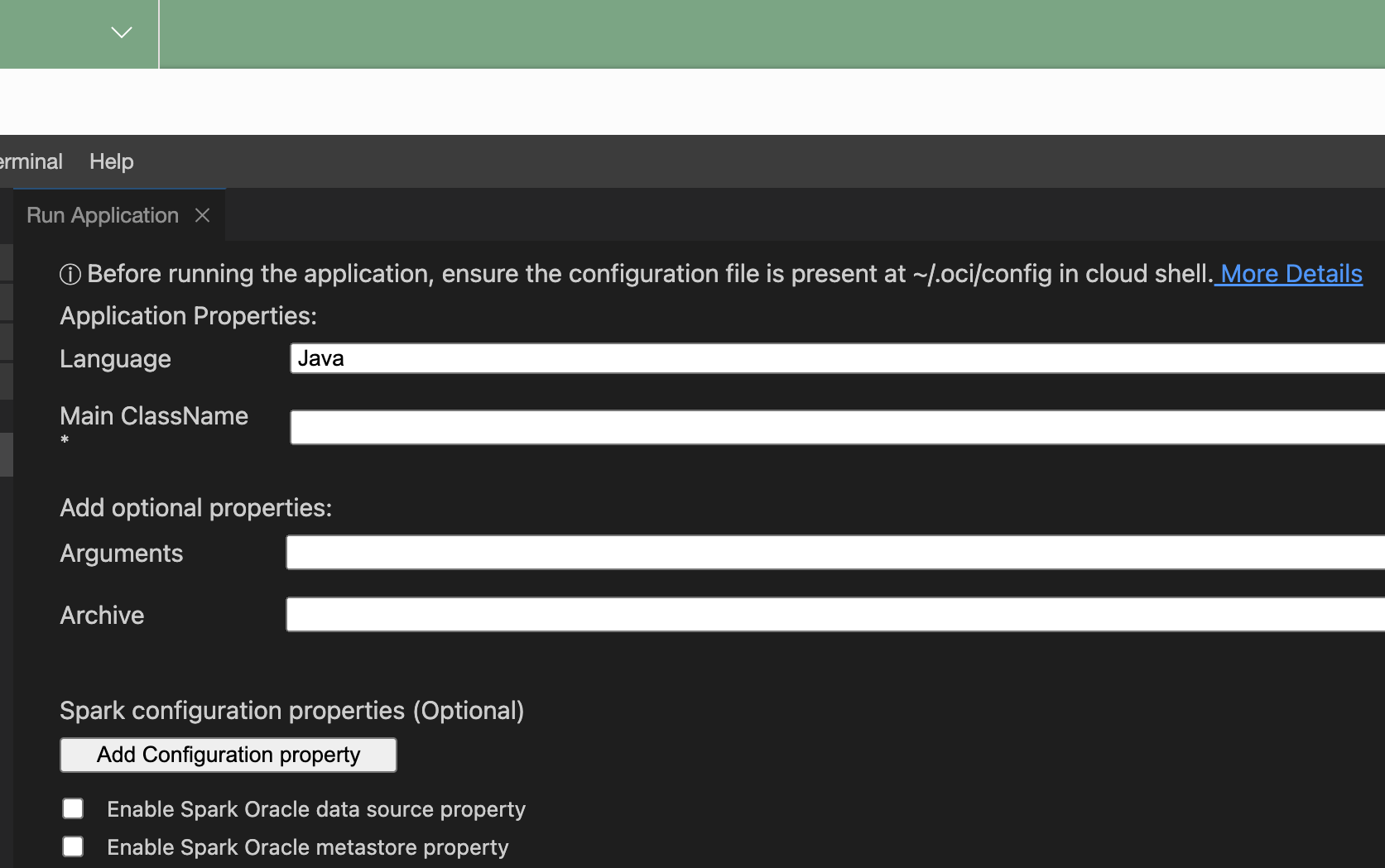

Se abre la ventana Ejecutar aplicación.

-

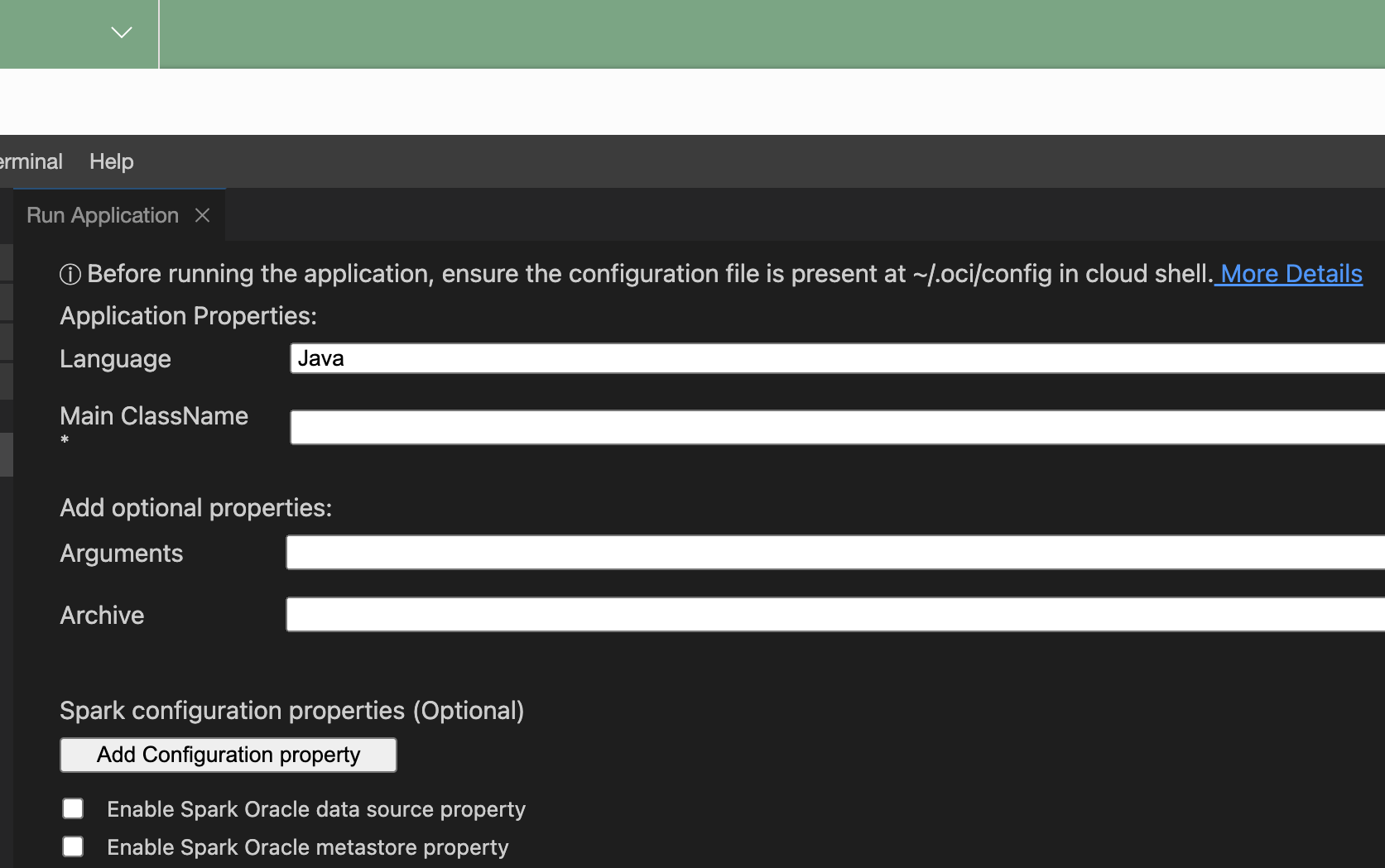

Proporcione las siguientes propiedades de aplicación:

-

Idioma: uno de Java, Python o Scala.

-

Principal ClassName: nombre de clase principal ejecutado en el proyecto. Para Python, es Nombre de archivo principal.

-

Argumentos: argumentos de línea de comandos esperados por la aplicación Spark.

-

conf: cualquier configuración adicional para que se ejecute la aplicación.

-

jars: archivo JAR de terceros que necesita la aplicación.

- Compruebe Activar propiedad de origen de datos de Oracle de Spark para utilizar el origen de datos de Oracle de Spark.

- Compruebe Activar propiedad de metastore de Oracle de Spark para utilizar un metastore.

- Seleccione un compartimento.

- Seleccione un Metasore.

-

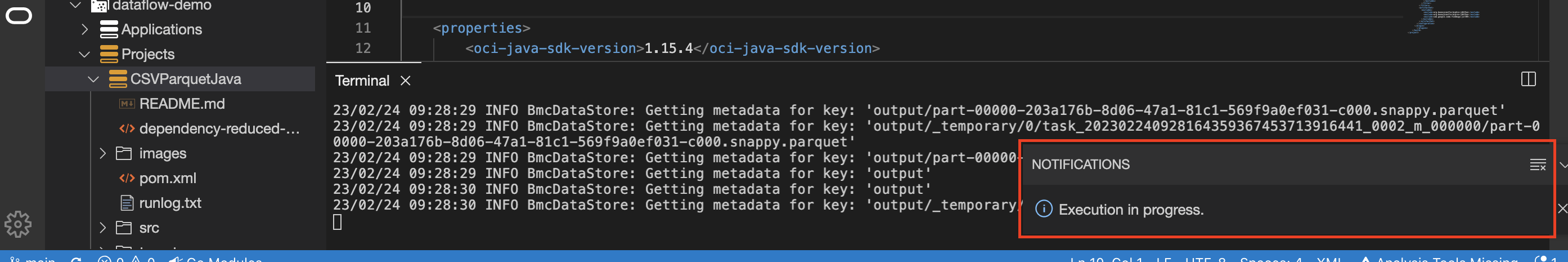

Seleccione Ejecutar.

El plugin Data Flow empaqueta la aplicación y la ejecuta.

- (Opcional) Compruebe el estado de la aplicación desde la bandeja de notificaciones. Al seleccionar la bandeja Notificaciones, se proporciona información de estado más detallada.

- (Opcional) Seleccione runlog.txt para comprobar los archivos log.

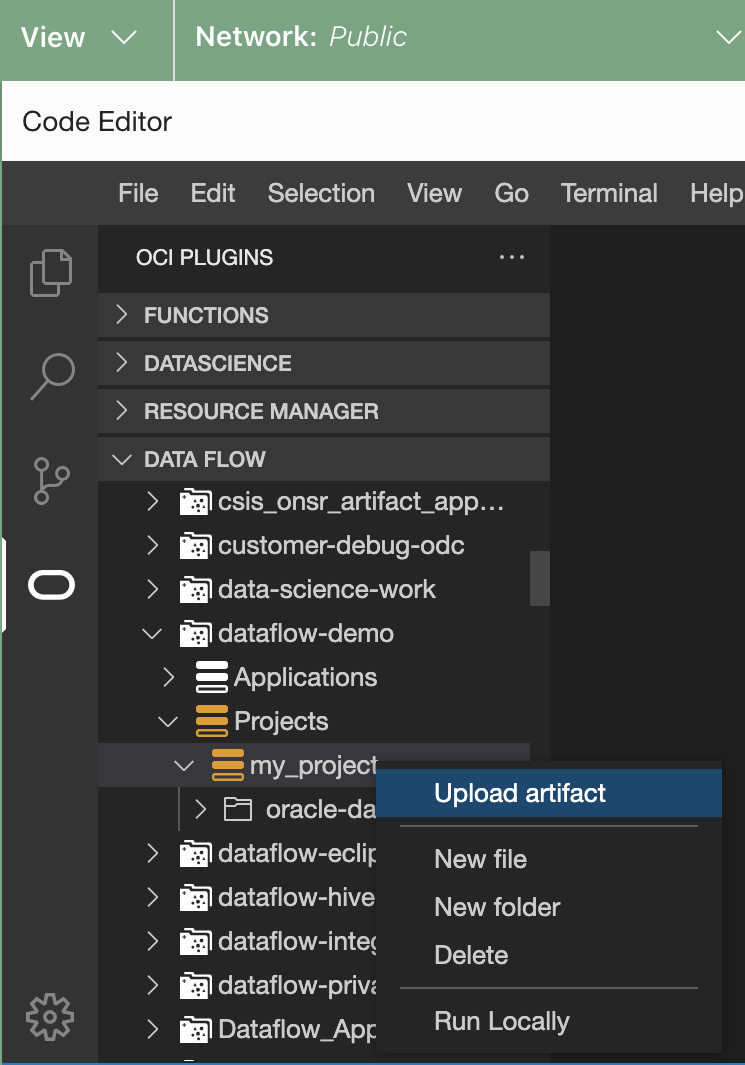

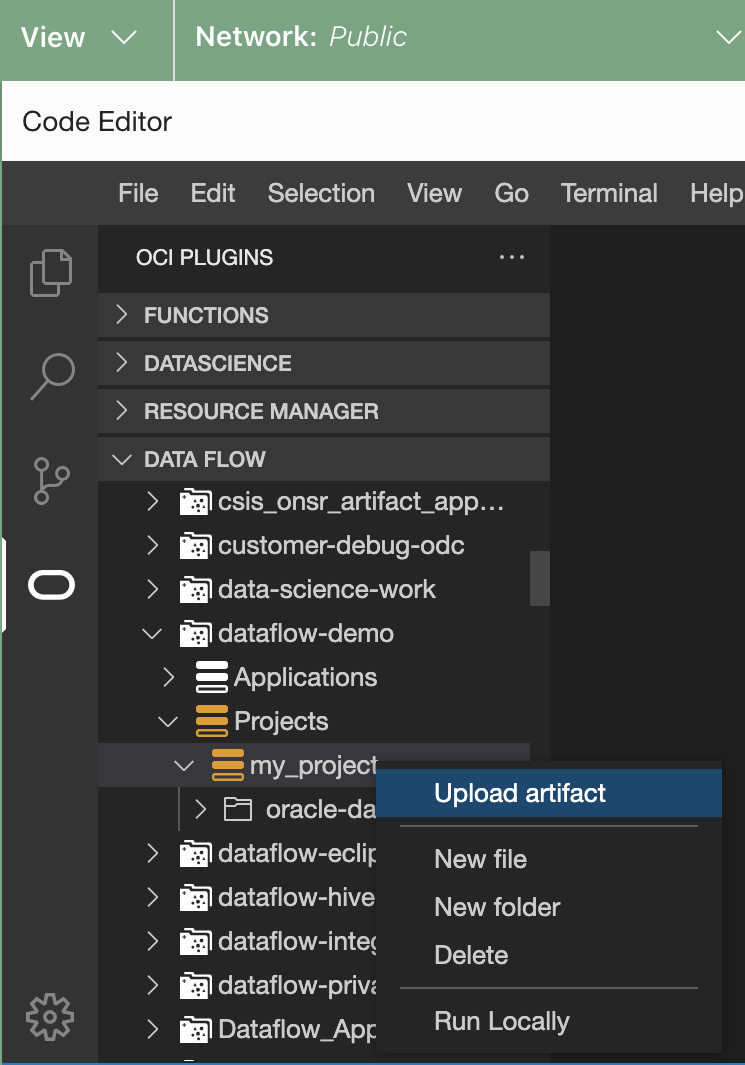

- (Opcional) Cargue el artefacto en Data Flow.

- Haga clic con el botón derecho en el proyecto en cuestión.

- Seleccione Cargar artefacto.

- Seleccione el idioma.

- Introduzca el espacio de nombres de Object Storage.

- Introduzca el nombre del cubo.

Se abre la ventana Ejecutar aplicación.

Se abre la ventana Ejecutar aplicación.