Regresión lineal

Las medias y los máximos se encuentran en los datos no procesados diarios o en los datos no procesados por horas, según el contexto de tiempo global de la siguiente manera: los agregados por hora se utilizan cuando el período de tiempo está dentro de los últimos siete días; de lo contrario, se utilizan los agregados diarios.

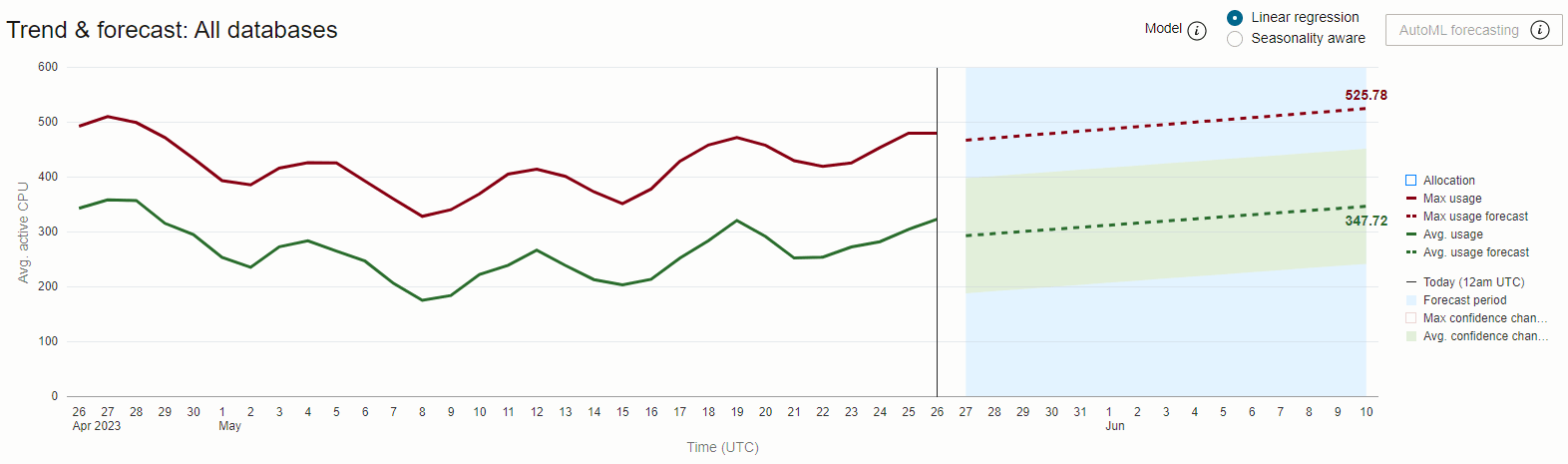

Los períodos de previsión se definen en la 1⁄2 del período de tiempo de tendencia, por ejemplo: las tendencias de 30 días se proyectan a 15 días, mientras que las tendencias de 90 días a 45 días.

En el gráfico anterior se muestra el uso medio diario y máximo de CPU durante 30 días para la base de datos HR-Dev. Observamos una brecha consistente y considerable entre la serie de datos de uso medio y uso máximo, lo que indica un alto nivel de variabilidad en la demanda de CPU durante el día.

La tendencia y la previsión de uso máximo están muy cerca o tocando la asignación máxima para la base de datos, lo que indica un riesgo de agotamiento de la capacidad si la demanda aumenta o si se introduce una nueva carga de trabajo.

La diferencia entre el uso máximo de previsión (~29 CPU activa media) y el uso medio de previsión (~15 CPU activa media) es la diferencia entre la cantidad de CPU necesaria para ejecutar todo el trabajo de forma segura y la cantidad de CPU realmente necesaria para realizar todo el trabajo. Cuando los recursos de CPU se "asignan de forma fija" a las bases de datos, esta diferencia representa la cantidad de recurso que se paga menos la cantidad de recurso que se utiliza y, por lo tanto, es un costo de oportunidad inducido por tener una demanda de CPU muy variable.

Una posible manera de mitigar este costo imputado de variabilidad es compartiendo recursos de CPU entre varias bases de datos y permitiendo la asignación dinámica de recursos entre ellas en respuesta a los cambios en la demanda.

Oracle Autonomous AI Database con opción Escala automática activada ofrece precisamente esta solución.