Replicación de datos entre bases de datos en la nube de la misma región

Descubra cómo configurar Oracle Cloud Infrastructure GoldenGate para replicar datos entre dos base de datos de IA autónoma.

Descripción general

Oracle Cloud Infrastructure GoldenGate permite replicar bases de datos soportadas dentro de la misma región. Los siguientes pasos le guiarán a través del proceso para instanciar una base de datos de destino mediante Oracle Data Pump y replicar datos del origen en el destino.

Este inicio rápido también está disponible como LiveLab: Ver el taller.

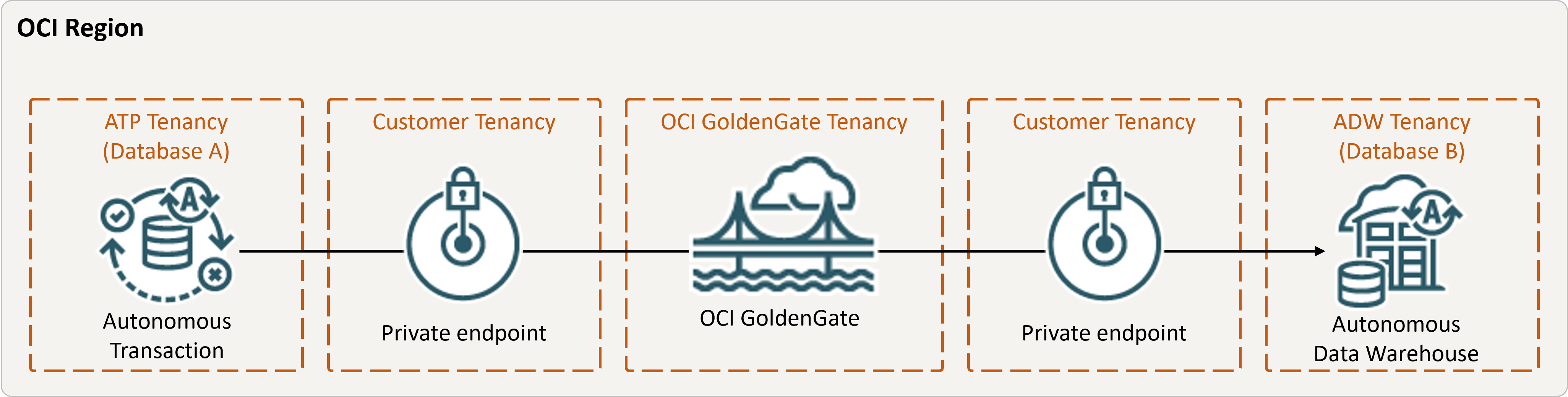

Descripción de la ilustración same-region.png

Antes de empezar

Para continuar, debe tener lo siguiente:

- Una base de datos de origen existente

- Una base de datos destino existente

- La base de datos de origen y destino deben estar en un único arrendamiento, en la misma región

- Si necesita datos de ejemplo, descargue Archive.zip y, a continuación, siga las instrucciones de Laboratorio 1, Tarea 3: Carga del esquema ATP.

Tarea 2: Creación del Extract integrado

Un Extract integrado captura los cambios en curso en la base de datos de origen.

Tarea 3: Exportación de datos mediante Oracle Data Pump (ExpDP)

Utilice Oracle Data Pump (ExpDP) para exportar datos de la base de datos de origen a Oracle Object Store.

Tarea 4: Instanciación de la base de datos de destino mediante Oracle Data Pump (ImpDP)

Utilice Oracle Data Pump (ImpDP) para importar datos a la base de datos de destino desde SRC_OCIGGLL.dmp que se ha exportado de la base de datos de origen.