Note:

- Este tutorial está disponible en un entorno de prácticas gratuito proporcionado por Oracle.

- Utiliza valores de ejemplo para credenciales, arrendamiento y compartimentos de Oracle Cloud Infrastructure. Al finalizar la práctica, sustituya estos valores por otros específicos de su entorno en la nube.

Migración de Oracle Linux Automation Manager a un despliegue en cluster

Introducción

Ya sea actualizando desde una versión anterior o comenzando con una instalación de un solo host, ambos entornos pueden migrar a un despliegue en cluster. Los administradores deben planificar su topología antes de la migración, ya que el cluster puede constar de una combinación de nodos Plano de control, Ejecución y Salto y una base de datos remota.

Después de seguir este tutorial, sabrá cómo migrar una instalación de host único a un despliegue en cluster con una base de datos remota.

Objetivos

En este tutorial, aprenderá a:

- Configurar una base de datos remota

- Migrar a un despliegue en cluster

Requisitos

-

Un sistema con Oracle Linux Automation Manager instalado.

Para obtener detalles sobre la instalación de Oracle Linux Automation Manager, consulte la Guía de instalación de Oracle Linux Automation Manager.

Despliegue de Oracle Linux Automation Manager

Nota: Si se ejecuta en su propio arrendamiento, lea el proyecto linux-virt-labs GitHub README.md y complete los requisitos antes de desplegar el entorno de prácticas.

-

Abra un terminal en el escritorio Luna.

-

Clone el proyecto

linux-virt-labsGitHub.git clone https://github.com/oracle-devrel/linux-virt-labs.git -

Cambie al directorio de trabajo.

cd linux-virt-labs/olam -

Instale las recopilaciones necesarias.

ansible-galaxy collection install -r requirements.yml -

Actualice la configuración de la instancia de Oracle Linux.

cat << EOF | tee instances.yml > /dev/null compute_instances: 1: instance_name: "olam-node" type: "control" 2: instance_name: "exe-node" type: "execution" 3: instance_name: "db-node" type: "db" passwordless_ssh: true add_cluster_ports: true EOF -

Despliegue el entorno de prácticas.

ansible-playbook create_instance.yml -e ansible_python_interpreter="/usr/bin/python3.6" -e "@instances.yml" -e olam_single_host=trueEl entorno de prácticas gratuito necesita la variable adicional

ansible_python_interpreterporque instala el paquete de RPM para el SDK para Python de Oracle Cloud Infrastructure. La ubicación de la instalación de este paquete está en los módulos python3.6.La unidad de despliegue por defecto utiliza la CPU AMD y Oracle Linux 8. Para utilizar una CPU de Intel u Oracle Linux 9, agregue

-e instance_shape="VM.Standard3.Flex"o-e os_version="9"al comando de despliegue.Importante: Espere a que el cuaderno de estrategias se ejecute correctamente y alcance la tarea de pausa. La instalación de Oracle Linux Automation Manager se ha completado en esta etapa del manual y las instancias están listas. Tome nota de la reproducción anterior, que imprime las direcciones IP públicas y privadas de los nodos que despliega.

Conéctese a WebUI

-

Abra un terminal y configure un túnel SSH a Oracle Linux Automation Manager.

ssh -L 8444:localhost:443 oracle@<hostname_or_ip_address>En el entorno de prácticas gratuito, utilice la dirección IP externa de la instancia del nodo olam.

-

Abra un explorador web e introduzca la URL.

https://localhost:8444Nota: Apruebe la advertencia de seguridad según el explorador utilizado. Para Chrome, haga clic en el botón **Avanzado y, a continuación, en el enlace Continuar con el host local (no seguro).

-

Conéctese a Oracle Linux Automation Manager con el Nombre de usuario de

adminy la Contraseña deadmincreados durante el despliegue automatizado.

-

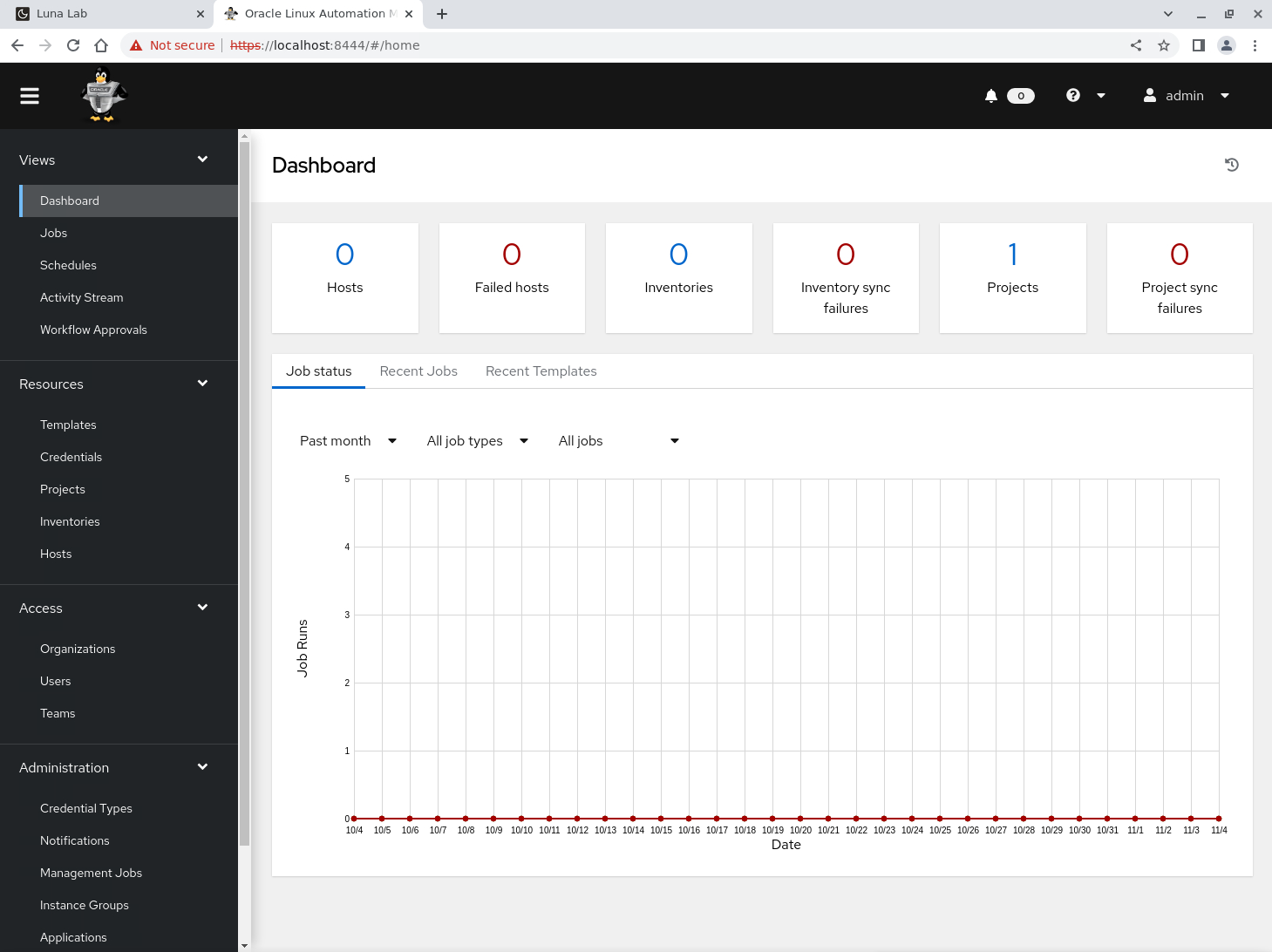

Después de conectarse, se muestra WebUI.

Migración a un despliegue de cluster

Mientras que Oracle Linux Automation Manager se ejecuta como un despliegue de host único, también soporta la ejecución como un cluster con una base de datos remota y nodos de ejecución y plano de control independientes. La instalación configura la instancia de host único como nodo hybrid. El primer paso para migrar a un despliegue de cluster es convertir esta instancia en un nodo control plane.

Para obtener más información sobre las diferentes topologías de instalación, consulte el capítulo Planificación de la instalación de la documentación de la Guía de instalación de Oracle Linux Automation Manager.

Preparación del nodo del plano de control

-

Cambie al terminal conectado a la instancia olam-node que ejecuta Oracle Linux Automation Manager.

Nota: A partir de ahora, haremos referencia a esta instancia como nodo de plano de control.

-

Detenga el servicio Oracle Linux Automation Manager.

sudo systemctl stop ol-automation-manager -

Crear una copia de seguridad de la base de datos.

sudo su - postgres -c 'pg_dumpall > /tmp/olamv2_db_dump'

Instalación de la base de datos remota

-

Copie la copia de seguridad de la base de datos del nodo de plano de control en el nuevo host de base de datos remoto.

scp /tmp/olamv2_db_dump oracle@db-node:/tmp/El comando

scpse comunica mediante una conexión SSH entre los nodos. Esta conexión es posible debido a que el entorno de prácticas libre configura inicios de sesión SSH sin contraseña entre las instancias. -

Conéctese mediante ssh a la instancia db-node.

ssh oracle@db-node -

Active el flujo del módulo de base de datos.

Oracle Linux Automation Manager permite el uso de la base de datos Postgresql versión 12 o 13. Utilizaremos y habilitaremos el flujo de módulos de la versión 13 en este tutorial.

sudo dnf -y module reset postgresql sudo dnf -y module enable postgresql:13 -

Instale el servidor de bases de datos.

sudo dnf -y install postgresql-server -

Agregue la regla de firewall de base de datos.

sudo firewall-cmd --add-port=5432/tcp --permanent sudo firewall-cmd --reload -

Inicialice la base de datos.

sudo postgresql-setup --initdb -

Defina el algoritmo de almacenamiento por defecto de la base de datos.

sudo sed -i "s/#password_encryption.*/password_encryption = scram-sha-256/" /var/lib/pgsql/data/postgresql.confPara obtener más información sobre esta funcionalidad de base de datos, consulte Autenticación de contraseña en la documentación ascendente.

-

Actualice el archivo de autenticación basado en host de la base de datos.

echo "host all all 0.0.0.0/0 scram-sha-256" | sudo tee -a /var/lib/pgsql/data/pg_hba.conf > /dev/nullEsta línea adicional realiza la autenticación SCRAM-SHA-256 para verificar la contraseña de un usuario al conectarse desde cualquier dirección IP.

-

Actualice el valor listen_address en el que la base de datos recibe conexiones.

sudo sed -i "/^#port = 5432/i listen_addresses = '"$(hostname -s)"'" /var/lib/pgsql/data/postgresql.confPuede elegir la dirección IP o el nombre de host para este valor. En el tutorial se utiliza

hostname -spara seleccionar el nombre de host. -

Inicie y active el servicio de base de datos.

sudo systemctl enable --now postgresql -

Importe el archivo de volcado de la base de datos.

sudo su - postgres -c 'psql -d postgres -f /tmp/olamv2_db_dump' -

Defina la contraseña de la cuenta de usuario de la base de datos de Oracle Linux Automation Manager.

sudo su - postgres -c "psql -U postgres -d postgres -c \"alter user awx with password 'password';\""Este comando define la contraseña

awxenpassword. Seleccione una contraseña más segura si ejecuta este comando fuera del entorno de prácticas gratuito. -

Cierre la sesión SSH conectada a la instancia db-node, ya que esto completa los pasos necesarios para configurar la base de datos remota.

exit

Adición de la configuración de la base de datos remota

-

Confirme la conexión a la instancia olam-node comprobando el indicador de terminal.

-

Verifique que el host se pueda comunicar con la base de datos remota.

pg_isready -d awx -h db-node -p 5432 -U awxEl paquete postgresql incluye el comando

pg_isready. Ese paquete forma parte de la instalación original de un solo host. Si este comando no funciona, es probable que haya omitido un paso anterior o que falte acceso de entrada al puerto 5432 de la red. -

Agregue los valores de la base de datos remota a un nuevo archivo de configuración personalizado.

cat << EOF | sudo tee /etc/tower/conf.d/db.py > /dev/null DATABASES = { 'default': { 'ATOMIC_REQUESTS': True, 'ENGINE': 'awx.main.db.profiled_pg', 'NAME': 'awx', 'USER': 'awx', 'PASSWORD': 'password', 'HOST': 'db-node', 'PORT': '5432', } } EOFUtilice la misma contraseña definida anteriormente para la cuenta de usuario de base de datos

awx. -

Pare y desactive la base de datos local en el nodo de plano de control.

sudo systemctl stop postgresql sudo systemctl disable postgresql -

Enmascarar el servicio de base de datos local.

sudo systemctl mask postgresqlEste paso impide que el servicio de base de datos local se inicie al iniciar el servicio Oracle Linux Automation Manager.

-

Inicie Oracle Linux Automation Manager.

sudo systemctl start ol-automation-manager -

Verifique que Oracle Linux Automation Manager se conecte a la base de datos remota.

sudo su -l awx -s /bin/bash -c "awx-manage check_db"La salida devuelve los detalles de la versión de la base de datos remota si la conexión se realiza correctamente.

Eliminación de la instancia de base de datos local

La eliminación de la base de datos local original es segura después de confirmar que la conexión a la base de datos remota está funcionando.

-

Elimine los paquetes de base de datos.

sudo dnf -y remove postgresql -

Elimine el directorio

pgsqlque contiene los archivos de datos de la base de datos antigua.sudo rm -rf /var/lib/pgsql

Cambio del tipo de nodo del nodo del plano de control

Al realizar la conversión a un despliegue en cluster, cambie la instancia de host único node_type de hybrid a control.

-

Confirme el tipo de nodo actual del nodo de plano de control.

sudo su -l awx -s /bin/bash -c "awx-manage list_instances"La salida muestra el juego

node_typeen un valor dehybrid. -

Elimine el grupo de instancias por defecto.

sudo su -l awx -s /bin/bash -c "awx-manage remove_from_queue --queuename default --hostname $(hostname -i)" -

Defina la nueva instancia y cola.

sudo su -l awx -s /bin/bash -c "awx-manage provision_instance --hostname=$(hostname -i) --node_type=control" sudo su -l awx -s /bin/bash -c "awx-manage register_queue --queuename=controlplane --hostnames=$(hostname -i)" -

Agregue los valores de nombre de cola predeterminados en el archivo de configuración personalizado.

cat << EOF | sudo tee -a /etc/tower/conf.d/olam.py > /dev/null DEFAULT_EXECUTION_QUEUE_NAME = 'execution' DEFAULT_CONTROL_PLANE_QUEUE_NAME = 'controlplane' EOF -

Actualice la configuración del receptor.

cat << EOF | sudo tee /etc/receptor/receptor.conf > /dev/null --- - node: id: $(hostname -i) - log-level: info - tcp-listener: port: 27199 - control-service: service: control filename: /var/run/receptor/receptor.sock - work-command: worktype: local command: /var/lib/ol-automation-manager/venv/awx/bin/ansible-runner params: worker allowruntimeparams: true verifysignature: false EOF -

Reinicio de Oracle Linux Automation Manager

sudo systemctl restart ol-automation-manager

Se ha completado la conversión del nodo híbrido de host único en un nodo de plano de control con una base de datos remota. Ahora, agregaremos un nodo de plano de ejecución para que este cluster sea completamente funcional.

Adición de un Nodo de Plano de Ejecución al Cluster

Antes de que el cluster sea totalmente funcional, agregue uno o más nodos de ejecución. Los nodos de ejecución ejecutan trabajos estándar mediante ansible-runner, que ejecuta cuadernos de estrategias en un entorno de ejecución basado en contenedores OLAM EE Podman.

Preparación del Nodo del Plano de Ejecución

-

Conéctese mediante ssh a la instancia *exe-node.

ssh exe-node -

Instale el paquete de repositorio de Oracle Linux Automation Manager.

sudo dnf -y install oraclelinux-automation-manager-release-el8 -

Desactive el repositorio para la versión anterior.

sudo dnf config-manager --disable ol8_automation ol8_automation2 -

Active el repositorio de la versión actual.

sudo dnf config-manager --enable ol8_automation2.2 -

Instale el paquete de Oracle Linux Automation Manager.

sudo dnf -y install ol-automation-manager -

Agregue la regla de firewall del receptor.

sudo firewall-cmd --add-port=27199/tcp --permanent sudo firewall-cmd --reload -

Edite la configuración del socket de Redis.

sudo sed -i '/^# unixsocketperm/a unixsocket /var/run/redis/redis.sock\nunixsocketperm 775' /etc/redis.conf -

Copie la clave secreta del nodo de plano de control.

ssh oracle@olam-node "sudo cat /etc/tower/SECRET_KEY" | sudo tee /etc/tower/SECRET_KEY > /dev/nullImportante: cada nodo de cluster necesita la misma clave secreta.

-

Cree un archivo de configuración personalizado que contenga la configuración necesaria.

cat << EOF | sudo tee /etc/tower/conf.d/olamv2.py > /dev/null CLUSTER_HOST_ID = '$(hostname -i)' DEFAULT_EXECUTION_QUEUE_NAME = 'execution' DEFAULT_CONTROL_PLANE_QUEUE_NAME = 'controlplane' EOFCLUSTER_HOST_IDes un identificador único del host dentro del cluster. -

Cree un archivo de configuración personalizado que contenga la configuración de la base de datos remota.

cat << EOF | sudo tee /etc/tower/conf.d/db.py > /dev/null DATABASES = { 'default': { 'ATOMIC_REQUESTS': True, 'ENGINE': 'awx.main.db.profiled_pg', 'NAME': 'awx', 'USER': 'awx', 'PASSWORD': 'password', 'HOST': 'db-node', 'PORT': '5432', } } EOF -

Despliegue el entorno de ejecución de ansible-runner.

-

Abra un shell como usuario

awx.sudo su -l awx -s /bin/bash -

Migre los contenedores existentes a la última versión de podman manteniendo activos los espacios de nombres sin privilegios.

podman system migrate -

Extraiga el entorno de ejecución de Oracle Linux Automation Engine para Oracle Linux Automation Manager.

podman pull container-registry.oracle.com/oracle_linux_automation_manager/olam-ee:2.2 -

Salga del shell de usuario

awx.exit

-

-

Genere los certificados SSL para NGINX.

sudo openssl req -x509 -nodes -days 365 -newkey rsa:2048 -keyout /etc/tower/tower.key -out /etc/tower/tower.crtIntroduzca la información solicitada o simplemente pulse la clave

ENTER. -

Sustituya la configuración predeterminada de NGINX por la siguiente configuración.

cat << 'EOF' | sudo tee /etc/nginx/nginx.conf > /dev/null user nginx; worker_processes auto; error_log /var/log/nginx/error.log; pid /run/nginx.pid; # Load dynamic modules. See /usr/share/doc/nginx/README.dynamic. include /usr/share/nginx/modules/*.conf; events { worker_connections 1024; } http { log_format main '$remote_addr - $remote_user [$time_local] "$request" ' '$status $body_bytes_sent "$http_referer" ' '"$http_user_agent" "$http_x_forwarded_for"'; access_log /var/log/nginx/access.log main; sendfile on; tcp_nopush on; tcp_nodelay on; keepalive_timeout 65; types_hash_max_size 2048; include /etc/nginx/mime.types; default_type application/octet-stream; # Load modular configuration files from the /etc/nginx/conf.d directory. # See http://nginx.org/en/docs/ngx_core_module.html#include # for more information. include /etc/nginx/conf.d/*.conf; } EOF -

Actualice el archivo de configuración del receptor.

cat << EOF | sudo tee /etc/receptor/receptor.conf > /dev/null --- - node: id: $(hostname -i) - log-level: debug - tcp-listener: port: 27199 - tcp-peer: address: $(ssh olam-node hostname -i):27199 redial: true - control-service: service: control filename: /var/run/receptor/receptor.sock - work-command: worktype: ansible-runner command: /var/lib/ol-automation-manager/venv/awx/bin/ansible-runner params: worker allowruntimeparams: true verifysignature: false EOFnode:ides el nombre de host o la dirección IP del nodo actual.tcp-peer:addresses el nombre de host o la dirección IP y el puerto de la malla del receptor en el nodo del plano de control.

-

Inicie y active el servicio Oracle Linux Automation Manager.

sudo systemctl enable --now ol-automation-manager.service -

Cierre la sesión SSH conectada a la instancia exe-node, ya que se completan los pasos necesarios para configurar el nodo de ejecución.

exit

Aprovisionamiento del nodo del plano de ejecución

-

Confirme la conexión a la instancia olam-node comprobando el indicador de terminal.

Debe ejecutar el paso de aprovisionamiento en uno de los nodos de plano de control del cluster y aplicarlo a todas las instancias de cluster de Oracle Linux Automation Manager.

-

Defina la instancia de ejecución y la cola.

sudo su -l awx -s /bin/bash -c "awx-manage provision_instance --hostname=$(ssh exe-node hostname -i) --node_type=execution" sudo su -l awx -s /bin/bash -c "awx-manage register_default_execution_environments" sudo su -l awx -s /bin/bash -c "awx-manage register_queue --queuename=execution --hostnames=$(ssh exe-node hostname -i)"register_queuetomaqueuenamepara crear/actualizar y una lista dehostnamesdelimitados por comas donde se ejecutan los trabajos.

-

Registre la relación de par de malla de servicio.

sudo su -l awx -s /bin/bash -c "awx-manage register_peers $(ssh exe-node hostname -i) --peers $(hostname -i)"

Verificación del Registro de Nodo del Plano de Ejecución

-

Conéctese mediante ssh a la instancia *exe-node.

ssh exe-node -

Verifique que el servicio de malla de Oracle Linux Automation Manager se esté ejecutando.

sudo systemctl status receptor-awx -

Compruebe el estado de la malla de servicios.

sudo receptorctl --socket /var/run/receptor/receptor.sock statusSalida de ejemplo:

[oracle@execution-node ~]$ sudo receptorctl --socket /var/run/receptor/receptor.sock status Node ID: 10.0.0.62 Version: +g System CPU Count: 2 System Memory MiB: 15713 Connection Cost 10.0.0.55 1 Known Node Known Connections 10.0.0.55 10.0.0.62: 1 10.0.0.62 10.0.0.55: 1 Route Via 10.0.0.55 10.0.0.55 Node Service Type Last Seen Tags 10.0.0.62 control Stream 2022-11-06 19:46:53 {'type': 'Control Service'} 10.0.0.55 control Stream 2022-11-06 19:46:06 {'type': 'Control Service'} Node Work Types 10.0.0.62 ansible-runner 10.0.0.55 localPara obtener más información sobre Receptor, consulte la documentación ascendente.

-

Verifique las instancias de cluster en ejecución y muestre la capacidad disponible.

sudo su -l awx -s /bin/bash -c "awx-manage list_instances"La salida aparece

greenuna vez que el cluster establece la comunicación entre todas las instancias. Si los resultados aparecen enred, espere de 20 a 30 segundos e intente volver a ejecutar el comando.Salida de ejemplo:

[oracle@control-node ~]$ sudo su -l awx -s /bin/bash -c "awx-manage list_instances" [controlplane capacity=136] 10.0.0.55 capacity=136 node_type=control version=19.5.1 heartbeat="2022-11-08 16:24:03" [default capacity=0] [execution capacity=136] 10.0.0.62 capacity=136 node_type=execution version=19.5.1 heartbeat="2022-11-08 17:16:45"

Esto completa la migración de Oracle Linux Automation Manager a un despliegue en cluster.

(Opcional) Verificación de que el cluster está funcionando

-

Refresque la ventana del explorador web utilizada para mostrar el WebUI anterior o abra una nueva ventana del explorador web e introduzca la URL.

https://localhost:8444El puerto utilizado en la URL debe coincidir con el puerto local del túnel SSH.

Nota: Apruebe la advertencia de seguridad según el explorador utilizado. Para Chrome, haga clic en el botón Advanced (Avanzado) y, a continuación, en el enlace Proceed to localhost (unsafe) (Continuar con el host local [no seguro]).

-

Vuelva a conectarse a Oracle Linux Automation Manager con el nombre de usuario

adminy la contraseñaadmin.

-

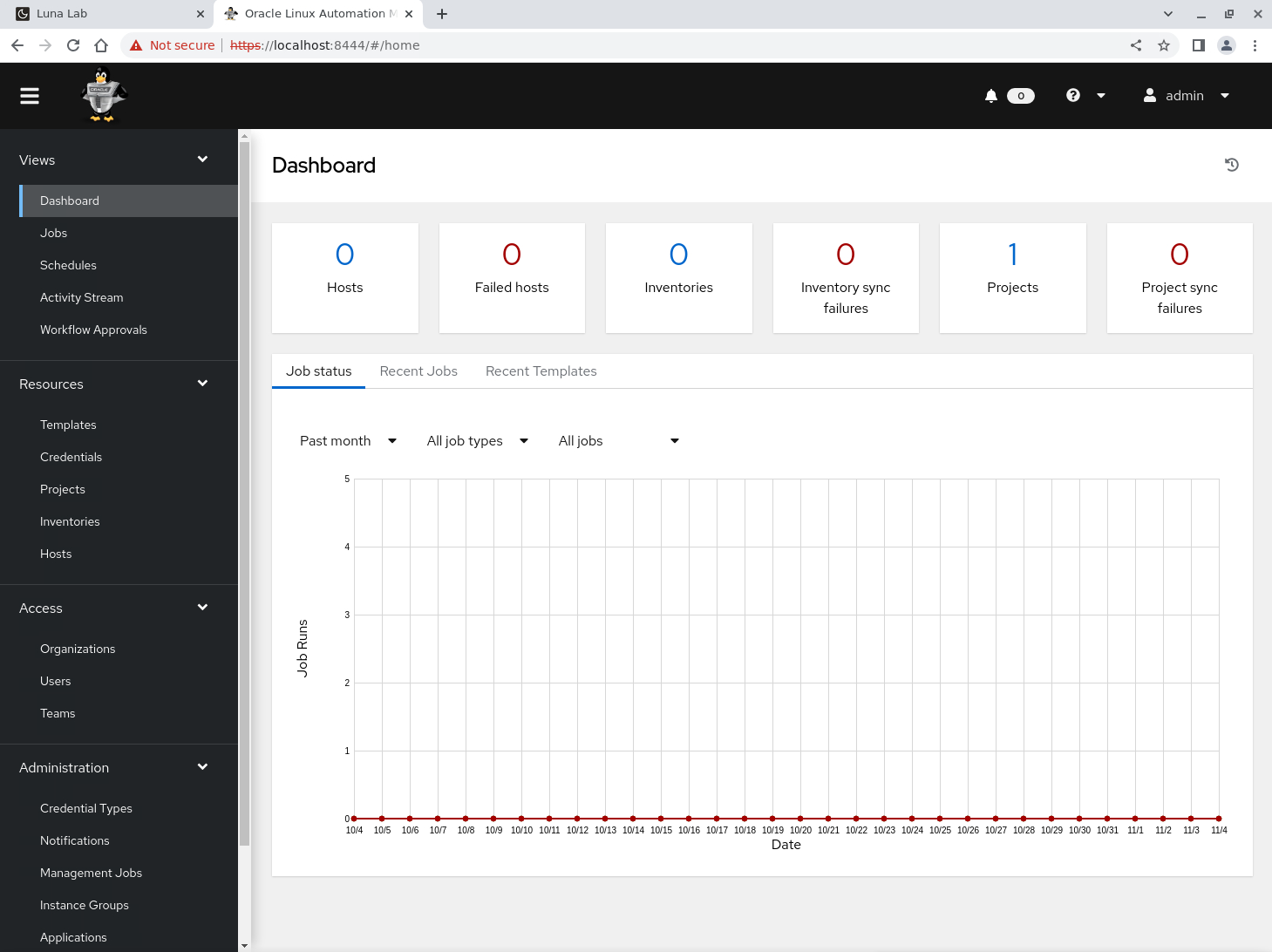

Después de conectarse, se muestra WebUI.

-

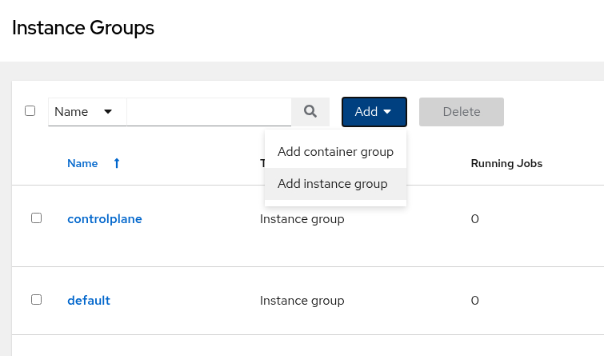

En el menú de navegación de la izquierda, haga clic en Instance Groups en la sección Administration.

-

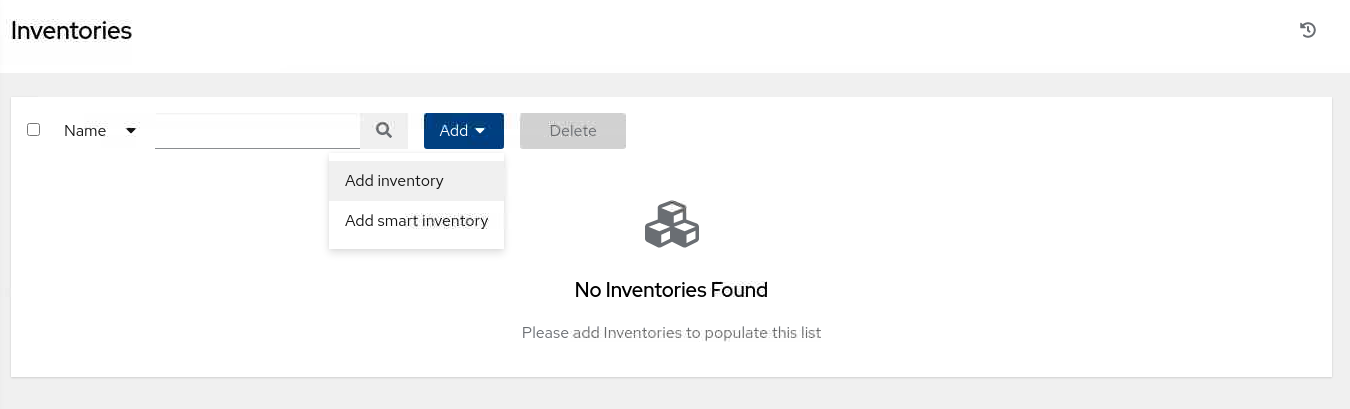

En la ventana principal, haga clic en el botón Agregar y, a continuación, seleccione Agregar grupo de instancias.

-

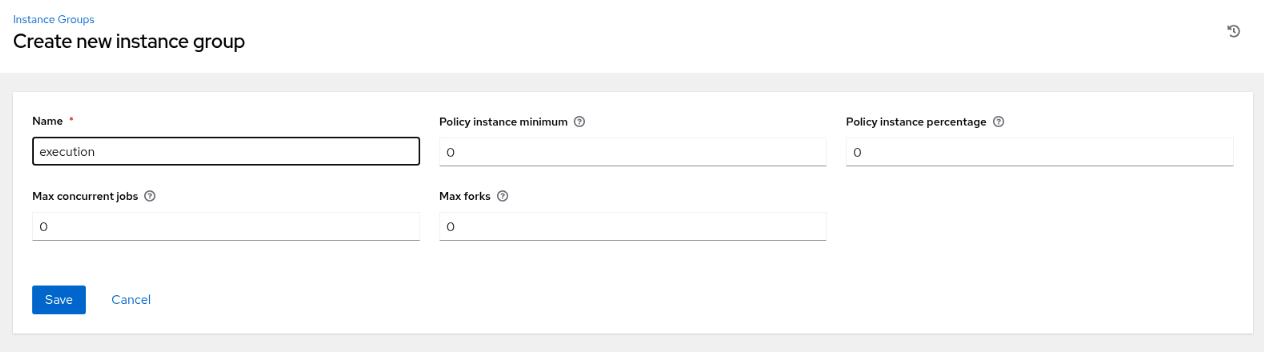

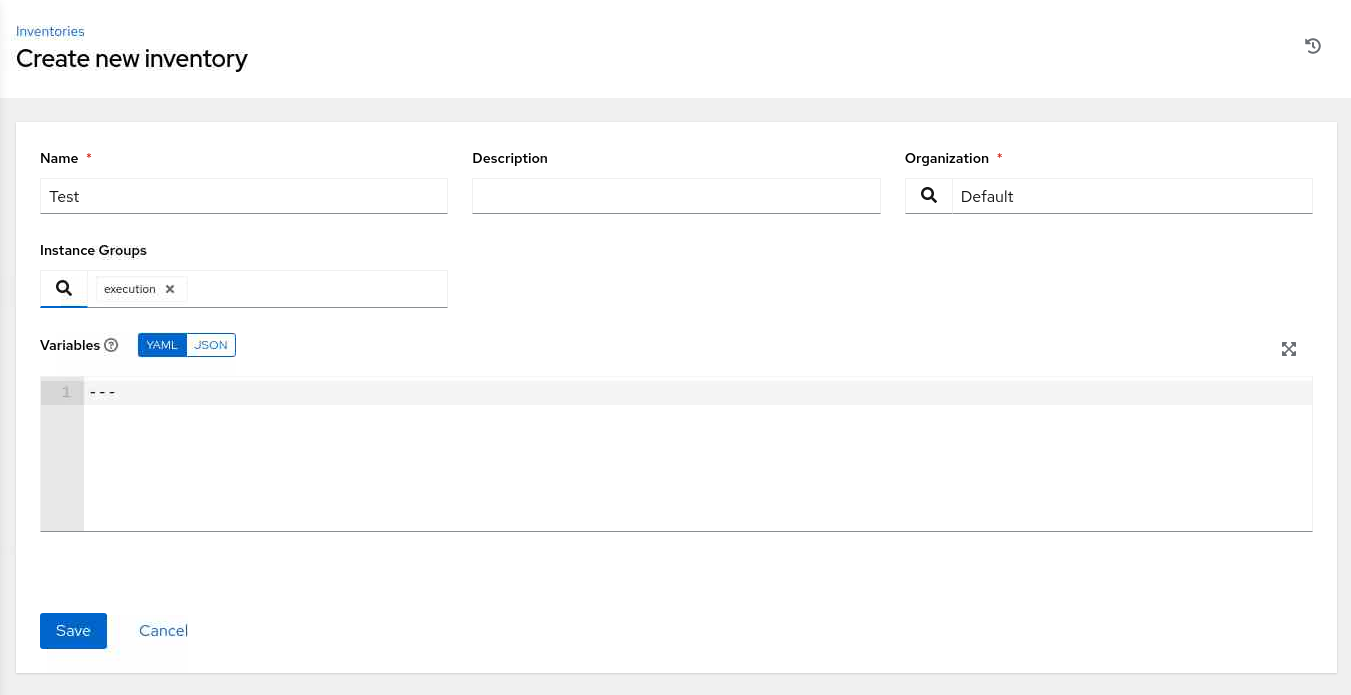

Introduzca la información necesaria en la página Crear nuevo grupo de instancias.

-

Haga clic en el botón Guardar.

-

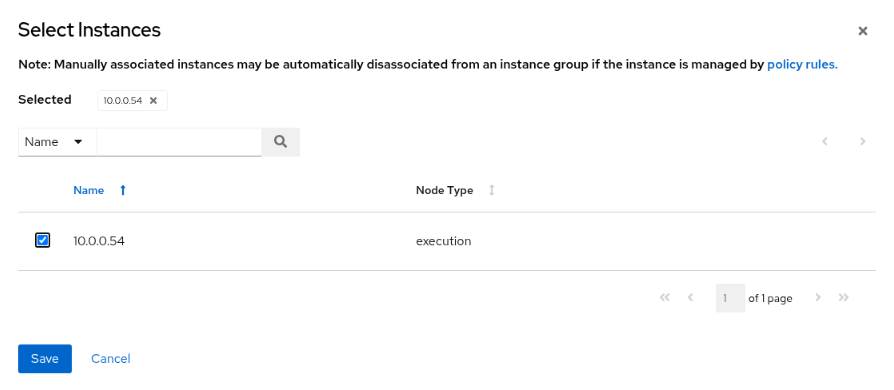

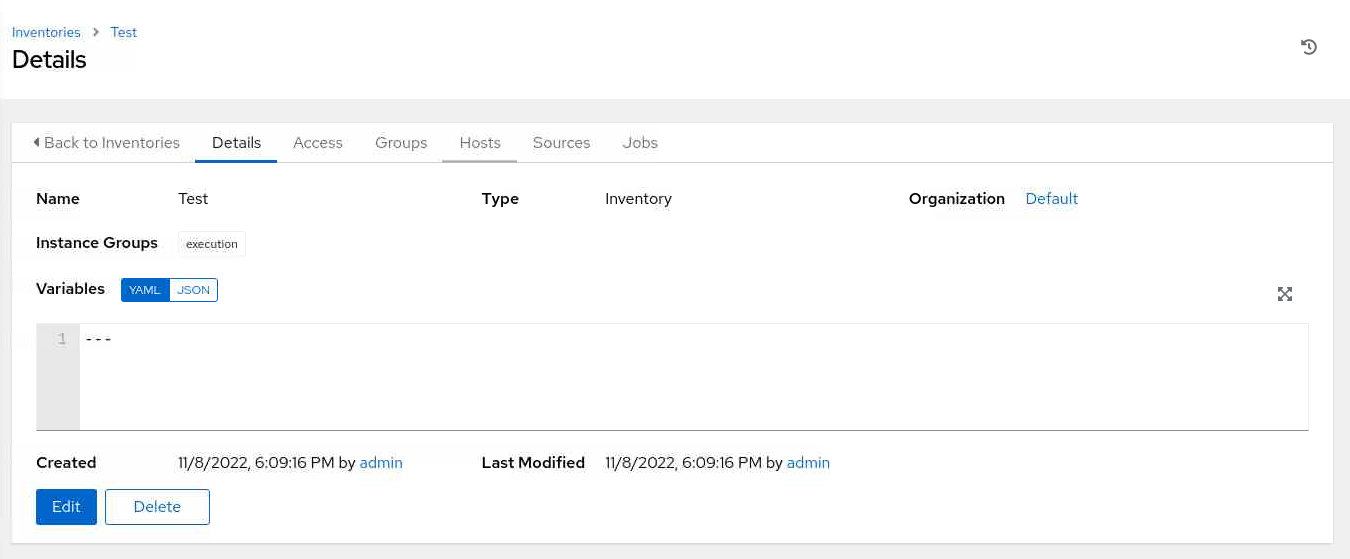

En la página de resumen Detalles, haga clic en el separador Instancias.

-

En la página Instancias, haga clic en el botón Asociar.

-

En la página Seleccionar instancias, haga clic en la casilla de control situada junto al nodo de ejecución.

-

Haga clic en el botón Guardar.

-

En el menú de navegación de la izquierda, haga clic en Inventarios en la sección Recursos.

-

En la ventana principal, haga clic en el botón Agregar y, a continuación, seleccione Agregar inventario.

-

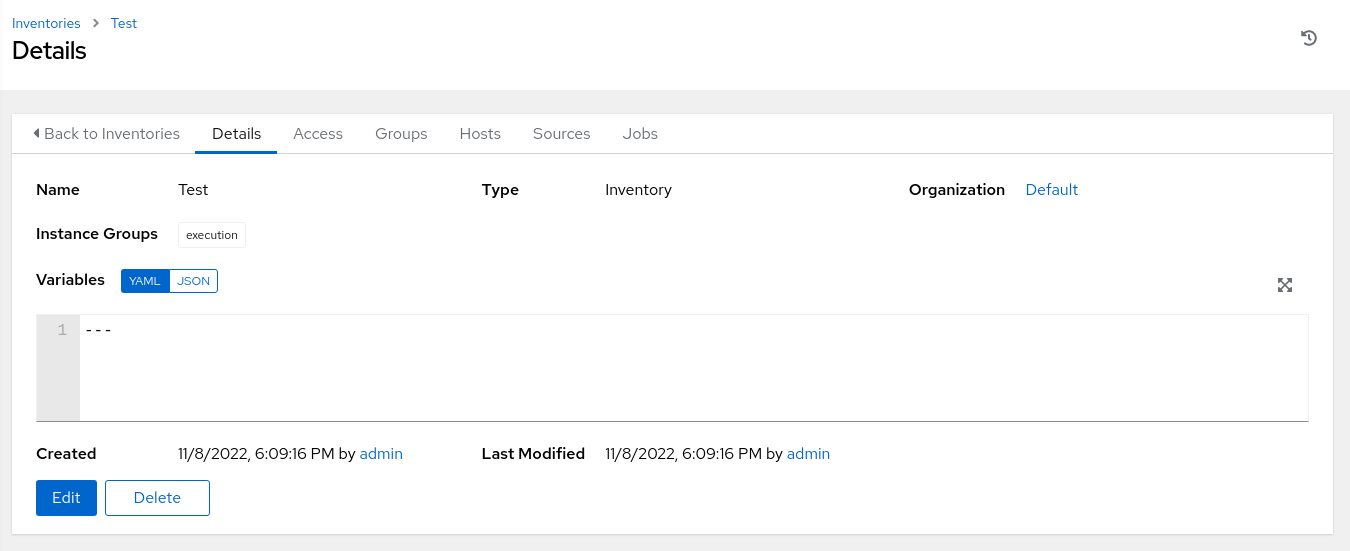

Introduzca la información necesaria en la página Crear nuevo inventario.

En Grupos de instancias, seleccione el icono de búsqueda para mostrar el cuadro de diálogo emergente Seleccionar grupos de instancias. Haga clic en la casilla de control situada junto al grupo de ejecución y, a continuación, haga clic en el botón Seleccionar.

-

Haga clic en el botón Guardar.

-

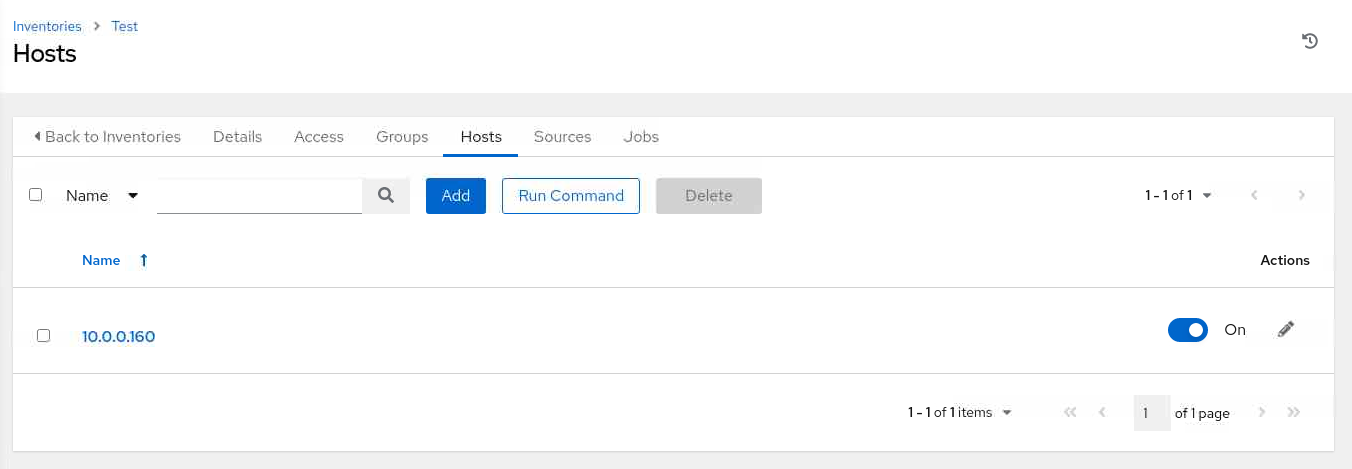

En la página de resumen Detalles, haga clic en el separador Hosts.

-

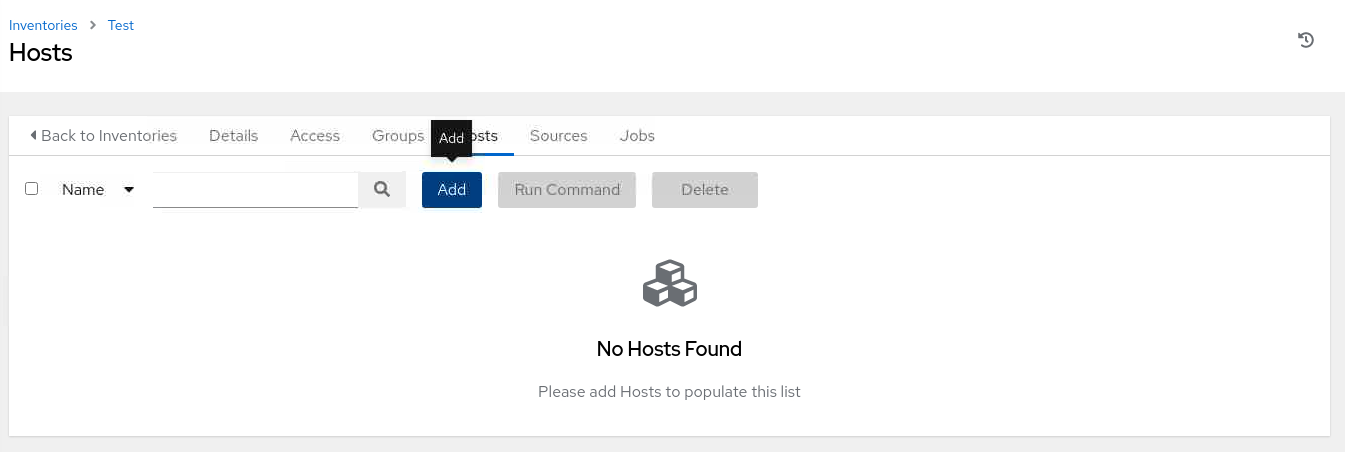

En la página Hosts, haga clic en el botón Add (Agregar).

-

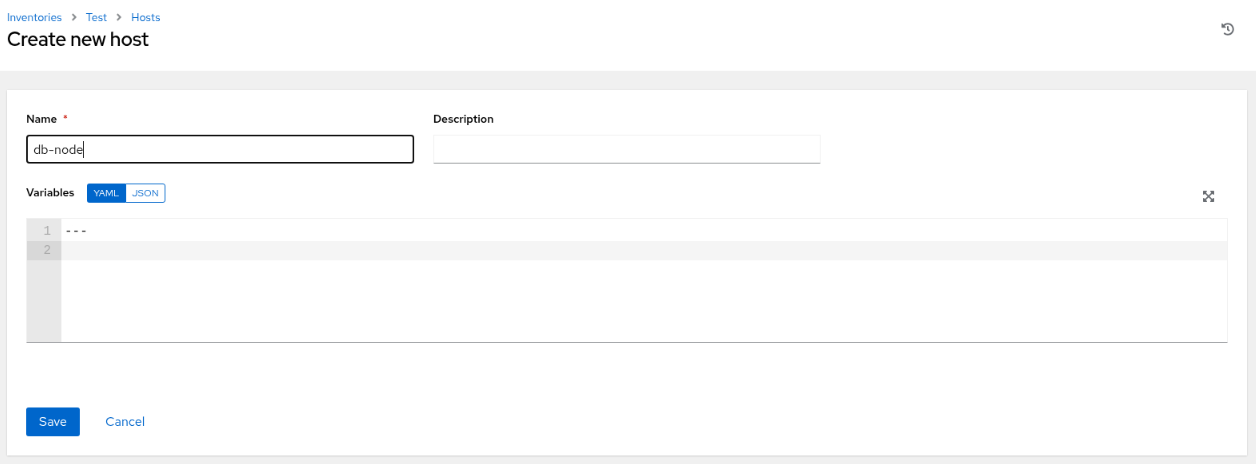

En la página Crear nuevo host, introduzca la dirección IP o el nombre de host de una instancia disponible.

En el entorno de prácticas gratuitas, utilizaremos db-node, que es el nombre de host de la instancia de base de datos remota.

-

Haga clic en el botón Guardar.

-

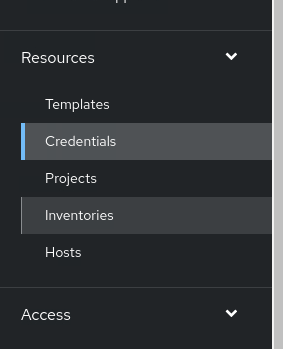

Navegue hasta el menú de la izquierda y haga clic en **Credenciales`.

-

En la página Credenciales, haga clic en el botón Agregar.

-

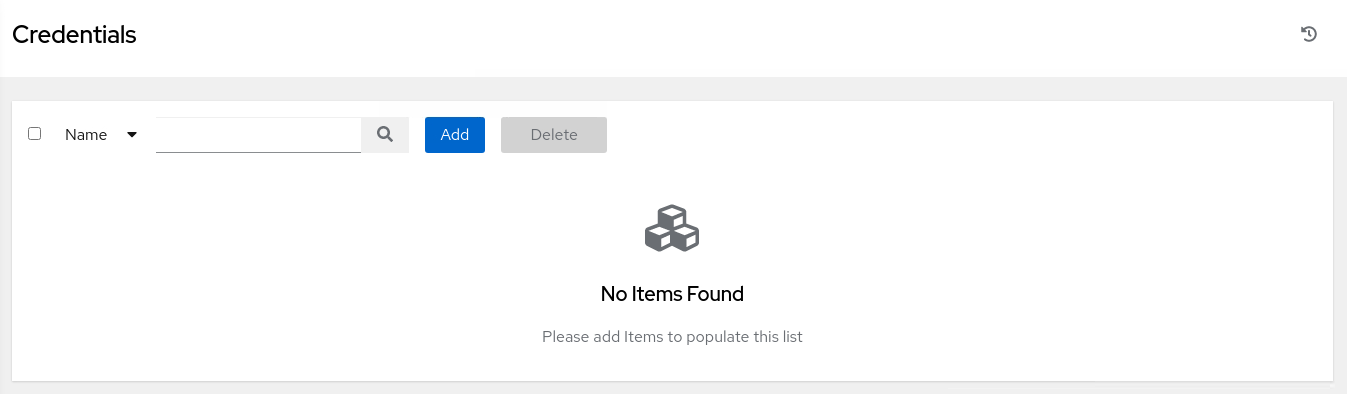

Introduzca la información necesaria en la página Crear Nueva Credencial.

En Tipo de credencial, haga clic en el menú desplegable y seleccione Máquina. Esto muestra las credenciales Detalles de tipo.

Introduzca un nombre de usuario de

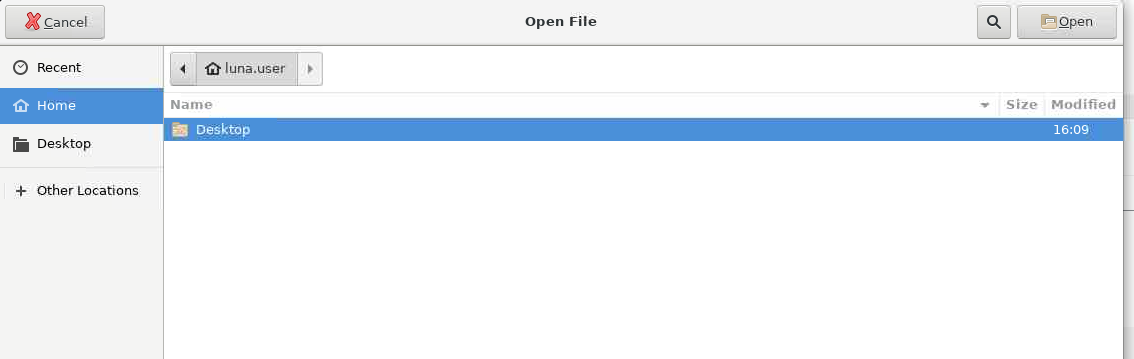

oracley busque la clave privada SSH. Al hacer clic en el botón Examinar... se muestra una ventana del cuadro de diálogo Abrir archivo.

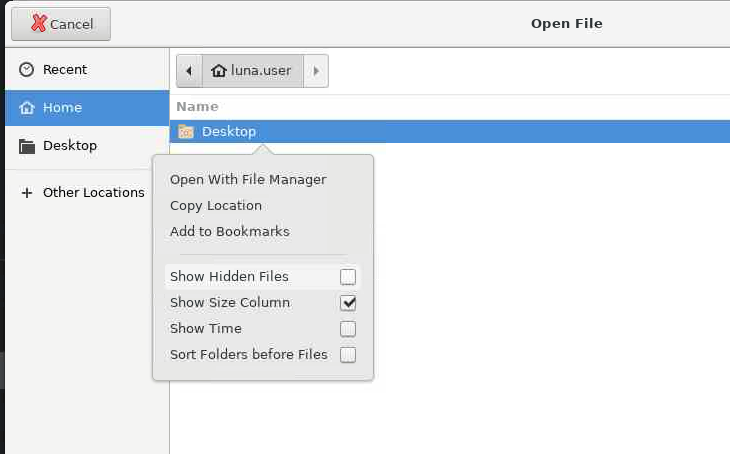

Haga clic con el botón derecho en la ventana principal de ese cuadro de diálogo y, a continuación, seleccione Mostrar archivos ocultos.

A continuación, seleccione la carpeta

.sshy el archivoid_rsa. Al hacer clic en el botón Open (Abrir), el contenido del archivo de clave privada se copia en el cuadro de diálogo SSH Private Key (Clave privada SSH). Desplácese hacia abajo y haga clic en el botón Guardar. -

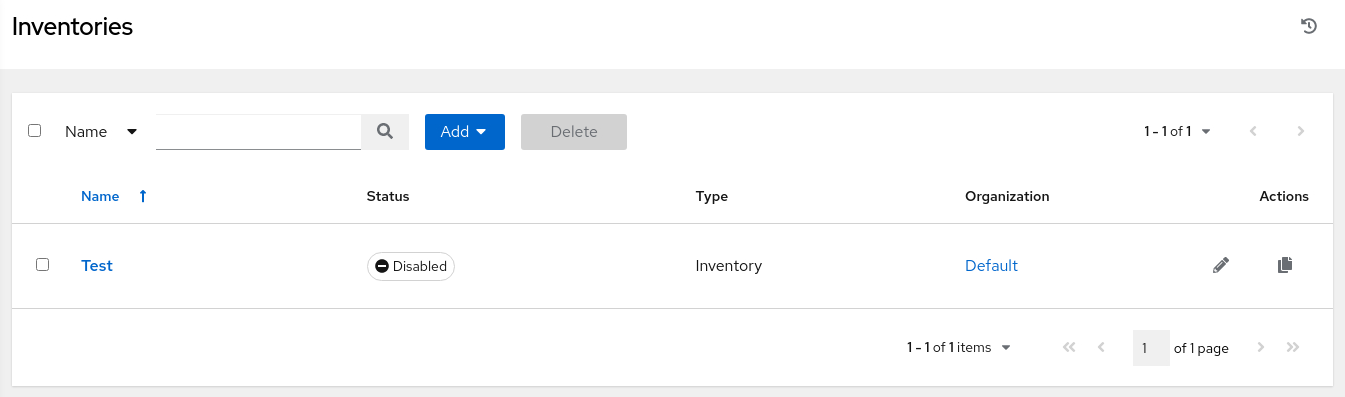

Vaya al menú de la izquierda y haga clic en Inventarios.

-

En la página Inventarios, haga clic en el inventario Probar.

-

En la página de resumen Detalles, haga clic en el separador Hosts.

-

En la página Hosts, haga clic en la casilla de control situada junto al host

db-node.

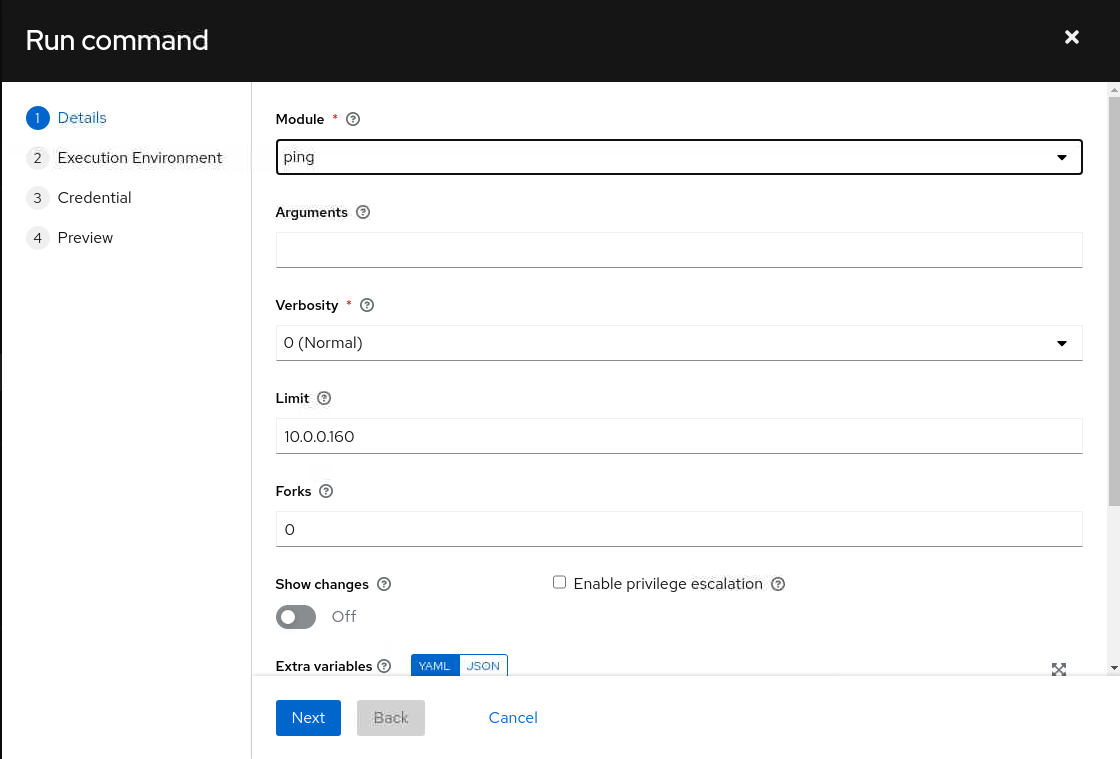

A continuación, haga clic en el botón Run Command (Ejecutar comando).

-

En el cuadro de diálogo Ejecutar comando, seleccione el módulo

pingde la lista de valores Módulos y haga clic en el botón Siguiente.

-

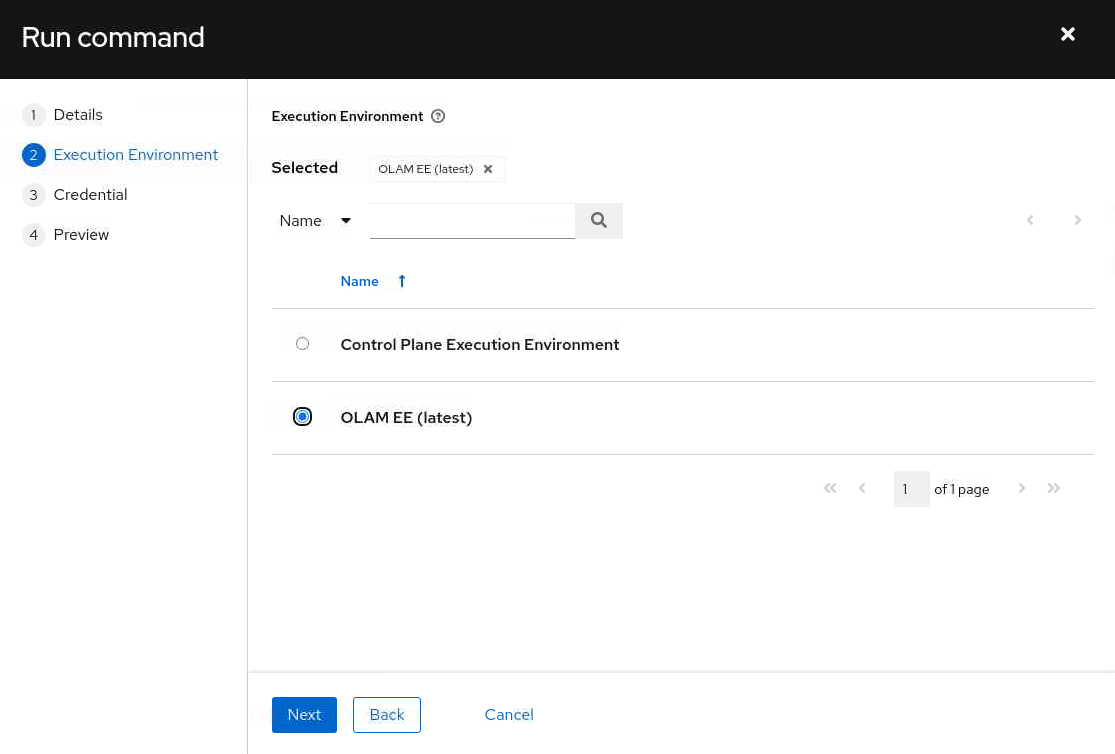

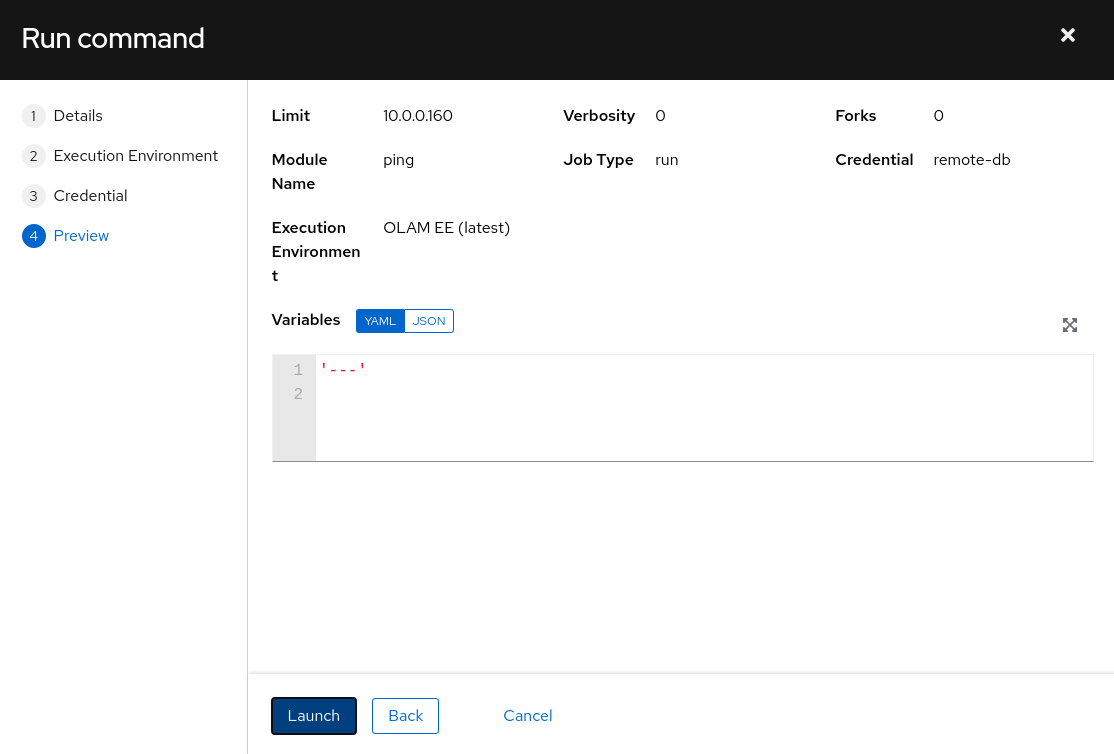

Seleccione el entorno de ejecución OLAM EE (2.2) y haga clic en el botón Next (Siguiente).

-

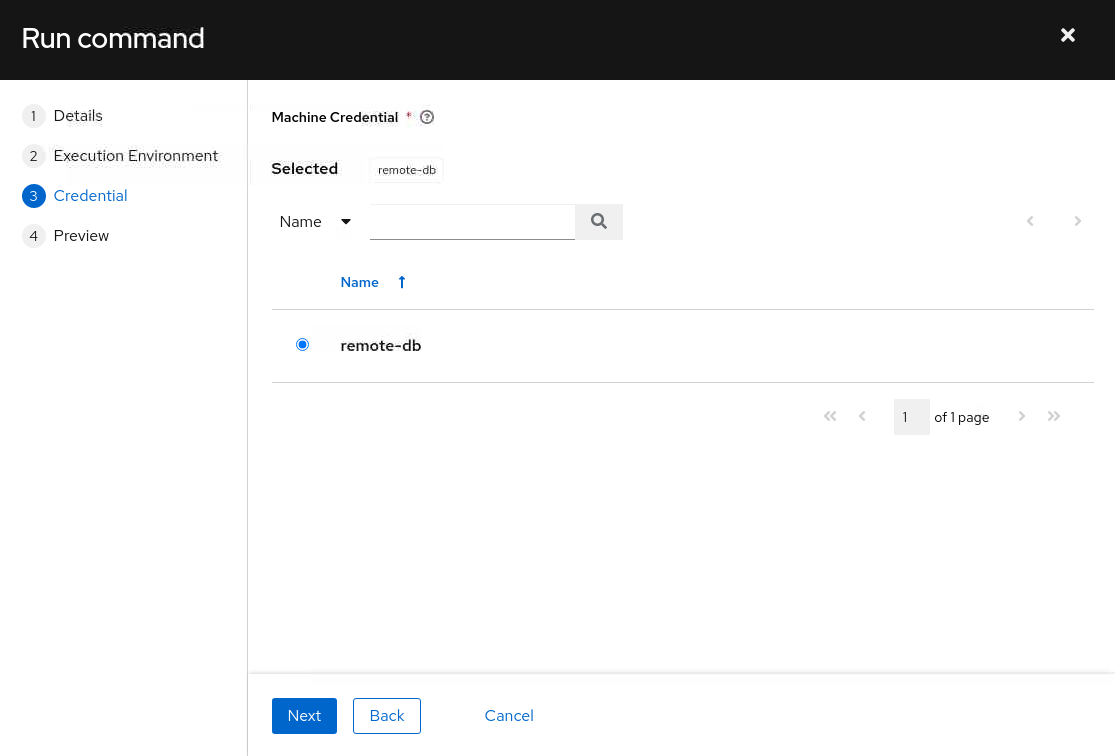

Seleccione la credencial de máquina db-node y haga clic en el botón Next (Siguiente).

-

El panel se refresca y muestra una vista previa del comando.

Después de revisar los detalles, haga clic en el botón Iniciar.

-

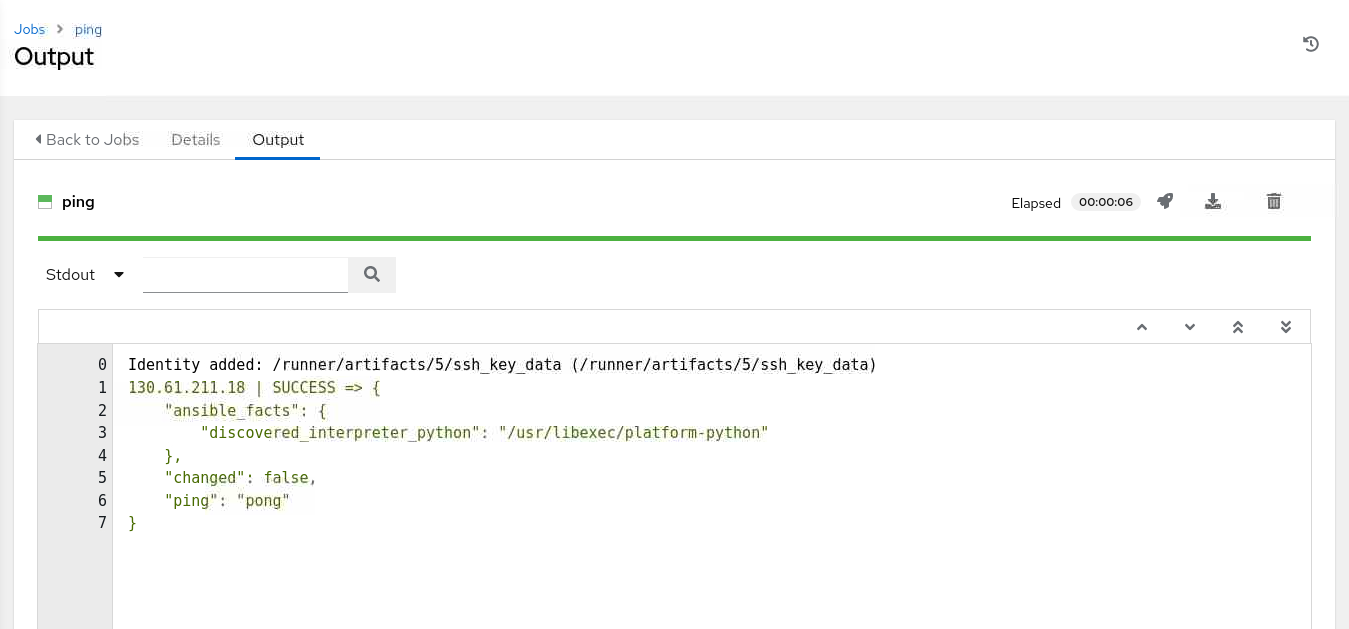

El trabajo se iniciará y mostrará la página Salida del trabajo.

Si todo se ha ejecutado correctamente, la salida muestra un mensaje

SUCCESSque indica que el nodo de ejecución se ha puesto en contacto con la instanciadb-nodemediante el módulopingde Ansible. Si no ve la salida, refresque la página haciendo clic en el separador Detalles y volviendo al separador Salida.

Pasos Siguientes

La salida de WebUI confirma que tiene un entorno de cluster de trabajo para Oracle Linux Automation Manager. Continúe desarrollando sus habilidades y consulte nuestra otra formación sobre Oracle Linux Automation Manager en Oracle Linux Training Station.

Enlaces relacionados

Documentación de Oracle Linux Automation Manager

Formación de Oracle Linux Automation Manager

Estación de formación de Oracle Linux

Más recursos de aprendizaje

Explore otros laboratorios en docs.oracle.com/learn o acceda a más contenido de formación gratuita en el canal YouTube de Oracle Learning. Además, visite education.oracle.com/learning-explorer para convertirse en un explorador de Oracle Learning.

Para obtener documentación sobre el producto, visite Oracle Help Center.

Migrate Oracle Linux Automation Manager to a Clustered Deployment

F74654-02

Copyright ©2022, Oracle and/or its affiliates.