Patrones recomendados para lagos de datos basados en la nube

En función de su caso de uso, los data lakes se pueden crear en Object Storage o Hadoop. Ambos pueden ampliarse e integrarse a la perfección con los datos y las herramientas empresariales existentes. Considere los patrones Greenfield o Migración para su organización. Elija Greenfield o el patrón de migración en función de si planea una implantación completamente nueva o desea migrar su solución de big data existente a Oracle Cloud.

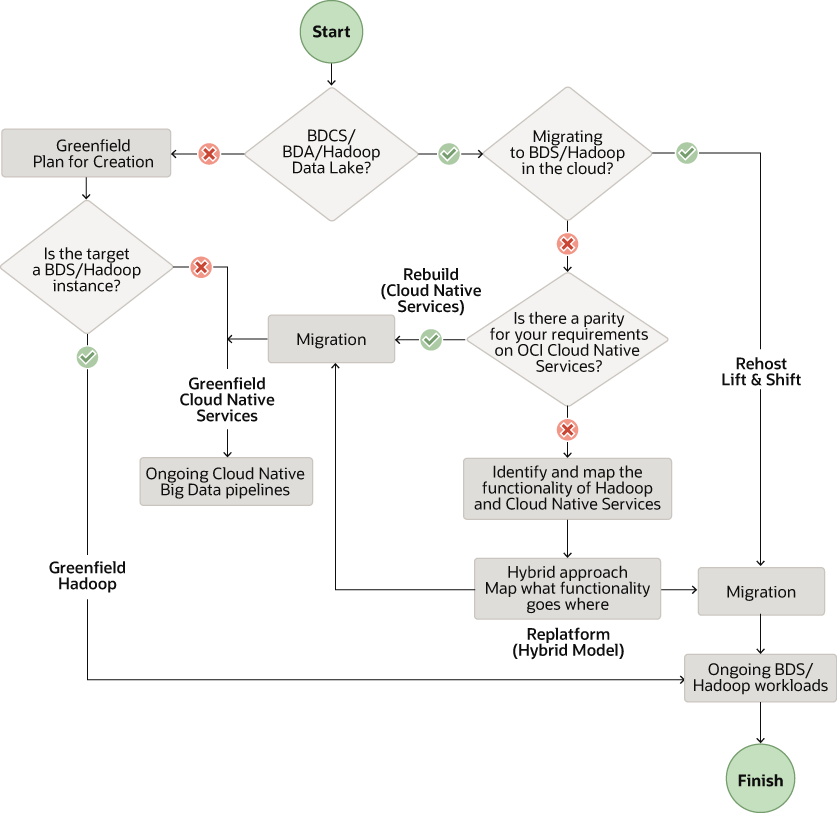

El siguiente flujo de trabajo muestra los patrones recomendados según sus requisitos.

Descripción de la ilustración data-lake-solution-pattern.png

Nota:

En este documento, nos centramos en la migración de clusters de Big Data Appliance (BDA) y Big Data Cloud Services (BDCS) a OCI basada en Cloudera Distribution de Hadoop (CDH). Sin embargo, las recomendaciones aquí se aplican a otras distribuciones Hadoop locales y en la nube.

Crear nueva plataforma de datos en Oracle Cloud (Greenfield)

Tiene dos opciones para crear lagos de datos en Oracle Cloud para proyectos de Greenfield. Utilice Big Data Service (BDS) para lagos de datos basados en HDFS. Utilice servicios de datos nativos en la nube de OCI para lagos de datos basados en Object Storage sin utilizar HDFS.

Servicios de datos en la nube

Cree un data lake en OCI Object Storage y utilice servicios de IA y datos nativos en la nube. Estos servicios incluyen Data Flow, Data Integration, Autonomous Data Warehouse, Data Catalog y Data Science, junto con algunos otros.

Oracle recomienda estos servicios para crear un nuevo data lake:

- Almacenamiento de objetos como tienda de data lake para todos los tipos de datos raw

- Servicio de flujo de datos para procesos por lotes de Spark y para clusters de Spark efímeros

- Servicio de integración de datos para la ingestión de datos y para trabajos de ETL

- Autonomous Data Warehouse (ADW) para servir y presentar datos de capa

- Data Catalog para la detección y el control de datos

Oracle recomienda estos servicios adicionales para crear un nuevo data lake:

- Servicio de flujo para una ingestión gestionada de datos en tiempo real

- Servicio de Data Transfer Appliance (DTA) para la transferencia masiva de datos puntual

- Servicio GoldenGate para datos de captura de datos de cambio (CDC) y para análisis de transmisión

- Servicio de ciencia de datos para requisitos de aprendizaje automático

- Servicio Oracle Analytics Cloud (OAC) para requisitos de BI, análisis e informes

Servicio Big Data

Cree su data lake en HDFS utilizando Oracle Big Data Service (BDS). BDS proporciona los componentes de Hadoop más utilizados, incluidos HDFS, Hive, HBase, Spark y Oozie.

Oracle recomienda estos servicios para crear un nuevo data lake mediante clusters Hadoop:

- Servicio de integración de datos para la ingestión de datos y para trabajos de ETL

- Servicio de Data Transfer Appliance (DTA) para la transferencia masiva de datos puntual

- Servicio GoldenGate para datos CDC y para análisis de transmisión

- Servicio de catálogo de datos para la detección y el control de datos

- Servicio de ciencia de datos para requisitos de aprendizaje automático

- Servicio de OAC para requisitos de informes, análisis y BI

- BDS para HDFS y otros componentes de Hadoop

Flujo de Trabajo de Patrón de Greenfield

Cuando cree un nuevo data lake, siga este flujo de trabajo desde los requisitos a través de pruebas y validación:

- Requisitos: enumere los requisitos de nuevos entornos en OCI.

- Evaluación: evalúe los servicios y herramientas de OCI necesarios

- Diseño: diseño de la arquitectura de su solución y ajuste de tamaño para OCI

- Plan: cree un plan detallado que asigne el tiempo y los recursos.

- Aprovisionamiento: aprovisione y configure los recursos necesarios en OCI

- Implantación: Implante las cargas de trabajo de datos y aplicaciones

- Automatizar pipeline: Organice y programe pipelines de flujo de trabajo para la automatización.

- Probar y validar: realice pruebas de validación, funcionales y de rendimiento para la solución integral

Migración de una plataforma de datos existente en Oracle Cloud

Volver a crear patrón

Utilice el patrón de reconstrucción si no desea utilizar clusters de Hadoop y desea migrar a servicios nativos en la nube en Oracle Cloud Infrastructure (OCI). Empiece por una pizarra limpia del arquitecto y empiece a implantarse desde cero en OCI. Aproveche los servicios gestionados nativos en la nube para todos los componentes principales de su pila. Por ejemplo, cree una pila mediante Data Flow, Data Catalog, Data Integration, Streaming, Data Science, ADW y OAC.

Oracle recomienda estos servicios para migrar a un data lake basado en la nube sin clusters Hadoop:

- Servicio de almacenamiento de objetos como tienda de data lake para todo tipo de datos raw

Nota:

Puede utilizar Object Storage con un conector HDFS como almacén de HDFS en lugar de HDFS en el cluster de Hadoop o Spark. - Servicio de integración de datos para la ingestión de datos y para trabajos de ETL

- Servicio de flujo para la ingestión gestionada de datos en tiempo real que puede reemplazar sus servicios de Kafka o Flume autogestionados

- Dispositivo de transferencia de datos para la transferencia masiva de datos única

- GoldenGate para datos CDC y para análisis de transmisión

- Servicio de flujo de datos para procesos por lotes de Spark y para clusters de Spark efímeros

- ADW para datos de la capa de presentación y presentación

- Servicio de catálogo de datos para la detección y el control de datos

- Servicio de ciencia de datos para requisitos de aprendizaje automático

- Servicio de OAC para requisitos de informes, análisis y BI

Patrón de plataforma

Utilice el patrón de migración de la plataforma si desea utilizar clusters de Hadoop en la nube y sustituir algunos de los componentes por servicios nativos en la nube. Utilice Big Data Service para HDFS y otros componentes de Hadoop y vuelva a diseñar parte de su pila mediante nuestros servicios gestionados nativos en la nube adicionales.

Puede que necesite volver a diseñar la pila para utilizar el patrón de plataforma.

- Incluir servicios nativos en la nube sin servidor junto con BDS en OCI

- Aproveche los servicios gestionados en la nube donde sea posible

Puede sustituir algunos de estos componentes según sus necesidades.

- BDS para HDFS y otros componentes de Hadoop como Hive, HBase, Kafka y Oozie

- Servicio de integración de datos para la ingestión de datos y para trabajos de ETL

- Servicio de Data Transfer Appliance para la transferencia masiva de datos puntual

- Servicio GoldenGate para datos CDC y para análisis de transmisión

- Servicio de catálogo de datos para la detección y el control de datos

- Servicio de ciencia de datos para requisitos de aprendizaje automático

- Servicio de OAC para requisitos de informes, análisis y BI

Patrón de Rehost

Migre su BDA, BDCS y otros clusters de Hadoop para crear su data lake en HDFS mediante Big Data Service (BDS). Puede utilizar un enfoque de elevación y cambio al utilizar el patrón Rehost. Todos los componentes de Hadoop más utilizados, incluidos HDFS, Hive, HBase, Spark y Oozie, están disponibles en los clusters de Hadoop gestionados que proporciona BDS.

Flujo de trabajo de patrón de migración

Al migrar su data lake a Oracle Cloud, siga este flujo de trabajo desde los requisitos hasta el nuevo entorno.

- Detección y requisitos: descubra y cataloga el sistema actual para mostrar los requisitos del nuevo entorno de OCI.

- Evaluación: evalúe los servicios y herramientas de OCI necesarios

- Diseño: diseño de la arquitectura de su solución y ajuste de tamaño para OCI

- Plan: cree un plan detallado que asigne el tiempo y los recursos.

- Aprovisionamiento: aprovisione y configure los recursos necesarios en OCI

- Migrar datos: transfiera los datos y metadatos al almacenamiento de datos de servicios de OCI seleccionado

- Migrar carga de trabajo: migre las cargas de trabajo y las aplicaciones a los servicios de OCI mediante el patrón de migración seleccionado

- Automatizar pipeline: Organice y programe pipelines de flujo de trabajo para la automatización.

- Probar y validar: planifique las pruebas funcionales y de rendimiento y la validación para el entorno de OCI final.

- Recuperación: desactive el entorno de origen y desplácese hasta que solo utilice el nuevo entorno basado en OCI.