Configuración de la pila de clusters de HPC desde Oracle Cloud Marketplace

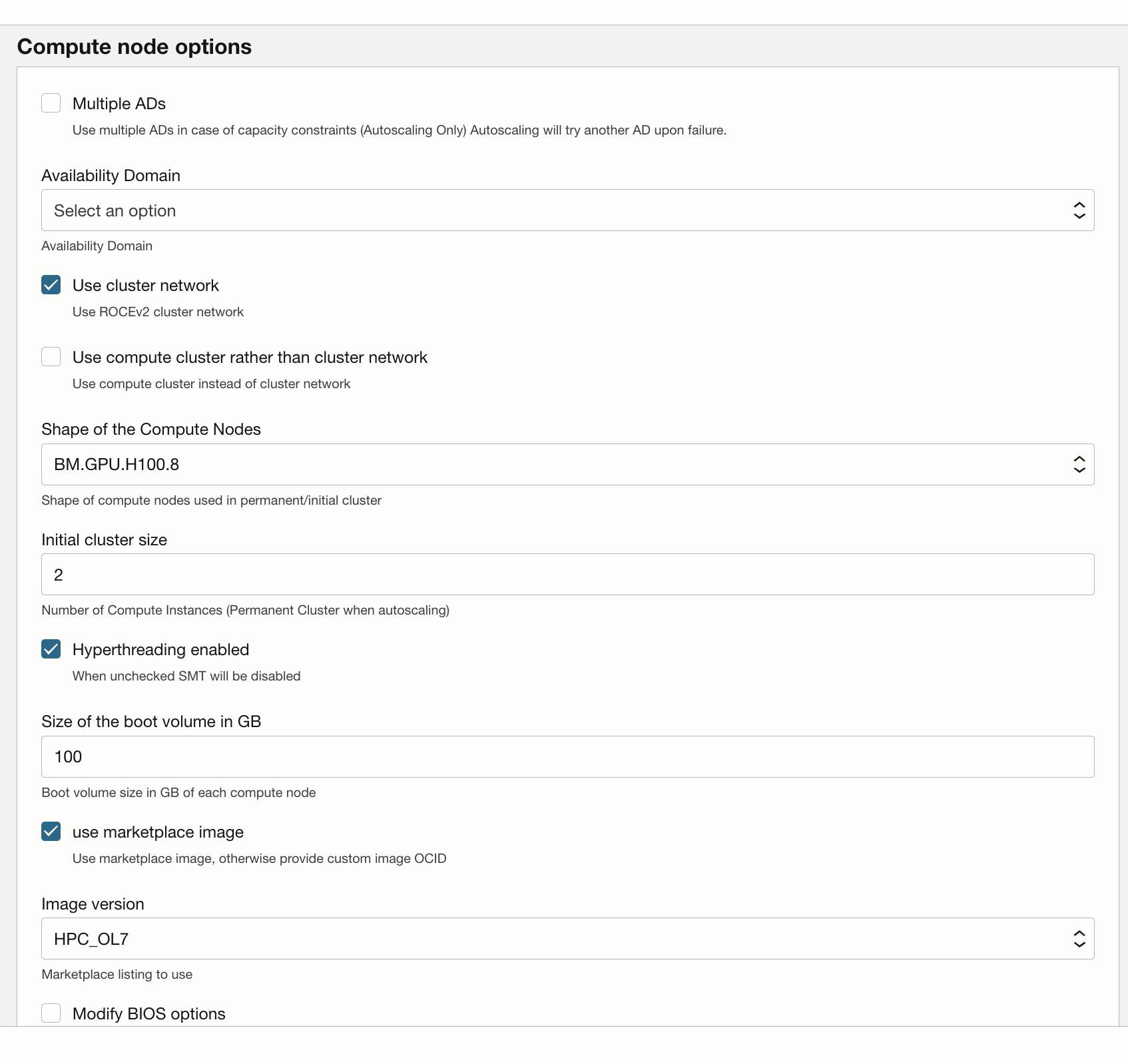

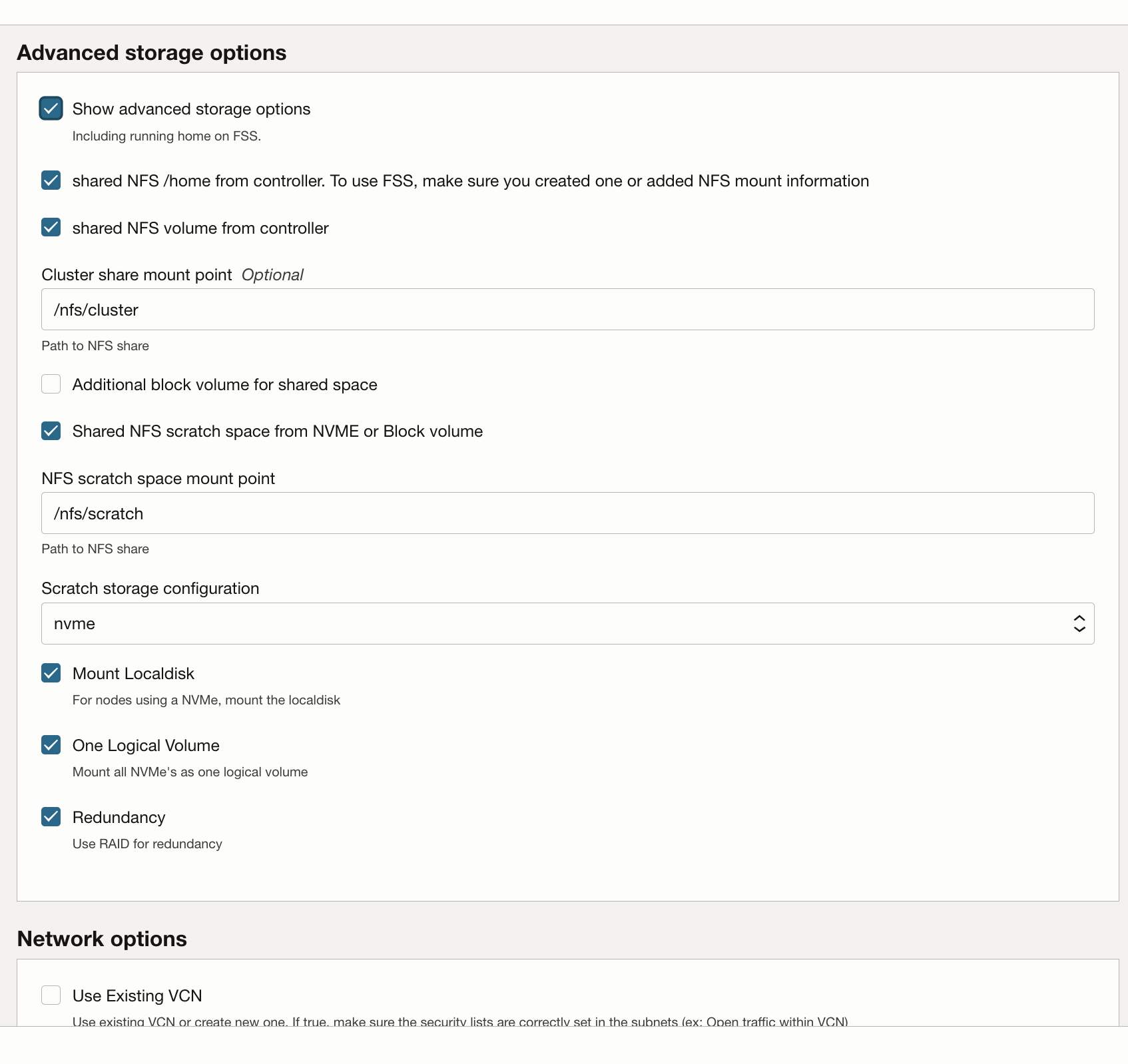

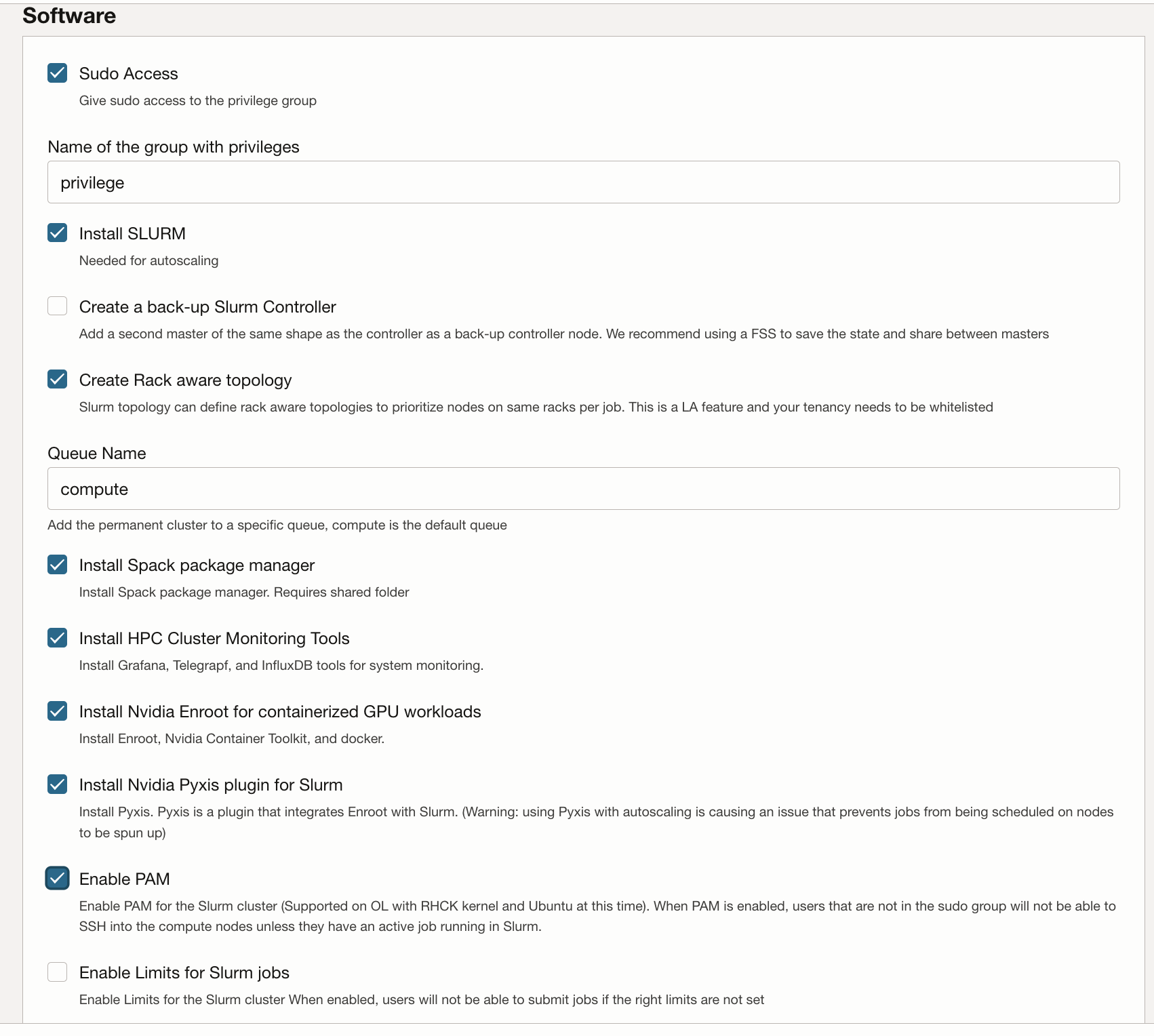

La pila de cluster de HPC utiliza Terraform para desplegar recursos de Oracle Cloud Infrastructure. La pila creará nodos de GPU, almacenamiento, redes estándar y redes de cluster de alto rendimiento, y un nodo bastión/cabeza para el acceso y la gestión del cluster.

Despliegue del cluster de GPU

Su cuenta de Oracle Cloud debe estar en un grupo con permiso para desplegar y gestionar estos recursos. Consulte las instrucciones de uso del cluster de HPC para obtener más información sobre los requisitos de políticas.

Puede desplegar la pila en un compartimento existente, pero puede que sea más limpia si crea un compartimento específicamente para el cluster.

Note:

Aunque no supone ningún costo utilizar la pila de Marketplace para aprovisionar un entorno, se le cobrará por los recursos aprovisionados cuando se inicie la pila.- Cree un compartimento para su arrendamiento y región y verifique que las políticas están disponibles.

- Utilice la pila de cluster de HPC para desplegar el cluster de GPU.