Implante Oracle Modern Data Platform para la generación de informes y previsiones empresariales

En esta sección se describe cómo aprovisionar servicios de OCI, implementar el caso de uso, visualizar datos y crear previsiones.

Aprovisionamiento de servicios de OCI

Veamos los pasos principales para aprovisionar recursos para una demostración sencilla de este caso de uso.

Implementación del caso de uso de Oracle Modern Data Platform

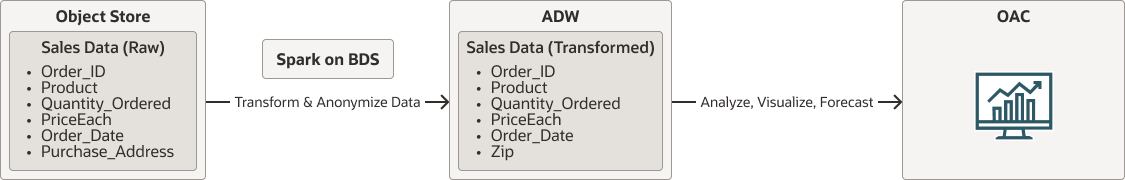

Antes de entrar en los detalles de implantación, veamos el flujo general.

- Los datos raw residirán en OCI Object Storage.

- Spark que se ejecuta de forma nativa en Oracle Big Data Service leerá datos de OCI Object Storage. Limpiará, transformará y anonimizará los datos y, por último, conservará los datos en Autonomous Data Warehouse.

- Los usuarios utilizarán Oracle Analytics Cloud para visualizar datos y realizar previsiones.

oci-modern-data-reporting-flow-oracle.zip (en inglés)

Note:

El flujo de datos elegido es un ejemplo simplista; se puede esperar que los casos de uso de negocio reales estén más involucrados.En la siguiente sección se describe cómo cargar datos de ejemplo, configurar OCI Object Storage, Oracle Big Data Service y llamar a un trabajo escala de Spark simple para transformar datos y mover datos a Autonomous Data Warehouse