-

Dans la console, naviguez jusqu'à la page Applications de flux de données.

-

Sélectionnez Lancer l'éditeur de code.

L'éditeur de code s'ouvre.

-

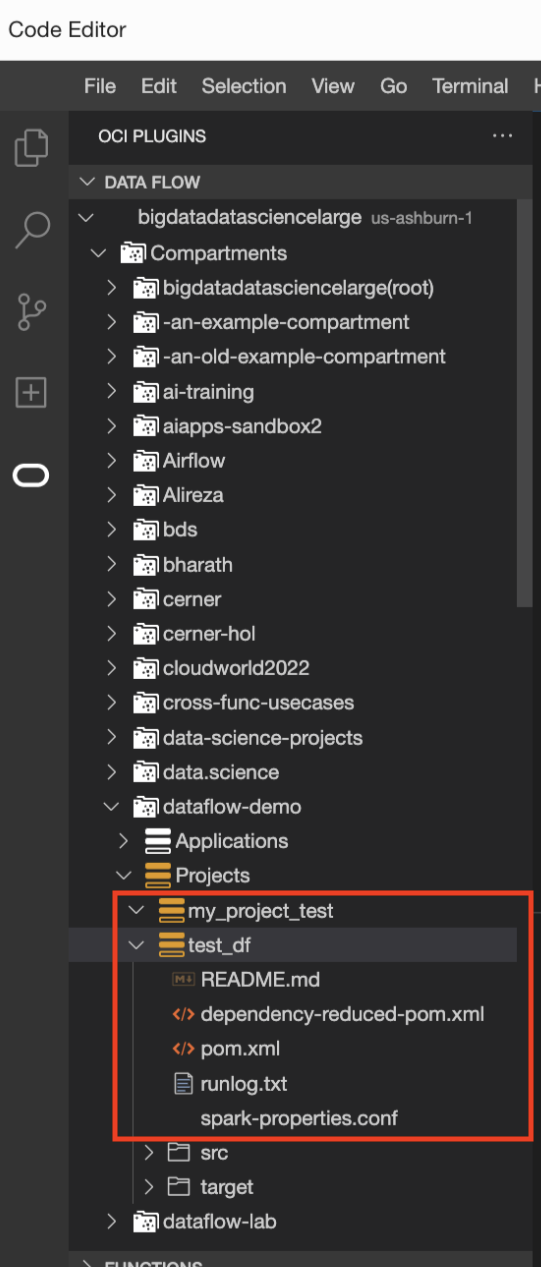

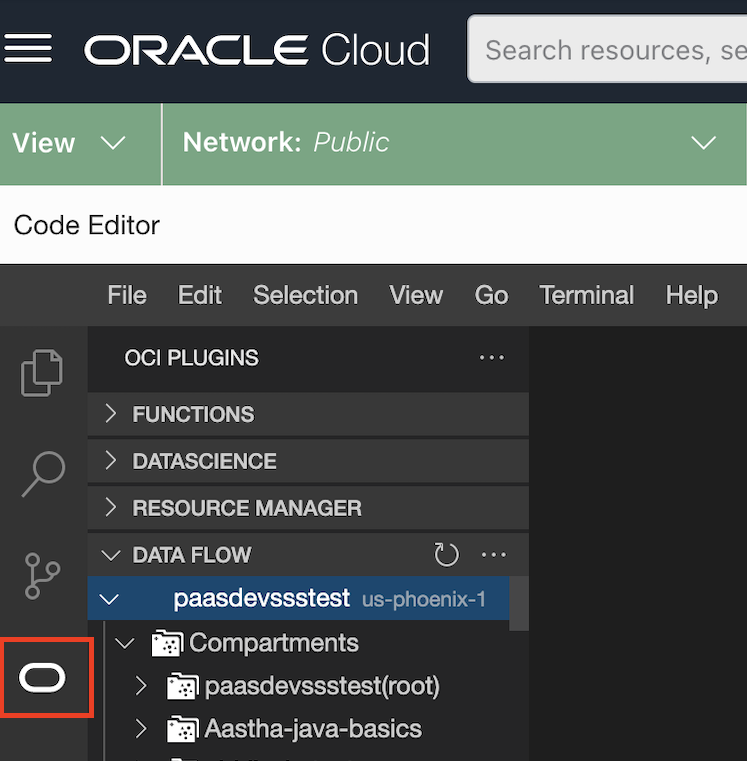

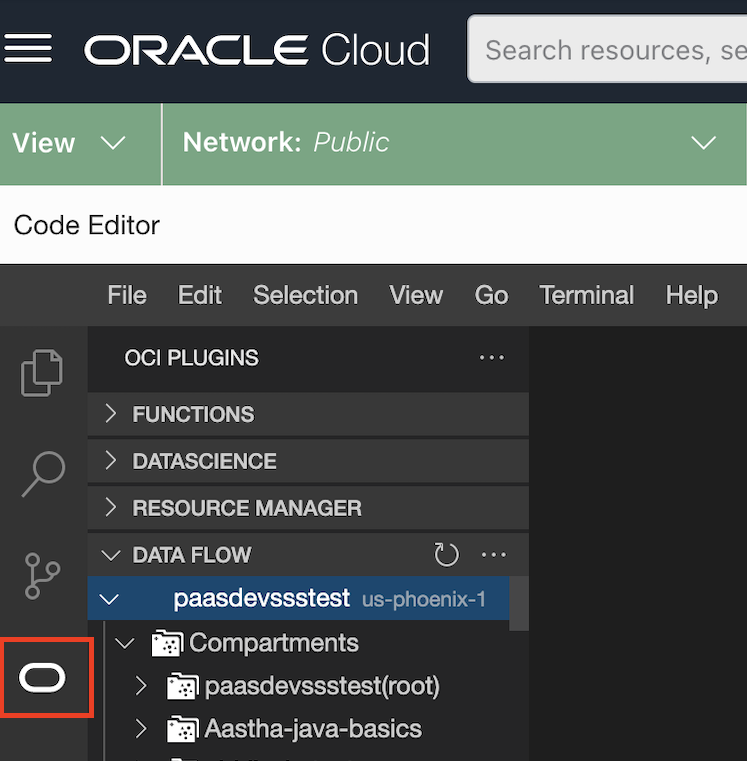

Sélectionnez le logo Oracle O.

La liste des plugiciels disponibles s'affiche.

-

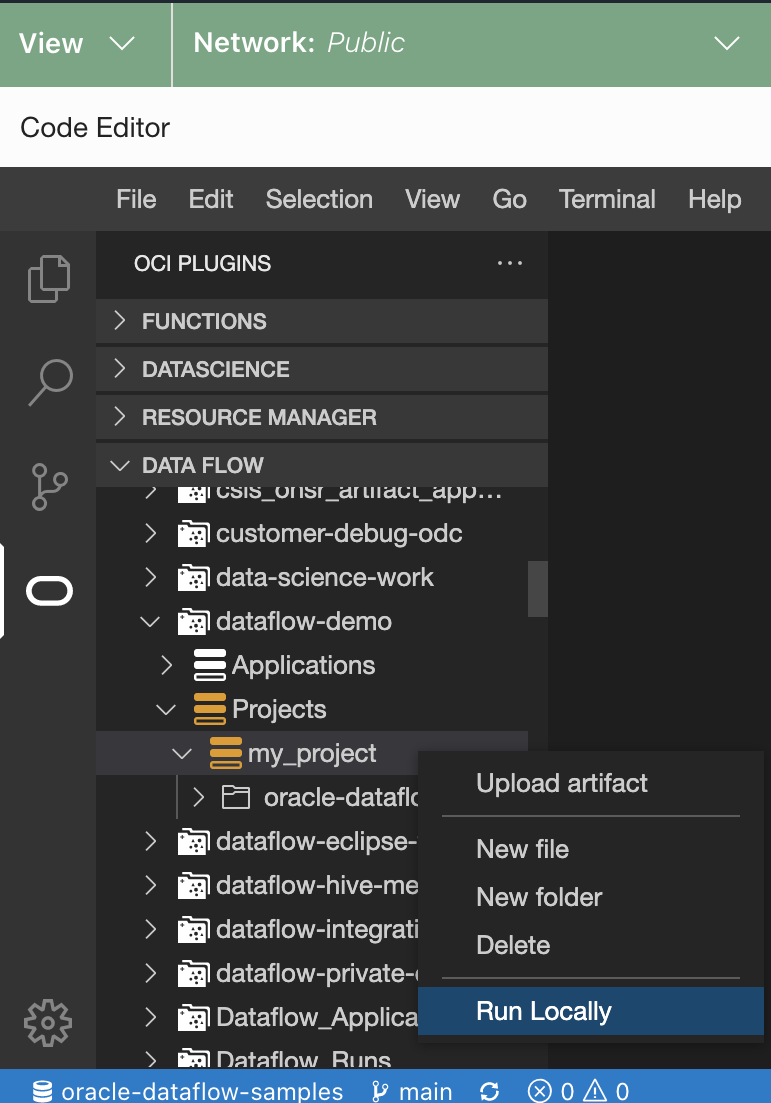

Sélectionnez le plugiciel DATA FLOW.

Il se développe pour afficher tous les compartiments et projets sous lui.

-

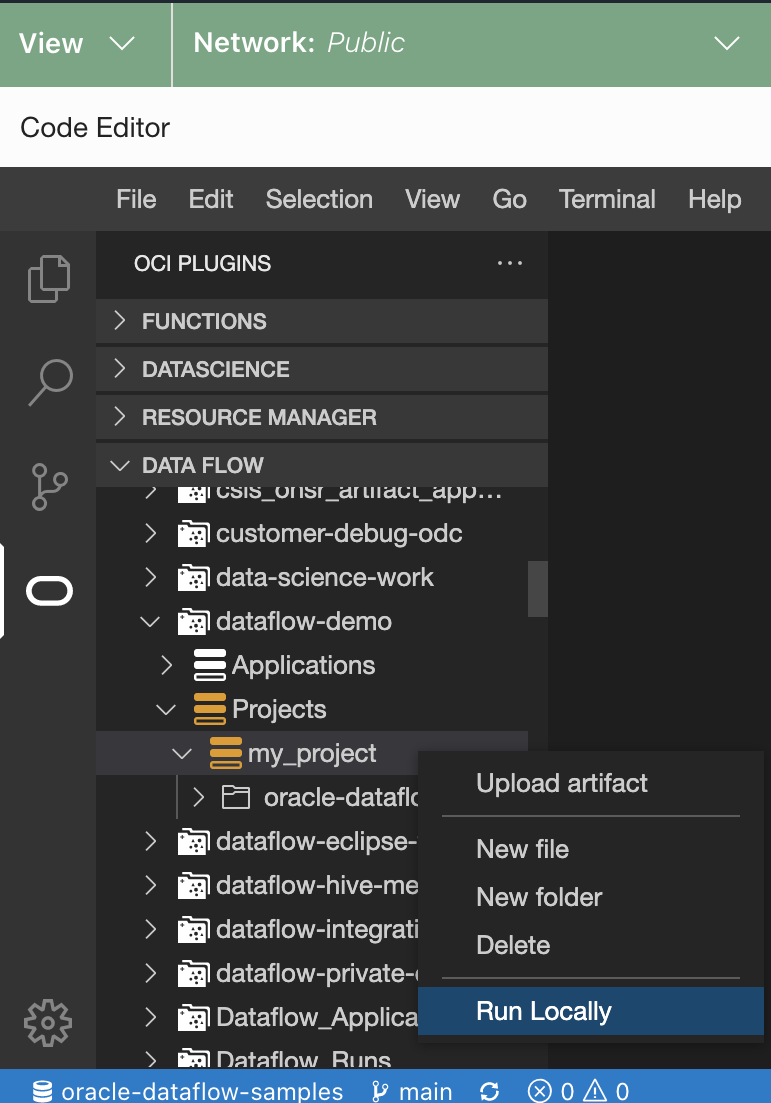

Naviguez jusqu'à l'emplacement de stockage de vos applications. Il peut s'agir d'un référentiel local ou réseau.

-

Cliquez avec le bouton droit de la souris sur le projet à exécuter et sélectionnez Exécuter localement.

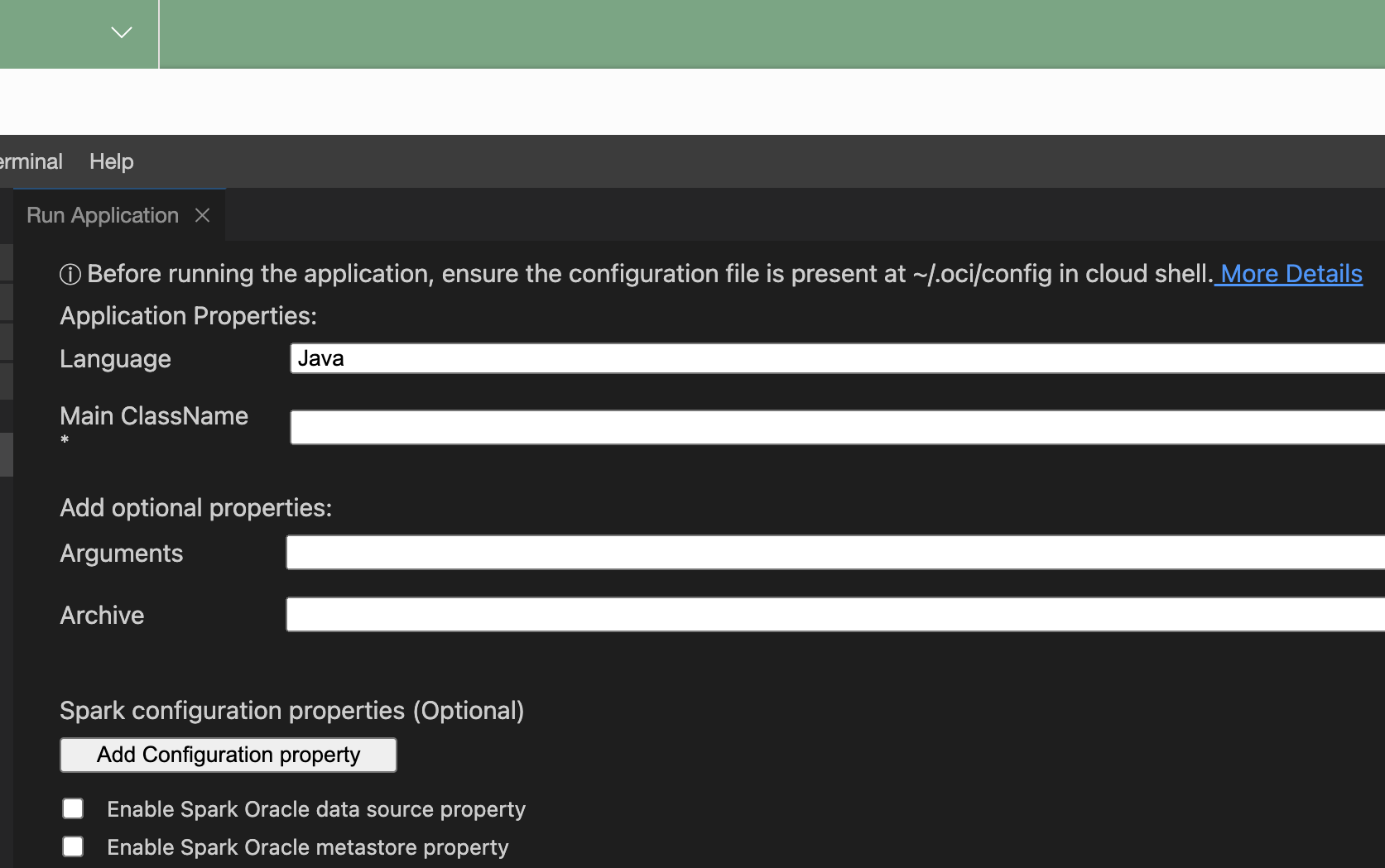

La fenêtre Run Application s'ouvre.

-

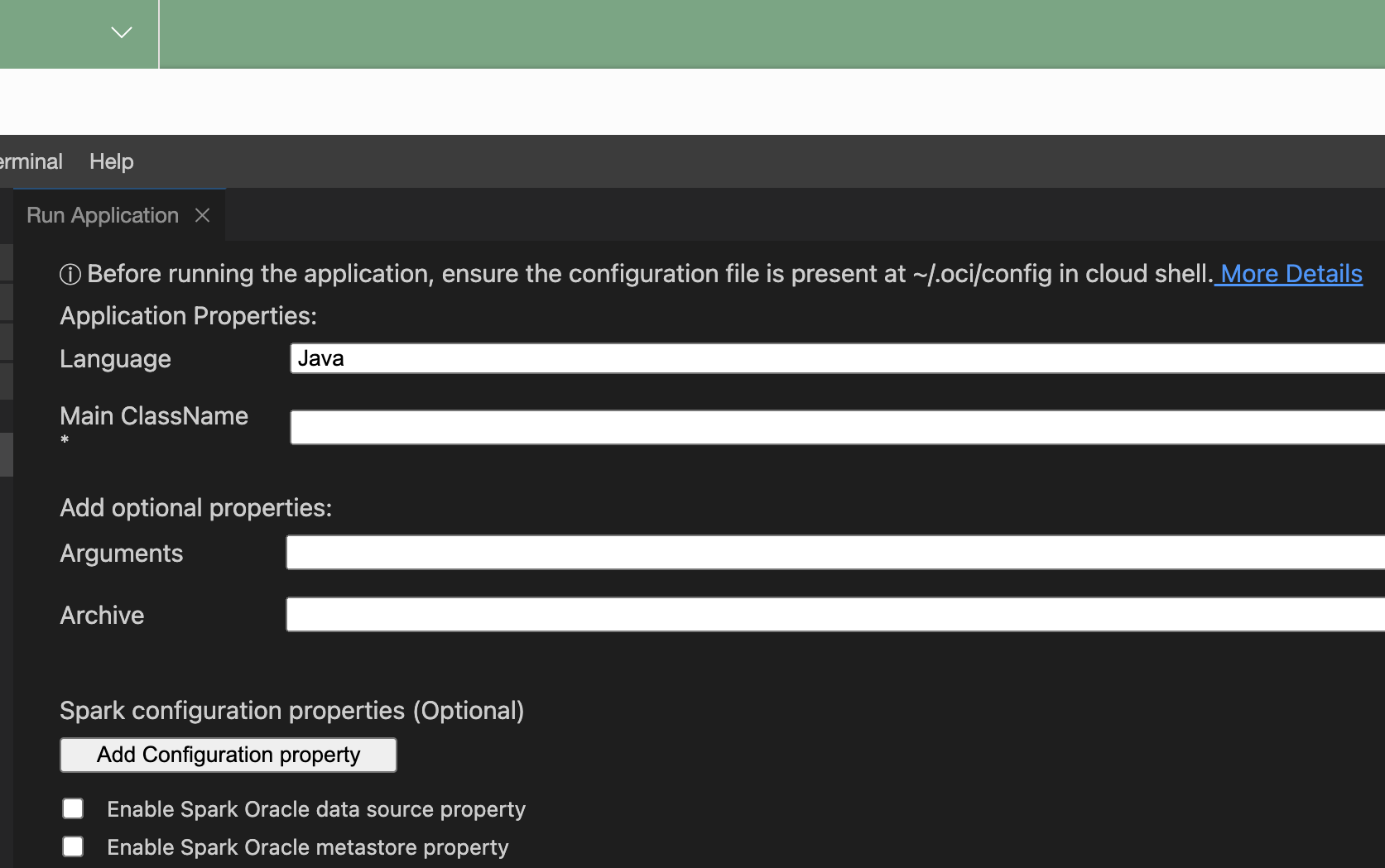

Indiquez les propriétés d'application suivantes :

-

Langue : Java, Python ou Scala.

-

Principal ClassName - Nom de la classe principale exécutée dans le projet. Pour Python, il s'agit du nom du fichier principal.

-

Arguments - Arguments de ligne de commande attendus par l'application Spark.

-

conf - Toute configuration supplémentaire pour l'exécution de l'application.

-

jars - Fichier JAR de tierce partie requis par l'application.

- Cochez la case Activer la propriété de source de données Oracle Spark pour utiliser la source de données Oracle Spark.

- Cochez la case Activer la propriété de magasin de métadonnées Oracle Spark pour utiliser un magasin de métadonnées.

- Sélectionnez un compartiment.

- Sélectionnez un magasin de métadonnées.

-

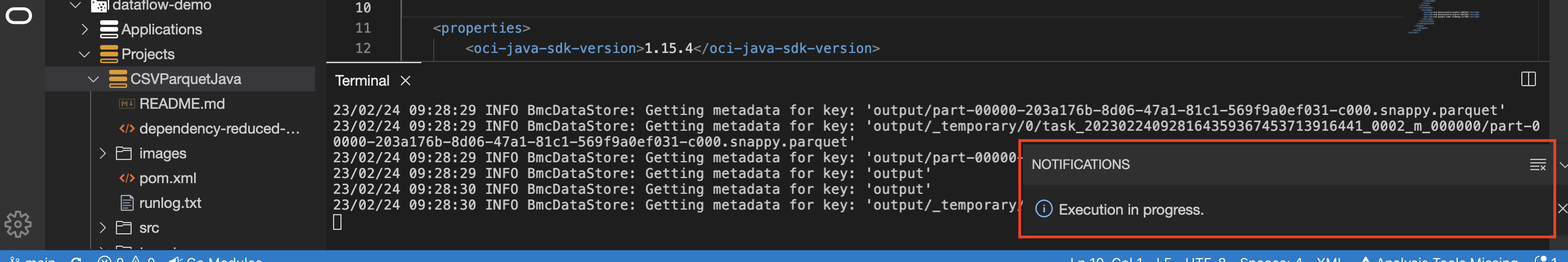

Sélectionnez Exécuter.

Le plugiciel de flux de données regroupe l'application et l'exécute.

- (Facultatif) Vérifiez le statut de l'application à partir du répertoire d'avis. La sélection du plateau Avis fournit des informations plus détaillées sur le statut.

- (Facultatif) Sélectionnez runlog.txt pour vérifier les fichiers journaux.

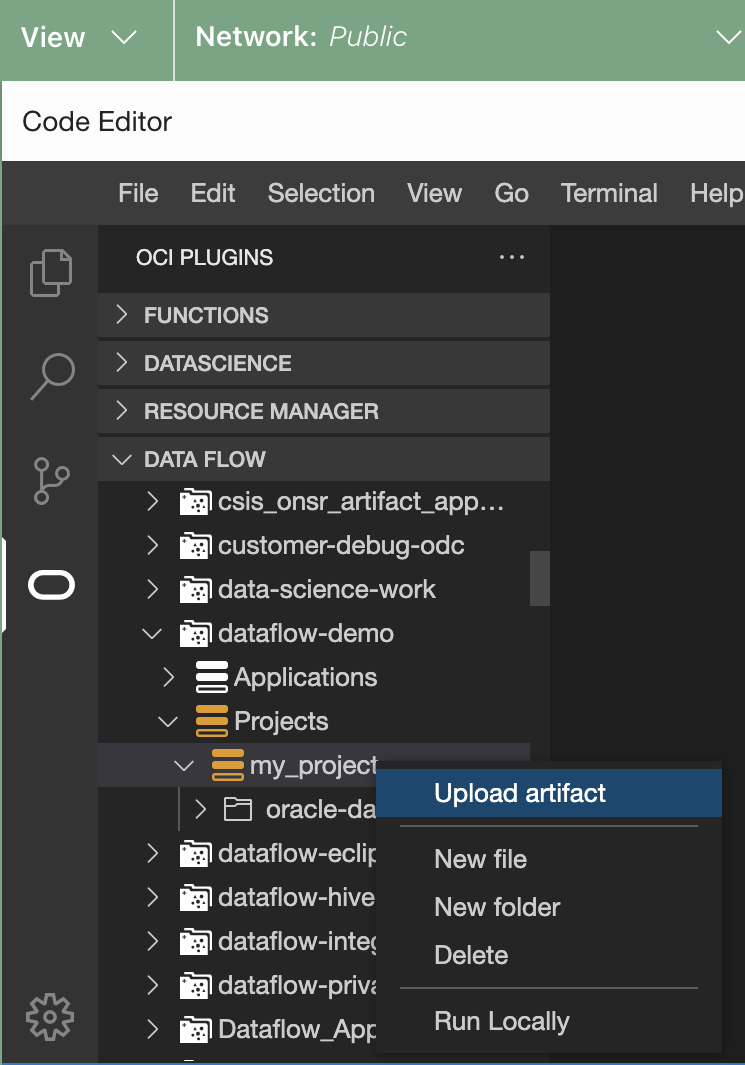

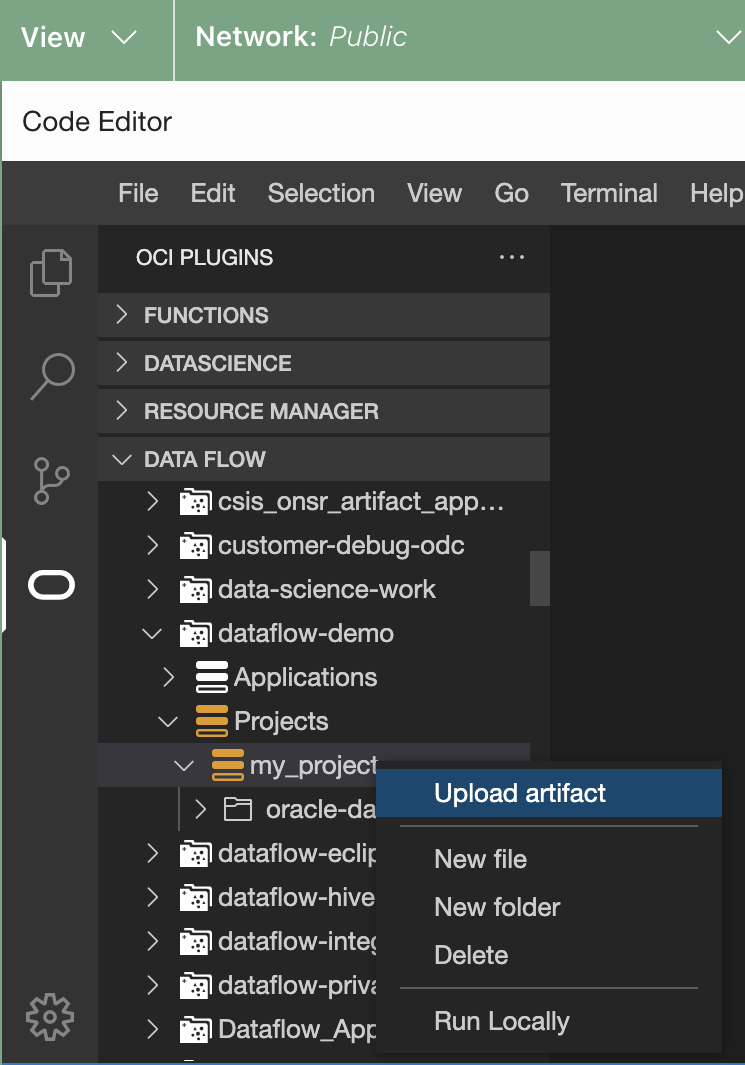

- (Facultatif) Chargez l'artefact dans le service de flux de données.

- Cliquez avec le bouton droit de la souris sur le projet en question.

- Sélectionnez Charger l'artefact.

- Sélectionnez la langue.

- Entrez l'espace de noms du stockage d'objets.

- Entrez le nom du seau.

La fenêtre Run Application s'ouvre.

La fenêtre Run Application s'ouvre.