Configurer pour la récupération après sinistre

Vous pouvez utiliser les scripts fournis avec ce livre de jeu de solutions pour créer un instantané YAML dans une grappe Kubernetes principale et le restaurer dans une autre grappe Kubernetes (secondaire). Il est important de planifier la configuration et de comprendre les exigences avant de télécharger et d'utiliser les scripts pour configurer votre instantané YAML.

Note :

Cette solution suppose que les grappes Kubernetes, y compris le plan de contrôle et les noeuds de travail, existent déjà.Planifier la configuration

Planifiez les ressources et la configuration sur le système secondaire en fonction du système principal. Les scripts nécessitent que les deux grappes Kubernetes existent déjà. Vous devez être en mesure d'accéder aux deux grappes à l'aide de l'outil de ligne de commande de Kubernetes,

kubectl, pour exécuter des commandes sur celles-ci.

Note :

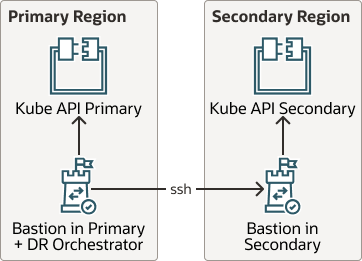

Cette solution suppose que les grappes Kubernetes, y compris le plan de contrôle et les noeuds de travail, existent déjà. Les recommandations et les scripts fournis dans ce livre de jeu ne vérifient pas les ressources, le plan de contrôle ou la configuration des noeuds de travail.Le diagramme suivant montre qu'une fois configuré, vous pouvez restaurer l'instantané d'artefact dans des grappes Kubernetes complètement différentes.

Description de l'illustration kube-api-dr.png

Répondez aux exigences suivantes pour Restore lors de la planification de votre configuration :

Vérifier

Après avoir exécuté le script

maak8DR-apply.sh, vérifiez que tous les artefacts qui existaient dans la grappe principale ont été répliqués vers la grappe secondaire. Examinez la grappe secondaire et vérifiez que les pods du site secondaire s'exécutent sans erreur.

Lorsque vous exécutez le script maak8DR-apply.sh, le cadre crée le répertoire working_dir en tant que /tmp/backup.date. Lorsque vous exécutez les scripts maak8-get-all-artifacts.sh et maak8-push-all-artifacts.sh individuellement, le répertoire de travail est fourni dans chaque cas en tant qu'argument dans la ligne de commande.