Création d'un connecteur

Créez un connecteur dans Connector Hub.

Pour éviter la désactivation automatique par Oracle Cloud Infrastructure, vérifiez que le connecteur déplace les données en vérifiant les résultats attendus au niveau du service cible et, éventuellement, en activant les journaux.

Cette page affiche des instructions générales pour la création d'un connecteur.

Les pages suivantes fournissent des instructions propres à la source :

Afin de vérifier les requêtes prises en charge pour le filtrage des journaux source, reportez-vous à Référence de requête de journal pour Connector Hub.

- Sur la page de liste Connecteurs, sélectionnez Créer un connecteur. Si vous avez besoin d'aide pour trouver la page de liste, reportez-vous à Liste des connecteurs.

- Sur la page Créer un connecteur, entrez un nom convivial pour le nouveau connecteur et éventuellement une description. Evitez de saisir des informations confidentielles.

- Sélectionnez le compartiment dans lequel stocker le nouveau connecteur.

-

Sélectionnez le service Source contenant les données à transférer :

- Logging : transférez des données de journal à partir du service Logging. Reportez-vous à Logging.

- Monitoring : transférez les points de données de mesure à partir du service Monitoring. Voir Monitoring.

- File d'attente : transférez des messages à partir d'une file d'attente du service. Reportez-vous à Queue.

- Streaming : transférez des données de flux à partir du service Streaming. Reportez-vous à Streaming.

-

Pour Cible, sélectionnez le service vers lequel transférer les données :

- Functions : envoyez les données à une fonction.

- Logging Analytics : envoyez les données à un groupe à journaux.

- Monitoring : envoyez les points de données de mesure au service Monitoring.

- Notifications : envoyez les données à un sujet.

- Object Storage : envoyez les données à un bucket.

- Streaming : envoyez les données à un flux de données.

- (Facultatif) Pour activer les journaux de service pour le nouveau connecteur, sélectionnez le commutateur Journaux et fournissez les valeurs suivantes :

- Catégorie de journal : la valeur Suivi de connecteur est automatiquement sélectionnée.

- Compartiment : sélectionnez le compartiment pour lequel stocker les journaux de service du connecteur.

- Groupe de journaux : sélectionnez le groupe de journaux à stocker pour les journaux de service. Pour créer un groupe de journaux, sélectionnez Créer un groupe, puis entrez un nom.

- Nom de journal : vous pouvez éventuellement saisir un nom pour le journal.

- Afficher les options avancées :

- Conservation de journal : indiquez éventuellement la durée de conservation des journaux de service (par défaut : 30 jours).

-

Sous Configurer la connexion source, entrez des valeurs pour la source sélectionnée.

- Journalisation

-

- Nom de compartiment : compartiment contenant le journal souhaité.

- Groupe de journaux : groupe de journaux qui contient le journal souhaité.

Pour obtenir le schéma d'entrée de journal, reportez-vous à LogEntry.

- Journaux : journal souhaité. Pour filtrer les journaux qui apparaissent dans ce champ, reportez-vous à l'étape suivante.

- Surveillance

-

- Compartiment de mesure : sélectionnez le compartiment contenant les mesures souhaitées.

- Espaces de noms : sélectionnez des espaces de noms de mesure qui incluent les mesures souhaitées. Toutes les mesures des espaces de noms sélectionnés sont extraites.

Les espaces de noms doivent commencer par "

oci_". Exemple :oci_computeagent. - Pour ajouter des espaces de noms de mesure à partir d'un autre compartiment, sélectionnez + Un autre compartiment.

Le nombre maximal de compartiments de mesure par source Monitoring est de 5. Le nombre maximal d'espaces de noms par source Monitoring (dans tous les compartiments de mesure) est de 50. Voici des exemples d'ensembles de compartiments d'une source unique qui restent dans cette limite maximale :

- 5 compartiments de mesure avec 10 espaces de noms chacun

- 3 compartiments de mesure avec un nombre variable d'espaces de noms (20, 20, 10)

- 1 compartiment de mesure avec 50 espaces de noms

- File d'attente

-

- Compartiment : sélectionnez le compartiment qui contient la file d'attente de votre choix.

- File d'attente : sélectionnez la file d'attente qui contient les messages de votre choix.Remarque

Pour sélectionner une file d'attente pour un connecteur, vous devez être autorisé à lire la file d'attente. Reportez-vous à Stratégies IAM (sécurisation de Connector Hub). -

Filtre de canal (sous Filtrage de message) (facultatif) : pour filtrer les messages des canaux de la file d'attente, entrez une valeur.

Par exemple, pour filtrer les messages par ID de canal, saisissez l'ID de canal.

Pour connaître les valeurs prises en charge, reportez-vous à

channelFilterà l'adresse GetMessages (API de file d'attente).

Remarque

Un message qui a été transféré vers la cible du connecteur est considéré comme "consommé". Pour répondre aux exigences du service de file d'attente, le connecteur supprime les messages transférés de la file d'attente source. Pour plus d'informations, reportez-vous à Utilisation des messages.

- Streaming

-

Remarque

La configuration d'adresse privée est prise en charge. Pour utiliser une adresse privée, reportez-vous à Prérequis de l'adresse privée pour Streams.- Compartiment : sélectionnez le compartiment qui contient le flux de données souhaité.

- Pool de flux de données : sélectionnez le pool de flux de données qui contient le flux de données souhaité.Remarque

Pour sélectionner un pool de flux de données et un flux de données pour un connecteur, vous devez être autorisé à lire le pool de flux de données et le flux de données. Reportez-vous à Stratégies IAM (sécurisation de Connector Hub). - Flux de données : sélectionnez le nom du flux de données à partir duquel recevoir les données.

- Position de lecture : indiquez la position du curseur à partir duquel commencer la lecture du flux de données.

- Dernier : commence la lecture des messages publiés après la création du connecteur.

- Si la première exécution d'un nouveau connecteur avec cette configuration réussit, les données sont déplacées à partir de l'heure de création du connecteur. Si la première exécution échoue (par exemple, si des stratégies sont manquantes), après la résolution, le connecteur déplace les données à partir de l'heure de création du connecteur ou, si l'heure de création est en dehors de la période de conservation, les données disponibles les plus anciennes dans le flux. Par exemple, prenons un connecteur créé à 10 heures pour un flux avec une période de conservation de deux heures. Si les exécutions en échec sont résolues à 11 heures, le connecteur déplace les données à partir de 10 heures. Si les exécutions en échec sont résolues à 1 heure du matin, le connecteur déplace les données disponibles les plus anciennes dans le flux.

- Les exécutions ultérieures déplacent les données de la position suivante dans le flux. En cas d'échec d'une exécution ultérieure, le connecteur déplace les données de la position suivante dans le flux ou des données disponibles les plus anciennes dans le flux, en fonction de la période de conservation du flux.

- Horizon de tri : commence la lecture à partir du message le plus ancien disponible dans le flux de données.

- Si la première exécution d'un nouveau connecteur avec cette configuration réussit, les données sont déplacées à partir des données les plus anciennes disponibles dans le flux. Si la première exécution échoue (par exemple avec des stratégies manquantes), après la résolution, le connecteur déplace les données disponibles les plus anciennes dans le flux, quelle que soit la période de conservation du flux.

- Les exécutions ultérieures déplacent les données de la position suivante dans le flux. En cas d'échec d'une exécution ultérieure, le connecteur déplace les données de la position suivante dans le flux ou des données disponibles les plus anciennes dans le flux, en fonction de la période de conservation du flux.

- Dernier : commence la lecture des messages publiés après la création du connecteur.

- (Facultatif) Sous Tâche de filtre de journal (disponible pour la source Logging), entrez des valeurs pour filtrer les journaux.

Pour spécifier des valeurs d'attribut pour les journaux d'audit (_Audit) :

- Type de filtre : sélectionnez Attribut.

- Nom d'attribut : sélectionnez l'attribut de journal d'audit souhaité.

- Valeurs d'attribut : indiquez les valeurs de l'attribut de journal d'audit sélectionné.

Pour spécifier des événements pour les journaux d'audit (_Audit) :

- Type de filtre : sélectionnez Type d'événement.

- Nom de service : sélectionnez le service qui contient l'événement souhaité.

- Type d'événement : sélectionnez l'événement de votre choix.

Pour spécifier des valeurs de propriété pour les journaux de service ou les journaux personnalisés (pas _Audit), procédez comme suit :

- Propriété : sélectionnez la propriété souhaitée.

- Opérateur : sélectionnez l'opérateur à utiliser pour le filtrage des valeurs de propriété.

- Valeur : indiquez la valeur de propriété souhaitée.

Pour consulter les requêtes prises en charge de filtrage des journaux source, reportez-vous à Référence de requête de journal pour Connector Hub.

- (Facultatif) Sous Configurer une tâche de fonction, configurez une tâche de fonction pour traiter les données de la source à l'aide du service Functions :

- Sélectionner une tâche : sélectionnez Fonction.

- Compartiment : sélectionnez le compartiment qui contient la fonction voulue.

- Application de fonction : sélectionnez le nom de l'application de fonction qui inclut la fonction souhaitée.

- Fonction : sélectionnez le nom de la fonction à utiliser pour traiter les données reçues de la source.

Pour être utilisée en tant que tâche par le connecteur, la fonction doit être configurée pour renvoyer l'une des réponses suivantes :

- Liste des entrées JSON (doit définir l'en-tête de réponse

Content-Type=application/json) - Entrée JSON unique (doit définir l'en-tête de réponse

Content-Type=application/json) - Objet binaire unique (doit définir l'en-tête de réponse

Content-Type=application/octet-stream)

- Liste des entrées JSON (doit définir l'en-tête de réponse

- Afficher les options supplémentaires : sélectionnez ce lien et indiquez des limites pour chaque batch de données envoyé à la fonction. Pour utiliser les paramètres manuels, indiquez des valeurs pour la limite de taille de batch (ko) et la limite de temps de batch (secondes).

Remarques concernant les tâches de fonction :

- Connector Hub n'analyse pas la sortie de la tâche de fonction. La sortie de la tâche de fonction est écrite telle quelle sur la cible. Par exemple, lors de l'utilisation d'une cible Notifications avec une tâche de fonction, tous les messages sont envoyés en tant qu'objets BLOB JSON bruts.

- Les fonctions sont appelées de manière synchrone avec 6 Mo de données par appel. Si les données dépassent 6 Mo, le connecteur appelle à nouveau la fonction pour déplacer les données qui dépassent la limite. Ces appels sont traités séquentiellement.

- Les fonctions peuvent s'exécuter pendant cinq minutes au maximum. Reportez-vous à Détails de la livraison.

- Les tâches de fonction sont limitées aux fonctions scalaires.

-

Si vous avez sélectionné Functions comme cible, sous Configurer la cible, configurez la fonction à laquelle envoyer les données de journal. Passez ensuite à l'étape 17.

- Compartiment : sélectionnez le compartiment qui contient la fonction voulue.

- Application de fonction : sélectionnez le nom de l'application de fonction contenant la fonction souhaitée.

- Fonction : sélectionnez le nom de la fonction à laquelle envoyer les données.

- Afficher les options supplémentaires : sélectionnez ce lien et indiquez des limites pour chaque batch de données envoyé à la fonction. Pour utiliser les paramètres manuels, indiquez des valeurs pour la limite de taille de batch (en Ko ou en nombre de messages) et la limite de temps de batch (en secondes).

Par exemple, limitez la taille du lot en sélectionnant 5 000 kilo-octets ou 10 messages. Un exemple de limite de durée de batch est de 5 secondes.

Remarques concernant les cibles Functions :

- Le connecteur vide les données source sous la forme d'une liste JSON dans des batches. La taille maximale du batch ou de la charge utile est de 6 Mo.

- Les fonctions sont appelées de manière synchrone avec 6 Mo de données par appel. Si les données dépassent 6 Mo, le connecteur appelle à nouveau la fonction pour déplacer les données qui dépassent la limite. Ces appels sont traités séquentiellement.

- Les fonctions peuvent s'exécuter pendant cinq minutes au maximum. Reportez-vous à Détails de la livraison.

- Ne renvoyez pas les données des cibles Functions aux connecteurs. Connector Hub ne lit pas les données renvoyées par les cibles Functions.

-

Si vous avez sélectionné Logging Analytics comme cible, sous Configurer la cible, configurez le groupe de journaux auquel envoyer les données de journal. Passez ensuite à l'étape 17.

- Compartiment : sélectionnez le compartiment contenant le groupe de journaux souhaité.

- Groupe : sélectionnez le groupe de journal souhaité.

- Identificateur de source de journal (pour la source Streaming uniquement) : sélectionnez la source de journal.

-

Si vous avez sélectionné Surveillance comme cible, sous Configurer la cible, configurez la mesure à laquelle envoyer les données de journal. Passez ensuite à l'étape 17.

- Compartiment : sélectionnez le compartiment qui contient la mesure voulue.

- Espace de noms de mesure : sélectionnez les espaces de noms de mesure qui incluent la mesure souhaitée. Vous pouvez sélectionner un espace de noms existant ou en saisir un nouveau.

Lorsque vous saisissez un nouvel espace de noms, appuyez sur Entrée pour le soumettre.

Pour un nouvel espace de noms de mesure, n'utilisez pas le préfixe

oci_réservé. Les mesures ne sont pas incluses lorsque des préfixes réservés sont utilisés. Reportez-vous à Publication de mesures personnalisées et à Référence PostMetricData (API). - Mesure : sélectionnez le nom de la mesure à laquelle envoyer les données. Vous pouvez sélectionner une mesure existante ou en saisir une nouvelle.

Lorsque vous saisissez un nouveau nom de mesure, appuyez sur Entrée pour le soumettre.

Pour une nouvelle mesure, n'utilisez pas le préfixe

oci_réservé. Les mesures ne sont pas incluses lorsque des préfixes réservés sont utilisés. Reportez-vous à Publication de mesures personnalisées et à Référence PostMetricData (API). -

Ajouter des dimensions : sélectionnez ce bouton pour éventuellement configurer des dimensions. Le panneau Ajouter des dimensions s'ouvre.

Les six dernières lignes des données de journal sont extraites du journal indiqué sous Configurer une source.

Indiquez une paire de clés nom/valeur pour chaque dimension à laquelle envoyer des données. Le nom peut être personnalisé et la valeur peut être soit statique, soit un chemin à évaluer. Utilisez des dimensions pour filtrer les données de journal après leur déplacement vers une mesure. Pour consulter un cas d'emploi de dimension, reportez-vous à Scénario : création de dimensions pour une cible Monitoring.

Pour extraire des données (valeur de chemin), procédez comme suit :-

Sous Sélectionner un chemin, sélectionnez la flèche vers le bas pour le journal souhaité.

Les chemins d'accès sont répertoriés pour le journal développé.

-

Cochez la case correspondant au chemin souhaité.

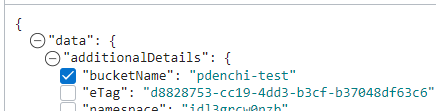

L'image suivante présente un exemple de chemin sélectionné (

bucketName) et de chemin non sélectionné (eTag) :

Sous Modifier le chemin, les champs Nom de la dimension et Valeur sont automatiquement renseignés à partir du chemin sélectionné.

Si aucune donnée de journal n'est disponible, vous pouvez saisir manuellement une valeur de chemin avec un nom de dimension personnalisée sous Modifier le chemin. Le chemin doit commencer parlogContentet utiliser la notation par points (.) ou par index ([]). Les points et les index sont les seuls sélecteurs JMESPath pris en charge. Exemples :logContent.data(notation par points)logContent.data[0].content(notation par index)

Pour plus d'informations sur la notation de chemin valide, reportez-vous à JmesPathDimensionValue.

- Modifiez éventuellement le nom de la dimension.

Pour baliser des données (valeur statique), procédez comme suit :

-

Sous Valeurs statiques, sélectionnez + Une autre valeur statique, puis saisissez un nom et une valeur de dimension. Par exemple, entrez

trafficetcustomer.

-

Remarque

Pour les nouvelles mesures (personnalisées), l'espace de noms et la mesure de mesure indiqués sont créés la première fois que le connecteur déplace des données de la source vers le service Monitoring. Pour vérifier l'existence de données déplacées, interrogez la nouvelle mesure à l'aide de la console, de l'interface de ligne de commande ou de l'API. Reportez-vous à Création d'une requête pour une mesure personnalisée.Eléments inclus avec la mesure

Outre les paires de clés nom/valeur de dimension que vous indiquez sous Configurer des dimensions, les dimensions suivantes sont incluses dans la mesure :connectorId: OCID du connecteur auquel les mesures s'appliquent.connectorName: nom du connecteur concerné par les mesures.connectorSourceType: service source concerné par les mesures.

L'horodatage de chaque point de données de mesure est l'horodatage du message de journal correspondant.

-

Si vous avez sélectionné Notifications comme cible, sous Configurer la cible, configurez la rubrique à laquelle envoyer les données de journal. Passez ensuite à l'étape 17.

- Compartiment : sélectionnez le compartiment qui contient le sujet souhaité.

- Sujet : sélectionnez le nom du sujet auquel envoyer les données.

- Format de message : sélectionnez l'option souhaitée :Remarque

Les options Format de message sont disponibles uniquement pour les connecteurs avec la source de journalisation. Ces options ne sont pas disponibles pour les connecteurs avec des tâches de fonction. Lorsque les options de format de message ne sont pas disponibles, les messages sont envoyés en tant que objets BLOB JSON bruts.- Envoyer les messages formatés : mise en page simplifiée et conviviale.

Pour afficher les protocoles d'abonnement et les types de message pris en charge pour les messages formatés, reportez-vous à Formatage convivial.

- Envoyer les messages bruts : objet BLOB JSON brut.

- Envoyer les messages formatés : mise en page simplifiée et conviviale.

Remarques concernant les cibles Notifications :

- La taille maximale des messages pour la cible Notifications est de 128 ko. Tout message qui dépasse la taille maximale est supprimé.

- Les SMS présentent des résultats inattendus pour certaines configurations de connecteur. Ce problème est limité aux sujets contenant des abonnements par SMS pour les configurations de connecteur indiquées. Pour plus d'informations, reportez-vous à Plusieurs SMS pour une même notification.

-

Si vous avez sélectionné Object Storage comme cible, sous Configurer la cible, configurez le bucket vers lequel envoyer les données de journal. Passez ensuite à l'étape 17.

- Compartiment : sélectionnez le compartiment qui contient le bucket souhaité.

- Bucket : sélectionnez le nom du bucket auquel envoyer les données.

- Préfixe de nom d'objet : entrez éventuellement une valeur de préfixe.

- Afficher les options supplémentaires : sélectionnez ce lien et saisissez éventuellement des valeurs pour la taille de batch (en Mo) et le temps de batch (en millisecondes).

Remarques concernant les cibles Object Storage :

-

Détails du remplacement de batch :

- Taille pour remplacement du batch : 100 Mo

- Durée pour remplacement du batch : 7 minutes

-

Les fichiers enregistrés dans Object Storage sont compressés à l'aide de gzip.

-

Format des données déplacées à partir d'une source Monitoring : Objets. Le connecteur partitionne les données source de Monitoring par espace de noms de mesure et écrit les données de chaque groupe (espace de noms) dans un objet. Chaque nom d'objet inclut les éléments suivants.

<object_name_prefix>/<service_connector_ocid>/<metric_compartment_ocid>/<metric_namespace>/<data_start_timestamp>_<data_end_timestamp>.<sequence_number>.<file_type>.gzAu sein d'un objet, chaque ensemble de points de données est ajouté à une nouvelle ligne.

-

Si vous avez sélectionné Streaming comme cible, sous Configurer la cible, configurez le flux vers lequel envoyer les données de journal.

Remarque

Pour sélectionner un pool de flux de données et un flux de données pour un connecteur, vous devez être autorisé à lire le pool de flux de données et le flux de données. Reportez-vous à Stratégies IAM (sécurisation de Connector Hub). La configuration d'adresse privée est prise en charge. Pour utiliser une adresse privée, reportez-vous à Prérequis de l'adresse privée pour Streams.- Compartiment : sélectionnez le compartiment qui contient le flux de données souhaité.

- Flux de données : sélectionnez le nom du flux de données auquel envoyer les données.

Remarques concernant les cibles Streaming :

- Format des données déplacées à partir d'une source Monitoring : chaque objet est écrit en tant que message distinct.

-

Pour accepter les stratégies par défaut, sélectionnez le lien Créer fourni pour chaque stratégie par défaut.

Des stratégies par défaut sont proposées pour toutes les autorisations requises afin que ce connecteur accède aux services source, de tâche et cible.

Vous pouvez obtenir cette autorisation via ces stratégies par défaut ou via des stratégies basées sur des groupes. Les stratégies par défaut sont proposées chaque fois que vous utilisez la console pour créer ou modifier un connecteur. La seule exception est lorsque la stratégie exacte existe déjà dans IAM, auquel cas la stratégie par défaut n'est pas proposée. Pour plus d'informations sur cette exigence d'autorisation, reportez-vous à Authentification et autorisation.

- Si vous n'êtes pas autorisé à accepter les stratégies par défaut, contactez l'administrateur.

- Les stratégies créées automatiquement sont conservées lorsque des connecteurs sont supprimés. Il est recommandé de supprimer les stratégies associées lors de la suppression d'un connecteur.

Pour consulter une stratégie nouvellement créée, sélectionnez le lien de vue associé.

- (Facultatif) Ajoutez des balises au connecteur : sélectionnez Afficher les options avancées pour afficher la section Ajouter des balises.

Si vous disposez des droits d'accès permettant de créer une ressource, vous disposez également de ceux permettant de l'appliquer à cette ressource. Pour appliquer une balise defined, vous devez être autorisé à utiliser la balise namespace. Pour plus d'informations sur le balisage, reportez-vous à Balises de ressource. Si vous n'êtes pas sûr d'appliquer des balises, ignorez cette option ou demandez à un administrateur. Vous pouvez appliquer des balises ultérieurement.

- Sélectionnez Créer.

Le processus de création commence et sa progression s'affiche. Une fois l'opération terminée, la page de détails du connecteur s'ouvre. Utilisez la commande oci sch service-connector create et les paramètres requis pour créer un connecteur :

oci sch service-connector create --display-name "<display_name>" --compartment-id <compartment_OCID> --source [<source_in_JSON>] --target [<target_in_JSON>]Pour obtenir la liste complète des paramètres et des valeurs des commandes de la CLI, reportez-vous à Référence des commandes de la CLI.

Exécutez l'opération CreateServiceConnector pour créer un connecteur.

Confirmer le déplacement des données par le nouveau connecteur

Une fois le connecteur créé, vérifiez qu'il déplace les données.

- Activez les journaux pour que le connecteur obtienne des détails sur le flux de données.

- Recherchez les résultats attendus sur le service cible.

La confirmation du déplacement des données vous permet d'éviter la désactivation automatique, qui se produit lorsqu'un connecteur tombe en panne pendant une longue période.

Flux privés : il n'est pas possible de mettre à niveau un connecteur existant pour utiliser un flux avec une adresse privée. Si le pool de flux de données sélectionné pour la source ou la cible de flux de données est public, il ne peut pas être modifié en privé et le connecteur ne peut pas être mis à jour pour référencer un flux de données privé. Pour modifier la source ou la cible afin d'utiliser un flux privé différent, ou pour utiliser une source ou une cible autre que Streaming, recréez le connecteur avec la source et la cible souhaitées. Un flux de données déplacé vers un autre pool de flux de données est un exemple de la nécessité d'un autre flux de données privé. Dans ce cas, recréez le connecteur à l'aide du flux déplacé. Assurez-vous de désactiver ou de supprimer l'ancien connecteur avec la source ou la cible de flux que vous ne souhaitez plus utiliser.