-

Dans la console, accédez à la page Applications Data Flow.

-

Sélectionnez Lancer l'éditeur de code.

L'éditeur de code s'ouvre.

-

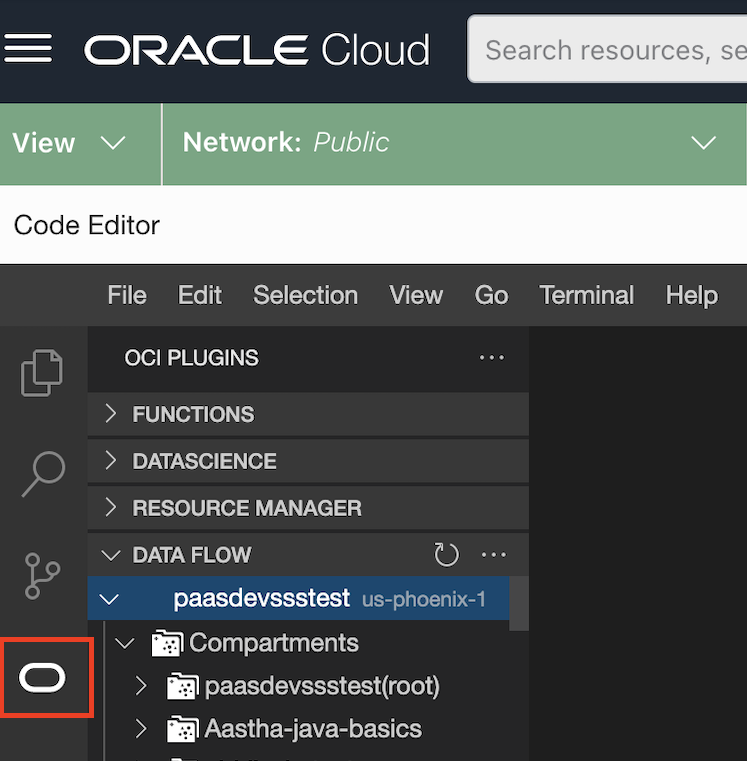

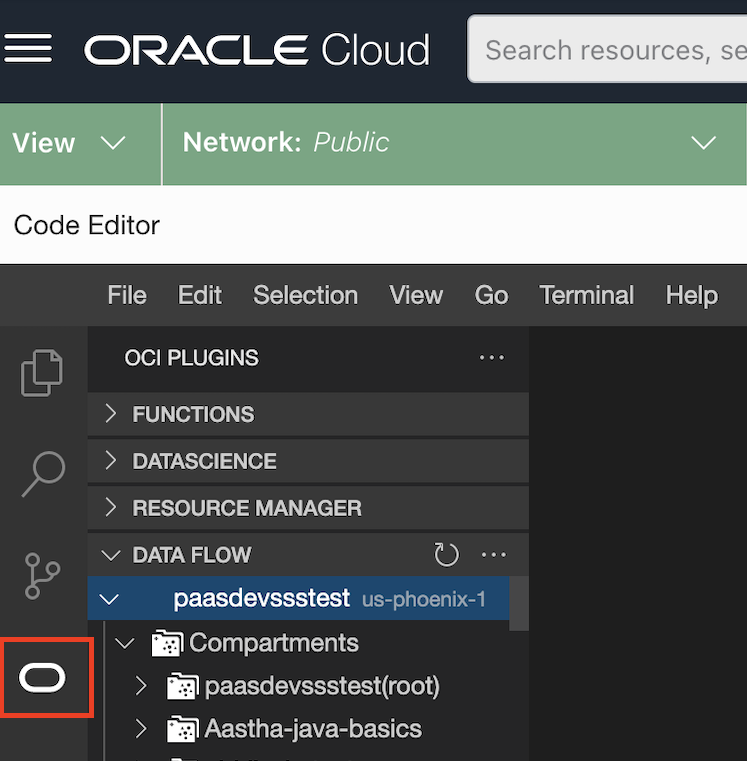

Sélectionnez le logo Oracle O.

La liste des modules d'extension disponibles s'affiche.

-

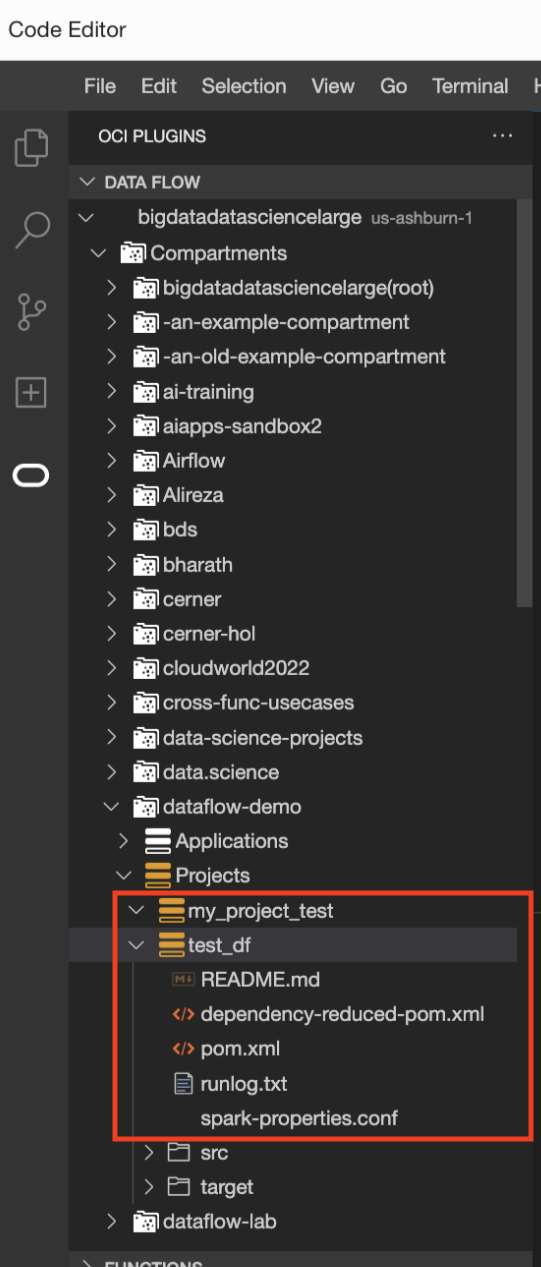

Sélectionnez le module d'extension DATA FLOW.

Elle s'étend pour afficher tous les compartiments et projets situés en dessous.

-

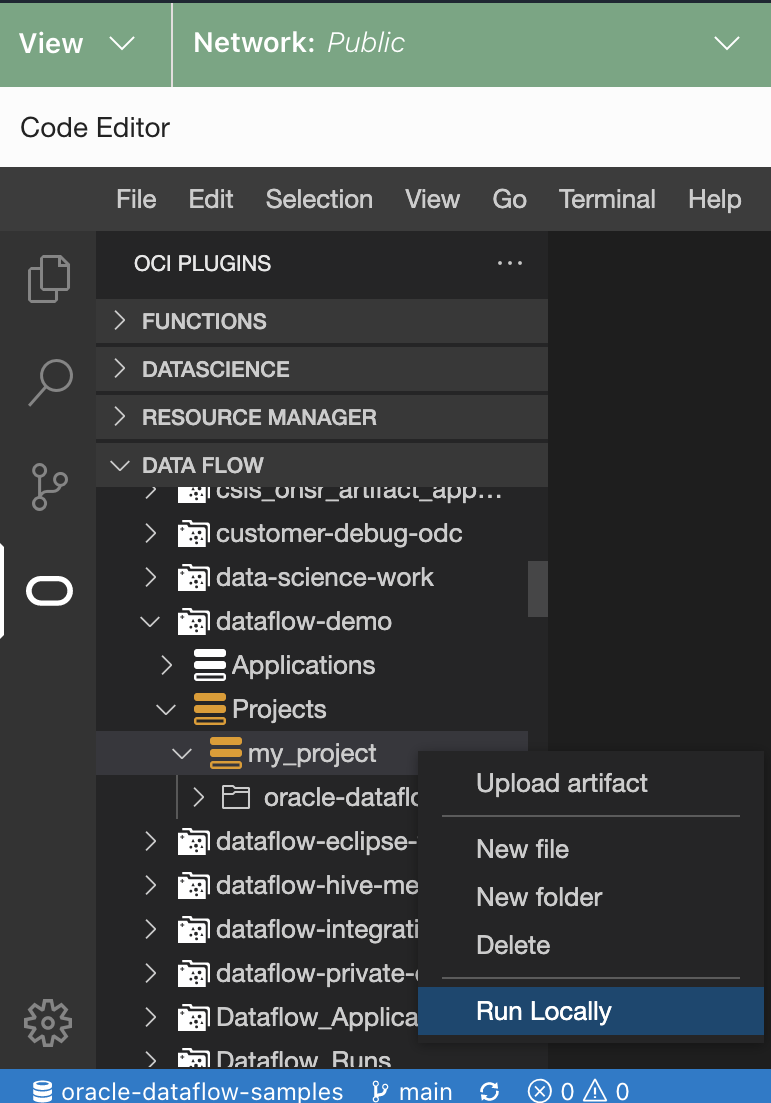

Accédez à l'emplacement de stockage des applications. Il peut s'agir d'un référentiel local ou réseau.

-

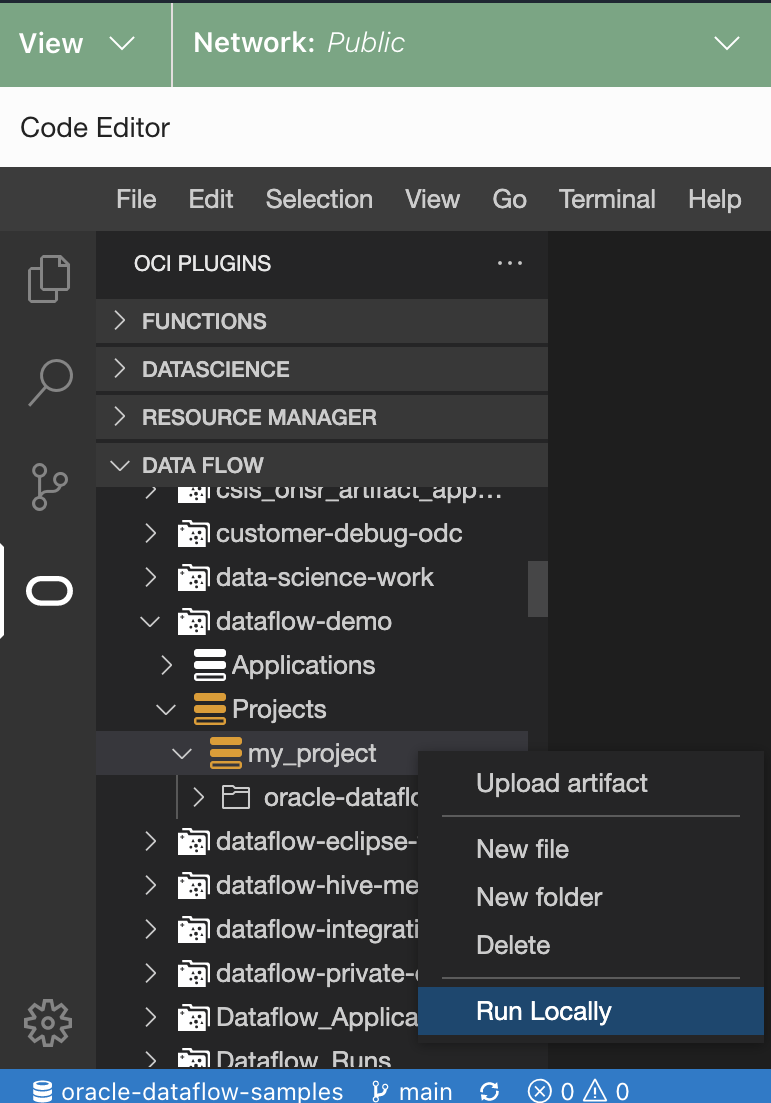

Cliquez avec le bouton droit de la souris sur le projet à exécuter et sélectionnez Exécuter localement.

La fenêtre Run Application (Exécuter l'application) s'ouvre.

-

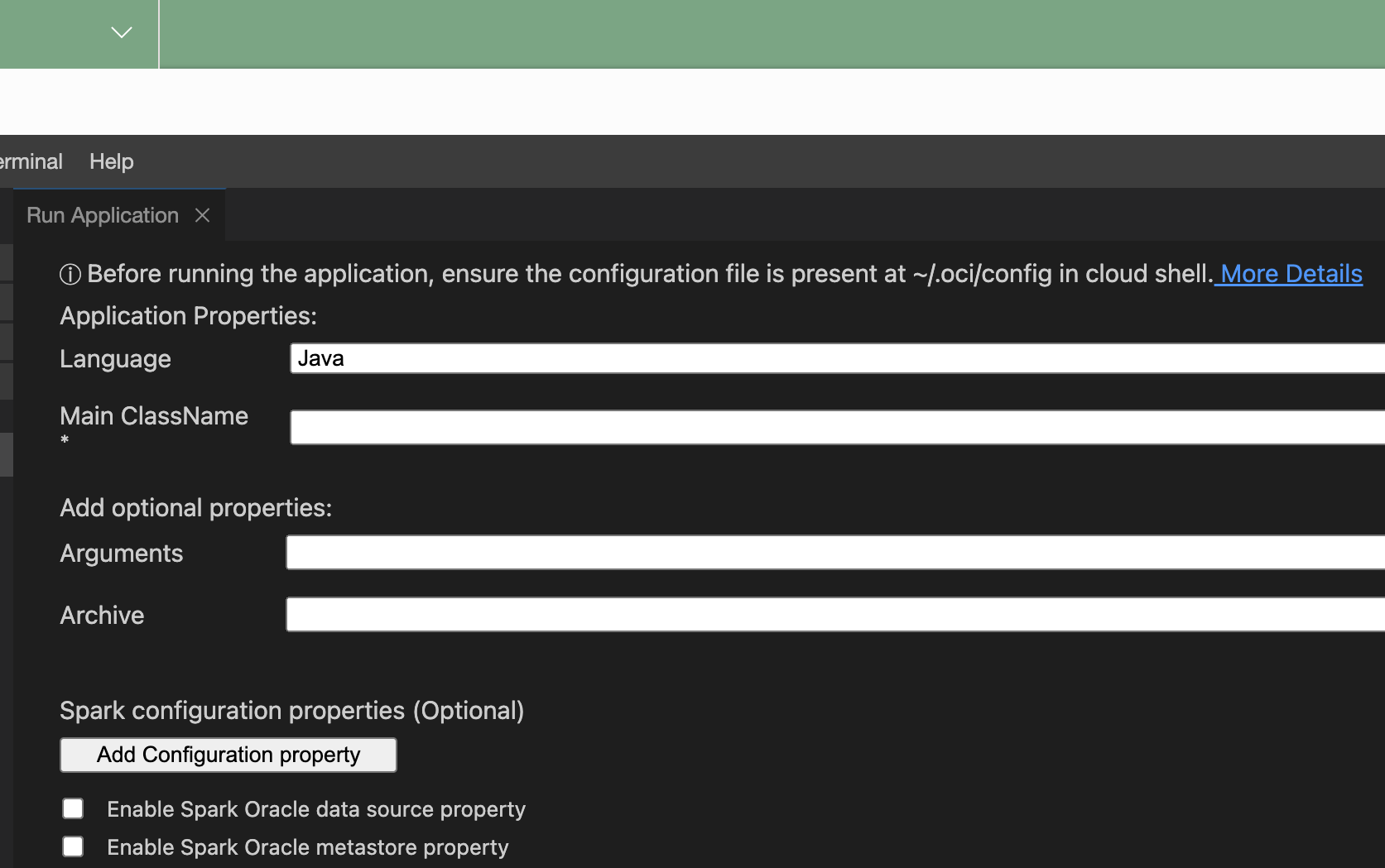

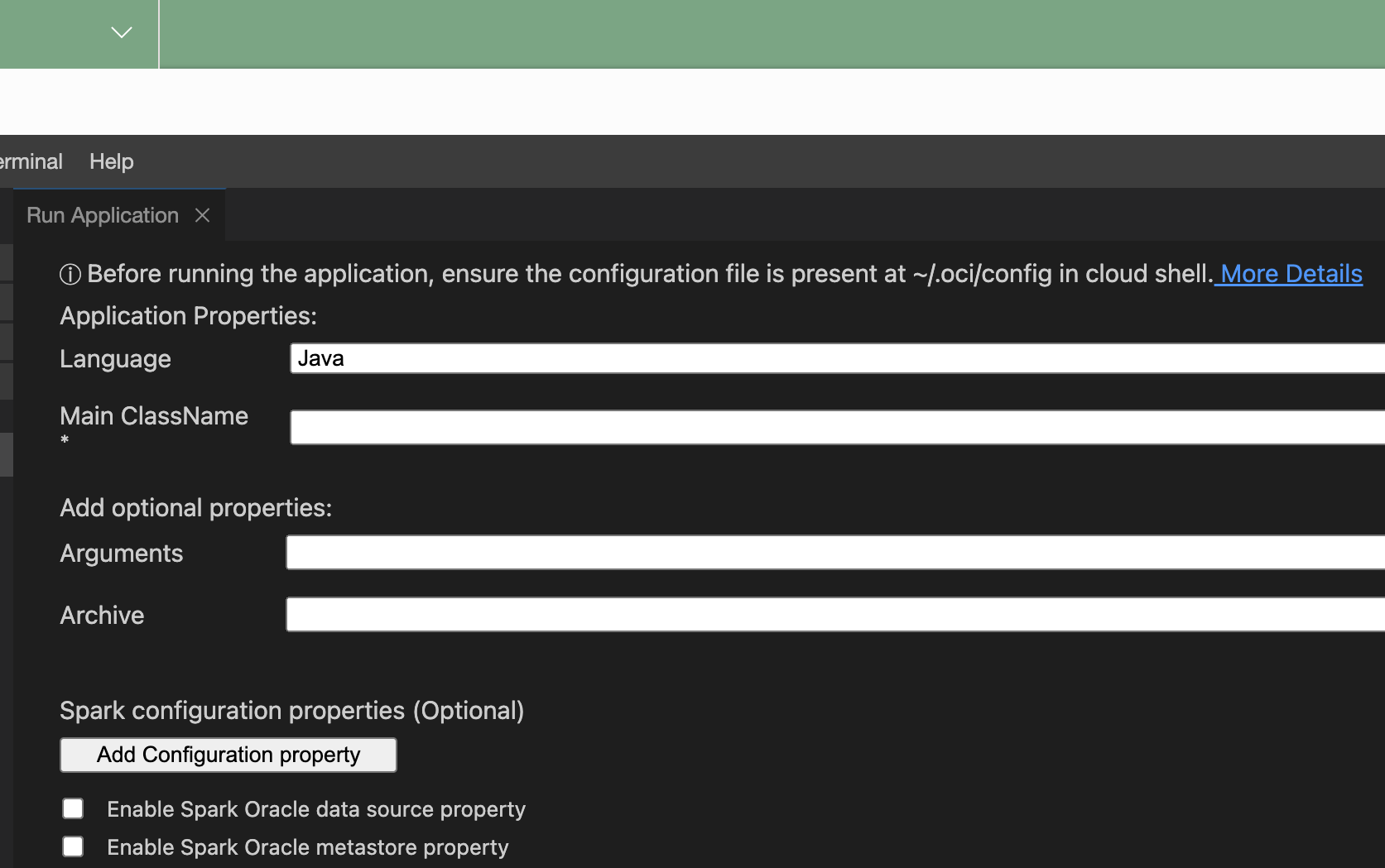

Fournissez les propriétés d'application suivantes :

-

Language : langage Java, Python ou Scala.

-

ClassName principal : nom de la classe principale exécutée dans le projet. Pour Python, il s'agit de Nom de fichier principal.

-

Arguments : arguments de ligne de commande attendus par l'application Spark.

-

conf : toute configuration supplémentaire pour l'exécution de l'application.

-

jars : fichier JAR tiers requis par l'application.

- Cochez Activer la propriété de source de données Oracle Spark pour utiliser la source de données Oracle Spark.

- Cochez Activer la propriété de metastore Oracle Spark pour utiliser un metastore.

- Sélectionnez un compartiment.

- Sélectionnez un métasore.

-

Sélectionnez Exécuter.

Le module d'extension Data Flow package l'application et l'exécute.

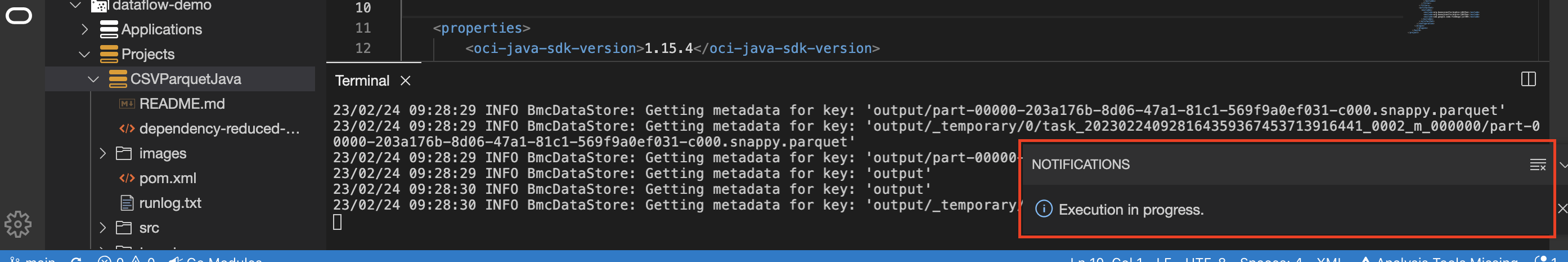

- (Facultatif) Vérifiez le statut de l'application à partir de la barre de notification. La sélection de l'onglet Notifications fournit des informations de statut plus détaillées.

- (Facultatif) Sélectionnez runlog.txt pour consulter les fichiers journaux.

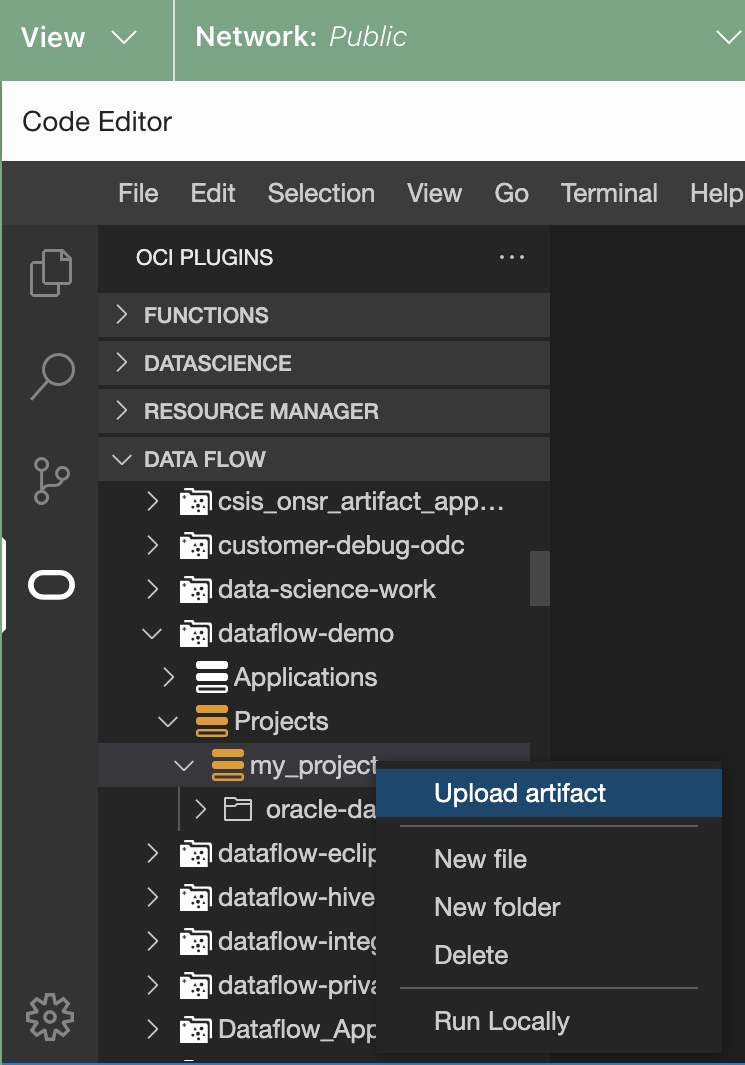

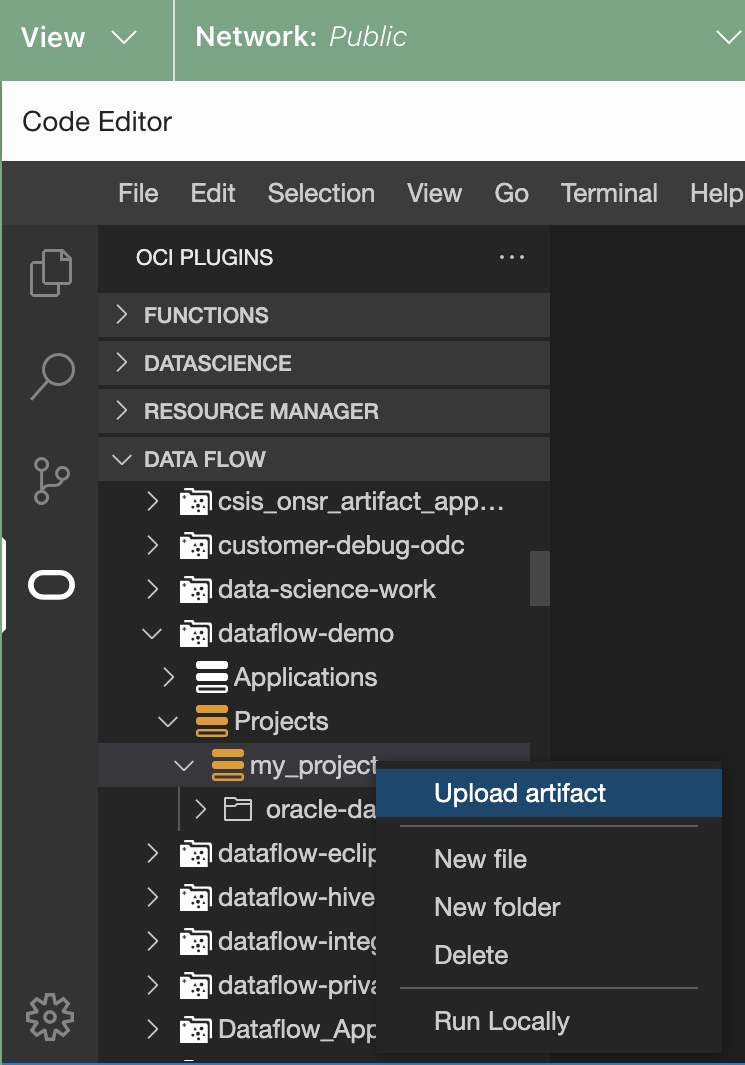

- (Facultatif) Téléchargez l'artefact vers Data Flow.

- Cliquez avec le bouton droit de la souris sur le projet en question.

- Sélectionnez Télécharger l'artefact vers le serveur.

- Sélectionnez la langue.

- Entrez l'espace de noms Object Storage.

- Saisissez le nom du bucket.

La fenêtre Run Application (Exécuter l'application) s'ouvre.

La fenêtre Run Application (Exécuter l'application) s'ouvre.