Présentation de Data Flow

Découvrez Data Flow et comment l'utiliser pour créer, partager, exécuter et visualiser facilement la sortie des applications Apache Spark .

Présentation d'Oracle Cloud Infrastructure Data Flow

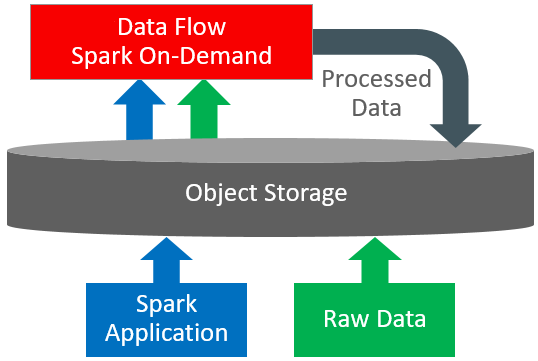

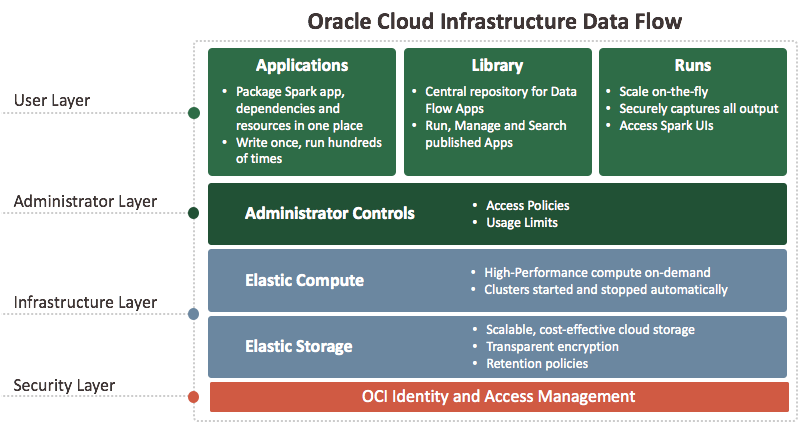

Le flux de données est une plate-forme sans serveur basée sur le cloud et dotée d'une interface utilisateur riche. Il permet aux développeurs et aux analystes de données Spark de créer, de modifier et d'exécuter des travaux Spark à toute échelle, sans avoir besoin de clusters, d'une équipe des opérations ou de connaissances Spark hautement spécialisées. Puisqu'il fonctionne sans serveur, vous n'avez aucune infrastructure à déployer ou à gérer. Il est entièrement piloté par les API REST, ce qui facilite l'intégration aux applications et aux workflows. Vous pouvez contrôler Data Flow à l'aide de cette API REST. Vous pouvez exécuter Data Flow à partir de l'interface de ligne de commande, car les commandes Data Flow sont disponibles dans le cadre de l'interface de ligne de commande Oracle Cloud Infrastructure. Vous pouvez :

-

vous connecter aux sources de données Apache Spark,

-

créer des applications Apache Spark réutilisables,

-

lancer les travaux Apache Spark en quelques secondes,

-

créer des applications Apache Spark à l'aide de SQL, Python, Java, Scala ou spark-submit,

-

gérer toutes les applications Apache Spark à partir d'une seule plate-forme,

-

traiter les données dans le cloud ou sur site dans votre centre de données,

-

créer des blocs de création Big Data que vous pouvez facilement assembler en applications Big Data avancées.