A propos des performances d'actualisation des données

Oracle s'efforce constamment d'améliorer les performances de chargement des données dans les pipelines.

Les performances de chargement des données pour votre instance varient. Le temps nécessaire au traitement des données, qu'il s'agisse de chargements complets d'entrepôt ou de chargements de données incrémentiels, dépend de divers facteurs. Un chargement de pipeline de données inclut les éléments suivants :

- Extraction de données à partir des applications Oracle Fusion Cloud.

- Chargement des données dans Oracle Autonomous Data Warehouse.

- Transformer les données en schéma prédéfini.

- Disponibilité du système source.

- Taille et complexité des données source.

- Les domaines fonctionnels activés.

- Requêtes SQL personnalisées ayant un impact sur Oracle Autonomous Data Warehouse.

- Vos requêtes s'exécutent simultanément.

- Personnalisations effectuées sur les objets du système source (qui nécessitent un chargement complet pour ces objets).

- Application de patches aux systèmes source et cible.

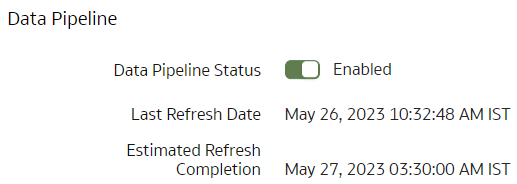

- Activez l'estimation de l'exécution du pipeline à l'aide de la fonction d'aperçu de l'estimation d'actualisation des données sur la page Activer les fonctionnalités. Les détails de fin de l'actualisation estimée sont visibles sur la page Paramètres du pipeline.

- Déclenchez toutes les opérations suivantes en fonction de l'heure de fin estimée de l'actualisation.

- Contactez le support technique Oracle si l'actualisation n'est pas terminée avant l'heure de fin estimée.

- Abonnez-vous aux notifications d'événement pour recevoir une notification par courriel dès qu'un problème survient lors de l'exécution du pipeline. Reportez-vous à Activation des notifications d'événement (aperçu).

L'actualisation des données est généralement effectuée quotidiennement, sauf si les travaux de pipeline de données sont désactivés ou bloqués. Vous pouvez observer les temps de chargement des données pour votre configuration source et d'entrepôt spécifique afin d'estimer le temps nécessaire pour une actualisation quotidienne incrémentielle et pour un chargement complet de l'entrepôt. Ces informations peuvent vous aider à planifier le moment optimal de la journée pour commencer l'actualisation quotidienne de vos données. Vous pouvez planifier l'exécution du chargement des données pendant les heures creuses. Par exemple, exécutez les chargements de data warehouse complets initiaux pendant les week-ends et les chargements incrémentiels pendant les soirs de la semaine afin de vous assurer que les utilisateurs ne sont pas affectés.

Vous pouvez afficher l'heure de fin estimée de l'actualisation pour les pipelines quotidiens dans la page Paramètres de pipeline du champ Fin estimée de l'actualisation en tant que fonction d'aperçu. Vous pouvez ainsi planifier vos tâches dans l'application.

- Actualisation prioritaire de tables spécifiques que vous avez configurées pour des cas d'utilisation opérationnels.

- Ensuite, le processus actualise les modules prédéfinis et les configurations de données personnalisées, le cas échéant. Les objets actualisés à cette étape font partie du pipeline de base et proviennent directement d'Oracle Fusion Cloud Applications et sont nécessaires pour le contenu de base (par exemple, les transactions et les dimensions).

- Enfin, le processus actualise les augmentations de données de type Jeu de données, les augmentations de données configurées en tant que jeux de données avec numéro de version, les augmentations de données sans date de dernière modification ou date de dernière mise à jour, et les modules de prédiction tels que Prévision des paiements ponctuels des fournisseurs. Les objets actualisés à cette étape nécessitent un traitement supplémentaire ; par exemple, les jeux de données utilisés dans les cas d'utilisation de l'apprentissage automatique prédéfinis.

Le système prédit et affiche l'heure de fin du chargement incrémentiel. Si vous n'avez pas activé le contenu qui a été traité en dernier dans le processus d'actualisation en plusieurs étapes, vous ne verrez pas ces informations sur la page Paramètres de pipeline dans la section Pipeline de données.