Régression linéaire

Selon le contexte de temps global, les valeurs moyennes et maximales portent sur des données brutes quotidiennes ou horaires. L'agrégation horaire est utilisée lorsque la période considérée est comprise dans les sept derniers jours. Dans le cas contraire, l'agrégation quotidienne est utilisée.

Les périodes de prévision sont définies sur la moitié de la durée de la période de tendance. Par exemple, les tendances sur 30 jours sont des tendances sur 15 jours en avant et celles sur 90 jours en avant sur 45 jours.

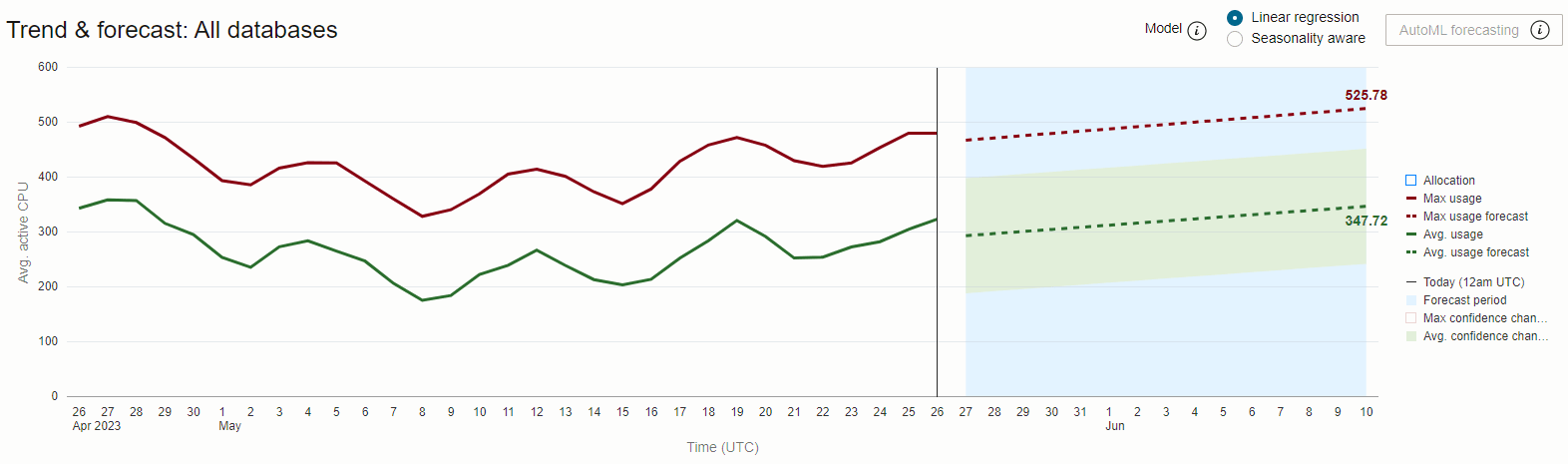

Le graphique ci-dessus montre l'utilisation moyenne et maximale quotidienne de l'UC sur 30 jours pour la base de données HR-Dev. Nous constatons un écart important et constant entre les séries de données Utilisation moyenne et Utilisation maximale, ce qui indique un niveau élevé de variabilité de la demande d'UC au cours de la journée.

La tendance et la prévision d'utilisation maximale atteignent l'allocation maximale de la base de données ou en sont très proches, ce qui indique un risque d'épuisement de la capacité en cas d'augmentation de la demande ou d'introduction d'une nouvelle charge globale.

La différence entre les prévisions d'utilisation maximale (moyenne de 29 UC actives environ) et moyenne (moyenne de 15 UC actives environ) correspond à la différence entre le nombre d'UC requises pour effectuer le travail en toute sécurité et le nombre d'UC réellement nécessaires pour effectuer le travail. En cas d'allocation ferme de ressources d'UC à des bases de données, cette différence représente la quantité de ressources payées moins la quantité de ressources utilisées et constitue donc un coût d'opportunité lié à une demande d'UC très variable.

Pour atténuer ce coût inhérent à la variabilité, vous pouvez partager les ressources d'UC entre les bases de données et autoriser leur allocation dynamique, au fur et à mesure de l'évolution de la demande.

Oracle Autonomous AI Database avec un redimensionnement automatique activé offre précisément une telle solution.