A propos des pipelines de données sur une base de données d'IA autonome

Les pipelines de chargement assurent un chargement incrémentiel continu des données à partir de sources externes (à mesure que les données arrivent dans la banque d'objets, elles sont chargées dans une table de base de données). Les pipelines d'export fournissent un export incrémentiel continu de données vers la banque d'objets (à mesure que de nouvelles données apparaissent dans une table de base de données, elles sont exportées vers la banque d'objets). Les pipelines utilisent le planificateur de base de données pour charger ou exporter en permanence des données incrémentielles.

Les pipelines de données Autonomous AI Database fournissent les éléments suivants :

-

Opérations unifiées : les pipelines vous permettent de charger ou d'exporter des données rapidement et facilement, et de répéter ces opérations à intervalles réguliers pour de nouvelles données. Le package

DBMS_CLOUD_PIPELINEfournit un ensemble unifié de procédures PL/SQL pour la configuration de pipeline, ainsi que pour la création et le démarrage d'un travail programmé pour les opérations de chargement ou d'export. -

Traitement programmé des données : les pipelines surveillent leur source de données, et chargent ou exportent régulièrement les données à mesure que de nouvelles données arrivent.

-

Hautes performances : les pipelines font évoluer les opérations de transfert de données avec les ressources disponibles sur votre base de données d'IA autonome. Par défaut, les pipelines utilisent le parallélisme pour toutes les opérations de chargement ou d'export, et évoluent en fonction des ressources d'UC disponibles sur votre base de données d'IA autonome ou en fonction d'un attribut de priorité configurable.

-

Atomicité et récupération : les pipelines garantissent l'atomicité de sorte que les fichiers de la banque d'objets soient chargés une seule fois pour un pipeline de chargement.

-

Surveillance et dépannage : les pipelines fournissent des tables de journaux et de statut détaillées qui vous permettent de surveiller et de déboguer les opérations de pipeline.

- Compatible multicloud : les pipelines sur Autonomous AI Database prennent en charge le basculement facile entre les fournisseurs cloud sans modification d'application. Les pipelines prennent en charge tous les formats d'URI d'informations d'identification et de banque d'objets pris en charge par Autonomous AI Database (Oracle Cloud Infrastructure Object Storage, Amazon S3, Azure Blob Storage, Google Cloud Storage et les banques d'objets Amazon S3-Compatible).

Rubriques connexes

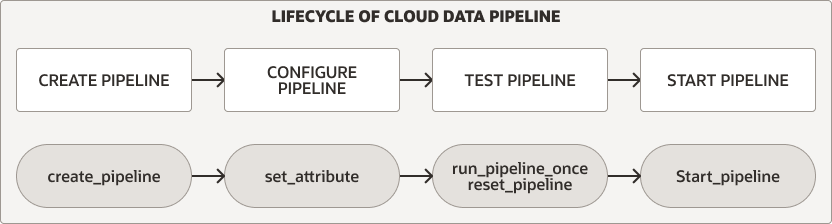

Cycle de vie du pipeline de données

Le package DBMS_CLOUD_PIPELINE fournit des procédures pour créer, configurer, tester et démarrer un pipeline. Le cycle de vie et les procédures du pipeline sont les mêmes pour les pipelines de chargement et d'exportation.

Description de l'image pipeline_lifecycle.eps

Pour chaque type de pipeline, procédez comme suit pour créer et utiliser un pipeline :

-

Créez et configurez le pipeline. Pour plus d'informations, reportez-vous à Création et configuration de pipelines.

-

Testez un nouveau pipeline. Pour plus d'informations, reportez-vous à Pipelines de test.

-

Démarrer un pipeline. Pour plus d'informations, reportez-vous à Démarrage d'un pipeline.

En outre, vous pouvez surveiller, arrêter ou supprimer des pipelines :

-

Pendant l'exécution d'un pipeline, lors du test ou lors d'une utilisation régulière après son démarrage, vous pouvez le surveiller. Pour plus d'informations, reportez-vous à Surveillance et dépannage des pipelines.

-

Vous pouvez arrêter un pipeline et le redémarrer ultérieurement, ou supprimer un pipeline lorsque vous avez fini d'utiliser le pipeline. Pour plus d'informations, reportez-vous à Arrêt d'un pipeline et à Suppression d'un pipeline.

Pipelines de chargement

Un pipeline de chargement fonctionne comme suit (certaines de ces fonctionnalités sont configurables à l'aide d'attributs de pipeline) :

-

Les fichiers de banque d'objets sont chargés en parallèle dans une table de base de données.

- Un pipeline de chargement utilise le nom du fichier de banque d'objets pour identifier et charger de manière unique les fichiers les plus récents.

- Une fois qu'un fichier de la banque d'objets a été chargé dans la table de base de données, si le contenu du fichier change dans la banque d'objets, il ne sera plus chargé.

- Si le fichier de banque d'objets est supprimé, cela n'a aucune incidence sur les données de la table de base de données.

-

En cas d'échec, un pipeline de chargement relance automatiquement l'opération. Des tentatives sont effectuées à chaque exécution ultérieure du travail programmé du pipeline.

-

Dans les cas où les données d'un fichier ne sont pas conformes à la table de base de données, elles sont marquées comme

FAILEDet peuvent être révisées pour déboguer et résoudre le problème.- Si le chargement d'un fichier échoue, le pipeline ne s'arrête pas et continue à charger les autres fichiers.

-

Les pipelines de chargement prennent en charge plusieurs formats de fichier d'entrée, notamment JSON, CSV, XML, Avro, ORC et Parquet.

Exporter les pipelines

Utilisez un pipeline d'export pour l'export incrémentiel continu des données de la base de données vers la banque d'objets. Un pipeline d'export identifie périodiquement les données candidates et les télécharge vers la banque d'objets.

Il existe trois options de pipeline d'export (les options d'export peuvent être configurées à l'aide d'attributs de pipeline) :

-

Exportez les résultats incrémentiels d'une requête vers la banque d'objets en utilisant une colonne de date ou d'horodatage comme clé pour le suivi des données plus récentes.

-

Exportez les données incrémentielles d'une table vers la banque d'objets en utilisant une colonne de date ou d'horodatage comme clé pour le suivi des données plus récentes.

-

Exportez les données d'une table vers une banque d'objets à l'aide d'une requête pour sélectionner des données sans référence à une colonne de date ou d'horodatage (de sorte que le pipeline exporte toutes les données sélectionnées par la requête pour chaque exécution du planificateur).

Les pipelines d'export présentent les fonctionnalités suivantes (certaines d'entre elles peuvent être configurées à l'aide d'attributs de pipeline) :

-

Les résultats sont exportés en parallèle vers la banque d'objets.

-

En cas d'échec, un travail de pipeline suivant répète l'opération d'export.

-

Les pipelines d'export prennent en charge plusieurs formats de fichier d'export, notamment : CSV, JSON, Parquet ou XML.

Pipelines mis à jour par Oracle

La base de données IA autonome sur une infrastructure Exadata dédiée fournit des pipelines intégrés pour exporter des journaux spécifiques vers une banque d'objets au format JSON. Ces pipelines sont préconfigurés et sont démarrés et détenus par l'utilisateur ADMIN.

Les pipelines maintenus par Oracle sont les suivants :

-

ORA$AUDIT_EXPORT: ce pipeline exporte les journaux d'audit de base de données vers la banque d'objets au format JSON et s'exécute toutes les 15 minutes après le démarrage du pipeline (en fonction de la valeur d'attributinterval). -

ORA$APEX_ACTIVITY_EXPORT: ce pipeline exporte le journal d'activité de l'espace de travail Oracle APEX vers la banque d'objets au format JSON. Ce pipeline est préconfiguré avec la requête SQL permettant d'extraire les enregistrements d'activité APEX et s'exécute toutes les 15 minutes après le démarrage du pipeline (en fonction de la valeur d'attributinterval).

Pour configurer et démarrer un pipeline géré par Oracle, procédez comme suit :