Configuration de la réplication bidirectionelle

Une fois la réplication unidirectionnelle définie, quelques étapes supplémentaires suffisaient pour répliquer des données dans la direction opposée. Cet exemple de démarrage rapide utilise Autonomous AI Transaction Processing et Autonomous AI Lakehouse comme ses deux bases de données cloud.

Rubriques connexes

Avant de commencer

Vous devez disposer de deux bases de données existantes dans les mêmes location et région pour pouvoir effectuer ce démarrage rapide. Si vous avez besoin de données échantillon, téléchargez Archive.zip, puis suivez les instructions fournies dans l'atelier pratique 11, Tâche 3 : charger le schéma ATP.

Présentation

Les étapes suivantes vous guident tout au long de l'instanciation d'une base de données cible à l'aide d'Oracle Data Pump et de la configuration de la réplication bidirectionnelle entre deux bases de données d'une même région.

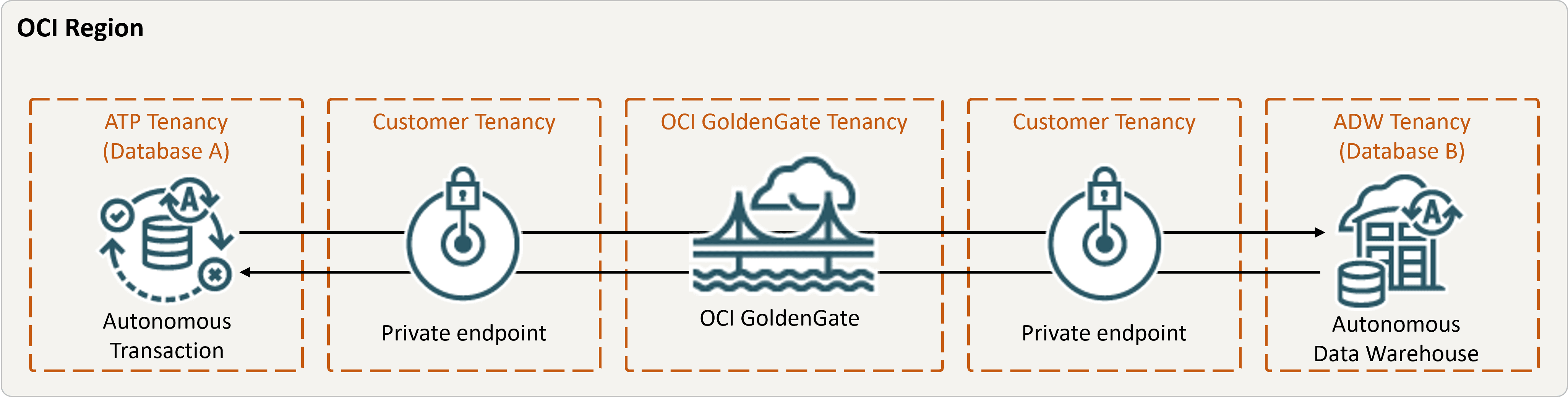

description de l'illustration bidirectional.png,

Tâche 2 : ajouter des informations relatives aux transactions et une table de point de reprise pour les deux bases de données

Dans la console de déploiement OCI GoldenGate, accédez à l'écran Configuration du service d'administration, puis effectuez les opérations suivantes :

Tâche 3 : créer l'extraction intégrée

L'extraction intégrée capture les modifications continues apportées à la base de données source.

Tâche 4 : exporter des données à l'aide d'Oracle Data Pump (ExpDP)

Utilisez Oracle Data Pump (ExpDP) pour exporter des données de la base de données source vers la banque d'objets Oracle.

Tâche 5 : instancier la base de données cible à l'aide d'Oracle Data Pump (ImpDP)

Utilisez Oracle Data Pump (ImpDP) pour importer des données dans la base de données cible à partir du fichier SRC_OCIGGLL.dmp exporté depuis la base de données source.

Tâche 6 : ajouter et exécuter une réplication non intégrée

- Ajoutez et exécutez une réplication.

- Apportez des modifications à la base de données A pour les voir répliquées vers la base de données B.

Tâche 7 : configurer la réplication de la base de données B vers la base de données A

Les tâches 1 à 6 ont établi la réplication de la base de données A vers la base de données B. Les étapes suivantes configurent la réplication de la base de données B vers la base de données A.