Remarques :

- Ce tutoriel est disponible dans un environnement d'atelier gratuit fourni par Oracle.

- Il utilise des exemples de valeur pour les informations d'identification, la location et les compartiments Oracle Cloud Infrastructure. Lorsque vous terminez votre atelier, remplacez ces valeurs par celles propres à votre environnement cloud.

Utiliser un assistant d'IA avec Oracle Cloud Native Environment

Introduction

L'assistant AI Oracle Cloud Native Environment (Oracle CNE) est un module d'extension fourni avec l'interface utilisateur Oracle CNE. AI Assistant aide les utilisateurs à gérer et à obtenir des informations sur le statut de leur cluster Kubernetes en langage naturel (actuellement uniquement en anglais). Il est contextuel, ce qui signifie que ses réponses sont pertinentes pour le statut du cluster et l'emplacement dans l'interface utilisateur Oracle CNE lors du démarrage d'une interaction avec l'assistant IA. Par exemple, si un utilisateur n'est pas certain du nombre de noeuds du cluster, demandez à l'assistant AI "Combien de noeuds se trouve dans mon cluster ?" et il confirmera le nombre de noeuds du cluster. D'autres invites peuvent être publiées, ce qui permet à l'utilisateur de démarrer un flux conversationnel avec l'assistant IA. Les principales fonctionnalités fournies par l'assistant IA sont les suivantes :

-

Expérience Kubernetes conversationnelle : permet aux utilisateurs expérimentés et novices d'interagir avec le cluster de manière conversationnelle en utilisant le langage naturel pour publier des questions sur le cluster sans avoir besoin d'une connaissance approfondie de Kubernetes.

-

Prise en charge du contexte : l'assistant IA sait ce que l'utilisateur affiche lorsqu'une demande est publiée et fournit des réponses appropriées à ce contexte de départ.

- Prise en charge de plusieurs fournisseurs : AI Assistant prend en charge plusieurs fournisseurs d'IA (pour plus de détails, reportez-vous à en amont).

Remarque : vous devez fournir votre propre clé d'API pour accéder au fournisseur de votre choix.

-

Outils configurables : peuvent être configurés pour utiliser les API Kubernetes afin d'interroger les informations de cluster.

-

Génération de ressources : les utilisateurs peuvent demander à l'assistant IA de générer Kubernetes YAML.

- Analyse approfondie : aide les utilisateurs à gérer le cluster. Par exemple, en diagnostiquant les problèmes, en collectant et en interprétant les journaux, etc.

Ce tutoriel explique comment configurer le module d'extension AI Assistant, inclus dans l'interface utilisateur Oracle CNE avec une instance AI hébergée localement (Ollama).

Objectifs

Dans ce tutoriel, vous allez apprendre à :

- Configuration et utilisation de l'assistant AI inclus dans l'interface utilisateur Oracle CNE.

Prérequis

- Installation d'Oracle Cloud Native Environment

Déploiement d'Oracle Cloud Native Environment

Remarque : si vous êtes en cours d'exécution dans votre propre location, lisez le projet linux-virt-labs GitHub README.md et complétez les prérequis avant de déployer l'environnement d'exercice.

-

Ouvrez un terminal sur le bureau Luna.

-

Clonez le projet

linux-virt-labsGitHub.git clone https://github.com/oracle-devrel/linux-virt-labs.git -

Accédez au répertoire de travail.

cd linux-virt-labs/ocne2 -

Installez les ensembles requis.

ansible-galaxy collection install -r requirements.yml -

Déployez l'environnement d'exercice.

ansible-playbook create_instance.yml -e localhost_python_interpreter="/usr/bin/python3.6" -e install_ocne_rpm=true -e create_ocne_cluster=true -e "ocne_cluster_node_options='-n 1 -w 1'"L'environnement d'exercice libre requiert la variable supplémentaire

local_python_interpreter, qui définitansible_python_interpreterpour les lectures exécutées sur localhost. Cette variable est nécessaire car l'environnement installe le package RPM pour le kit SDK Oracle Cloud Infrastructure pour Python, qui se trouve sous les modules python3.6.La forme de déploiement par défaut utilise l'UC AMD et Oracle Linux 8. Pour utiliser une CPU Intel ou Oracle Linux 9, ajoutez

-e instance_shape="VM.Standard3.Flex"ou-e os_version="9"à la commande de déploiement.Important : attendez que le guide de lecture s'exécute correctement et atteignez la tâche de pause. A ce stade du guide, l'installation d'Oracle Cloud Native Environment est terminée et les instances sont prêtes. Prenez note de la lecture précédente, qui affiche les adresses IP publiques et privées des noeuds qu'elle déploie et toutes les autres informations de déploiement nécessaires lors de l'exécution de l'exercice.

Vérifier le nombre de noeuds

Il permet de connaître le nombre et le nom des noeuds dans votre cluster Kubernetes.

-

Ouvrez un terminal et connectez-vous à l'instance OCNE via SSH.

ssh oracle@<ip_address_of_node> -

Liste des noeuds du cluster.

kubectl get nodesLa sortie affiche le plan de contrôle et les noeuds de processus actif dans un état

Ready, ainsi que leur version de Kubernetes en cours.

Créer un jeton d'accès

Oracle Cloud Native Environment déploie l'interface utilisateur dans le cluster Kubernetes à l'aide d'un déploiement et d'un service nommé UI, que vous utiliserez pour y accéder. Le déploiement et le service sont déployés dans l'espace de noms ocne-system. Pour vous connecter au service, vous devez générer un jeton d'accès.

-

Générez un jeton d'authentification.

kubectl --namespace ocne-system create token uiExemple de résultat :

> [oracle@ocne ~]$ kubectl --namespace ocne-system create token ui > eyJhbGciOiJSUzI1NiIsImtpZCI6IjhfRWczUG13VWRfWjFkWDIxdkp6UUZlRzEwU2QxaExkbm9TME1CcS1rVFEifQ.eyJhdWQiOlsiaHR0cHM6Ly9rdWJlcm5ldGVzLmRlZmF1bHQuc3ZjLmNsdXN0ZXIubG9jYWwiXSwiZXhwIjoxNzI4Mzg3MTgwLCJpYXQiOjE3MjgzODM1ODAsImlzcyI6Imh0dHBzOi8va3ViZXJuZXRlcy5kZWZhdWx0LnN2Yy5jbHVzdGVyLmxvY2FsIiwianRpIjoiYzlmMWViZTctYzA1ZC00MTYxLTg2MzctOWNiZGFlNTI5MzFiIiwia3ViZXJuZXRlcy5pbyI6eyJuYW1lc3BhY2UiOiJvY25lLXN5c3RlbSIsInNlcnZpY2VhY2NvdW50Ijp7Im5hbWUiOiJ1aSIsInVpZCI6IjdjY2RjZGZlLTAzNzMtNGUwZS1hMzViLTc5MzdhM2NiZmYzMyJ9fSwibmJmIjoxNzI4MzgzNTgwLCJzdWIiOiJzeXN0ZW06c2VydmljZWFjY291bnQ6b2NuZS1zeXN0ZW06dWkifQ.WSLZFste1ggkE2GtjJ2cBrORNFgCzHOlALNXD_-6vLA9kIiDJHp44HshUcXvUFH1XdFM1SGbiCvITOwT8Y5_93IKVZLu1NRyGPZlo5l4JqwnJtqLn7J6e39OlC2SXqex6vLBCU-sBqiw_P9xksNa7fO_MzsryEo-5oMgsVVo9oJr9wv4LYLv2Obd8U5ukKjBeiRiwTu9MTK0r_GlhmZ9d7GHrYrgF1MJGMgzvqyTyviyIynD2F0OkKARIThghpEL6aou4F_DFFMy8t0qjiJG3rBTXL6fXxZ-3WxZUGdx920ZSHcqG2XOaLY7txRkKYbudIjyt-gODeR-FZCIthw5kw >Vous utiliserez le jeton affiché pour vous authentifier lorsque vous vous serez connecté à l'interface utilisateur.

Création d'un port de transfert pour afficher l'interface utilisateur

Le transfert de port offre un moyen rapide et facile d'exposer le service d'interface utilisateur sur votre système local afin que vous puissiez l'utiliser pour surveiller, dépanner et, si nécessaire, déboguer votre environnement de développement.

Important : Oracle ne recommande pas d'utiliser le transfert de port pour exposer l'interface utilisateur d'un environnement de production.

-

Configurez le transfert de port.

kubectl port-forward --namespace ocne-system service/ui 8443:443Exemple de résultat :

> [oracle@ocne ~]$ kubectl port-forward --namespace ocne-system service/ui 8443:443 > Forwarding from 127.0.0.1:8443 -> 4466 > Forwarding from [::1]:8443 -> 4466 >Remarque : la commande

kubectl port-forwardcontinuera à s'exécuter au premier plan. Laissez-le continuer lorsque vous accédez à l'interface utilisateur.

Installer Ollama

-

Ouvrez un nouveau terminal et connectez-vous à l'instance OCNE via SSH.

ssh oracle@<ip_address_of_node> -

Installez une dépendance requise.

sudo dnf install -y zstd -

Installez Ollama.

curl -fsSL https://ollama.com/install.sh | sh -

Exécutez un modèle.

ollama run llama3.2 -

Ouvrez un terminal et créez un tunnel SSH.

ssh -L 11434:127.0.0.1:11434 -L 9898:127.0.0.1:8443 oracle@<ip_address_of_node>Le tunnel permet l'accès d'un navigateur sur votre système local à un port donné au système distant qui exécute le cluster Kubernetes. Vous n'avez pas besoin de générer un tunnel si les deux sont sur le même système. Lorsque vous êtes exécuté sur le même système, vous pouvez accéder à l'interface utilisateur à l'aide de

https://127.0.0.1:8443et d'Ollama à l'aide dehttp://127.0.0.1:11434. -

Ouvrez un navigateur sur le bureau Luna et entrez l'URL pour confirmer que Ollama est en cours d'exécution.

http://127.0.0.1:11434Le navigateur doit afficher un message texte semblable au suivant :

Ollama is running.

Connexion à l'interface utilisateur

-

Ouvrez un navigateur sur le bureau Luna et entrez l'URL.

https://127.0.0.1:9898Approuvez l'avertissement de sécurité en fonction du navigateur utilisé. Pour Chrome, cliquez sur le bouton

Advanced, puis sur le lienAccept the Risk and Continue. -

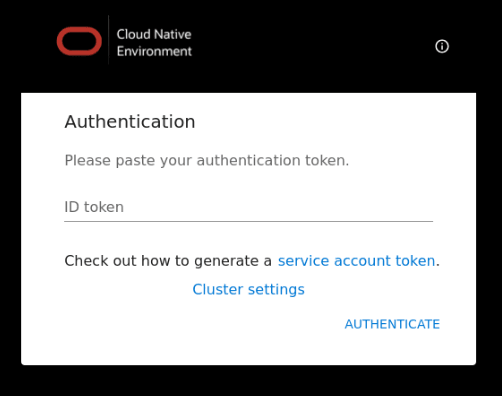

Entrez le jeton d'accès.

Entrez le jeton d'accès que vous avez créé précédemment, puis cliquez sur le lien

Authenticate.

-

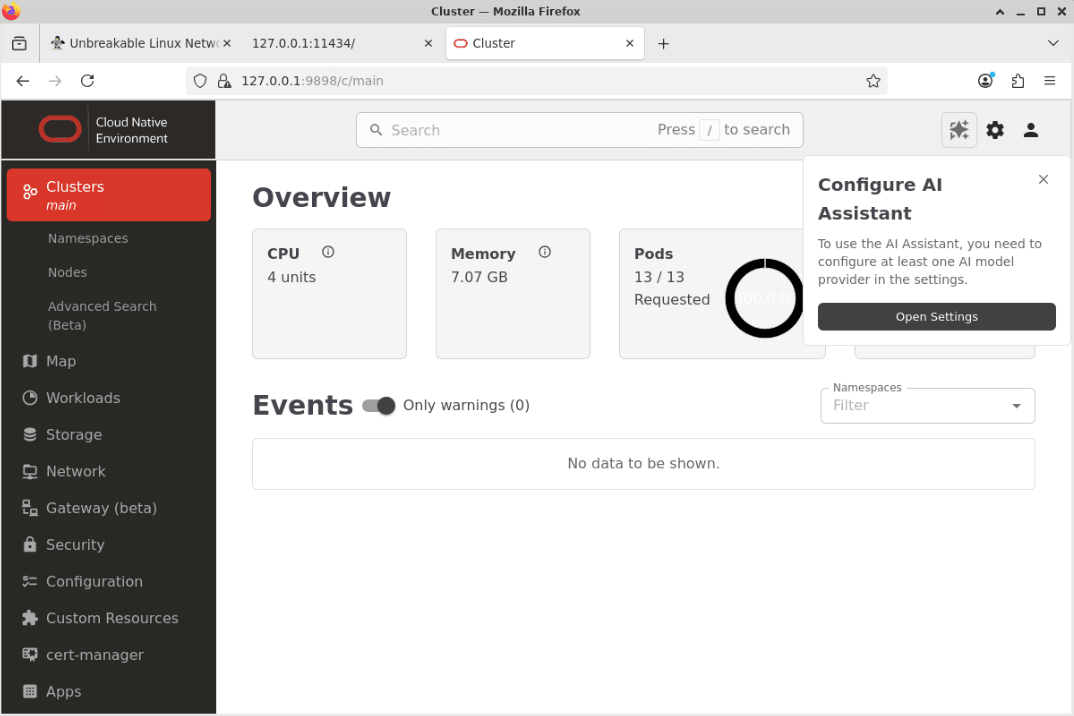

La page Présentation de l'interface utilisateur s'affiche.

Cliquez sur le bouton Ouvrir les paramètres dans la fenêtre contextuelle appelée Configurer l'assistant AI.

Remarque : certains avertissements peuvent être répertoriés dans la section Evénement de la page de destination. Ce comportement est normal et disparaîtra après quelques minutes.

-

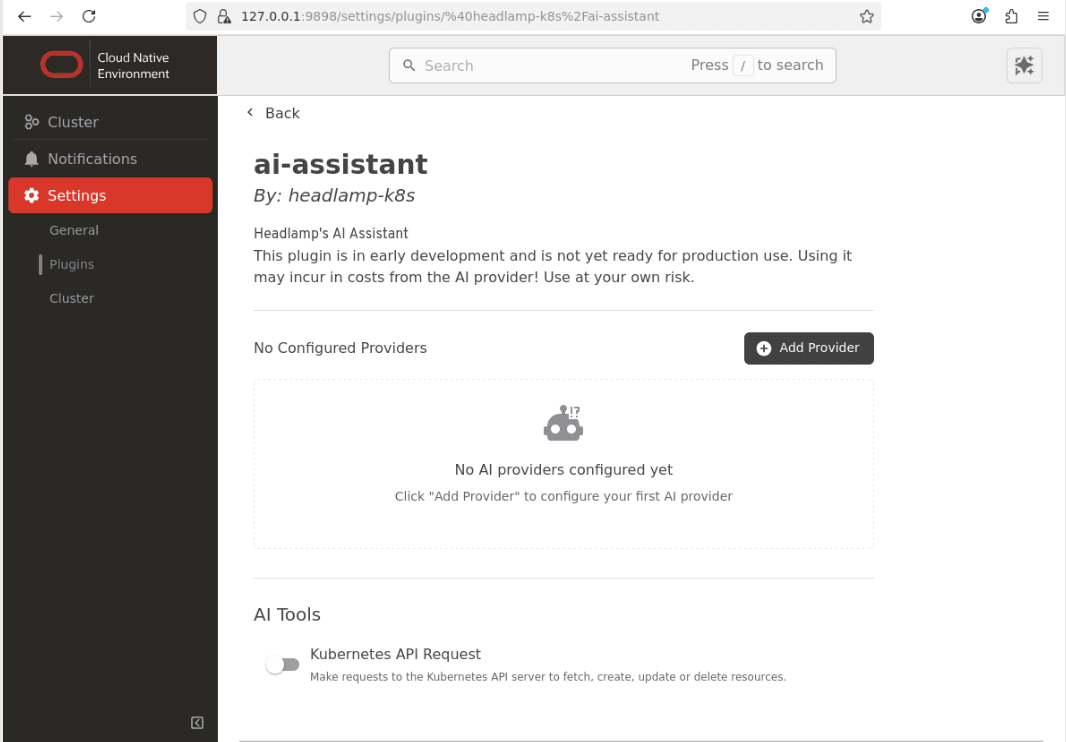

La page de configuration d'assistant électronique s'ouvre dans la section Paramètres.

Remarque : désélectionnez le bouton Demande d'API Kubernetes dans la section Outils d'IA.

Configuration d'un soignant local

-

Cliquez sur le bouton

Add Provider.

-

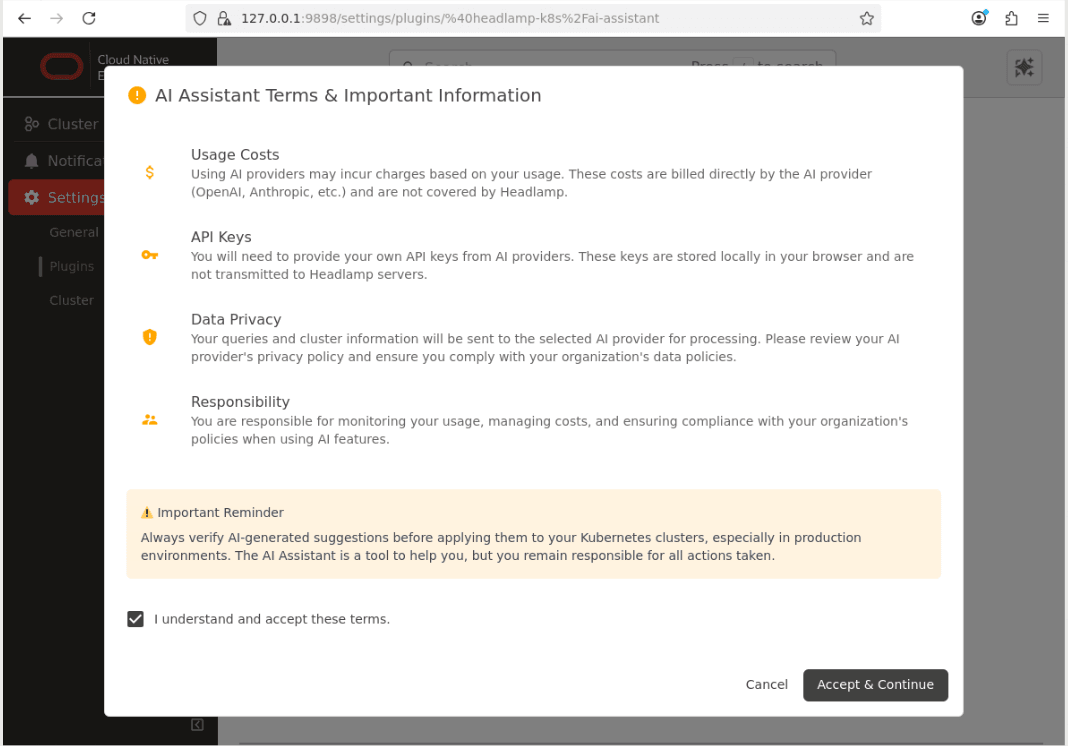

Accusez réception de la boîte de dialogue Conditions et informations importantes.

-

Cliquez sur l'option de menu

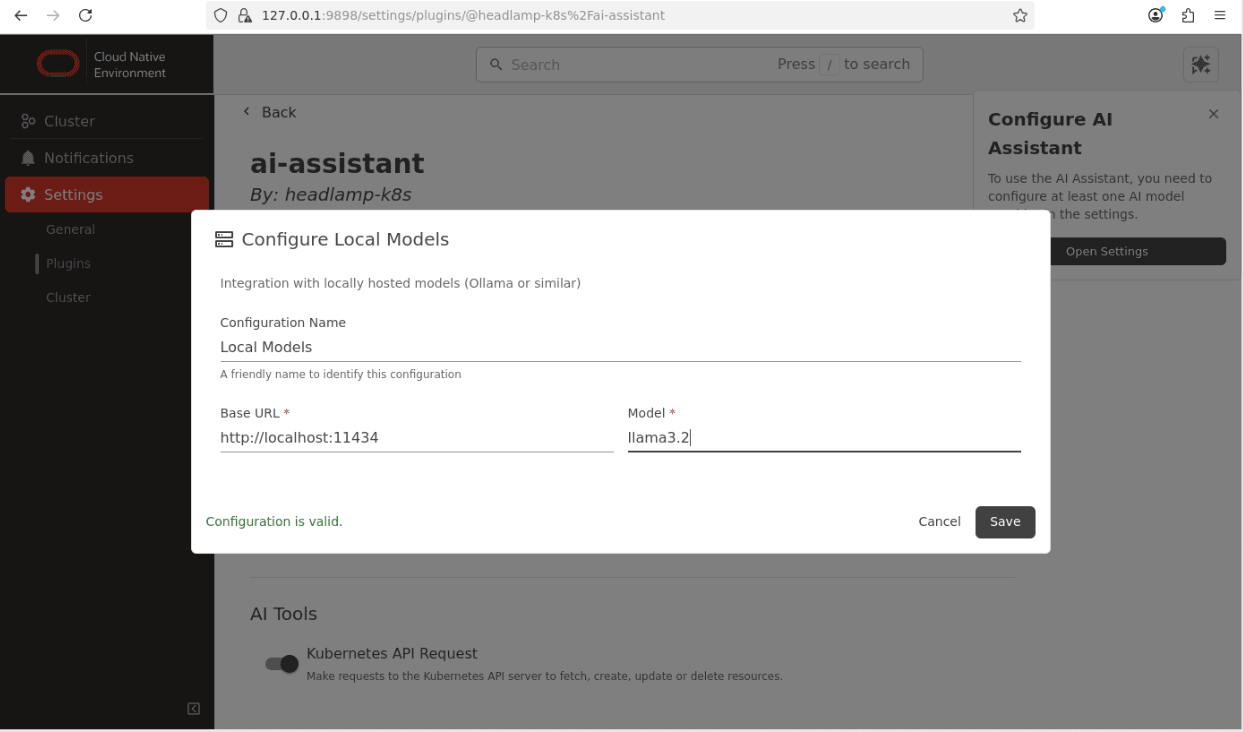

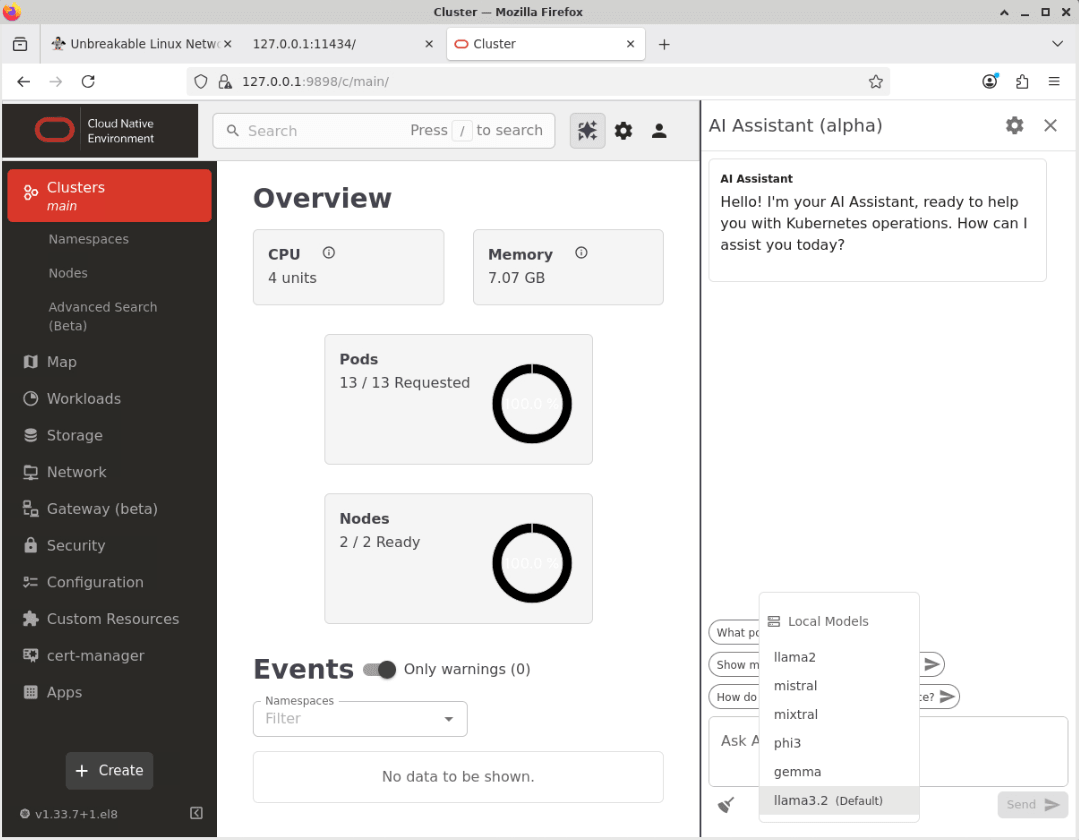

Clusterpuis sur le lienLocal Models.

Remarque : entrez les détails corrects pour le modèle Ollama local que vous utilisez. Cet exemple illustre le modèle

llama3.2configuré précédemment. -

Cliquez sur l'icône

Savepour enregistrer les paramètres de fournisseur.L'assistant AI est maintenant configuré et prêt à être utilisé.

Vérifiez que l'assistant AI fonctionne.

-

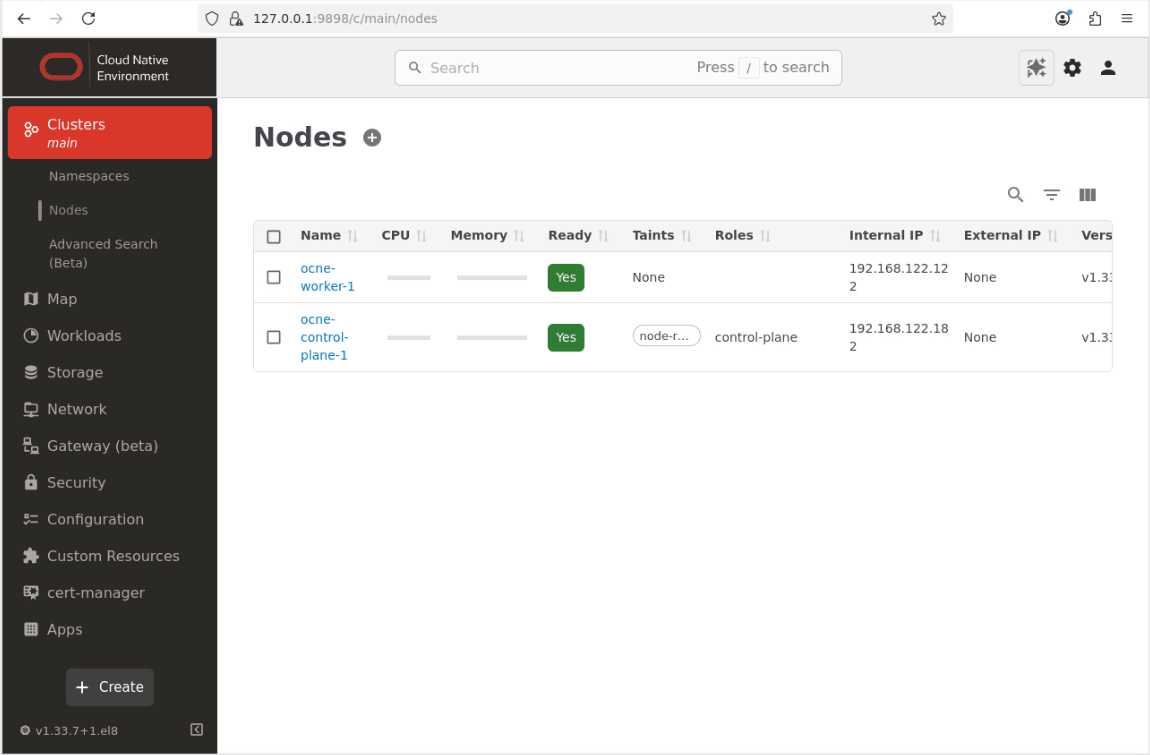

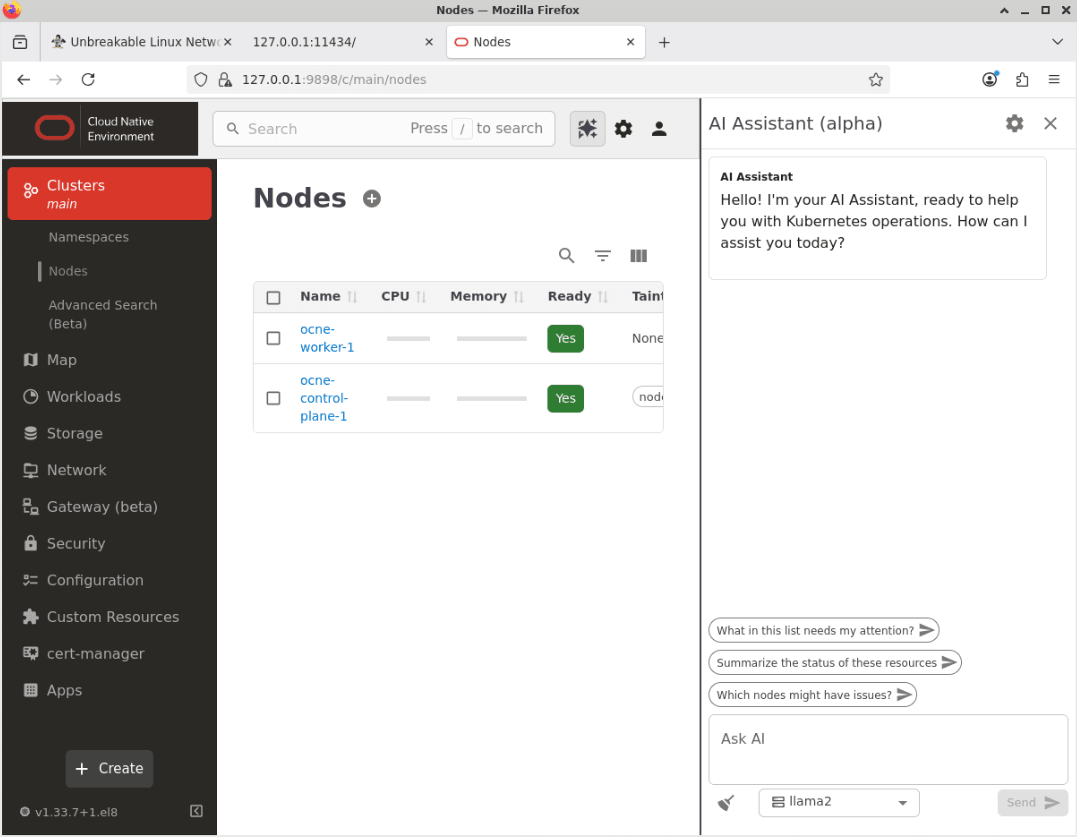

Cliquez sur l'option de menu appelée Cluster et sur les noeuds pour accéder à la page Noeuds.

-

Cliquez sur le bouton Assistant IA situé dans la partie supérieure droite de l'écran principal.

-

La fenêtre Assistant IA s'affiche.

-

Cliquez sur la zone de liste déroulante pour faire passer le modèle de l'option par défaut (llama2) au modèle local nouvellement configuré (llama3.2).

-

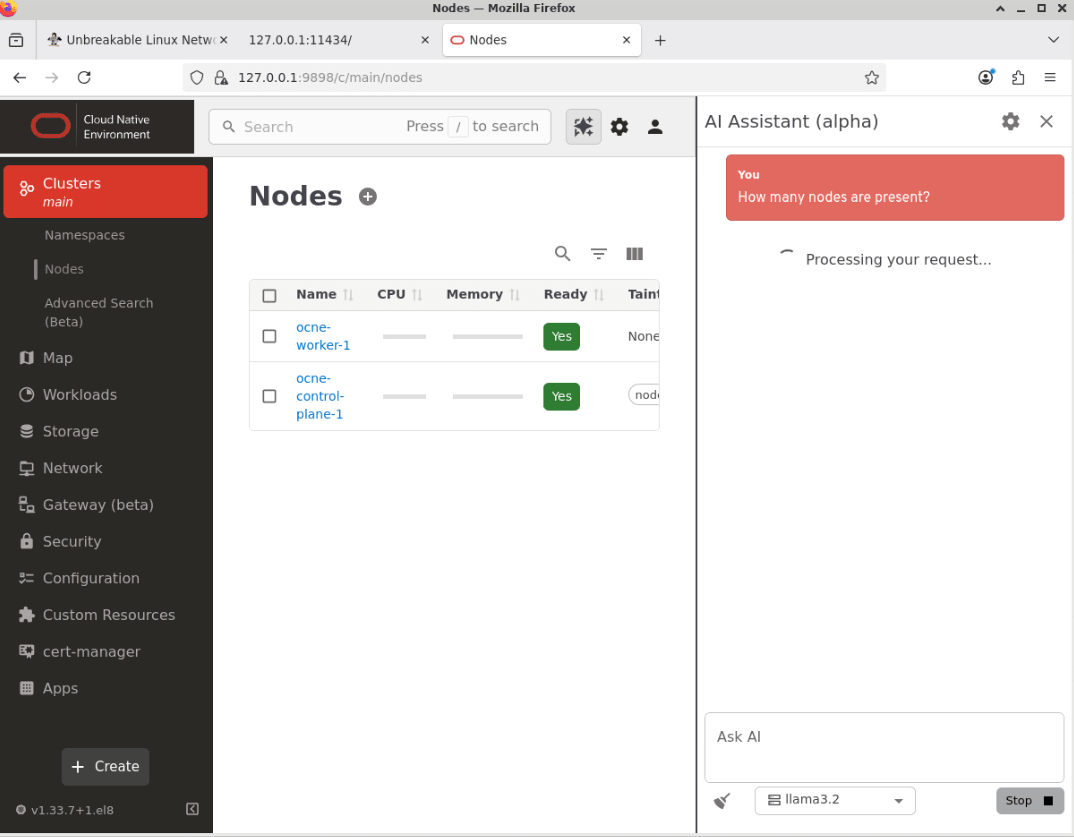

Posez une question à l'assistant IA dans la zone de texte intitulée Demander l'IA.

Collez cet exemple dans la zone de texte appelée Ask AI.

How many nodes are present? -

Cliquez sur le bouton Envoyer pour soumettre la question.

Remarque : le temps nécessaire à l'assistant IA pour répondre dépend de plusieurs facteurs, tels que les ressources disponibles pour le modèle LLM configuré et la complexité de la question posée.

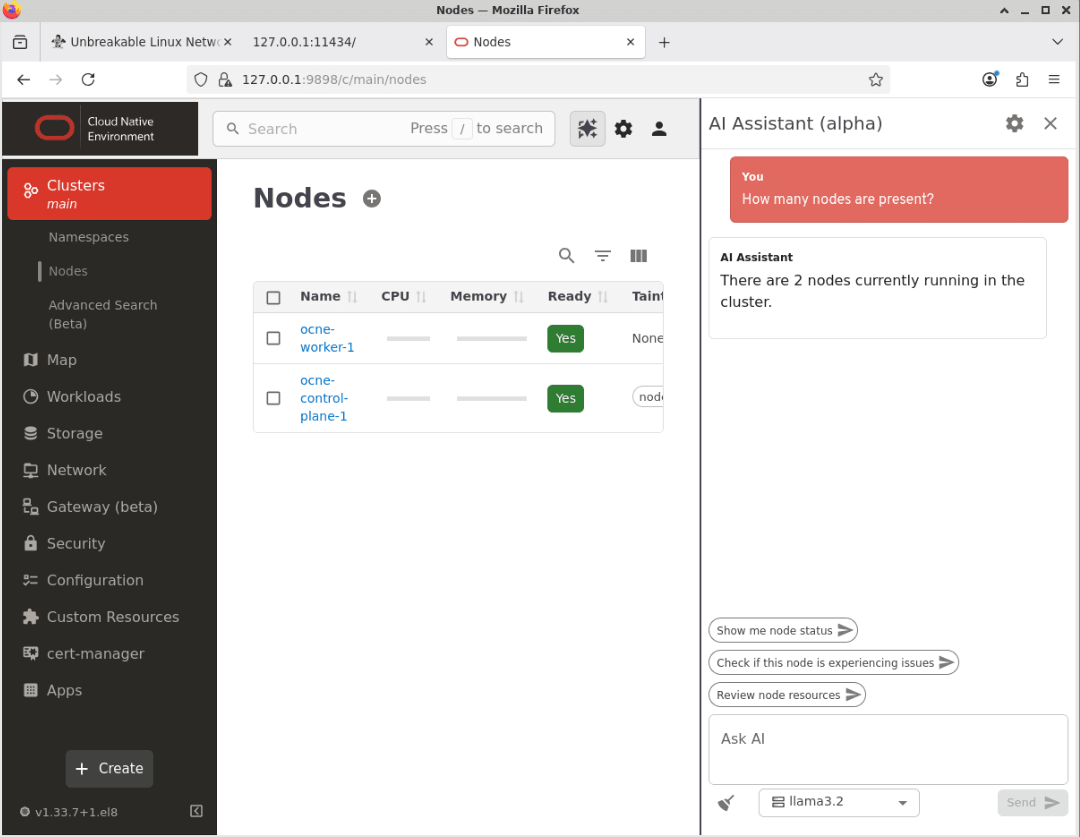

-

L'assistant IA renvoie une réponse.

Remarque : le libellé exact utilisé dans la réponse peut varier légèrement d'une demande à l'autre.

-

Cela confirme que l'assistant d'IA fonctionne.

Etapes suivantes

Grâce à ces étapes, vous savez désormais activer l'accès à l'interface utilisateur d'Oracle Cloud Native Environment et la configurer pour qu'elle utilise un LLM. Vous pouvez explorer ses nombreuses fonctionnalités, que nous aborderons dans les futurs tutoriels.

Liens connexes

- Documentation Oracle Cloud Native Environment

- Parcours Oracle Cloud Native Environment

- Centre de formation Oracle Linux

Ressources de formation supplémentaires

Explorez d'autres ateliers sur le site docs.oracle.com/learn ou accédez à d'autres contenus d'apprentissage gratuits sur le canal Oracle Learning YouTube. En outre, visitez le site education.oracle.com/learning-explorer pour devenir un explorateur Oracle Learning.

Pour obtenir de la documentation sur le produit, consultez Oracle Help Center.

Use AI Assistant with Oracle Cloud Native Environment

G50310-01