Configurer la pile de clusters HPC à partir d'Oracle Cloud Marketplace

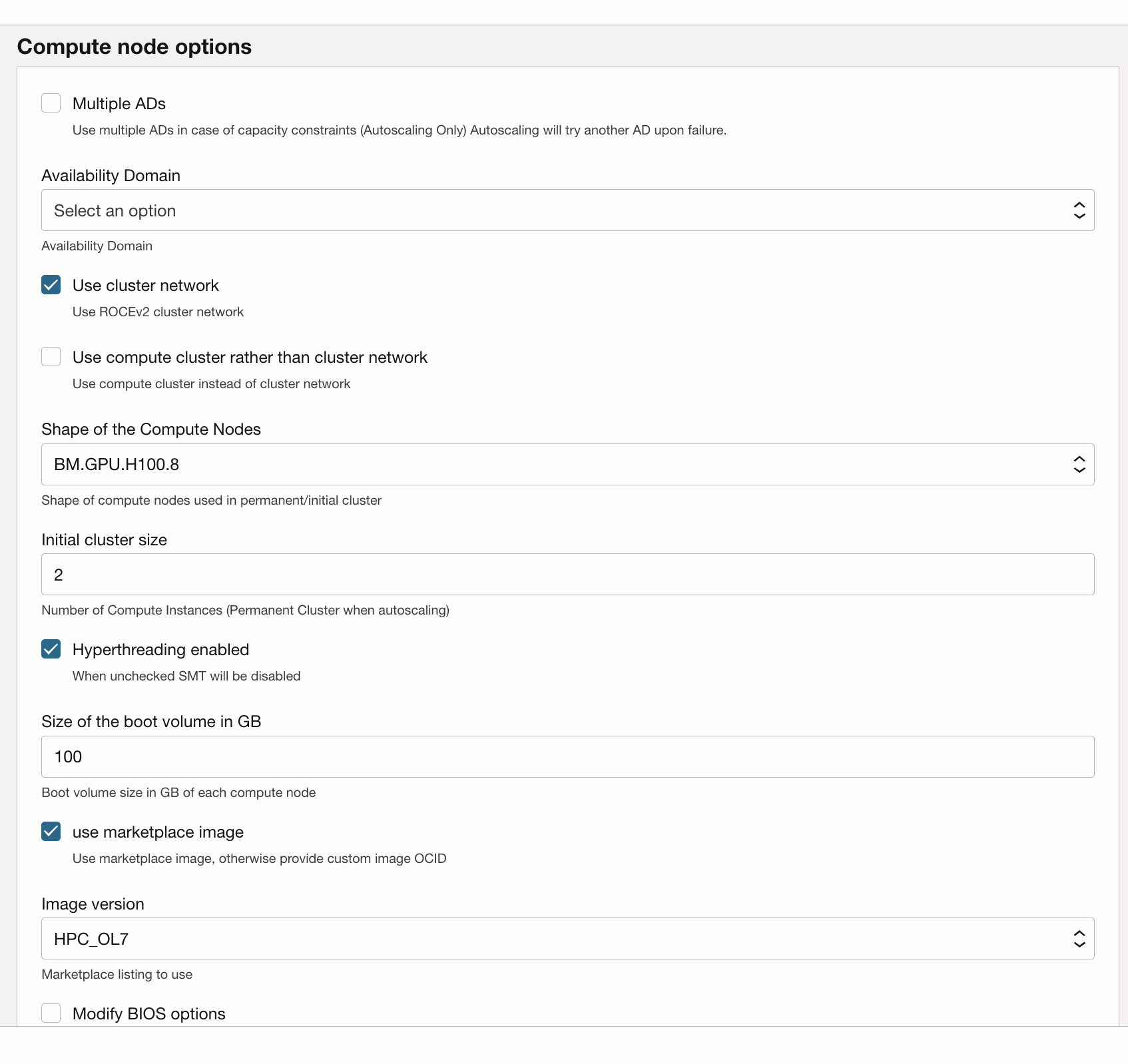

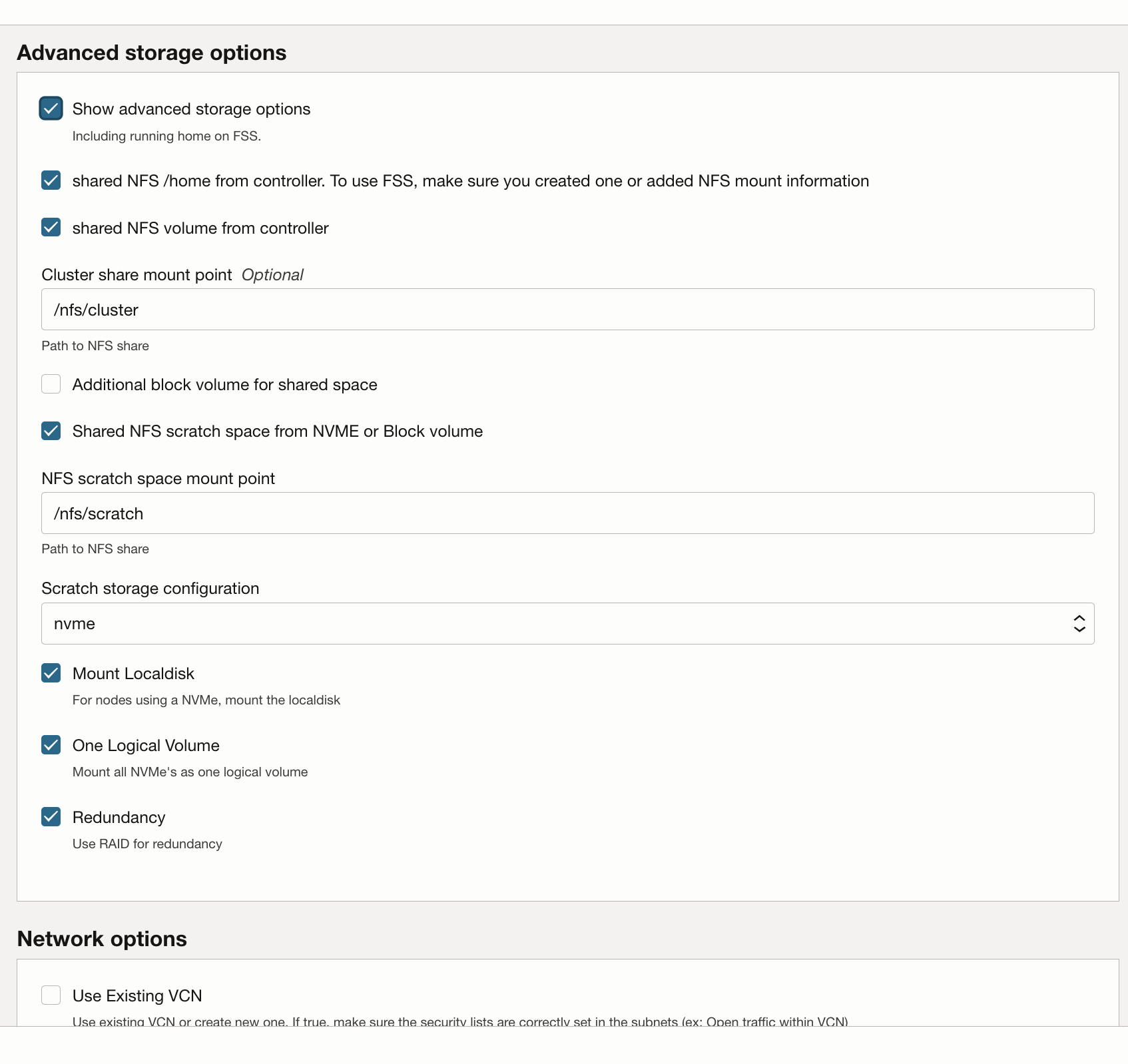

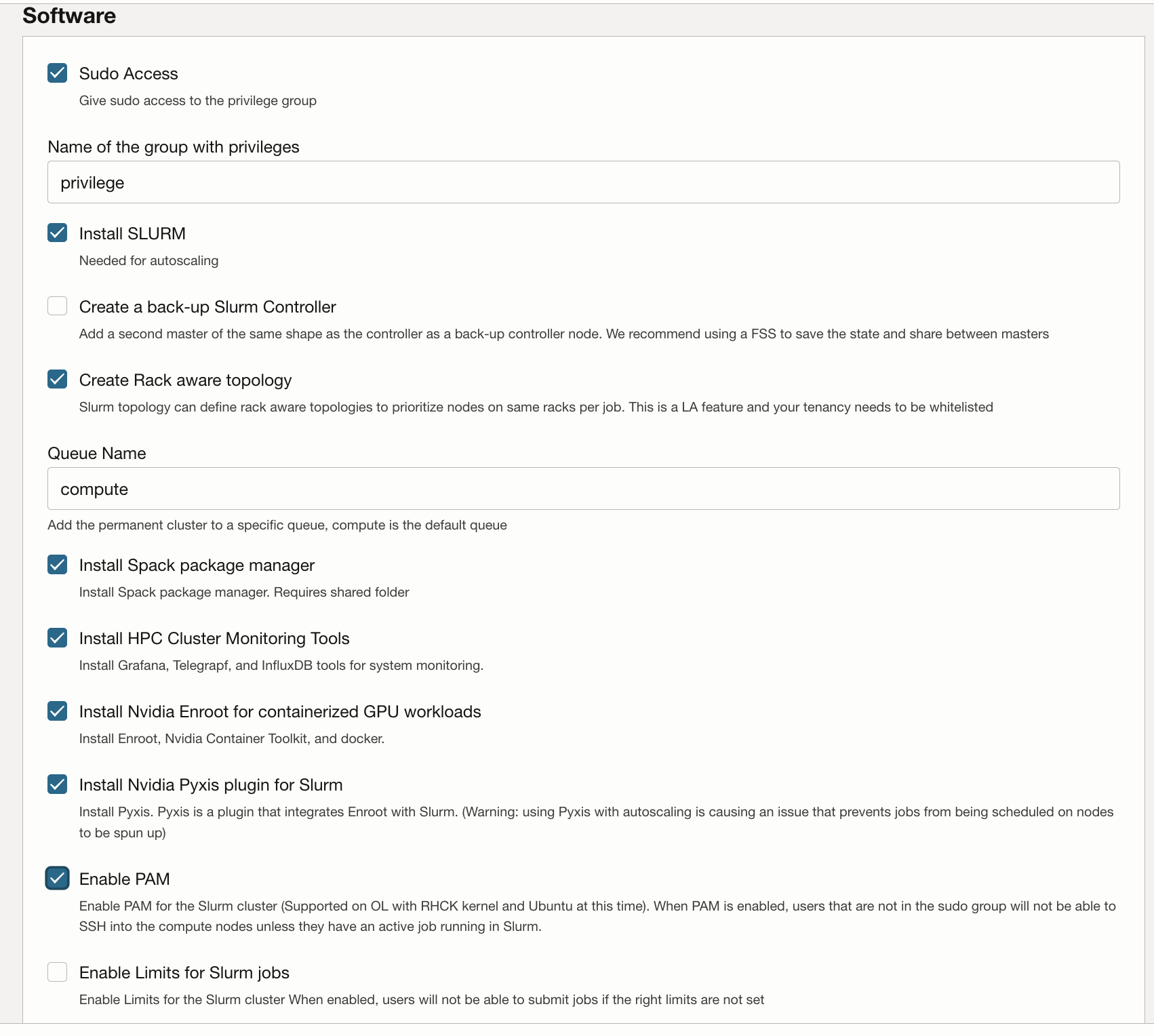

La pile de cluster HPC utilise Terraform pour déployer les ressources Oracle Cloud Infrastructure. La pile crée des noeuds GPU, du stockage, des fonctions de réseau standard et des fonctions de réseau de cluster hautes performances, ainsi qu'un bastion/noeud principal pour l'accès au cluster et sa gestion.

Déployer le cluster GPU

Votre compte Oracle Cloud doit appartenir à un groupe autorisé à déployer et à gérer ces ressources. Reportez-vous à la section Usage Instructions du cluster HPC pour plus d'informations sur les exigences de stratégie.

Vous pouvez déployer la pile vers un compartiment existant, mais il peut être plus propre si vous créez un compartiment spécifique pour le cluster.

Remarques :

Bien que l'utilisation de la pile Marketplace pour provisionner un environnement n'entraîne aucun coût, les ressources provisionnées lors du lancement de la pile vous seront facturées.- Créez un compartiment pour votre location et votre région et vérifiez que des stratégies sont disponibles.

- Utilisez la pile de cluster HPC pour déployer le cluster GPU.