Implémenter Oracle Modern Data Platform pour le reporting et les prévisions métier

Cette section explique comment provisionner les services OCI, implémenter le cas d'utilisation, visualiser les données et créer des prévisions.

Provisionner les services OCI

Passons en revue les principales étapes de provisionnement des ressources pour une démonstration simple de ce cas d'utilisation.

Implémenter le cas d'utilisation d'Oracle Modern Data Platform

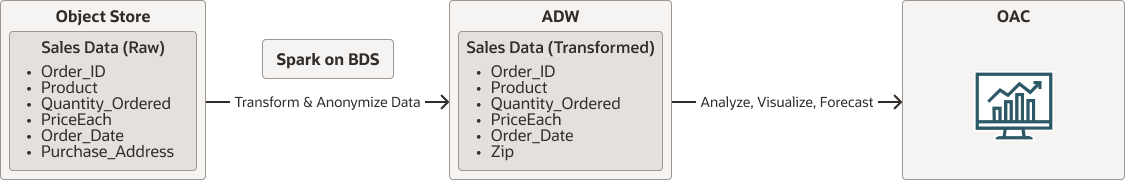

Avant d'entrer dans les détails de l'implémentation, examinons le flux global.

- Les données brutes résideront dans OCI Object Storage.

- Spark exécuté de manière native sur Oracle Big Data Service lit les données d'OCI Object Storage. Elle nettoiera, transformera et anonymisera les données et persistera enfin dans Autonomous Data Warehouse.

- Les utilisateurs utiliseront Oracle Analytics Cloud pour visualiser les données et effectuer des prévisions.

oci-modern-data-reporting-flow-oracle.zip

Remarques :

Le flux de données choisi est un exemple simpliste, les cas d'utilisation réels de l'entreprise peuvent être plus impliqués.La section suivante explique comment télécharger des données échantillon, configurer OCI Object Storage, Oracle Big Data Service et appeler un travail Scala Spark simple pour transformer des données et déplacer des données vers Autonomous Data Warehouse.