Configuration de IaaS pour Private Cloud Appliance

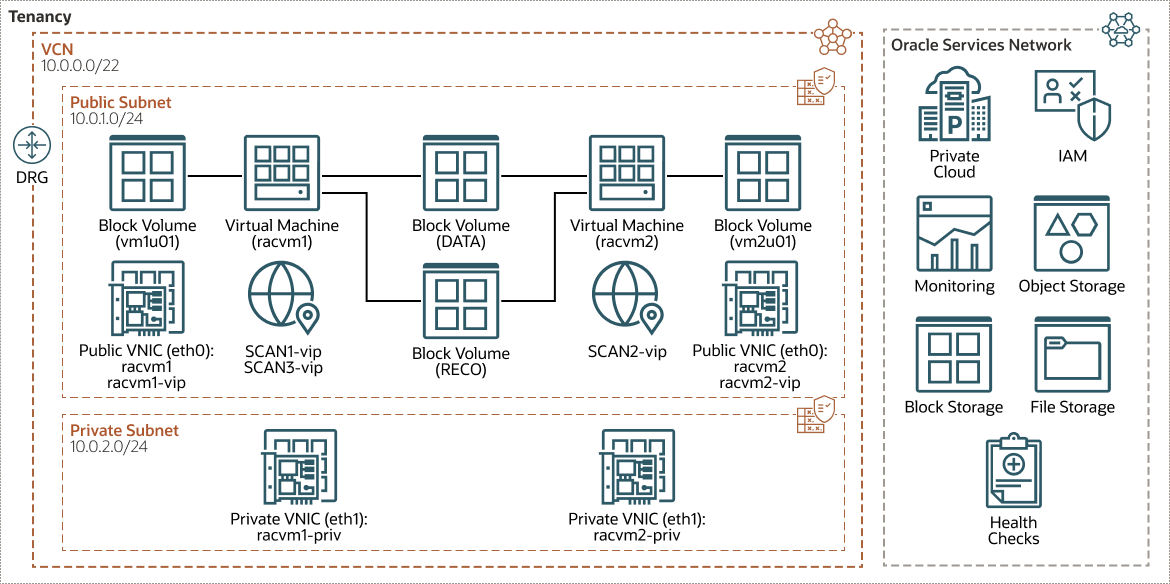

Vous devez configurer le réseau, le calcul, le stockage, le système d'exploitation et installer Oracle Grid Infrastructure et le logiciel de base de données Oracle RAC pour pouvoir créer une base de données Oracle RAC sur Oracle Private Cloud Appliance. La configuration IaaS sur Private Cloud Appliance ressemble à l'architecture suivante.

Avant de créer l'infrastructure, passez en revue les hypothèses et considérations suivantes :

- Tous les noeuds (machines virtuelles) d'un environnement Oracle RAC doivent se connecter à au moins un réseau public pour permettre aux utilisateurs et aux applications d'accéder à la base de données.

- En plus du réseau public, Oracle RAC requiert une connectivité de réseau privé utilisée exclusivement pour la communication entre les noeuds et les instances de base de données en cours d'exécution sur ces noeuds.

- Lorsque vous utilisez Oracle Private Cloud Appliance, une seule interconnexion de réseau privé peut être configurée. Ce réseau est communément appelé interconnexion. Le réseau d'interconnexion est un réseau privé qui connecte tous les serveurs du cluster.

- En plus d'accéder à l'interface utilisateur de l'enclave de calcul (CEUI), vous devez également configurer l'interface de ligne de commande OCI sur une machine virtuelle Bastion pour exécuter les commandes à l'aide d'OCI au lieu de compter sur CEUI.

Les sections suivantes expliquent comment créer des structures de calcul, de réseau et de stockage sur un système Private Cloud Appliance.

Configuration des noeuds de calcul

Cette procédure explique comment créer des machines virtuelles de calcul.

Configurer le stockage

Oracle RAC utilise Oracle Automatic Storage Management (Oracle ASM) pour un accès efficace au stockage partagé. Oracle Automatic Storage Management (Oracle ASM) agit en tant que gestionnaire de volumes en cluster sous-jacent. Il fournit à l'administrateur de base de données une interface de gestion du stockage simple et cohérente sur toutes les plates-formes de serveur et de stockage. En tant que gestionnaire de volumes et de systèmes de fichiers verticalement intégrés, spécialement conçu pour les fichiers Oracle Database, Oracle Automatic Storage Management (Oracle ASM) offre les performances des E/S brutes grâce à la gestion facile d'un système de fichiers.