Sviluppo di applicazioni Data Flow

Informazioni sulla libreria , inclusi i modelli di applicazione Spark riutilizzabili e la sicurezza delle applicazioni. Imparare inoltre a creare e visualizzare applicazioni, modificare applicazioni, eliminare applicazioni e applicare argomenti o parametri.

- Quando si creano applicazioni mediante la console

- In Opzioni avanzate specificare la durata in Minuti durata massima esecuzione.

- Quando si creano applicazioni mediante l'interfaccia CLI

- Opzione pass della riga di comando di

--max-duration-in-minutes <number> - Quando si creano applicazioni mediante l'SDK

- Fornire l'argomento facoltativo

max_duration_in_minutes - Quando si creano applicazioni mediante l'API

- Impostare l'argomento facoltativo

maxDurationInMinutes

Modelli di applicazione Spark riutilizzabili

Un'applicazione è un modello di applicazione Spark riutilizzabile all'infinito.

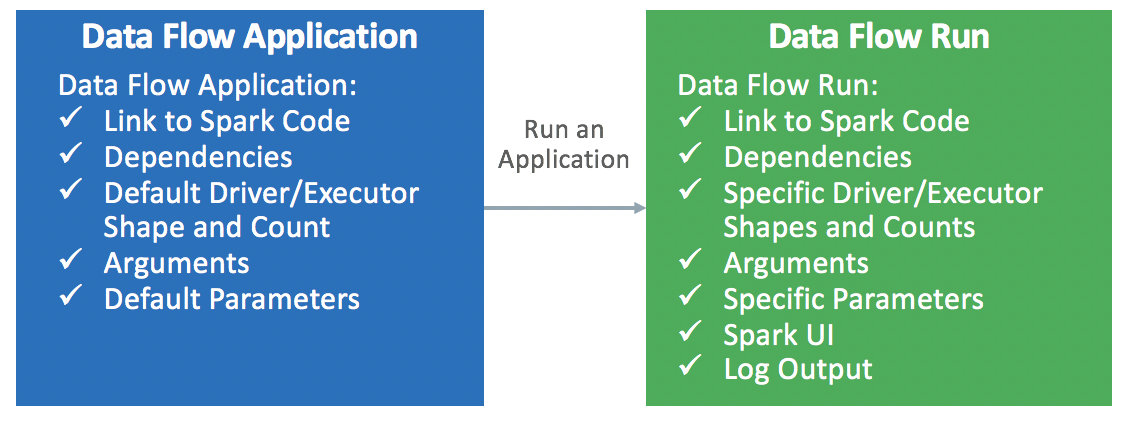

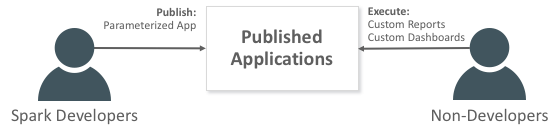

Le applicazioni di flusso dati sono costituite da un'applicazione Spark, dalle relative dipendenze, dai parametri predefiniti e da una specifica di risorsa runtime predefinita. Dopo che uno sviluppatore Spark ha creato un'applicazione di flusso dati, chiunque può utilizzarla senza preoccuparsi delle complessità legate alla sua distribuzione, impostazione o esecuzione. Puoi utilizzarlo tramite l'analitica Spark in dashboard, report, script o chiamate API REST personalizzate.

Ogni volta che si richiama l'applicazione di flusso dati, si crea un'esecuzione . Compila i dettagli del modello di applicazione e lo avvia su un set specifico di risorse IaaS.