Regressione lineare

Le medie e i valori massimi superano i dati raw giornalieri o i dati raw orari in base al contesto temporale globale, come indicato di seguito. Gli aggregati orari vengono utilizzati quando il periodo di tempo è compreso negli ultimi sette giorni, altrimenti vengono utilizzati gli aggregati giornalieri.

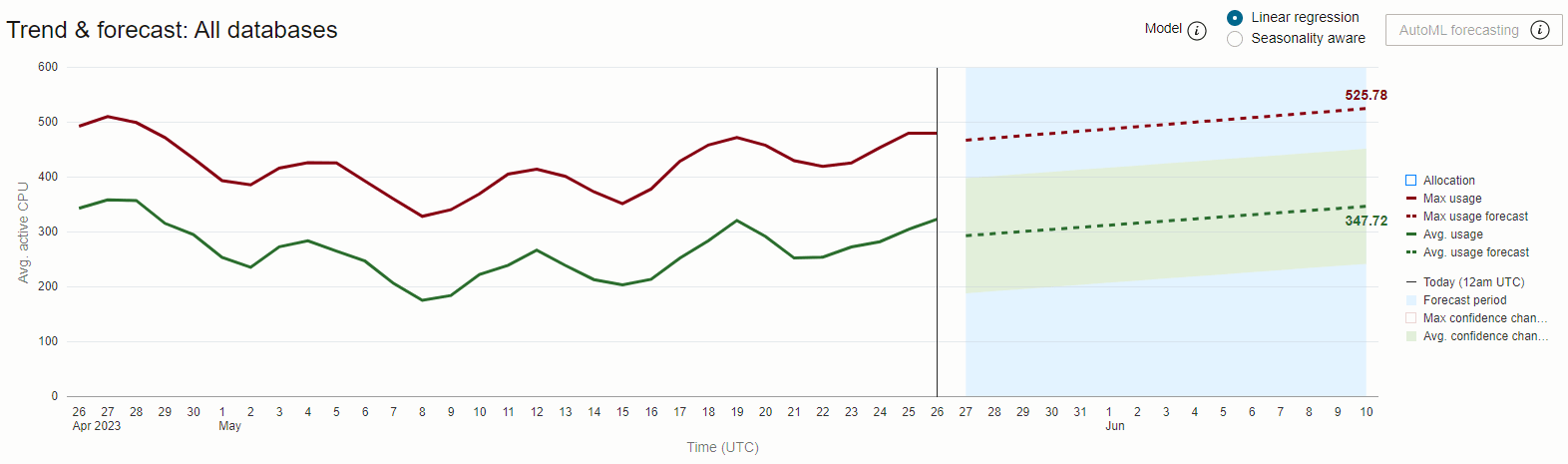

I periodi di previsione sono impostati su 1⁄2 della lunghezza del periodo di tempo di tendenza, ad esempio: gli andamenti a 30 giorni vengono proiettati con 15 giorni di anticipo e gli andamenti a 90 giorni con 45 giorni di anticipo.

Il grafico precedente mostra l'uso medio giornaliero e massimo della CPU su 30 giorni per il database HR-Dev. Vediamo un divario consistente e considerevole tra la serie di dati Uso medio e Uso massimo, indicando un alto livello di variabilità nella domanda di CPU durante il giorno.

L'andamento e la previsione dell'utilizzo massimo sono molto vicini o toccano l'allocazione massima per il database, il che indica che il rischio di esaurimento della capacità dovrebbe richiedere un aumento o se viene introdotto un nuovo carico di lavoro.

La differenza tra l'uso massimo previsto (~29 CPU attiva media) e l'uso medio previsto (~15 CPU attiva media) è la differenza tra la quantità di CPU necessaria per eseguire tutto il lavoro in modo sicuro e la quantità di CPU effettivamente necessaria per eseguire tutto il lavoro. Quando le risorse CPU sono "allocate a fondo" per i database, questa differenza rappresenta la quantità di risorsa pagata meno la quantità di risorsa utilizzata ed è quindi un costo opportunità indotto dalla domanda di CPU ad alta variabile.

Un modo potenziale per mitigare questo costo imputato di variabilità è condividere le risorse CPU tra diversi database e consentire l'allocazione dinamica delle risorse tra di loro in risposta al cambiamento della domanda.

Oracle Autonomous AI Database con scala automatica abilitata offre proprio una soluzione di questo tipo.