Nota

- Questa esercitazione è disponibile in un ambiente di esercitazione pratica gratuito fornito da Oracle.

- Utilizza valori di esempio per le credenziali, la tenancy e i compartimenti di Oracle Cloud Infrastructure. Quando completi il tuo laboratorio, sostituisci questi valori con quelli specifici del tuo ambiente cloud.

Usa un assistente AI con Oracle Cloud Native Environment

Introduzione

L'Assistente AI di Oracle Cloud Native Environment (Oracle CNE) è un plugin fornito con l'interfaccia utente (UI) di Oracle CNE. AI Assistant aiuta gli utenti a gestire e ottenere insight sullo stato del loro cluster Kubernetes utilizzando il linguaggio naturale (attualmente solo l'inglese). È dipendente dal contesto, il che significa che le sue risposte sono pertinenti allo stato del cluster e alla posizione all'interno dell'interfaccia utente di Oracle CNE quando si avvia un'interazione con l'Assistente AI. Ad esempio, se un utente non è sicuro del numero di nodi nel cluster, chiedere all'Assistente AI, "Quanti nodi si trovano nel cluster?" e confermerà il numero di nodi nel cluster. È possibile inviare ulteriori prompt, consentendo all'utente di avviare un flusso di conversazione con l'Assistente AI. Le funzioni principali fornite dall'Assistente AI includono:

-

Esperienza Kubernetes conversazionale: consente agli utenti esperti e alle prime armi di interagire con il cluster in modo conversazionale utilizzando il linguaggio naturale per inviare domande sul cluster senza richiedere una conoscenza approfondita di Kubernetes.

-

Supporto contestuale: l'Assistente AI conosce ciò che l'utente sta visualizzando quando viene pubblicata una richiesta e fornisce risposte appropriate a questo contesto iniziale.

- Supporto multi-provider: l'Assistente AI supporta più provider AI (per i dettagli, vedere a monte).

Nota: è necessario fornire la propria chiave API per accedere al provider scelto.

-

Strumenti configurabili: può essere configurato per utilizzare le API Kubernetes per eseguire query sulle informazioni del cluster.

-

Generazione delle risorse: gli utenti possono richiedere all'Assistente AI di generare Kubernetes YAML.

- Analisi approfondita: assiste gli utenti nella gestione del cluster. Ad esempio, diagnosticando i problemi, raccogliendo e interpretando i log e altro ancora.

Questa esercitazione descrive come configurare il plugin AI Assistant, incluso nell'interfaccia utente di Oracle CNE con un'istanza AI in hosting locale (Ollama).

Obiettivi

In questo tutorial imparerai:

- Come configurare e utilizzare AI Assistant incluso nell'interfaccia utente di Oracle CNE.

Prerequisiti

- Installazione di Oracle Cloud Native Environment

Distribuire Oracle Cloud Native Environment

Nota: se è in esecuzione nella propria tenancy, leggere il progetto linux-virt-labs GitHub README.md e completare i prerequisiti prima di distribuire l'ambiente di laboratorio.

-

Aprire un terminale sul Luna Desktop.

-

Duplicare il progetto

linux-virt-labsGitHub.git clone https://github.com/oracle-devrel/linux-virt-labs.git -

Passare alla directory di lavoro.

cd linux-virt-labs/ocne2 -

Installare le raccolte richieste.

ansible-galaxy collection install -r requirements.yml -

Implementare l'ambiente di laboratorio.

ansible-playbook create_instance.yml -e localhost_python_interpreter="/usr/bin/python3.6" -e install_ocne_rpm=true -e create_ocne_cluster=true -e "ocne_cluster_node_options='-n 1 -w 1'"L'ambiente di esercitazione pratica gratuito richiede l'aggiunta della variabile

local_python_interpreter, che impostaansible_python_interpreterper le riproduzioni eseguite su localhost. Questa variabile è necessaria perché l'ambiente installa il pacchetto RPM per l'SDK Oracle Cloud Infrastructure per Python, che si trova sotto i moduli python3.6.La forma di distribuzione predefinita utilizza la CPU AMD e Oracle Linux 8. Per utilizzare una CPU Intel o Oracle Linux 9, aggiungere

-e instance_shape="VM.Standard3.Flex"o-e os_version="9"al comando di distribuzione.Importante: attendere che il playbook venga eseguito correttamente e raggiungere il task di sospensione. In questa fase del playbook, l'installazione di Oracle Cloud Native Environment è completa e le istanze sono pronte. Prendi nota del gioco precedente, che stampa gli indirizzi IP pubblici e privati dei nodi che distribuisce e qualsiasi altra informazione di distribuzione necessaria durante l'esecuzione del laboratorio.

Confermare il numero di nodi

Consente di conoscere il numero e i nomi dei nodi nel cluster Kubernetes.

-

Aprire un terminale e connettersi tramite SSH all'istanza ocne.

ssh oracle@<ip_address_of_node> -

Elenca i nodi nel cluster.

kubectl get nodesL'output mostra il piano di controllo e i nodi di lavoro in uno stato

Ready, insieme alla versione Kubernetes corrente.

Crea un token di accesso

Oracle Cloud Native Environment distribuisce l'interfaccia utente nel cluster Kubernetes utilizzando una distribuzione e un servizio denominati UI, che verranno utilizzati per accedervi. Sia la distribuzione che il servizio vengono distribuiti nello spazio di nomi ocne-system. Per connettersi al servizio, è necessario generare un token di accesso.

-

Generare un token di accedere.

kubectl --namespace ocne-system create token uiOutput di esempio:

> [oracle@ocne ~]$ kubectl --namespace ocne-system create token ui > eyJhbGciOiJSUzI1NiIsImtpZCI6IjhfRWczUG13VWRfWjFkWDIxdkp6UUZlRzEwU2QxaExkbm9TME1CcS1rVFEifQ.eyJhdWQiOlsiaHR0cHM6Ly9rdWJlcm5ldGVzLmRlZmF1bHQuc3ZjLmNsdXN0ZXIubG9jYWwiXSwiZXhwIjoxNzI4Mzg3MTgwLCJpYXQiOjE3MjgzODM1ODAsImlzcyI6Imh0dHBzOi8va3ViZXJuZXRlcy5kZWZhdWx0LnN2Yy5jbHVzdGVyLmxvY2FsIiwianRpIjoiYzlmMWViZTctYzA1ZC00MTYxLTg2MzctOWNiZGFlNTI5MzFiIiwia3ViZXJuZXRlcy5pbyI6eyJuYW1lc3BhY2UiOiJvY25lLXN5c3RlbSIsInNlcnZpY2VhY2NvdW50Ijp7Im5hbWUiOiJ1aSIsInVpZCI6IjdjY2RjZGZlLTAzNzMtNGUwZS1hMzViLTc5MzdhM2NiZmYzMyJ9fSwibmJmIjoxNzI4MzgzNTgwLCJzdWIiOiJzeXN0ZW06c2VydmljZWFjY291bnQ6b2NuZS1zeXN0ZW06dWkifQ.WSLZFste1ggkE2GtjJ2cBrORNFgCzHOlALNXD_-6vLA9kIiDJHp44HshUcXvUFH1XdFM1SGbiCvITOwT8Y5_93IKVZLu1NRyGPZlo5l4JqwnJtqLn7J6e39OlC2SXqex6vLBCU-sBqiw_P9xksNa7fO_MzsryEo-5oMgsVVo9oJr9wv4LYLv2Obd8U5ukKjBeiRiwTu9MTK0r_GlhmZ9d7GHrYrgF1MJGMgzvqyTyviyIynD2F0OkKARIThghpEL6aou4F_DFFMy8t0qjiJG3rBTXL6fXxZ-3WxZUGdx920ZSHcqG2XOaLY7txRkKYbudIjyt-gODeR-FZCIthw5kw >Il token visualizzato verrà utilizzato per l'autenticazione quando ci si connette all'interfaccia utente.

Creare una porta in avanti per esporre l'interfaccia utente

Il port-forwarding fornisce un modo semplice e rapido per esporre il servizio dell'interfaccia utente sul sistema locale in modo da poterlo utilizzare per monitorare, risolvere i problemi e, se necessario, eseguire il debug dell'ambiente di sviluppo.

Importante: Oracle sconsiglia di utilizzare l'inoltro delle porte per esporre l'interfaccia utente per un ambiente di produzione.

-

Impostare l'inoltro della porta.

kubectl port-forward --namespace ocne-system service/ui 8443:443Output di esempio:

> [oracle@ocne ~]$ kubectl port-forward --namespace ocne-system service/ui 8443:443 > Forwarding from 127.0.0.1:8443 -> 4466 > Forwarding from [::1]:8443 -> 4466 >Nota: il comando

kubectl port-forwardcontinuerà a essere eseguito in primo piano. Lascia che continui mentre accedi all'interfaccia utente.

Installa Ollama

-

Aprire un nuovo terminale e connettersi tramite SSH all'istanza ocne.

ssh oracle@<ip_address_of_node> -

Installa una dipendenza richiesta.

sudo dnf install -y zstd -

Installare Ollama.

curl -fsSL https://ollama.com/install.sh | sh -

Eseguire un modello.

ollama run llama3.2 -

Aprire un nuovo terminale e creare un tunnel SSH.

ssh -L 11434:127.0.0.1:11434 -L 9898:127.0.0.1:8443 oracle@<ip_address_of_node>Il tunnel consente l'accesso da un browser nel sistema locale a una determinata porta al sistema remoto che esegue il cluster Kubernetes. Non è necessario generare un tunnel se entrambi si trovano nello stesso sistema. Quando si esegue sullo stesso sistema, è possibile accedere all'interfaccia utente utilizzando

https://127.0.0.1:8443e Ollama utilizzandohttp://127.0.0.1:11434. -

Aprire un browser sul desktop Luna e immettere l'URL per confermare l'esecuzione di Ollama.

http://127.0.0.1:11434Il browser dovrebbe visualizzare un messaggio di testo simile a questo:

Ollama is running.

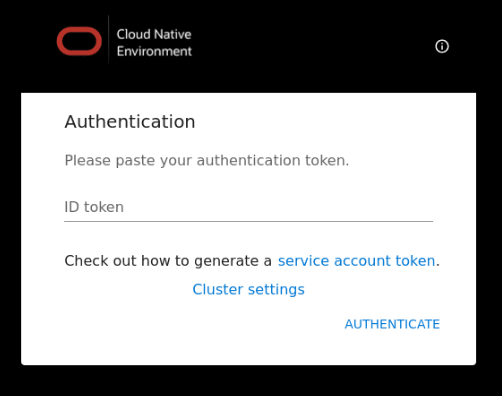

Login all'interfaccia utente

-

Aprire un browser sul desktop Luna e immettere l'URL.

https://127.0.0.1:9898Approva l'avvertenza di sicurezza in base al browser utilizzato. Per Chrome, fare clic sul pulsante

Advanced, quindi sul collegamentoAccept the Risk and Continue. -

Immettere il token d'accesso.

Immettere il token di accesso creato in precedenza e fare clic sul collegamento

Authenticate.

-

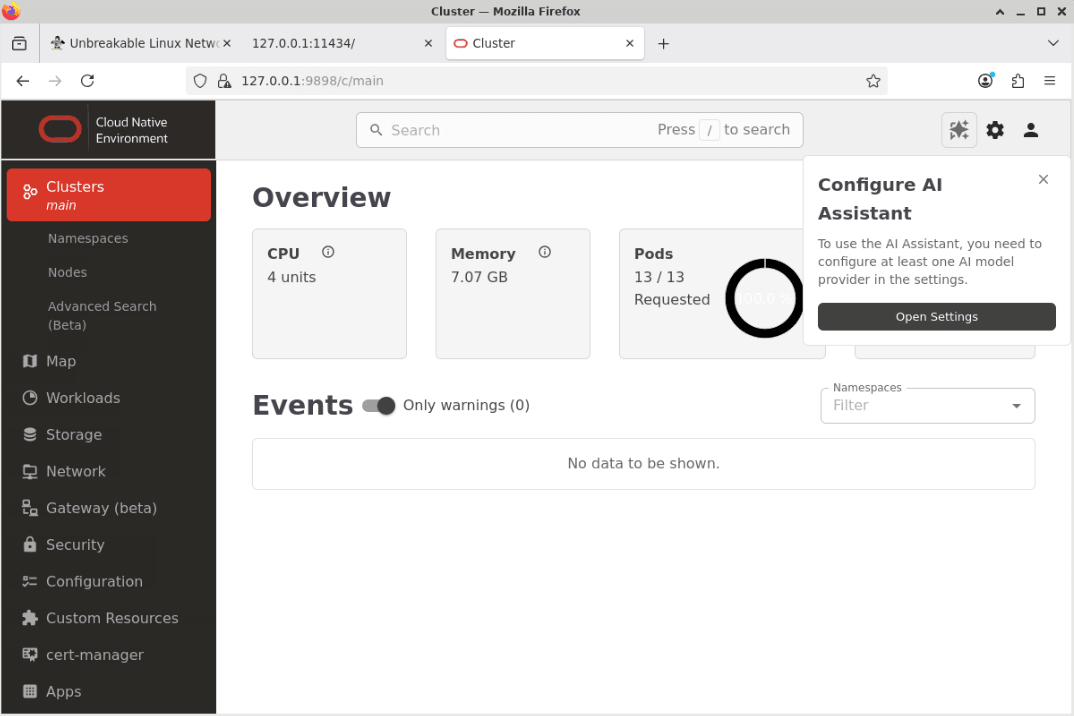

Viene visualizzata la pagina Panoramica interfaccia utente.

Fare clic sul pulsante Apri impostazioni nella finestra popup denominata Configura assistente AI.

Nota: è possibile che alcune avvertenze siano elencate nella sezione Evento della pagina di arrivo. Questo comportamento è normale e si risolverà dopo pochi minuti.

-

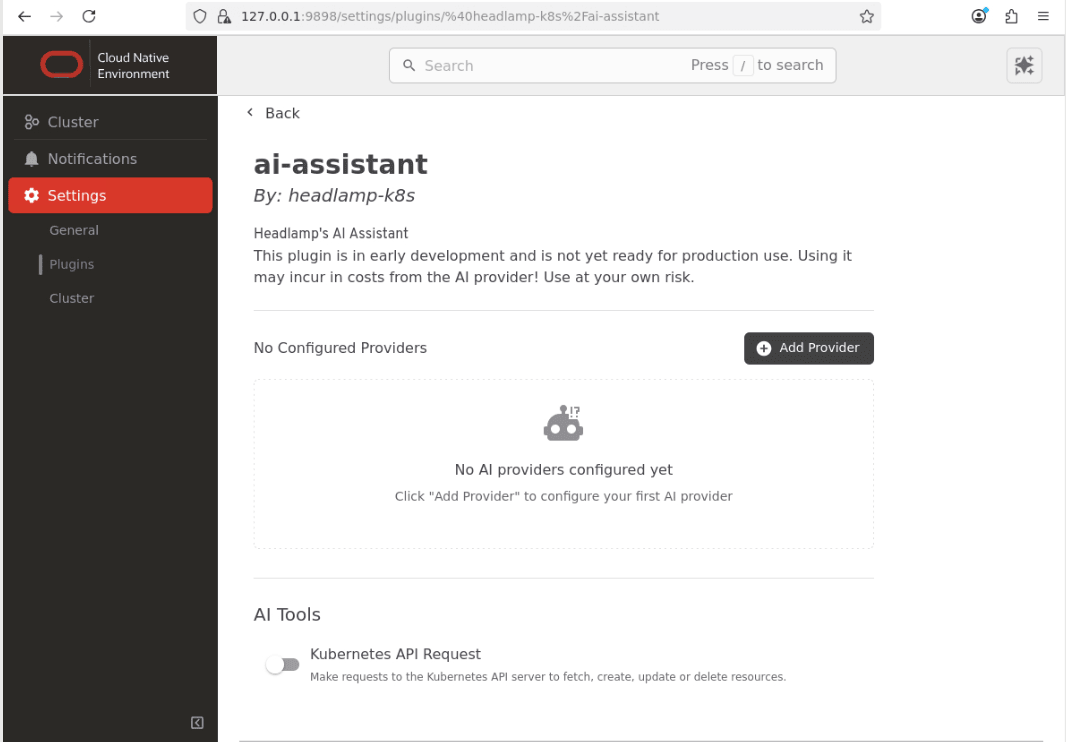

Viene visualizzata la pagina di configurazione ai-assistant nella sezione Impostazioni.

Nota: deselezionare il pulsante Richiesta API Kubernetes nella sezione Strumenti AI.

Configurare un provider locale.

-

Fare clic sul pulsante

Add Provider.

-

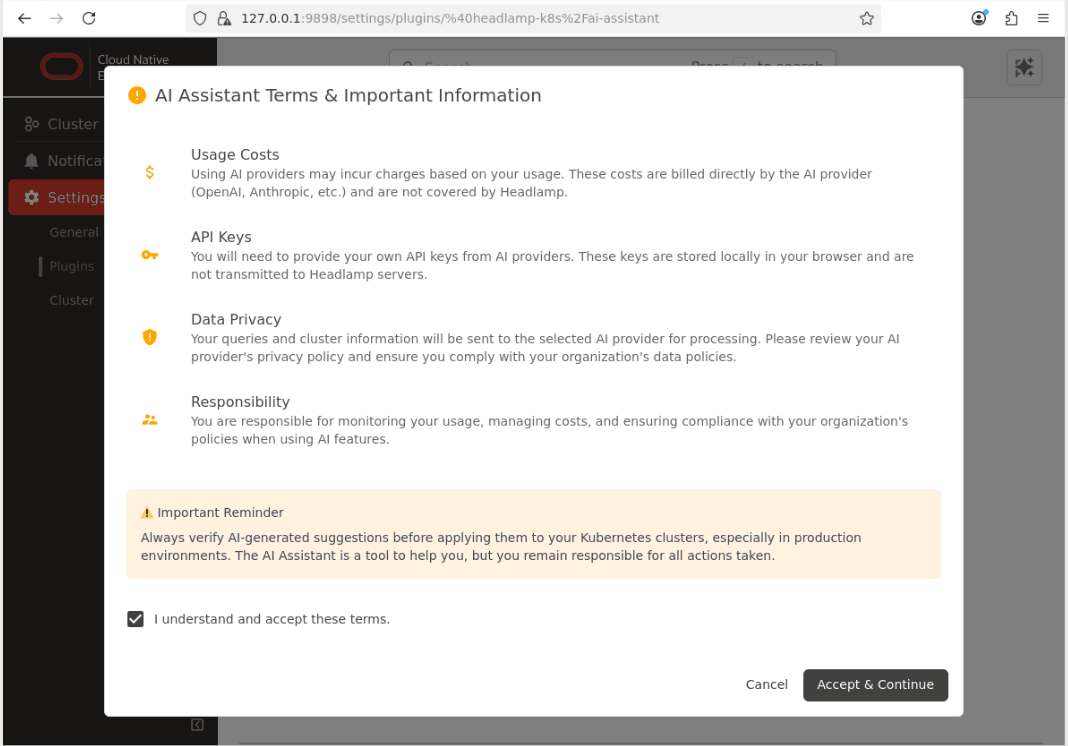

Confermare la finestra di dialogo 'Termini e informazioni importanti'.

-

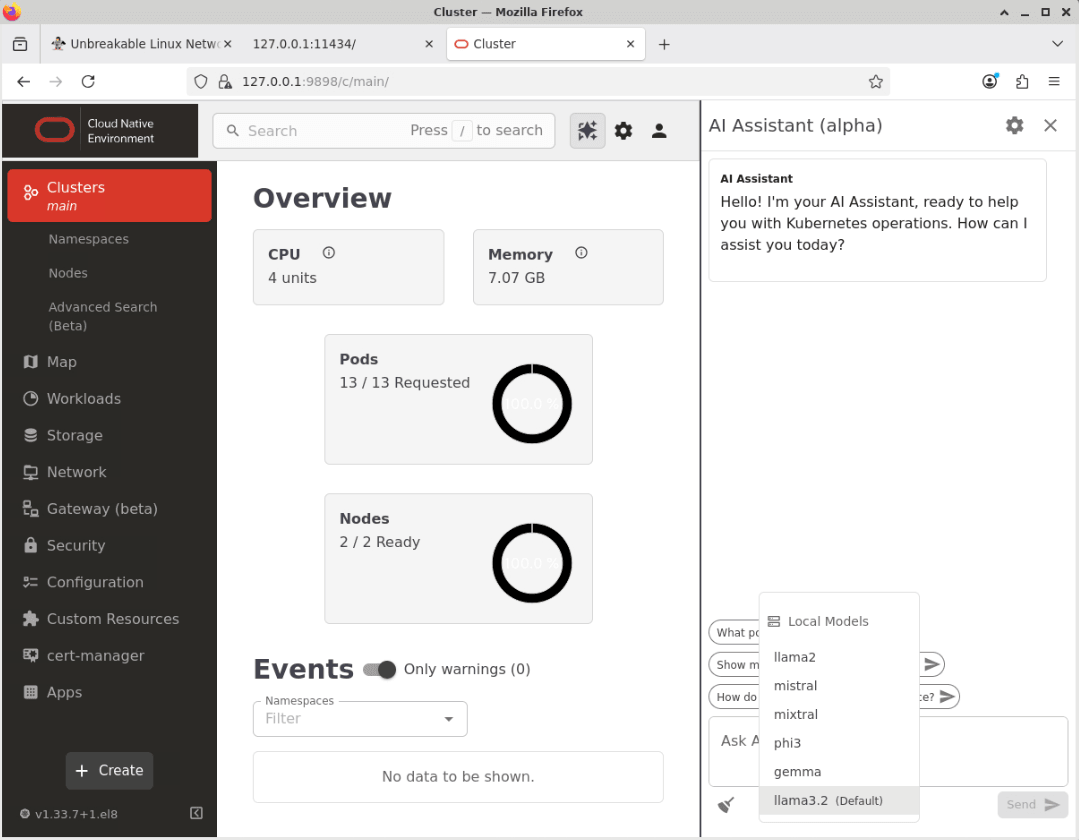

Fare clic sull'opzione di menu

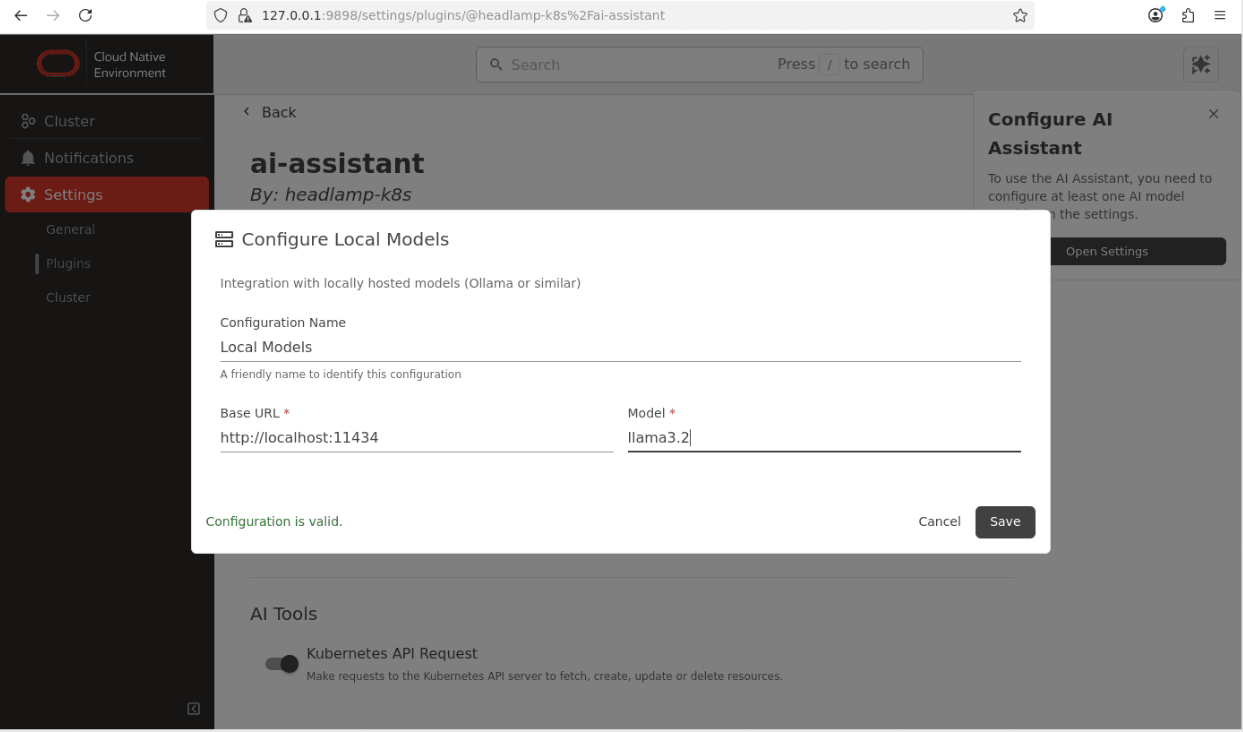

Clustere quindi sul collegamentoLocal Models.

Nota: immettere i dettagli corretti per il modello di Ollama locale in uso. Questo esempio mostra il modello

llama3.2impostato in precedenza. -

Fare clic su

Saveper salvare le impostazioni del provider.L'Assistente AI è ora configurato e pronto per essere utilizzato.

Confermare il funzionamento dell'assistente AI.

-

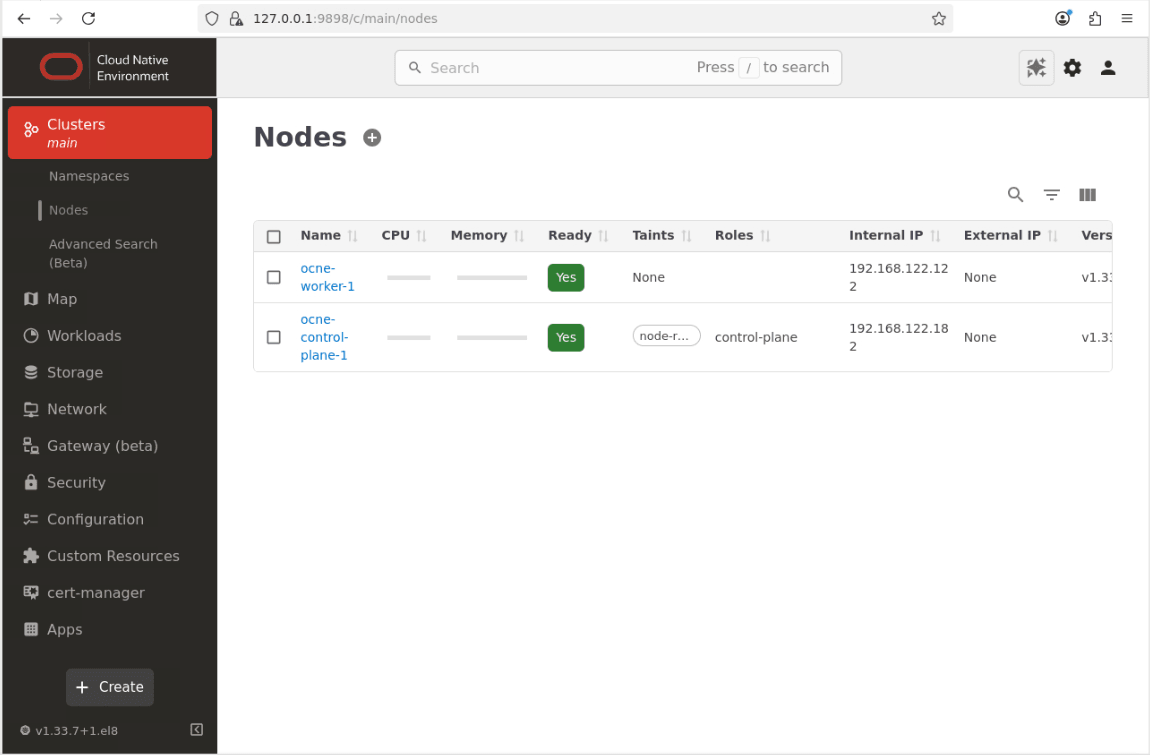

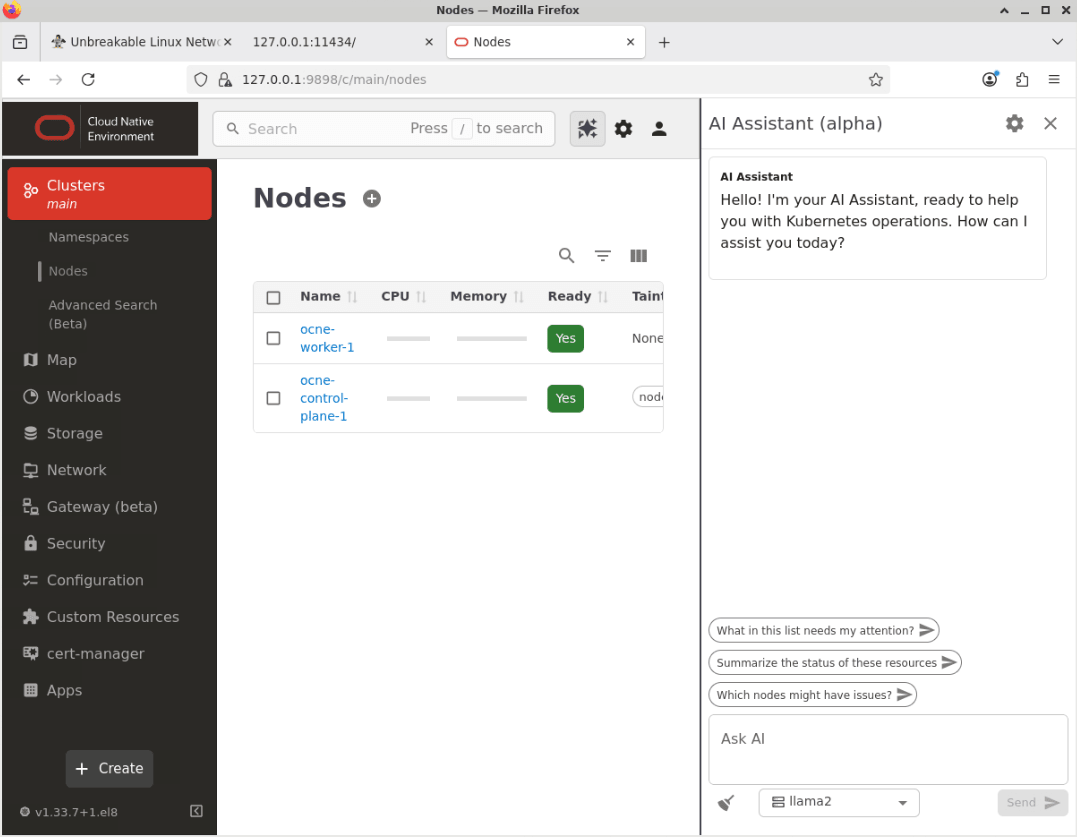

Fare clic sulla voce di menu denominata Cluster e su 'Nodi' per accedere alla pagina Nodi.

-

Fare clic sul pulsante AI Assistant situato nella parte superiore destra della schermata principale.

-

Viene visualizzata la finestra di AI Assistant.

-

Fare clic sulla casella di riepilogo a discesa per modificare il modello dall'opzione predefinita (llama2) al modello locale appena configurato (llama3.2).

-

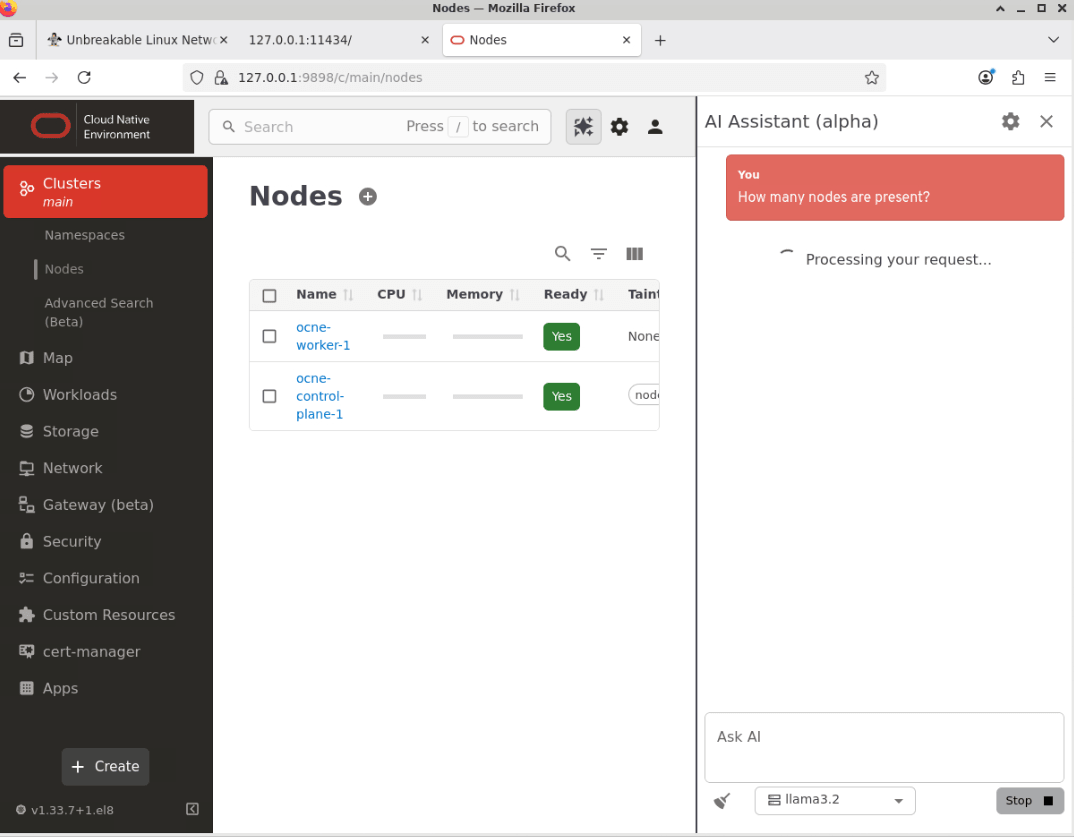

Fare all'Assistente AI una domanda nella casella di testo denominata 'Chiedi AI'.

Incollare questo esempio nella casella di testo denominata Chiedi AI.

How many nodes are present? -

Fare clic sul pulsante Invia per sottomettere la domanda.

Nota: il tempo impiegato dall'Assistente AI per rispondere dipende da diversi fattori, ad esempio le risorse disponibili per il modello LLM configurato e la complessità della domanda posta.

-

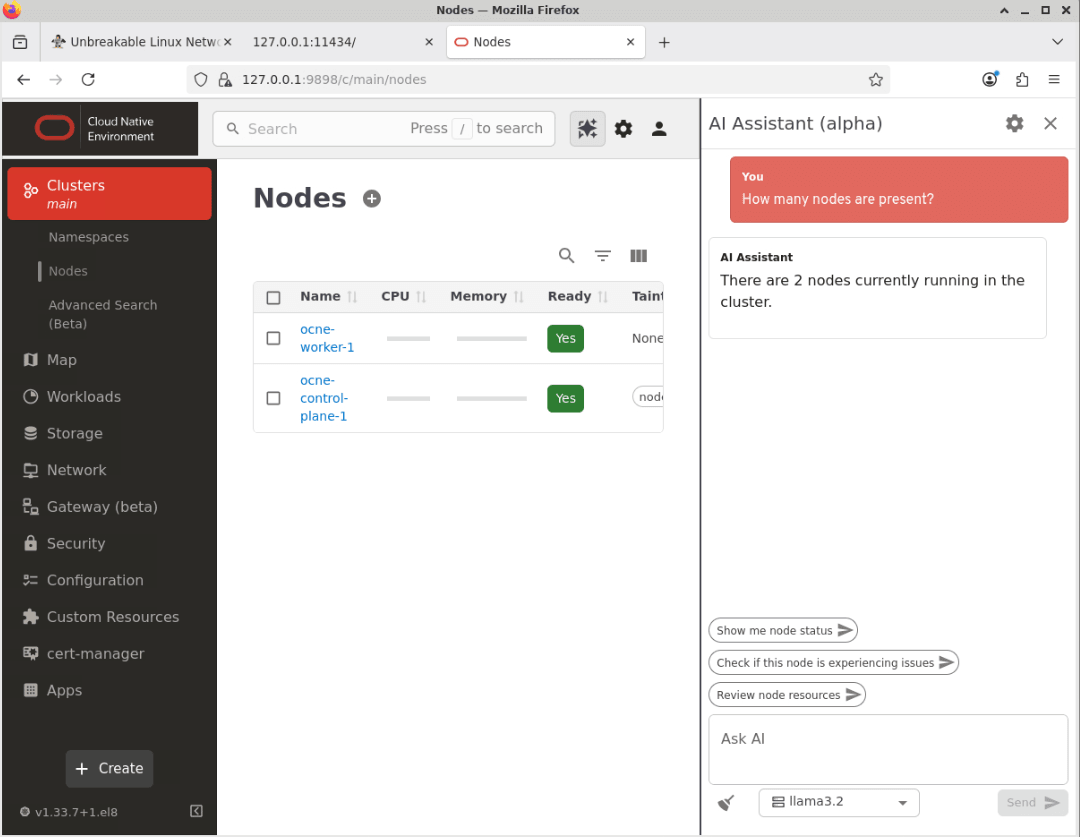

L'Assistente AI restituisce una risposta.

Nota: la formulazione esatta utilizzata nella risposta può variare leggermente tra le richieste.

-

Ciò conferma che l'Assistente AI sta funzionando.

Passi successivi

Attraverso questi passaggi, ora sai come abilitare l'accesso all'interfaccia utente (UI) di Oracle Cloud Native Environment e configurarla per utilizzare un LLM. Puoi esplorare le sue numerose caratteristiche e funzionalità, che tratteremo in futuri tutorial.

Collegamenti correlati

- Documentazione di Oracle Cloud Native Environment

- Oracle Cloud Native Environment Track

- Stazione di formazione Oracle Linux

Altre risorse di apprendimento

Esplora altri laboratori su docs.oracle.com/learn o accedi a più contenuti di formazione gratuiti sul canale YouTube di Oracle Learning. Inoltre, visitare education.oracle.com/learning-explorer per diventare Oracle Learning Explorer.

Per la documentazione del prodotto, visitare Oracle Help Center.

Use AI Assistant with Oracle Cloud Native Environment

G50305-01