Configurare lo stack di cluster HPC da Oracle Cloud Marketplace

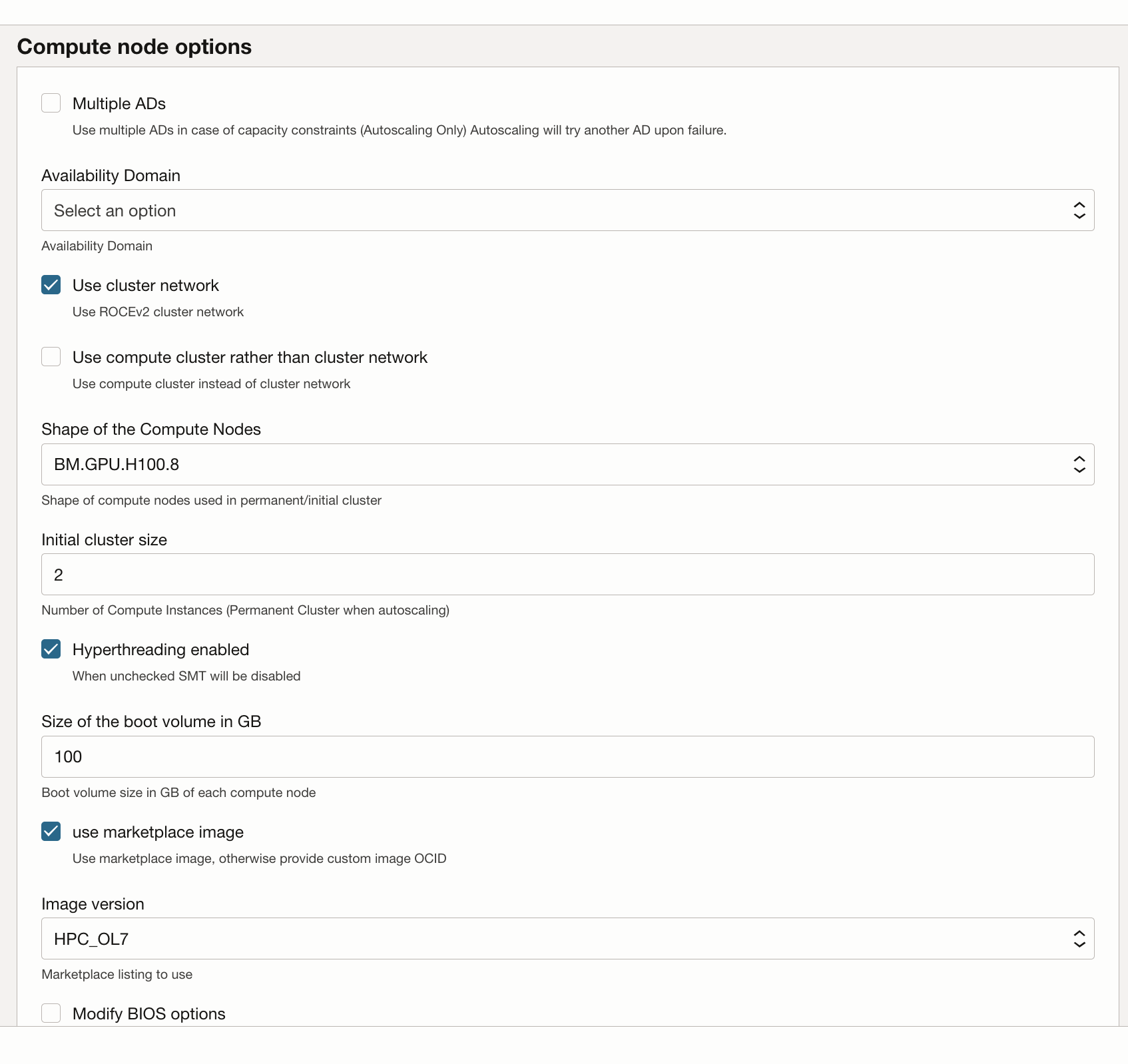

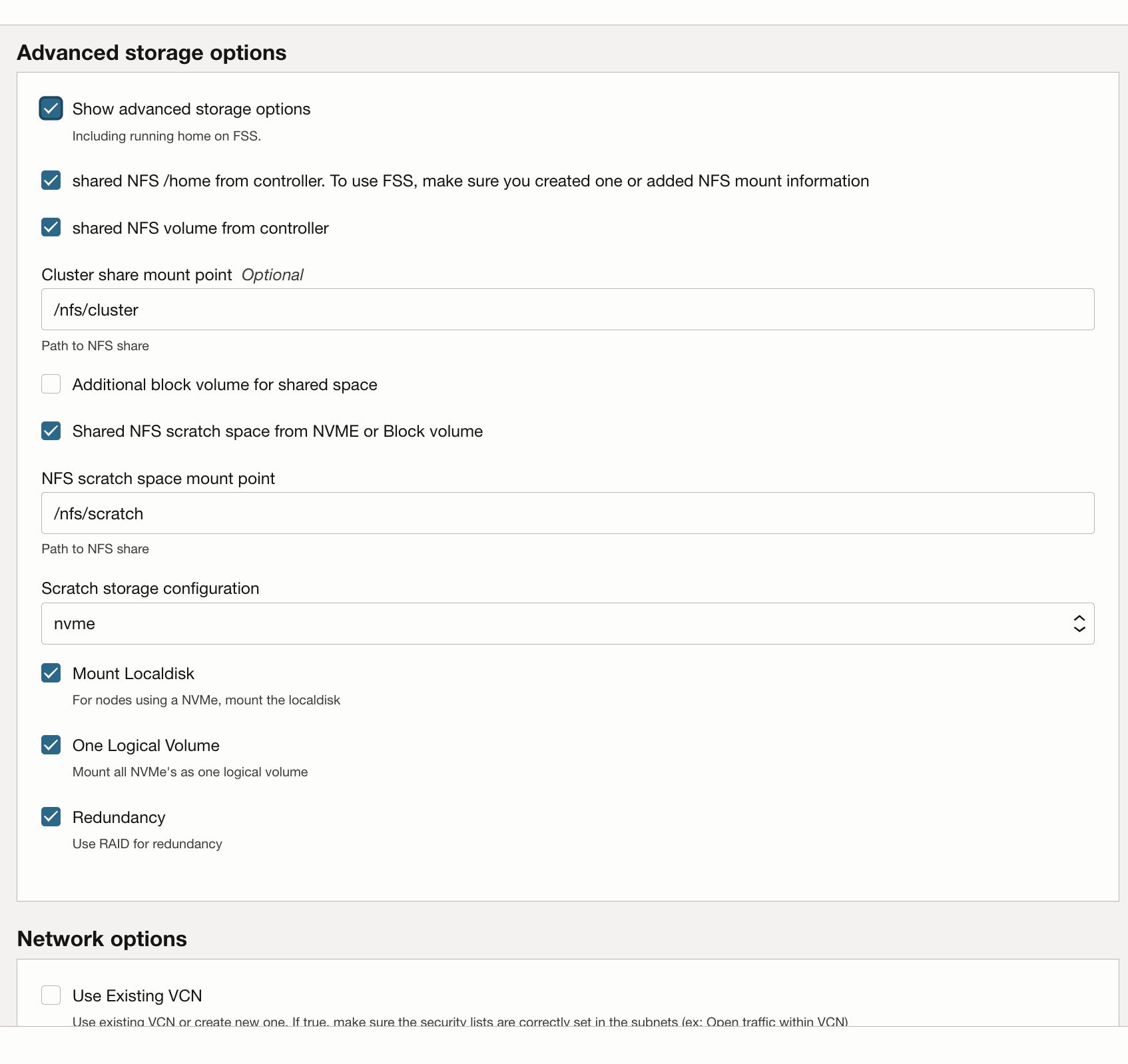

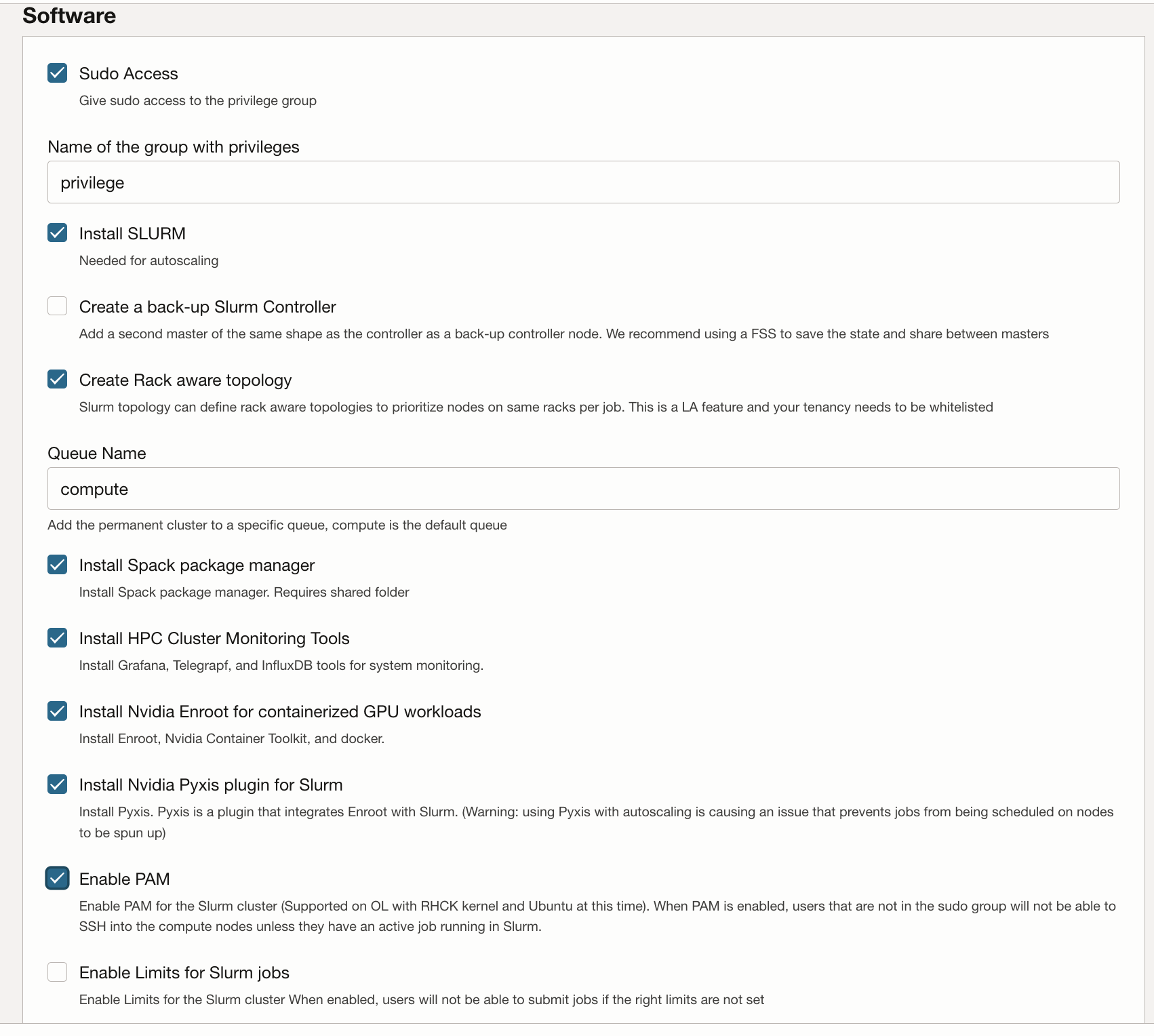

Lo stack di cluster HPC utilizza Terraform per distribuire le risorse Oracle Cloud Infrastructure. Lo stack creerà nodi GPU, storage, networking standard e networking cluster a elevate prestazioni e un nodo bastion/head per l'accesso e la gestione del cluster.

Distribuisci cluster GPU

L'account Oracle Cloud deve appartenere a un gruppo con l'autorizzazione per distribuire e gestire queste risorse. Per ulteriori dettagli sui requisiti dei criteri, vedere le istruzioni d'uso del cluster HPC.

Puoi distribuire lo stack in un compartimento esistente, ma potrebbe essere più pulito se crei un compartimento specifico per il cluster.

Nota

Sebbene non vi sia alcun costo per utilizzare lo stack del Marketplace per eseguire il provisioning di un ambiente, al momento dell'avvio dello stack verranno addebitate le risorse di cui è stato eseguito il provisioning.- Creare un compartimento per la tenancy e l'area e verificare che i criteri siano disponibili.

- Utilizzare lo stack di cluster HPC per distribuire il cluster GPU.