Configura per disaster recovery

È possibile utilizzare gli script forniti con questa guida di soluzione per creare uno snapshot YAML in un cluster Kubernetes primario e ripristinarlo in un altro cluster Kubernetes (secondario). È importante pianificare la configurazione e comprendere i requisiti prima di scaricare e utilizzare gli script per configurare lo snapshot YAML.

Nota

Questa soluzione presuppone che entrambi i cluster Kubernetes, inclusi il piano di controllo e i nodi di lavoro, esistano già.Pianificare la configurazione

Pianificare le risorse e la configurazione nel sistema secondario in base al sistema primario. Gli script richiedono che entrambi i cluster Kubernetes esistano già. Per eseguire i comandi, è necessario essere in grado di accedere a entrambi i cluster con lo strumento della riga di comando Kubernetes,

kubectl.

Nota

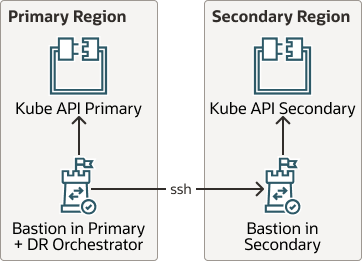

Questa soluzione presuppone che entrambi i cluster Kubernetes, inclusi il piano di controllo e i nodi di lavoro, esistano già. I suggerimenti e gli script forniti in questa guida non controllano le risorse, il piano di controllo o la configurazione dei nodi di lavoro.Il diagramma riportato di seguito mostra che, quando è configurato, è possibile ripristinare lo snapshot dell'artifact in cluster Kubernetes completamente diversi.

Descrizione dell'immagine kube-api-dr.png

Quando si pianifica la configurazione, completare i seguenti requisiti per Restore:

Verifica

Dopo aver eseguito lo script

maak8DR-apply.sh, verificare che tutti gli artifact esistenti nel cluster primario siano stati replicati nel cluster secondario. Esaminare il cluster secondario e verificare che i pod nel sito secondario siano in esecuzione senza errori.

Quando si esegue lo script maak8DR-apply.sh, il framework crea la directory working_dir come /tmp/backup.date. Quando si eseguono gli script maak8-get-all-artifacts.sh e maak8-push-all-artifacts.sh singolarmente, la directory di lavoro viene fornita in ogni caso come argomento nella riga di comando.