Implementa Oracle Modern Data Platform for Business Reporting and Forecasting

Questa sezione descrive come eseguire il provisioning dei servizi OCI, implementare il caso d'uso, visualizzare i dati e creare previsioni.

Esegui provisioning servizi OCI

Esaminiamo i passaggi principali per il provisioning delle risorse per una semplice demo di questo caso d'uso.

Implementa il caso d'uso di Oracle Modern Data Platform

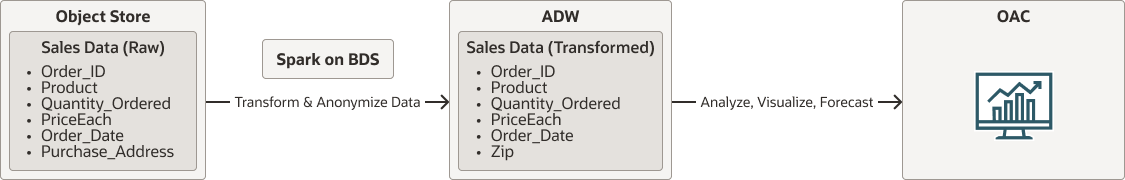

Prima di esaminare i dettagli dell'implementazione, esaminiamo il flusso complessivo.

- I dati non elaborati risiederanno in OCI Object Storage.

- Spark in esecuzione in modo nativo su Oracle Big Data Service leggerà i dati da OCI Object Storage. Pulisce, trasforma e rende anonimi i dati e infine rende persistenti i dati in Autonomous Data Warehouse.

- Gli utenti utilizzeranno Oracle Analytics Cloud per visualizzare i dati e fare previsioni.

oci-modern-data-reporting-flow-oracle.zip

Nota

Il flusso di dati scelto è un esempio semplicistico, i casi d'uso aziendali effettivi possono essere considerati più coinvolti.La sezione seguente descrive come caricare dati di esempio, configurare OCI Object Storage, Oracle Big Data Service e richiamare un semplice job Spark scala per trasformare i dati e spostare i dati in Autonomous Data Warehouse