ビジネス・レポートおよび予測のためのOracle Modern Data Platformの実装

This section describes how to provision OCI services, implement the use case, visualize data, and create forecasts.

Oracle Modern Data Platformのユースケースの実装

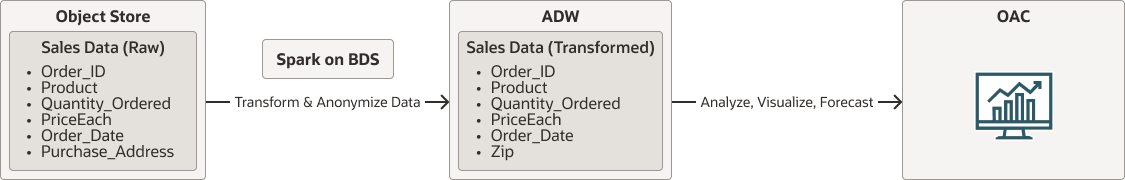

実装の詳細に進む前に、全体的なフローを見てみましょう。

- RAWデータはOCI Object Storageに存在します。

- Oracle Big Data Serviceでネイティブに実行されているSparkは、OCI Object Storageからデータを読み取ります。データをクレンジング、変換および匿名化し、最後にデータをAutonomous Data Warehouseに保持します。

- ユーザーは、Oracle Analytics Cloudを使用してデータを視覚化し、予測を行います。

oci-modern-data-reporting-flow-oracle.zip

ノート:

選択したデータ・フローは単純な例であり、実際のビジネス・ユース・ケースはより関与することが予想されます。次の項では、サンプル・データのアップロード方法、OCI Object Storage、Oracle Big Data Serviceの構成方法、およびデータを変換してAutonomous Data Warehouseにデータを移動する単純なSpark scalaジョブの起動方法について説明します

データ変換ジョブが終了したら、Autonomous Data Warehouseでデータを表示できることを確認します。