Oracle Cloud Marketplace에서 HPC 클러스터 스택 구성

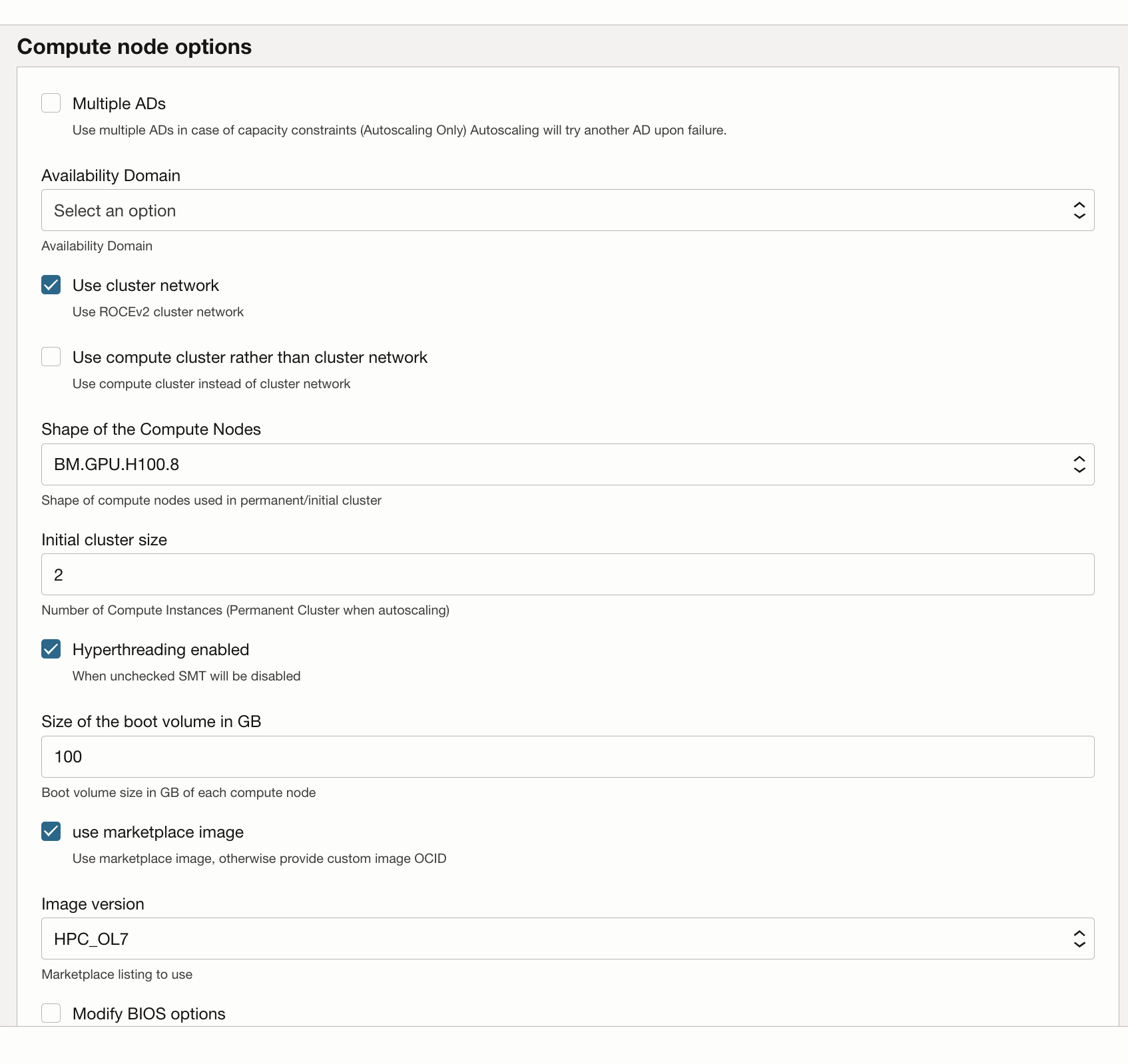

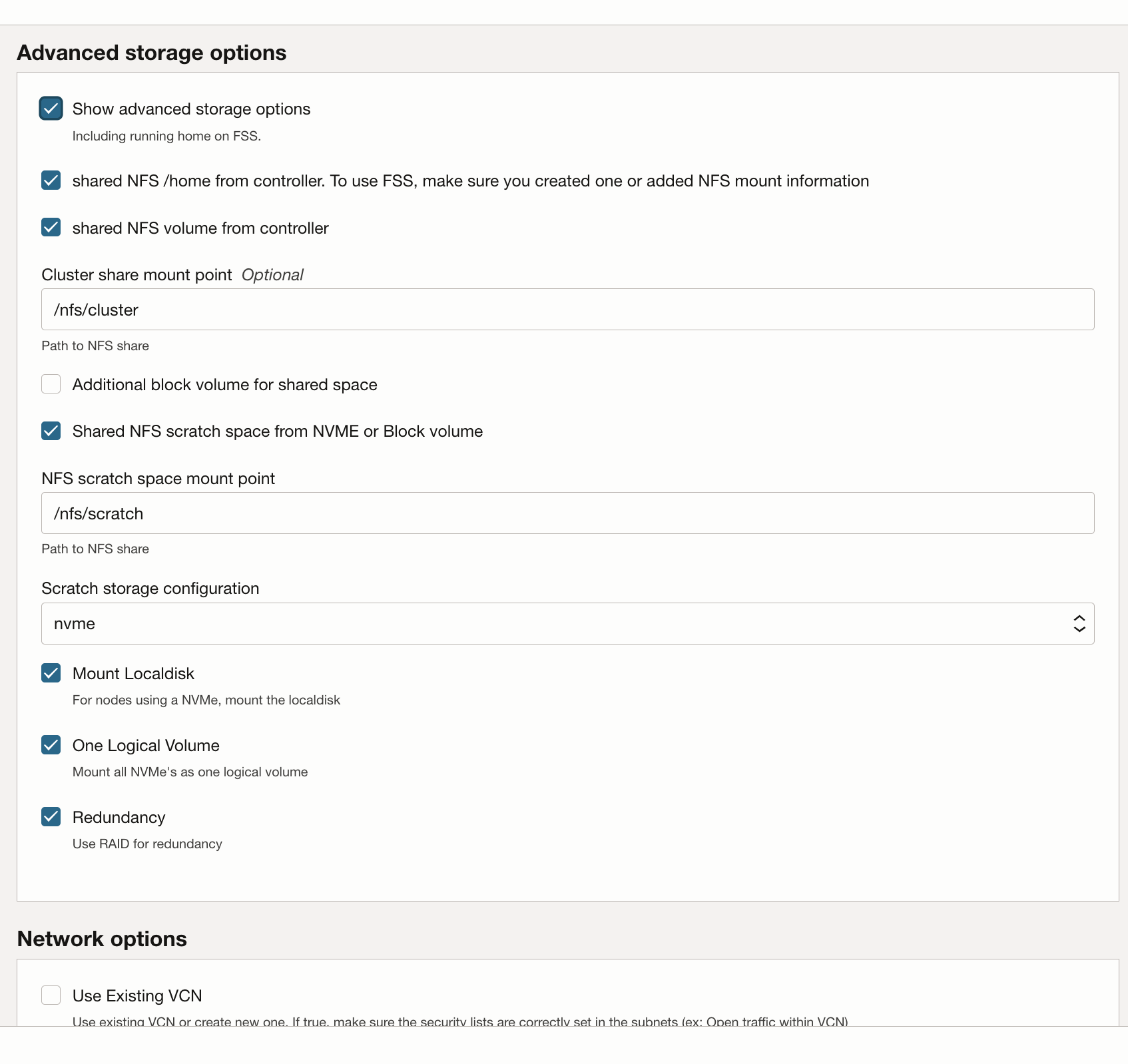

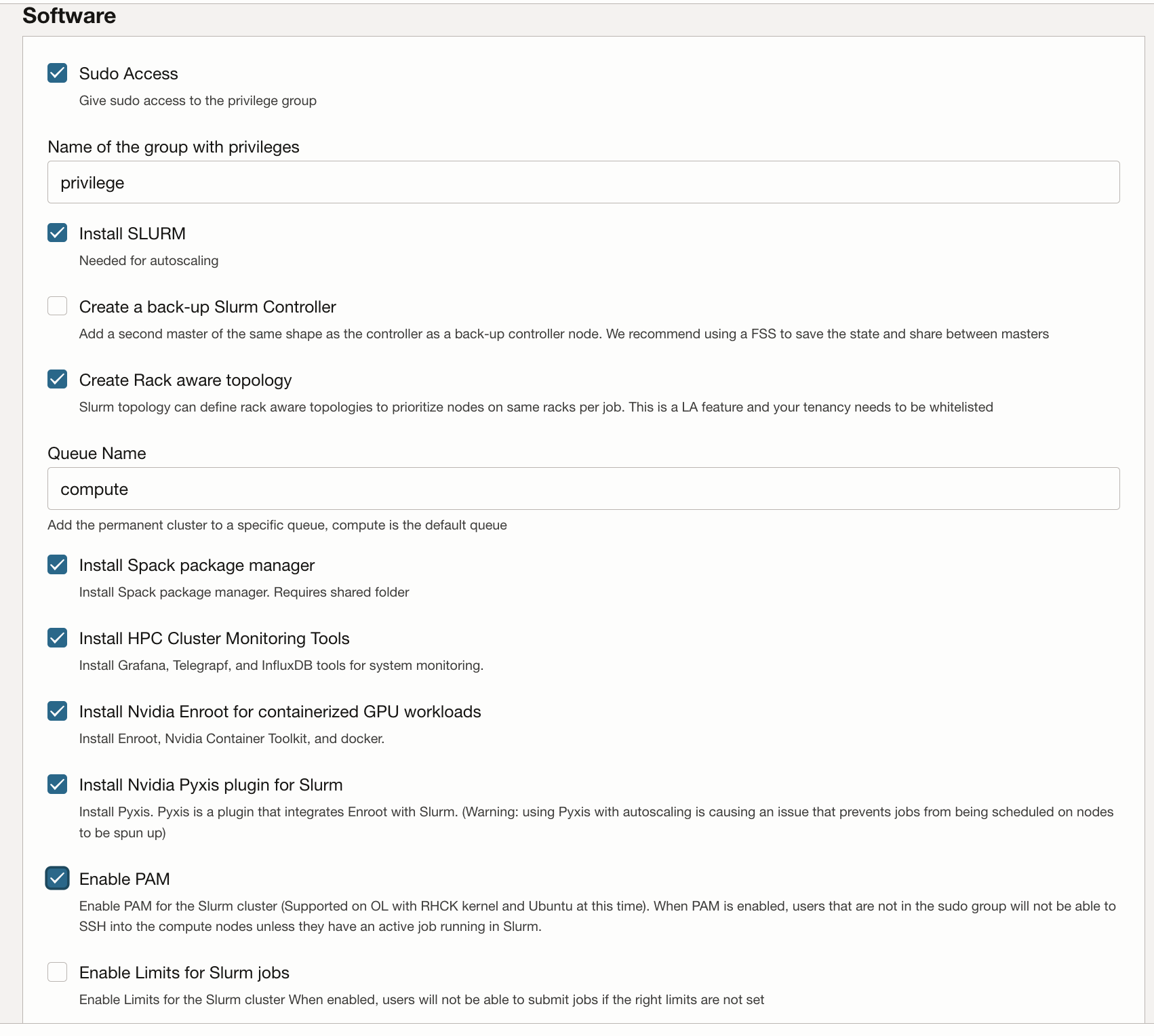

HPC 클러스터 스택은 Terraform을 사용하여 Oracle Cloud Infrastructure 리소스를 배치합니다. 이 스택은 GPU 노드, 스토리지, 표준 네트워킹 및 고성능 클러스터 네트워킹, 클러스터 액세스 및 관리를 위한 배스천/헤드 노드를 생성합니다.

GPU 클러스터 배치

Oracle Cloud 계정은 이러한 리소스를 배치 및 관리할 수 있는 권한이 있는 그룹에 속해야 합니다. 정책 요구 사항에 대한 자세한 내용은 HPC 클러스터 사용 지침을 참조하십시오.

기존 구획에 스택을 배치할 수 있지만 클러스터 전용 구획을 생성하는 경우 더 클린할 수 있습니다.

주:

Marketplace 스택을 사용하여 환경을 프로비저닝하는 데는 비용이 들지 않지만 스택이 시작될 때 프로비저닝된 리소스에 대해 비용이 청구됩니다.- 테넌시 및 지역에 대한 구획을 생성하고 정책을 사용할 수 있는지 확인합니다.

- HPC 클러스터 스택을 사용하여 GPU 클러스터를 배치합니다.