비즈니스 보고 및 예측을 위한 Oracle Modern Data Platform 구현

이 섹션에서는 OCI 서비스 프로비저닝, 사용 사례 구현, 데이터 시각화, 예측 생성 방법을 설명합니다.

Oracle Modern Data Platform 사용 사례 구현

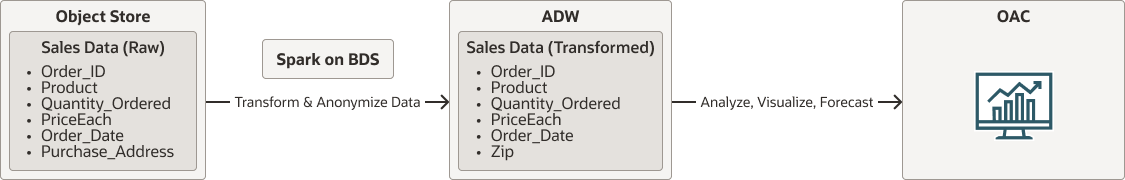

구현 세부정보를 살펴보기 전에 전체 플로우를 살펴보겠습니다.

- 원시 데이터는 OCI Object Storage에 상주합니다.

- Oracle Big Data Service에서 기본적으로 실행되는 Spark는 OCI Object Storage에서 데이터를 읽습니다. 데이터를 정리, 변환 및 익명화하고 마지막으로 데이터를 Autonomous Data Warehouse로 유지합니다.

- 사용자는 Oracle Analytics Cloud를 활용하여 데이터를 시각화하고 예측을 수행합니다.

oci-modern-data-reporting-flow-oracle.zip

주:

선택한 데이터 흐름은 단순한 예입니다. 실제 비즈니스 사용 사례는 더 많이 관련될 수 있습니다.다음 섹션에서는 샘플 데이터를 업로드하고, OCI Object Storage, Oracle Big Data Service를 구성하고, 간단한 Spark scala 작업을 호출하여 데이터를 변환하고, 데이터를 Autonomous Data Warehouse로 이동하는 방법에 대해 설명합니다.

데이터 변환 작업이 완료되면 Autonomous Data Warehouse에서 데이터를 볼 수 있는지 확인합니다.