Padrões Recomendados para Data Lakes Baseados na Nuvem

Dependendo do seu caso de uso, os data lakes podem ser criados no Object Storage ou no Hadoop. Ambas podem ser dimensionadas e integradas perfeitamente com ferramentas e dados corporativos existentes. Considere os padrões Greenfield ou Migration da sua organização. Escolha o padrão Greenfield ou Migração com base no planejamento de uma implementação completamente nova ou queira migrar sua solução de Big Data existente para o Oracle Cloud.

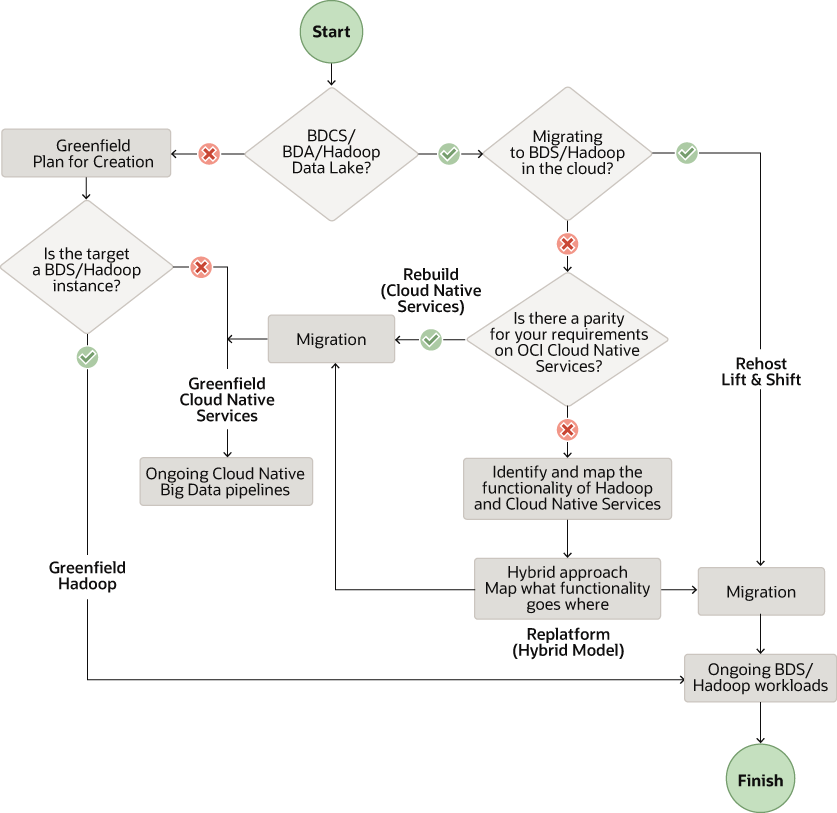

O workflow a seguir mostra os padrões recomendados com base nas suas necessidades.

Descrição da ilustração data-lake-solution-pattern.png

Observação:

Neste documento, focamos na migração de clusters do Big Data Appliance (BDA) e do Big Data Cloud Services (BDCS) para o OCI com base na distribuição Cloudera do Hadoop (CDH). No entanto, as recomendações aqui são aplicáveis a outras distribuições locais e na nuvem do Hadoop.

Crie uma Nova Plataforma de Dados no Oracle Cloud (Greenfield)

Você tem duas opções para criar data lakes no Oracle Cloud para projetos Greenfield. Use o Big Data Service (BDS) para data lakes baseados em HDFS. Use serviços de dados nativos da nuvem do OCI para data lakes baseados em Armazenamento de Objetos sem usar HDFS.

Serviços de dados nativos de nuvem

Crie um data lake no OCI Object Storage e use serviços de IA e Dados Nativos da Nuvem. Esses serviços incluem o serviço Data Flow, Data Integration, Autonomous Data Warehouse, Data Catalog e Data Science junto com alguns outros.

A Oracle recomenda esses serviços para criar um novo data lake:

- Armazenamento de Objetos como o armazenamento do data lake para todos os tipos de dados brutos

- Serviço Data Flow para processos em lote do Spark e para clusters Spark efêmeros

- Serviço Data Integration para ingestão de dados e para jobs ETL

- Autonomous Data Warehouse (ADW) para atender e apresentar dados de camada

- Data Catalog para detecção e governança de dados

A Oracle recomenda esses serviços adicionais para criar um novo data lake:

- Serviço de streaming para uma ingestão gerenciada de dados em tempo real

- Serviço Data Transfer Appliance (DTA) para transferência única de dados em massa

- Serviço GoldenGate para dados do Change Data Capture (CDC) e para análise de streaming

- Serviço Data Science para requisitos de aprendizagem de máquina

- Serviço Oracle Analytics Cloud (OAC) para BI, análise avançada e requisitos de geração de relatórios

Big Data Service

Crie seu data lake no HDFS usando o Oracle Big Data Service (BDS). O BDS fornece os componentes Hadoop mais usados, incluindo HDFS, Hive, HBase, Spark e Oozie.

A Oracle recomenda esses serviços para criar um novo data lake usando clusters Hadoop:

- Serviço Data Integration para ingestão de dados e para jobs ETL

- Serviço Data Transfer Appliance (DTA) para transferência única de dados em massa

- Serviço GoldenGate para dados CDC e para análise de fluxo

- Serviço Data Catalog para detecção e governança de dados

- Serviço Data Science para requisitos de aprendizagem de máquina

- Serviço OAC para requisitos de BI, análise e geração de relatórios

- BDS para HDFS e outros componentes do Hadoop

Workflow do Padrão de Greenfield

Ao criar um novo data lake, siga este workflow com base nos requisitos de teste e validação:

- Requisitos: Lista os requisitos para novos ambientes no OCI

- Avaliação: Avalie os serviços e as ferramentas necessários do OCI

- Design: Projete sua arquitetura de solução e dimensione para OCI

- Plano: crie um mapeamento de plano detalhado de horário e recursos

- Provisionamento: Provisione e configure os recursos necessários no OCI

- Implementação: Implemente suas cargas de trabalho de dados e aplicativos

- Automação de Pipeline: Orquestre e programe pipelines de fluxo de trabalho para automação

- Teste e Valide: Execute testes de validação, funcionais e de desempenho para a solução completa

Migre a Plataforma de Dados Existente no Oracle Cloud

Recriar Padrão

Use o padrão Recriar se não quiser usar clusters do Hadoop e quiser migrar para serviços nativos da nuvem no Oracle Cloud Infrastructure (OCI). Comece com uma apresentação organizada para arquitetar e comece a implementar do zero no OCI. Aproveite os serviços nativos em nuvem e gerenciados para todos os principais componentes da sua pilha. Por exemplo, crie uma pilha usando o serviço Data Flow, Data Catalog, Data Integration, Streaming, Data Science, ADW e OAC.

A Oracle recomenda que esses serviços migrem para um data lake baseado em nuvem sem clusters do Hadoop:

- Serviço Object Storage como o armazenamento do data lake para todos os tipos de dados brutos

Observação:

Você pode usar o Object Storage com um conector HDFS como o armazenamento HDFS no lugar do HDFS no cluster do Hadoop ou do Spark. - Serviço Data Integration para ingestão de dados e para jobs ETL

- Serviço de streaming para ingestão gerenciada de dados em tempo real, que pode substituir seus serviços de Kafka ou Flume autogerenciados

- Data Transfer Appliance para transferência de dados em massa única

- GoldenGate para dados CDC e para análise de fluxo

- Serviço Data Flow para processos em lote do Spark e para clusters Spark efêmeros

- ADW para dados de camada de atendimento e apresentação

- Serviço Data Catalog para detecção e governança de dados

- Serviço Data Science para requisitos de Aprendizado de Máquina

- Serviço OAC para requisitos de BI, análise e geração de relatórios

Padrão de plataforma de substituição

Use o padrão de migração de Plataforma se quiser usar clusters do Hadoop na nuvem e substituir alguns dos componentes por serviços nativos da nuvem. Use o Big Data Service para HDFS e outros componentes do Hadoop e redesigne parte da sua pilha usando nossos serviços nativos da nuvem gerenciados adicionais.

Talvez você precise redesenhar sua pilha para usar o padrão de Plataforma.

- Inclua serviços nativos da nuvem sem servidor junto com o BDS no OCI

- Aproveite os serviços nativos em nuvem gerenciados, onde possível

É possível substituir alguns desses componentes com base em suas necessidades.

- BDS para HDFS e outros componentes do Hadoop, como Hive, HBase, Kafka e Oozie

- Serviço Data Integration para ingestão de dados e para jobs ETL

- Serviço Data Transfer Appliance para transferência única de dados em massa

- Serviço GoldenGate para dados CDC e para análise de fluxo

- Serviço Data Catalog para detecção e governança de dados

- Serviço Data Science para requisitos de Aprendizado de Máquina

- Serviço OAC para requisitos de BI, análise e geração de relatórios

Padrão Rehost

Migre seu BDA, BDCS e outros clusters Hadoop para criar seu data lake em HDFS usando o Big Data Service (BDS). Você pode usar uma abordagem de elevação e deslocamento ao usar o padrão Rehost. Todos os componentes do Hadoop comumente usados, incluindo HDFS, Hive, HBase, Spark e Oozie, estão disponíveis nos clusters gerenciados do Hadoop fornecidos pelo BDS.

Workflow do Padrão de Migração

Ao migrar seu data lake para o Oracle Cloud, siga este workflow dos requisitos até o novo ambiente.

- Descoberta e requisitos: Descubra e cataloge o sistema atual para listar os requisitos do novo ambiente OCI

- Avaliação: Avalie os serviços e as ferramentas necessários do OCI

- Design: Projete sua arquitetura de solução e dimensione para OCI

- Plano: crie um mapeamento de plano detalhado de horário e recursos

- Provisionamento: Provisione e configure os recursos necessários no OCI

- Migrar Dados: Transfira os dados e os metadados para o armazenamento de dados dos serviços OCI selecionados

- Migrar carga de trabalho: Migre suas cargas de trabalho e aplicativos para serviços OCI usando o padrão de migração selecionado

- Automação de Pipeline: Orquestre e programe pipelines de fluxo de trabalho para automação

- Teste e Valide: planeje testes e validações funcionais e de desempenho para o ambiente OCI final

- Reduzir: Desative o ambiente de origem e resulte em usar apenas o novo ambiente com base no OCI