Configurar a Pilha de Clusters de HPC no Oracle Cloud Marketplace

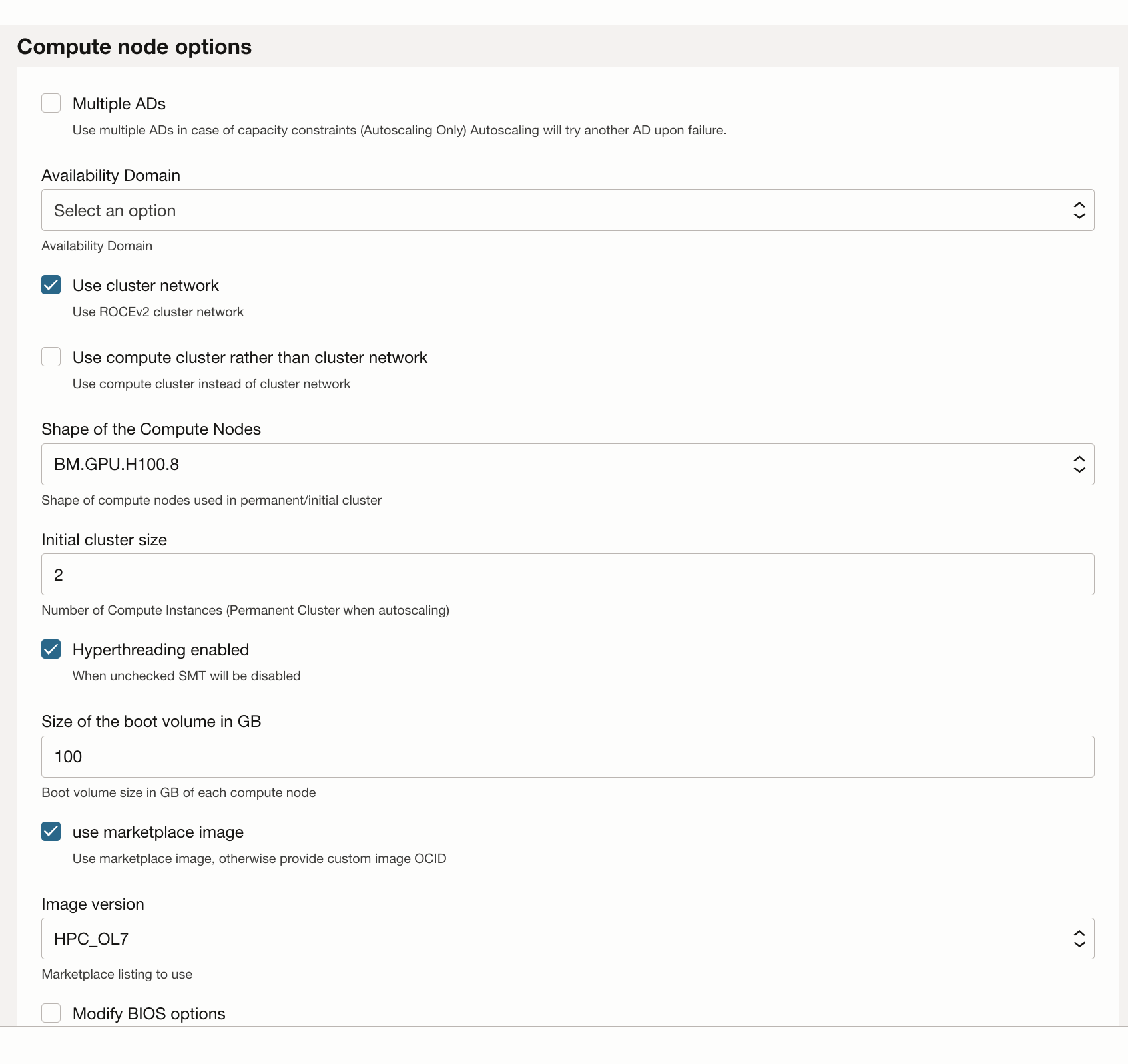

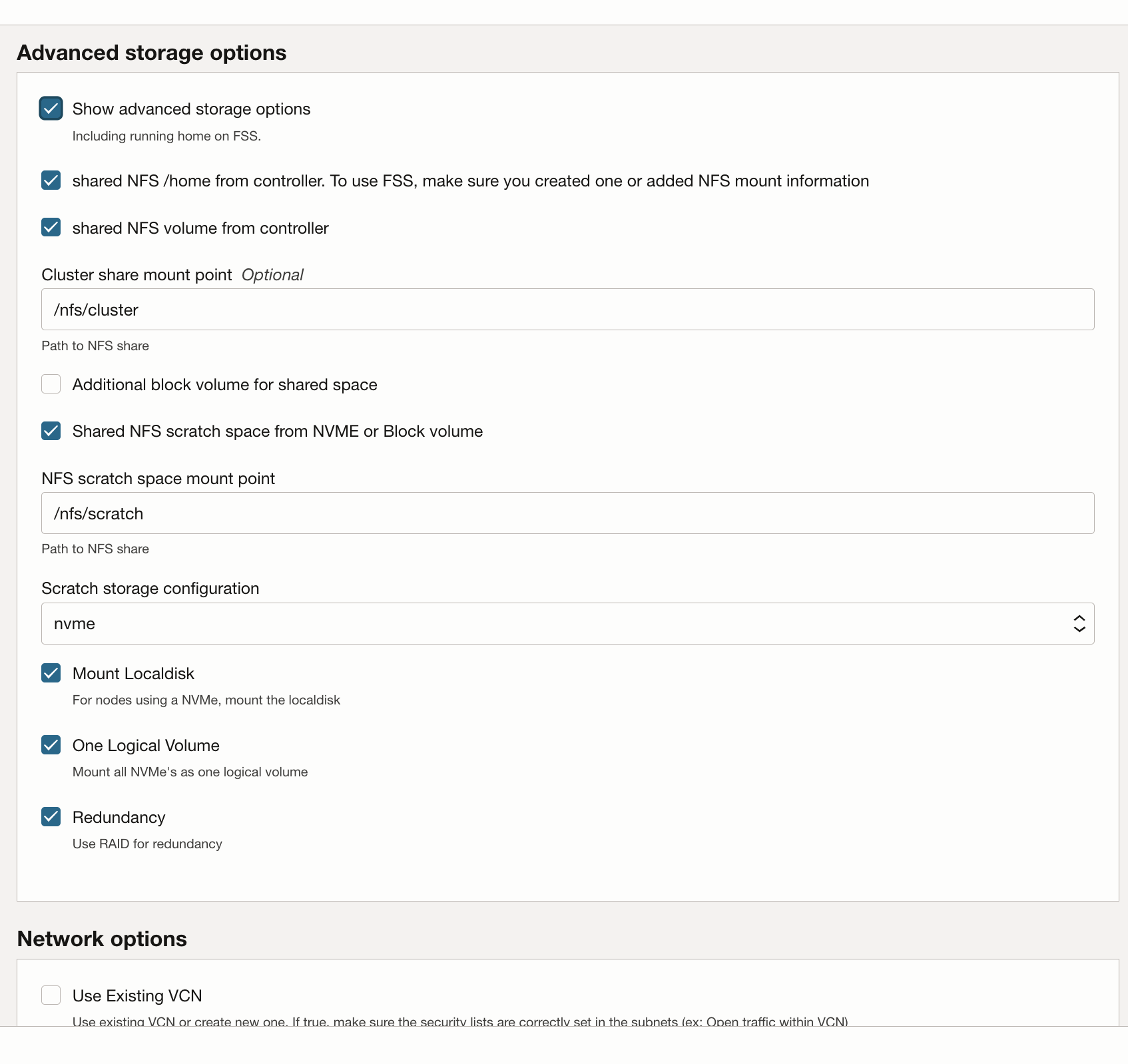

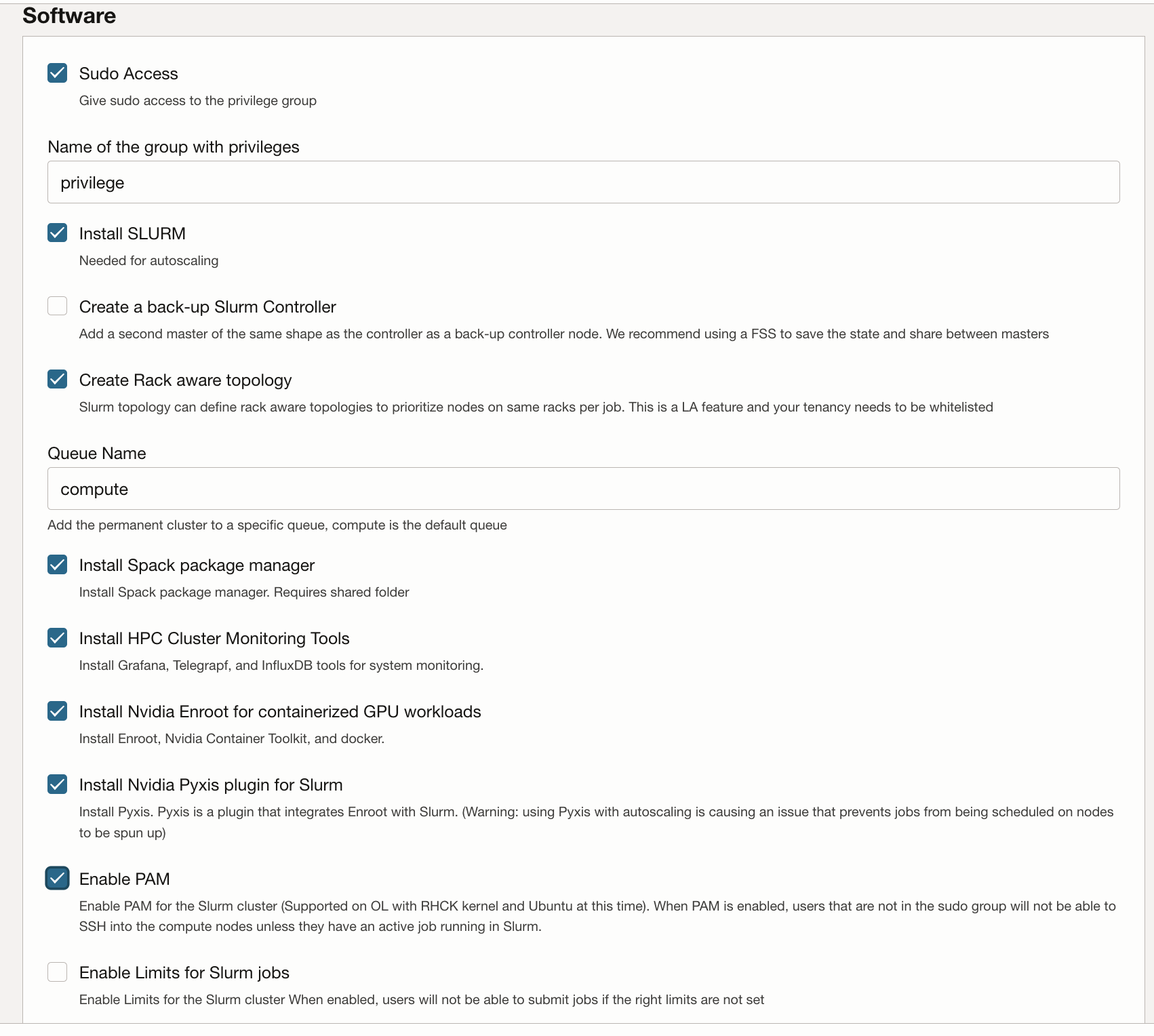

A pilha do Cluster de HPC usa o Terraform para implantar recursos do Oracle Cloud Infrastructure. A pilha criará nós de GPU, armazenamento, rede padrão e rede de cluster de alto desempenho e um nó bastion/head para acesso e gerenciamento do cluster.

Implantar o Cluster de GPU

Sua conta do Oracle Cloud deve estar em um grupo com permissão para implantar e gerenciar esses recursos. Consulte Instruções de Uso do Cluster de HPC para obter mais detalhes sobre requisitos de política.

Você pode implantar a pilha em um compartimento existente, mas poderá ficar mais limpo se criar um compartimento especificamente para o cluster.

Observação:

Embora não haja custo para usar a pilha do Marketplace para provisionar um ambiente, você será cobrado pelos recursos provisionados quando a pilha for iniciada.- Crie um compartimento para sua tenancy e região e verifique se as políticas estão disponíveis.

- Use a pilha do Cluster de HPC para implantar o cluster de GPU.