Implemente o Oracle Modern Data Platform para Relatórios e Previsão de Negócios

Esta seção descreve como provisionar serviços do OCI, implementar o caso de uso, visualizar dados e criar previsões.

Provisionar Serviços do OCI

Vamos analisar as principais etapas para provisionar recursos para uma demonstração simples desse caso de uso.

Implemente o Caso de Uso do Oracle Modern Data Platform

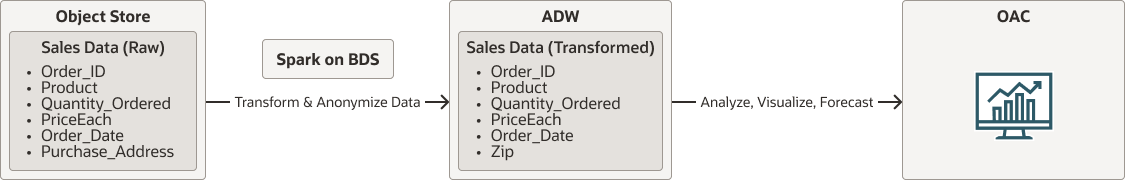

Antes de entrar nos detalhes da implementação, vejamos o fluxo geral.

- Os dados brutos residirão no OCI Object Storage.

- O Spark executado nativamente no Oracle Big Data Service lerá dados do OCI Object Storage. Ele limpará, transformará e anonimizará dados e, finalmente, persistirá dados no Autonomous Data Warehouse.

- Os usuários utilizarão o Oracle Analytics Cloud para visualizar dados e fazer previsões.

oci-modern-data-reporting-flow-oracle.zip

Observação:

O fluxo de dados escolhido é um exemplo simplista. É esperado que os casos de uso de negócios reais sejam mais envolvidos.A seção a seguir descreve como fazer upload de dados de amostra, configurar o OCI Object Storage, o Oracle Big Data Service e chamar um job de escala simples do Spark para transformar dados e mover dados para o Autonomous Data Warehouse

Quando o job de transformação de dados terminar, confirme se você pode ver os dados no Autonomous Data Warehouse.