从 Oracle Cloud Marketplace 配置 HPC 集群堆栈

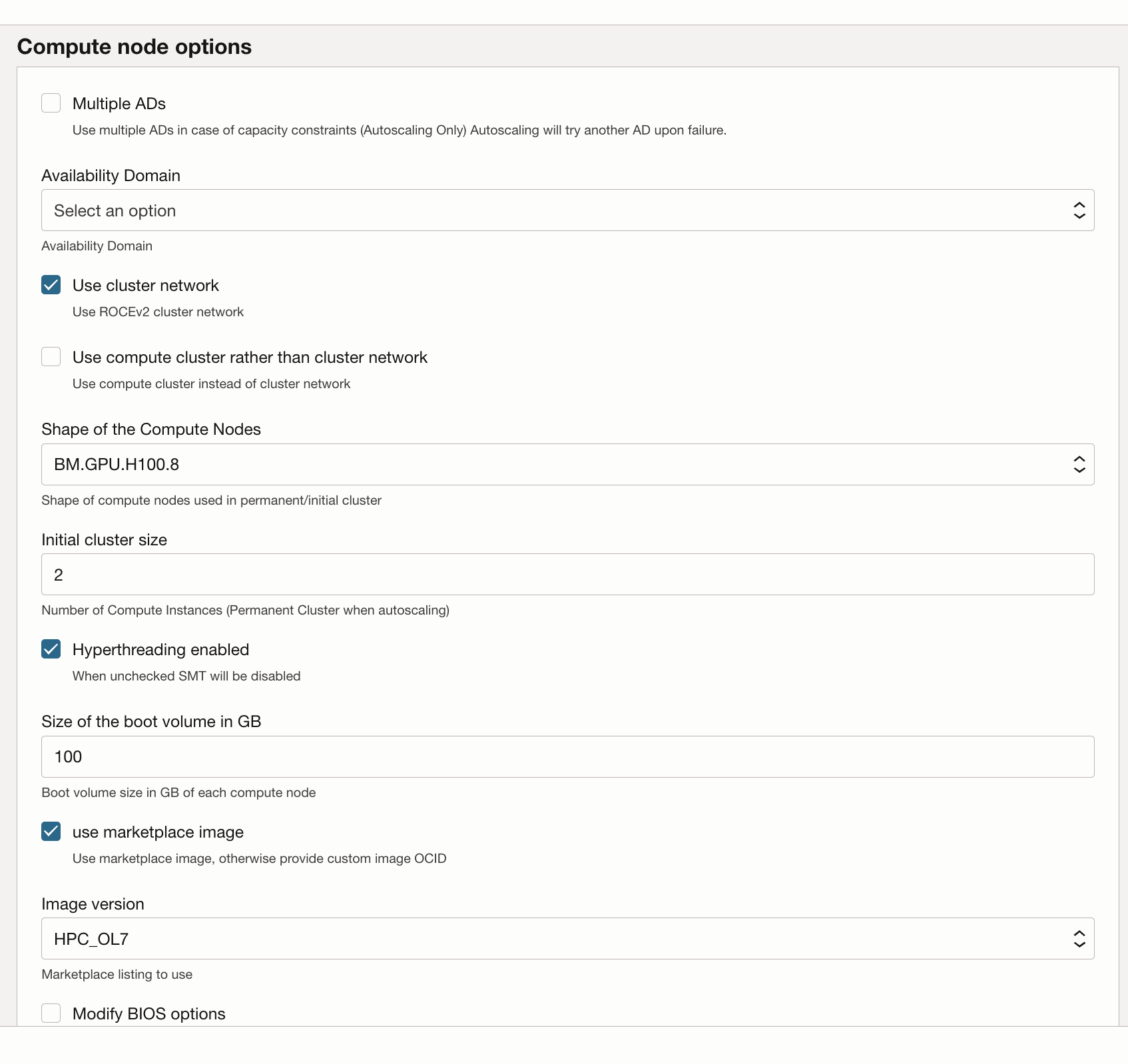

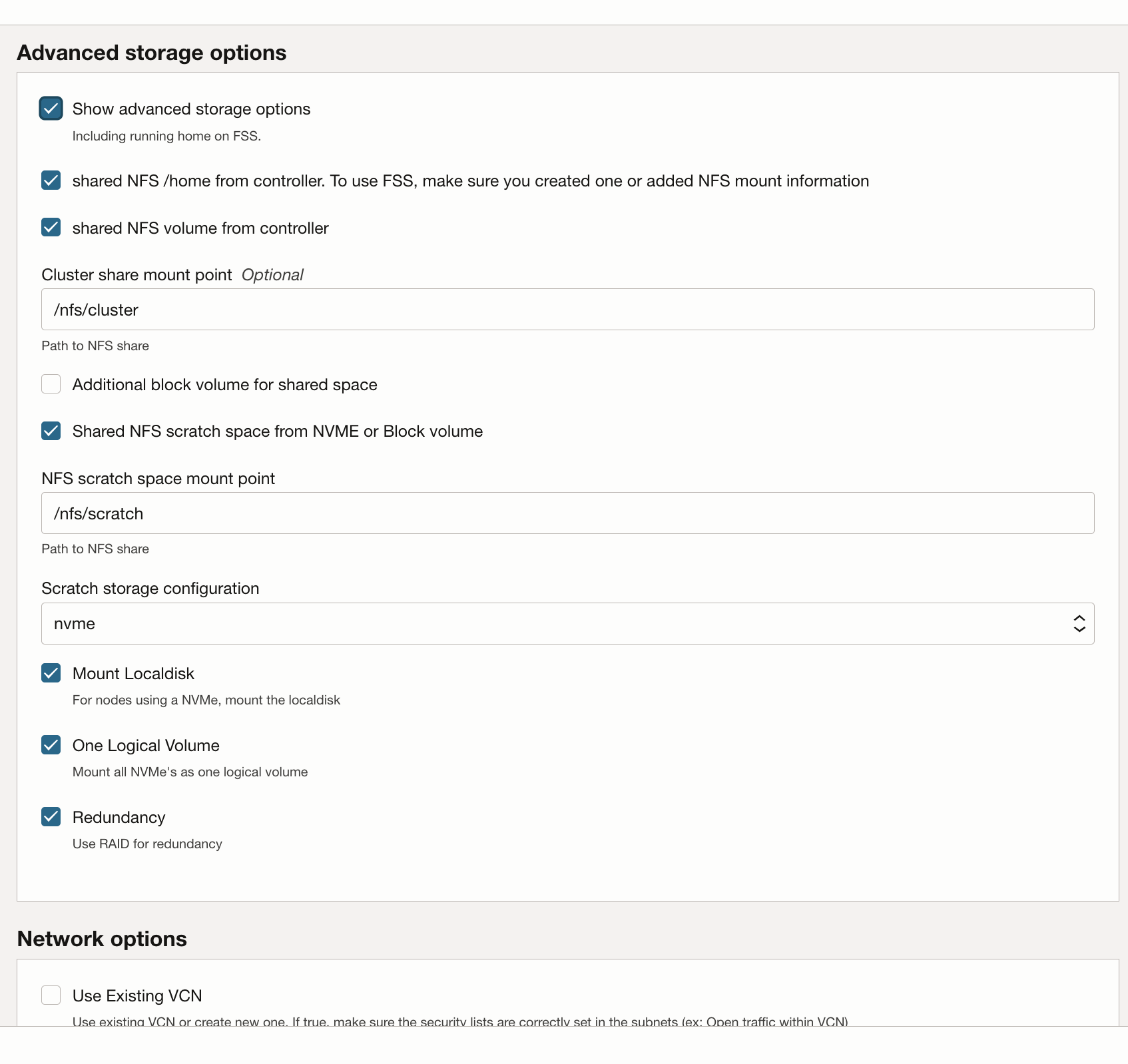

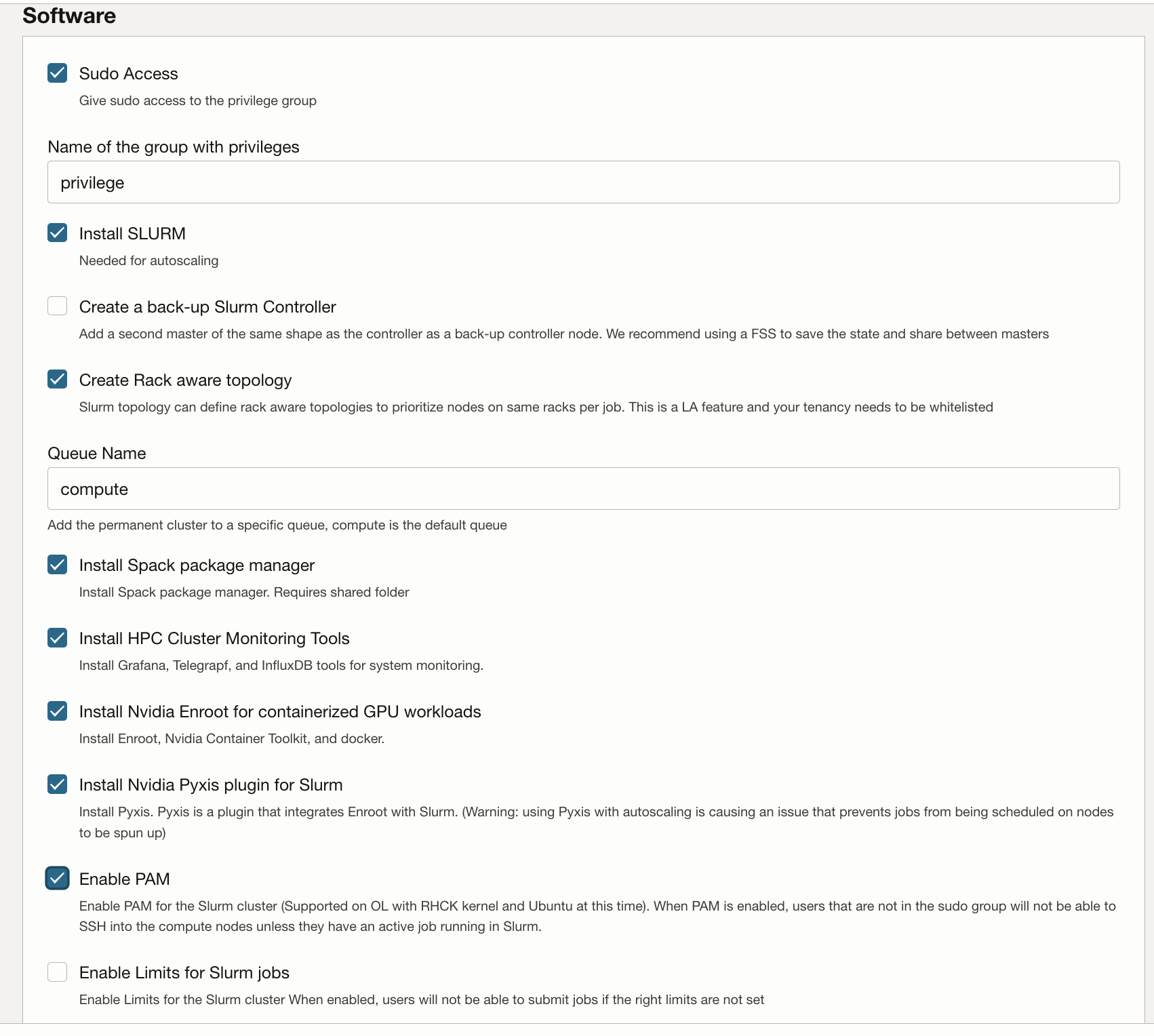

HPC 集群堆栈使用 Terraform 部署 Oracle Cloud Infrastructure 资源。该堆栈将创建 GPU 节点、存储、标准网络和高性能集群网络,以及用于访问和管理集群的堡垒/头节点。

部署 GPU 集群

您的 Oracle Cloud 账户必须位于有权部署和管理这些资源的组中。有关策略要求的更多详细信息,请参见 HPC 集群使用说明。

您可以将堆栈部署到现有区间,但如果您专门为集群创建区间,则堆栈可能会更干净。

注意:

虽然使用市场堆栈预配环境没有成本,但启动堆栈时预配的资源将向您收费。- 为您的租户和区域创建区间并验证策略是否可用。

- 使用 HPC 集群堆栈部署 GPU 集群。