部署蓝图

请确保您有权访问 OCI 租户,并且您具有管理权限来提供足够的 CPU/GPU 实例。

- 使用下面的 Terraform 模块安装 OKE 集群。将使用 6 个 worker 节点创建具有单个节点池的 OKE 集群。

- 单击下面的部署到 Oracle Cloud 。

- 为堆栈提供一个 name (例如 oke-stack )。

- 选择部署 OCI AI 蓝图的区间。

- 根据您的首选项提供任何其他参数(例如节点大小、节点计数)。

- 依次单击下一步和创建,最后单击运行应用以预配集群。

- 登录 Oracle Cloud Infrastructure 控制台,在主页中单击存储,然后在对象存储下单击存储桶。提供将用于 OCI AI 蓝图部署的存储桶名称。

单击您创建的存储桶,然后单击资源下的预先验证的请求 (PAR) 链接。为 PAR 指定名称,将访问类型更改为允许对象读取和写入,然后单击预先验证的请求。完成后,复制 PAR URL 并将其保存到某个位置,因为在部署 CPU 推断蓝图时需要该 URL。

- 在新的 OKE 集群中安装 OCI AI 蓝图。成功部署后,您将拥有用于访问 OCI AI Blueprints 控制台的 URL。

- 在 OCI AI Blueprints 主页上, Blueprint Binary 下提供了多个可供部署的蓝图,请向下滚动并单击 CPU Inference 下的 Deploy(部署)。

- 选择 CPU Inference with mistral 和 VM-Standard.E4。Flex 选项。

使用默认参数并更改上面创建的预先验证身份的请求 URL。请勿更改配置参数部分中的任何值。

请注意参数:

"recipe_container_env": [ { "key": "MODEL_NAME", "value": "mistral" }, { "key": "PROMPT", "value": "What is the capital of Spain?" }成功部署 CPU 推断蓝图后,上述提示的输出将显示在 Kubernetes 云池日志中。

- 单击部署蓝图。成功部署蓝图后,您会看到一个名称,例如 cpu inference 雾值 E4Flex ,其中列出了监视部署状态以及创建日期、节点数和 E4 配置。

- 在部署列表中,单击 cpu 推断误差 E4Flex 链接,这将使用公共端点转到部署详细信息。单击公共端点,您将看到一条消息,例如 "ollama is running"。

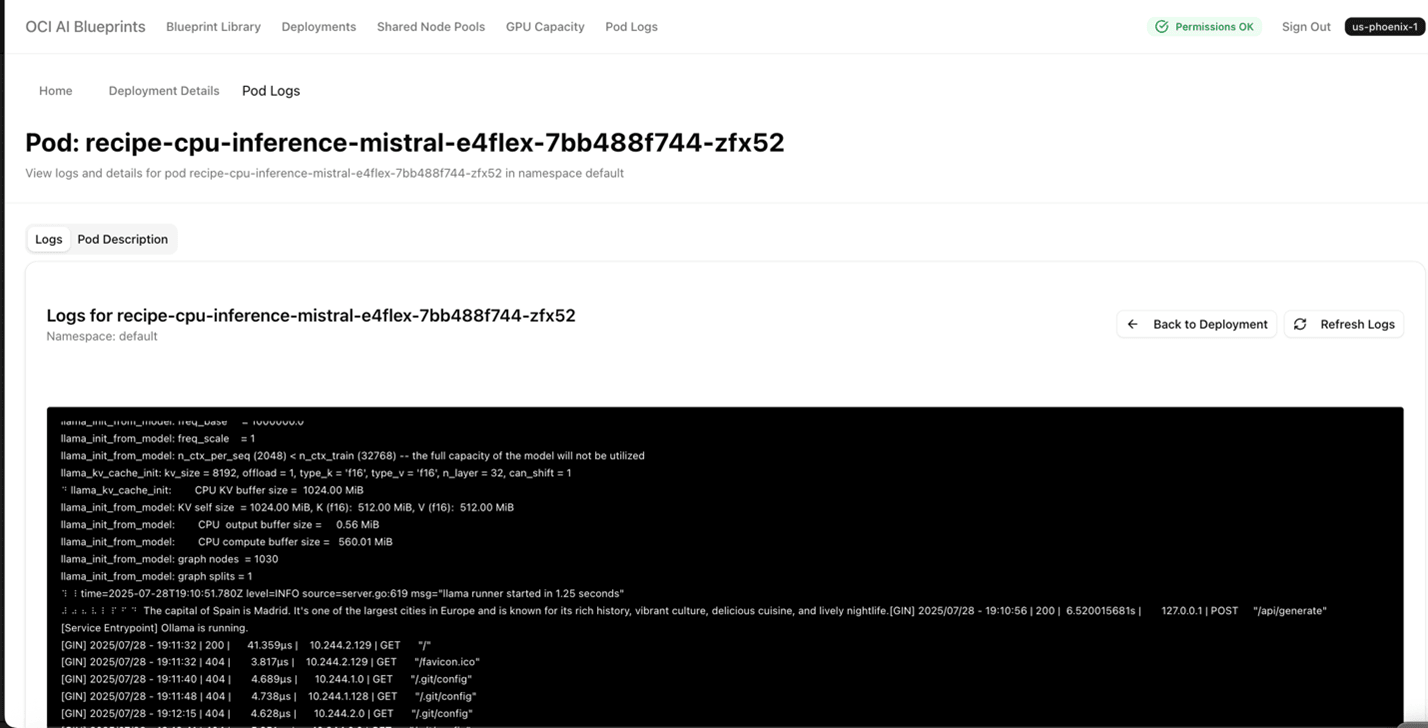

- 返回到 cpu 推断误差 E4Flex 页面,并向下滚动到 Pod logs 。单击查看和日志详细信息。将显示一个类似于以下内容的页面,用于提供输出。

- 选择 CPU Inference with mistral 和 VM-Standard.E4。Flex 选项。