实施 Oracle Modern Data Platform for Business Reporting and Forecasting

本节介绍如何供应 OCI 服务、实施用例、可视化数据以及创建预测。

实施 Oracle Modern Data Platform 用例

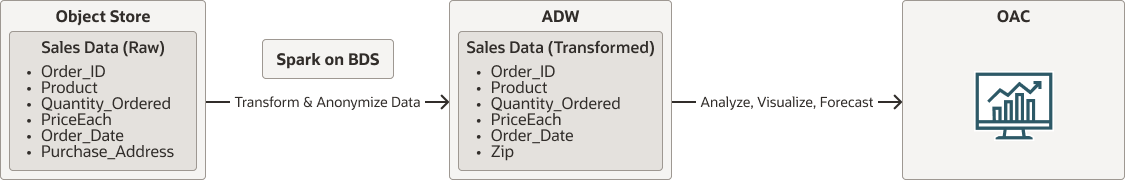

在介绍实施细节之前,让我们看看整体流程。

- 原始数据将驻留在 OCI 对象存储中。

- 在 Oracle Big Data Service 上原生运行的 Spark 将从 OCI 对象存储读取数据。它将清理、转换和匿名化数据,最终将数据保留到 Autonomous Data Warehouse 。

- 用户将利用 Oracle Analytics Cloud 来可视化数据和进行预测。

oci-modern-data-reporting-flow-oracle.zip

注意:

所选的数据流是一个简单的例子,实际的业务用例可能会更多地涉及。以下部分介绍了如何上载示例数据、配置 OCI Object Storage 、Oracle Big Data Service 以及调用简单的 Spark scala 作业来转换数据以及将数据移动到 Autonomous Data Warehouse

数据转换作业完成后,确认可以在 Autonomous Data Warehouse 中查看数据。