2 Big Data Spatial and Graphおよび空間データの使用

この章では、ビッグ・データ環境での空間データのロード、格納、アクセス、および使用に関する概念と使用状況の情報について説明します。

- 空間データに対するBig Data Spatial and Graphのサポートについて

Oracle Big Data Spatial and Graphの機能では、位置情報に基づく意思決定のために、空間データを迅速かつ効率的に格納、アクセス、および分析できます。 - Oracle Big Dataベクトル・データおよびラスター・データの処理

Oracle Big Data Spatial and Graphでは、ベクトルおよびラスター空間データの両方の保管と処理をサポートしています。 - ラスター・データ処理のためのOracle Big Data Spatial Hadoop Image Processing Framework

Oracle Spatial Hadoop Image Processing Frameworkを使用すると、一連の並列処理フェーズの結果として生成される新しい結合イメージの作成が可能になります。 - Image Loaderを使用したHadoopへのイメージのロード

Oracle Spatial and Graph Hadoop Image Processing Frameworkを使用してイメージを処理するには、最初にイメージを実際にHDFSに保存し、次に各イメージをそれぞれ別のスマート・タイルに保存します。 - Oracle Spatial Hadoop Image Processorを使用したイメージの処理

イメージはHDFSにロードされると、Oracle Spatial Hadoop Image Processing Frameworkによって並列で処理できます。 - Oracle Spatial Hadoop Raster Processing APIを使用したイメージのロードおよび処理

このフレームワークでは、XMLを作成せずに、Javaアプリケーションを使用してラスターをロードし、処理するラスター処理APIが用意されています。このアプリケーションはクラスタ内またはリモート・ノード上で実行できます。 - Oracle Spatial Hadoop Raster Simulator Frameworkを使用したラスター処理のテスト

カスタム処理クラスを作成する場合、Oracle Spatial Hadoop Raster Simulator Frameworkを使用して、これらをOracle Raster Processing Frameworkにプラグインすることを偽装することにより、次を実行できます。 - Oracle Big Data Spatial Raster Processing for Spark

Oracle Big Data Spatial Raster Processing for Apache Sparkは、Spatial Raster Processing API for Javaです。 - Oracle Big Data Spatial Vector Analysis

Oracle Big Data Spatial Vector AnalysisはSpatial Vector Analysis APIであり、Hadoopジョブとして実行され、HDFSに格納されているデータの空間処理のためのMapReduceコンポーネントを提供します。 - Oracle Big Data Spatial Vector Analysis for Spark

Oracle Big Data Spatial Vector Analysis for Apache Sparkは、空間の変換およびアクション、空間のパーティショニングおよび索引付けをサポートしている空間対応のRDD (Resilient Distributed Datasets)が用意されたSpatial Vector Analysis API for Java and Scalaです。 - Oracle Big Data Spatial Vector Hive Analysis

Oracle Big Data Spatial Vector Hive Analysisには、Hiveを使用してデータを分析するために空間関数が用意されています。 - Oracle Big Data SpatialViewer Webアプリケーションの使用

Oracle Big Data SpatialViewer Webアプリケーション(SpatialViewer)を使用すると、様々なタスクを実行できます。

2.1 空間データに対するBig Data Spatial and Graphのサポートについて

Oracle Big Data Spatial and Graphの機能では、位置情報に基づく意思決定のために、空間データを迅速かつ効率的に格納、アクセス、および分析できます。

空間データは、実際の空間または地理情報システム(GIS)やその他の位置情報アプリケーション上の概念的な空間に関連する実際、または概念的なオブジェクトの位置特性を表します。

空間機能を使用して、特定の位置の2次元および3次元の地理イメージに対して位置情報を付加、補完、視覚化、変換、ロード、処理を行い、GIS機能におけるジオメトリ形状を操作します。

2.1.1 Big Data Spatial and Graph on Apache Hadoopとは

Oracle Big Data Spatial and Graph on Apache Hadoopとは、MapReduceプログラムとHadoopクラスタの分析機能を使用して空間データを格納し、データにアクセスし、分析するフレームワークです。空間機能によってスキーマが提供され、空間データ・コレクションの格納、取得、更新、および問合せが容易になります。Big Data Spatial and Graph on Hadoopでは、ジオメトリ形状、ラスターまたはベクトル・イメージのいずれかの空間イメージの格納と処理をサポートしており、サポート対象の数百種類の形式のいずれかで保存されます。

注意:

空間のコンセプト、データ、および操作の概要は、『Oracle Spatial and Graph開発者ガイド』を参照してください

2.1.2 Oracle Big Data Spatial and Graphの利点

Oracle Big Data Spatial and Graphの使用には、次の利点があります。

-

一部のGISを中心とした空間処理システムやエンジンとは異なり、Oracle Big Data Spatial and Graphでは、空間情報が構造化されていても、構造化されていなくても処理が可能です。

-

顧客の環境で保存するデータ形式が1つに限定されることはありません。空間データと空間以外のビジネスデータの両方が保存されていても、Oracle Big Dataで空間処理を実行できます。

-

これはフレームワークであるため、顧客は提供されているAPIを使用して、アプリケーションや操作をカスタムで作成できます。

-

Oracle Big Data Spatialでは、ベクトル・タイプとラスター・タイプの両方の情報やイメージを処理できます。

2.1.3 Oracle Big Data Spatialの機能

空間データはSpatialサーバーによって問合せと分析のためにロードされ、イメージはイメージ処理フレームワークによって保存され、処理されます。Oracle Big Data Spatial and Graphサーバーは、Hadoop上で次のために使用できます。

-

地勢図上の足跡、ジオメトリのリソースの可用性などの地理空間情報のカタロギング。

-

地図上の位置で最も近い距離などを計算する距離演算の位相処理。

-

地図要素内で人口統計の相関を作成することによって、階層型の地勢図を構築し、地図を補完するためのカテゴリ化。

Oracle Big Data Spatial and Graphには、次の機能が組み込まれています。

-

空間データをすばやく取得するための索引付け機能。

-

地図上に足跡を表示するマップ機能。

-

特定の地勢地域をズームインおよびズームアウトするズーム機能。

-

モザイク操作またはサブセット操作の作成を処理するために一連のイメージ・ファイルをグループ化するモザイクおよびグループ機能。

-

デカルトおよび測地座標系で、空間データを表すデカルトおよび測地座標の機能。

-

国、州、都市、郵便番号などのジオメトリック階層を構築し、関連付ける階層機能。この機能では、ドキュメントまたは緯度/経度座標の形式で入力データを処理できます。

2.2 Oracle Big Dataベクトル・データおよびラスター・データの処理

Oracle Big Data Spatial and Graphでは、ベクトルおよびラスター空間データの両方の保管と処理をサポートしています。

2.2.1 Oracle Big Data Spatialラスター・データの処理

ラスター・データの処理では、GDALローダーがラスター空間データまたはイメージをHDFS環境にロードします。ラスター空間データでは、次の基本操作を実行できます。

-

モザイク: 複数のラスター・イメージを組み合せて単一のモザイク・イメージを作成します。

-

サブセット: 個々のイメージに対してサブセット操作を実行します。

-

ラスター代数演算: ラスター内のすべてのピクセルに対して代数演算を実行します(add、divide、multiply、log、pow、sine、sinhおよびacosなど)。

-

ユーザー定義の処理: ラスター処理は、マッピング・フェーズおよびリデュース・フェーズで実行されるようユーザーが設定するクラスに基づいています。

この機能は、ラスター分析操作のためのMapReduceフレームワークをサポートしています。ユーザーは、ラスター・データの代数関数などの独自のラスター操作をカスタムで構築できます。たとえば、地形など、数値標高モデルや空間的表面の3次元の表現の各基盤の傾斜を計算します。詳細は、「ラスター・データ処理のためのOracle Big Data Spatial Hadoop Image Processing Framework」を参照してください。

2.2.2 Oracle Big Data Spatialベクトル・データの処理

この機能は、空間ベクトル・データの処理をサポートしています。

-

Hadoop HDFS環境へのロードおよび格納

-

デカルトまたは測地データとして格納

格納された空間ベクトル・データは次の問合せ操作などの実行に使用されます。

-

ポイントインポリゴン

-

距離計算

-

Anyinteract

-

バッファ作成

空間ベクトル・データでは、複数のデータ・サービス操作がサポートされています。

-

データ・エンリッチメント

-

データ・カテゴリ化

-

空間の結合

また、HTML5形式にのみ限定されますが、Map Visualization APIもサポートされています。このようなAPIにアクセスして、カスタム操作を作成できます。詳細は、「Oracle Big Data Spatial Vector Analysis」を参照してください。

2.3 ラスター・データ処理のためのOracle Big Data Spatial Hadoop Image Processing Framework

Oracle Spatial Hadoop Image Processing Frameworkを使用すると、一連の並列処理フェーズの結果として生成される新しい結合イメージの作成が可能になります。

次の機能が含まれます。

-

HDFSイメージ・ストレージでは、各ブロック・サイズ分割が個別の四角形として格納され、その後のそれぞれの処理に使用されます

-

MapReduceフレームワークを使用した、サブセット操作、ユーザー定義操作、および地図代数演算の並列処理

-

マッピング・フェーズまたはリデュース・フェーズで透過的に並列して実行されるカスタム処理クラスの追加機能

-

ジオリファレンスされるイメージの高速処理

-

GDAL形式、複数帯域イメージ、DEM (数値標高モデル)、複数ピクセル深度、およびSRIDのサポート

-

Java APIでは、WebサービスまたはスタンドアロンJavaアプリケーションに使用できるフレームワーク操作にアクセスできます

-

ローカル環境でユーザー処理クラスをテストおよびデバッグするためのフレームワーク

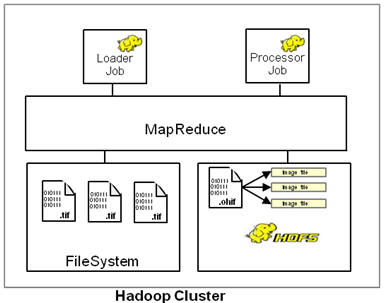

Oracle Spatial Hadoop Image Processing Frameworkは、LoaderとProcessorと呼ばれる2つのモジュールで構成されており、次の図に示すように、それぞれがHadoopクラスタ内の別のステージで実行されるHadoopジョブで表されます。また、Image Server Webアプリケーションを使用してイメージをロードおよび処理し、Java APIを使用してフレームワークの機能を公開できます。

インストールと構成について詳しくは、次を参照してください。

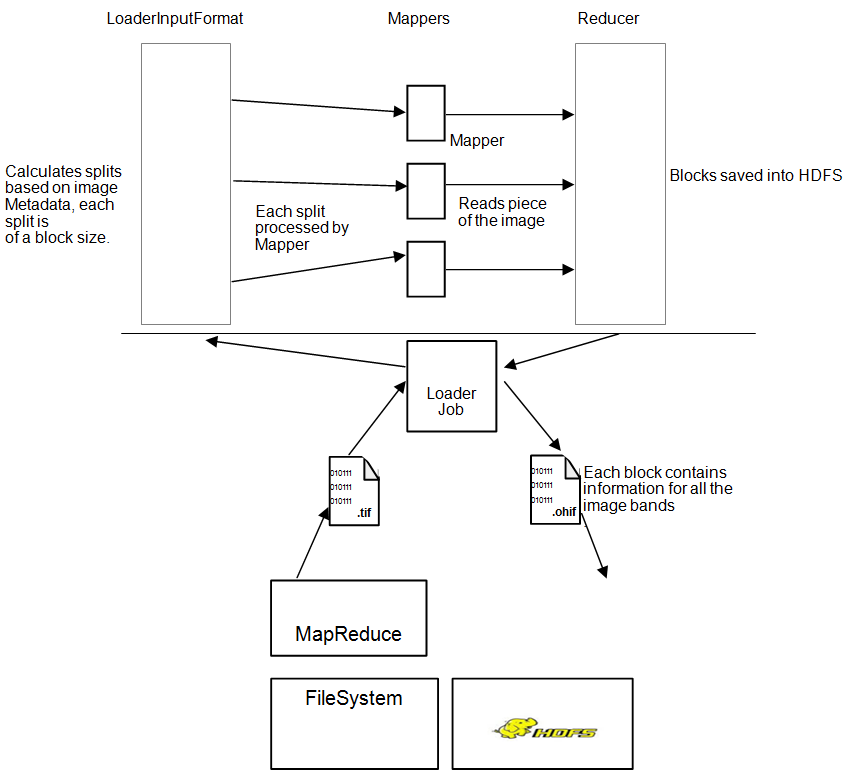

2.3.1 Image Loader

Image Loaderは、特定のイメージまたはイメージ・グループをHDFSにロードするHadoopジョブの1つです。

-

イメージはインポート中、HDFSブロックとして四角形処理され、格納されます。

-

GDALはイメージの四角形処理に使用されます。

-

それぞれの四角形は個々のマッパーによってロードされるため、並列で読み取られ、高速になります。

-

それぞれの四角形は一定のバイト数(ユーザー入力)が重なっているため、隣接する四角形の領域にかかっています。

-

MapReduceジョブでは、それぞれの四角形の情報をロードするマッパーを使用します。マッパーの数は、四角形の数、イメージ解像度、およびブロック・サイズに応じて'n'個になります。

-

イメージごとのリデュース・フェーズでは、マッパーによってロードされた情報をすべてまとめ、そのイメージを解像度、帯域、オフセット、イメージ・データを含む特別な

.ohif形式で格納します。これにより、それぞれの四角形を含むファイル・オフセットとノード場所が明らかになります。 -

それぞれの四角形には、各帯域の情報が含まれます。これは、一部の四角形のみを処理し、それに対応するブロックのみをロードする場合に役立ちます。

次の図はImage Loaderの処理を示しています。

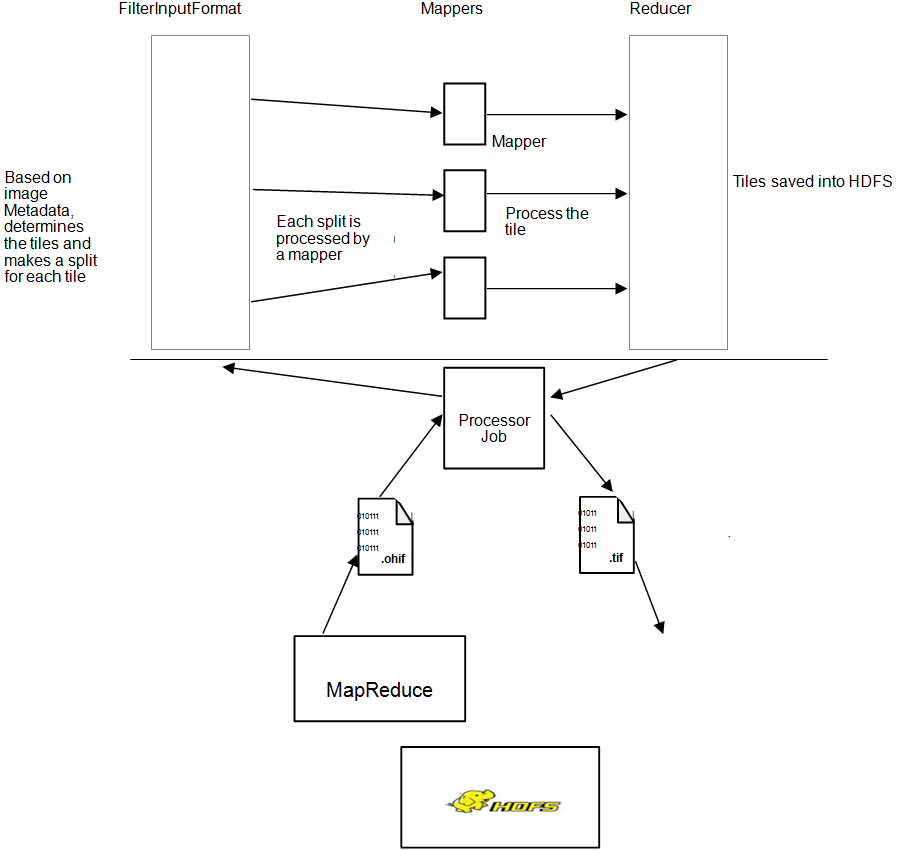

2.3.2 Image Processor

Image Processorは、ユーザー入力に基づいて処理対象の四角形をフィルタ処理し、並列処理によって新しい1つのイメージを作成するためのHadoopジョブです。

-

ユーザーが識別した特定のイメージの四角形を処理します。識別できる処理クラスは1つ、ゼロ、または複数です。これらのクラスは、構成に応じてマッピング・フェーズまたはリデュース・フェーズで実行されます。マッピング・フェーズの場合、処理クラスの実行後、モザイク操作を実行し、ピクセルを調整してユーザーが要求した最終的な出力形式にします。モザイク操作が要求されなかった場合、入力ラスターがそのままリデュース・フェーズに送信されます。リデュース・フェーズの場合、ユーザー・リデュース処理クラス用として入力されるGDALデータ・セットにすべての四角形がまとめられます。これにより、ユーザーのニーズに応じて最終出力を変更または分析できるようになります。

-

マッパーは、データのローカル性を保ちながら、1つの四角形に対応するデータをロードします。

-

データがロードされると、マッパーはユーザーが要求した帯域をフィルタ処理します。

-

フィルタされた情報は、リデュース・フェーズで各マッパーに送信され、そこでバイト数がまとめられ、ユーザーの要求に応じて最終的な処理イメージがHDFSまたは通常のファイル・システムに格納されます。

次の図はImage Processorジョブを示しています。

2.4 Image Loaderを使用したHadoopへのイメージのロード

Oracle Spatial and Graph Hadoop Image Processing Frameworkを使用してイメージを処理するには、最初にイメージを実際にHDFSに保存し、次に各イメージをそれぞれ別のスマート・タイルに保存します。

ここでは、四角形をそれぞれ使用してジョブを処理できます。Image Loaderでは、単一イメージ、またはイメージのコレクションを並列でHDFSにインポートできるため、ロード時間を短縮できます。

Image Loaderはファイル・システムのイメージをHDFSにインポートし、そこでブロックにイメージのすべての帯域のデータを含められるため、特定の位置でその後処理が必要になった場合、その情報を単一ノードで処理できます。

2.4.1 イメージ・ロード・ジョブ

イメージ・ロード・ジョブには、イメージを関連イメージに分割するカスタム入力形式があります。分割は、次の方法で特定される、定義済の領域をカバーするイメージの四角形のブロックを読み取るアルゴリズムに基づいて計算されます

領域 = ((ブロックサイズ - メタデータ・バイト数) / 帯域数) / 1ピクセル当たりのバイト数。

ブロック・サイズ全体を使用しない部分については、残りのバイト数がゼロで埋められます。

分割は複数のマッパーに割り当てられ、そこでImageSplit情報に基づき、割当て済の四角形がすべてGDALによって読み取られます。その結果、ImageDataWritableインスタンスが作成され、コンテキストに保存されます。

ImageDataWritableインスタンスのメタデータ・セットは、四角形処理したイメージを操作および処理できるように、処理クラスでの設定に使用されます。ソース・イメージは複数のマッパーから読み取られるため、並列ロードが高速で実行されます。

マッパーが読取りを完了すると、 リデューサがコンテキストから四角形を選択してまとめ、ファイルをHDFSに保存します。イメージを再度読み取るには、特殊な読取り処理が必要です。

2.4.2 入力パラメータ

次の入力パラメータをHadoopコマンドに指定します。

hadoop jar /opt/oracle/oracle-spatial-graph/spatial/raster/jlib/hadoop-imageloader.jar -files <SOURCE_IMGS_PATH> -out <HDFS_OUTPUT_FOLDER> -gdal <GDAL_LIB_PATH> -gdalData <GDAL_DATA_PATH> [-overlap <OVERLAPPING_PIXELS>] [-thumbnail <THUMBNAIL_PATH>] [-expand <false|true>] [-extractLogs <false|true>] [-logFilter <LINES_TO_INCLUDE_IN_LOG>] [-pyramid <OUTPUT_DIRECTORY, LEVEL, [RESAMPLING]>]

説明:

SOURCE_IMGS_PATHはソース・イメージまたはフォルダのパスです。入力が複数の場合はカンマで区切ります。NFSを介してクラスタ内のすべてにアクセスできるパスを指定する必要があります。HDFS_OUTPUT_FOLDERはロードしたイメージを格納するHDFS出力フォルダです。OVERLAPPING_PIXELSはそれぞれの四角形の境界線上で重なるピクセルの任意の数であり、このパラメータが指定されていない場合、重なっている2つのピクセルのデフォルトが使用されます。GDAL_LIB_PATHはGDALライブラリの場所を示すパスです。GDAL_DATA_PATHはGDALデータ・フォルダの場所を示すパスです。NFSを介してクラスタ内のすべてにアクセスできるパスを指定する必要があります。THUMBNAIL_PATHはロードしたイメージのサムネイルを格納する任意のパスです。NFSを介してクラスタ内のすべてにアクセスでき、Yarnユーザーの書込みアクセス権のあるパスを指定する必要があります。-expandは、ロードされたラスターのHDFSパスによってソース・パス(すべてのディレクトリを含む)が拡張されるかどうかを制御します。これをfalseに設定すると、.ohifファイルは、(-oオプションを使用して指定された)出力ディレクトリに直接格納され、この場合、このラスター内のこのディレクトリのパスは含まれません。-extractLogsは、実行したアプリケーションのログをシステムの一時ディレクトリに抽出するかどうかを制御します。デフォルトでは有効ではありません。抽出には、Oracle Frameworkクラスの一部ではないログは含まれません。-logFilter <LINES_TO_INCLUDE_IN_LOG>は、たとえば、カスタム処理クラス・パッケージを含めるために、抽出したログに含めるすべてのパターンがリストされたカンマ区切りの文字列です。-pyramid <OUTPUT_DIRECTORY, LEVEL, [RESAMPLING]>を使用すると、最初のラスター・ロードを行う際にピラミッドを作成できます。HDFSにアップロードする前に、ローカル・ピラミッドを格納するためのOUPUT_DIRECTORYを指定する必要があります。ピラミッドはロードで要求したHDFSAディレクトリと同じディレクトリにロードされます。各ラスターで必要なピラミッドの数を示すために、ピラミッドのLEVELを指定する必要があります。RESAMPLINGアルゴリズムは、再サンプリングの実行に使用するメソッドを指定するためのオプションです。何も設定しない場合は、BILINEARが使用されます。

たとえば、次のコマンドでは、imagesフォルダ内のジオリファレンスされたイメージすべてをロードし、該当するすべての境界線に重なる10ピクセルを追加します。HDFS出力フォルダはohiftestであり、ロードしたイメージのサムネイルがprocesstestフォルダに格納されます。

hadoop jar /opt/oracle/oracle-spatial-graph/spatial/raster/jlib/hadoop-imageloader.jar -files /opt/shareddir/spatial/demo/imageserver/images/hawaii.tif -out ohiftest -overlap 10 -thumbnail /opt/shareddir/spatial/processtest –gdal /opt/oracle/oracle-spatial-graph/spatial/raster/gdal/lib –gdalData /opt/shareddir/data

デフォルトでは、マッパーとリデューサは2GBのJVMを取得できるよう構成されていますが、この設定、またはその他のジョブ構成プロパティは、コマンドを実行する同じフォルダの場所で、ユーザーがimagejob.propプロパティ・ファイルを追加することによってオーバーライドできます。このプロパティ・ファイルは、オーバーライドする構成プロパティをすべてリストできます。次に例を示します。

mapreduce.map.memory.mb=2560 mapreduce.reduce.memory.mb=2560 mapreduce.reduce.java.opts=-Xmx2684354560 mapreduce.map.java.opts=-Xmx2684354560

Javaヒープ・メモリー(java.optsプロパティ)は、マッパーとリデューサ(mapreduce.map.memoryとmapreduce.reduce.memory)に割り当てられたメモリーの合計以下である必要があります。したがって、Javaヒープ・メモリーを増やす場合、マッパーとリデューサのメモリーも増やすことが必要である場合があります。

GDALが適切に機能するように、$LD_LIBRARY_PATHを使用してライブラリを使用可能にする必要があります。ジョブを実行する前に、共有ライブラリ・パスがシェル・ウィンドウに適切に設定されていることを確認してください。次に例を示します。

export LD_LIBRARY_PATH=$ALLACCESSDIR/gdal/native

2.4.3 出力パラメータ

リデューサは、入力イメージごとに2つの出力ファイルを生成します。1つ目は、ソース・イメージのすべての四角形を集める.ohifファイルであり、それぞれの四角形は処理マッパーによって別のインスタンスとして処理されます。四角形は内部でHDFSブロックとして格納されます。ブロックは複数のノードに配置され、1つのノードには特定の.ohifファイルのブロックが1つ以上含まれます。.ohifファイルは、–expandが使用されなかった場合、/user/<USER_EXECUTING_JOB>/OUT_FOLDER/<PARENT_DIRECTORIES_OF_SOURCE_RASTER>フォルダの下にあるユーザー指定フォルダに、-outフラグを付けて格納されます。それ以外の場合、.ohifは/user/<USER_EXECUTING_JOB>/OUT_FOLDER/に配置され、このファイルはoriginal_filename.ohifとして識別できます。

2つ目の出力は、メタデータ・ファイルに関連しており、イメージのすべてのピースをリストし、それぞれがカバーする座標を示します。ファイルはメタデータの場所にあるHDFSに置かれており、その名前はohifファイルの名前を使用してハッシュ生成されます。このファイルはOracle内部専用であり、ソース・ラスターの重要なメタデータをリストします。メタデータ・ファイルのサンプル行の一部は次のとおりです。

srid:26904 datatype:1 resolution:27.90809458890406,-27.90809458890406 file:/user/hdfs/ohiftest/opt/shareddir/spatial/data/rasters/hawaii.tif.ohif bands:3 mbr:532488.7648166901,4303164.583549625,582723.3350767174,4269619.053853762 0,532488.7648166901,4303164.583549625,582723.3350767174,4269619.053853762 thumbnailpath:/opt/shareddir/spatial/thumb/

-thumbnailフラグが指定されている場合、ソース・イメージのサムネイルが関連フォルダに格納されます。これは.ohifファイルの変換を視覚化する方法の1つです。ジョブ実行ログには、コマンドyarn logs -applicationId <applicationId>を使用してアクセスできます。

2.5 Oracle Spatial Hadoop Image Processorを使用したイメージの処理

イメージはHDFSにロードされると、Oracle Spatial Hadoop Image Processing Frameworkによって並列で処理されます。

出力を指定すると、フレームワークによって出力に適合するようフィルタおよび処理され、まとめて1つのファイルに格納されます。地図代数演算も可能であり、設定されていれば、処理フェーズの最初の部分になります。最終的な出力がフレームワークによって作成される前であれば、実行する処理クラスを追加で指定できます。

Image Processorは、入力(モザイク記述または単一のラスター)に基づいて特定のデータ・ブロックをロードし、最終的な出力に適合する帯域およびピクセルのみを選択します。指定した処理クラスはすべて実行され、最終的な出力は、ユーザーの要求に応じてHDFSまたはファイル・システムに格納されます。

2.5.1 イメージ処理ジョブ

イメージ処理ジョブには、ユーザーによって要求された処理のタイプに応じて異なるフローがあります。

-

デフォルトのイメージ処理ジョブ・フロー: モザイク操作、単一のラスター操作、または基本的な複数のラスター操作が含まれる処理に対して実行されます。

-

複数のラスター・イメージ処理ジョブ・フロー: 複雑な複数のラスター代数演算が含まれる処理に対して実行されます。

2.5.1.1 デフォルトのイメージ処理ジョブ・フロー

デフォルトのイメージ処理ジョブ・フローは、次の処理のいずれかが要求されたときに実行されます。

-

モザイク操作

-

単一のラスター操作

-

基本的な複数のラスター代数演算

このフローには、独自のカスタムFilterInputFormatがあり、SRIDおよび座標に基づいて処理対象の四角形を決定します。モザイク入力のデータ型(ピクセル深度)と同じデータ型(モザイク深度)のイメージのみが該当します。ユーザーがモザイク出力に指定した座標と交差する四角形のみが含まれます。単一のラスター操作または基本的な複数のラスター代数演算(モザイクを除く)の場合、処理は完全なイメージに対して実行されるため、フィルタには、入力ラスターのすべての四角形が含まれます。四角形が選択されると、イメージごとにカスタムImageProcessSplitが作成されます。

マッパーがImageProcessSplitを受け取ると、ImageSplitの指定に基づいて情報が読み取られ、ユーザーが指定した帯域のみを選択するようフィルタ処理され、地図操作、および(要求に定義されていれば)処理クラスのリストが実行されます。

それぞれのマッパー処理は、データがあるノードで実行されます。地図代数演算および処理クラスが実行された後、検証により、ユーザーがモザイク操作を要求しているかどうか、または分析に完全なイメージが含まれるかどうかが検証されます。モザイク操作が要求されている場合、最終処理によってこの操作が実行されます。モザイク操作では、すべての四角形から出力に適合するピクセルのみを選択し、必要に応じて解像度を変更してモザイク出力に追加します。単一の処理操作では、前のラスターの四角形のバイトがそのままコピーされます。結果として得られたバイトは、リデューサによってリカバリされる対象としてNFSに格納されます。

1つのリデューサで複数の四角形を選択し、それをまとめます。基本的な複数のラスター代数演算を指定した場合、これは、四角形が最終出力にマージされるときに同時に実行されます。この操作は、モザイク出力内の交差ピクセルのみに影響するか、モザイク操作が要求されなかった場合はすべてのピクセルに影響します。リデューサ処理クラスを指定した場合、出力ラスターとともにGDALデータ・セットが分析および処理のためにこのクラスに送信されます。HDFS出力を選択した場合、ImageLoaderが呼び出され、結果がHDFSに格納されます。それ以外の場合、イメージはデフォルトでGDALによって用意され、ファイル・システム(NFS)に格納されます。

親トピック: イメージ処理ジョブ

2.5.1.2 複数のラスター・イメージ処理ジョブ・フロー

複数のラスター・イメージ処理ジョブ・フローは、複雑な複数のラスター代数演算が要求されるときに実行されます。これは、同じMBR、ピクセル・タイプ、ピクセル・サイズおよびSRIDを持つラスターに適用されます。なぜなら、これらの操作は対応するセルにピクセル単位で適用され、この場合、すべてのピクセルが同じ座標を表します。

このフローには、独自のカスタムMultipleRasterInputFormatがあり、SRIDおよび座標に基づいて処理対象の四角形を決定します。同じMBR、ピクセル・タイプ、ピクセル・サイズおよびSRIDを持つイメージのみが考慮されます。カタログ内の最初のラスターによって指定された座標と一致するラスターのみが含まれます。入力ラスターのすべての四角形が考慮されますが、これは、処理が完全なイメージに対して実行されるからです。

四角形が選択されると、カスタムMultipleRasterSplitが作成されます。この分割には、ブロック・サイズに応じてすべての元の四角形の小さい領域が含まれますが、これは、小さい領域であってもすべてのラスターを分割に含める必要があるからです。これらはそれぞれIndividualRasterSplitと呼ばれ、これらは親MultipleRasterSplitに含まれます。

マッパーがMultipleRasterSplitを受け取ると、親分割に含まれるすべてのラスターの四角形の情報が読み取られ、ユーザーが指定した帯域のみ、およびこの特定のマッパーで処理する対応する小さい領域のみを選択するようフィルタ処理され、複雑な複数のラスター代数演算が実行されます。

同じノード内にない可能性がある単一のマッパーに複数のラスターが含まれるため、処理のこの部分ではデータのローカル性が失われる可能性があります。すべてのピクセルに関して結果として得られたバイトは、リデューサによってリカバリされる対象としてコンテキストに取り込まれます。

1つのリデューサでピクセル値を選択し、それをまとめます。リデューサ処理クラスを指定した場合、出力ラスターとともにGDALデータ・セットが分析および処理のためにこのクラスに送信されます。このシナリオではこのクラスの四角形のリストはnullを受け取り、このクラスは出力データ・セットのみを操作できます。HDFS出力を選択した場合、ImageLoaderが呼び出され、結果がHDFSに格納されます。それ以外の場合、イメージはデフォルトでGDALによって用意され、ファイル・システム(NFS)に格納されます。

親トピック: イメージ処理ジョブ

2.5.2 入力パラメータ

次の入力パラメータをHadoopコマンドに指定できます。

hadoop jar /opt/oracle/oracle-spatial-graph/spatial/raster/jlib/hadoop-imageprocessor.jar -config <MOSAIC_CONFIG_PATH> -gdal <GDAL_LIBRARIES_PATH> -gdalData <GDAL_DATA_PATH> [-catalog <IMAGE_CATALOG_PATH>] [-usrlib <USER_PROCESS_JAR_PATH>] [-thumbnail <THUMBNAIL_PATH>] [-nativepath <USER_NATIVE_LIBRARIES_PATH>] [-params <USER_PARAMETERS>] [-file <SINGLE_RASTER_PATH>]

説明:

MOSAIC_CONFIG_PATHは、出力の機能を定義するモザイク構成xmlへのパスです。GDAL_LIBRARIES_PATHはGDALライブラリの場所を示すパスです。GDAL_DATA_PATHはGDALデータ・フォルダの場所を示すパスです。NFSを介してクラスタ内のすべてにアクセスできるパスを指定する必要があります。IMAGE_CATALOG_PATHは、処理対象のHDFSイメージをリストするカタログxmlへのパスです。–fileフラグを使用して処理する単一のラスターも指定できるため、これはオプションです。USER_PROCESS_JAR_PATHは任意のユーザー定義jarファイルまたはjarファイルのカンマ区切りのリストであり、これらにはそれぞれ、ソース・イメージに適用される追加の処理クラスが含まれています。THUMBNAIL_PATHはロードしたイメージのサムネイル作成を有効化するための任意のフラグです。このパスは、クラスタ内のすべてのノードへのNFSを介してアクセスし、HDFS出力の場合のみ有効です。USER_NATIVE_LIBRARIES_PATHは、分析で使用する追加のネイティブ・ライブラリの任意のカンマ区切りのリストです。これはまた、アプリケーションにロードするすべてのネイティブ・ライブラリが含まれるディレクトリである場合もあります。USER_PARAMETERSは、ユーザー処理クラスの入力データを定義するために使用する任意のキー/値のリストです。セミコロンを使用して、パラメータを区切ります。たとえば、azimuth=315;altitude=45などですSINGLE_RASTER_PATHは、ジョブによって処理される.ohifファイルへの任意のパスです。これが設定されている場合、カタログを設定する必要はありません。

たとえば、次のコマンドは、testFS.xmlファイルに設定されているモザイク出力定義を使用して、カタログ・ファイルinput.xmlファイルにリストされるすべてのファイルを処理します。

hadoop jar /opt/oracle/oracle-spatial-graph/spatial/raster/jlib/hadoop-imageprocessor.jar -catalog /opt/shareddir/spatial/demo/imageserver/images/input.xml -config /opt/shareddir/spatial/demo/imageserver/images/testFS.xml -thumbnail /opt/shareddir/spatial/processtest –gdal /opt/oracle/oracle-spatial-graph/spatial/raster/gdal/lib –gdalData /opt/shareddir/data

デフォルトでは、マッパーとリデューサは2GBのJVMを取得できるよう構成されていますが、この設定、またはその他のジョブ構成プロパティは、コマンドを実行する同じフォルダの場所で、ユーザーがimagejob.propプロパティ・ファイルを追加することによってオーバーライドできます。

GDALが適切に機能するように、$LD_LIBRARY_PATHを使用してライブラリを使用可能にする必要があります。ジョブを実行する前に、共有ライブラリ・パスがシェル・ウィンドウに適切に設定されていることを確認してください。次に例を示します。

export LD_LIBRARY_PATH=$ALLACCESSDIR/gdal/native

2.5.2.1 カタログXML構造

次の例は、イメージ処理ジョブによって生成されるモザイク操作に必要なすべてのソース・イメージをリストする入力カタログXMLを示します。

-<catalog> -<image> <raster>/user/hdfs/ohiftest/opt/shareddir/spatial/data/rasters/maui.tif.ohif</raster> <bands datatype='1' config='1,2,3'>3</bands> </image> </catalog>

<catalog>要素には処理対象の<image>要素のリストが含まれています。

それぞれの<image>要素は、<raster>要素内にソース・イメージまたはソース・フォルダを定義します。フォルダ内のすべてのイメージが処理されます。

<bands>要素はイメージの帯域数を指定し、datatype属性には、ラスター・データ型があり、config属性はモザイク出力帯域の順序にどの帯域が表示されるかを指定します。たとえば、3,1,2はモザイク出力帯域番号1にはこのラスターの帯域番号3、モザイク帯域番号2にはソース帯域1、およびモザイク帯域番号3にはソース帯域2があることを示します。この順序はラスターからベクトルへ変更されることがあります。

親トピック: 入力パラメータ

2.5.2.2 モザイク定義XML構造

次の例は、イメージ処理ジョブで生成される出力の機能を定義する場合に必要なモザイク構成XMLを示します。

-<mosaic exec="false">

-<output>

<SRID>26904</SRID>

<directory type="FS">/opt/shareddir/spatial/processOutput</directory>

<!--directory type="HDFS">newData</directory-->

<tempFSFolder>/opt/shareddir/spatial/tempOutput</tempFSFolder>

<filename>littlemap</filename>

<format>GTIFF</format>

<width>1600</width>

<height>986</height>

<algorithm order="0">2</algorithm>

<bands layers="3" config="3,1,2"/>

<nodata>#000000</nodata>

<pixelType>1</pixelType>

</output>

-<crop>

-<transform>

356958.985610072,280.38843650364862,0,2458324.0825054757,0,-280.38843650364862 </transform>

</crop>

<process><classMapper params="threshold=454,2954">oracle.spatial.hadoop.twc.FarmTransformer</classMapper><classReducer params="plot_size=100400">oracle.spatial.hadoop.twc.FarmAlignment</classReducer></process>

<operations>

<localif operator="<" operand="3" newvalue="6"/>

<localadd arg="5"/>

<localsqrt/>

<localround/>

</operations>

</mosaic>

<mosaic>要素は処理出力の仕様を定義します。exec属性は、処理にモザイク操作が含まれるかどうかを指定します。“false”に設定されている場合、モザイク操作は実行されず、単一のラスターが処理されます。“true”に設定されているか一切設定されていない場合、モザイク操作は実行されます。次の要素の一部はモザイク操作に対してのみ必要であり、単一のラスター処理の場合は無視されます。

<output>要素は出力に使用される<SRID>などの機能を定義します。異なるSRIDのすべてのイメージは、モザイクSRIDに変換され、その四角形がモザイクに適合するかどうかが判断されます。出力ラスターが入力と同じSRIDを持つため、この要素は単一のラスター処理には必要ありません。

<directory>要素は出力の場所を定義します。これは、タグの型で指定される、通常のファイルシステム(FS)またはHDFSのいずれかです。

<tempFsFolder>要素はモザイク出力を一時的に格納するパスを設定します。属性delete=”false”を指定することにより、出力の出力をHDFSに格納するためにローダーが実行されていた場合でも、この出力を保持できます。

<filename>および<format>要素は、出力ファイル名を指定します。<filename>は、単一のラスター処理には必要ありません。これが指定されていない場合、(ジョブの呼出し時に-file属性によって決定される)入力ファイルの名前が出力ファイルに使用されます。出力ラスターが入力と同じ形式であるため、<format>は単一のラスター処理には必要ありません。

<width>および<height>要素はモザイク出力の解像度を設定します。出力ラスターが入力と同じ解像度を持つため、これらは単一のラスター処理には必要ありません。

<algorithm>要素はイメージの順序アルゴリズムを設定します。1はソースの最終変更日付順、2はイメージ・サイズ順を示します。順序タグは昇順モードまたは降順モードを表します。(これらのプロパティは、複数のラスターが重複する可能性があるモザイク操作用です。)

<bands>要素は出力モザイクの帯域数を指定します。この数より帯域の少ないイメージは破棄されます。config属性を単一のラスター処理に使用することにより、カタログがない場合に出力の帯域構成を設定できます。

<nodata>要素は、値のないモザイク出力のすべてのピクセルのうち、最初の3帯域の色を指定します。

<pixelType>要素はモザイク出力のピクセル・タイプを設定します。同じピクセル・サイズのないソース・イメージは処理段階で破棄されます。この要素は、単一のラスター処理には必要ありません。これが指定されていない場合、ピクセル・タイプは入力と同じものになります。

<crop>要素は、モザイク出力に含まれる座標を、startcoordinateX、pixelXWidth、RotationX、startcoordinateY、RotationY、pixelheightYの順に定義します。この要素は、単一のラスター処理には必要ありません。これが指定されていない場合、完全なイメージが分析用として考慮されます。

<process>要素はモザイク操作の前に実行するクラスをすべてリストします。

<classMapper>要素は、マッピング・フェーズ中に実行されるクラスに使用され、<classReducer>要素は、リデュース・フェーズ中に実行されるクラスに使用されます。両方の要素がparams属性を持ち、この場合、ニーズに応じて処理クラスに入力パラメータを送信できます。

<operations>要素は、この要求で処理される地図代数演算をすべてリストします。この要素には、ピラミッド操作の要求を含めることもできます。次に例を示します。

<operations>

<pyramid resampling="NEAREST_NEIGHBOR" redLevel="6"/>

</operations>

親トピック: 入力パラメータ

2.5.3 ジョブ実行

ジョブの最初のステップは、出力に適合する四角形をフィルタ処理することです。最初に、四角形のメタデータを保持している位置ファイルがInputFormatに送信されます。

pixelTypeを抽出すると、フィルタにより、関連するソース・イメージが処理に有効かどうかが判別されます。カタログxmlで作成したユーザー定義に基づき、次のいずれかが実行されます。

-

イメージが処理に有効な場合、次にSRIDが評価されます

-

ユーザー定義と異なる場合、すべての四角形のMBR座標がユーザーSRIDに変換され、評価されます。

この方法では、すべての四角形が出力定義と交差するかどうかが評価されます。

-

モザイク処理要求の場合、交差する四角形のみが選択され、これらの1つずつに分割が作成されます。

-

単一のラスター処理要求の場合、すべての四角形が選択され、これらの1つずつに分割が作成されます。

-

複雑な複数のラスター代数演算要求の場合、MBRおよびピクセル・サイズが同じであれば、すべての四角形が選択されます。選択したラスターの数およびブロックサイズに応じて、(完全な元のラスターの四角形が必ずしも含まれるわけではない)すべての四角形のラスターの特定の領域が単一の親分割に含まれます。

マッパーでは、格納先のノードでそれぞれの分割が処理されます。(複雑な複数のラスター代数演算の場合、分割に複数のラスターからのデータが含まれるため、データのローカル性が失われる可能性があります。)マッパーでは、ユーザーが定義した地図代数演算および処理クラスが順に実行され、次に、要求された場合、モザイク処理が実行されます。単一のリデューサにより、マッパーの結果がまとめられ、ユーザー指定のリデュース処理クラスの場合、これらのクラスに出力データ・セットが分析または処理のために設定されます。最後に、ユーザーの要求に応じてイメージがFSまたはHDFSに格納されます。ユーザーがHDFSへの出力の格納を要求した場合、ImageLoaderジョブが起動され、イメージが.ohifファイルとして格納されます。

デフォルトでは、マッパーとリデューサは1GBのJVMを取得できるよう構成されていますが、この設定、またはその他の構成プロパティは、コマンドを実行する同じフォルダの場所で、imagejob.propプロパティ・ファイルを追加することによってオーバーライドできます。

2.5.4 処理クラスおよびImageBandWritable

カタログXMLで指定した処理クラスは、ジョブで正しく処理できるように、次の一連のルールを遵守している必要があります。マッピング・フェーズのすべての処理クラスにImageProcessorInterfaceインタフェースが実装されている必要があります。リデューサ・フェーズの場合、ImageProcessorReduceInterfaceインタフェースが実装されている必要があります。

処理クラスを実装するには、そのオブジェクト表現ImageBandWritableを使用してラスターを操作する必要があります。処理クラスの例はフレームワークで提供され、DEMの傾斜を計算できます。関数によってピクセル値を別の値に変換する場合などは、マッピング操作を作成できます。ImageBandWritableインスタンスは、解像度、サイズ、ピクセルなど、四角形のコンテンツを定義します。これらの値は、四角形の定義を作成するプロパティに反映する必要があります。モザイク出力の整合性は、これらのプロパティの操作が正しいかどうかによって決まります。

ImageBandWritableインスタンスは、解像度、サイズ、ピクセルなど、四角形のコンテンツを定義します。これらの値は、四角形の定義を作成するプロパティに反映する必要があります。出力の整合性は、これらのプロパティの操作が正しいかどうかによって決まります。

表2-1 ImageBandWritableプロパティ

| タイプ - プロパティ | 説明 |

|---|---|

|

IntWritable dstWidthSize |

四角形の幅のサイズ |

|

IntWritable dstHeightSize |

四角形の高さのサイズ |

|

IntWritable bands |

四角形の帯域数 |

|

IntWritable dType |

四角形のデータ型 |

|

IntWritable offX |

ソース・イメージに関連し、Xピクセルから開始 |

|

IntWritable offY |

ソース・イメージに関連し、Yピクセルから開始 |

|

IntWritable totalWidth |

ソース・イメージの幅のサイズ |

|

IntWritable totalHeight |

ソース・イメージの高さのサイズ |

|

IntWritable bytesNumber |

四角形のピクセルを含み、baseArrayに格納されるバイト数 |

|

BytesWritable[] baseArray |

四角形のピクセルを表すバイト数を含む配列であり、それぞれのセルが1つの帯域を表します |

|

IntWritable[][] basePaletteArray |

四角形のパレットを表す整数値を含む配列であり、それぞれの配列が帯域を表します。それぞれの整数が色テーブルの各色のエントリを表し、色ごとに4つのエントリがあります |

|

IntWritable[] baseColorArray |

色の解釈を表す整数値を含む配列であり、それぞれのセルが1つの帯域を表します |

|

DoubleWritable[] noDataArray |

イメージのNODATA値を含む配列であり、それぞれのセルに関連する帯域の値が含まれます |

|

ByteWritable isProjection |

四角形にByte.MAX_VALUEの予測情報が含まれている場合に指定します |

|

ByteWritable isTransform |

四角形にByte.MAX_VALUEの地図変換配列情報が含まれている場合に指定します |

|

ByteWritable isMetadata |

四角形にByte.MAX_VALUEのメタデータ情報が含まれている場合に指定します |

|

IntWritable projectionLength |

予測情報の長さを指定します |

|

BytesWritable projectionRef |

予測情報のバイト数を指定します |

|

DoubleWritable[] geoTransform |

地理変換配列を含みます |

|

IntWritable metadataSize |

四角形の中のメタデータ値の数 |

|

IntWritable[] metadataLength |

それぞれのメタデータ値の長さを指定する配列 |

|

BytesWritable[] metadata |

四角形のメタデータの配列 |

|

GeneralInfoWritable mosaicInfo |

モザイクxml内のユーザー定義情報。モザイク出力機能は変更しないでください。新しい名前で元のxmlファイルを変更し、その新しいxmlを使用して実行および処理します |

|

MapWritable extraFields |

分析のためにリデューサ・フェーズに渡されるすべての四角形に固有のパラメータのキー/値ペアがリストされた地図 |

処理クラスおよびメソッド

四角形のピクセルを変更する場合は、次のメソッドを使用して、最初に帯域情報を配列に取り込みます。

byte [] bandData1 =(byte []) img.getBand(0);

帯域1の四角形のピクセルを表すバイト数は、現在bandData1配列にあります。底の索引はゼロです。

getBand(int bandId)メソッドは指定したbandIdの位置のラスターの帯域を取得します。取得したオブジェクトをラスターの配列型へのキャストに使用できます。これはbyte、short (unsigned int 16ビット、int 16ビット)、int (unsigned int 32ビット、int 32ビット)、float (float 32ビット)、またはdouble (float 64ビット)のいずれかです。

配列でピクセルを使用できる場合は、この時点でユーザーの要求に応じて変換できます。

ピクセルの処理後、ImageBandWritableの同じインスタンスを使用する必要がある場合は、次のメソッドを実行します。

img.removeBands;

これにより、前の帯域のコンテンツが削除され、新しい帯域の追加を開始できます。新しい帯域を追加するには、次のメソッドを使用します。

img.addBand(Object band);

それ以外の場合は、次のメソッドを使用して特定の帯域を置き換えることもできます。

img.replaceBand(Object band, int bandId)

前述のメソッドでは、bandは、ピクセル情報が含まれる配列であり、bandIDは、置換対象の帯域の識別子です。処理操作の結果、影響を受けるインスタンス・サイズ、データ型、bytesNumberおよびその他のプロパティを必ず更新してください。各プロパティには、セッターを使用できます。

2.5.4.1 クラスおよびJarファイルの位置

Oracle Image Serverコンソールを使用している場合は、すべての処理クラスが単一のJARファイルに含まれます。コマンドライン・オプションを使用している場合、処理クラスはそれぞれ異なるJARファイルに配置されます。

クラスパス内に新しいクラスが表示されている場合、これらを<process><classMapper>または<process><classReducer>セクションのモザイクXMLに追加する必要があります。追加されたすべての<class>要素は、表示されている順序で実行されます。マッパーの場合は最終モザイク操作が実行される直前、リデューサの場合はすべての処理済四角形が単一のデータ・セットにまとめられる直後です。

親トピック: 処理クラスおよびImageBandWritable

2.5.5 地図代数演算

ローカル地図代数演算は入力ラスター上で処理でき、そこではピクセル数が操作に応じて変更されます。構成XMLの操作の順序によって、処理される操作の順序が決まります。すべての地図代数演算が処理されると、処理クラスが実行され、最後にモザイク操作が実行されます。

次の地図代数演算はモザイク構成XMLの<operations>要素に追加でき、演算名を要素名として使用できます。(各操作がサポートされているデータ型は、カッコで囲まれてリストされています。)

-

localnot: 各ピクセルの否定を取得し、ビット・パターンを反転します。結果が負の値でデータ型が符号なしの場合、NODATA値が設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(バイト、Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット) -

locallog: ピクセルの自然対数(底e)を返します。結果がNaNの場合は元のピクセル値が設定され、結果が無限の場合はNODATA値が設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

locallog10: ピクセルの底10の対数が返されます。結果がNaNの場合は元のピクセル値が設定され、結果が無限の場合はNODATA値が設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localadd: 指定した値を引数としてピクセルに追加します。例:<localadd arg="5"/>。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localdivide: 各ピクセルの値を、引数として指定した値セットで除算します。例:<localdivide arg="5"/>。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localif: 各ピクセルの値を引数として指定した値および条件に基づいて変更します。有効な演算子: =、<、>、>=、< !=。例:<localif operator="<" operand="3" newvalue="6"/>、ここでは、値が3未満のピクセルがすべて変更され、新しい値が6に設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localmultiply: 各ピクセルの値に、引数として指定した値を乗算します。例:<localmultiply arg="5"/>。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localpow: 各ピクセルの値を、指定した引数の値のべき乗に切り上げます。例:<localpow arg="5"/>。結果が無限の場合、このピクセルにNODATA値が設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localsqrt: 各ピクセルを正しく四捨五入した正の値の平方根を返します。結果が無限またはNaNの場合、このピクセルにNODATA値が設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localsubstract: すべてのピクセル値から引数として指定した値を減算します。例:<localsubstract arg="5"/>。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localacos: ピクセルの逆余弦を計算します。結果がNaNの場合、NODATA値がこのピクセルに設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localasin: ピクセルの逆正弦を計算します。結果がNaNの場合、NODATA値がこのピクセルに設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localatan: ピクセルの逆正接を計算します。結果がNaNの場合、NODATA値がこのピクセルに設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localcos: ピクセルの余弦を計算します。結果がNaNの場合、NODATA値がこのピクセルに設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localcosh: ピクセルの逆双曲線余弦を計算します。結果がNaNの場合、NODATA値がこのピクセルに設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localsin: ピクセルの正弦を計算します。結果がNaNの場合、NODATA値がこのピクセルに設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localtan: ピクセルの正接を計算します。ピクセルの余弦が0の場合、このピクセルは変更されません。結果がNaNの場合、NODATA値がこのピクセルに設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localsinh: ピクセルの逆双曲線正弦を計算します。結果がNaNの場合、NODATA値がこのピクセルに設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localtanh: ピクセルの双曲線正接を計算します。結果がNaNの場合、NODATA値がこのピクセルに設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localdefined: セルの値がNODATAではない場合は整数型指定のピクセルが1にマップされ、それ以外の場合は0にマップされます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット、Float 32ビット) -

localundefined: セルの値がNODATAではない場合は整数型指定のラスターが0にマップされ、それ以外の場合は1にマップされます。(Unsigned int 16ビット、Unsigned int 32ビット、Int 16ビット、Int 32ビット) -

localabs: 符号付きピクセルの絶対値を返します。結果が無限の場合、このピクセルにNODATA値が設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localnegate: 各ピクセルの値から1を引いた数を乗算します。(Int 16ビット、Int 32ビット、Float 32ビット、Float 64ビット) -

localceil: ピクセル値以上であり、ある数学的整数と等しい最小値を返します。結果が無限の場合、このピクセルにNODATA値が設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Float 32ビット、Float 64ビット) -

localfloor: ピクセル値以下であり、ある数学的整数と等しい最小値を返します。結果が無限の場合、このピクセルにNODATA値が設定されます。ラスターにNODATA値が指定されていない場合、元のピクセルが設定されます。(Float 32ビット、Float 64ビット) -

localround: 各ピクセルに最も近い整数値を返します。(Float 32ビット、Float 64ビット)

2.5.6 複数のラスター代数演算

複数のラスターが含まれるラスター代数演算を処理できます。この場合、操作に応じて、および同じセル内の関連するすべてのラスターのピクセルを考慮して、ピクセルが変更されます。

一度に処理できる操作は1つのみであり、この操作は、<multipleops>要素を使用して構成XMLに定義されます。その値は、処理対象の操作です。

操作には2つのタイプがあります。

-

基本的な複数のラスター代数演算は、ユーザーのリデュース処理クラスの直前のリデュース・フェーズで実行されます。

-

複雑な複数のラスター代数演算は、マッピング・フェーズで実行されます。

2.5.6.1 基本的な複数のラスター代数演算

基本的な複数のラスター代数演算は、ジョブのリデュース・フェーズで実行されます。

これらは、モザイク操作または単なる処理要求とともに要求できます。モザイク操作とともに要求された場合、入力ラスターは同じMBR、ピクセル・サイズ、SRIDおよびデータ型を持つ必要があります。

モザイク操作を実行する場合、交差するピクセル(両方のラスターで同一のピクセル)のみが影響を受けます。

この操作が処理されるのは、マッピング四角形が出力データ・セットにまとめられ、(モザイク操作が要求された場合は)交差するピクセル値、または(モザイクが要求されていない場合は)すべてのピクセルが要求された操作に応じて変更される場合です。

ラスターがデータ・セットに追加される順序は、モザイク操作が要求された場合はモザイク操作の順序であり、それ以外の場合は、カタログ内の表示の順序です。

次の基本的な複数のラスター代数演算が使用可能です。

-

add: ラスター・シーケンスの同じセル内のすべてのピクセルを加算します。 -

substract: ラスター・シーケンスの同じセル内のすべてのピクセルを減算します。 -

divide: ラスター・シーケンスの同じセル内のすべてのピクセルを除算します。 -

multiply: ラスター・シーケンスの同じセル内のすべてのピクセルを乗算します。 -

min: ラスター・シーケンスの同じセル内のピクセルの最小値を割り当てます。 -

max: ラスター・シーケンスの同じセル内のピクセルの最大値を割り当てます。 -

mean: ラスター・シーケンスの同じセル内のすべてのピクセルの平均値を計算します。 -

and: ラスター・シーケンスの同じセル内のすべてのピクセルのバイナリ“and”演算を処理し、“and“演算によって結果にビットがコピーされます(両方のオペランドに存在する場合)。 -

or: ラスター・シーケンスの同じセル内のすべてのピクセルのバイナリ“or”演算を処理し、“or“演算によってビットがコピーされます(どちらかのオペランドに存在する場合)。 -

xor: ラスター・シーケンスの同じセル内のすべてのピクセルのバイナリ“xor”演算を処理し、“xor“演算によってビットがコピーされます(1つのオペランドに存在するが両方には存在しない場合)。

親トピック: 複数のラスター代数演算

2.5.6.2 複雑な複数のラスター代数演算

複雑な複数のラスター代数演算は、ジョブのマッピング・フェーズで実行され、ジョブはこの演算のみを処理できます。SRIDのサイズ変更、変更、またはカスタム・マッピングに対する要求は前に実行されている必要があります。このジョブの入力は、同じMBR、SRID、データ型およびピクセル・サイズを持つ一連のラスターです。

このジョブの四角形には、カタログ内のすべてのラスターの一部が含まれます。このため、すべてのマッパーがすべてのラスター内のセルの領域にアクセスでき、演算はそこで処理されます。結果として生成されたすべてのセルのピクセルはこのコンテキストで書き込まれるため、リデューサはリデューサ処理クラスを処理する前に結果を出力データ・セットに配置できます。

ラスターが演算を評価すると見なされる順序は、カタログ内に表示される順序です。

次の複雑な複数のラスター代数演算が使用可能です。

-

combine: ラスター・シーケンスの同じセル内の入力値の一意の組合せごとに一意の出力値を割り当てます。 -

majority: 最も多数のラスター・シーケンスの同じセル内の値を割り当てます。値が結合されている場合、右側の値が選択されます。 -

minority: 最も少数のラスター・シーケンスの同じセル内の値を割り当てます。値が結合されている場合、右側の値が選択されます。 -

variety: ラスター・シーケンスの同じセルごとに一意の値のカウントを割り当てます。 -

mask: 最初のラスターの値を使用してラスターを生成しますが、シーケンスの残りのラスター内の対応するピクセルが特定のマスク値に設定されているピクセルのみが含まれます。それ以外の場合は、0が設定されます。 -

inversemask: 最初のラスターの値を使用してラスターを生成しますが、シーケンスの残りのラスター内の対応するピクセルが特定のマスク値に設定されていないピクセルのみが含まれます。それ以外の場合は、0が設定されます。 -

equals: バイト・データ型でラスターを作成します。この場合、すべての入力ラスターに対応するセルが同じ値を持つ場合、セル値は1です。それ以外の場合は、0が設定されます。 -

unequal: バイト・データ型でラスターを作成します。この場合、すべての入力ラスターに対応するセルが異なる値を持つ場合、セル値は1です。それ以外の場合は、0が設定されます。 -

greater: バイト・データ型でラスターを作成します。この場合、最初のラスター内のセル値が、すべての入力ラスターに対応する残りのセル値より大きい場合、セル値は1です。それ以外の場合は、0が設定されます。 -

greaterorequal: バイト・データ型でラスターを作成します。この場合、最初のラスター内のセル値が、すべての入力ラスターに対応する残りのセル値以上である場合、セル値は1です。それ以外の場合は、0が設定されます。 -

less: バイト・データ型でラスターを作成します。この場合、最初のラスター内のセル値が、すべての入力ラスターに対応する残りのセル値より小さい場合、セル値は1です。それ以外の場合は、0が設定されます。 -

lessorequal: バイト・データ型でラスターを作成します。この場合、最初のラスター内のセル値が、すべての入力ラスターに対応する残りのセル値以下である場合、セル値は1です。それ以外の場合は、0が設定されます。

親トピック: 複数のラスター代数演算

2.5.7 Pyramids

Pyramidsは、異なるサイズと解像度でラスター・イメージまたはラスター・データを表すラスター・オブジェクトのサブオブジェクトです。

通常、サイズはアプリケーションが特にWeb経由でイメージを取得して表示するために必要な時間の長さに関連しています。つまり、イメージのサイズが小さければより速く表示できます。詳細な解像度が必要ない場合(たとえば、ユーザーがかなりズームアウトしている場合)は、小さいイメージの表示品質で十分です。

ピラミッドのレベルは、イメージの解像度の増減を表し、それぞれより多くのまたはより少ない記憶域が必要となります。(Big Data Spatial and Graphは、解像度を下げたピラミッドのみをサポートしています。)ピラミッド・レベルが0の場合は、元のラスター・データを示します。つまり、画像の解像度は下がっておらず、必要な記憶域は変わっていません。0(ゼロ)より大きい値は、イメージの解像度が下がり、記憶域の要件が低くなることを示します。

単一のラスターは各ピラミッド要求で処理され、次のパラメータが適用されます。

-

ピラミッド・レベル(必須): 最大減少レベル。つまり、元のオブジェクトより小さいサイズで作成するためのピラミッド・レベルの数です。たとえば、

redLevel="6"の場合は、レベル0から5のピラミッド・レベルが作成されます。各下位レベルのディメンション・サイズは、

r(n) = r(n - 1)/2およびc(n) = c(n - 1)/2となります。ここで、r(n)およびc(n)は、レベルnのピラミッドの行および列のサイズです最上位レベルの概要の行と列のディメンション・サイズの小さい方は、64と128 (最大に下げられた解像度レベル)の間です(

(int)(log2(a/64)))。ここで、aは元の行または列のディメンション・サイズの小さい方です。最大に下げられた解像度レベルより大きい

rLevel値が指定されている場合、rLevel値は最大に下げられた解像度レベルに設定されます。 -

再サンプリング・アルゴリズム: 使用する再サンプリング方法。

次のいずれかである必要があります:

NEAREST_NEIGHBOR、BILINEAR、AVERAGE4、AVERAGE16(BILINEARおよびAVERAGE4の効果は同じです。)再サンプリング・アルゴリズムが指定されていない場合は、デフォルトでBILINEARが使用されます。

ピラミッドは複数のラスターをロードする際や単一ラスターの処理中に作成できます。

-

HDFSでラスターをロードするときに、ローダー・コマンドライン・コールに

-pyramidパラメータを追加するか、APIloader.addPyramid()を使用します。 -

単一ラスターの処理の場合は、ユーザー要求XMLに操作を追加するか、API

processor.addPyramid()を使用します。

2.6 Oracle Spatial Hadoop Raster Processing APIを使用したイメージのロードおよび処理

このフレームワークでは、XMLを作成せずに、Javaアプリケーションを使用してラスターをロードし、処理するラスター処理APIが用意されています。このアプリケーションはクラスタ内またはリモート・ノード上で実行できます。

このAPIはフレームワーク操作へのアクセスが可能であり、WebサービスまたはスタンドアロンJavaアプリケーションに使用できます。

いずれかのジョブを実行するには、HadoopConfigurationオブジェクトを作成する必要があります。このオブジェクトは、ジョブの作成、ラスターの操作、およびジョブの実行に必要な構成情報(JARファイル名やGDALパスなど)の設定に使用されます。基本のロジックは次のとおりです。

//Creates Hadoop Configuration

HadoopConfiguration hadoopConf = new HadoopConfiguration();

//Assigns GDAL_DATA location based on specified SHAREDDIR, this data folder is required by gdal to look for data tables that allow SRID conversions

String gdalData = sharedDir + ProcessConstants.DIRECTORY_SEPARATOR + "data";

hadoopConf.setGdalDataPath(gdalData);

//Sets jar name for processor

hadoopConf.setMapreduceJobJar("hadoop-imageprocessor.jar");

//Creates the job

RasterProcessorJob processor = (RasterProcessorJob) hadoopConf.createRasterProcessorJob();

APIがリモート・ノードで使用されている場合は、Hadoop Configurationオブジェクトでプロパティを設定してクラスタに接続できます。次に例を示します。

//Following config settings are required for standalone execution. (REMOTE ACCESS)

hadoopConf.setUser("hdfs");

hadoopConf.setHdfsPathPrefix("hdfs://den00btb.us.oracle.com:8020");

hadoopConf.setResourceManagerScheduler("den00btb.us.oracle.com:8030");

hadoopConf.setResourceManagerAddress("den00btb.us.oracle.com:8032");

hadoopConf.setYarnApplicationClasspath("/etc/hadoop/conf/,/usr/lib/hadoop/*,/usr/lib/hadoop/lib/*," +

"/usr/lib/hadoop-hdfs/*,/usr/lib/hadoop-hdfs/lib/*,/usr/lib/hadoop-yarn/*," +

"/usr/lib/hadoop-yarn/lib/*,/usr/lib/hadoop-mapreduce/*,/usr/lib/hadoop-mapreduce/lib/* ");

ジョブは作成後、その実行のプロパティをジョブ・タイプに応じて設定する必要があります。ジョブ・クラスには、ラスターをHDFSにロードするRasterLoaderJob、およびそれを処理するRasterProcessorJobの2つがあります。

次の例では、ハワイのラスターをAPICALL_HDFSディレクトリにロードします。ここでは、共有フォルダにサムネイルを作成し、四角形のそれぞれの辺と重なる10ピクセルを指定します。

private static void executeLoader(HadoopConfiguration hadoopConf){

hadoopConf.setMapreduceJobJar("hadoop-imageloader.jar");

RasterLoaderJob loader = (RasterLoaderJob) hadoopConf.createRasterLoaderJob();

loader.setFilesToLoad("/net/den00btb/scratch/zherena/hawaii/hawaii.tif");

loader.setTileOverlap("10");

loader.setOutputFolder("APICALL");

loader.setRasterThumbnailFolder("/net/den00btb/scratch/zherena/processOutput");

try{

loader.setGdalPath("/net/den00btb/scratch/zherena/gdal/lib");

boolean loaderSuccess = loader.execute();

if(loaderSuccess){

System.out.println("Successfully executed loader job");

}

else{

System.out.println("Failed to execute loader job");

}

}catch(Exception e ){

System.out.println("Problem when trying to execute raster loader " + e.getMessage());

}

}

}次の例では、ロードしたラスターを処理します。

private static void executeProcessor(HadoopConfiguration hadoopConf){

hadoopConf.setMapreduceJobJar("hadoop-imageprocessor.jar");

RasterProcessorJob processor = (RasterProcessorJob) hadoopConf.createRasterProcessorJob();

try{

processor.setGdalPath("/net/den00btb/scratch/zherena/gdal/lib");

MosaicConfiguration mosaic = new MosaicConfiguration();

mosaic.setBands(3);

mosaic.setDirectory("/net/den00btb/scratch/zherena/processOutput");

mosaic.setFileName("APIMosaic");

mosaic.setFileSystem(RasterProcessorJob.FS);

mosaic.setFormat("GTIFF");

mosaic.setHeight(3192);

mosaic.setNoData("#FFFFFF");

mosaic.setOrderAlgorithm(ProcessConstants.ALGORITMH_FILE_LENGTH);

mosaic.setOrder("1");

mosaic.setPixelType("1");

mosaic.setPixelXWidth(67.457513);

mosaic.setPixelYWidth(-67.457513);

mosaic.setSrid("26904");

mosaic.setUpperLeftX(830763.281336);

mosaic.setUpperLeftY(2259894.481403);

mosaic.setWidth(1300);

processor.setMosaicConfigurationObject(mosaic.getCompactMosaic());

RasterCatalog catalog = new RasterCatalog();

Raster raster = new Raster();

raster.setBands(3);

raster.setBandsOrder("1,2,3");

raster.setDataType(1);

raster.setRasterLocation("/user/hdfs/APICALL/net/den00btb/scratch/zherena/hawaii/hawaii.tif.ohif");

catalog.addRasterToCatalog(raster);

processor.setCatalogObject(catalog.getCompactCatalog());

boolean processorSuccess = processor.execute();

if(processorSuccess){

System.out.println("Successfully executed processor job");

}

else{

System.out.println("Failed to execute processor job");

}

}catch(Exception e ){

System.out.println("Problem when trying to execute raster processor " + e.getMessage());

}

}前の例でモザイクの結果がHDFSに格納される場合は、サムネイルがオプションになります。JARファイルの処理が指定されている場合(追加のユーザー処理クラスが指定されている場合に使用)、このクラスを含むJARファイルの場所を指定する必要があります。モザイクを正しく生成するには、その他のパラメータが必要です。

処理APIを使用するいくつかの例については、/opt/oracle/oracle-spatial-graph/spatial/raster/examples/java/srcを参照してください。Javaクラスを確認し、その目的を理解します。これらは/opt/oracle/oracle-spatial-graph/spatial/raster/examples/java/cmdにあるそれぞれの例に示すスクリプトを使用して実行できます。

スクリプトを実行してその結果を検証した後、用意されているスクリプト/opt/oracle/oracle-spatial-graph/spatial/raster/examples/java/build.xmlを使用して、試験を実行し、コンパイルできるようにJavaソース・ファイルを変更します。/opt/oracle/oracle-spatial-graph/spatial/raster/jlib directoryへの書込みアクセスが可能であることを確認します。

2.7 Oracle Spatial Hadoop Raster Simulator Frameworkを使用したラスター処理のテスト

カスタム処理クラスを作成する場合、Oracle Spatial Hadoop Raster Simulator Frameworkを使用して、これらをOracle Raster Processing Frameworkにプラグインすることを「偽装」することにより、次を実行できます。

-

ローカル・コンピュータでのユーザー処理クラスの開発

-

ユーザー処理クラスをクラスタ内またはBig Data Lite内でデプロイして正しく機能するかどうかを検証する必要性の回避

-

ユーザー処理クラスのデバッグ

-

小さいローカルデータ・セットの使用

-

ローカル・デバッグ出力の作成

-

ユニット・テストの自動化

シミュレータ・フレームワークにより、ローカル環境内のロード・プロセスおよび処理プロセスがクラスタ内で実行されているかのように、これらがエミュレートされます。このため、必要なのは、1つ以上のラスターをロードしてXMLまたは構成オブジェクト内の仕様に応じてこれらを処理するJunitテスト・ケースを作成することのみです。

タイルは指定したブロック・サイズに応じて生成されるため、ブロック・サイズを設定する必要があります。実行するマッパーおよびリデューサの数は、通常のクラスタ実行の場合と同じように、タイルの数によって決まります。ロード・プロセス中に生成されるOHIFファイルは、HDFSが必要ないため、ローカル・ディレクトリに格納されます。

-

シミュレータ("モック")オブジェクト

-

ユーザーのローカル環境要件

-

ラスターをロードおよび処理するためのサンプル・テスト・ケース

シミュレータ("モック")オブジェクト

ラスターをロードし、処理可能な.OHIFファイルに変換するには、RasterLoaderJobMockを実行する必要があります。このクラス・コンストラクタは、ブロック・サイズ、ロード対象のディレクトリまたはラスター、OHIFファイルを格納するための出力ディレクトリ、およびgdalディレクトリを含める必要があるHadoopConfigurationを受け取ります。入力ファイルおよびユーザー構成を表すパラメータは、これらを指定する方法によって変化します。

-

カタログおよびユーザー構成XMLファイルの場所の文字列

-

カタログ・オブジェクト(

CatalogMock) -

構成オブジェクト(

MosaicProcessConfigurationMockまたはSingleProcessConfigurationMock) -

単一のラスター処理およびユーザー構成の場所(

MosaicProcessConfigurationMockまたはSingleProcessConfigurationMock)

ユーザーのローカル環境要件

テスト・ケースを作成する前に、ローカル環境を構成する必要があります。

-

1. ディレクトリにネイティブgdalライブラリ

gdal-dataおよびlibprojがあることを確認します。Linuxの場合:

-

「Cartographic Projections Libraryの取得およびコンパイル」の手順に従い

libproj.soを取得します。 -

クラスタまたはBigDataLite VM (

/opt/oracle/oracle-spatial-graph/spatial/raster/gdal)にあるSpatialインストールからgdalディストリビューションを取得します。 -

libproj.soを残りのネイティブgdalライブラリとともにgdal/libの下のローカルgdalディレクトリに移動します。

Windowsの場合:

-

クラスタまたはBigDataLite VM (

/opt/oracle/oracle-spatial-graph/spatial/raster/examples/java/mock/lib/gdal_windows.x64.zip)にあるSpatialインストールからgdalディストリビューションを取得します。 -

Visual Studioがインストールされていることを確認します。インストールする場合、「Common Tools for Visual C++」を選択していることを確認します。

-

PROJ 4ソース・コード、バージョン・ブランチ4.9をhttps://trac.osgeo.org/proj4jからダウンロードします。

-

Visual Studio開発者コマンド・プロンプトを開き、以下を入力します。

cd PROJ4/src_dir nmake /f makefile.vc -

proj.dllを残りのネイティブgdalライブラリとともにgdal/binの下のローカルgdalディレクトリに移動します。

-

-

GDALネイティブ・ライブラリをシステム・パスに追加します。

Linuxの場合: LD_LIBRARY_PATHを対応するネイティブgdalライブラリ・ディレクトリとともにエクスポートします。

Windowsの場合: Path環境変数にネイティブgdalライブラリ・ディレクトリを追加します。

-

JavaプロジェクトにJunitライブラリがあることを確認します。

-

Javaプロジェクトのクラスパス内に次のHadoop jarおよびOracle Image Processing Frameworkファイルが含まれることを確認します。これらは、Oracle BigDataLite VMまたはクラスタから取得できます。これらはすべて、Hadoopディストリビューションに含まれるjarです。特定のフレームワークのjarについては、

/opt/oracle/oracle-spatial-graph/spatial/raster/jlibを参照してください。(次のリストでは、

VERSION_INCLUDEDは、ファイルが含まれるHadoopインストールからのバージョン番号です。これは、BDAクラスタである場合やBigDataLite VMである場合があります。)commons-collections-VERSION_INCLUDED.jar commons-configuration-VERSION_INCLUDED.jar commons-lang-VERSION_INCLUDED.jar commons-logging-VERSION_INCLUDED.jar commons-math3-VERSION_INCLUDED.jar gdal.jar guava-VERSION_INCLUDED.jar hadoop-auth-VERSION_INCLUDED-cdhVERSION_INCLUDED.jar hadoop-common-VERSION_INCLUDED-cdhVERSION_INCLUDED.jar hadoop-imageloader.jar hadoop-imagemocking-fwk.jar hadoop-imageprocessor.jar hadoop-mapreduce-client-core-VERSION_INCLUDED-cdhVERSION_INCLUDED.jar hadoop-raster-fwk-api.jar jackson-core-asl-VERSION_INCLUDED.jar jackson-mapper-asl-VERSION_INCLUDED.jar log4j-VERSION_INCLUDED.jar slf4j-api-VERSION_INCLUDED.jar slf4j-log4j12-VERSION_INCLUDED.jar

ラスターをロードおよび処理するためのサンプル・テスト・ケース

Javaプロジェクトがテスト・ケース用として準備された後、ラスターのロードおよび処理をテストできます。

次の例では、setUpメソッドを使用してクラスを作成し、gdal、ロード対象のラスター、構成XMLファイル、出力サムネイル、ohifファイルおよび処理結果用のディレクトリを構成します。また、ブロック・サイズ(8 MB)も構成しています。(単一のコンピュータの場合はブロック・サイズを小さくすることをお薦めします。) /**

* Set the basic directories before starting the test execution

*/

@Before

public void setUp(){

String sharedDir = "C:\\Users\\zherena\\Oracle Stuff\\Hadoop\\Release 4\\MockTest";

String allAccessDir = sharedDir + "/out/";

gdalDir = sharedDir + "/gdal";

directoryToLoad = allAccessDir + "rasters";

xmlDir = sharedDir + "/xmls/";

outputDir = allAccessDir;

blockSize = 8;

}

次の例では、RasterLoaderJobMockオブジェクトを作成し、ロード対象のラスター、およびOHIFファイルの出力パスを設定します。

/**

* Loads a directory of rasters, and generate ohif files and thumbnails

* for all of them

* @throws Exception if there is a problem during load process

*/

@Test

public void basicLoad() throws Exception {

System.out.println("***LOAD OF DIRECTORY WITHOUT EXPANSION***");

HadoopConfiguration conf = new HadoopConfiguration();

conf.setBlockSize(blockSize);

System.out.println("Set block size of: " +

conf.getProperty("dfs.blocksize"));

RasterLoaderJobMock loader = new RasterLoaderJobMock(conf,

outputDir, directoryToLoad, gdalDir);

//Puts the ohif file directly in the specified output directory

loader.dontExpandOutputDir();

System.out.println("Starting execution");

System.out.println("------------------------------------------------------------------------------------------------------------");

loader.waitForCompletion();

System.out.println("Finished loader");

System.out.println("LOAD OF DIRECTORY WITHOUT EXPANSION ENDED");

System.out.println();

System.out.println();

}

次の例では、RasterProcessorJobMockオブジェクトに対するカタログおよびユーザー構成XMLファイルを指定します。catalog xmlがローカルOHIFファイルの正しい場所を指し示していることを確認します。

/**

* Creates a mosaic raster by using configuration and catalog xmls.

* Only two bands are selected per raster.

* @throws Exception if there is a problem during mosaic process.

*/

@Test

public void mosaicUsingXmls() throws Exception {

System.out.println("***MOSAIC PROCESS USING XMLS***");

HadoopConfiguration conf = new HadoopConfiguration();

conf.setBlockSize(blockSize);

System.out.println("Set block size of: " +

conf.getProperty("dfs.blocksize"));

String catalogXml = xmlDir + "catalog.xml";

String configXml = xmlDir + "config.xml";

RasterProcessorJobMock processor = new RasterProcessorJobMock(conf, configXml, catalogXml, gdalDir);

System.out.println("Starting execution");

System.out.println("------------------------------------------------------------------------------------------------------------");

processor.waitForCompletion();

System.out.println("Finished processor");

System.out.println("***********************************************MOSAIC PROCESS USING XMLS ENDED***********************************************");

System.out.println();

System.out.println();

RasterProcessorJobMockに対してサポートされている様々な構成を使用した追加例は、/opt/oracle/oracle-spatial-graph/spatial/raster/examples/java/mock/srcに用意されています。これらには、外部処理クラスを使用した例が含まれており、このクラスも組み込まれていて、デバッグすることもできます。

2.8 Oracle Big Data Spatial Raster Processing for Spark

Oracle Big Data Spatial Raster Processing for Apache Sparkは、Spatial Raster Processing API for Javaです。

このAPIでは、次の機能を使用して、一連のユーザー定義の処理フェーズの結果からイメージを組み合わせて新たに作成できます。

-

各ブロック・サイズ分割が個別の四角形として格納され、その後のそれぞれの処理に使用される、HDFSイメージ・ストレージ

-

処理を分割するためにSparkを使用して並行して処理されるサブセット、モザイクおよびラスター代数演算。

-

GDAL形式、複数帯域イメージ、DEM (数値標高モデル)、複数ピクセル深度、およびSRIDのサポート

2.8.1 Sparkラスター・ローダー

Spark Java API用のラスター処理を使用するには、最初にイメージをHDFSに保存し、次に各イメージをそれぞれ別のスマート・タイルに保存します。これにより、プロセッサを使用して各四角形を個別に処理できます。Sparkラスター・ローダーでは、単一イメージ、またはイメージのコレクションを並列でHDFSにインポートできるため、ロード時間を短縮できます。各ブロックにはすべてのラスター帯域のデータが含まれるため、特定のピクセルでその後処理が必要になった場合、その情報を単一ノードで処理できます。

Sparkラスター・ローダーの基本的なワークフローは、次のとおりです。

-

GDALを使用して、ラスターがインポートされ、ブロック・サイズに応じてこれらが四角形に分けられてから、各四角形がHDFSブロックとして格納されます。

-

ロード対象のラスターのセットが、

JavaRDDの拡張機能であるSpatialRasterJavaRDDに読み込まれます。このRDDは、帯域の数、ピクセル・サイズ、HDFSブロック・サイズおよびラスター解像度に基づいてラスターごとに作成される四角形の情報を表すImagePieceWritableオブジェクトのコレクションです。これは、Spatial Hadoopローダーで使用されるカスタム入力形式を使用することによって実現されます。 -

各四角形のラスター情報がロードされます。このロードは、各四角形のエグゼキュータによって実行されるため、読込みは並行して実行されます。それぞれの四角形は一定のバイト数(ユーザー入力)が重なっているため、隣接する四角形の領域にかかっています。Sparkエグゼキュータの数は、四角形の数、イメージ解像度、およびブロック・サイズに応じて“n”個になります。

-

RDDはキーによってグループ化されるため、同じラスターに対応する四角形はすべて同じレコードの一部になります。このRDDは、

OhifOutputFormatを使用してOHIFとして保存されます。このクラスは、エグゼキュータによってロードされた情報をすべてまとめ、そのイメージを解像度、帯域、オフセット、イメージ・データを含む特別な.ohif形式で格納します。これにより、それぞれの四角形を含むファイル・オフセットとノード場所が明らかになります。イメージを読み込み戻すには、特別な読込みプロセスが必要であり、このプロセスは、Spark SQLラスター・プロセッサに含まれています。

それぞれの四角形には、各帯域の情報が含まれます。これは、一部の四角形のみを処理し、それに対応するブロックのみをロードする場合に役立ちます。

ローダーは、コマンドラインでパラメータを設定するか、Spark APIを使用することにより、構成できます。

2.8.1.1 Sparkラスター・ローダーへの入力パラメータ

次の例は、spark-submitコマンドを使用して提供される入力パラメータを示します。

spark-submit

--class <DRIVER_CLASS>

--driver-memory <DRIVER_JVM>

--driver-class-path <DRIVER_CLASSPATH>

--jars <EXECUTORS_JARS>

<DRIVER_JAR>

-files <SOURCE_IMGS_PATH>

-out <HDFS_OUTPUT_FOLDER>

-gdal <GDAL_LIB_PATH>

-gdalData <GDAL_DATA_PATH>

[-overlap <OVERLAPPING_PIXELS>]

[-thumbnail <THUMBNAIL_PATH>]

[-expand <false|true>]

説明:

-

DRIVER_CLASSは、ドライバ・コードを持ち、Sparkによって実行されるクラスです。 -

DRIVER_JVMは、ドライバのJVMに割り当てるメモリーです。 -

DRIVER_CLASSPATHは、ドライバ・クラスのクラスパスで、jarはコロンによって区切られます。 -

EXECUTOR_JARSは、エグゼキュータに配布されるクラスパスで、jarはカンマによって区切られます。 -

DRIVER_JARは、Sparkによって実行される<DRIVER_CLASS>が含まれるjarです。 -

SOURCE_IMGS_PATHは、ソース・ラスターまたはフォルダのパスです。入力が複数の場合はカンマで区切ります。NFSを介してクラスタ内のすべてにアクセスできるパスを指定する必要があります。 -

HDFS_OUTPUT_FOLDERはロードしたイメージを格納するHDFS出力フォルダです。 -

OVERLAPPING_PIXELSはそれぞれの四角形の境界線上で重なるピクセルの任意の数であり、このパラメータが指定されていない場合、重なっている2つのピクセルのデフォルトが使用されます。 -

GDAL_LIB_PATHはGDALライブラリの場所を示すパスです。 -

GDAL_DATA_PATHはGDALデータ・フォルダの場所を示すパスです。NFSを介してクラスタ内のすべてにアクセスできるパスを指定する必要があります。 -

THUMBNAIL_PATHはロードしたイメージのサムネイルを格納する任意のパスです。NFSを介してクラスタ内のすべてにアクセスでき、Yarnユーザーの書込みアクセス権のあるパスを指定する必要があります。 -

-expandは、ロードされたラスターのHDFSパスによってソース・パス(すべてのディレクトリを含む)が拡張されるかどうかを制御します。これをfalseに設定すると、.ohifファイルは、(-oオプションを使用して指定された)出力ディレクトリに直接格納され、この場合、このラスター内のこのディレクトリのパスは含まれません。

それぞれの四角形には、各帯域の情報が含まれます。これは、一部の四角形のみを処理し、それに対応するブロックのみをロードする場合に役立ちます。

ローダーは、コマンドラインでパラメータを設定するか、Spark APIを使用することにより、構成できます。

親トピック: Sparkラスター・ローダー

2.8.1.2 Sparkラスター・ローダーの予想出力

Sparkラスター・ローダーに対する各出力イメージには、入力イメージごとに2つの出力ファイルがあります。

-

ソース・イメージのすべての四角形を集める

.ohifファイル。各四角形(HDFSブロックとして格納されます)は、処理エグゼキュータによって別のインスタンスとして処理される場合があります。.ohifファイルは、–expandが使用されなかった場合、/user/<USER_EXECUTING_JOB>/OUT_FOLDER/<PARENT_DIRECTORIES_OF_SOURCE_RASTER>の下にあるユーザー指定フォルダに、-outフラグを付けて格納されます。それ以外の場合、.ohifは/user/<USER_EXECUTING_JOB>/OUT_FOLDER/に配置され、このファイルはoriginal_filename.ohifとして識別できます。 -

イメージのすべてのピースをリストし、それぞれがカバーする座標を示す関連メタデータ・ファイル。このファイルは、

spatial_raster/metadataの場所にあるHDFSに置かれており、その名前は.ohifファイルの名前を使用してハッシュ生成されます。このファイルはOracle内部専用であり、ソース・ラスターの重要なメタデータをリストします。メタデータ・ファイルのサンプル行の一部は次のとおりです。size:3200,2112 srid:26904 datatype:1 resolution:27.90809458890406,-27.90809458890406 file:/user/hdfs/ohiftest/opt/shareddir/spatial/data/rasters/hawaii.tif.ohif bands:3 mbr:532488.7648166901,4303164.583549625,582723.3350767174,4269619.053853762 0,532488.7648166901,4303164.583549625,582723.3350767174,4269619.053853762 thumbnailpath:/opt/shareddir/spatial/thumb/

-thumbnailフラグが指定されている場合、ソース・イメージのサムネイルが関連フォルダに格納されます。これは.ohifファイルの変換を視覚化する方法の1つです。実行ログには、コマンドyarn logs -applicationId <applicationId>を使用してアクセスできます。

親トピック: Sparkラスター・ローダー

2.8.2 Spark SQLラスター・プロセッサ

イメージがHDFSにロードされたら、Spark SQLラスター・プロセッサを使用して処理できるようになります。モザイク定義XML構造またはSpark APIを使用して予想されるラスター出力機能を指定すると、モザイクUDFにより、四角形がその出力に適合するようフィルタおよび処理されます。ラスター代数演算はUDFで実行可能です。

Hadoopラスター処理フレームワークでも使用されるカスタムInputFormatは、ラスターSRIDおよび座標を使用して入力(モザイクの記述または単一のラスター)に基づいて特定のデータのブロックをロードし、処理操作を受け入れる前に最終出力に適合する帯域およびピクセルのみを選択します。

-

モザイク処理要求の場合、交差する四角形のみが選択され、これらの1つずつに分割が作成されます。

-

単一のラスター処理要求の場合、すべての四角形が選択され、これらの1つずつに分割が作成されます。

Spark SQLラスター・プロセッサを使用すると、四角形を表すすべての行とともに、入力カタログまたはラスターに基づいてOHIF四角形をフィルタしてDataframeにまとめ、Spatial UDF Spark機能を使用してこれらを処理できます。

簡略化されたSpark SQLラスター処理の擬似コード表現は、次のとおりです。

sqlContext.udf().register("localop", new LocalOperationsFunction(),DataTypes.createStructType(SpatialRasterJavaRDD.createSimpleTileStructField(dataTypeOfTileToProcess)));

tileRows.registerTempTable("tiles");

String query = "SELECT localop(tileInfo, userRequest, \"localnot\"), userRequest FROM tiles";

DataFrame processedTiles = sqlContext.sql(query);

Spark SQLラスター・プロセッサの基本的なワークフローは、以下のとおりです。

-

処理対象のラスターが最初に四角形メタデータにRDDとしてロードされます。ユーザーがモザイク操作用の構成を設定している場合、これらの四角形をフィルタできます。RDDは後で、2つの複雑な行のSpark DataFrameに変換されます。最初の行は、四角形のすべてのメタデータが含まれる

tileInfoで、2番目の行は、ラスタークライアントの予想される機能がリストされたユーザー入力構成が含まれるuserRequestです。 -

DataFrameが作成されたら、ドライバは、処理対象の問合せを実行する前に、“localop” UDFを登録するとともに、DataFrameも表として登録する必要があります。モザイクUDFを実行できるのは、ユーザーが必要なパラメータをすべて正しく構成した場合のみです。XMLが使用されておらず、APIを使用して構成が設定されている場合、

setExecuteMosaic(false)メソッドが設定されていない限り、デフォルトでは、モザイク操作構成が予想されます。 -

モザイク操作では、すべての四角形から出力に適合するピクセルのみを選択し、必要に応じて解像度を変更してモザイク出力に追加します。

-

問合せが実行されたら、エグゼキュータにより、データのローカル性を保ちながら、四角形に対応するデータがロードされ、指定したローカル・ラスター代数演算が実行されます。

-

DataFrame内の行が新しいピクセル・データを使用して更新され、後処理が必要になった場合のためにドライバに返されます。

-

処理が完了したら、DataFrameは、処理された四角形のMapReduce表現である

ImageBandWritableオブジェクトのリストに変換されます。これらは、ProcessedRasterCreatorに入力されます。ここでは、ローカル・ラスター代数演算および/またはモザイク操作の結果として生成されたバイトがまとめられ、ユーザーの要求に応じて最終的なラスターがHDFSまたは通常のファイル・システムに格納されます。

ユーザー構成入力のデータ型(ピクセル深度)と同じデータ型(モザイク深度)のイメージのみが該当します。ユーザーがモザイク出力に指定した座標と交差する四角形のみが含まれます。単一のラスター操作の場合、処理は完全なイメージに対して実行されるため、フィルタには、入力ラスターのすべての四角形が含まれます。

2.8.2.1 Spark SQLラスター・プロセッサへの入力パラメータ

次の例は、spark-submitコマンドを使用して提供される入力パラメータを示します。

spark-submit

--class <DRIVER_CLASS>

--driver-memory <DRIVER_JVM>

--driver-class-path <DRIVER_CLASSPATH>

--jars <EXECUTORS_JARS>

<DRIVER_JAR>

-config <MOSAIC_CONFIG_PATH>

-gdal <GDAL_LIBRARIES_PATH>

-gdalData <GDAL_DATA_PATH>

[-catalog <IMAGE_CATALOG_PATH>]

[-file <SINGLE_RASTER_PATH>]

説明:

-

DRIVER_CLASSは、ドライバ・コードを持ち、Sparkによって実行されるクラスです。 -

DRIVER_JVMは、ドライバのJVMに割り当てるメモリーです。 -

DRIVER_CLASSPATHは、ドライバ・クラスのクラスパスで、jarはコロンによって区切られます。 -

EXECUTOR_JARSは、エグゼキュータに配布されるクラスパスで、jarはカンマによって区切られます。 -

DRIVER_JARは、Sparkによって実行される<DRIVER_CLASS>が含まれるjarです。 -

MOSAIC_CONFIG_PATHは、出力の機能を定義するモザイク構成XMLへのパスです。 -

GDAL_LIBRARIES_PATHはGDALライブラリの場所を示すパスです。 -

GDAL_DATA_PATHはGDALデータ・フォルダの場所を示すパスです。NFSを介してクラスタ内のすべてにアクセスできるパスを指定する必要があります。 -

IMAGE_CATALOG_PATHは、処理対象のHDFSイメージをリストするカタログxmlへのパスです。–fileフラグを使用して処理する単一のラスターも指定できるため、これはオプションです。 -

SINGLE_RASTER_PATHは、ジョブによって処理される.ohifファイルへの任意のパスです。これが設定されている場合、カタログを設定する必要はありません。

次の例のコマンドは、testFS.xmlファイルに設定されているモザイク出力定義を使用して、カタログ・ファイルinputSPARK.xmlにリストされるすべてのファイルを処理します。

spark-submit --class oracle.spatial.spark.raster.test.SpatialRasterTest --driver-memory 2048m --driver-class-path /opt/oracle/oracle-spatial-graph/spatial/raster/jlib/hadoop-raster-fwk-api.jar:/opt/oracle/oracle-spatial-graph/spatial/raster/jlib/gdal.jar:/opt/oracle/oracle-spatial-graph/spatial/raster/jlib/hadoop-imageloader.jar:/opt/oracle/oracle-spatial-graph/spatial/raster/jlib/hadoop-imageprocessor.jar --jars /opt/oracle/oracle-spatial-graph/spatial/raster/jlib/hadoop-imageloader.jar,/opt/oracle/oracle-spatial-graph/spatial/raster/jlib/hadoop-imageprocessor.jar,/opt/oracle/oracle-spatial-graph/spatial/raster/jlib/gdal.jar /opt/oracle/oracle-spatial-graph/spatial/raster/jlib/spark-raster-fwk-api.jar -taskType algebra -catalog /opt/shareddir/spatial/data/xmls/inputSPARK.xml -config /opt/shareddir/spatial/data/xmls/testFS.xml -gdal /opt/oracle/oracle-spatial-graph/spatial/raster/gdal/lib –gdalData /opt/shareddir/data親トピック: Spark SQLラスター・プロセッサ

2.8.2.2 Spark SQLラスター・プロセッサの予想出力

Spark処理の場合、ファイル・システムの出力のみがサポートされています。つまり、生成された出力は、指定されたファイル名およびタイプを持つイメージであり、通常のFileSystemに格納されます。

ジョブ実行ログには、コマンドyarn logs -applicationId <applicationId>を使用してアクセスできます。

親トピック: Spark SQLラスター・プロセッサ

2.8.3 Sparkラスター処理APIの使用

SparkラスターAPIを使用して、ドライバ・クラスを作成することによってラスターをロードおよび処理できます。

一部のクラス例は、/opt/oracle/oracle-spatial-graph/spatial/raster/examples/java/srcの下に用意されています。また、/opt/oracle/oracle-spatial-graph/spatial/raster/examples/java/cmdディレクトリにも、これらの例をコマンドラインから実行するためのスクリプトが含まれています。

スクリプトを実行してその結果を検証した後、用意されているスクリプト/opt/oracle/oracle-spatial-graph/spatial/raster/examples/java/build.xmlを使用して、試験を実行し、コンパイルできるようにJavaソース・ファイルを変更できます。/opt/oracle/oracle-spatial-graph/spatial/raster/jlibへの書込みアクセスが可能であることを確認します。

GDALが適切に機能するように、$LD_LIBRARY_PATHを使用してライブラリを使用可能にする必要があります。ジョブを実行する前に、共有ライブラリ・パスがシェル・ウィンドウに適切に設定されていることを確認してください。次に例を示します。

export LD_LIBRARY_PATH=$ALLACCESSDIR/gdal/native

2.8.3.1 Sparkラスター・ローダーAPIの使用

イメージ・ロードを実行するには、SpatialRasterLoaderオブジェクトを作成する必要があります。このオブジェクトを使用して、実行に必要な構成情報を設定します。インスタンスの作成には2つの方法があります。

-

コマンドラインから受け取った引数の配列をパラメータとして送信します。次に例を示します。

//args is the String[] received from command line SpatialRasterLoader core = new SpatialRasterLoaderCore(args); -

このトピックの対象であるAPIを使用してドライバ・クラス内で直接構成します

ローダーAPIを使用して、GDALライブラリ・パスを設定します。これにより、SparkContextおよび対応するHadoop構成が内部的に初期化されるためです。次に例を示します。

SpatialRasterLoader core = new SpatialRasterLoader();

core.setGdalLibrary("/opt/sharedddir/spatial/gdal");

core.setFilesToLoad("/opt/shareddir/spatial/rasters");

core.setHDFSOutputDirectory("ohifsparktest");

core.setGdalData("/opt/shareddir/data");

core.setOverlap("20");

core.setThumbnailDirectory("/opt/shareddir/spatial/");

関連するラスターの最も一般的なサイズに応じて、ブロック・サイズを必要に応じて変更できます。たとえば、クラスタのHDFSのブロック・サイズがデフォルトでは大きすぎるときに(256MBなど)、ユーザー・ラスターの平均サイズが64MBである場合、ピクセルによってブロックが埋められていなくてもHDFS内のブロックがすべての四角形によって占有されるため、実際のデータが含まれないHDFS空間の使用は避ける必要があります。このシナリオでは、次の例のように、ブロック・サイズを64MBに変更できます。

JavaSparkContext sc = core.getRasterSparkContext();

core.getHadoopConfiguration().set("dfs.blocksize", "67108864");

ローダーを実行するには、ラスターのロードが成功した場合はtrueを返し、失敗した場合はfalseを返すloadRastersメソッドを使用します。次に例を示します。

if (core.loadRasters(sc, StorageLevel.DISK_ONLY())) {

LOG.info("Successfully loaded raster files");

}

処理が正常に終了した場合、OHIFファイルはHDFS内に格納され、対応するサムネイルは、ユーザー検証のために指定されたディレクトリに格納されます。

親トピック: Sparkラスター処理APIの使用

2.8.3.2 Spark SQLプロセッサAPIを使用するための構成

プロセッサを実行するには、SpatialRasterProcessorオブジェクトを作成し、実行に必要な構成情報を設定する必要があります。インスタンスの作成には2つの方法があります。

-

コマンドラインから受け取った引数の配列をパラメータとして送信します。次に例を示します。

//args is the String[] received from command line SpatialRasterProcessor processor = new SpatialRasterProcessor(args); -

このトピックの対象であるAPIを使用してドライバ・クラス内で直接構成します

ローダーAPIを使用して、GDALライブラリ・パスを設定します。これにより、SparkContextおよび対応するHadoop構成が内部的に初期化されるためです。次に例を示します。

SpatialRasterProcessor processor = new SpatialRasterProcessor();

processor.setGdalLibrary("/opt/sharedddir/spatial/gdal");

processor.setGdalData("/opt/sharedddir/spatial/data");

処理対象のラスターを指定します。

-

処理するラスターのカタログの追加については、モザイク操作を実行する場合は特に、次の例を考慮してください。

String ohifPath = "ohifsparktest/opt/shareddir/spatial/data/rasters"); //Creates a catalog to list the rasters to process RasterCatalog catalog = new RasterCatalog(); //Creates a raster object for the catalog Raster raster = new Raster(); //raster of 3 bands raster.setBands(3); //the tree bands will appear in order 1,2,3. You may list less bands here. raster.setBandsOrder("1,2,3"); //raster data type is byte raster.setDataType(1); raster.setRasterLocation(ohifPath + "hawaii.tif.ohif"); //Add raster to catalog //catalog.addRasterToCatalog(raster); Raster rasterKahoolawe = new Raster(); rasterKahoolawe.setBands(3); rasterKahoolawe.setBandsOrder("1,2,3"); rasterKahoolawe.setDataType(1); rasterKahoolawe.setRasterLocation(ohifPath + "kahoolawe.tif.ohif"); catalog.addRasterToCatalog(rasterKahoolawe); //Sets the catalog to the job processor.setCatalogObject(catalog.getCompactCatalog()); -

単一のラスターの処理については、次の例を考慮してください。

String ohifPath = "ohifsparktest/opt/shareddir/spatial/data/rasters"); //Set the file to process to the job processor.setFileToProcess(ohifPath + "NapaDEM.tif.ohif");*/

出力ラスターの詳細を定義するユーザー構成要求を設定します。

-

モザイク操作を実行する場合、予想される出力のすべての機能(座標を含む)をMosaicConfigurationオブジェクトに設定する必要があります。次の例では、以前にカタログに追加されたハワイのラスターが両方とも含まれるラスターを作成します。

MosaicConfiguration mosaic = new MosaicConfiguration(); mosaic.setFormat("GTIFF"); mosaic.setBands(3); mosaic.setFileSystem(RasterProcessorJob.FS); mosaic.setDirectory("/opt/shareddir/spatial/processtest"); mosaic.setFileName("HawaiiIslands"); mosaic.setHeight(986); //value for pixels where there is no data, starts with #, followed by //two characters per band mosaic.setNoData("#FFFFFF"); //byte datatype mosaic.setPixelType("1"); //width for pixels in X and Y mosaic.setPixelXWidth(280.388143); mosaic.setPixelYWidth(-280.388143); mosaic.setSrid("26904"); //upper left coordinates mosaic.setUpperLeftX(556958.985610); mosaic.setUpperLeftY(2350324.082505); mosaic.setWidth(1600); mosaic.setOrderAlgorithm(ProcessConstants.ALGORITHM_FILE_LENGTH); mosaic.setOrder(RasterProcessorJob.DESC); //mosaic configuration must be set to the job processor.setUserRequestConfigurationObject(mosaic.getCompactMosaic()); -

モザイク操作を実行しない場合は、より簡単な構成が必要です。次に例を示します。

MosaicConfiguration mosaic = new MosaicConfiguration(); mosaic.setExecuteMosaic(false); mosaic.setBands(1); mosaic.setLayers("1"); mosaic.setDirectory("/opt/shareddir/spatial/processtest"); mosaic.setFileSystem(RasterProcessorJob.FS); mosaic.setNoData("#00");

この時点で、必要な構成がすべて完了しました。これで、処理を開始できます。

親トピック: Sparkラスター処理APIの使用

2.8.3.3 DataFrameの作成

ラスターに対して問合せを実行する前に、すべての行が分割を表しているDataFrameにこれらをロードする必要があります。これらの分割はまとめて四角形のSpatialJavaRDDとして作成され、これがDataFrameに変換されます。使用可能なJVMランタイム・メモリーに応じて、DataFrameをメモリーまたはディスクにキャッシュすることをお薦めします。ディスクにキャッシュする場合、SparkインストールにKryoが使用されている必要があります。

DataFrameは、tileInfoとuserRequestという2つの複雑な列で構成されています。

-

tileInfo: ピクセル情報だけでなくメタデータの詳細を含む、すべての四角形に関するデータ。表2-2 tileInfo列データ

列 データ型 NULL値可能 説明 dstWidthSize

Integer

False

幅

dstHeightSize

Integer

False

高さ

bands

Integer

False

帯域の数

dType

Integer

False

データ型

piece

Integer

False

ソース・ラスター内のピース合計のピース数

offX

Integer

False

X内のオフセット

offY

Integer

False

Y内のオフセット

sourceWidth

Integer

False

ソース・ラスターの幅

sourceHeight

Integer

False

ソース・ラスターの高さ

bytesNumber

Integer

False

バイトの数

baseArray

[[Pixel DataType]]

False

ピクセルの配列(帯域ごとに1つ)

basePaletteArray

[[整数]]

True

パレット解釈の配列(ラスターに含まれる場合、帯域ごとに1つ)

baseColorArray

[Integer]

False

色の配列(帯域ごとに1つ)

noDataArray

[Double]

False

NODATA値の配列(帯域ごとに1つ)

Overlap

Integer

False

重なるピクセルの数

leftOv

Byte

False

左側に重なるピクセルがあるかどうかを示すフラグ

rightOv

Byte

False

右側に重なるピクセルがあるかどうかを示すフラグ

upOv

Byte

False

上側に重なるピクセルがあるかどうかを示すフラグ

downOv

Byte

False

下側に重なるピクセルがあるかどうかを示すフラグ

projectionRef

String

False

予測参照

geoTransform

[Double]

False

地理変換配列

Metadata

[String]

False

場所メタデータ

lastModified

Long

False

ソース・ラスターの最終変更日

imageLength

Double

False

ソース・ラスターの長さ

dataLength

Integer

True

モザイク後のバイトの数

xCropInit

Integer

True

モザイク後のX内の開始ピクセル

yCropInit

Integer

True

モザイク後のY内の開始ピクセル

xCropLast

Integer

True

モザイク後のX内の終了ピクセル

yCropLast

Integer

True

モザイク後のY内の終了ピクセル

catalogOrder

Integer

False

カタログ内の順序

baseMountPoint

String

False

ソース・ラスターのパス

sourceResolution

String

False

ソース・ラスターの解像度

extraFields

[String]

True

その他のフィールド・マップ、NA

-

userRequest: 予想される出力ラスター機能が定義されているユーザー要求構成。表2-3 userRequest列データ

列 データ型 NULL値可能 説明 offset

Long

False

オフセット

piece

Integer

False

ピース数

splitSize

Long

False

分割サイズ

bandsToAdd

String

False

出力に含める帯域(“1,2,3”など)

upperLeftX

Double

True

モザイクの要求時に使用されるXの左上の出力の座標

upperLeftY

Double

True

モザイクの要求時に使用されるYの左上の出力の座標

lowerRightX

Double

True

モザイクの要求時に使用されるXの右下の出力の座標

lowerRightY

Double

True

モザイクの要求時に使用されるYの右下の出力の座標

width

Integer

True

モザイクが要求されたときに使用される出力の幅

height

Integer

True

モザイクが要求されたときに使用される出力の高さ

srid

String

True

モザイクが要求されたときに使用される出力のSRID

order

String

True

モザイクが要求されたときに使用される出力の順序(昇順または降順)

format

String

True

モザイクが要求されたときに使用される出力のGDAL形式

noData

String

False

出力のNODATA値(#の後ろに帯域当たり2桁の数値、たとえば、3帯域出力の場合は“#000000”)

pixelType

String

True

モザイクが要求されたときに使用される出力のGDALデータ型

Directory

String

False

出力ディレクトリ

pixelXWidth

Double

True

モザイクが要求されたときに使用される出力のピクセルの幅

pixelYWidth

Double

True

モザイクが要求されたときに使用される出力のピクセルの高さ

wkt

String

False

ソース予測参照

mosaicWkt

String

True

モザイクが要求されたときに使用される出力の予測参照

processingClasses

String

True

実行対象のユーザー処理クラス(Sparkではまだサポートされていません)

reducingClasses

String

True

実行対象のユーザー・リデュース・クラス(Sparkではまだサポートされていません)

tempOut

String

True

HDFS出力が要求された場合の一時出力フォルダ(Sparkではまだサポートされていません)

filename

String

False

出力のファイル名

contextId

String

False

実行コンテキストID

sourceResolution

String

False

ソース・ラスターの解像度

catalogOrder

Integer

False

カタログ内のソース・ラスターの順序

executeMosaic

Boolean

False

モザイク操作が要求されたかどうかを示すフラグ

次の例では、DataFrameを作成し、これに関する情報を表示します。

JavaSparkContext sc = processor.getRasterSparkContext();

SpatialRasterJavaRDD<GeneralInfoWritable> spatialRDD = processor.getProcessSplits();

HiveContext sqlContext = new HiveContext(sc.sc());

DataFrame tileRows = spatialRDD.createSpatialTileDataFrame(sqlContext, StorageLevel.DISK_ONLY());

Row[] rows = tileRows.collect();

System.out.println("First Tile info: ");

System.out.println("Width " + rows[0].getStruct(0).getInt(0));

System.out.println("Height " + rows[0].getStruct(0).getInt(1));

System.out.println("Total width " + rows[0].getStruct(0).getInt(7));

System.out.println("Total height " + rows[0].getStruct(0).getInt(8));

System.out.println("File " + rows[0].getStruct(0).getString(30));

System.out.println("First Tile User request data: ");

System.out.println("Bands to add " + rows[0].getStruct(1).getString(3));親トピック: Sparkラスター処理APIの使用

2.8.3.4 ラスター代数演算用のSpark SQLの使用

Spark UDF localopを使用すると、Hadoopイメージ・プロセッサを使用してイメージを処理するために、「地図代数演算」で説明されているラスター代数演算を実行できます。Spark SQL UDF用の演算名およびサポート対象のデータ型は、Hadoopの場合と同じです

任意の問合せが実行される前に、ドライバ・クラスでは、UDFを登録するとともに、四角形のDataFrameを一時表として登録する必要があります。次に例を示します。

sqlContext.udf().register("localop", new LocalOperationsFunction(),

DataTypes.createStructType(SpatialRasterJavaRDD.createSimpleTileStructField(dataTypeOfTileToProcess)));

tileRows.registerTempTable("tiles");

これで、localop UDFが登録され、使用する準備が整いました。この関数は、2つのパラメータを受け取ります。

-

tileInfo行 -

実行対象のラスター代数演算が含まれる文字列。同じ問合せ内で複数の演算を実行でき、これらはセミコロンで区切る必要があります。パラメータを受け取る演算の場合、これらをカンマで区切る必要があります。

この関数により、問合せに送信されたtileInfoが返されますが、これとともに、実行された演算に基づいて更新されたピクセル・データも返されます。

以下に、様々な演算の実行の例を示します。

String query = "SELECT localop(tileInfo, \"localnot\"),

userRequest FROM tiles";

String query = "SELECT localop(tileInfo,\"localadd,456;localdivide,2;

localif,>,0,12;localmultiply,20;

localpow,2;localsubstract,4;

localsqrt;localacos\"),

userRequest FROM tiles";

String query = "SELECT localop(tileInfo,\"localnot;localatan;localcos;

localasin;localtan;localcosh;

localtanh\"), userRequest FROM tiles";

問合せを実行するには、以下を入力します。

DataFrame cachedTiles = processor.queryAndCache(query, sqlContext);この新しいDataFrameには、更新されたピクセルがあります。必要に応じて、特定の四角形のコンテンツをTIFファイルとして保存でき、このファイル内でこの四角形は構成済の出力ディレクトリ内に格納されます。次に例を示します。

Row[] pRows = cachedTiles.collect();

processor.debugTileBySavingTif(pRows[0],

processor.getHadoopConfiguration());

モザイク操作を実行するには、最初に任意のラスター代数演算を実行してから、モザイク操作を実行します。新しいSpark UDFがモザイク操作に使用されます。これは、tileInfoおよびuserRequest列を受け取り、モザイクに適合するよう更新されたtileInfoを返します。次に例を示します。

sqlContext.udf().register("mosaic", new MosaicFunction(),

DataTypes.createStructType(SpatialRasterJavaRDD.createSimpleTileStructField(dataTypeOfTileToProcess)));

cachedTiles.registerTempTable("processedTiles");

String queryMosaic = "SELECT mosaic(tileInfo, userRequest), userRequest

FROM processedTiles";

DataFrame mosaicTiles = processor.queryAndCache(queryMosaic,

sqlContext);

処理が完了したら、内部操作用の一時HDFSディレクトリ、マージ対象のDataFrame、およびSparkコンテキストをHadoop構成から受け取るProcessedRasterCreatorを使用することにより、四角形を出力ラスターにまとめることができます。これにより、指定した出力ディレクトリ内に予想される出力ラスターが作成されます。次に例を示します。

try {

ProcessedRasterCreator creator = new ProcessedRasterCreator();

creator.create(new Text("createOutput"), mosaicTiles,

sc.hadoopConfiguration());

LOG.info("Finished");

} catch (Exception e) {

LOG.error("Failed processor job due to " + e.getMessage());

throw e;

}

親トピック: Sparkラスター処理APIの使用

2.9 Oracle Big Data Spatial Vector Analysis

Oracle Big Data Spatial Vector AnalysisはSpatial Vector Analysis APIであり、Hadoopジョブとして実行され、HDFSに格納されているデータの空間処理のためのMapReduceコンポーネントを提供します。

これらのコンポーネントでは、Spatial Java APIを利用して空間分析タスクを実行します。このAPIには、Webコンソールも用意されています。

- 複数のHadoop APIのサポート

- 空間の索引付け

- MVSuggestの使用

- 空間のフィルタ処理

- データの階層分類

- バッファの生成

- 空間のビニング

- 空間のクラスタ化

- 空間の結合

- 空間のパーティション化

- RecordInfoProvider

- HierarchyInfo

- MapReduceジョブでのJGeometryの使用

- 異なるデータ・ソースのサポート

- ジョブ・レジストリ

- Vector Analysis APIを使用したジョブ実行時間のパフォーマンス・データのチューニング

関連項目:

次の情報を参照し、実装について詳しく理解してください。

2.9.1 複数のHadoop APIのサポート

Oracle Big Data Spatial Vector Analysisには、新旧両方の(コンテキスト・オブジェクト) Hadoop API用のクラスが用意されています。通常、mapredパッケージ内のクラスが古いAPIとともに使用され、mapreduceパッケージ内のクラスが新しいAPIとともに使用されます

このガイドの例では古いHadoop APIを使用しますが、すべての古いHadoop Vector APIクラスが新しいAPI内に同等のクラスを持ちます。たとえば、古いクラスであるoracle.spatial.hadoop.vector.mapred.job.SpatialIndexingは、oracle.spatial.hadoop.vector.mapreduce.job.SpatialIndexingという名前の新しい同等のクラスを持ちます。通常、別途記述がない限り、新しいHadoop API Vectorクラスを使用するには、mapredからmapreduceに変更するだけですみます。

mapredまたはmapreduceパッケージに含まれていないoracle.spatial.hadoop.vector.RecordInfoなどのクラスには、両方のHadoop APIとの互換性があります。

2.9.2 空間の索引付け

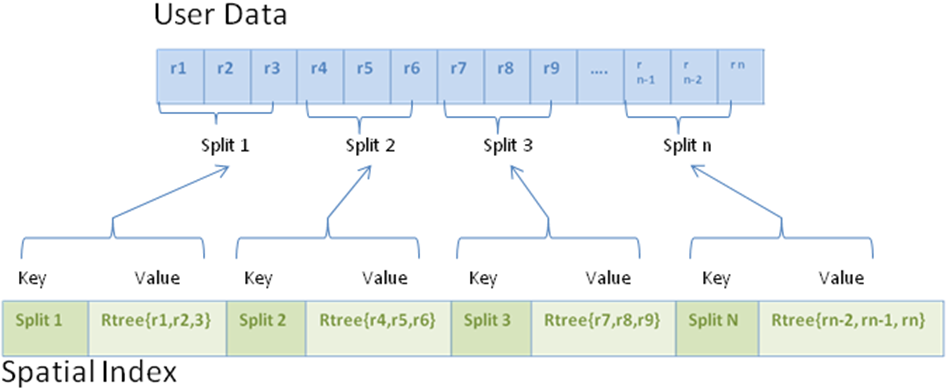

空間の索引付けは、キー/値ペアの形式をとり、Hadoop MapFileとして生成されます。それぞれのMapFileエントリには、元のデータの分割の1つに対する空間索引付けが含まれます。キー/値ペアには次の情報が含まれます。

-

キー: パス + 開始オフセット + 長さの形式の分割識別子。

-

値: 実際に索引付けしたレコードを含む空間索引の構造。

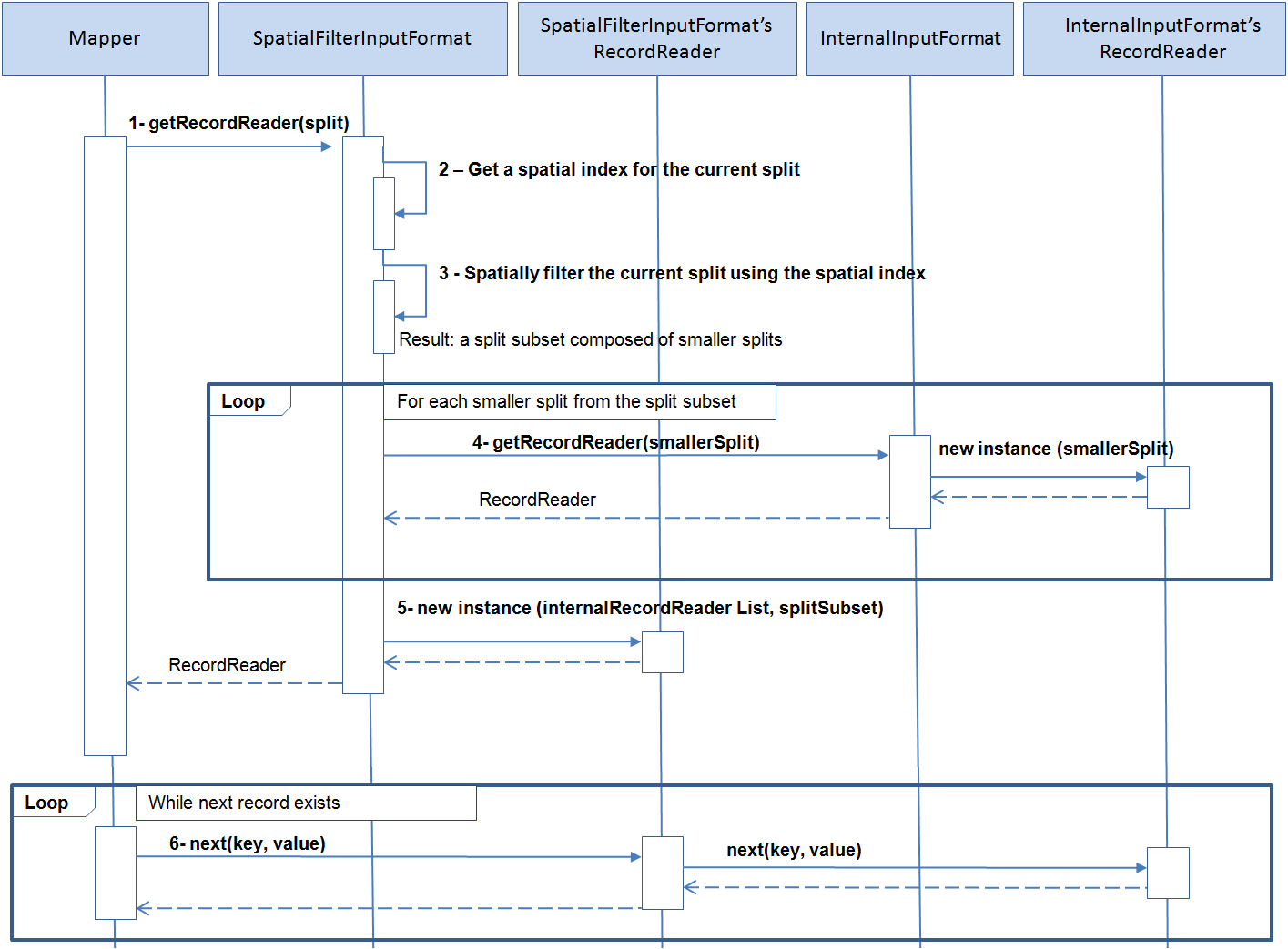

次の図は、ユーザー・データに関連する空間索引を表します。レコードはr1、r2、のように表現されます。レコードは分割(Split 1、Split 2、Split 3、Split n)ごとにまとめられます。それぞれの分割にはキー/値ペアがあり、キーは分割を表し、値はその分割のレコード上にあるRtree索引を表します。

2.9.2.1 空間の索引付けクラスの構造

空間の索引付けのレコードは、クラスoracle.spatial.hadoop.vector.RecordInfoを使用して表現されます。RecordInfoには通常、元のレコード・データのサブセット、およびレコードが格納されているファイル内でレコードを特定する方法が含まれています。それぞれのRecordInfoデータは次の2つに応じて異なります。

-

データの読取りに使用する

InputFormat -

レコードのデータを提供する

RecordInfoProvider実装

RecordInfoには次のフィールドが含まれています。

-

Id: レコードIDを含むテキスト・フィールド。

-

Geometry: レコード・ジオメトリのある

JGeometryフィールド。 -

Extra fields: その他の任意のレコード・フィールドを名前/値ペアとして追加できます。値は常にテキストで表現されます。

-

Start offset: バイト・オフセットとしてのファイル内のレコードの位置。この値は元のデータを読み取る

InputFormatによって異なります。 -

Length: 元のレコードの長さ(バイト単位)。

-

Path: ファイル・パスはオプションで追加できます。ファイル・パスは空間の索引付けエントリ・キーとして把握できるため、これはオプションです。ただし、空間索引を作成するときに

RecordInfoインスタンスへのパスを追加するには、構成プロパティoracle.spatial.recordInfo.includePathFieldキーの値がtrueに設定されます。

親トピック: 空間の索引付け

2.9.2.2 空間索引を作成する構成

空間索引はFileSplitInputFormat、SpatialIndexingMapper、InputFormat、およびRecordInfoProviderを組み合せて作成されますが、この最後の2つはユーザーが提供します。次のコードの例は、HDFSフォルダ/user/dataで特定されたデータの空間索引を作成するジョブを実行するために必要な構成の一部を示します。

//input

conf.setInputFormat(FileSplitInputFormat.class);

FileSplitInputFormat.setInputPaths(conf, new Path("/user/data"));

FileSplitInputFormat.setInternalInputFormatClass(conf, GeoJsonInputFormat.class);

FileSplitInputFormat.setRecordInfoProviderClass(conf, GeoJsonRecordInfoProvider.class);

//output

conf.setOutputFormat(MapFileOutputFormat.class);

FileOutputFormat.setOutputPath(conf, new Path("/user/data_spatial_index"));

//mapper

conf.setMapperClass(SpatialIndexingMapper.class);

conf.setOutputKeyClass(Text.class);

conf.setOutputValueClass(RTreeWritable.class);

この例では次のとおりです。

-

FileSplitInputFormatはジョブInputFormatとして設定されています。FileSplitInputFormatは、データを読み取るための別のInputFormat実装(internalInputFormat)を使用する抽象クラスであるCompositeInputFormat(新しいHadoop APIバージョン内のWrapperInputFormat)のサブクラスです。内部InputFormatおよびRecordInfoProvider実装はユーザーによって指定され、それぞれGeoJsonInputFormatおよびGeoJsonRecordInfoProviderに設定されます。 -

MapFileOutputFormatは、MapFileを生成するためにOutputFormatとして設定されます -

マッパーは

SpatialIndexingMappperに設定されます。マッパー出力キーおよび値のタイプは、Text(分割識別子)およびRTreeWritable(実際の空間索引)です。 -

リデューサ・クラスが指定されていないため、デフォルトのリデューサで実行されます。出力MapFileキーをソートするには、リデュース・フェーズが必要です。

また、この構成は、oracle.spatial.hadoop.vector.mapred.job.SpatialIndexingクラスを使用すると設定が容易になります。SpatialIndexingは空間索引を作成するジョブ・ドライバです。次の例では、SpatialIndexingインスタンスが作成および設定され、configure()メソッドを呼び出してジョブ構成への設定の追加に使用されます。構成が設定されると、ジョブが開始されます。

SpatialIndexing<LongWritable, Text> spatialIndexing = new SpatialIndexing<LongWritable, Text>();

//path to input data

spatialIndexing.setInput("/user/data");

//path of the spatial index to be generated

spatialIndexing.setOutput("/user/data_spatial_index");

//input format used to read the data

spatialIndexing.setInputFormatClass(TextInputFormat.class);

//record info provider used to extract records information

spatialIndexing.setRecordInfoProviderClass(TwitterLogRecordInfoProvider.class);

//add the spatial indexing configuration to the job configuration

spatialIndexing.configure(jobConf);

//run the job

JobClient.runJob(jobConf);親トピック: 空間の索引付け

2.9.2.3 空間索引メタデータ

作成されるすべての空間索引にメタデータ・ファイルが生成されます。空間索引メタデータを使用すると、索引付きレコードの数、索引付きデータの最小外接矩形(MBR)、および空間索引と索引付きソース・データの両方のパスなど、空間索引に関連する情報を簡単に検索できます。空間索引メタデータは、空間索引名を使用して取得できます。

空間索引メタデータ・ファイルには、次の情報が含まれます。

-

空間索引名

-

空間索引へのパス

-

索引付きレコードの数

-

ローカル索引の数

-

索引付きレコードに含まれる追加フィールド

-

SRID、次元、許容差、境界、およびジオメトリが測地であるかどうかの是非などのジオメトリ・レイヤー情報

-

各ローカル空間索引ファイルに関する次の情報: 索引付きデータへのパス、ローカル索引へのパス、および索引付きデータのMBR

SpatialIndexingクラスを使用して空間索引を作成する場合、次のメタデータ・プロパティを設定できます。

-

indexName: 空間索引の名前。設定されていない場合、出力フォルダ名が使用されます。 -

metadataDir: メタデータ・ファイルの格納先のディレクトリへのパス。-

デフォルトでは、ユーザー・ディレクトリへの相対パスである

oracle_spatial/index_metadataに格納されます。ユーザーがhdfsである場合は、/user/hdfs/oracle_spatial/index_metadataになります。

-

-

overwriteMetadata:trueに設定すると、現在のmetadataDir内で同じindexNameを持つ空間索引に対して空間索引メタデータ・ファイルがすでに存在する場合、この空間索引メタデータが上書きされます。falseに設定し、現在のmetadataDir内で同じindexNameを持つ空間索引に対して空間索引メタデータ・ファイルがすでに存在する場合、エラーが発生します。

次の例では、メタデータ・ディレクトリおよび空間索引名を設定し、索引がすでに存在する場合は既存の任意のメタデータを上書きするよう指定します。

spatialIndexing.setMetadataDir("/user/hdfs/myIndexMetadataDir");

spatialIndexing.setIndexName("testIndex");

spatialIndexing.setOverwriteMetadata(true);

indexNameのみを指定するとともに、必要に応じて索引メタデータがあるindexMetadataDirを指定することにより、既存の空間索引を他のジョブに渡すことができます。索引名が提供されている場合、空間索引パスや入力形式を指定する必要はありません。

次のジョブ・ドライバは、indexNameをパラメータとして受け取ります。

-

oracle.spatial.hadoop.vector.mapred.job.Categorization -

oracle.spatial.hadoop.vector.mapred.job.SpatialFilter -

oracle.spatial.hadoop.vector.mapred.job.Binning -

oracle.spatial.hadoop.vector.InputDataSetを受け取るドライバ(SpatialJoinやPartitioningなど)

索引名がindexMetadataDirパスで見つからない場合、空間索引が見つからなかったことを示すエラーがスローされます。

次の例は、ビニング・ジョブの入力データ・セットとして設定されている空間索引を示します。

Binning binning = new Binning();

binning.setIndexName("indexExample");

binning.setIndexMetadataDir("indexMetadataDir");

親トピック: 空間の索引付け

2.9.2.4 空間索引の入力形式

InputFormatは次のサポート対象の要件と一致している必要があります。

-

FileInputFormatのサブクラスであること。 -

getSplits()メソッドがFileSplitまたはCombineFileSplit分割タイプを返すこと。 -

古いHadoop APIの場合、

RecordReaderのgetPos()メソッドが現在の位置を返し、空間索引のレコードをユーザー・ファイルの元のレコードにトラック・バックすること。現在の位置が返されない場合、空間索引では元のレコードが見つかりません。ただし、空間索引は引き続き作成でき、元のレコードの読取りを必要としない操作に使用できます。たとえば、他のフィールドを追加フィールドとして追加すると、元のレコード全体を読み取る必要はありません。

注意:

それぞれの分割が

getSplits()メソッドから返されたら、その分割に対して空間索引が作成されます。空間索引をフィルタ処理に使用する(空間のフィルタ処理)場合は、空間索引を作成したものと同じInputFormat実装を使用して、分割索引があるかどうか確認することをお薦めします。

getPos()メソッドはHadoopの新しいAPIから削除されていますが、org.apache.hadoop.mapreduce.lib.input.TextInputFormatおよびCombineTextInputFormatはサポートされており、引き続きレコードの開始オフセットの取得に使用できます。

新しいAPIのその他の入力形式もサポートされていますが、レコード開始オフセットは空間索引に含まれません。このため、元のレコードは検索できません。新しいAPI入力形式の要件は、古いAPIのものと同じです。ただし、新しいAPI FileInputFormat、FileSplit、およびCombineFileSplitに変換する必要があります。

親トピック: 空間の索引付け

2.9.2.5 GeoJSONおよびShapefile形式のサポート

Vector APIには、GeoJSONおよびShapefileファイル形式のためのInputFormat実装、およびRecordInfoProvider実装が提供されています。

次のInputFormat/RecordInfoProviderペアは、それぞれGeoJSONおよびShapeFilesの読取りと解釈に使用されます。

oracle.spatial.hadoop.vector.geojson.mapred.GeoJsonInputFormat / oracle.spatial.hadoop.vector.geojson.GeoJsonRecordInfoProvider oracle.spatial.hadoop.vector.shapefile.mapred.ShapeFileInputFormat / oracle.spatial.hadoop.vector.shapefile.ShapeFileRecordInfoProvider

使用方法とプロパティについて詳しくは、Javadocを参照してください。

親トピック: 空間の索引付け

2.9.2.6 空間索引の削除

次を実行することにより、前に生成した空間索引を削除できます。