5 ビッグ・データ環境でのプロパティ・グラフの使用

この章では、ビッグ・データ環境でのプロパティ・グラフ・データの作成、格納および操作に関する概念と使用方法の情報を提供します。

- プロパティ・グラフについて

プロパティ・グラフでは、プロパティ(キー値ペア)をグラフの頂点およびエッジに簡単に関連付けることができ、大量のデータ・セット間の関係に基づく分析操作が可能になります。 - プロパティ・グラフのデータ形式について

次のグラフ形式がサポートされています。 - プロパティ・グラフの開始

プロパティ・グラフを開始するには、次の主要手順に従います。 - プロパティ・グラフ・データ用のJava APIの使用

プロパティ・グラフの作成には、Java APIを使用したプロパティ・グラフとそのオブジェクトの作成が含まれます。 - プロパティ・グラフ・データのテキスト索引付けの管理

Oracle Big Data Spatial and Graphの索引付けは、特定のキー/値またはキー/テキスト・ペア別に要素を高速に読み取ることを可能にします。これらの索引は、要素タイプ(頂点またはエッジ)、キー(および値)のセットおよび索引タイプに基づいて作成されます。 - PGQLを使用したプロパティ・グラフ・データに対する問合せ

Oracle Big Data Spatial and Graphは、豊富なグラフ・パターン一致機能セットをサポートしています。 - プロパティ・グラフ・データを使用したApache Sparkの使用

Apache Sparkは、大量のデータを効率的に処理することを可能にし、データを処理するためのライブラリ・セット(SQL、MLlib、Spark StreamingおよびDataFrame)が用意されています。Apache Sparkでは、HDFS、Oracle NoSQL DatabaseおよびApache HBaseなどの様々なソースからデータを読み込むことができます。 - セキュアなOracle NoSQL Databaseのサポート

Oracle Big Data Spatial and Graphプロパティ・グラフ・サポートは、Oracle NoSQL Databaseのセキュア・インストールと非セキュア・インストールの両方で機能します。このトピックでは、セキュアなOracle NoSQL Database設定でプロパティ・グラフ機能を使用する方法についての情報を提供します。 - Apache HBaseに格納されているグラフでのセキュリティの実装

Oracle Big Data Spatial and Graphのプロパティ・グラフを保護するために、Apache HBaseでKerberos認証を使用することが推奨されます。 - プロパティ・グラフ・データでのGroovyシェルの使用

Oracle Big Data Spatial and Graphプロパティ・グラフ・サポートには、組込みのGroovyシェル(オリジナルのGremlin Groovyシェル・スクリプトに基づく)が含まれています。このコマンドライン・シェル・インタフェースを使用して、Java APIを参照できます。 - プロパティ・グラフ・データのRESTサポート

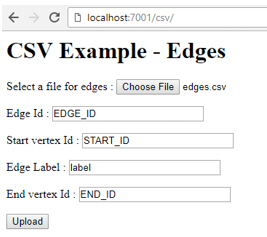

一連のRESTful APIによって、HTTP/RESTプロトコルを介してデータ・アクセス・レイヤーJava APIが公開されます。 - サンプル・プログラムの探索

ソフトウェア・インストールには、プロパティ・グラフの作成および操作方法を習得するために使用できる、プログラムの例のディレクトリが含まれています。 - Oracleフラット・ファイル形式の定義

プロパティ・グラフは、頂点用の記述ファイルとエッジ用の記述ファイルの2つのフラット・ファイルに定義できます。 - Pythonユーザー・インタフェースの例

Oracle Big Data Spatial and Graphのプロパティ・グラフ・サポートには、Pythonユーザー・インタフェースの例が含まれています。これは、様々なプロパティ・グラフ操作を実行するPythonスクリプトおよびモジュールの例のセットを起動できます。 - iPython Notebookユーザー・インタフェースの例

主なプロパティ・グラフ機能に対する次のタイプのiPython Notebookシェル・インタフェースのサポートが提供されています。

5.1 プロパティ・グラフについて

プロパティ・グラフでは、プロパティ(キー値ペア)をグラフの頂点およびエッジに簡単に関連付けることができ、大量のデータ・セット間の関係に基づく分析操作が可能になります。

5.1.1 プロパティ・グラフとは

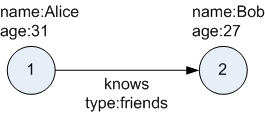

プロパティ・グラフは、オブジェクトまたは頂点のセットと、これらのオブジェクトをつなぐ矢印またはエッジのセットで構成されます。頂点とエッジには複数のプロパティを含めることができ、それらはキー値ペアとして表されます。

各頂点には一意の識別子があり、次のものを含めることができます。

-

出力エッジのセット

-

入力エッジのセット

-

プロパティの集まり

各エッジには一意の識別子があり、次のものを含めることができます。

-

出力頂点

-

入力頂点

-

2つの頂点間の関係を示すテキスト・ラベル

-

プロパティの集まり

図5-1は、2つの頂点と1つのエッジを持つ非常に単純なプロパティ・グラフを示しています。2つの頂点には、識別子1および2があります。両方の頂点には、プロパティnameおよびageがあります。エッジは、出力頂点1から入力頂点2に向かっています。このエッジは、テキスト・ラベルknowsと、頂点1と2の関係のタイプを識別するプロパティtypeで表されます。

Big Data Spatial and Graphプロパティ・グラフ・データ・モデルには標準が用意されていませんが、これはW3C標準ベースのResource Description Framework (RDF)グラフ・データ・モデルに似ています。プロパティ・グラフ・データ・モデルはRDFよりも単純であり、精密ではありません。このような相違点により、これは次のようなユースケースでよい候補になります。

-

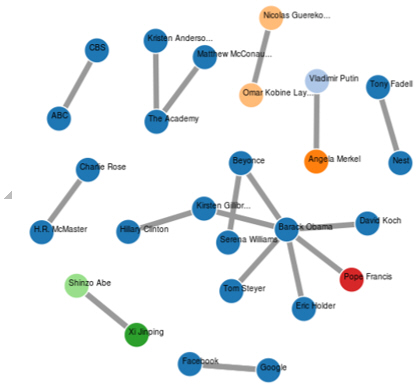

ソーシャル・ネットワークでの影響の特定

-

トレンドおよび顧客行動の予測

-

パターン一致に基づく関係の発見

-

キャンペーンをカスタマイズするためのクラスタの特定

注意:

データベース側でOracleがサポートしているプロパティ・グラフ・データ・モデルでは、頂点にラベルを使用することはできません。ただし、「頂点のラベルの指定」で説明されているように、指定した頂点プロパティの値を1つ以上のラベルとして扱うことができます。

親トピック: プロパティ・グラフについて

5.1.2 プロパティ・グラフのビッグ・データ・サポートとは

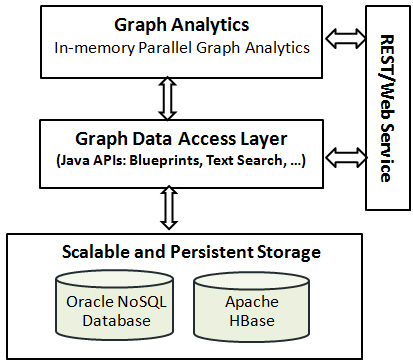

プロパティ・グラフは、HadoopおよびOracle NoSQL Databaseのビッグ・データに対してサポートされます。このサポートは、データ・アクセス・レイヤーと分析レイヤーで構成されます。Hadoopでのデータベースの選択肢により、スケーラブルで一貫したストレージ管理が提供されます。

図5-2は、Oracleプロパティ・グラフのアーキテクチャを示しています。

5.1.2.1 インメモリー・アナリスト

インメモリー・アナリスト・レイヤーでは、パラレル・インメモリー実行を使用してプロパティ・グループを分析できます。これは、パス計算、ランキング、コミュニティ検出、推奨ムを含む、35を超える分析機能を提供します。

親トピック: プロパティ・グラフのビッグ・データ・サポートとは

5.1.2.2 データ・アクセス・レイヤー

データ・アクセス・レイヤーは、プロパティ・グラフの作成および削除、頂点とエッジの追加および削除、キー値ペアを使用した頂点とエッジの検索、テキスト索引の作成、およびその他の操作の実行に使用できる、Java APIのセットを提供します。Java APIには、プロパティ・グラフ・データ・モデル用のTinkerPop Blueprintsグラフ・インタフェースの実装が含まれています。また、これらのAPIは、広く普及しているオープンソースのテキスト索引付けおよび検索エンジンであるApache LuceneおよびApache SolrCloudと統合されています。

親トピック: プロパティ・グラフのビッグ・データ・サポートとは

5.1.2.3 ストレージ管理

プロパティ・グラフは、Oracle NoSQL DatabaseまたはApache HBaseのいずれかに格納できます。これらのデータベースは両方とも成熟しており、スケーラブルで、効率的なナビゲーション、問合せおよび分析をサポートします。両方とも、プロパティ・グラフの頂点およびエッジをモデル化するために表を使用します。

親トピック: プロパティ・グラフのビッグ・データ・サポートとは

5.1.2.4 RESTful Webサービス

RESTful Webサービスを使用して、グラフ・データにアクセスしてグラフ操作を実行することもできます。たとえば、Linux curlコマンドを使用して、頂点とエッジを取得したり、グラフ要素を追加および削除したりすることができます。

親トピック: プロパティ・グラフのビッグ・データ・サポートとは

5.2 プロパティ・グラフのデータ形式について

次のグラフ形式がサポートされます。

5.2.1 GraphMLデータ形式

GraphMLファイル形式では、XMLを使用してグラフを記述します。例5-1は、図5-1に示されているプロパティ・グラフのGraphMLの記述を示しています。

例5-1 単純なプロパティ・グラフのGraphMLの記述

<?xml version="1.0" encoding="UTF-8"?>

<graphml xmlns="http://graphml.graphdrawing.org/xmlns">

<key id="name" for="node" attr.name="name" attr.type="string"/>

<key id="age" for="node" attr.name="age" attr.type="int"/>

<key id="type" for="edge" attr.name="type" attr.type="string"/>

<graph id="PG" edgedefault="directed">

<node id="1">

<data key="name">Alice</data>

<data key="age">31</data>

</node>

<node id="2">

<data key="name">Bob</data>

<data key="age">27</data>

</node>

<edge id="3" source="1" target="2" label="knows">

<data key="type">friends</data>

</edge>

</graph>

</graphml>

親トピック: プロパティ・グラフのデータ形式について

5.2.2 GraphSONデータ形式

GraphSONファイル形式では、JavaScript Object Notation (JSON)に基づいてグラフを記述します。例5-2は、図5-1に示されているプロパティ・グラフのGraphSONの記述を示しています。

関連項目:

『GraphSON Reader and Writer Library』

https://github.com/tinkerpop/blueprints/wiki/GraphSON-Reader-and-Writer-Library

例5-2 単純なプロパティ・グラフのGraphSONの記述

{

"graph": {

"mode":"NORMAL",

"vertices": [

{

"name": "Alice",

"age": 31,

"_id": "1",

"_type": "vertex"

},

{

"name": "Bob",

"age": 27,

"_id": "2",

"_type": "vertex"

}

],

"edges": [

{

"type": "friends",

"_id": "3",

"_type": "edge",

"_outV": "1",

"_inV": "2",

"_label": "knows"

}

]

}

}親トピック: プロパティ・グラフのデータ形式について

5.2.3 GMLデータ形式

Graph Modeling Language (GML)ファイル形式では、ASCIIを使用してグラフを記述します。例5-3は、図5-1に示されているプロパティ・グラフのGMLの記述を示しています。

関連項目:

『GML: A Portable Graph File Format』、Michael Himsolt著

例5-3 単純なプロパティ・グラフのGMLの記述

graph [

comment "Simple property graph"

directed 1

IsPlanar 1

node [

id 1

label "1"

name "Alice"

age 31

]

node [

id 2

label "2"

name "Bob"

age 27

]

edge [

source 1

target 2

label "knows"

type "friends"

]

]親トピック: プロパティ・グラフのデータ形式について

5.2.4 Oracleフラット・ファイル形式

Oracleフラット・ファイル形式はプロパティ・グラフのみを記述します。これは、その他のファイル形式よりも正確で、より優れたデータ型サポートを提供します。Oracleフラット・ファイル形式は、グラフを記述するために、頂点用とエッジ用にそれぞれ1つずつ、2つのファイルを使用します。レコードのフィールドはカンマで区切られます。

例5-4は、図5-1に示されているプロパティ・グラフを記述するOracleフラット・ファイルを示しています。

関連項目:

例5-4 単純なプロパティ・グラフのOracleフラット・ファイルの記述

頂点ファイル:

1,name,1,Alice,, 1,age,2,,31, 2,name,1,Bob,, 2,age,2,,27,

エッジ・ファイル:

1,1,2,knows,type,1,friends,,

親トピック: プロパティ・グラフのデータ形式について

5.4 プロパティ・グラフ・データ用のJava APIの使用

プロパティ・グラフの作成には、Java APIを使用したプロパティ・グラフとそのオブジェクトの作成が含まれます。

- Java APIの概要

- グラフ・データのパラレル・ロード

グラフ・データのパラレル・ロードを実行するために、Java APIが提供されています。 - プロパティ・グラフ・インスタンスのオープンおよびクローズ

- 頂点の作成

- エッジの作成

- 頂点およびエッジの削除

- データベースから埋込みインメモリー・アナリストへのグラフの読込み

- 頂点のラベルの指定

- インメモリー・グラフの構築

- プロパティ・グラフの削除

親トピック: ビッグ・データ環境でのプロパティ・グラフの使用

5.4.1 Java APIの概要

プロパティ・グラフで使用できるJava APIには、次のものが含まれます。

- Oracle Big Data Spatial and Graph Java API

- TinkerPop Blueprints Java API

- Apache Hadoop Java API

- Oracle NoSQL Database Java API

- Apache HBase Java API

親トピック: プロパティ・グラフ・データ用のJava APIの使用

5.4.1.1 Oracle Big Data Spatial and Graph Java API

Oracle Big Data Spatial and Graphのプロパティ・グラフ・サポートは、Apache HBaseおよびOracle NoSQL Database用のデータベース固有のAPIを提供します。データ・アクセス・レイヤーAPI (oracle.pg.*)は、Oracle NoSQL DatabaseおよびApache HBaseに格納されているプロパティ・グラフ用のTinkerPop Blueprints API、テキスト検索および索引付けを実装します。

Oracle Big Data Spatial and Graph APIを使用するには、次のクラスをJavaプログラムにインポートします。

import oracle.pg.nosql.*; // or oracle.pg.hbase.*

import oracle.pgx.config.*;

import oracle.pgx.common.types.*;

関連項目:

Oracle Big Data Spatial and Graph Java APIリファレンス

親トピック: Java APIの概要

5.4.1.2 TinkerPop Blueprints Java API

TinkerPop Blueprintsはプロパティ・グラフ・データ・モデルをサポートします。このAPIは、主にBig Data Spatial and Graphのデータ・アクセス・レイヤーJava APIを介して使用する、グラフ操作のためのユーティリティを提供します。

Blueprints APIを使用するには、次のクラスをJavaプログラムにインポートします。

import com.tinkerpop.blueprints.Vertex; import com.tinkerpop.blueprints.Edge;

関連項目:

『Blueprints: A Property Graph Model Interface API』

http://www.tinkerpop.com/docs/javadocs/blueprints/2.3.0/index.html

親トピック: Java APIの概要

5.4.1.3 Apache Hadoop Java API

Apache Hadoop Java APIを使用すると、JavaコードをHadoop分散フレームワーク内で実行するMapReduceプログラムとして作成できます。

Hadoop Java APIを使用するには、次のクラスをJavaプログラムにインポートします。次に例を示します。

import org.apache.hadoop.conf.Configuration;

親トピック: Java APIの概要

5.4.1.4 Oracle NoSQL Database Java API

The Oracle NoSQL Database APIを使用すると、キー値(KV)ストアを作成および移入し、Hadoop、HiveおよびOracle NoSQL Databaseへのインタフェースを提供できます。

Oracle NoSQL Databaseをグラフ・データ・ストアとして使用するには、次のクラスをJavaプログラムにインポートします。次に例を示します。

import oracle.kv.*; import oracle.kv.table.TableOperation;

親トピック: Java APIの概要

5.4.1.5 Apache HBase Java API

Apache HBase APIを使用すると、キー値ペアを作成および操作できます。

HBaseをグラフ・データ・ストアとして使用するには、次のクラスをJavaプログラムにインポートします。次に例を示します。

import org.apache.hadoop.hbase.*; import org.apache.hadoop.hbase.client.*; import org.apache.hadoop.hbase.filter.*; import org.apache.hadoop.hbase.util.Bytes; import org.apache.hadoop.conf.Configuration;

関連項目:

『HBase 0.98.6-cdh5.3.2 API』

http://archive.cloudera.com/cdh5/cdh/5/hbase/apidocs/index.html?overview-summary.html

親トピック: Java APIの概要

5.4.2 グラフ・データのパラレル・ロード

グラフ・データのパラレル・ロードを実行するために、Java APIが提供されています。

頂点ファイル(または入力ストリーム)のセットとエッジ・ファイル(または入力ストリーム)のセットがある場合、それらを複数のチャンクに分割し、並列でデータベースにロードできます。チャンクの数は、ユーザーが指定した並列度(DOP)によって決定されます。

並列性は、頂点およびエッジ・フラット・ファイルを複数のチャンクに分割するスプリッタ・スレッドと、別個のデータベース接続を使用して各チャンクをデータベースにロードするローダー・スレッドによって実現されます。スプリッタ・スレッドとローダー・スレッドを接続するために、Javaパイプが使用されます -- スプリッタ: PipedOutputStreamおよびローダー: PipedInputStream。

データ・ロードAPIの最も単純な使用方法は、1つのプロパティ・グラフ・インスタンス、1つの頂点ファイル、1つのエッジ・ファイルおよびDOPを指定することです。

次のロード・プロセスの例では、最適化されたOracleフラット・ファイル形式の頂点ファイルおよびエッジ・ファイルに格納されたグラフ・データをロードし、並列度48でロードを実行します。

opgdl = OraclePropertyGraphDataLoader.getInstance();

vfile = "../../data/connections.opv";

efile = "../../data/connections.ope";

opgdl.loadData(opg, vfile, efile, 48);- パーティションを使用したパラレル・データ・ロード

- ファインチューニングを使用したパラレル・データ・ロード

- 複数のファイルを使用したパラレル・データ・ロード

- グラフ・データのパラレル取得

- サブグラフ抽出のための要素フィルタ・コールバックの使用

- プロパティ・グラフ・データの読取りでの最適化フラグの使用

- プロパティ・グラフのサブグラフの属性の追加および削除

- プロパティ・グラフ・メタデータの取得

親トピック: プロパティ・グラフ・データ用のJava APIの使用

5.4.2.1 パーティションを使用したパラレル・データ・ロード

データ・ロードAPIを使用することにより、複数のパーティションを使用してデータをデータベースにロードできます。このAPIは、プロパティ・グラフ、頂点ファイル、エッジ・ファイル、DOP、パーティション合計数およびパーティション・オフセット(0からパーティション合計数 - 1まで)を必要とします。たとえば、2つのパーティションを使用してデータをロードするには、パーティション・オフセットは0および1である必要があります。つまり、グラフ全体をロードするために2つのデータ・ロードAPIコールがあり、これら2つのAPIコールの相違点は、パーティション・オフセット(0および1)のみになります。

次のコード・フラグメントは、4つのパーティションを使用してグラフ・データをロードします。データ・ローダーの各コールは、単一システム上または複数のシステム上の別々のJavaクライアントを使用して処理できます。

OraclePropertyGraph opg = OraclePropertyGraph.getInstance(

args, szGraphName);

int totalPartitions = 4;

int dop= 32; // degree of parallelism for each client.

String szOPVFile = "../../data/connections.opv";

String szOPEFile = "../../data/connections.ope";

SimpleLogBasedDataLoaderListenerImpl dll = SimpleLogBasedDataLoaderListenerImpl.getInstance(100 /* frequency */,

true /* Continue on error */);

// Run the data loading using 4 partitions (Each call can be run from a

// separate Java Client)

// Partition 1

OraclePropertyGraphDataLoader opgdlP1 = OraclePropertyGraphDataLoader.getInstance();

opgdlP1.loadData(opg, szOPVFile, szOPEFile, dop,

4 /* Total number of partitions, default 1 */,

0 /* Partition to load (from 0 to totalPartitions - 1, default 0 */,

dll);

// Partition 2

OraclePropertyGraphDataLoader opgdlP2 = OraclePropertyGraphDataLoader.getInstance();

opgdlP2.loadData(opg, szOPVFile, szOPEFile, dop, 4 /* Total number of partitions, default 1 */,

1 /* Partition to load (from 0 to totalPartitions - 1, default 0 */, dll);

// Partition 3

OraclePropertyGraphDataLoader opgdlP3 = OraclePropertyGraphDataLoader.getInstance();

opgdlP3.loadData(opg, szOPVFile, szOPEFile, dop, 4 /* Total number of partitions, default 1 */,

2 /* Partition to load (from 0 to totalPartitions - 1, default 0 */, dll);

// Partition 4

OraclePropertyGraphDataLoader opgdlP4 = OraclePropertyGraphDataLoader.getInstance();

opgdlP4.loadData(opg, szOPVFile, szOPEFile, dop, 4 /* Total number of partitions, default 1 */,

3 /* Partition to load (from 0 to totalPartitions - 1, default 0 */, dll);

親トピック: グラフ・データのパラレル・ロード

5.4.2.2 ファインチューニングを使用したパラレル・データ・ロード

データ・ロードAPIは、ロードされるソース頂点ファイルおよびエッジ・ファイル内のこれらの行のファインチューニングもサポートします。頂点(またはエッジ)オフセット行数と頂点(またはエッジ)最大行数を指定できます。オフセット行数から最大行数までのデータがロードされます。最大行数が-1である場合、ロード・プロセスはファイルの終わりに達するまでデータをスキャンします。

次のコード・フラグメントは、ファインチューニングを使用してグラフ・データをロードします。

OraclePropertyGraph opg = OraclePropertyGraph.getInstance(

args, szGraphName);

int totalPartitions = 4;

int dop= 32; // degree of parallelism for each client.

String szOPVFile = "../../data/connections.opv";

String szOPEFile = "../../data/connections.ope";

SimpleLogBasedDataLoaderListenerImpl dll = SimpleLogBasedDataLoaderListenerImpl.getInstance(100 /* frequency */,

true /* Continue on error */);

// Run the data loading using fine tuning

long lVertexOffsetlines = 0;

long lEdgeOffsetlines = 0;

long lVertexMaxlines = 100;

long lEdgeMaxlines = 100;

int totalPartitions = 1;

int idPartition = 0;

OraclePropertyGraphDataLoader opgdl = OraclePropertyGraphDataLoader.getInstance();

opgdl.loadData(opg, szOPVFile, szOPEFile,

lVertexOffsetlines /* offset of lines to start loading

from partition, default 0*/,

lEdgeOffsetlines /* offset of lines to start loading

from partition, default 0*/,

lVertexMaxlines /* maximum number of lines to start loading

from partition, default -1 (all lines in partition)*/,

lEdgeMaxlines /* maximun number of lines to start loading

from partition, default -1 (all lines in partition)*/,

dop,

totalPartitions /* Total number of partitions, default 1 */,

idPartition /* Partition to load (from 0 to totalPartitions - 1,

default 0 */,

dll);

親トピック: グラフ・データのパラレル・ロード

5.4.2.3 複数のファイルを使用したパラレル・データ・ロード

Oracle Big Data Spatial and Graphは、データベースへの複数の頂点ファイルおよび複数のエッジ・ファイルのロードもサポートします。指定された頂点ファイルがDOPチャンクに分割され、DOPスレッドを使用してデータベースに並列にロードされます。同様に、複数のエッジ・ファイルも分割されて、並列にロードされます。

次のコード・フラグメントは、パラレル・データ・ロードAPIを使用して、複数の頂点ファン・ファイルおよびエッジ・ファイルを並列にロードします。この例では、入力ファイルを保持するために2つの文字列配列szOPVFilesおよびszOPEFilesを使用しています。この例では1つの頂点ファイルと1つのエッジ・ファイルのみを使用していますが、これら2つの配列に複数の頂点ファイルと複数のエッジ・ファイルを指定できます。

OraclePropertyGraph opg = OraclePropertyGraph.getInstance(

args, szGraphName);

String[] szOPVFiles = new String[] {"../../data/connections.opv"};

String[] szOPEFiles = new String[] {"../../data/connections.ope"};

// Clear existing vertices/edges in the property graph

opg.clearRepository();

opg.setQueueSize(100); // 100 elements

// This object will handle parallel data loading over the property graph

OraclePropertyGraphDataLoader opgdl = OraclePropertyGraphDataLoader.getInstance();

opgdl.loadData(opg, szOPVFiles, szOPEFiles, dop);

System.out.println("Total vertices: " + opg.countVertices());

System.out.println("Total edges: " + opg.countEdges());

親トピック: グラフ・データのパラレル・ロード

5.4.2.4 グラフ・データのパラレル取得

プロパティ・グラフのパラレル問合せは、頂点(またはエッジ)のパラレル・スキャンを実行するための単純なJava APIを提供します。パラレル取得は、バックエンド・データベースとの分割間でのデータの配分を利用する最適化されたソリューションであり、各分割は別個のデータベース接続を使用して問い合せられます。

パラレル取得では、各要素が特定の分割からのすべての頂点(またはエッジ)を保持する配列が生成されます。問い合せられたシャードのサブセットは、特定の開始分割IDと指定された接続の配列のサイズによって分離されます。これにより、サブセットは[開始, 開始 - 1 + 接続の配列のサイズ]の範囲内の分割を考慮します。N分割を含む頂点表にあるすべての分割に、([0, N - 1]の範囲の)整数IDが割り当てられることに注意してください。

次のコードは、Apache HBaseを使用してプロパティ・グラフをロードし、接続の配列を開き、開いた接続を使用してパラレル問合せを実行してすべての頂点およびエッジを取得します。getVerticesPartitioned (getEdgesPartitioned)メソッドの呼出し数は、分割の合計数と使用される接続の数によって制御されます。

OraclePropertyGraph opg = OraclePropertyGraph.getInstance(

args, szGraphName);

// Clear existing vertices/edges in the property graph

opg.clearRepository();

String szOPVFile = "../../data/connections.opv";

String szOPEFile = "../../data/connections.ope";

// This object will handle parallel data loading

OraclePropertyGraphDataLoader opgdl = OraclePropertyGraphDataLoader.getInstance();

opgdl.loadData(opg, szOPVFile, szOPEFile, dop);

// Create connections used in parallel query

HConnection[] hConns= new HConnection[dop];

for (int i = 0; i < dop; i++) {

Configuration conf_new =

HBaseConfiguration.create(opg.getConfiguration());

hConns[i] = HConnectionManager.createConnection(conf_new);

}

long lCountV = 0;

// Iterate over all the vertices��� splits to count all the vertices

for (int split = 0; split < opg.getVertexTableSplits();

split += dop) {

Iterable<Vertex>[] iterables

= opg.getVerticesPartitioned(hConns /* Connection array */,

true /* skip store to cache */,

split /* starting split */);

lCountV += consumeIterables(iterables); /* consume iterables using

threads */

}

// Count all vertices

System.out.println("Vertices found using parallel query: " + lCountV);

long lCountE = 0;

// Iterate over all the edges��� splits to count all the edges

for (int split = 0; split < opg.getEdgeTableSplits();

split += dop) {

Iterable<Edge>[] iterables

= opg.getEdgesPartitioned(hConns /* Connection array */,

true /* skip store to cache */,

split /* starting split */);

lCountE += consumeIterables(iterables); /* consume iterables using

threads */

}

// Count all edges

System.out.println("Edges found using parallel query: " + lCountE);

// Close the connections to the database after completed

for (int idx = 0; idx < hConns.length; idx++) {

hConns[idx].close();

}

Apache HBaseのかわりにOracle NoSQL Database接続を使用してプロパティ・グラフをロードするには、次のコードを使用する必要があります。

// Create connections used in parallel query

hConns = new KVStoreConfig[dop];

kvsc = opg.getKVStoreConfig();

for (i = 0; i < dop; i++) {hConns[i] = kvsc.clone(); }

opg.setNumSplits(dop);

親トピック: グラフ・データのパラレル・ロード

5.4.2.5 サブグラフ抽出のための要素フィルタ・コールバックの使用

Oracle Big Data Spatial and Graphは、ユーザー定義の要素フィルタ・コールバックを使用した、容易なサブグラフ抽出のサポートを提供します。要素フィルタ・コールバックは、サブグラフに頂点(またはエッジ)を保持するために、頂点(またはエッジ)が満たす必要のある条件セットを定義します。ユーザーはVertexFilterCallbackおよびEdgeFilterCallback APIインタフェースを実装することによって、独自の要素フィルタを定義できます。

次のコード・フラグメントは、頂点が政治的役割を持たず、その出生地が米国であるかどうかを検証するVertexFilterCallbackを実装します。

/**

* VertexFilterCallback to retrieve a vertex from the United States

* that does not have a political role

*/

private static class NonPoliticianFilterCallback

implements VertexFilterCallback

{

@Override

public boolean keepVertex(OracleVertexBase vertex)

{

String country = vertex.getProperty("country");

String role = vertex.getProperty("role");

if (country != null && country.equals("United States")) {

if (role == null || !role.toLowerCase().contains("political")) {

return true;

}

}

return false;

}

public static NonPoliticianFilterCallback getInstance()

{

return new NonPoliticianFilterCallback();

}

}

次のコード・フラグメントは、VertexFilterCallbackを使用して特定の入力頂点に接続しているエッジのうち、その接続が政治家ではなく米国出身であるエッジのみを保持するEdgeFilterCallbackを実装します。

/**

* EdgeFilterCallback to retrieve all edges connected to an input

* vertex with "collaborates" label, and whose vertex is from the

* United States with a role different than political

*/

private static class CollaboratorsFilterCallback

implements EdgeFilterCallback

{

private VertexFilterCallback m_vfc;

private Vertex m_startV;

public CollaboratorsFilterCallback(VertexFilterCallback vfc,

Vertex v)

{

m_vfc = vfc;

m_startV = v;

}

@Override

public boolean keepEdge(OracleEdgeBase edge)

{

if ("collaborates".equals(edge.getLabel())) {

if (edge.getVertex(Direction.IN).equals(m_startV) &&

m_vfc.keepVertex((OracleVertex)

edge.getVertex(Direction.OUT))) {

return true;

}

else if (edge.getVertex(Direction.OUT).equals(m_startV) &&

m_vfc.keepVertex((OracleVertex)

edge.getVertex(Direction.IN))) {

return true;

}

}

return false;

}

public static CollaboratorsFilterCallback

getInstance(VertexFilterCallback vfc, Vertex v)

{

return new CollaboratorsFilterCallback(vfc, v);

}

}

前に定義したフィルタ・コールバックを使用して、次のコード・フラグメントは、プロパティ・グラフをロードし、フィルタ・コールバックのインスタンスを作成し、その後に政治家ではなく米国出身であるBarack Obamaのすべての協力者を取得します。

OraclePropertyGraph opg = OraclePropertyGraph.getInstance( args, szGraphName); // Clear existing vertices/edges in the property graph opg.clearRepository(); String szOPVFile = "../../data/connections.opv"; String szOPEFile = "../../data/connections.ope"; // This object will handle parallel data loading OraclePropertyGraphDataLoader opgdl = OraclePropertyGraphDataLoader.getInstance(); opgdl.loadData(opg, szOPVFile, szOPEFile, dop); // VertexFilterCallback to retrieve all people from the United States // who are not politicians NonPoliticianFilterCallback npvfc = NonPoliticianFilterCallback.getInstance(); // Initial vertex: Barack Obama Vertex v = opg.getVertices("name", "Barack Obama").iterator().next(); // EdgeFilterCallback to retrieve all collaborators of Barack Obama // from the United States who are not politicians CollaboratorsFilterCallback cefc = CollaboratorsFilterCallback.getInstance(npvfc, v); Iterable<<Edge> obamaCollabs = opg.getEdges((String[])null /* Match any of the properties */, cefc /* Match the EdgeFilterCallback */ ); Iterator<<Edge> iter = obamaCollabs.iterator(); System.out.println("\n\n--------Collaborators of Barack Obama from " + " the US and non-politician\n\n"); long countV = 0; while (iter.hasNext()) { Edge edge = iter.next(); // get the edge // check if obama is the IN vertex if (edge.getVertex(Direction.IN).equals(v)) { System.out.println(edge.getVertex(Direction.OUT) + "(Edge ID: " + edge.getId() + ")"); // get out vertex } else { System.out.println(edge.getVertex(Direction.IN)+ "(Edge ID: " + edge.getId() + ")"); // get in vertex } countV++; }

デフォルトでは、すべての頂点の取得、すべてのエッジの取得(および並列アプローチ)などのすべての読取り操作は、opg.setVertexFilterCallback(vfc)およびopg.setEdgeFilterCallback(efc)メソッドを使用してプロパティ・グラフに関連付けられたフィルタ・コールバックを使用します。フィルタ・コールバック・セットがない場合は、すべての頂点(またはエッジ)およびエッジが取得されます。

次のコード・フラグメントは、プロパティ・グラフでデフォルトのエッジ・フィルタ・コールバック・セットを使用して、エッジを取得します。

// VertexFilterCallback to retrieve all people from the United States // who are not politicians NonPoliticianFilterCallback npvfc = NonPoliticianFilterCallback.getInstance(); // Initial vertex: Barack Obama Vertex v = opg.getVertices("name", "Barack Obama").iterator().next(); // EdgeFilterCallback to retrieve all collaborators of Barack Obama // from the United States who are not politicians CollaboratorsFilterCallback cefc = CollaboratorsFilterCallback.getInstance(npvfc, v); opg.setEdgeFilterCallback(cefc); Iterable<Edge> obamaCollabs = opg.getEdges(); Iterator<Edge> iter = obamaCollabs.iterator(); System.out.println("\n\n--------Collaborators of Barack Obama from " + " the US and non-politician\n\n"); long countV = 0; while (iter.hasNext()) { Edge edge = iter.next(); // get the edge // check if obama is the IN vertex if (edge.getVertex(Direction.IN).equals(v)) { System.out.println(edge.getVertex(Direction.OUT) + "(Edge ID: " + edge.getId() + ")"); // get out vertex } else { System.out.println(edge.getVertex(Direction.IN)+ "(Edge ID: " + edge.getId() + ")"); // get in vertex } countV++; }

親トピック: グラフ・データのパラレル・ロード

5.4.2.6 プロパティ・グラフ・データの読取りでの最適化フラグの使用

最適化フラグを使用すると、グラフ反復のパフォーマンスを向上させることができます。最適化フラグにより、情報がない、または最小限の情報(ID、ラベルおよび入力/出力頂点など)を持つオブジェクトとして、頂点(またはエッジ)を処理できます。これにより、反復中の各頂点またはエッジの処理にかかる時間が削減されます。

次の表に、プロパティ・グラフで頂点またはエッジを処理するときに使用できる最適化フラグを示します。

表5-1 プロパティ・グラフで頂点またはエッジを処理するための最適化フラグ

| 最適化フラグ | 説明 |

|---|---|

| DO_NOT_CREATE_OBJECT | 頂点またはエッジを処理するときに、事前定義済の定数オブジェクトを使用します。 |

| JUST_EDGE_ID | エッジの処理時に、IDのみを持つエッジ・オブジェクトを作成します。 |

| JUST_LABEL_EDGE_ID | エッジの処理時に、IDとラベルのみを持つエッジ・オブジェクトを作成します。 |

| JUST_LABEL_VERTEX_EDGE_ID | エッジの処理時に、ID、ラベルおよび入力/出力頂点IDのみを持つエッジ・オブジェクトを作成します。 |

| JUST_VERTEX_EDGE_ID | エッジの処理時に、IDおよび入力/出力頂点IDのみを持つエッジ・オブジェクトを作成します。 |

| JUST_VERTEX_ID | 頂点の処理時に、IDのみを持つ頂点オブジェクトを作成します。 |

次のコード・フラグメントは、最適化フラグのセットを使用して、プロパティ・グラフの頂点およびエッジからすべてのIDのみを取得します。すべての頂点およびエッジの読取りによって取得されたオブジェクトには、IDのみが含まれ、キー/値プロパティや追加情報は含まれません。

import oracle.pg.common.OraclePropertyGraphBase.OptimizationFlag; OraclePropertyGraph opg = OraclePropertyGraph.getInstance( args, szGraphName); // Clear existing vertices/edges in the property graph opg.clearRepository(); String szOPVFile = "../../data/connections.opv"; String szOPEFile = "../../data/connections.ope"; // This object will handle parallel data loading OraclePropertyGraphDataLoader opgdl = OraclePropertyGraphDataLoader.getInstance(); opgdl.loadData(opg, szOPVFile, szOPEFile, dop); // Optimization flag to retrieve only vertices IDs OptimizationFlag optFlagVertex = OptimizationFlag.JUST_VERTEX_ID; // Optimization flag to retrieve only edges IDs OptimizationFlag optFlagEdge = OptimizationFlag.JUST_EDGE_ID; // Print all vertices Iterator<Vertex> vertices = opg.getVertices((String[])null /* Match any of the properties */, null /* Match the VertexFilterCallback */, optFlagVertex /* optimization flag */ ).iterator(); System.out.println("----- Vertices IDs----"); long vCount = 0; while (vertices.hasNext()) { OracleVertex v = vertices.next(); System.out.println((Long) v.getId()); vCount++; } System.out.println("Vertices found: " + vCount); // Print all edges Iterator<Edge> edges = opg.getEdges((String[])null /* Match any of the properties */, null /* Match the EdgeFilterCallback */, optFlagEdge /* optimization flag */ ).iterator(); System.out.println("----- Edges ----"); long eCount = 0; while (edges.hasNext()) { Edge e = edges.next(); System.out.println((Long) e.getId()); eCount++; } System.out.println("Edges found: " + eCount);

デフォルトでは、すべての頂点の取得、すべてのエッジの取得(および並列アプローチ)などのすべての読取り操作は、opg.setDefaultVertexOptFlag(optFlagVertex)およびopg.setDefaultEdgeOptFlag(optFlagEdge)メソッドを使用してプロパティ・グラフに関連付けられた最適化フラグを使用します。頂点またはエッジの処理に対する最適化フラグが定義されていない場合、頂点およびエッジに関するすべての情報が取得されます。

次のコード・フラグメントは、プロパティ・グラフでデフォルト最適化フラグのセットを使用して、その頂点およびエッジからすべてのIDのみを取得します。

import oracle.pg.common.OraclePropertyGraphBase.OptimizationFlag; // Optimization flag to retrieve only vertices IDs OptimizationFlag optFlagVertex = OptimizationFlag.JUST_VERTEX_ID; // Optimization flag to retrieve only edges IDs OptimizationFlag optFlagEdge = OptimizationFlag.JUST_EDGE_ID; opg.setDefaultVertexOptFlag(optFlagVertex); opg.setDefaultEdgeOptFlag(optFlagEdge); Iterator<Vertex> vertices = opg.getVertices().iterator(); System.out.println("----- Vertices IDs----"); long vCount = 0; while (vertices.hasNext()) { OracleVertex v = vertices.next(); System.out.println((Long) v.getId()); vCount++; } System.out.println("Vertices found: " + vCount); // Print all edges Iterator<Edge> edges = opg.getEdges().iterator(); System.out.println("----- Edges ----"); long eCount = 0; while (edges.hasNext()) { Edge e = edges.next(); System.out.println((Long) e.getId()); eCount++; } System.out.println("Edges found: " + eCount);

親トピック: グラフ・データのパラレル・ロード

5.4.2.7 プロパティ・グラフのサブグラフの属性の追加および削除

Oracle Big Data Spatial and Graphは、ユーザーがカスタマイズした操作コールバックを使用した、頂点またはエッジ(あるいはその両方)のサブグラフへの属性(キー/値ペア)の更新をサポートします。操作コールバックは、(特定の属性および値を追加または削除することによって)頂点(またはエッジ)を更新するために、頂点(またはエッジ)が満たす必要のある条件セットを定義します。

VertexOpCallbackおよびEdgeOpCallback APIインタフェースを実装することにより、独自の属性操作を定義できます。更新操作に含まれる頂点(またはエッジ)によって満たされる必要のある条件を定義するneedOpメソッド、および要素の更新時に使用されるキー名とキー値をそれぞれ返すgetAttributeKeyNameメソッドとgetAttributeKeyValueメソッドをオーバーライドする必要があります。

次のコード・フラグメントは、Barack Obamaの協力者のみに関連付けられたobamaCollaborator属性を操作するVertexOpCallbackを実装します。このプロパティの値は、協力者の役職に基づいて指定されます。

private static class CollaboratorsVertexOpCallback implements VertexOpCallback { private OracleVertexBase m_obama; private List<Vertex> m_obamaCollaborators; public CollaboratorsVertexOpCallback(OraclePropertyGraph opg) { // Get a list of Barack Obama'sCollaborators m_obama = (OracleVertexBase) opg.getVertices("name", "Barack Obama") .iterator().next(); Iterable<Vertex> iter = m_obama.getVertices(Direction.BOTH, "collaborates"); m_obamaCollaborators = OraclePropertyGraphUtils.listify(iter); } public static CollaboratorsVertexOpCallback getInstance(OraclePropertyGraph opg) { return new CollaboratorsVertexOpCallback(opg); } /** * Add attribute if and only if the vertex is a collaborator of Barack * Obama */ @Override public boolean needOp(OracleVertexBase v) { return m_obamaCollaborators != null && m_obamaCollaborators.contains(v); } @Override public String getAttributeKeyName(OracleVertexBase v) { return "obamaCollaborator"; } /** * Define the property's value based on the vertex role */ @Override public Object getAttributeKeyValue(OracleVertexBase v) { String role = v.getProperty("role"); role = role.toLowerCase(); if (role.contains("political")) { return "political"; } else if (role.contains("actor") || role.contains("singer") || role.contains("actress") || role.contains("writer") || role.contains("producer") || role.contains("director")) { return "arts"; } else if (role.contains("player")) { return "sports"; } else if (role.contains("journalist")) { return "journalism"; } else if (role.contains("business") || role.contains("economist")) { return "business"; } else if (role.contains("philant")) { return "philanthropy"; } return " "; } }

次のコード・フラグメントは、Barack Obamaの敵対者のみに関連付けられたobamaFeud属性を操作するEdgeOpCallbackを実装します。このプロパティの値は、協力者の役職に基づいて指定されます。

private static class FeudsEdgeOpCallback implements EdgeOpCallback { private OracleVertexBase m_obama; private List<Edge> m_obamaFeuds; public FeudsEdgeOpCallback(OraclePropertyGraph opg) { // Get a list of Barack Obama's feuds m_obama = (OracleVertexBase) opg.getVertices("name", "Barack Obama") .iterator().next(); Iterable<Edge> iter = m_obama.getEdges(Direction.BOTH, "feuds"); m_obamaFeuds = OraclePropertyGraphUtils.listify(iter); } public static FeudsEdgeOpCallback getInstance(OraclePropertyGraph opg) { return new FeudsEdgeOpCallback(opg); } /** * Add attribute if and only if the edge is in the list of Barack Obama's * feuds */ @Override public boolean needOp(OracleEdgeBase e) { return m_obamaFeuds != null && m_obamaFeuds.contains(e); } @Override public String getAttributeKeyName(OracleEdgeBase e) { return "obamaFeud"; } /** * Define the property's value based on the in/out vertex role */ @Override public Object getAttributeKeyValue(OracleEdgeBase e) { OracleVertexBase v = (OracleVertexBase) e.getVertex(Direction.IN); if (m_obama.equals(v)) { v = (OracleVertexBase) e.getVertex(Direction.OUT); } String role = v.getProperty("role"); role = role.toLowerCase(); if (role.contains("political")) { return "political"; } else if (role.contains("actor") || role.contains("singer") || role.contains("actress") || role.contains("writer") || role.contains("producer") || role.contains("director")) { return "arts"; } else if (role.contains("journalist")) { return "journalism"; } else if (role.contains("player")) { return "sports"; } else if (role.contains("business") || role.contains("economist")) { return "business"; } else if (role.contains("philanthropist")) { return "philanthropy"; } return " "; } }

前に定義した操作コールバックを使用して、次のコード・フラグメントはプロパティ・グラフをロードし、操作コールバックのインスタンスを作成し、その後にOraclePropertyGraphでaddAttributeToAllVerticesおよびaddAttributeToAllEdgesメソッドを使用して属性を適切な頂点およびエッジに追加します。

OraclePropertyGraph opg = OraclePropertyGraph.getInstance( args, szGraphName); // Clear existing vertices/edges in the property graph opg.clearRepository(); String szOPVFile = "../../data/connections.opv"; String szOPEFile = "../../data/connections.ope"; // This object will handle parallel data loading OraclePropertyGraphDataLoader opgdl = OraclePropertyGraphDataLoader.getInstance(); opgdl.loadData(opg, szOPVFile, szOPEFile, dop); // Create the vertex operation callback CollaboratorsVertexOpCallback cvoc = CollaboratorsVertexOpCallback.getInstance(opg); // Add attribute to all people collaborating with Obama based on their role opg.addAttributeToAllVertices(cvoc, true /** Skip store to Cache */, dop); // Look up for all collaborators of Obama // The function getVerticesAsString prints the vertices in the given iterable Iterable<Vertex> collaborators = opg.getVertices("obamaCollaborator", "political"); System.out.println("Political collaborators of Barack Obama " + getVerticesAsString(collaborators)); collaborators = opg.getVertices("obamaCollaborator", "business"); System.out.println("Business collaborators of Barack Obama " + getVerticesAsString(collaborators)); // Add an attribute to all people having a feud with Barack Obama to set // the type of relation they have FeudsEdgeOpCallback feoc = FeudsEdgeOpCallback.getInstance(opg); opg.addAttributeToAllEdges(feoc, true /** Skip store to Cache */, dop); // Look up for all feuds of Obama // The function getEdgesAsString prints the edges in the given iterable Iterable<Edge> feuds = opg.getEdges("obamaFeud", "political"); System.out.println("\n\nPolitical feuds of Barack Obama " + getEdgesAsString(feuds)); feuds = opg.getEdges("obamaFeud", "business"); System.out.println("Business feuds of Barack Obama " + getEdgesAsString(feuds));

次のコード・フラグメントは、属性obamaCollaboratorにphilanthropyという値を持つ頂点を削除した後でAPI removeAttributeFromAllVerticesをコールするために使用できるVertexOpCallbackの実装を定義します。また、属性obamaFeudにbusinessという値を持つエッジを削除した後でAPI removeAttributeFromAllEdgesをコールするために使用できるEdgeOpCallbackの実装も定義します。

System.out.println("\n\nRemove 'obamaCollaborator' property from all the" +

"philanthropy collaborators");

PhilanthropyCollaboratorsVertexOpCallback pvoc = PhilanthropyCollaboratorsVertexOpCallback.getInstance();

opg.removeAttributeFromAllVertices(pvoc);

System.out.println("\n\nRemove 'obamaFeud' property from all the" + "business feuds");

BusinessFeudsEdgeOpCallback beoc = BusinessFeudsEdgeOpCallback.getInstance();

opg.removeAttributeFromAllEdges(beoc);

/**

* Implementation of a EdgeOpCallback to remove the "obamaCollaborators"

* property from all people collaborating with Barack Obama that have a

* philanthropy role

*/

private static class PhilanthropyCollaboratorsVertexOpCallback implements VertexOpCallback

{

public static PhilanthropyCollaboratorsVertexOpCallback getInstance()

{

return new PhilanthropyCollaboratorsVertexOpCallback();

}

/**

* Remove attribute if and only if the property value for

* obamaCollaborator is Philanthropy

*/

@Override

public boolean needOp(OracleVertexBase v)

{

String type = v.getProperty("obamaCollaborator");

return type != null && type.equals("philanthropy");

}

@Override

public String getAttributeKeyName(OracleVertexBase v)

{

return "obamaCollaborator";

}

/**

* Define the property's value. In this case can be empty

*/

@Override

public Object getAttributeKeyValue(OracleVertexBase v)

{

return " ";

}

}

/**

* Implementation of a EdgeOpCallback to remove the "obamaFeud" property

* from all connections in a feud with Barack Obama that have a business role

*/

private static class BusinessFeudsEdgeOpCallback implements EdgeOpCallback

{

public static BusinessFeudsEdgeOpCallback getInstance()

{

return new BusinessFeudsEdgeOpCallback();

}

/**

* Remove attribute if and only if the property value for obamaFeud is

* business

*/

@Override

public boolean needOp(OracleEdgeBase e)

{

String type = e.getProperty("obamaFeud");

return type != null && type.equals("business");

}

@Override

public String getAttributeKeyName(OracleEdgeBase e)

{

return "obamaFeud";

}

/**

* Define the property's value. In this case can be empty

*/

@Override

public Object getAttributeKeyValue(OracleEdgeBase e)

{

return " ";

}

}

親トピック: グラフ・データのパラレル・ロード

5.4.2.8 プロパティ・グラフ・メタデータの取得

データベース内のすべてのグラフ名など、グラフのメタデータと統計を取得できます。各グラフについて、最小/最大頂点ID、最小/最大エッジID、頂点プロパティ名、エッジ・プロパティ名、グラフ頂点内の分割の数、およびパラレル表スキャンをサポートするエッジ表などを取得します。

次のコード・フラグメントは、バックエンド・データベース(Oracle NoSQL DatabaseまたはApache HBase)に格納されている既存のプロパティ・グラフのメタデータおよび統計を取得します。必要な引数は、各データベースで異なります。

// Get all graph names in the database

List<String> graphNames = OraclePropertyGraphUtils.getGraphNames(dbArgs);

for (String graphName : graphNames) {

OraclePropertyGraph opg = OraclePropertyGraph.getInstance(args,

graphName);

System.err.println("\n Graph name: " + graphName);

System.err.println(" Total vertices: " +

opg.countVertices(dop));

System.err.println(" Minimum Vertex ID: " +

opg.getMinVertexID(dop));

System.err.println(" Maximum Vertex ID: " +

opg.getMaxVertexID(dop));

// The function getPropertyNamesAsString prints the given set of properties

Set<String> propertyNamesV = new HashSet<String>();

opg.getVertexPropertyNames(dop, 0 /* timeout,0 no timeout */,

propertyNamesV);

System.err.println(" Vertices property names: " +

getPropertyNamesAsString(propertyNamesV));

System.err.println("\n\n Total edges: " + opg.countEdges(dop));

System.err.println(" Minimum Edge ID: " + opg.getMinEdgeID(dop));

System.err.println(" Maximum Edge ID: " + opg.getMaxEdgeID(dop));

Set<String> propertyNamesE = new HashSet<String>();

opg.getEdgePropertyNames(dop, 0 /* timeout,0 no timeout */,

propertyNamesE);

System.err.println(" Edge property names: " +

getPropertyNamesAsString(propertyNamesE));

System.err.println("\n\n Table Information: ");

System.err.println("Vertex table number of splits: " +

(opg.getVertexTableSplits()));

System.err.println("Edge table number of splits: " +

(opg.getEdgeTableSplits()));

}親トピック: グラフ・データのパラレル・ロード

5.4.3 プロパティ・グラフ・インスタンスのオープンおよびクローズ

プロパティ・グラフを記述する際、次のOracle Property Graphクラスを使用して、プロパティ・グラフ・インスタンスを適切にオープンおよびクローズします。

-

OraclePropertyGraph.getInstance: Oracleプロパティ・グラフのインスタンスをオープンします。このメソッドには、接続情報とグラフ名の2つのパラメータがあります。接続情報のフォーマットは、バックエンド・データベースとしてHBaseまたはOracle NoSQL Databaseのいずれを使用しているかによって異なります。 -

OraclePropertyGraph.clearRepository: プロパティ・グラフ・インスタンスからすべての頂点およびエッジを削除します。 -

OraclePropertyGraph.shutdown: グラフ・インスタンスをクローズします。

さらに、Oracle NoSQL DatabaseまたはHBase APIからの適切なクラスを使用する必要があります。

5.4.3.1 Oracle NoSQL Databaseの使用

Oracle NoSQL Databaseでは、OraclePropertyGraph.getInstanceメソッドはKVストア名、ホスト・コンピュータ名およびポート番号を接続に使用します。

String kvHostPort = "cluster02:5000"; String kvStoreName = "kvstore"; String kvGraphName = "my_graph"; // Use NoSQL Java API KVStoreConfig kvconfig = new KVStoreConfig(kvStoreName, kvHostPort); OraclePropertyGraph opg = OraclePropertyGraph.getInstance(kvconfig, kvGraphName); opg.clearRepository(); // . // . Graph description // . // Close the graph instance opg.shutdown();

アプリケーションでインメモリー・アナリスト機能が必要な場合、GraphConfigBuilderを使用してOracle NoSQL Databaseに対してグラフconfigを作成し、引数としてconfigを指定してOraclePropertyGraphをインスタンス化することをお薦めします。

例として、次のコード・スニペットはグラフconfigを作成し、OraclePropertyGraphインスタンスを取得し、いくつかのデータをそのグラフにロードして、インメモリー・アナリストを取得します。

import oracle.pgx.config.*;

import oracle.pgx.api.*;

import oracle.pgx.common.types.*;

...

String[] hhosts = new String[1];

hhosts[0] = "my_host_name:5000"; // need customization

String szStoreName = "kvstore"; // need customization

String szGraphName = "my_graph";

int dop = 8;

PgNosqlGraphConfig cfg = GraphConfigBuilder.forPropertyGraphNosql()

.setName(szGraphName)

.setHosts(Arrays.asList(hhosts))

.setStoreName(szStoreName)

.addEdgeProperty("lbl", PropertyType.STRING, "lbl")

.addEdgeProperty("weight", PropertyType.DOUBLE, "1000000")

.build();

OraclePropertyGraph opg = OraclePropertyGraph.getInstance(cfg);

String szOPVFile = "../../data/connections.opv";

String szOPEFile = "../../data/connections.ope";

// perform a parallel data load

OraclePropertyGraphDataLoader opgdl = OraclePropertyGraphDataLoader.getInstance();

opgdl.loadData(opg, szOPVFile, szOPEFile, dop);

...

PgxSession session = Pgx.createSession("session-id-1");

PgxGraph g = session.readGraphWithProperties(cfg);

Analyst analyst = session.createAnalyst();

...

親トピック: プロパティ・グラフ・インスタンスのオープンおよびクローズ

5.4.3.2 Apache HBaseの使用

Apache HBaseでは、OraclePropertyGraph.getInstanceメソッドはHadoopノードとApache HBaseポート番号を接続に使用します。

String hbQuorum = "bda01node01.example.com, bda01node02.example.com, bda01node03.example.com";

String hbClientPort = "2181"

String hbGraphName = "my_graph";

// Use HBase Java APIs

Configuration conf = HBaseConfiguration.create();

conf.set("hbase.zookeeper.quorum", hbQuorum);

conf.set("hbase.zookeper.property.clientPort", hbClientPort);

HConnection conn = HConnectionManager.createConnection(conf);

// Open the property graph

OraclePropertyGraph opg = OraclePropertyGraph.getInstance(conf, conn, hbGraphName);

opg.clearRepository();

// .

// . Graph description

// .

// Close the graph instance

opg.shutdown();

// Close the HBase connection

conn.close();

アプリケーションでインメモリー・アナリスト機能が必要な場合、GraphConfigBuilderを使用してグラフconfigを作成し、引数としてconfigを指定してOraclePropertyGraphをインスタンス化することをお薦めします。

例として、次のコード・スニペットはインメモリー分析の構成を設定し、Apache HBaseに対してグラフconfigを作成し、OraclePropertyGraphインスタンスをインスタンス化し、インメモリー・アナリストを取得して、グラフ内のトライアングルの数をカウントします。

confPgx = new HashMap<PgxConfig.Field, Object>();

confPgx.put(PgxConfig.Field.ENABLE_GM_COMPILER, false);

confPgx.put(PgxConfig.Field.NUM_WORKERS_IO, dop + 2);

confPgx.put(PgxConfig.Field.NUM_WORKERS_ANALYSIS, 8); // <= # of physical cores

confPgx.put(PgxConfig.Field.NUM_WORKERS_FAST_TRACK_ANALYSIS, 2);

confPgx.put(PgxConfig.Field.SESSION_TASK_TIMEOUT_SECS, 0);// no timeout set

confPgx.put(PgxConfig.Field.SESSION_IDLE_TIMEOUT_SECS, 0); // no timeout set

ServerInstance instance = Pgx.getInstance();

instance.startEngine(confPgx);

int iClientPort = Integer.parseInt(hbClientPort);

int splitsPerRegion = 2;

PgHbaseGraphConfig cfg = GraphConfigBuilder.forPropertyGraphHbase()

.setName(hbGraphName)

.setZkQuorum(hbQuorum)

.setZkClientPort(iClientPort)

.setZkSessionTimeout(60000)

.setMaxNumConnections(dop)

.setSplitsPerRegion(splitsPerRegion)

.addEdgeProperty("lbl", PropertyType.STRING, "lbl")

.addEdgeProperty("weight", PropertyType.DOUBLE, "1000000")

.build();

PgxSession session = Pgx.createSession("session-id-1");

PgxGraph g = session.readGraphWithProperties(cfg);

Analyst analyst = session.createAnalyst();

long triangles = analyst.countTriangles(g, false);

親トピック: プロパティ・グラフ・インスタンスのオープンおよびクローズ

5.4.4 頂点の作成

頂点を作成するには、次のOracle Property Graphメソッドを使用します。

-

OraclePropertyGraph.addVertex: グラフに頂点インスタンスを追加します。 -

OracleVertex.setProperty: 頂点にキー値プロパティを割り当てます。 -

OraclePropertyGraph.commit: すべての変更をプロパティ・グラフ・インスタンスに保存します。

次のコード・フラグメントは、opgプロパティ・グラフ・インスタンスに年齢、名前、体重、身長、性別のプロパティを指定して、V1およびV2という名前の2つの頂点を作成します。v1プロパティはデータ型を明示的に設定します。

// Create vertex v1 and assign it properties as key-value pairs

Vertex v1 = opg.addVertex(1l);

v1.setProperty("age", Integer.valueOf(31));

v1.setProperty("name", "Alice");

v1.setProperty("weight", Float.valueOf(135.0f));

v1.setProperty("height", Double.valueOf(64.5d));

v1.setProperty("female", Boolean.TRUE);

Vertex v2 = opg.addVertex(2l);

v2.setProperty("age", 27);

v2.setProperty("name", "Bob");

v2.setProperty("weight", Float.valueOf(156.0f));

v2.setProperty("height", Double.valueOf(69.5d));

v2.setProperty("female", Boolean.FALSE); 親トピック: プロパティ・グラフ・データ用のJava APIの使用

5.4.5 エッジの作成

エッジを作成するには、次のOracle Property Graphメソッドを使用します。

-

OraclePropertyGraph.addEdge: グラフにエッジ・インスタンスを追加します。 -

OracleEdge.setProperty: エッジにキー値プロパティを割り当てます。

次のコード・フラグメントは、2つの頂点(v1およびv2)と1つのエッジ(e1)を作成します。

// Add vertices v1 and v2

Vertex v1 = opg.addVertex(1l);

v1.setProperty("name", "Alice");

v1.setProperty("age", 31);

Vertex v2 = opg.addVertex(2l);

v2.setProperty("name", "Bob");

v2.setProperty("age", 27);

// Add edge e1

Edge e1 = opg.addEdge(1l, v1, v2, "knows");

e1.setProperty("type", "friends");親トピック: プロパティ・グラフ・データ用のJava APIの使用

5.4.6 頂点およびエッジの削除

頂点インスタンスとエッジ・インスタンスを個別に、またはすべて同時に削除できます。次のメソッドを使用します。

-

OraclePropertyGraph.removeEdge: 指定されたエッジをグラフから削除します。 -

OraclePropertyGraph.removeVertex: 指定された頂点をグラフから削除します。 -

OraclePropertyGraph.clearRepository: プロパティ・グラフ・インスタンスからすべての頂点およびエッジを削除します。

次のコード・フラグメントは、グラフ・インスタンスからエッジe1と頂点v1を削除します。頂点を削除するときに、隣接するエッジもグラフから削除されます。これは、すべてのエッジは開始頂点と終了頂点を持っている必要があるためです。開始頂点または終了頂点を削除した後、そのエッジは有効なエッジではなくなります。

// Remove edge e1 opg.removeEdge(e1); // Remove vertex v1 opg.removeVertex(v1);

OraclePropertyGraphインスタンスからすべてのコンテンツを削除するには、OraclePropertyGraph.clearRepositoryメソッドを使用できます。ただし、この操作は元に戻せないため、慎重に使用してください。

親トピック: プロパティ・グラフ・データ用のJava APIの使用

5.4.7 データベースから埋込みインメモリー・アナリストへのグラフの読込み

Apache HBaseまたはOracle NoSQL Databaseから、同じクライアントJavaアプリケーション(単一のJVM)に埋め込まれたインメモリー・アナリストにグラフを読み込むことができます。次のApache HBaseの例の場合:

-

正しい

java.io.tmpdir設定が必要です。 -

dop + 2は、リリース1.1.2よりも前のパフォーマンスの問題に対処する方法です。リリース1.1.2で有効ですが、かわりにdop値を構成設定に直接指定できます。

int dop = 8; // need customization

Map<PgxConfig.Field, Object> confPgx = new HashMap<PgxConfig.Field, Object>();

confPgx.put(PgxConfig.Field.ENABLE_GM_COMPILER, false);

confPgx.put(PgxConfig.Field.NUM_WORKERS_IO, dop + 2); // use dop directly with release 1.1.2 or newer

confPgx.put(PgxConfig.Field.NUM_WORKERS_ANALYSIS, dop); // <= # of physical cores

confPgx.put(PgxConfig.Field.NUM_WORKERS_FAST_TRACK_ANALYSIS, 2);

confPgx.put(PgxConfig.Field.SESSION_TASK_TIMEOUT_SECS, 0); // no timeout set

confPgx.put(PgxConfig.Field.SESSION_IDLE_TIMEOUT_SECS, 0); // no timeout set

PgHbaseGraphConfig cfg = GraphConfigBuilder.forPropertyGraphHbase()

.setName("mygraph")

.setZkQuorum("localhost") // quorum, need customization

.setZkClientPort(2181)

.addNodeProperty("name", PropertyType.STRING, "default_name")

.build();

OraclePropertyGraph opg = OraclePropertyGraph.getInstance(cfg);

ServerInstance localInstance = Pgx.getInstance();

localInstance.startEngine(confPgx);

PgxSession session = localInstance.createSession("session-id-1"); // Put your session description here.

Analyst analyst = session.createAnalyst();

// The following call will trigger a read of graph data from the database

PgxGraph pgxGraph = session.readGraphWithProperties(opg.getConfig());

long triangles = analyst.countTriangles(pgxGraph, false);

System.out.println("triangles " + triangles);

// After reading a graph in memory, modifying the graph on the database side should not affect in memory results:

// Remove edge e1

opg.removeEdge(e1);

// Remove vertex v1

opg.removeVertex(v1);

親トピック: プロパティ・グラフ・データ用のJava APIの使用

5.4.8 頂点のラベルの指定

「プロパティ・グラフとは」で説明されているように、データベースおよびデータ・アクセス・レイヤーには、頂点用のラベルは用意されていません。ただし、指定した頂点プロパティの値を1つ以上のラベルとして扱うことができます。このような変換が関連するのは、インメモリー・アナリストの場合のみです。

次の例では、プロパティ"country"がsetUseVertexPropertyValueAsLabel()への呼出しに指定されており、カンマ区切り","がsetPropertyValueDelimiter()への呼出しに指定されています。これら2つをまとめると、country頂点プロパティの値がカンマ区切りの頂点ラベルとして扱われることを意味します。たとえば、頂点Xの国プロパティの文字列値が"US"である場合、頂点ラベルはUSになり、頂点Yの文字列値が"UK,CN"である場合、2つのラベルUKおよびCNを持ちます。

GraphConfigBuilder.forPropertyGraph...

.setName("<your_graph_name>")

...

.setUseVertexPropertyValueAsLabel("country")

.setPropertyValueDelimiter(",")

.build();

親トピック: プロパティ・グラフ・データ用のJava APIの使用

5.4.9 インメモリー・グラフの構築

「グラフ・データのメモリーへの読込み」以外にも、インメモリー・グラフをプログラムで作成できます。これにより、グラフのサイズが小さい場合やグラフのコンテンツが非常に動的である場合、開発を簡略化できます。主要なJavaクラスは、addVertexおよびaddEdge APIを使用して追加された頂点とエッジのセットを累計できるGraphBuilderです。すべての変更が行われた後、GraphBuilderによってインメモリー・グラフ・インスタンス(PgxGraph)を作成できます。

次のJavaコード・スニペットは、グラフの構築フローを示します。まだ存在していない頂点は隣接するエッジが作成されるときに動的に追加されるため、addVertexに対する明示的な呼出しはありません。

import oracle.pgx.api.*;

PgxSession session = Pgx.createSession("example");

GraphBuilder<Integer> builder = session.newGraphBuilder();

builder.addEdge(0, 1, 2);

builder.addEdge(1, 2, 3);

builder.addEdge(2, 2, 4);

builder.addEdge(3, 3, 4);

builder.addEdge(4, 4, 2);

PgxGraph graph = builder.build();

頂点プロパティを使用してグラフを構築するには、作成された頂点オブジェクトに対してsetPropertyを使用できます。

PgxSession session = Pgx.createSession("example");

GraphBuilder<Integer> builder = session.newGraphBuilder();

builder.addVertex(1).setProperty("double-prop", 0.1);

builder.addVertex(2).setProperty("double-prop", 2.0);

builder.addVertex(3).setProperty("double-prop", 0.3);

builder.addVertex(4).setProperty("double-prop", 4.56789);

builder.addEdge(0, 1, 2);

builder.addEdge(1, 2, 3);

builder.addEdge(2, 2, 4);

builder.addEdge(3, 3, 4);

builder.addEdge(4, 4, 2);

PgxGraph graph = builder.build();

頂点およびエッジ識別子としてLong整数を使用するには、GraphBuilderの新しいインスタンスの取得時にIdType.LONGを指定します。次に例を示します。

import oracle.pgx.common.types.IdType;

GraphBuilder<Long> builder = session.newGraphBuilder(IdType.LONG);

エッジの構築時に、addEdgeへの呼出しで前に作成した頂点オブジェクトを直接使用できます。

v1 = builder.addVertex(1l).setProperty("double-prop", 0.5)

v2 = builder.addVertex(2l).setProperty("double-prop", 2.0)

builder.addEdge(0, v1, v2)

頂点の場合と同じように、エッジもプロパティを持つことができます。次の例では、setLabelを使用してエッジ・ラベルを設定します。

builder.addEdge(4, v4, v2).setProperty("edge-prop", "edge_prop_4_2").setLabel("label")親トピック: プロパティ・グラフ・データ用のJava APIの使用

5.4.10 プロパティ・グラフの削除

データベースからプロパティ・グラフを削除するには、OraclePropertyGraphUtils.dropPropertyGraphメソッドを使用します。このメソッドには、接続情報とグラフ名の2つのパラメータがあります。

接続情報のフォーマットは、バックエンド・データベースとしてHBaseまたはOracle NoSQL Databaseのいずれを使用しているかによって異なります。これは、OraclePropertyGraph.getInstanceに指定する接続情報と同じです。

5.4.10.1 Oracle NoSQL Databaseの使用

Oracle NoSQL Databaseでは、OraclePropertyGraphUtils.dropPropertyGraphメソッドはKVストア名、ホスト・コンピュータ名およびポート番号を接続に使用します。このコード・フラグメントは、my_graphという名前のグラフをOracle NoSQL Databaseから削除します。

String kvHostPort = "cluster02:5000"; String kvStoreName = "kvstore"; String kvGraphName = "my_graph"; // Use NoSQL Java API KVStoreConfig kvconfig = new KVStoreConfig(kvStoreName, kvHostPort); // Drop the graph OraclePropertyGraphUtils.dropPropertyGraph(kvconfig, kvGraphName);

親トピック: プロパティ・グラフの削除

5.4.10.2 Apache HBaseの使用

Apache HBaseでは、OraclePropertyGraphUtils.dropPropertyGraphメソッドはHadoopノードとApache HBaseポート番号を接続に使用します。このコード・フラグメントは、my_graphという名前のグラフをApache HBaseから削除します。

String hbQuorum = "bda01node01.example.com, bda01node02.example.com, bda01node03.example.com";

String hbClientPort = "2181";

String hbGraphName = "my_graph";

// Use HBase Java APIs

Configuration conf = HBaseConfiguration.create();

conf.set("hbase.zookeeper.quorum", hbQuorum);

conf.set("hbase.zookeper.property.clientPort", hbClientPort);

// Drop the graph

OraclePropertyGraphUtils.dropPropertyGraph(conf, hbGraphName);親トピック: プロパティ・グラフの削除

5.5 プロパティ・グラフ・データのテキスト索引付けの管理

Oracle Big Data Spatial and Graphの索引付けは、特定のキー/値またはキー/テキスト・ペア別に要素を高速に読み取ることを可能にします。これらの索引は、要素タイプ(頂点またはエッジ)、キー(および値)のセットおよび索引タイプに基づいて作成されます。

Oracle Big Data Spatial and Graphは、手動と自動の2つのタイプの索引付け構造をサポートしています。

-

自動テキスト索引は、プロパティ・キーのセット別に頂点またはエッジの自動索引付けを行います。この主な目的は、特定のキー/値ペアに基づく頂点およびエッジの問合せパフォーマンスを向上させることです。

-

手動テキスト索引付けでは、プロパティ・グラフの指定された頂点およびエッジのセットに対して複数の索引を定義できます。索引に含めるグラフ要素を指定する必要があります。

Oracle Big Data Spatial and Graphは、Oracle NoSQL DatabaseおよびApache HBaseのプロパティ・グラフに対して手動および自動テキスト索引を作成するためのAPIを提供します。索引は、使用可能な検索エンジン、Apache LuceneおよびSolrCloudを使用して管理されます。この節の続きでは、データ・アクセス・レイヤーのプロパティ・グラフ機能を使用してテキスト索引を作成する方法に焦点を当てます。

- プロパティ・グラフ・データのテキスト索引の構成

- プロパティ・グラフ・データの自動索引の使用

- プロパティ・グラフ・データの手動索引の使用

- プロパティ・グラフ・テキスト索引に対する検索問合せの実行

- データ型の処理

- ZookeeperへのコレクションのSolrCloud構成のアップロード

- プロパティ・グラフ・データのテキスト索引の構成設定の更新

- プロパティ・グラフ・データのテキスト索引でのパラレル問合せの使用

- プロパティ・グラフ・データのテキスト索引に対するネイティブ問合せオブジェクトの使用

- プロパティ・グラフ・データのテキスト索引に対するネイティブ問合せ結果の使用

親トピック: ビッグ・データ環境でのプロパティ・グラフの使用

5.5.1 プロパティ・グラフ・データのテキスト索引の構成

テキスト索引の構成は、OracleIndexParametersオブジェクトを使用して定義されます。このオブジェクトには、検索エンジン、場所、ディレクトリ(またはシャード)の数、および並列度などの索引に関する情報が含まれます。

デフォルトでは、テキスト索引はメソッドopg.setDefaultIndexParameters(indexParams)を使用してプロパティ・グラフに関連付けられたOracleIndexParametersに基づいて構成されます。自動索引の初期作成により、将来索引付けされるキーのために構成およびテキスト検索エンジンが区切られます。

別のパラメータ・セットを指定して索引を作成することもできます。次のコード・フラグメントは、Luceneエンジンとともに物理ディレクトリを使用して既存のプロパティ・グラフに対して自動テキスト索引を作成します。

// Create an OracleIndexParameters object to get Index configuration (search engine, etc).

OracleIndexParameters indexParams = OracleIndexParameters.buildFS(args)

// Create auto indexing on above properties for all vertices

opg.createKeyIndex("name", Vertex.class, indexParams.getParameters());

テキスト索引の初期構成を変更するには、最初に既存のグラフを削除してから、新しい構成を使用して索引を再作成する必要がある場合があります。

-

Apache Lucene検索エンジンを使用したテキスト索引の構成

-

SolrCloud検索エンジンを使用したテキスト索引の構成

Apache Lucene検索エンジンを使用したテキスト索引の構成

Apache Lucene検索エンジンを使用したテキスト索引では、LuceneIndexParameters構成オブジェクトを使用します。Lucene検索エンジンを使用した索引の構成パラメータには、次が含まれます。

-

ディレクトリの数: 自動索引に使用するApache Luceneディレクトリの数を指定する整数。複数のディレクトリを使用すると、記憶域とパフォーマンスのスケーラビリティを実現できます。デフォルト値は1に設定されています。

-

バッチ・サイズ: Apache Luceneでのバッチ処理用のドキュメントに使用するバッチ・サイズを指定する整数。デフォルトで使用されるバッチ・サイズは10000です。

-

バッチのコミット・サイズ:コミット操作が実行される前にApache Lucene索引に追加されるドキュメントの数を指定する整数。デフォルトで使用されるバッチのコミット・サイズは500000です。

-

データ型処理フラグ: Apache Luceneのデータ型処理を有効にするかどうかを指定するブール。データ型処理を有効にすると、数値および日時データ型に対する検索が高速になります。

-

ディレクトリ名: Apache Luceneディレクトリが作成されるベース・パスの場所を指定する文字列配列。

次のコード・フラグメントは、Apache Lucene検索エンジンとともに物理ディレクトリを使用してテキスト索引の構成を作成します。

OracleIndexParameters indexParams =

OracleIndexParameters.buildFS(4, 4, 10000, 50000, true,

"/home/data/text-index");

SolrCloud検索エンジンを使用したテキスト索引の構成

SolrCloud検索エンジンを使用したテキスト索引は、バックグラウンドでSolrIndexParametersオブジェクトを使用して、索引構築時に使用されるSolrCloudホスト名、シャードの数およびレプリケーション・ファクタを識別します。SolrCloud検索エンジンを使用した索引の構成パラメータには、次が含まれます。

-

構成名: Oracle Property GraphのSolrCloud構成ファイルが格納されるApache Zookeeperディレクトリの名前。例: opgconfig。構成ファイルには、必要なフィールドのスキーマ(schema.xml)および記憶域設定(solrconfig.xml)が含まれます。

-

サーバーURL: SolrCloudサービスに接続するために使用されるSolrCloudサーバーURL。例: http://localhost:2181/solr

-

SolrCloudノード・セット: コレクションのシャードが格納されるSolrCloudサービス内のノードのホスト名。例: node01:8983_solr,node02:8983_solr,node03:8983_solr。値がnullに設定されている場合、コレクションはサービス内で使用可能なすべてのSolrCloudノードを使用して作成されます。

-

Zookeeperのタイムアウト: Zookeeper接続を待機するために使用されるタイムアウト(秒単位)を表す正の整数。

-

シャードの数: テキスト索引コレクション用として作成するシャードの数。SolrCloud構成でHDFSディレクトリを使用している場合、シャードの数が、SolrCloudノード・セットに指定されているSolrCloudノードの数を超えないようにする必要があります。

-

レプリケーション・ファクタ: SolrCloudコレクションで使用されるレプリケーション・ファクタ。デフォルト値は1に設定されています。

-

ノード当たりのシャードの最大数: 各SolrCloudノードで作成できるシャードの最大数。この値は、シャードの数をSolrCloudノード・セット内のノードの数で割った値より小さくしないようにする必要があります。

-

DOP: プロパティ・グラフから頂点(またはエッジ)を読み込み、キー/値ペアに索引を付けるときに使用する並列度。デフォルト値は1に設定されています。

-

バッチ・サイズ: Apache SolrCloudでのバッチ処理用のドキュメントに使用するバッチ・サイズを指定する整数。デフォルトで使用されるバッチ・サイズは10000です。

-

バッチのコミット・サイズ:コミット操作が実行される前にApache SolrCloud索引に追加されるドキュメントの数を指定する整数。デフォルトで使用されるバッチのコミット・サイズは500000 (50万)です。

-

書込みタイムアウト: 索引操作が完了するまで待機するために使用するタイムアウト(秒単位)。通信エラーが原因で索引操作が失敗した場合、タイムアウトに達するか操作が完了するまで必要に応じて操作が繰り返し再試行されます。

次のコード・フラグメントは、SolrCloudを使用してテキスト索引の構成を作成します。

String configName = "opgconfig";

String solrServerUrl = "nodea:2181/solr"

String solrNodeSet = "nodea:8983_solr,nodeb:8983_solr," +

"nodec:8983_solr,noded:8983_solr";

int zkTimeout = 15;

int numShards = 4;

int replicationFactor = 1;

int maxShardsPerNode = 1;

OracleIndexParameters indexParams =

OracleIndexParameters.buildSolr(configName,

solrServerUrl,

solrNodeSet,

zkTimeout,

numShards,

replicationFactor,

maxShardsPerNode,

4,

10000,

500000,

15);

SolrCloudを使用する場合、「ZookeeperへのコレクションのSolrCloud構成のアップロード」で説明されているように、最初にテキスト索引のためのコレクションの構成をApache Zookeeperにロードする必要があります。

親トピック: プロパティ・グラフ・データのテキスト索引付けの管理

5.5.2 プロパティ・グラフ・データの自動索引の使用

自動テキスト索引は、プロパティ・キーのセット別に頂点またはエッジの自動索引付けを行います。その主な目的は、特定のキー/値ペアに基づく頂点およびエッジに対する索引速度を上げることです。特定のキーの自動索引が有効である場合、データベース索引を実行する代わりに、キー/値ペアの索引が索引に対してテキスト索引として実行されます。

プロパティ・グラフに対する自動索引を記述する場合、次のOracleプロパティ・グラフ・メソッドを使用して自動索引を作成、削除および操作します。

-

OraclePropertyGraph.createKeyIndex(String key, Class elementClass, Parameter[] parameters): 特定のプロパティ・キー別にelementClass型の要素すべての自動索引を作成します。索引は、指定したパラメータに基づいて構成されます。 -

OraclePropertyGraph.createKeyIndex(String[] keys, Class elementClass, Parameter[] parameters): プロパティ・キー・セット別にelementClass型の要素すべての自動索引を作成します。索引は、指定したパラメータに基づいて構成されます。 -

OraclePropertyGraph.dropKeyIndex(String key, Class elementClass): 特定のプロパティ・キー別にelementClass型の要素すべての自動索引を削除します。 -

OraclePropertyGraph.dropKeyIndex(String[] keys, Class elementClass): 特定のプロパティ・キー・セット別にelementClass型の要素すべての自動索引を削除します。 -

OraclePropertyGraph.getAutoIndex(Class elementClass):elementClass型の自動索引の索引インスタンスを取得します。 -

OraclePropertyGraph.getIndexedKeys(Class elementClass):elementClass型の要素すべての自動索引で現在使用されている索引付けされたキー・セットを取得します。

提供されているExampleNoSQL6およびExampleHBase6の例では、入力ファイルからプロパティ・グラフを作成し、頂点に自動テキスト索引を作成し、Apache Luceneを使用していくつかのテキスト検索問合せを実行します。

次のコード・フラグメントは、name、role、religion、countryのプロパティ・キーを指定して、既存のプロパティ・グラフの頂点に自動索引を作成します。自動テキスト索引は、/home/data/text-indexディレクトリの下にある4つのサブディレクトリに格納されます。Apache Luceneデータ型処理が有効になります。この例では、再索引付けタスクのためにDOP (並列度) 4を使用しています。

OraclePropertyGraph opg = OraclePropertyGraph.getInstance(

args, szGraphName);

String szOPVFile = "../../data/connections.opv";

String szOPEFile = "../../data/connections.ope";

// Do a parallel data loading

OraclePropertyGraphDataLoader opgdl =

OraclePropertyGraphDataLoader.getInstance();

opgdl.loadData(opg, szOPVFile, szOPEFile, dop);

// Create an automatic index using Apache Lucene engine.

// Specify Index Directory parameters (number of directories,

// number of connections to database, batch size, commit size,

// enable datatypes, location)

OracleIndexParameters indexParams =

OracleIndexParameters.buildFS(4, 4, 10000, 50000, true,

"/home/data/text-index ");

opg.setDefaultIndexParameters(indexParams);

// specify indexed keys

String[] indexedKeys = new String[4];

indexedKeys[0] = "name";

indexedKeys[1] = "role";

indexedKeys[2] = "religion";

indexedKeys[3] = "country";

// Create auto indexing on above properties for all vertices

opg.createKeyIndex(indexedKeys, Vertex.class);

デフォルトでは、索引はopg.setDefaultIndexParameters(indexParams)メソッドを使用してプロパティ・グラフに関連付けられたOracleIndexParametersに基づいて構成されます。

別のパラメータ・セットを指定して索引を作成することもできます。これは次のコード・スニペットに示されています。

// Create an OracleIndexParameters object to get Index configuration (search engine, etc).

OracleIndexParameters indexParams = OracleIndexParameters.buildFS(args)

// Create auto indexing on above properties for all vertices

opg.createKeyIndex("name", Vertex.class, indexParams.getParameters());

次の例のコード・フラグメントは、すべての頂点に対して問合せを実行し、キー値ペアname:Barack Obamaを持つすべての一致する頂点を検索します。この操作は、テキスト索引の検索を実行します。

さらに、getVertices APIコールでuseWildCardsパラメータを指定することにより、ワイルドカード検索がサポートされます。ワイルドカード検索は、指定されたプロパティ・キーに対して自動索引が有効化されている場合にのみサポートされます。Apache Luceneを使用したテキスト検索構文の詳細は、https://lucene.apache.org/core/2_9_4/queryparsersyntax.htmlを参照してください。

// Find all vertices with name Barack Obama.

Iterator<Vertices> vertices = opg.getVertices("name", "Barack Obama").iterator();

System.out.println("----- Vertices with name Barack Obama -----");

countV = 0;

while (vertices.hasNext()) {

System.out.println(vertices.next());

countV++;

}

System.out.println("Vertices found: " + countV);

// Find all vertices with name including keyword "Obama"

// Wildcard searching is supported.

boolean useWildcard = true;

Iterator<Vertices> vertices = opg.getVertices("name", "*Obama*",useWildcard).iterator();

System.out.println("----- Vertices with name *Obama* -----");

countV = 0;

while (vertices.hasNext()) {

System.out.println(vertices.next());

countV++;

}

System.out.println("Vertices found: " + countV);

前述のコード例では、次のような出力が生成されます。

----- Vertices with name Barack Obama-----

Vertex ID 1 {name:str:Barack Obama, role:str:political authority, occupation:str:44th president of United States of America, country:str:United States, political party:str:Democratic, religion:str:Christianity}

Vertices found: 1

----- Vertices with name *Obama* -----

Vertex ID 1 {name:str:Barack Obama, role:str:political authority, occupation:str:44th president of United States of America, country:str:United States, political party:str:Democratic, religion:str:Christianity}

Vertices found: 15.5.3 プロパティ・グラフ・データの手動索引の使用

手動索引は、プロパティ・グラフの頂点およびエッジに対して複数の索引の定義をサポートしています。手動索引の場合、索引の要素を手動で挿入、取得および選択する必要があります。

プロパティ・グラフに対する手動索引を記述する場合、次のOracleプロパティ・グラフ・メソッドを使用して手動索引を追加、削除および操作します。

-

OraclePropertyGraph.createIndex(String name, Class elementClass, Parameter[] parameters): elementClass型の要素すべてに指定した名前を使用して手動索引を作成します。 -

OraclePropertyGraph.dropIndex(String name): 特定の手動索引を削除します。 -

OraclePropertyGraph.getIndex(String name, Class elementClass): elementClass型の特定の手動索引の索引インスタンスを取得します。 -

OraclePropertyGraph.getIndices(): プロパティ・グラフ内で作成したすべての手動で索引の索引インスタンスの配列を取得します。

提供されているExampleNoSQL7およびExampleHBase7の例では、入力ファイルからプロパティ・グラフを作成し、エッジに手動テキスト索引を作成し、いくつかのデータを索引に含めて、Apache SolrCloudを使用していくつかのテキスト検索問合せを実行します。

SolrCloudを使用する場合、「ZookeeperへのコレクションのSolrCloud構成のアップロード」で説明されているように、最初にテキスト索引のためのコレクションの構成をApache Zookeeperにロードする必要があります。

次のコード・フラグメントは、4つのシャード(ノードごとに1つのシャード)とレプリケーション係数1を使用して既存のプロパティ・グラフに手動テキスト索引を作成します。シャードの数は、SolrCloudクラスタ上のノードの数と一致します。

OraclePropertyGraph opg = OraclePropertyGraph.getInstance(args,

szGraphName);

String szOPVFile = "../../data/connections.opv";

String szOPEFile = "../../data/connections.ope";

// Do a parallel data loading

OraclePropertyGraphDataLoader opgdl =

OraclePropertyGraphDataLoader.getInstance();

opgdl.loadData(opg, szOPVFile, szOPEFile, dop);

// Create a manual text index using SolrCloud// Specify Index Directory parameters: configuration name, Solr Server URL, Solr Node set,

// replication factor, zookeeper timeout (secs),

// maximum number of shards per node,

// number of connections to database, batch size, commit size,

// write timeout (in secs)

String configName = "opgconfig";

String solrServerUrl = "nodea:2181/solr"

String solrNodeSet = "nodea:8983_solr,nodeb:8983_solr," +

"nodec:8983_solr,noded:8983_solr";

int zkTimeout = 15;

int numShards = 4;

int replicationFactor = 1;

int maxShardsPerNode = 1;

OracleIndexParameters indexParams =

OracleIndexParameters.buildSolr(configName,

solrServerUrl,

solrNodeSet,

zkTimeout,

numShards,

replicationFactor,

maxShardsPerNode,

4,

10000,

500000,

15);

opg.setDefaultIndexParameters(indexParams);

// Create manual indexing on above properties for all vertices

OracleIndex<Edge> index = ((OracleIndex<Edge>) opg.createIndex("myIdx", Edge.class));

Vertex v1 = opg.getVertices("name", "Barack Obama").iterator().next();

Iterator<Edge> edges

= v1.getEdges(Direction.OUT, "collaborates").iterator();

while (edges.hasNext()) {

Edge edge = edges.next();

Vertex vIn = edge.getVertex(Direction.IN);

index.put("collaboratesWith", vIn.getProperty("name"), edge);

}

次のコード・フラグメントは、手動索引に対して問合せを実行して、キー値ペアcollaboratesWith:Beyonceを持つすべてのエッジを取得します。さらに、get APIコールでuseWildCardsパラメータを指定することにより、ワイルドカード検索がサポートされます。

// Find all edges with collaboratesWith Beyonce.

// Wildcard searching is supported using true parameter.

edges = index.get("collaboratesWith", "Beyonce").iterator();

System.out.println("----- Edges with name Beyonce -----");

countE = 0;

while (edges.hasNext()) {

System.out.println(edges.next());

countE++;

}

System.out.println("Edges found: "+ countE);

// Find all vertices with name including Bey*.

// Wildcard searching is supported using true parameter.

edges = index.get("collaboratesWith", "*Bey*", true).iterator();

System.out.println("----- Edges with collaboratesWith Bey* -----");

countE = 0;

while (edges.hasNext()) {

System.out.println(edges.next());

countE++;

}

System.out.println("Edges found: " + countE);

前述のコード例では、次のような出力が生成されます。

----- Edges with name Beyonce -----

Edge ID 1000 from Vertex ID 1 {country:str:United States, name:str:Barack Obama, occupation:str:44th president of United States of America, political party:str:Democratic, religion:str:Christianity, role:str:political authority} =[collaborates]=> Vertex ID 2 {country:str:United States, music genre:str:pop soul , name:str:Beyonce, role:str:singer actress} edgeKV[{weight:flo:1.0}]

Edges found: 1

----- Edges with collaboratesWith Bey* -----

Edge ID 1000 from Vertex ID 1 {country:str:United States, name:str:Barack Obama, occupation:str:44th president of United States of America, political party:str:Democratic, religion:str:Christianity, role:str:political authority} =[collaborates]=> Vertex ID 2 {country:str:United States, music genre:str:pop soul , name:str:Beyonce, role:str:singer actress} edgeKV[{weight:flo:1.0}]

Edges found: 15.5.4 プロパティ・グラフ・テキスト索引に対する検索問合せの実行

自動および手動テキスト索引に対してテキスト検索問合せを実行できます。これらの機能は、特定のキー/値ペアに基づく問合せと、(ワイルドカード、ファジー検索および範囲問合せなどの拡張問合せオプションを使用した)単一または複数のキーに対するテキスト検索の実行とでは異なります。

-

Apache Luceneを使用したテキスト索引に対する索引問合せの実行

-

SolrCloudを使用したテキスト索引に対する索引問合せの実行

Apache Luceneを使用したテキスト索引に対する索引問合せの実行

次のコード・フラグメントは、Apache Luceneを使用して自動索引を作成し、特定のキー/値ペアを指定してテキスト索引に対する問合せを実行します。

// Do a parallel data loading

OraclePropertyGraphDataLoader opgdl =

OraclePropertyGraphDataLoader.getInstance();

opgdl.loadData(opg, szOPVFile, szOPEFile, dop);

// Create an automatic index using Apache Lucene engine.

// Specify Index Directory parameters (number of directories,

// number of connections to database, batch size, commit size,

// enable datatypes, location)

OracleIndexParameters indexParams =

OracleIndexParameters.buildFS(4, 4, 10000, 50000, true,

"/home/data/text-index ");

opg.setDefaultIndexParameters(indexParams);

// Create manual indexing on above properties for all vertices

OracleIndex<Edge> index = ((OracleIndex<Edge>) opg.createIndex("myIdx", Edge.class));

Vertex v1 = opg.getVertices("name", "Barack Obama").iterator().next();

Iterator<Edge> edges

= v1.getEdges(Direction.OUT, "collaborates").iterator();

while (edges.hasNext()) {

Edge edge = edges.next();

Vertex vIn = edge.getVertex(Direction.IN);

index.put("collaboratesWith", vIn.getProperty("name"), edge);

index.put("country", vIn.getProperty("country"), edge);

}

// Wildcard searching is supported using true parameter.

Iterator<Edge> edges = index.get("country", "United States").iterator();

System.out.println("----- Edges with query: " + queryExpr + " -----");

long countE = 0;

while (edges.hasNext()) {

System.out.println(edges.next());

countE++;

}

System.out.println("Edges found: "+ countE);

この場合、テキスト索引により、キーおよび値オブジェクトから索引問合せが生成されます。また、useWildcardsフラグが指定または有効化されていない場合、取得される結果には正確な一致のみが含まれます。値オブジェクトが数値または日時値である場合、生成される問合せは、値によって下限および上限が定義されているかどうかとは関係なく、両端を含む範囲問合せになります。数値または日時の一致のみが取得されます。

値が文字列である場合、データ型とは関係なく一致するすべてのキー/値ペアが取得されます。このタイプの問合せの結果として生成されるテキスト問合せは、オプションの検索条件セット(サポート対象のデータ型ごとに1つずつ)が含まれるブール問合せです。データ型の処理の詳細は、「データ型の処理」を参照してください。

したがって、前のコード例では、問合せ式country1:"United States" OR country9:"United States" OR … OR countryE:"United States" (Luceneのデータ型処理が有効である場合)、または country:"1United States" OR country:"2United States" OR … OR country:"EUnited States" (Luceneのデータ型処理が無効である場合)を生成します。

文字列値オブジェクトでワイルドカードが有効である場合、値はApache Lucene構文を使用して書き込む必要があります。Apache Luceneを使用したテキスト検索構文の詳細は、https://lucene.apache.org/core/2_9_4/queryparsersyntax.htmlを参照してください

問合せの実行対象のデータ型クラスを指定することにより、一致するキー/値ペアのデータ型をフィルタできます。次のコード・フラグメントは、文字列データ型のみを持つ単一のキー/値ペアを使用してテキスト索引に対して問合せを実行します。次のコードは、問合せ式country1:"United States" (Luceneのデータ型処理が有効である場合)またはcountry:"1United States" (Luceneのデータ型処理が無効である場合)を生成します。

// Wildcard searching is supported using true parameter.

Iterator<Edge> edges = index.get("country", "United States", true, String.class).iterator();

System.out.println("----- Edges with query: " + queryExpr + " -----");

long countE = 0;

while (edges.hasNext()) {

System.out.println(edges.next());

countE++;

}

System.out.println("Edges found: "+ countE);

ブール演算子を使用して処理する場合は、問合せで適切な一致が見つかるように、後続の各キー/値ペアにデータ型の接頭辞/接尾辞を追加する必要があります。自動および手動テキスト索引に必要な問合せ構文およびデータ型識別子を使用して独自のLuceneテキスト検索問合せを作成するユーザーを支援するためにユーティリティが用意されています。

LuceneIndex内のメソッドbuildSearchTerm(key, value, dtClass)は、キー(または値)にデータ型識別子を追加し、特定のデータ型およびApache Luceneのデータ型処理構成に基づいて値を必要な文字列表現に変換することにより、field:query_expr形式の問合せ式を作成します。

次のコード・フラグメントは、buildSearchTermメソッドを使用して、前の例で使用した問合せ式country1:United* (Luceneのデータ型処理が有効である場合)またはcountry:1United* (Luceneのデータ型処理が無効である場合)を生成します。

String szQueryStrCountry = index.buildSearchTerm("country",

"United*", String.class);

キーおよび値を個別オブジェクトとして扱ってWildcardQueryのような異なるLucene問合せを構築するために、LuceneIndex内のメソッドappendDatatypesSuffixToKey(key, dtClass)およびappendDatatypesSuffixToValue(value, dtClass)は、適切なデータ型識別子を追加し、特定のデータ型に基づいて値を必要なLucene文字列表現に変換します。

次のコード・フラグメントは、appendDatatypesSuffixToKeyメソッドを使用してLuceneテキスト問合せで必要なフィールド名を生成します。Luceneのデータ型処理が有効である場合、返される文字列により、文字列データ型識別子がキー(country1)の接尾辞として追加されます。それ以外の場合、取得された文字列は元のキー(country)になります。

String key = index.appendDatatypesSuffixToKey("country", String.class);次のコード・フラグメントは、appendDatatypesSuffixToValueメソッドを使用して、Luceneテキスト問合せで必要な問合せ本体式を生成します。Luceneのデータ型処理が無効である場合、返される文字列により、文字列データ型識別子がキー(1United*)の接頭辞として追加されます。他のすべての場合、返される文字列は、値の文字列表現(United*)になります。

String value = index.appendDatatypesSuffixToValue("United*", String.class);LuceneIndexは、メソッドbuildSearchTermObject(key, value, dtClass)を使用した条件オブジェクトの生成もサポートしています。条件オブジェクトは通常、取得対象のドキュメントのフィールドおよび値を制約するためにLucene問合せオブジェクトの様々な型の間で使用されます。次のコード・フラグメントは、buildSearchTermObjectメソッドを使用してWildcardQueryオブジェクトを作成する方法を示します。

Term term = index.buildSearchTermObject("country", "United*", String.class);

Query query = new WildcardQuery(term);

SolrCloudを使用したテキスト索引に対する索引問合せの実行

次のコード・フラグメントは、SolrCloudを使用して自動索引を作成し、特定のキー/値ペアを指定してテキスト索引に対する問合せを実行します。

// Create a manual text index using SolrCloud// Specify Index Directory parameters: configuration name, Solr Server URL, Solr Node set,

// replication factor, zookeeper timeout (secs),

// maximum number of shards per node,

// number of connections to database, batch size, commit size,

// write timeout (in secs)

String configName = "opgconfig";

String solrServerUrl = "nodea:2181/solr"

String solrNodeSet = "nodea:8983_solr,nodeb:8983_solr," +

"nodec:8983_solr,noded:8983_solr";

int zkTimeout = 15;

int numShards = 4;

int replicationFactor = 1;

int maxShardsPerNode = 1;

OracleIndexParameters indexParams =

OracleIndexParameters.buildSolr(configName,

solrServerUrl,

solrNodeSet,

zkTimeout,

numShards,

replicationFactor,

maxShardsPerNode,

4,

10000,

500000,

15);

opg.setDefaultIndexParameters(indexParams);

// specify indexed keys

String[] indexedKeys = new String[4];

indexedKeys[0] = "name";

indexedKeys[1] = "role";

indexedKeys[2] = "religion";

indexedKeys[3] = "country";

// Create auto indexing on above properties for all vertices

opg.createKeyIndex(indexedKeys, Vertex.class);

// Create manual indexing on above properties for all vertices

OracleIndex<Vertex> index = ((OracleIndex<Vertex>) opg.getAutoIndex(Vertex.class);

Iterator<Vertex> vertices = index.get("country", "United States").iterator();

System.out.println("----- Vertices with query: " + queryExpr + " -----");

countV = 0;

while (vertices.hasNext()) {

System.out.println(vertices.next());

countV++;

}

System.out.println("Vertices found: "+ countV);

この場合、テキスト索引により、値オブジェクトから索引が生成されます。また、useWildcardsフラグが指定または有効化されていない場合、取得される結果には正確な一致のみが含まれます。値オブジェクトが数値または日時値である場合、生成される問合せは、値によって下限および上限が定義されているかどうかとは関係なく、両端を含む範囲問合せになります。数値または日時の一致のみが取得されます。

値が文字列である場合、データ型とは関係なく一致するすべてのキー/値ペアが取得されます。このタイプの問合せの結果として生成されるテキスト問合せは、オプションの検索条件セット(サポート対象のデータ型ごとに1つずつ)が含まれるブール問合せです。データ型の処理の詳細は、「データ型の処理」を参照してください。

したがって、前のコード例では、問合せ式country_str:"United States" OR country_ser:"United States" OR … OR country_json:"United States"を生成します。

ワイルドカードが有効な状態で文字列値オブジェクトを使用するには、値がApache Lucene構文を使用して書き込まれる必要があります。Apache Luceneを使用したテキスト検索構文の詳細は、「データ型の処理」を参照してください

問合せの実行対象のデータ型クラスを指定することにより、一致するキー/値ペアのデータ型をフィルタできます。次のコード・フラグメントは、文字列データ型のみを持つ単一のキー/値ペアを使用してテキスト索引に対して問合せを実行します。次のコードは、問合せ式country_str:"United States"を作成します。

// Wildcard searching is supported using true parameter.

Iterator<Edge> edges = index.get("country", "United States", true, String.class).iterator();

System.out.println("----- Edges with query: " + queryExpr + " -----");

countE = 0;

while (edges.hasNext()) {

System.out.println(edges.next());

countE++;

}

System.out.println("Edges found: "+ countE);

ブール演算子を使用して処理する場合は、問合せで適切な一致が見つかるように、後続の各キー/値ペアにデータ型の接頭辞/接尾辞を追加する必要があります。自動および手動テキスト索引に必要な問合せ構文およびデータ型識別子を使用して独自のSolrCloudテキスト検索問合せを作成するユーザーを支援するためにユーティリティ・セットが用意されています。

SolrIndex内のメソッドbuildSearchTerm(key, value, dtClass)は、キー(または値)にデータ型識別子を追加し、索引に必要なデータ型形式を使用して値を必要な文字列表現に変換することにより、field:query_expr形式の問合せ式を作成します。

次のコード・フラグメントは、buildSearchTermメソッドを使用して、前の例で使用した問合せ式country_str:United*を作成します。

String szQueryStrCountry = index.buildSearchTerm("country",

"United*", String.class);

キーおよび値を個別オブジェクトとして扱ってWildcardQueryのような異なるSolrClud問合せを構築するために、SolrIndex内のメソッドappendDatatypesSuffixToKey(key, dtClass)およびappendDatatypesSuffixToValue(value, dtClass)は、適切なデータ型識別子を追加し、特定のデータ型に基づいてキーおよび値を必要なSolrCloud文字列表現に変換します。

次のコード・フラグメントは、appendDatatypesSuffixToKeyメソッドを使用してSolrCloudテキスト問合せで必要なフィールド名を生成します。取得した文字列は、文字列データ型識別子をキーの接尾辞(country_str)として追加します。

String key = index.appendDatatypesSuffixToKey("country", String.class);次のコード・フラグメントは、appendDatatypesSuffixToValueメソッドを使用して、SolrCloudテキスト問合せで必要な問合せ本体式を生成します。返される文字列は、値の文字列表現(United*)になります。

String value = index.appendDatatypesSuffixToValue("United*", String.class);親トピック: プロパティ・グラフ・データのテキスト索引付けの管理

5.5.5 データ型の処理

Oracleのプロパティ・グラフ・サポートは、値のデータ型に基づいて要素のキー/値ペアを索引付けおよび格納します。データ型処理の主な目的は、数値や日付範囲の問合せなど、包括的な問合せのサポートを提供することです。

デフォルトでは、特定のキー/値ペアに対する検索は、その値のデータ型に基づく問合せ式まで行われます。たとえば、キー値ペアage:30を持つ頂点を検索する場合は、整数のデータ型が指定されたすべての年齢フィールドに対して問合せが実行されます。値が問合せ式である場合は、API get(String key, Object value, Class dtClass, Boolean useWildcards)をコールすることにより、検索する値のデータ型クラスも指定できます。データ型が指定されていない場合、問合せ式はすべての使用可能なデータ型と一致します。

ブール演算子を使用して処理する場合は、問合せで適切な一致が見つかるように、後続の各キー/値ペアにデータ型の接頭辞/接尾辞を追加する必要があります。次の各トピックでは、Apache LuceneおよびSolrCloudでこの接頭辞/接尾辞を追加する方法について説明します。

5.5.5.1 Apache Luceneでのデータ型識別子の追加

Luceneのデータ型処理が有効化されている場合、問合せ式のキーの接尾辞として適切なデータ型識別子を追加する必要があります。これは、キーに対してString.concat()の演算を実行することによって行うことができます。Luceneのデータ型処理が無効化されている場合、データ型識別子を値Stringに接頭辞として挿入する必要があります。表5-1は、Apache Luceneを使用したテキスト索引付けに使用可能なデータ型識別子を示しています(LuceneIndexのJavadocも参照)。

表5-2 Apache Luceneデータ型識別子

| Luceneデータ型識別子 | 説明 |

|---|---|

|

TYPE_DT_STRING |

String |

|

TYPE_DT_BOOL |

Boolean |

|

TYPE_DT_DATE |

Date |

|

TYPE_DT_FLOAT |

Float |

|

TYPE_DT_DOUBLE |

Double |

|

TYPE_DT_INTEGER |

Integer |

|

TYPE_DT_LONG |

Long |

|

TYPE_DT_CHAR |

Character |

|

TYPE_DT_SHORT |

Short |

|

TYPE_DT_BYTE |

Byte |

|

TYPE_DT_SPATIAL |

Spatial |

|

TYPE_DT_SERIALIZABLE |

Serializable |

次のコード・フラグメントは、Luceneのデータ型処理を使用してエッジに手動索引を作成し、データを追加してから、手動索引に対して問合せを実行し、ワイルドカードを使用してキー/値ペアcollaboratesWith:Beyonce AND country1:United*を持つすべてのエッジを取得します。

OraclePropertyGraph opg = OraclePropertyGraph.getInstance(args,

szGraphName);

String szOPVFile = "../../data/connections.opv";

String szOPEFile = "../../data/connections.ope";

// Do a parallel data loading

OraclePropertyGraphDataLoader opgdl =

OraclePropertyGraphDataLoader.getInstance();

opgdl.loadData(opg, szOPVFile, szOPEFile, dop);

// Specify Index Directory parameters (number of directories,

// number of connections to database, batch size, commit size,

// enable datatypes, location)

OracleIndexParameters indexParams =

OracleIndexParameters.buildFS(4, 4, 10000, 50000, true,