5 Oracle Exadata Database MachineのOracle VMドメインの管理

Oracle Exadata Database Machine上のOracle VMユーザー・ドメインを管理するには、管理ドメイン(domain-0またはdom0)からxm(1)コマンドを実行します。xm helpを実行すると、すべてのOracle VM管理コマンドの一覧が表示されます。

注意:

次に示すxmサブコマンドは、Oracle Exadata Database Machineではサポートされていません。

mem-set

mem-max

migrate

restore

resume

save

suspend

sched-*

cpupool-*

tmem-*

この項では、次の項目について説明します。

- Oracle VMおよびOracle Exadata Database Machine

- ベア・メタルOracle RACクラスタからOracle VMのOracle RACクラスタへの移行

- 実行中のドメインの表示

- ユーザー・ドメイン・コンソールの監視

- ユーザー・ドメインの開始

- ユーザー・ドメインの自動起動の無効化

- ユーザー・ドメイン内部のユーザー・ドメインのシャットダウン

- 管理ドメイン内部のユーザー・ドメインのシャットダウン

- Oracle VMユーザー・ドメインでのOracle Databasesのバックアップおよびリストア

- ユーザー・ドメインに割り当てられたメモリーの変更

- ユーザー・ドメインに割り当てられた仮想CPU数の変更

- ユーザー・ドメインのディスク領域の増加

- データベース・サーバーのディスク拡張キット追加後の/EXAVMIMAGESの拡張

- Oracle VM Oracle RACクラスタの作成

- ExadataでのOracle VM Oracle RACクラスタの拡張

- Oracle Grid InfrastructureおよびOracle Databaseの存在しないユーザー・ドメインの作成

- ユーザー・ドメインの別のデータベース・サーバーへの移動

- Oracle VMで実行するOracle RACクラスタの削除

- Oracle VM Oracle RACクラスタからのユーザー・ドメインの削除

- タグVLANインタフェースの実装

- Oracle Exadata Database MachineでのOracle VM Oracle RACクラスタ間のInfiniBandパーティションの実装

- Oracle VM環境でのOracle EXAchkの実行

注意:

特に明記された場合を除き、前述の手順で実行するすべてのコマンドはrootユーザーとして実行します。

5.1 Oracle VMおよびOracle Exadata Database Machine

Oracle Exadata Database Machineをデプロイする場合は、データベース・サーバーにOracle VMを実装できます。

Oracle VM Serverおよび1つ以上のOracle VMゲストが、すべてのデータベース・サーバーにインストールされます。Oracle Exadata Deployment Assistant (OEDA)で作成されたスクリプトを使用して初期デプロイメントでOracle VM環境を構成するか、既存の環境をOracle VMに移行できます。

5.1.1 Oracle VMについて

Oracle VMを使用すると、サポートされている仮想化環境内にOracle Linuxオペレーティング・システムとアプリケーション・ソフトウェアをデプロイできます。

Oracle Exadata Database Machine ExadataでOracle VMを使用する場合、ワークロードにCPU、メモリー、オペレーティング・システムおよびsysadminの分離を提供します。VMとネットワークおよびI/Oの優先度付けを組み合せて、完全なスタック分離を実現できます。連結の場合、Oracle VMで複数の信頼できるデータベースまたはプラガブル・データベースを作成すると、リソースをより動的に共有できます。

Oracle VM環境は、Oracle VM Server、仮想マシンおよびリソースで構成されます。Oracle VM Serverは、ドメインとも呼ばれる、仮想マシンを実行するための軽量でセキュアなサーバー・プラットフォームを提供する、管理された仮想化環境です。

Oracle VM Serverはベア・メタル・コンピュータにインストールされています。各Oracle VM Serverに存在するハイパーバイザは、フットプリントが非常に小さい仮想マシン・マネージャおよびスケジューラです。システムで唯一完全な権限を持つエンティティとなるように設計されています。CPUとメモリーの使用量、権限の確認、ハードウェア割込みなど、システムの最も基本的なリソースのみを制御します。

ハイパーバイザは、1台のホスト・コンピュータで複数の仮想マシンを安全に実行します。各仮想マシンは独自のドメインで実行され、独自のゲスト・オペレーティング・システムを持ちます。プライマリ管理ドメイン、dom0 (domain zeroの略称)は、ハイパーバイザの上部のゲストとしても実行されます。dom0には、ハードウェアおよびデバイス・ドライバへの特権アクセス権があります。

ユーザー・ドメイン(domU)は、InfiniBandHCAにアクセスできる権限のないドメインです。domUは、dom0によってOracle VM Serverで起動され、管理されます。ユーザー・ドメインは他のドメインとは独立して動作するため、domUの仮想リソースに適用される構成変更は、他のドメインには影響しません。domUの障害は、他のドメインには影響しません。

ドメイン、ゲストおよび仮想マシンは、ほぼ同じ意味に使用されていますが、若干の違いがあります。

- ドメインは、構成可能な一連のリソースで、メモリー、仮想CPU、仮想マシンを実行するネットワーク・デバイスおよびディスク・デバイスを含みます。

- ドメインまたは仮想マシンには仮想リソースが付与され、他のドメインまたはホスト・サーバー自体とは関係なく起動、停止および再起動できます。

- ゲストは、ドメイン内で実行される仮想化されたオペレーティング・システムです。各ゲスト・オペレーティング・システムには、「ユーザー・ドメイン」と呼ばれるこのシステムの管理ドメインがあり、「domU」と省略されます。

最大8つのゲストは、それぞれ独自のドメイン内で同じOracle VM Serverで実行できます。これらのドメインは、InfiniBandHCAにアクセスできる権限のないドメインです。各domUは、Oracle VM Serverで実行されるdom0とともに起動されます。他のドメインはdom0と直接相互作用しません。これらの要件は、ハイパーバイザ自体によって処理されます。dom0はハイパーバイザを管理する手段のみを提供します。

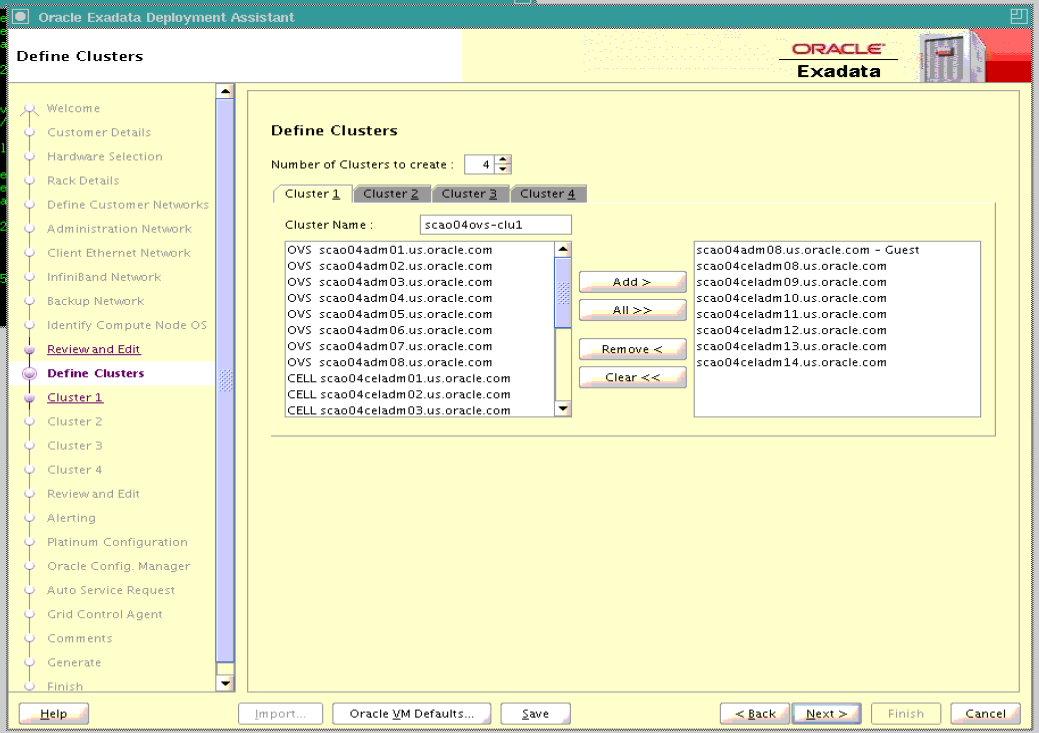

Oracle Exadata Database MachineでOracle VMを作成および構成するには、Oracle Exadata Deployment Assistant (OEDA)を使用します。

5.1.2 Oracle Exadata Database Machineでサポートされる仮想マシンの最大数

Oracle Exadata Database Serverの場合、サポートされる仮想マシンの最大数は8です。

ソフトウェアの前提条件については、My Oracle Supportのドキュメント888828.1を参照してください。

5.1.3 管理ドメイン(dom0)でサポートされている操作

dom0を手動で変更すると、Oracle VM Serverの構成上の問題が発生する場合があります。これにより、パフォーマンスが低下したり、サービスが失われる可能性があります。

警告:

Oracleでは、ドキュメント化されている内容以外のdom0への変更はサポートされていません。dom0内のサード・パーティ・ソフトウェアの実行はサポートされていません。dom0での操作がサポートされているかどうか不明な場合は、Oracleサポート・サービスに問い合せてください。

5.1.4 Oracle VMリソース

Oracle VMインフラストラクチャの2つの基本部分(ネットワークおよびストレージ)は、Oracle VMの外部で構成されます。

ネットワーク

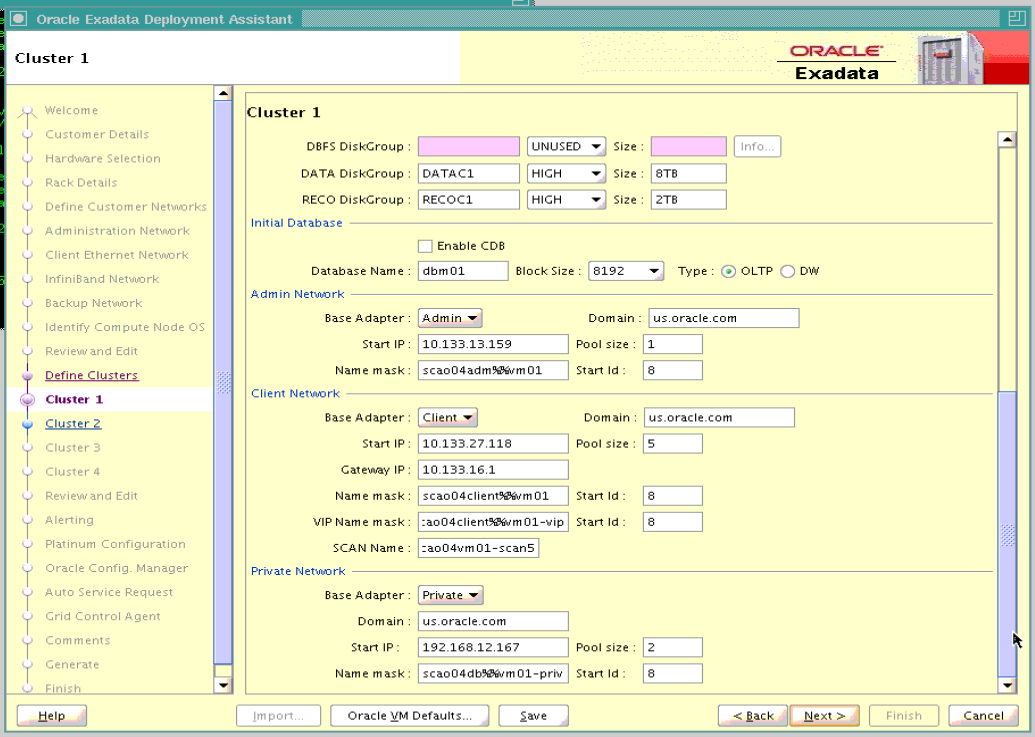

Oracle Exadata Deployment Assistant (OEDA)を使用してOracle Exadataラックの構成詳細を指定する場合は、Oracle VM環境に必要なネットワークIPアドレスの作成方法を入力します。生成されたOEDA設定ファイルはOracle Exadataラックに転送され、ネットワーク・アドレスの作成に使用されます。

ストレージ

Oracle VMには、仮想マシンの作成および管理に不可欠な環境リソースを格納する場所が常に必要です。こういったリソースには、ISOファイル(仮想DVDイメージ)、VM構成ファイル、およびVM仮想ディスクがあります。このようなリソースのグループが格納される場所を記憶域リポジトリといいます。

Oracle Exadata Database Machineでは、Oracle VMの記憶域はOCFS2 (Oracle Cluster File System)ストレージとして構成されます。

OEDAを使用してOracle Exadataラックを構成する場合、ユーザー・ドメイン内のローカル・ディスクのサイズを選択できます。/u01のサイズは、小(20GB)、中(40GB)または大(60GB)です。この領域には、Oracle Grid InfrastructureまたはOracle Databaseホーム・ディレクトリは含まれません。Oracleソフトウェア・ホーム・ディレクトリは、別のファイル・システムに格納されます。

Oracle VM用の記憶領域が必要な場合は、ディスク拡張キットを購入できます。追加のディスク領域を使用し、/EXAVMIMAGESを拡張して、より多くのOracle VMゲスト(最大8個まで)をサポートしたり、各domUの/u01パーティションのサイズを増やすことができます。

Exadataでサポートされる最大VM数

既存のExadata Database Serverの場合、サポートされるVMの最大数は8個です。ソフトウェアの前提条件については、My Oracle Supportのノート888828.1および1270094.1を参照してください。

5.1.4.1 管理ドメインのストレージ構成

管理ドメイン(dom0)には、イメージ・リポジトリおよびOracle VM構成ファイルが含まれます。

管理ドメインには次のディレクトリが含まれます。

/EXAVMIMAGES。ゲストの作成に使用されたイメージが格納されます。このディレクトリ内のZIPファイルには、ISOファイルが含まれています。/conf/GuestImages。各ユーザー・ドメインを表すファイルが格納されます。

管理ドメインは、物理ディスク/dev/sdaに存在します。次の3つのディスク・パーティションがあります。

/dev/sda1—/bootとしてマウントされます。/dev/sda2—swapに使用されます。/dev/sda3— ボリューム・グループVGExaDbに使用されます。

管理ドメイン用に作成された論理ボリュームは次のとおりです。

/dev/VGExaDb/LVDbSys2— バックアップの実行中にdbnodeupdate.shによって使用されます/dev/VGExaDb/LVDbSys3—/としてマウントされます/dev/VGExaDb/LVDbSwap1— スワップ領域に使用されます/dev/VGExaDb/LVDoNotRemoveOrUse— バックアップの実行中にdbnodeupdate.shによって使用されます/dev/VGExaDb/LVDbExaVMImages—EXAVMIMAGESとしてマウントされます

/EXAVMIMAGESディレクトリは、各仮想マシンの構成ファイルが配置される場所です。ファイルの名前は/EXAVMIMAGES/GuestImages/nodename/vm.cfgの形式になります。各仮想マシンには、イメージ・リポジトリ内のISOファイルを指すイメージ・ファイルもあります。pv1_vgeexadb.imgを除く次のファイルは、reflinks (OCFS2機能)を使用して作成されます。

/EXAVMIMAGES/GuestImages/user-domain-name/System.img/EXAVMIMAGES/GuestImages/user-domain-name/gridversion.img/EXAVMIMAGES/GuestImages/user-domain-name/dbversion.img

5.1.4.2 ユーザー・ドメインのストレージ構成

ユーザー・ドメイン(domU)は、仮想化されたデータベース・ノードです。

各ユーザー・ドメインには、管理ドメイン(dom0)レベルで4つの仮想ディスクがあります。これは、/EXAVMIMAGES/GuestImages/user_domain_name/vm.cfgで参照できます。これらの4つの仮想ディスクは、次に示すように、実際のディスク・イメージ・ファイルである/EXAVMIMAGES/GuestImages/user_domain_nameの4つのファイルにソフト・リンクされます。

/dev/xvdaは、システム・イメージ・ファイルSystem.img用です/dev/xvdbは、Oracle Grid Infrastructureイメージ・ファイル(grid12.1.0.2.2.imgなど)用です。この仮想ディスクのサイズは50GBで、/u01/app/version/gridとしてマウントされます。/dev/xvdcは、Oracle Databaseイメージ・ファイル(db12.1.0.2.2-3.imgなど)用です。この仮想ディスクのサイズは50GBで、/u01/app/oracle/product/version/dbhome_1としてマウントされます。/dev/xvddは、pv1_vgexadb.imgイメージ・ファイル用です

System.img (/dev/xvda)ディスクには、pre-grub2イメージ上に2つのパーティションが作成され、grub2イメージ上に3つのパーティションが作成されます。

- Pre-Grub2イメージ

- パーティション1 — ユーザー・ドメイン(512MB)のブート・パーティション(

/boot)で、ユーザー・ドメインのxvda1として表されます。 - パーティション2 — bios-grubが格納されている場所(24.5GB)。ユーザー・ドメインの

xvda2として表されます。

- パーティション1 — ユーザー・ドメイン(512MB)のブート・パーティション(

- Grub2イメージ

- パーティション1 — ユーザー・ドメイン(512MB)のブート・パーティション(

/boot)で、ユーザー・ドメインのxvda1として表されます。 - パーティション2 - Oracle Exadata Database Machine X7以上のシステムのEFIブート・パーティション

- パーティション3 — bios-grubが格納されている場所(24.5GB)。ユーザー・ドメインの

xvda3として表されます。

- パーティション1 — ユーザー・ドメイン(512MB)のブート・パーティション(

pv1_vgexadb.img (/dev/xvdd)ディスクには1つのパーティションがあります。ディスク・パーティション/dev/xvdd1のサイズは62GBです。

pre-grub2イメージの場合、2つの物理ボリューム(PV)がxvda2およびxvdd1パーティションの上部に配置されます。grub2イメージの場合、2つの物理ボリューム(PV)がxvda3およびxvdd1パーティションの上部に配置されます。サイズ86.49Gのボリューム・グループ(VgExaDb)は、これらの物理ボリュームの上部に配置されます。このボリューム・グループには、次の論理ボリューム(LVM)が含まれています。

/dev/VGExaDb/LVDbSys1(24GB) — ルート・ファイル・システム/に使用されます。このLVMは、xvda2パーティション(pre-grub2イメージの場合)またはxvda3パーティション(grub2イメージの場合)に制限されます。/dev/VGExaDb/LVDbSys2(24GB) —dbnodeupdateバックアップに使用されます。/dev/VGExaDb/LVDbOra1(24GB) —diagnostic_dest領域を格納する/u01ファイル・システムに使用されます。/dev/VGExaDb/LVDbSwap1(16GB) —swapに使用されます/dev/VGExaDb/LVDbDoNotRemoveOrUse(1GB) —dbnodeupdateによって使用される予約済LVM/dev/VGExaDb/LVDbVdnodenamedgname(128MB) — quorumディスク用。

前述のリストの最初のLVMおよび最後のLVM以外のすべてのLVMは、xvdd1パーティションに含まれています。

5.2 ベア・メタルOracle RACクラスタからOracle VMのOracle RACクラスタへの移行

注意:

このトピックは、2ソケットのx86サーバーにのみ適用されます。Oracle Exadata Database Machine X5-8などの8ソケット・サーバーには適用されません。ベア・メタルOracle RACクラスタからOracle VMのOracle RACクラスタへの移行は次の方法で実行できます。

-

既存のベア・メタルOracle RACクラスタを使用して、Oracle VMにOracle RACクラスタを移行します(ダウンタイムは発生しません)。

-

Oracle VMに新しいOracle RACクラスタを作成して、Oracle VMにOracle RACクラスタを移行します(最低限のダウンタイムが発生します)。

-

Oracle Data Guardを使用してOracle VMにOracle RACクラスタに移行します(最低限のダウンタイムが発生します)。

-

Oracle Recovery Manager (RMAN)バックアップおよびリストアを使用してOracle VMのOracle RACクラスタに移行します(ダウンタイムが発生します)。

ベア・メタルOracle RACクラスタからOracle VMのOracle RACクラスタに変換することは、次のことを示唆します。

-

各データベース・サーバーがOracle VM Serverに変換され、Oracle VM Serverには管理ドメイン(dom0)と、デプロイされるOracle RACクラスタの数に応じて1つ以上のユーザー・ドメインが作成されます。データベース・サーバー上の各ユーザー・ドメインは特定のOracle RACクラスタに属します。

-

変換手順の一環として、初めにベア・メタルOracle RACクラスタがOracle VM内の1つのOracle RACクラスタに変換されます。データベース・サーバーごとに1つのユーザー・ドメインがあります。

-

変換が終わった後のストレージ・セルのセル・ディスクとグリッド・ディスクの構成は、変換の開始時の構成と同じになります。

-

各データベース・サーバー上で管理ドメインによって使用されるシステム・リソースの量は同じになります。通常、管理ドメインでは8 GBのメモリーと4つの仮想CPUが使用されます。この点を考慮してOracle VMのOracle RACクラスタで実行するデータベースのSGAのサイズを決定してください。

- 詳細な手順は、My Oracle Supportノート2099488.1を参照してください。

5.5 Oracle Enterprise Managerを使用したOracle VMの監視

Oracle Enterprise ManagerのExadataプラグインは、Oracle Enterprise Managerの仮想インフラストラクチャ・プラグインと組み合せて、仮想化されたOracle Exadata Database Machineを検出、管理および監視します。

- Oracle Exadata Database Machine上のOracle VMドメインを検出する方法については、Oracle Enterprise Manager Exadata Managementスタート・ガイドの仮想化されたExadata Database Machineに関する項を参照してください。

5.10 Oracle VMユーザー・ドメインでのOracle Databasesのバックアップおよびリストア

Oracle VMユーザー・ドメインでのOracleデータベースのバックアップとリストアは、物理ノードでのOracleデータベースのバックアップとリストアと同じです。

5.11 ユーザー・ドメインに割り当てられたメモリーの変更

次の手順では、ユーザー・ドメインに割り当てられたメモリーを変更する方法について説明します。

注意:

ユーザー・ドメインに割り当てられるメモリーの量を減らす場合は、ユーザー・ドメインで実行中のデータベースのSGAサイズおよび対応するヒュージ・ページ・オペレーティング・システム構成を最初に確認して調整する必要があります。そうしない場合、Linuxオペレーティング・システムのブート中に、多すぎるメモリーがヒュージ・ページに予約されるため、ユーザー・ドメインを起動できなくなることがあります。詳細は、My Oracle Supportノート361468.1を参照してください。

注意:

この手順では、ユーザー・ドメインを再起動する必要があります。メモリー割当てを変更する場合、xm mem-setコマンドはサポートされていません。

5.12 ユーザー・ドメインに割り当てられた仮想CPU数の変更

-

ユーザー・ドメインに割り当てられた仮想CPU数を変更するためのすべてのアクションは、管理ドメインで実行されます。

-

ユーザー・ドメインに可能な仮想CPU数は、ユーザー・ドメインの

maxvcpusパラメータで設定される値の範囲内で、動的に増減します。 -

仮想CPUをオーバーコミットすると、すべてのドメインに割り当てられた仮想CPUを、システム上の物理CPU数より多く割り当てることができます。ただし、CPUのオーバーコミットは、過剰に収容されたリソースへの競合するワークロードが十分理解され、同時に発生する要求が物理能力を超えない場合にのみ、実行する必要があります。

次の手順では、ユーザー・ドメインに割り当てられた仮想CPU数を変更する方法について説明します。

-

次の手順に従い、物理CPU数を判別します。

-

管理ドメインで、次のコマンドを実行します。

# xm info | grep -A3 nr_cpus nr_cpus : 24 nr_nodes : 2 cores_per_socket : 6 threads_per_core : 2

出力で、

nr_nodes行はソケットの数を示しています。コマンドが実行されるExadataデータベース・サーバーのプロセッサは2ソケットで、ソケット当たり6コアであるため、物理CPUスレッドは24個(2ソケット x 6コア/ソケット = 12コア。12コア x 2スレッド/コア = 24 CPUスレッド)です。 -

次のコマンドを実行して、ユーザー・ドメインに構成されオンラインである仮想CPUの現在の設定を判別します。

# xm list DomainName -l | grep vcpus (vcpus 4) (online_vcpus 2)前述のコマンドで、DomainNameはユーザー・ドメインの名前です。コマンドの出力例では、ユーザー・ドメインの仮想CPUの最大数は4で、現在のオンライン仮想CPUは2です。このユーザー・ドメインのオンラインの仮想CPUの数は、ユーザー・ドメインがオンラインの間に、

vcpusパラメータよりも大きくない数に調整されます。オンラインの仮想CPUの数をvcpusパラメータよりも大きい値に増やすには、ユーザー・ドメインをオフラインにする必要があります。

-

-

次の手順に従い、仮想CPU数を小さくするまたは大きくします。

-

仮想CPU数を減らす手順は、次の通りです。

-

次のコマンドを使用して、ユーザー・ドメインに現在割り当てられている仮想CPUの数を判別します。

# xm listDomainName -

次のコマンドを使用して、現在割り当てられている仮想CPU数を減らします。

# xm vcpu-set

DomainNamevCPUs_preferred前述のコマンドで、vCPUs_preferredは、推奨される仮想CPU数の値です

-

-

仮想CPU数を増やす手順は、次の通りです。

-

次のコマンドを使用して、

vcpusパラメータの現在の設定を判別します。# xm list DomainName -l | grep vcpus (vcpus 4) (online_vcpus 2) -

推奨される仮想CPU数が、

vcpusパラメータの値より小さいか等しい場合、次のコマンドを実行して、オンライン仮想CPU数を増やします。# xm vcpu-set DomainName

vCPUs_preferred前述のコマンドで、vCPUs_preferredは、推奨される仮想CPU数の値です

-

推奨される仮想CPU数が、

vcpusパラメータの値より大きい場合、オンラインの仮想CPUの数をvcpusパラメータよりも大きい値に増やすには、ユーザー・ドメインをオフラインする必要があります。次の手順を実行します。i.ユーザー・ドメインをシャットダウンします。

ii.

/EXAVMIMAGES/GuestImages/DomainName/vm.cfgファイルのバックアップ・コピーを作成します。iii.

/EXAVMIMAGES/GuestImages/DomainName/vm.cfgファイルを編集し、vcpusパラメータを推奨される仮想vCPUの数に設定します。注意: デフォルトでは、ユーザー・ドメインは、

vcpusパラメータで構成された仮想CPUの数をオンラインにします。一部の仮想CPUをオフラインにしてユーザー・ドメインを起動する場合は、maxvcpusパラメータをvm.cfgに追加し、ユーザー・ドメインでオンラインにできる仮想CPUの最大数に設定します。vcpusパラメータを仮想CPUの数に設定し、ユーザー・ドメインの起動時にオンラインにします。たとえば、2つの仮想CPUがオンラインのユーザー・ドメインを起動し、そのユーザー・ドメインがオンラインの間に、さらに6つの仮想CPUをユーザー・ドメインに追加する場合は、次の設定をvm.cfgに使用します。maxvcpus=8 vcpus=2

iv.ユーザー・ドメインを開始します。

-

-

5.13 ユーザー・ドメインのディスク領域の増加

5.13.1 新規LVMディスクのユーザー・ドメインへの追加

次の手順では、新LVMディスクをユーザー・ドメインに追加して、ユーザー・ドメイン内で使用できるLVMディスク領域の量を増やす方法について説明します。この手順を実行すると、ファイル・システムまたはスワップLVMパーティションのサイズを増やすことができます。これはシステムがオンラインの場合に実行できます。

注意:

この手順は、管理ドメイン(Domain-0)およびユーザー・ドメイン内で実行する必要があります。

すべての手順を、rootユーザーとして実行してください。

5.13.2 rootファイル・システムのサイズの増加

この手順では、システム・パーティションおよび/ (ルート)ファイル・システムのサイズを増やす方法について説明します。

これはファイル・システムがオンラインの場合に実行できます。

注意:

2種類のシステム・パーティション、LVDbSys1およびLVDbSys2が使用できます。片方のパーティションがアクティブでマウントされます。もう一方のパーティションは非アクティブで、アップグレード中、バックアップする場所として使用します。この2つのシステム・パーティションは、サイズが等しい必要があります。

VGExaDbボリューム・グループ内に、少なくとも1GBの空き領域が必要です。空き領域は、ソフトウェア保守の際に、dbnodeupdate.shユーティリティで作成したLVMスナップショットで使用します。「Oracle Linuxデータベース・サーバーのスナップショット・ベースのバックアップの作成」の手順に従い、/ (root)および/u01ディレクトリのバックアップをスナップショット・ベースで作成する場合、VGExaDbボリューム・グループに少なくとも6GBの空き領域が必要です。

関連トピック

5.13.3 /u01ファイル・システムのサイズの増加

この手順では、/u01ファイル・システムのサイズを増やす方法について説明します。

これはファイル・システムがオンラインの場合に実行できます。

注意:

VGExaDbボリューム・グループ内に、少なくとも1GBの空き領域が必要です。空き領域は、ソフトウェア保守の際に、dbnodeupdate.shユーティリティで作成したLVMスナップショットで使用します。「Oracle Linuxデータベース・サーバーのスナップショット・ベースのバックアップの作成」の手順に従い、/ (root)および/u01ディレクトリのバックアップをスナップショット・ベースで作成する場合、VGExaDbボリューム・グループに少なくとも6GBの空き領域が必要です。

関連トピック

5.13.4 Oracle Grid InfrastructureホームまたはDatabaseホーム・ファイル・システムのサイズの増加

ユーザー・ドメイン内のOracle Grid InfrastructureまたはOracle Databaseホームのファイル・システムのサイズを増やすことができます。

Oracle Grid Infrastructureソフトウェア・ホームおよびOracle Databaseソフトウェア・ホームのために、それぞれのディスク・イメージ・ファイルが管理ドメインに作成されます。ディスク・イメージ・ファイルの場所は、/EXAVMIMAGES/GuestImages/DomainName/ディレクトリです。ディスク・イメージ・ファイルは、仮想マシンの起動中に自動的にユーザー・ドメインに関連付けられ、別個にLVMではないファイル・システムとしてユーザー・ドメインにマウントされます。

5.14 データベース・サーバーのディスク拡張キット追加後の/EXAVMIMAGESの拡張

データベース・サーバーにディスク拡張キットを追加するときには、適切な手順に従って、新しい領域を/EXAVMIMAGESファイル・システムに追加することが重要です。

5.14.1 リリース18.1.x以降の管理ドメインでの/EXAVMIMAGESの拡張

Oracle Exadata System Softwareリリース18c (18.1.0)以降のリリースを使用している場合は、この手順を使用して、ディスク拡張キットの追加後に管理ドメインで/EXAVMIMAGESファイル・システムを拡張します。

デプロイメント中、データベース・サーバー上の使用可能なディスク領域はすべて管理ドメイン (dom0)に割り当てられ、その領域のほとんどがユーザー・ドメイン・ストレージ用の/EXAVMIMAGESに割り当てられます。/EXAVMIMAGESファイル・システムが/dev/VGExaDb/LVDbExaVMImagesに作成されます。

次の例では、dm01db01が管理ドメインの名前で、dm01db01vm01がユーザー・ドメインです。

5.14.2 リリース12.2.xの管理ドメインでの/EXAVMIMAGESの拡張

Oracle Exadata System Softwareリリース12.2.xを使用している場合は、この手順を使用して、ディスク拡張キットの追加後に管理ドメインで/EXAVMIMAGESファイル・システムを拡張します。

デプロイメント中、データベース・サーバー上の使用可能なディスク領域はすべて管理ドメイン (dom0)に割り当てられ、その領域のほとんどがユーザー・ドメイン・ストレージ用の/EXAVMIMAGESに割り当てられます。/EXAVMIMAGESファイル・システムが/dev/VGExaDb/LVDbExaVMImagesに作成されます。

次の例では、dm01db01が管理ドメインの名前で、dm01db01vm01がユーザー・ドメインです。

5.14.3 リリース12.2.xより前の管理ドメインでの/EXAVMIMAGESの拡張

リリース12.1.x以前のOracle Exadata System Softwareを使用している場合は、この手順を使用して、ディスク拡張キットの追加後に管理ドメインで/EXAVMIMAGESディレクトリを拡張します。

デプロイメント中、データベース・サーバー上の使用可能なディスク領域はすべて管理ドメインに割り当てられ、その領域のほとんどがユーザー・ドメイン・ストレージ用の/EXAVMIMAGESに割り当てられます。/EXAVMIMAGESファイル・システムが/dev/sda3に作成されます。

次の例では、dm01db01が管理ドメインの名前で、dm01db01vm01がユーザー・ドメインです。

5.15 Oracle VM Oracle RACクラスタの作成

この手順では、Oracle Exadata Deployment Assistant構成ツールおよびデプロイメント・ツールを使用して、Oracle VM Oracle RACクラスタを作成します。

Oracle VM Oracle RACクラスタを追加する要件は、次のとおりです。

-

システムが、1つ以上のOracle VM Oracle RACクラスタにデプロイ済である。

-

メモリー、CPU、ローカル・ディスク領域およびOracle Exadata Storage Serverディスク領域などのリソースが、システムで使用可能である。

-

最初のシステム構成で使用したOracle Exadata Deployment Assistantデプロイメント・ファイルが、使用可能である。

5.16 ExadataでのOracle VM Oracle RACクラスタの拡張

Oracle Exadata Deployment Assistant (OEDA)を使用しゲスト・ドメインを追加して、Oracle VM上の既存のOracle RACクラスタを拡張できます。

注意:

この手順の実行中、既存のOracle RACクラスタ・ノードとそのデータベース・インスタンスでは、停止時間は発生しません。

この手順のユースケースは次のとおりです。

- Exadataラックのデータベース・サーバーのサブセットのみを使用する既存のOracle RACクラスタがあり、現在クラスタによって使用されていないノードが使用候補になった場合。

- 新しいOracle VM Serverノードまたは個別のExadataラックと最近相互ラック接続された既存のOracle RACクラスタがExadata上にある場合。

5.17 Oracle Grid InfrastructureおよびOracle Databaseの存在しないユーザー・ドメインの作成

ユーザー・ドメインは、システムにOracle Grid InfrastructureおよびOracle Databaseをインストールせずに作成することができます。新しいユーザー・ドメインの要素は、次の通りです。

-

オペレーティング・システム・イメージがOracle Linuxである。

-

管理ネットワーク、クライアント・ネットワークおよびInfiniBandネットワークへアクセスできる。

-

Oracle Grid InfrastructureおよびOracle Databaseがインストールされていない。

Oracle Grid InfrastructureおよびOracle Databaseの存在しないユーザー・ドメインを作成する手順は、次の通りです。

-

未使用の新規IPアドレスおよびホスト名を新しいユーザー・ドメインに割り当てます。IPアドレスおよびホスト名は、管理ネットワーク、クライアント(SCAN)ネットワークおよびプライベートInfiniBandネットワークで必要です。

注意:

アドレスごとに

pingコマンドを使用して、該当のInfiniBandネットワークのIPアドレスが使用されていないことを確認します。ibhostsコマンドには、ユーザー・ドメインのエントリが含まれていないため、このコマンドを使用して、すべてのInfiniBandネットワークのIPアドレスが使用されていることを確認することはできません。 -

必要に応じて、更新されたユーザー・ドメイン(domU)システム・イメージ・ファイルを取得します。

ユーザー・ドメインを作成するために、この手順の後で実行する

exadata.img.domu_makerコマンドには、ユーザー・ドメイン(domU)システム・イメージ・ファイルSystem.first.boot.version.imgが/EXAVMIMAGESに必要です(versionは、管理ドメインのExadataソフトウェアのバージョンに一致し、管理ドメインで"imageinfo -ver"コマンドを実行することで確認できます)。たとえば、

exadata.img.domu_makerを実行して、新しいユーザー・ドメインを作成し、管理ドメインのExadataソフトウェアのバージョンが12.1.2.1.1.150316.2の場合、ユーザー・ドメイン(domU)システム・イメージ・ファイル/EXAVMIMAGES/System.first.boot.12.1.2.1.1.150316.2.imgが存在する必要があります。# imageinfo -ver 12.1.2.1.1.150316.2 # ls -l /EXAVMIMAGES/System.first.boot.12.1.2.1.1.150316.2.img -rw-r--r-- 1 root root 13958643712 Mar 23 12:25 /EXAVMIMAGES/System.first.boot.12.1.2.1.1.150316.2.img

ユーザー・ドメイン(domU)システム・イメージ・ファイルが存在しない場合は、My Oracle Supportから取得し、管理ドメインの

/EXAVMIMAGESに配置する必要があります。詳細は、My Oracle Supportノート888828.1を参照してください。 -

次のコマンドを使用して、管理ドメインで、既存のXML構成ファイルをデプロイ済ユーザー・ドメインからコピーして、新しい名前のファイルにコピーします。

# cp /EXAVMIMAGES/conf/existingDomainName-vm.xml /EXAVMIMAGES/conf/newDomainName-vm.xml

前述のコマンドで、

existingDomainName-vm.xmlは、デプロイされたユーザー・ドメインのXML構成ファイルで、newDomainName-vm.xmlは新しいファイルの名前です。次の例では、ユーザー・ドメイン"dm01db01vm01"の構成ファイルを、

nondbdomain-vm.xmlにコピーします。# cp /EXAVMIMAGES/conf/dm01db01vm01-vm.xml /EXAVMIMAGES/conf/nondbdomain-vm.xml

-

管理ドメインで、次のようにして、新しいXMLファイルを編集します。

-

すべての

<Hostname>タグを変更して、対応するネットワークの新しいホスト名に一致させます。 -

すべての

<IP_address>タグを変更して、対応するネットワークの新しいIPアドレスに一致させます。 -

<virtualMachine>タグを変更して、新しいホスト名を含めます。 -

<hostName>タグを変更して、新しいホスト名を含めます。 -

すべてのサブ要素を含む、

<disk id="disk_2">および<disk id="disk_3">要素全体を削除します。開始<disk>タグから対応する終了</disk>の間のエントリ全体を削除する必要があります。

-

-

管理ドメインで、

/opt/exadata_ovm/exadata.img.domu_makerコマンドを使用して、InfiniBandネットワークGUIDを新しいユーザー・ドメインに割り当てます。# /opt/exadata_ovm/exadata.img.domu_maker allocate-guids \ /EXAVMIMAGES/conf/newDomainName-vm.xml \ /EXAVMIMAGES/conf/final-newDomainName-vm.xml -

管理ドメインで、

/opt/exadata_ovm/exadata.img.domu_makerコマンドを使用して、新しいユーザー・ドメインを作成します。# /opt/exadata_ovm/exadata.img.domu_maker start-domain \ /EXAVMIMAGES/conf/final-newDomainName-vm.xml

5.18 ユーザー・ドメインの別のデータベース・サーバーへの移動

ユーザー・ドメインを別のデータベース・サーバーへ移動できます。

ターゲットのOracle Exadata Database Serverが、次の要件を満たしている必要があります。

-

ターゲット・データベース・サーバーに、同一リリースのOracle Exadata System SoftwareおよびOracle VMがインストールされている。

-

ターゲット・データベース・サーバーに、同一のネットワークが表示されている。

-

ターゲット・データベース・サーバーは、同一のOracle Exadata Storage Serverにアクセスできる。

-

ターゲット・データベース・サーバーで、ユーザー・ドメインの操作に必要な十分な空きリソース(メモリー、CPUおよびローカル・ディスク領域)が使用可能である。

-

仮想CPUをオーバーコミットすると、すべてのドメインに割り当てられた仮想CPUを、システム上の物理CPU数より多く割り当てることができます。CPUのオーバーコミットは、過剰に収容されたリソースへの競合するワークロードが十分理解され、同時に発生する要求が物理能力を超えない場合にのみ、実行する必要があります。

-

メモリーをオーバーコミットすることはできません。

-

ディスク・イメージをターゲット・データベース・サーバーにコピーすると、ディスク・イメージ・ファイルの領域の割当てが増加する場合があります。これは、コピーされたファイルは、OCFS2 reflinkを利用してディスク領域を省略できないためです。

-

-

ユーザー・ドメイン名は、ターゲット・データベース・サーバーで未使用の名前にする必要があります。

次の手順に従い、ユーザー・ドメインを同一のOracle Exadata System Software構成内の新しいデータベース・サーバーに移動します。すべての手順は、管理ドメインで実行してください。

5.19 Oracle VMで実行するOracle RACクラスタの削除

クラスタ内で実行中のデータベースおよびこのデータベースで使用中のOracle Exadata Storage Serverで保存するすべてのデータを含む、Oracle VMクラスタのすべてのOracle RACノードを削除します。

Oracle VMクラスタの一部のユーザー・ドメインを削除する場合、次の項を参照してください。

Oracle VMクラスタを削除する手順は、主に2つあります。

-

ユーザー・ドメイン・ファイルを管理ドメインから削除する。

-

使用していないOracle Exadataグリッド・ディスクを削除する。

注意:

Oracle Exadata Deployment Assistant xml構成ファイルを後で再び使用する場合、削除されたユーザー・ドメインの定義がOracle Exadata Deployment Assistantファイル内に残っているため、それらの構成ファイルは同期できません。

5.20 Oracle VM Oracle RACクラスタからのユーザー・ドメインの削除

Oracle VMクラスタから1つのOracle RACノードを削除できます。

Oracle Exadataグリッド・ディスクは、クラスタ内に残っているノードで使用中のため、削除しないでください。

注意:

Oracle Exadata Deployment Assistant xml構成ファイルを後で再び使用する場合、削除されたユーザー・ドメインの定義がOracle Exadata Deployment Assistantファイル内に残っているため、それらの構成ファイルは同期できません。

5.21 タグVLANインタフェースの実装

このトピックでは、Exadata上のOracle VM環境でのタグVLANインタフェースの実装について説明します。

Oracle Exadata Database Machine上のOracle VMゲストで稼働しているOracleデータベースは、Oracle Exadata Deployment Assistant (OEDA)構成ツールで定義されたクライアントEthernetネットワークを介してアクセスされます。管理ドメイン(dom0)およびユーザー・ドメイン(domU's)の両方で、クライアント・ネットワーク構成は、初回のデプロイメント中にOEDAインストール・ツールが最初のユーザー・ドメインを作成すると、自動的に実行されます。

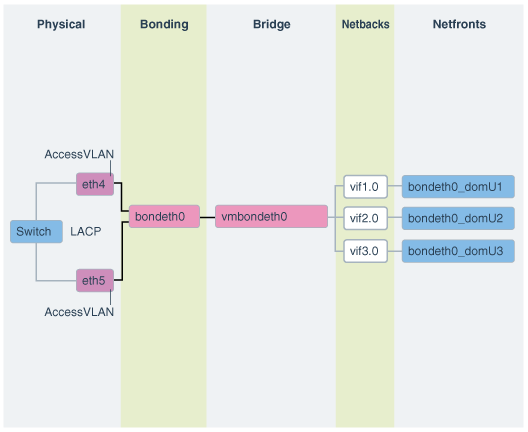

次の図に、デフォルトの結合クライアント・ネットワーク構成を示します。

ネットワークは、次のように構成されます:

-

dom0では、OEDAで定義されて、domUクライアントへのアクセスが許可されているethスレーブ・インタフェース(たとえば、eth1とeth2またはeth4とeth5)が、検出、構成されて、起動しますが、IPは割り当てられません。

-

dom0では、bondeth0マスター・インタフェースが構成され、起動しますが、IPは割り当てられません。

-

dom0では、ブリッジ・インタフェースvmbondeth0が構成されますが、IPは割り当てられません。

-

dom0では、特定のdomU's bondeth0インタフェースにマッピングされる仮想バックエンド・インタフェース(vif)がdomUごとに1つずつ構成され、起動しますが、IPは割り当てられません。これらのvifsは、ブリッジ・インタフェースvmbondeth0の上に構成されます。dom0 vifインタフェースと、これに対応するユーザー・ドメイン・インタフェース、bondeth0の間のマッピングは、

/EXAVMIMAGES/GuestImages/user domain nameにあるvm.cfgと呼ばれるユーザー・ドメイン構成ファイルで定義されます。

デフォルトのインストールでは、単一のbondeth0と対応するvmbondeth0ブリッジ・インタフェースは、前述で説明するようにdom0内で構成されます。このbondeth0インタフェースは、デフォルトのAccess Virtual Local Area Network (Access VLAN)に基づいています。Access VLANに対して、bondeth0を構築するスレーブ・インタフェースで使用されるスイッチ上のポートが構成されます。

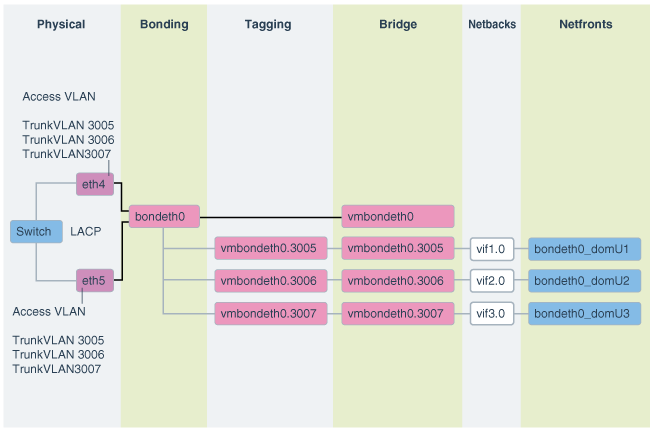

VLANタグ付けの使用

Exadataの仮想デプロイメントで、ユーザー・ドメインをまたいでネットワーク分離を有効にするなど、クライアント・ネットワーク上の他のVLANにアクセスする必要がある場合、802.1QベースのVLANタグ付けにより解決できます。次の図に、VLANタグ付けをしたクライアント・ネットワーク構成を示します。

図5-4 VLANタグ付けをしたOracle Virtual EnvironmentのNICレイアウト

「図5-4 VLANタグ付けをしたOracle Virtual EnvironmentのNICレイアウト」の説明

このようなクライアント・ネットワーク上の追加のタグ付けされたVLANインタフェースの構成方法および使用方法の手順は、My Oracle Supportノート2018550.1を参照してください。これらの手順の実行の前後に、Access VLANが継続して稼働および構成されている必要があります。Access VLANが無効にされることはありません。

5.22 Oracle Exadata Database MachineでのOracle VM Oracle RACクラスタ間のInfiniBandパーティションの実装

セキュリティの見地から、結合システムの重要な要件の1つは、結合システム内の複数の環境間のネットワーク分離です。Oracle Exadata上でOracle VM Oracle Real Application Clusters (Oracle RAC)クラスタを使用した結合では、これは、1つのOracle RACクラスタのネットワーク・トラフィックが別のOracle RACクラスタにアクセスできないようするなどの、異なるOracle RACクラスタ同士の分離を意味します。Ethernetネットワークでは、これは、My Oracle Support DocID 2018550.1で説明するように、VLANタグ付けを使用して完成します。InfiniBandネットワークでは、これは、カスタムInfiniBandパーティション、専用パーティション鍵およびパーティション化表を使用して完成します。

InfiniBandパーティションは、相互の通信を許可されるInfiniBandノードまたはメンバーのグループを定義します。InfiniBandパーティションでは、一意のパーティション鍵で識別されるパーティションが作成され、マスター・サブネット・マネージャで管理されます。メンバーは、これらのカスタム・パーティションに割り当てられます。パーティション内のメンバーは、メンバー自身同士でのみ通信できます(My Oracle Support DocID 2018550.1の付録1で説明されているように、メンバーシップにより異なります)。1つのパーティションのメンバーは、別のパーティションのメンバーとは、メンバーシップにかかわらず、通信できません。これらのラインを継続して、特定の1つのクラスタのOracle VM Oracle RACノードが、クラスタウェア通信用の1つの専用パーティションと、ストレージ・セルとの通信用の1つのパーティションに割り当てられます。このようにして、1つのOracle RACクラスタのノードは、異なるパーティションに属する別のOracle RACクラスタのノードと通信できません。それぞれのOracle RACクラスタのノードには、それらに割り当てられた異なるパーティション鍵があります。

デフォルトで、InfiniBandサブネット・マネージャは、パーティション鍵0x7FFF (制限されたメンバーシップ)または0xFFFF (完全なメンバーシップ)により識別される単一パーティションを提供します。カスタムのInfiniBandパーティションを使用していないOracle Exadata Database Machine上のOracle VMデプロイメントでは、すべてのユーザー・ドメイン間で、パーティション鍵0xFFFFが使用されます。

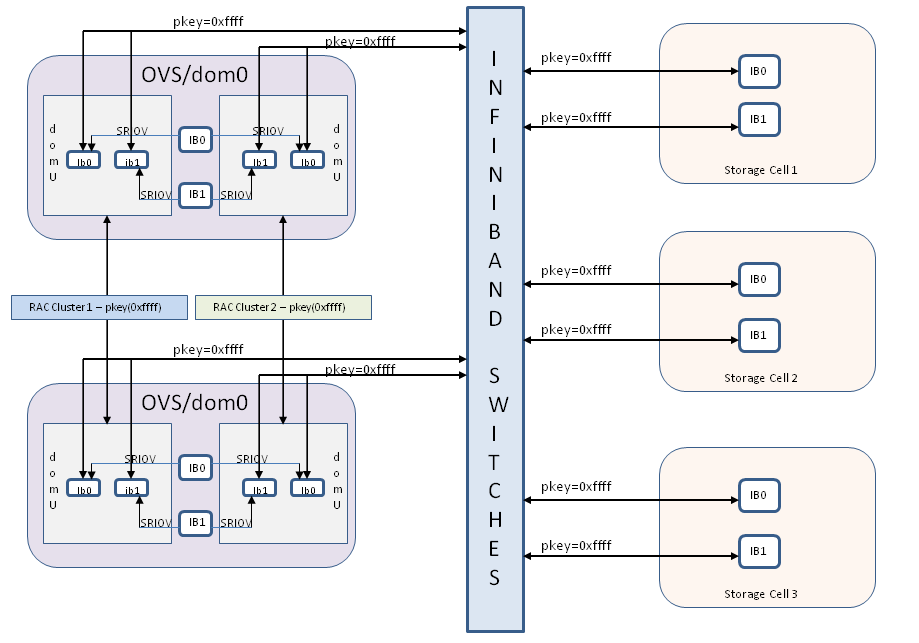

図5-5 クラスタ間でInfiniBandネットワーク分離がないOracle VM Oracle RACクラスタ

「図5-5 クラスタ間でInfiniBandネットワーク分離がないOracle VM Oracle RACクラスタ」の説明

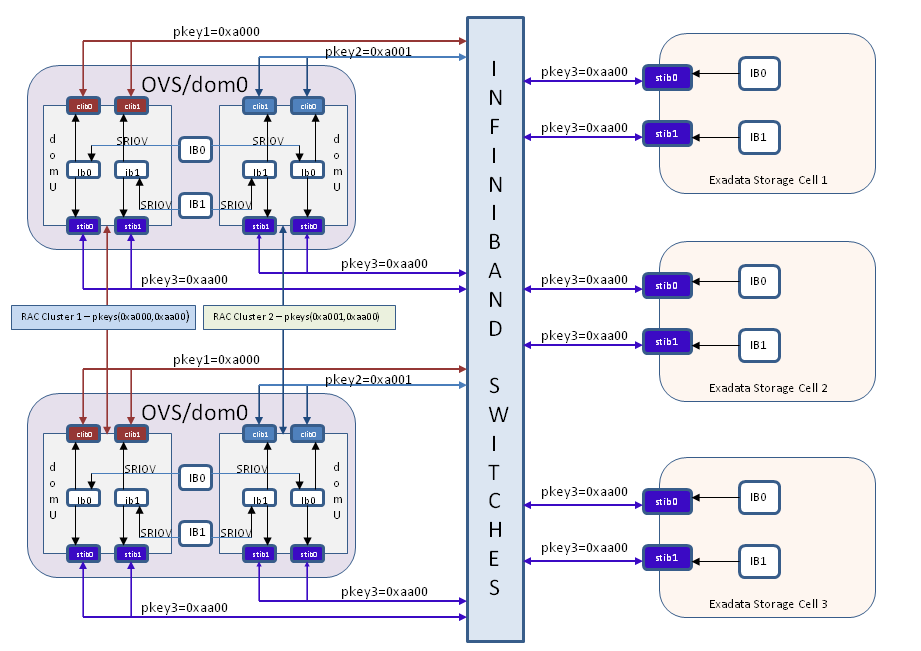

Oracle VM Oracle RACクラスタ間の分離の実装のかわりのデフォルトではないカスタム・パーティションを使用すると、構成は、図5-6に示すように変更されます。新しいインタフェースclib0、clib1 (クラスタpkey用)およびstib0、stib1 (ストレージpkey用)が、それぞれのユーザー・ドメイン(domU's)に存在します。

管理ドメイン(dom0)では、InfiniBandインタフェースの変更はありません。

図5-6 InfiniBandパーティションを使用してクラスタ間でInfiniBandネットワーク分離があるOracle VM Oracle RACクラスタ

「図5-6 InfiniBandパーティションを使用してクラスタ間でInfiniBandネットワーク分離があるOracle VM Oracle RACクラスタ」の説明

5.22.1 OVM RACクラスタ間のInfiniBandパーティションの実装: 要件

InfiniBandパーティションの構成前に、次のことを確認します。

-

ExadataシステムでOVMを構成しました。

-

すべてのユーザー・ドメインとストレージ・セルで、デフォルトのパーティション鍵0xFFFFを使用しています。

-

rootユーザー用に、いずれかの管理ドメイン(dom0ノード)からすべてのOVM RACクラスタ・ノード、ストレージ・セルおよびInfiniBandスイッチへの、パスワードなしのセキュア・シェル(SSH)・アクセスを設定しました。

-

InfiniBandスイッチがファームウェア・バージョン2.0.4以上で設置されています。

-

InfiniBandパーティションについて理解しています。

5.22.2 Oracle VM RACクラスタ間のInfiniBandパーティションの実装: 手順

InfiniBandパーティションを実装するには、次の大まかな手順を実行します。

-

InfiniBandスイッチで、クラスタウェアで使用されるそれぞれのOracle VM RACクラスタに対して、専用パーティション(クラスタpkey)を作成します。

-

InfiniBandスイッチで、Oracle RACクラスタ・ノードとストレージ・セルとの通信のために、すべてのOracle VM RACクラスタおよびストレージ・セルで使用される1つのパーティション(ストレージpkey)を作成します。

-

パーティションごとに、新しいIPoIBネットワーク・インタフェースが必要です。Oracle VM RACノードとストレージ・セルで、新しいIPoIBインタフェースのすべての関連するネットワーク構成ファイルを生成します(前の図のclib0、clib1、stib0、stib1)。

-

新しく作成したIPoIBインタフェースを使用するようにOracle VM RACクラスタ・ノードとすべてのOracle VM RACクラスタのGrid Infrastructure構成を変更します。

-

管理ドメイン(dom0)で、各ユーザー・ドメインのユーザー・ドメイン構成ファイルを、そのユーザー・ドメインに該当するパーティション鍵を使用するように変更します。

-

新しく作成したIPoIBインタフェースを使用するようにストレージ・セルを変更します。

-

ストレージ・セルとOracle RACクラスタを再起動して、Grid Infrastructureとデータベースが機能することを確認します。この一連の手順では、Oracle RACクラスタで多少のダウンタイムが発生します。この手順のときにダウンタイムが発生します。

この項では、各手順について詳しく説明します。

-

pkeyインタフェースによって使用されるIPアドレスを割り当てます。

クラスタにInfiniBandパーティションが実装されたときに、クラスタpkeyインタフェースおよびストレージpkeyインタフェースで使用される各Oracle VM RACクラスタのIPアドレスとネットマスクのセットを計画して割り当てます。

Oracle VM RACクラスタ内では、クラスタpkey IPアドレスおよびネットマスクは、ストレージpkey IPアドレスおよびネットマスクとは別のサブネット上に存在する必要があります。

参考として、次の表に、ある特定のRACクラスタのものを示します。

表5-1 既存の構成

インタフェース名 IPアドレス ネットマスク ib0

192.168.12.153

255.255.248.0

ib1

192.168.12.154

255.255.248.0

次の表に、この1つのOracle RACクラスタに対してこのドキュメントの手順を実行したときにpkeyインタフェースによって要求される新しいIPアドレスとネットマスクを示します。

表5-2 pkeyインタフェースによって要求される新しいIPアドレスとネットマスク

インタフェース名 IPアドレス ネットマスク clib0

192.168.112.1

255.255.248.0

clib1

192.168.112.2

255.255.248.0

stib0

192.168.114.1

255.255.240.0

stib1

192.168.114.2

255.255.240.0

-

InfiniBandスイッチでパーティション鍵を作成して構成します。

-

rootユーザー用に、いずれかのdom0ノードからInfiniBandファブリックのすべてのスイッチへのパスワードなしのSSH等価を有効化します。これは、この手順のすべてのスクリプトを実行するために使用するノードです。この手順では、このノードをドライバdom0と呼びます。

これを行うには、スクリプトを実行するために使用されるdom0ノードから、次の

dcliコマンドを実行します。# dcli –g ib_switch_list -l root –kib_switch_listは、ファブリックのすべてのInfiniBandスイッチが1つずつ個々の行に記載されたリストが含まれるファイルを示します。

-

ExadataでのOVM RACクラスタ間のInfiniBandパーティションの実装(My Oracle SupportのドキュメントID 2075398.1)に従って、

create_pkeys.tarをドライバdom0ノードにダウンロードして解凍します。tarファイルを解凍すると、3つのファイルが表示されます。-

create_pkeys_on_switch.sh -

run_create_pkeys.sh -

create_pkey_files.sh

-

-

ドライバdom0からスクリプト

create_pkeys_on_switch.shを実行して、InfiniBandスイッチでパーティション鍵を作成して構成します。注意:

create_pkeys_on_switch.shを1回実行すると、1つのパーティションが作成されます。作成するパーティションごとにスクリプトを1回実行する必要があります。たとえば、2つのOracle VM RACクラスタを含む環境に、1つのストレージ・パーティションと2つのクラスタ・パーティション(Oracle RACクラスタごとに1つ)の合計3つのパーティションを作成するとします。この例では、create_pkeys_on_switch.shを3回実行する必要があります。このスクリプトは、1つのみのノード(ドライバdom0)から実行する必要があります。これにより、スクリプトの実行中に入力として指定されたすべてのスイッチにパーティションが作成されます。

スクリプトの完了後に、すべてのスイッチでパーティションが作成されたことを確認します。

# /usr/local/sbin/smpartition list active no-page

この段階で、すべての必要なパーティションを作成したことを確認します。

-

-

パーティション鍵を使用するために、Oracle VM RACクラスタ・ノードを構成します。

注意:

この手順では、Oracle VM RACクラスタ・ノードに次の変更を加えます。

-

次のファイルを変更します。

-

/etc/sysconfig/network-scripts/ifcfg-ib0 -

/etc/sysconfig/network-scripts/ifcfg-ib1

-

-

次のファイルを削除します。

-

/etc/sysconfig/network-scripts/rule-ib0 -

/etc/sysconfig/network-scripts/rule-ib1 -

/etc/sysconfig/network-scripts/route-ib0 -

/etc/sysconfig/network-scripts/route-ib1

-

-

前述のファイルを変更または削除する前に、スクリプトでこれらを

/etc/sysconfig/network-scripts/backup-for-pkeysディレクトリにバックアップします。この手順が失敗した場合は、この手順を再実行する前に、/etc/sysconfig/network-scripts/backup-for-pkeysから/etc/sysconfig/network-scriptsにすべてのファイルをリストアします。 -

/etc/sysconfig/network-scriptsに次の新しいファイルを作成します。-

ifcfg-clib0 -

ifcfg-clib1 -

rule-clib0 -

rule-clib1 -

route-clib0 -

route-clib1 -

ifcfg-stib0 -

ifcfg-stib1 -

rule-stib0 -

rule-stib1 -

route-stib0 -

route-stib1

-

この手順が失敗し、前述のファイルが作成された場合は、この手順を再実行する前にこれらのファイルを削除する必要があります。

-

手順1で使用したドライバdom0ノードからの、パーティション鍵に対して構成する必要があるすべてのOracle RACクラスタ・ノードおよびストレージ・セルへのパスワードなしのSSHが設定されていることを確認します。

-

run_create_pkeys.shおよびcreate_pkey_files.shが実行可能で、これらがドライバdom0ノードの同じディレクトリに存在することを確認します。 -

run_create_pkeys.shを実行します。このスクリプトの構文は次のとおりです。run_create_pkeys.sh <node_name> <interface_name> <pkey_id> <node_type> <pkey_ipaddr> <pkey_netmask> <pkey_interfaceType><node_name>にノード名を指定します。

<interface_name>は

ib0またはib1のいずれかです。<pkey_id>に、

0xの接頭辞を除いたpkeyを指定します。<node_type>は

computeまたはcellのいずれかです。<pkey_ipaddr>にIPアドレスを指定します。

<pkey_netmask>に、

/21などのCIDR形式のネットマスクを指定します。<pkey_interfaceType>は、computeノード・タイプの場合は

clusterまたはstorage、cellノード・タイプの場合はstorageです。注意:

クラスタpkeyインタフェースのpkey_ipaddrおよびpkey_netmaskは、ストレージpkeyインタフェースのpkey_ipaddrおよびpkey_netmaskとは異なるサブネット上に存在する必要があります。

クラスタ・ノードの場合は、computeのノード・タイプ値を使用して、それぞれのクラスタ・ノードに対して合計4回スクリプトを実行する必要があります。

<pkey_id>は、手順2で入力したクラスタのpkey_idの値から導出されたクラスタのパーティション鍵です。

次のコマンドを使用すると、手順2で入力したpkey_idの値から、前述のコマンドに入力するパーティション鍵の値を導出できます。

FinalHexValue=$(echo "obase=16;ibase=2;$(expr 1000000000000000 + $(echo "obase=2;ibase=16;$(echo $HexValue|tr [:lower:] [:upper:])"|bc))"|bc|tr [:upper:] [:lower:])FinalHexValueはここでコマンドに入力される値で、HexValueは手順2で入力したpkey_idの値です。

次の表で、4回の実行について説明します。

表5-3 クラスタ・ノードに対する4回の実行

実行 インタフェース名 pkey_id node_type pkey_ipaddress pkey_netmask pkey_interfaceType 1

ib0

クラスタpkey ID

compute

ib0のクラスタpkey IPアドレス

ib0のクラスタpkeyネットマスク

cluster

2

ib1

クラスタpkey ID

compute

ib1のクラスタpkey IPアドレス

ib1のクラスタpkeyネットマスク

cluster

3

ib0

ストレージpkey ID

compute

ib0のストレージpkey IPアドレス

ib0のストレージpkeyネットマスク

storage

4

ib1

ストレージpkey ID

compute

ib1のストレージpkey IPアドレス

ib1のストレージpkeyネットマスク

storage

次に例を示します。

# ./run_create_pkeys.sh vm-guest-1 ib0 a000 compute 192.168.12.153 /21 cluster # ./run_create_pkeys.sh vm-guest-1 ib1 a000 compute 192.168.12.154 /21 cluster # ./run_create_pkeys.sh vm-guest-1 ib0 aa00 compute 192.168.114.15 /20 storage # ./run_create_pkeys.sh vm-guest-1 ib1 aa00 compute 192.168.114.16 /20 storageこの段階で、Oracle VM RACクラスタ・ノードの新しいpkey対応ネットワーク・インタフェースに対して、次に示す、すべての必要なネットワーク・ファイルが作成されています。

-

/etc/sysconfig/network-scripts/ifcfg-clib0 -

/etc/sysconfig/network-scripts/ifcfg-clib1 -

/etc/sysconfig/network-scripts/ifcfg-stib0 -

/etc/sysconfig/network-scripts/ifcfg-stib1 -

/etc/sysconfig/network-scripts/rule-clib0 -

/etc/sysconfig/network-scripts/rule-clib1 -

/etc/sysconfig/network-scripts/rule-stib0 -

/etc/sysconfig/network-scripts/rule-stib1 -

/etc/sysconfig/network-scripts/route-clib0 -

/etc/sysconfig/network-scripts/route-clib1 -

/etc/sysconfig/network-scripts/route-stib0 -

/etc/sysconfig/network-scripts/route-stib1

Oracle Grid Infrastructureも変更され、再起動時に新しいネットワーク・インタフェースを使用するようになりました。

$GRID_HOME/bin/oifcfg getifで、cluster_interconnectに使用されるインタフェースのリストにclib0とclib1が表示されます。 -

-

-

Oracle ASMおよびOracle RAC

CLUSTER_INTERCONNECTSパラメータを変更します。-

SYSとしてSQL*Plusを使用してOracle RACクラスタの各Oracle ASMインスタンスにログインし、次のコマンドを実行します。

alter system set cluster_interconnects='<cluster pkey IP address of ib0>:<cluster pkey IP address of ib1>' scope=spfile sid='<name of the current ASM instance>';次に例を示します。

alter system set cluster_interconnects='192.168.12.153:192.168.12.154' scope=spfile sid='<name of the current ASM instance>'; -

SQL*Plusを使用してOracle RACクラスタの各データベース・インスタンスにログインし、次のコマンドを実行します。

alter system set cluster_interconnects='<cluster pkey IP address of ib0>:<cluster pkey IP address of ib1>' scope=spfile sid='<name of the current RDBMS instance>';次に例を示します。

alter system set cluster_interconnects='192.168.12.153:192.168.12.154' scope=spfile sid='<name of the current RDBMS instance>'; -

すべてのOracle RACクラスタ・ノードでCRS自動起動を停止して無効化します。

# $GRID_HOME/bin/crsctl stop crs # $GRID_HOME/bin/crsctl disable crs

この段階で、Oracle Grid Infrastructure、Oracle ASMインスタンスおよびOracle Databaseインスタンスが、新しく作成したネットワーク・インタフェースを使用するように変更されました。

-

-

すべてのクラスタ・ノード(ユーザー・ドメイン)の

cellip.oraとcellinit.oraを変更します。-

すべてのOracle RACクラスタ・ノードの

/etc/oracle/cell/network-config/cellip.oraを手動で編集して、既存のIPアドレスを、手順6で設定するすべてのストレージ・セルの2つのストレージpkey IPアドレスに置き換えます。;を使用して2つのIPアドレスを区切ります。次に、

/etc/oracle/cell/network-config/cellip.oraファイルの例を示します。cell="192.168.114.1;192.168.114.2" cell="192.168.114.3;192.168.114.4" cell="192.168.114.5;192.168.114.6" cell="192.168.114.7;192.168.114.8" cell="192.168.114.9;192.168.114.10" cell="192.168.114.11;192.168.114.12" cell="192.168.114.13;192.168.114.14"この手順の目的を達成するために、次の手順をお薦めします。クラスタのいずれかのデータベース・サーバー・ノード(Oracle VM RACクラスタのユーザー・ドメイン)で、次の手順を実行します。

-

次のコマンドを実行します。

# cd /etc/oracle/cell/network-config # cp cellip.ora cellip.ora-bak -

cellip.ora-bakを変更します。 -

rootユーザー用にすべてのクラスタ・ノードからこのクラスタ・ノードへのSSH等価が設定されていることを確認します。

-

次のコマンドを実行します。

<cluster_nodes>は、Oracle VM RACクラスタのすべてのOracle RACクラスタ・ノードの名前が含まれるファイルで、個々の行で各ノードを示します。# /usr/local/bin/dcli -g <cluster_nodes> –l root "/bin/cp /etc/oracle/cell/network-config/cellip.ora /etc/oracle/cell/network-config/cellip-orig.ora" # /usr/local/bin/dcli -g <cluster_nodes> –l root –f cellip.ora-bak –d /etc/oracle/cell/network-config/cellip.ora

-

-

/etc/oracle/cell/network-config/cellinit.oraを/etc/oracle/cell/network-config/cellinit.ora-bakにバックアップします。 -

/etc/oracle/cell/network-config/cellinit.oraを手動で編集して、既存のIPアドレスおよびネットマスクを、手順3で使用したクラスタ・ノードの2つのストレージpkey IPアドレスおよびネットマスクに置き換えます。このIPアドレスとネットマスクは、手順3の3回目と4回目の実行で使用されています。

-

-

dom0のすべての関連する

vm.cfgファイルを変更します。この手順はOracle VM環境にのみ適用できます。すべてのdom0にログインして、手順2で作成したパーティション鍵を含めるように

/EXAVMIMAGES/GuestImages/<user domain name>/vm.cfgを手動で編集します。次の例を参照してください。次の行を変更します。

ib_pkeys = [{'pf':'40:00.0','port':'1','pkey':['0xffff',]},{'pf':'40:00.0','port':'2','pkey':['0xffff',]},]変更後:

ib_pkeys = [{'pf':'40:00.0','port':'1','pkey':['0xa000','0xaa00',]},{'pf':'40:00.0','port':'2','pkey':['0xa000','0xaa00',]},]前述の例では、

0xa000が手順2で入力したクラスタpkey_id値から導出されたクラスタのパーティション鍵で、0xaa00がストレージpkey_id値から導出されたストレージのパーティション鍵です。次のコマンドを使用すると、手順2で入力したpkey_idの値から、前述の

vm.cfgに入力するパーティション鍵の値を導出できます。FinalHexValue=$(echo "obase=16;ibase=2;$(expr 1000000000000000 + $(echo "obase=2;ibase=16;$(echo $HexValue|tr [:lower:] [:upper:])"|bc))"|bc|tr [:upper:] [:lower:])FinalHexValueは

vm.cfgに入力される値で、HexValueは手順2で入力したpkey_idの値です。注意:

環境内に複数のOracle VM RACクラスタがある場合は、すべてのOracle VM RACクラスタに対して手順3から6を実行した後で、手順7と手順8を1回のみ実行する必要があります。

-

パーティション鍵を使用するために、ストレージ・セルを構成します。

-

手順2で

run_create_pkeys.shおよびcreate_pkey_files.shを使用可能にしてあり、かつ、これらが手順2で使用した同じdom0ノードの同じディレクトリに存在することを確認します。 -

手順2で使用したdom0ノードからの、パーティション鍵に対して構成する必要があるすべてのストレージ・セルへのパスワードなしのSSHが設定されていることを確認します。

-

そのdom0ノードから

run_create_pkeys.shを実行します。ストレージ・セルのこのスクリプトの構文は次のとおりです。run_create_pkeys.sh <node_name> <interfaceName> <pkey_id> <node_type> <pkey_ipaddr> <pkey_netmask> <pkey_interfaceType><node_name>にノード名を指定します。

<interface_name>は

ib0またはib1のいずれかです。<pkey_id>に、

0xの接頭辞を除いたpkeyを指定します。<node_type>は

computeまたはcellのいずれかです。<pkey_ipaddr>にIPアドレスを指定します。

<pkey_netmask>に、

/21などのCIDR形式のネットマスクを指定します。<pkey_interfaceType>は、computeノード・タイプの場合は

clusterまたはstorage、cellノード・タイプの場合はstorageです。注意:

前述のコマンドの<pkey_id>は、手順2で入力したストレージのpkey_idの値から導出されたストレージのパーティション鍵です。

次のコマンドを使用すると、手順2で入力したpkey_idの値から、前述のコマンドに入力するパーティション鍵の値を導出できます。

FinalHexValue=$(echo "obase=16;ibase=2;$(expr 1000000000000000 + $(echo "obase=2;ibase=16;$(echo $HexValue|tr [:lower:] [:upper:])"|bc))"|bc|tr [:upper:] [:lower:])FinalHexValueはコマンドに入力される値で、HexValueは手順2で入力したpkey_idの値です。

ストレージ・セルの場合は、次の表に示すように、cellのnode_typeを使用して、それぞれのストレージ・セルに対して2回スクリプトを実行する必要があります。

表5-4 ストレージ・セルに対する2回の実行

実行 インタフェース名 pkey_id node_type pkey_ipaddress pkey_netmask pkey_interfaceType 1

ib0

ストレージpkey ID

cell

ib0のストレージpkey IPアドレス

ib0のストレージpkeyネットマスク

storage

2

ib1

ストレージpkey ID

cell

ib1のストレージpkey IPアドレス

ib1のストレージpkeyネットマスク

storage

次に例を示します。

# ./run_create_pkeys.sh cell-1 ib0 aa00 cell 192.168.114.1 /20 storage # ./run_create_pkeys.sh cell-1 ib1 aa00 cell 192.168.114.2 /20 storage注意:

スクリプトからの次のメッセージは無視できます。手順9のストレージ・セルの再起動でこれらの項目が考慮されます。

ネットワーク構成が変更されました。次のコマンドをルートで発行して、ネットワークを再起動し、IBスタックをオープンしてください:service openibd restartservice network restart新しいネットワーク構成を有効にするには、すべてのサービスを再起動する必要があります。MS-CELLSRV通信は、再起動されるまで行えない場合があります。この段階で、ストレージ・セルが、再起動時に新しいネットワーク・インタフェースを使用するように変更されました。

-

-

ストレージ・セルの

/opt/oracle.cellos/cell.confを変更して、ストレージ・セルを再起動します。-

/opt/oracle.cellos/cell.confをバックアップします。# cp /opt/oracle.cellos/cell.conf /opt/oracle.cellos/cell.conf-prepkey -

/opt/oracle.cellos/cell.confの次の行を変更します。次の行を変更します。

<Pkeyconfigured>no</Pkeyconfigured>変更後:

<Pkeyconfigured>yes</Pkeyconfigured>2つのプライベート・インタフェース、ib0とib1について、次の行を変更します。

<IP_enabled>yes</IP_enabled>変更後:

<IP_enabled>no</IP_enabled> -

すべてのOracle VM RACノードでGrid Infrastructureが停止されていることを確認します。

-

すべてのストレージ・セル・サーバーを再起動します。

-

ストレージ・セルが再度稼働したら、新しいpkey対応ネットワーク・インタフェースが使用中であることを確認します。

# cellcli -e list cell detail | egrep 'interconnect|ipaddress'これにより、新しいpkey対応インタフェース(stib0およびstib1)が新しいIPアドレスのセットとともに表示されます。

-

-

クラスタ・ノードを再起動します。

-

各ユーザー・ドメイン・ノードの対応するdom0にログインします。

-

次のコマンドを実行します。

# xm shutdown <user domain name> # xm create /EXAVMIMAGES/GuestImages/<user domain name>/vm.cfg

-

-

すべてのクラスタ・ノードで、Oracle Grid Infrastructureスタックを起動し、完全に稼働していることを確認します。

-

すべてのOracle RACクラスタ・ノードで、Grid Infrastructureスタックを起動し、自動起動を有効化します。

# $GRID_HOME/bin/crsctl start crs # $GRID_HOME/bin/crsctl enable crs

-

すべてのノードでOracle Grid Infrastructureが起動したら、新しく構成したpkeyインタフェースを使用するように

cluster_interconnectsパラメータが設定されていることを確認します。SQL> select inst_id, value from gv$parameter where name = 'cluster_interconnects' -

OCRから、古いクラスタ相互接続インタフェースを削除します。

# $GRID_HOME/bin/oifcfg delif –global ib0/<old subnet> # $GRID_HOME/bin/oifcfg delif –global ib1/<old subnet>

-

5.22.3 OVM RACクラスタ間のInfiniBandパーティションの実装: 制限されたメンバーシップの設定

2016年10月の12.1.0.2データベース・バンドル・パッチでセキュリティ拡張機能が導入され、2016年10月の12.1.0.2バンドル・パッチより前に使用されていた完全なメンバーシップのかわりに、制限されたメンバーシップを使用して、データベース・ノードのGUIDをストレージpkeyに割り当てることができます。これは、ストレージpkeyインタフェースを使用するとあるRACクラスタのあるRACノードが別のRACクラスタのRACノードと通信できるセキュリティ上の問題の対策になります。

完全なメンバーシップと制限されたメンバーシップ

InfiniBandパーティションは、相互の通信を許可されるInfiniBandノードのグループを定義します。InfiniBandパーティションで、マスター・サブネット・マネージャによって管理されるカスタムまたは一意のパーティション鍵を定義して、カスタムのパーティション鍵にメンバーを割り当てます。同じパーティション鍵を持つメンバーのみが相互に通信できます。1つのパーティション鍵のメンバーは、別のパーティション鍵を持つメンバーとは、メンバーシップのタイプにかかわらず、通信できません。1つのクラスタのOVM RACクラスタ・ノードには、クラスタウェア通信用の1つのパーティション鍵と、ストレージ・セルとの通信用の別のパーティション鍵が割り当てられます。このように、RACクラスタのノードは、異なるパーティション鍵が割り当てられた別のRACクラスタのノードとは通信できません。このことは、イーサネットの分野のタグ付けされたVLANと概念的に非常に似ています。

パーティション鍵(pkey)は15ビットの整数で、0x1から0x7FFFの値を持ちます。追加のビットであるメンバーシップ・ビットによって、パーティションのメンバーのメンバーシップが識別されます。メンバーシップは次のとおりです。

-

完全: メンバーシップ・ビットは1に設定されます。完全なメンバーシップを持つメンバーは、相互に通信できることに加えて、同じパーティション鍵内の制限されたメンバーシップを持つメンバーと通信できます。

-

制限: メンバーシップ・ビットは0に設定されます。パーティション内の制限されたメンバーシップを持つメンバーは、相互に通信できません。ただし、同じパーティション内の完全なメンバーシップを持つ他のメンバーと通信できます。

pkeyとメンバーシップ・ビットが組み合されて16ビットの整数を構成します。最も重要なビットはメンバーシップ・ビットです。

デフォルトで、InfiniBandサブネット・マネージャは、パーティション鍵0x7FFF (制限されたメンバーシップ)または0xFFFF (完全なメンバーシップ)により識別される単一パーティションを提供します。

HCAポートは、最大で128個のパーティションに参加できます。それぞれのパーティション鍵で新しいIPoIBネットワーク・インタフェースが提供されます。たとえば、パーティション鍵0xa001を持つInfiniBandポート1が新しいネットワーク・インタフェースになります。これらのインタフェースには、ifcfg-<interface>ファイル・パラメータによって意味のある名前が付けられます。

1つのInfiniBandノードを複数のパーティションのメンバーにできます。パケットがデータベース・ノードに到着すると、パケットのパーティション鍵(pkey)がサブネット・マネージャ構成と照合されます。この検証により、データベース・ノードが、それがメンバーになっているパーティションの外部の別のデータベース・ノードと通信できなくなります。

InfiniBandファブリック内のすべてのノードには、/sys/class/infiniband/mlx4_0/ports/[1-2]/pkeysで確認できるパーティション鍵の表があります。ノードのそれぞれのキュー・ペア(QP)には、その表の1つのエントリにマッピングされる索引(pkey)が関連付けられています。QPの送信キューからパケットが送信される場合は、索引付きのpkeyが添付されます。QPの受信キューでパケットを受信した場合は、索引付きのpkeyが受信パケットのものと比較されます。一致しない場合、パケットは警告なしで破棄されます。受信チャネル・アダプタはその到着を認識せず、同様に送信チャネル・アダプタも受信確認を取得しません。送信済パケットは単に失われたパケットとして示されます。受信パケットのpkeyがQPの受信キューの索引付きのpkeyと一致した場合にのみ、ハンドシェイクが行われてパケットが受け入れられ、送信チャネル・アダプタに確認が送信されます。このようにして、同じパーティションのメンバーのみが相互に通信でき、そのパーティションのメンバーではないホスト(つまり、パーティション表にそのpkeyを持たないホスト)とは通信できないようになっています。

次の手順で、2016年10月の12.1.0.2データベース・バンドル・パッチが適用されたpkey対応環境でこの拡張機能を設定する方法について説明します。次で説明するように、考えられるシナリオは2つあります。

ケース1.ローリング形式によるpkey対応環境での機能の実装

このケースでは、すでに2016年10月の12.1.0.2データベース・バンドル・パッチを適用しています。

次の手順を、1回に1つのノードに実行します。

-

ノードでグリッド・インフラストラクチャを停止します。

# $GI_HOME/bin/crsctl stop crs

-

このユーザー・ドメインのOVM RACクラスタ・ノードを管理するdom0 (制御ドメイン)の2つのポートのGUIDを特定します。

# /usr/sbin/ibstat | grep Port

-

SMマスターがrootとして実行されているInfiniBandスイッチにログインします。

-

InfiniBandスイッチで次のコマンドを実行します。

# /usr/local/sbin/smpartition start # /usr/local/sbin/smpartition modify -n <storage pkey name> -port <Port GUID1 of the dom0 from step 2> -m limited # /usr/local/sbin/smpartition modify -n <storage pkey name> -port <Port GUID2 of the dom0 from step 2> -m limited # /usr/local/sbin/smpartition commit

-

dom0のこのOVM RACユーザー・ドメイン・ノードの

vm.cfgファイルを変更します。-

rootとしてdom0にログインします。

-

/EXAVMIMAGES/GuestImages/<user domain name>/vm.cfgを編集して、次の例に示すようにパーティション鍵を変更します。次の行を変更します。

ib_pkeys = [{'pf':'40:00.0','port':'1','pkey':[ '0xclpkey','0x<stpkey>',]},{'pf':'40:00.0','port':'2','pkey':[ '0xclpkey','0x<stpkey>',]},]次のように変更します。

ib_pkeys = [{'pf':'40:00.0','port':'1','pkey':[ '0xclpkey','0x<mod_stpkey>',]},{'pf':'40:00.0','port':'2','pkey':[ '0xclpkey','0x<mod_stpkey>',]},]<mod_stpkey>は、次の式を使用して<stpkey>から導出されます。mod_stpkey=$(echo "obase=16;ibase=2;$(expr $(echo "obase=2;ibase=16;$(echo $stpkey|tr [:lower:] [:upper:])"|bc) - 1000000000000000)"|bc|tr [:upper:] [:lower:])前述の式の

<stpkey>と<mod_stpkey>は、0xの接頭辞なしで指定されています。

-

-

ユーザー・ドメインのRACノードの

/etc/sysconfig/network-scripts/ifcfg-stib*ファイルを変更します。次の式を使用して、これらのファイルのPKEY_IDを編集します。

mod_stpkey=$(echo "obase=16;ibase=2;$(expr $(echo "obase=2;ibase=16;$(echo $stpkey|tr [:lower:] [:upper:])"|bc) - 1000000000000000)"|bc|tr [:upper:] [:lower:])mod_stpkeyが新しいPKEY_IDで、stpkeyが古いPKEY_IDです。

前述の式の

<stpkey>と<mod_stpkey>は、0xの接頭辞なしで指定されています。 -

ユーザー・ドメインのRACノードの

/opt/oracle.cellos/pkey.confを変更します。ストレージ・ネットワークpkeyインタフェース(stib*)のPkeyを編集します。

変更前:

<Pkey>0xstpkey</Pkey>変更後:

<Pkey>0xmod_stpkey</Pkey>mod_stpkeyは、次の式を使用してstpkeyから導出されます。

mod_stpkey=$(echo "obase=16;ibase=2;$(expr $(echo "obase=2;ibase=16;$(echo $stpkey|tr [:lower:] [:upper:])"|bc) - 1000000000000000)"|bc|tr [:upper:] [:lower:])前述の式で使用されている

stpkeyとmod_stpkeyは、0xの接頭辞なしで指定されています。 -

OVM RACユーザー・ドメイン・ノードを再起動します。

-

rootとしてdom0にログインします。

-

次のコマンドを実行します。

# xm shutdown <user domain name> # xm create /EXAVMIMAGES/GuestImages/<user domain name>/vm.cfg

-

-

クラスタ・ノードでGrid Infrastructureスタックが完全に稼働していることを確認します。

-

残りのクラスタ・ノードに対して、1回に1つのノードでこの手順を繰り返します。

ケース2.ローリング形式による2016年10月の12.1.0.2データベース・バンドル・パッチの適用中のpkey対応環境での機能の実装

次の手順を、1回に1つのノードに実行します。

-

クラスタ・ノードで2016年10月の12.1.0.2データベース・バンドル・パッチを適用します。

-

パッチが適用されたノードで前述のケース1の手順1から10を繰り返します。

-

次のクラスタ・ノードに進み、前述の手順1および2を繰り返します。

注意:

dom0のGUIDが制限されたメンバーシップに変換された後、すべての新しいクラスタのデプロイメントには、2016年10月のデータベース・バンドル・パッチが前提条件として含められるようになります。

5.23 Oracle VM環境でのOracle EXAchkの実行

Oracle Exadata Database Machineでの仮想化は、Oracle EXAchkバージョン12.1.0.2.2以降でサポートされています。

Oracle Exadata Database Machine Oracle VM環境でOracle EXAchk監査チェックの完全なセットを実行するには、Oracle EXAchkをインストールして、次のように複数の場所から実行する必要があります。

-

1つの管理ドメイン(dom0)から

-

Oracle VM Oracle Real Application Clusters (Oracle RAC)クラスタごとに1つのユーザー・ドメイン(domU)から

たとえば、4つのOracle VM Oracle RACクラスタを含む2つのデータベース・サーバー(両方のデータベース・サーバーで合計8つのdomU、クラスタごとに2つのノード)を搭載しているOracle Exadata Database Machineクオータ・ラックでは、次のようにOracle EXAchkを個別に5回実行する必要があります。

-

最初のクラスタの最初のユーザー・ドメイン(domU)でOracle EXAchkを実行します。

-

2番目のクラスタの最初のユーザー・ドメイン(domU)でOracle EXAchkを実行します。

-

3番目のクラスタの最初のユーザー・ドメイン(domU)でOracle EXAchkを実行します。

-

4番目のクラスタの最初のユーザー・ドメイン(domU)でOracle EXAchkを実行します。

-

最初の管理ドメイン(dom0)でOracle EXAchkを実行します。

Oracle EXAchkによって実行される監査チェックは、次の表に指定されています。

表5-5 Oracle EXAchkによって実行される監査チェック

| Oracle EXAchkのインストールおよび実行先 | 実行される監査チェック |

|---|---|

|

管理ドメイン(dom0) |

ハードウェアおよびオペレーティング・システム・レベルのチェック対象:

|

|

ユーザー・ドメイン(domU) |

ユーザー・ドメインのオペレーティング・システム・レベル・チェックおよびOracle Grid InfrastructureおよびOracle Databaseのチェック |

Oracle EXAchkコマンドラインのオプション

Oracle EXAchkには、専用のコマンドライン・オプションが不要です。Oracle Exadata Database Machine Oracle VM環境で実行されていることと、管理ドメインとユーザー・ドメインのどちらで実行されているのかを自動的に検出し、適用可能な監査チェックを実行します。たとえば、最も簡単なケースとして、コマンドライン・オプションなしでOracle EXAchkを実行できます。

./exachk

Oracle EXAchkが管理ドメインで実行されると、すべてのデータベース・サーバー、ストレージ・サーバー、およびInfiniBandネットワーク経由でアクセス可能なInfiniBandスイッチで監査チェックを実行します。

サーバーまたはスイッチのサブセットでOracle EXAchkを実行するには、次のコマンドライン・オプションを使用します。

表5-6 Oracle EXAchkのコマンドライン・オプション

| オプション | 説明 |

|---|---|

|

|

データベース・サーバーのカンマ区切りリストを指定します。 |

|

|

ストレージ・サーバーのカンマ区切りリストを指定します。 |

|

|

InfiniBandスイッチのカンマ区切りリストを指定します。 |

たとえば、最初のクオータ・ラックのみが仮想化用に構成されているが、InfiniBandネットワーク経由ですべてのコンポーネントにアクセス可能なOracle Exadata Database Machineフル・ラックの場合、データベース・サーバーdm01adm01から次のようなコマンドを実行できます。

./exachk -clusternodes dm01adm01,dm01adm02

-cells dm01celadm01,dm01celadm02,dm01celadm03

-ibswitches dm01swibs0,dm01sw-iba0,dm01sw-ibb0