ダウンストリーム・データベース・マイニングのダウンストリームExtract

Oracle GoldenGate Extractを使用したダウンストリーム・データベース・マイニングおよびActive Data Guard (ADG)を使用したカスケード・ダウンストリーム・データベース・マイニングの構成について説明します。

ダウンストリーム・デプロイ用のExtractの構成

ノート:

ソース・データベース・サーバーとダウンストリーム・データベース・サーバーは、同じエンディアンおよびプロセッサ・タイプである必要があります。たとえば、ダウンストリームExtractは、ソース・サーバーがLinux (x86)でダウンストリーム・サーバーがWindows (x86)の場合は動作しますが、ソース・サーバーがHP-UXでダウンストリーム・サーバーがAIXの場合、またはソース・サーバーがHP PA-RISCでダウンストリーム・サーバーがHP-Itaniumの場合、動作しません。-

リアルタイム・マイニング・モード: リアルタイム・マイニング・モードでは、REDOレコードはオンラインREDOログまたはスタンバイREDOログから即時に処理されるため、データベース変更の処理に遅延はありません。

-

アーカイブ・ログ専用モード: アーカイブ・ログ・マイニング・モードでは、REDOレコードは、REDOログ・ファイルにアーカイブされるまで処理されません。

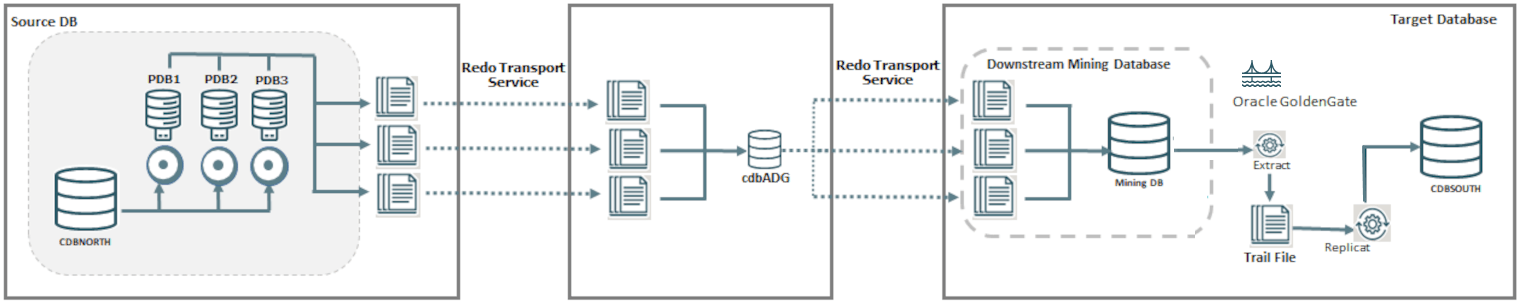

一般的なダウンストリーム・デプロイメントでは、データに変更が加えられるソース・データベースは、そのREDOログまたはアーカイブ・ログをマイニング・データベースに送信します。マイニング・データベースでは、ExtractプロセスによってREDOログがマイニングされ、証跡ファイルが書き込まれます。次の図では、CDBNORTHがソース・データベース、CDBSOUTHがターゲット・データベースです。ソースとターゲットの間に、ダウンストリームExtractからターゲットにREDOログを転送するデータベース・ログマイニング・サーバーを備えたマイニング・データベースがあります。

別の方法として、カスケード方式を使用することもできます。Active Data Guardスタンバイがある場合は、プライマリからログを送信するかわりに、スタンバイがREDOログをマイニング・データベースに送信するようにできます。このオプションは、ネットワーク帯域幅が制限されており、スタンバイ・データベースがマイニング・データベースと同じリージョンまたはデータ・センターにある場合に使用する必要があります。

ノート:

OracleのExtractプロセスは、データを取得するためにData GuardスタンバイまたはActive Data Guardスタンバイに接続できません。

カスケード・ダウンストリーム環境の設定に関する構成の詳細は、「ダウンストリームExtractがADGと連携できるようにする」を参照してください。

ダウンストリーム・デプロイ用のExtractオプションの評価

ダウンストリーム・マイニング・データベースでExtractを構成するには、次のガイドラインを考慮します:

-

複数のソース・データベースのREDOデータを1つのダウンストリーム・データベースに送信できます。ただし、ダウンストリーム・マイニング・データベースは、それらのソース・データベースの1つからのみオンラインREDOログを受け入れることができます。残りのソース・データベースはアーカイブ・ログを送る必要があります。

-

オンライン・ログがダウンストリーム・データベースに送られると、Extractによるリアルタイム・キャプチャが可能です。Extractでソース・ログからの読取りと同様に変更がキャプチャされます。オンラインREDOログをソース・データベースから受け入れるには、ダウンストリーム・マイニング・データベースにスタンバイREDOログが構成されている必要があります。

-

ダウンストリーム・マイニング構成を使用する場合、ソース・データベースとマイニング・データベースは、エンディアンとビット・サイズ(64ビット)が同じである必要があります。たとえば、ソース・データベースがLinux 64ビットである場合、マイニング・データベースを64ビットWindowsで実行できます(これらのエンディアンとビット・サイズが同じため)。

-

初期化パラメータ

db_block_sizeは、ソース・データベースとマイニング・データベースで同じである必要があります。

ダウンストリーム・デプロイ用のソース・データベースの準備

ソース・データベースにExtractユーザーが必要です。Extractではこのユーザーの資格証明を使用してメタデータ問合せを行い、必要に応じてソース・データベースから列値をフェッチします。

Microservices ArchitectureのWebインタフェースからソース・データベースにExtractを接続するための資格証明を追加します。

トピック:

ソース・データベースに接続するためのデータベース資格証明の追加

ExtractおよびReplicatプロセスを作成して実行するには、データベース資格証明を設定して、Extract/Replicatユーザーをそれぞれのソース・データベースまたはターゲット・データベースに接続する必要があります。

- Administration Serviceインタフェースを起動してログインします。

- 「アプリケーション・ナビゲーション」ペインで「構成」をクリックします。

- 資格証明の横にあるプラス記号(+)をクリックします。

- 表示されたフィールドに次の詳細を入力します。

データベース資格証明オプション 説明 資格証明ドメイン データベース資格証明を関連付けるドメイン名を指定します。たとえば、ドメイン名を指定しない場合は、OracleGoldenGateがデフォルトのドメイン名となります。 資格証明別名 これはデータベース資格証明の別名です。 ユーザーID データベース・ユーザーのユーザー名です。

Oracleデータベースの場合、EZconnect構文を使用してデータベースに接続するときは、このフィールドの値を次のように指定できます。

dbusername@hostname:port/service_namedbusernameは、データベース・ユーザー名です。そのデータベースが実行されているサーバーのhostnameまたはIPアドレス。portは、データベース・サーバーに接続するためのポート番号です。通常、この値は1521です。service_nameは、データベース接続のtnsnames.oraファイル内で指定されているサービスの名前です。パスワード データベース・ユーザーがデータベースにログインするために使用するパスワード。 - 「発行」をクリックします。

- 「データベースに接続」アイコンをクリックして、接続が正しく機能していることをテストします。接続に成功すると、データベースに接続アイコンが青に変わります。

データベースに正常にログインすると、チェックポイント表、トランザクション情報(TRANDATA)およびハートビート表を追加および管理できるようになります。すべての表は様々な検索フィールドを使用して検索できます。入力するにつれて表が絞り込まれます。また、検索テキストを指定して検索ボタンを使用できます。

ソース・データベースからダウンストリーム・マイニング・データベースへのREDO転送の構成

ソース・データベースからダウンストリーム・マイニング・データベースへのREDOログ・ファイルの転送を設定し、ダウンストリーム・マイニング・データベースでこれらのREDOログ・ファイルを受け入れる準備をするには、このトピックで説明したステップを実行します。

複数のソースから1つのダウンストリーム・マイニング・データベースへのREDOの送信をサポートするためのルールを次に要約します。

- オンラインREDOログをダウンストリーム・マイニング・データベースのスタンバイREDOログに送信するよう構成できるのは、1つのソース・データベースのみです。このソース・データベースの

log_archive_dest_n設定にTEMPLATE句を含めることはできません。 - オンラインREDOログをダウンストリーム・マイニング・データベースのスタンバイREDOログに送信しないソース・データベースには、

log_archive_dest_nパラメータにTEMPLATE句を指定する必要があります。 - ダウンストリーム・マイニング・データベースに送信する各ソース・データベースは一意の

DBIDを持つ必要があります。これらのソース・データベースのv$databaseビューからDBID列を選択し、DBIDが一意であることを確認します。 - ダウンストリーム・マイニング・データベースに対して、

FAL_SERVER値を設定する必要があります。FAL_SERVERには、スタンバイ・データベースのFAL(フェッチ・アーカイブ・ログ)サーバーを指定します。値はOracle Netサービス名のリストで、スタンバイ・データベース・システムで、目的のFALサーバーをポイントするように正しく構成されていることを前提とします。リストには、ダウンストリーム・データベースにREDOを送信する可能性のある任意のデータベースのNetサービス名が含まれます。 - REDO転送を使用する場合、ネットワーク待機時間のためREDOの処理に遅延が生じる可能性があります。Extractでは、この待機時間はソース・データベースから受信したLCR間の遅延を測定し、その遅延を報告することでモニタリングされます。待機時間がしきい値を超える場合、レポート・ファイル内に警告メッセージが表示され、ラグが標準的な値まで減少すると後続の情報メッセージが表示されます。しきい値のデフォルト値は10秒です。

ノート:

ソース・データベースから送られたアーカイブ・ログは、外部アーカイブ・ログと呼ばれます。外部アーカイブ・ログの格納にダウンストリーム・マイニング・データベースのリカバリ領域を使用することはできません。そのような構成は、Extractではサポートされません。フラッシュ・リカバリ領域(FRA)に格納された外部アーカイブ・ログは、RMANジョブによって自動的に削除されることはありません。そうしたアーカイブ・ログは手動でパージする必要があります。これらの手順では、必要に応じて複数のソースからREDOを転送するための要件が考慮されています。これらのソースのそれぞれについてExtractプロセスを構成する必要があります。

REDO転送を構成する手順:

- データベース接続を構成して、ソース・データベースをマイニング・データベースに接続します。

- REDOデータの転送をサポートするよう、各ソース・データベースとダウンストリーム・マイニング・データベースで認証を構成します。REDO転送セッションは、Secure Sockets Layer(SSL)プロトコルまたはリモート・ログイン・パスワード・ファイルを使用して認証されます。ソース・データベースにリモート・ログイン・パスワード・ファイルがある場合、マイニング・データベース・システムの適切なディレクトリにコピーします。パスワード・ファイルは、すべてのソース・データベースとマイニング・データベースで同じである必要があります。

- 各ソース・データベースで、REDOデータをダウンストリーム・マイニング・データベースに転送するために

LOG_ARCHIVE_DEST_n初期化パラメータを1つ構成します。リアルタイム・キャプチャ・モードを使用するか、アーカイブログのみキャプチャ・モードを使用するかに応じて、次の例のいずれかのようにこのパラメータの属性を設定します。- ソース・データベースがオンラインREDOログをダウンストリーム・データベースに送信する場合のダウンストリーム・マイニング・サーバーでのリアルタイム・キャプチャの例:

ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='SERVICE=DBMSCAP.EXAMPLE.COM ASYNC NOREGISTER VALID_FOR=(ONLINE_LOGFILES,PRIMARY_ROLE)DB_UNIQUE_NAME=dbmscap'

- ダウンストリーム・ログマイニング・サーバーでのアーカイブログのみキャプチャの例:

ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='SERVICE=DMBSCAP.EXAMPLE.COM ASYNC NOREGISTER VALID_FOR=(ONLINE_LOGFILES,PRIMARY_ROLE) TEMPLATE=/usr/oracle/log_for_dbms1/dbms1_arch_%t_%s_%r.log DB_UNIQUE_NAME=dbmscap'

ノート:

アーカイブ・ログのみのダウンストリーム・マイニング・データベースを使用する場合、TEMPLATE属性の値を指定する必要があります。ソース・データベースでTEMPLATE句を使用して、すべてのリモート・ソース・データベースのログ・ファイルが、ローカル・データベース・ログ・ファイルと分けて保管され、ログ・ファイル同士が分けて保管されるようにすることをお薦めします。 - ソース・データベースがオンラインREDOログをダウンストリーム・データベースに送信する場合のダウンストリーム・マイニング・サーバーでのリアルタイム・キャプチャの例:

- ソース・データベースで、次の例に示すように、ダウンストリーム・マイニング・データベースの宛先に相当する

LOG_ARCHIVE_DEST_nパラメータに対応するLOG_ARCHIVE_DEST_STATE_n初期化パラメータに値ENABLEを設定します。ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_2=ENABLE - ソース・データベースとダウンストリーム・マイニング・データベースで、次の例に示すように、ソース・データベースとダウンストリーム・データベースの

DB_UNIQUE_NAMEを含むようLOG_ARCHIVE_CONFIG初期化パラメータのDG_CONFIG属性を設定します。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='DG_CONFIG=(dbms1,dbmscap)'

オンラインREDOログを受信するためのダウンストリーム・マイニング・データベースの準備

ダウンストリーム・マイニング・データベースでは、アーカイブ・ログとオンラインREDOログの両方をソース・データベースから受け入れることができます。

トピック:

ダウンストリーム・マイニング・ユーザー・アカウントの作成

ダウンストリーム・マイニング構成を使用する場合、ダウンストリーム・データベースにExtractマイニング・ユーザーが必要です。マイニングExtractプロセスはこのユーザーの資格証明を使用して、ダウンストリーム・ログマイニング・サーバーと対話します。

ダウンストリーム・マイニング・ユーザーは、MININGUSERALIASオプションを使用したTRANLOGOPTIONSパラメータで指定します。

データベースのバージョンに正しい資格証明を割り当てるには、「ソース・データベースに接続するためのデータベース資格証明の追加」を参照してください。

ローカルREDOログ・ファイルをアーカイブするためのマイニング・データベースの構成

この手順では、REDOデータをオンラインREDOログにアーカイブするようダウンストリーム・マイニング・データベースを構成します。これらは、ダウンストリーム・マイニング・データベースで生成されるREDOログです。

Extractをリアルタイム統合キャプチャ・モードで実行する場合、ダウンストリーム・マイニング・データベースでアーカイブを有効にする必要がありますが、これはアーカイブ・ログのみキャプチャの場合も推奨されます。統合キャプチャ・モードのExtractはデータベースの状態情報を書き込みます。ダウンストリーム・マイニング・データベースでディスクの障害や破損があった場合、アーカイブと通常のバックアップによって、この状態情報をリカバリできます。

ローカルREDOログ・ファイルをアーカイブする手順:

- ダウンストリーム・マイニング・データベースをアーカイブ・ログ・モードに変更します。これを行うには、次を発行します

DDL.STARTUP MOUNT; ALTER DATABASE ARCHIVELOG; ALTER DATABASE OPEN;

- ダウンストリーム・マイニング・データベースで、次の例に示すように、1つ目のアーカイブ・ログの宛先を

LOG_ARCHIVE_DEST_n初期化パラメータに設定します。ALTER SYSTEM SET LOG_ARCHIVE_DEST_1='LOCATION=/home/arc_dest/local VALID_FOR=(ONLINE_LOGFILE,PRIMARY_ROLE)'

あるいは、次の例のようなコマンドを使用します。ALTER SYSTEM SET LOG_ARCHIVE_DEST_1='LOCATION='USE_DB_RECOVERY_FILE_DEST' valid_for=(ONLINE_LOGFILE,PRIMARY_ROLE)'

ノート:

ダウンストリーム・マイニング・データベースによって生成されるオンラインREDOログはリカバリ領域にアーカイブできます。ただし、外部アーカイブ・ログのステージングやスタンバイREDOログのアーカイブにダウンストリーム・マイニング・データベースのリカバリ領域は使用できません。高速リカバリ領域の構成の詳細は、Oracle Databaseバックアップおよびリカバリ・ユーザーズ・ガイドを参照してください。

- ローカル・アーカイブの宛先を有効にします。

ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_1=ENABLE

ダウンストリーム・マイニング・データベースのウォレットの構成

ソース・データベースおよびダウンストリーム・データベースでTDEが有効になっている場合は、ダウンストリーム・マイニング・データベースとソース・データベースでソース・ウォレットまたはキーが同じである必要があります。

次のステップに従って、ソース・データベースからダウンストリーム・マイニング・データベースにウォレット・ディレクトリをコピーします。

-

shutdown immediateコマンドを使用してダウンストリーム・データベースを停止します。

-

ダウンストリーム・データベースでwalletディレクトリを削除します:

rm $OGG_DS_HOME/wallet/* -

$OGG_DS_HOME/wallet/*をソース・データベース・ビューからダウンストリーム・データベース・ビューにコピーします。 -

ダウンストリーム・データベースを再起動します。

-

ソース・データベース・ビューおよびダウンストリーム・データベース・ビューでチェックサムを実行して、一致を確認します。

cksum $OGG_DS_HOME/wallet/*

リアルタイム・キャプチャ用のダウンストリーム・マイニング・データベースの準備

トピック:

スタンバイREDOログ・ファイルの作成

次のステップでは、スタンバイREDOログ・ファイルをダウンストリーム・マイニング・データベースに追加する手順を概説します。スタンバイREDOログの作成ルールを次に要約します。

-

各スタンバイREDOログ・ファイルのサイズは、少なくともREDOソース・データベースの最大REDOログ・ファイルと同程度である必要があります。管理を簡単にするために、ソース・データベースのすべてのREDOログ・ファイルとダウンストリーム・マイニング・データベースのスタンバイREDOログ・ファイルを同じサイズにすることをお薦めします。

-

スタンバイREDOログは、ソース・データベースのREDOスレッドごとにソース・データベースのREDOログより1つ以上多い数のREDOログ・グループを持つ必要があります。

スタンバイREDOログ・ファイルの追加に必要な特定のステップやSQL文は、環境によって異なります。スタンバイREDOログ・ファイルをデータベースに追加する手順の詳細は、『Oracle Data Guard概要および管理』を参照してください。

ノート:

1つのダウンストリーム・マイニング・データベースにREDOを送信するソース・データベースが複数ある場合、それらのソースのうち1つのみがマイニング・データベースのスタンバイREDOログにREDOを送信できます。このソース・データベースからのREDOをマイニングするExtractプロセスはリアルタイム・モードで実行できます。他のソース・データベースはすべてアーカイブ・ログのみをダウンストリーム・マイニング・データベースに送信し、このデータを読み取るExtractはアーカイブ・ログのみモードで実行されるよう構成される必要があります。スタンバイREDOログ・ファイルを作成する手順:

-

SQL*Plusで、ソース・データベースに管理ユーザーとして接続します。

-

ソース・ログ・ファイルのサイズを確認します。結果をノートにとっておきます。

SELECT BYTES FROM V$LOG; -

ソース・データベースに構成されているオンライン・ログ・ファイル・グループの数を確認します。結果をノートにとっておきます。

SELECT COUNT(GROUP#) FROM V$LOG; -

管理ユーザーとしてダウンストリーム・マイニング・データベースに接続します。

-

スタンバイ・ログ・ファイル・グループをマイニング・データベースに追加します。スタンバイ・ログ・ファイルのサイズは、ソース・ログ・ファイルのサイズ以上である必要があります。スタンバイ・ログ・ファイル・グループの数は、ソース・オンライン・ログ・ファイル・グループの数より1つ以上多い数である必要があります。これは、RACインストールの各インスタンス(スレッド)に適用されます。ソース・データベースに"n"個のスレッドがあり、それぞれ"m"個のREDOログ・グループがある場合、n*(m+1)個のREDOログ・グループをダウンストリーム・マイニング・データベースで構成する必要があります。

次の例は、3つのスタンバイ・ログ・グループを示しています。

ALTER DATABASE ADD STANDBY LOGFILE GROUP 3 ('/oracle/dbs/slog3a.rdo', '/oracle/dbs/slog3b.rdo') SIZE 500M; ALTER DATABASE ADD STANDBY LOGFILE GROUP 4 ('/oracle/dbs/slog4.rdo', '/oracle/dbs/slog4b.rdo') SIZE 500M; ALTER DATABASE ADD STANDBY LOGFILE GROUP 5 ('/oracle/dbs/slog5.rdo', '/oracle/dbs/slog5b.rdo') SIZE 500M; -

スタンバイ・ログ・ファイル・グループが正常に追加されたことを確認します。

SELECT GROUP#, THREAD#, SEQUENCE#, ARCHIVED, STATUS FROM V$STANDBY_LOG;

結果は次のようになります。

GROUP# THREAD# SEQUENCE# ARC STATUS ---------- ---------- ---------- --- ---------- 3 0 0 YES UNASSIGNED 4 0 0 YES UNASSIGNED 5 0 0 YES UNASSIGNED

-

ソース・データベースのログ・ファイルが、次で指定した場所にあることを確認します

属性(ローカルのLOCATION

設定)。ディレクトリ内のファイルを確認するには、ソース・データベースのログ・ファイルを切り替える必要がある場合があります。LOG_ARCHIVE_DEST_n

スタンバイREDOログ・ファイルをローカルにアーカイブするためのデータベースの構成

この手順では、ソース・データベースのオンラインREDOログからREDOデータを受信するスタンバイREDOログをアーカイブするようダウンストリーム・マイニング・データベースを構成します。外部アーカイブ・ログは、ダウンストリーム・マイニング・データベースのリカバリ領域にアーカイブできないことに注意してください。

スタンバイREDOログをローカルでアーカイブする手順:

- ダウンストリーム・マイニング・データベースで、次の例に示すように、2つ目のアーカイブ・ログの宛先を

LOG_ARCHIVE_DEST_n初期化パラメータに設定します。ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='LOCATION=/home/arc_dest/srl_dbms1 VALID_FOR=(STANDBY_LOGFILE,PRIMARY_ROLE)'外部アーカイブ・ログ(リモート・ソース・データベースからのログ)はローカル・マイニング・データベース・ログ・ファイルと分けて保管し、ログ・ファイル同士も分けて保管することをお薦めします。外部アーカイブ・ログのステージングにダウンストリーム・マイニング・データベースのリカバリ領域を使用することはできません。

- 前のステップで設定した

LOG_ARCHIVE_DEST_2パラメータを次の例に示すように有効にします。ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_2=ENABLE

ダウンストリームExtractがADGと連携できるようにする

カスケードされたダウンストリーム取得環境では、ダウンストリーム・データベースはソース・データベースに直接接続しません。Active Data Guard (ADG)を参照として使用します。

Extractは、ソースレス・オプションを使用して起動する必要があります。そうすることで、非ネイティブのデータ型をフェッチする必要があるときには、ソース・データベースに接続するかわりに、FETCHUSERIDまたはFETCHUSERIDALIASを使用してADGに接続するようにします。たとえば、このインスタンスは読取り専用モードで開かれているため、FETCH操作はADGデータベースで処理されます。ADGインスタンスで処理できないその他の操作(ディクショナリ・ビルドの作成など)は、ADGからソース・データベースにリダイレクトされます。

-

SCHEMATRANDATA -

TRANDATA -

FLUSH SEQUENCE -

TRACETABLE -

HEARTBEATTABLE -

REGISTER EXTRACT

ノート:

SCHEMATRANDATAおよびTRANDATAは、コマンドがスタンバイREDOログで実行された場合でも、実際のDML操作が実行されるプライマリ・データベースで実際のログ・グループが作成および管理されます。

EXTRACT EXTDSC

NOUSERID

TRANLOGOPTIONS MININGUSERALIAS cgg_cdbDSC_src DOMAIN OracleGoldenGate

TRANLOGOPTIONS INTEGRATEDPARAMS (DOWNSTREAM_REAL_TIME_MINE Y) FETCHUSERIDALIAS cgg_cdbADG_src DOMAIN OracleGoldenGate

EXTTRAIL cascade/ea

SOURCECATALOG CDBNORTH_PDB01

DDL INCLUDE MAPPED

TABLE HR.*;次に、ダウンストリーム統合ExtractがADGスタンバイと連携できるようにするステップを示します。

-

次の例に示すように、ADGスタンバイに

LOG_ARCHIVE_DESTINATION_N (LAD)を追加します。ALTER SYSTEM SET LOG_ARCHIVE_DEST_3='service=mining_db_service_name ASYNC NOREGISTER VALID_FOR(STANDBY_LOGFILES,STANDBY_ROLES) DB_UNIQUE_NAME=3rd_db_unique_name' scope=bothこのステップにより、ADGスタンバイの

standby_logfilesが転送および生成されます。 -

次の例に示すように、ログをマイニング・データベースに送るようにADGスタンバイの

LOG_ARCHIVE_CONFIGを設定します。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='dg_config' scope=both;db_configは、1番目、2番目および3番目のデータベースの一意の名前です。 -

マイニング・データベースで、受信する

standby_logfilesをマイニング・データベースに格納する場所を設定します。ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='location= DB_RECOVERY_FILE_DEST VALID_FOR=(STANDBY_LOGFILE,ALL_ROLES)' scope=both場所は、データベース・リカバリ・ファイルの宛先です。

-

次の例に示すように、マイニング・データベースで

LOG_ARCHIVE_CONFIGを実行して、Extractプロセスがマイニング・データベースでそれらを読み取れるようにします。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='dg_config' scope=bothここで、db_configは、1番目、2番目および3番目のデータベースの一意の名前です。

-

ダウンストリームExtractの場合、データベース接続が適切に構成されるようにする必要があります。Extractを登録するときは、ADGスタンバイに対して

DBLOGIN接続が確立され、読取り専用アクティビティ用に開いていることを確認します。 -

Extractを追加して登録するには、次のコマンドを使用します。

DBLOGIN USERID ggadmin@cdbADG_src, PASSWORD ggadmin MININGDBLOGIN USERID ggadmin@cgg_cdbDSC, password ggadmincdbADG_srcは、プライマリではないADGです。cgg_cdbDSCはマイニング・データベースです。 - 次に、

NOUSERIDパラメータを使用するExtractを登録します。ADD EXTRACT exte, INTEGRATED TRANLOG, BEGIN NOW REGISTER EXTRACT exte DATABASE - Extractの登録後、このExtractを使用してデータをマイニングし、正常にExtractを開始できます。

ダウンストリーム・マイニング構成のユースケース

様々なダウンストリーム・マイニング構成のユースケースについてお読みください。

トピック:

ケース1: リアルタイム・モードでの1つのソース・データベースからのキャプチャ

この例では、ダウンストリーム・マイニング・データベースDBMSCAPにExtractをデプロイして、ソース・データベースDBMS1から変更をキャプチャします。

例では、必要なスタンバイREDOログ・ファイルをダウンストリーム・デプロイ用のExtractの構成に記載されているように作成してあるものとします。

次のユーザーが存在するものとします。

- DBMS1にユーザー

GGADM1。Extractはこの資格証明を使用して、DBMS1からデータとメタデータをフェッチします。このユーザーはOracle GoldenGate資格証明ストアにggadm1のエイリアスを持っており、ggadm1@dbms1としてログインします。DBMS_GOLDENGATE_AUTH.GRANT_ADMIN_PRIVILEGE()プロシージャをコールして、ソース・データベースで適切な権限がこのユーザーに付与されているものとします。 DBMSCAPにユーザーGGADMCAP。Extractはこの資格証明を使用して、論理変更レコードをダウンストリーム・マイニング・データベースDBMSCAPのログマイニング・サーバーから取得します。このユーザーはOracle GoldenGate資格証明ストアにggadmcapのエイリアスを持っており、ggadmcap@dbmscapとしてログインします。DBMS_GOLDENGATE_AUTH.GRANT_ADMIN_PRIVILEGE()プロシージャをコールして、マイニング・データベースで適切な権限がこのユーザーに付与されているものとします。

トピック:

ローカルREDOをアーカイブするためのマイニング・データベースの準備

ローカルREDOをアーカイブするためにマイニング・データベースを準備する手順:

- ダウンストリーム・マイニング・データベースはアーカイブ・ログ・モードである必要があります。これは、次のDDLコマンドを発行して行います。

STARTUP MOUNT; ALTER DATABASE ARCHIVELOG; ALTER DATABASE OPEN; - ダウンストリーム・マイニング・データベースで

log_archive_dest_1をアーカイブ・ローカルREDOに設定します。ALTER SYSTEM SET LOG_ARCHIVE_DEST_1='LOCATION=/home/arc_dest/local VALID_FOR=(ONLINE_LOGFILE, PRIMARY_ROLE)' log_archive_dest_1を有効にします。ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_1=ENABLE

ソース・データベースから受信したREDOをスタンバイREDOログにアーカイブするためのマイニング・データベースの準備

ソース・データベースから受信したREDOをスタンバイREDOログにアーカイブするためにマイニング・データベースを準備する手順:

- ダウンストリーム・マイニング・データベースで、次の例に示すようにlog_archive_dest_2を設定します。

ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='LOCATION=/home/arc_dest/srl_dbms1 VALID_FOR=(STANDBY_LOGFILE,PRIMARY_ROLE)' - 次の例に示すようにlog_archive_dest_2を有効にします。

ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_2=ENABLE - ダウンストリーム・マイニング・データベースで

DG_CONFIGを設定します。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='DG_CONFIG=(dbms1,dbmscap)'

REDOをマイニング・データベースに送信するためのソース・データベースの準備

REDOをマイニング・データベースに送信するためのソース・データベースを準備する手順::

- ソース・データベースが、必要とされる互換性で稼働していることを確認します。

統合キャプチャに必要な最低限の互換性設定は、11.1.0.0.0です。select name, value from v$parameter where name = 'compatible'; - ソース・データベースで

DG_CONFIGを設定します。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='DG_CONFIG=(dbms1,dbmscap)'; - ソース・データベースでREDO転送を設定します。

ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='SERVICE=DBMSCAP.EXAMPLE.COM ASYNC OPTIONAL NOREGISTER VALID_FOR=(ONLINE_LOGFILES,PRIMARY_ROLE)DB_UNIQUE_NAME=dbmscap'; - ダウンストリームの宛先を有効にします。

ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_2=ENABLE;

DBMSCAPでのExtract (ext1)の設定

DBMSCAPにExtract (ext1)を設定するには:

- Extractをダウンストリーム・マイニング・データベースに登録します。資格証明ストアでは、

ggadm1のエイリアス名はggadm1@dbms1のユーザー接続文字列にリンクされています。ggadmcapのエイリアス名はggadmcap@dbmscapのユーザー接続文字列にリンクされています。DBLOGIN USERIDALIAS ggadm1MININGDBLOGIN USERIDALIAS ggadmcapREGISTER EXTRACT ext1 DATABASE - Extractをダウンストリーム・マイニング・データベースで作成します。

ADD EXTRACT ext1 INTEGRATED TRANLOG BEGIN NOW - Extractパラメータ・ファイル

ext1.prmを編集します。リアルタイム・キャプチャを使用するには、次の行が必要です。資格証明ストアでは、ggadm1のエイリアス名はggadm1@dbms1のユーザー接続文字列にリンクされています。ggadmcapのエイリアス名はggadmcap@dbmscapのユーザー接続文字列にリンクされています。USERIDALIAS ggadm1 TRANLOGOPTIONS MININGUSERALIAS ggadmcap TRANLOGOPTIONS INTEGRATEDPARAMS (downstream_real_time_mine Y) - Extractを起動します。

START EXTRACT ext1

ノート:

同一のソース・データベースからデータをキャプチャする(前述の例でデータベースDBMS1の変更をキャプチャするなど)かぎり、ダウンストリーム・マイニング・データベースにリアルタイムExtractモードで実行するExtractを複数作成できます。ケース2: アーカイブログのみモードでの複数のソースからのキャプチャ

次の例では、ダウンストリーム・マイニング・データベースDBMSCAPにExtractをデプロイして、データベースDBMS1およびDBMS2から変更をキャプチャします。

次のユーザーが存在するものとします。

-

DBMS1にユーザーGGADM1。Extractはこの資格証明を使用して、DBMS1からデータとメタデータをフェッチします。DBMS_GOLDENGATE_AUTH.GRANT_ADMIN_PRIVILEGE()プロシージャをコールして、DBMS1で適切な権限がこのユーザーに付与されているものとします。 -

DBMS2にユーザーGGADM2。Extractはこの資格証明を使用して、DBMS2からデータとメタデータをフェッチします。DBMS_GOLDENGATE_AUTH.GRANT_ADMIN_PRIVILEGE()プロシージャをコールして、DBMS2で適切な権限がこのユーザーに付与されているものとします。 -

DBMSCAPにユーザーGGADMCAP。Extractはこの資格証明を使用して、論理変更レコードをダウンストリーム・マイニング・データベースのログマイニング・サーバーから取得します。DBMS_GOLDENGATE_AUTH.GRANT_ADMIN_PRIVILEGE()プロシージャをコールして、ダウンストリーム・マイニング・データベースDBMSCAPで適切な権限がこのユーザーに付与されているものとします。

この手順では、ダウンストリーム・マイニング・データベースがアーカイブ・ログ・モードで構成されていることも前提とします。

トピック:

ローカルREDOをアーカイブするためのマイニング・データベースの準備

ローカルREDOをアーカイブするためにマイニング・データベースを準備する手順:

- ダウンストリーム・マイニング・データベースはアーカイブ・ログ・モードである必要があります。これは、次のDDLコマンドを発行して行います。

STARTUP MOUNT; ALTER DATABASE ARCHIVELOG; ALTER DATABASE OPEN; - ダウンストリーム・マイニング・データベースで

log_archive_dest_1をアーカイブ・ローカルREDOに設定します。ALTER SYSTEM SET LOG_ARCHIVE_DEST_1='LOCATION=/home/arc_dest/local VALID_FOR=(ONLINE_LOGFILE, PRIMARY_ROLE)' log_archive_dest_1を有効にします。ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_1=ENABLE- Extractを起動します。

START EXTRACT ext1

ノート:

同一のソース・データベースからデータをキャプチャする(前述の例でデータベースDBMS1の変更をキャプチャするなど)かぎり、ダウンストリーム・マイニング・データベースにリアルタイムExtractモードで実行するExtractを複数作成できます。ソース・データベースからのREDOをアーカイブするためのマイニング・データベースの準備

ダウンストリーム・マイニング・データベースでDG_CONFIG

ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='DG_CONFIG=(dbms1,dbms2, dbmscap)'トピック:

REDOをマイニング・データベースに送信するための最初のソース・データベースの準備

REDOをマイニング・データベースに送信するための最初のソース・データベースを準備する手順:

- DBMS1ソース・データベースが、必要とされる互換性で稼働していることを確認します。

キャプチャに必要な最低限の互換性設定は、11.1.0.0.0です。select name, value from v$parameter where name = 'compatible'; NAME VALUE --------- --------------------- compatible 11.1.0.0.0 - DBMS1ソース・データベースで

DG_CONFIGを設定します。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='DG_CONFIG=(dbms1, dbmscap)'; - DBMS1ソース・データベースでREDO転送を設定します。REDOデータをダウンストリーム・マイニング・データベースの外部アーカイブ・ログに直接送信する場合、

TEMPLATE句は必須です。ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='SERVICE=DBMSCAP.EXAMPLE.COM ASYNC OPTIONAL NOREGISTER TEMPLATE='/usr/orcl/arc_dest/dbms1/dbms1_arch_%t_%s_%r.log VALID_FOR=(ONLINE_LOGFILES,PRIMARY_ROLE)DB_UNIQUE_NAME=dbmscap'; - ダウンストリームの宛先を有効にします。

ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_2=ENABLE;

ノート:

同一のソース・データベースからデータをキャプチャする(前述の例でデータベースDBMS1の変更をキャプチャするなど)かぎり、ダウンストリーム・マイニング・データベースにリアルタイムExtractモードで実行するExtractを複数作成できます。REDOをマイニング・データベースに送信するための2番目のソース・データベースの準備

REDOをマイニング・データベースに送信するための2番目のソース・データベースを準備する手順:

- DBMS2ソース・データベースが、必要とされる互換性で稼働していることを確認します。

キャプチャに必要な最低限の互換性設定は、11.1.0.0.0です。select name, value from v$parameter where name = 'compatible'; NAME VALUE --------- --------------------- compatible 11.1.0.0.0 - DBMS2ソース・データベースで

DG_CONFIGを設定します。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='DG_CONFIG=(dbms2, dbmscap)'; - DBMS2ソース・データベースでREDO転送を設定します。REDOデータをダウンストリーム・マイニング・データベースの外部アーカイブ・ログに直接送信する場合、

TEMPLATE句は必須です。ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='SERVICE=DBMSCAP.EXAMPLE.COM ASYNC OPTIONAL NOREGISTER TEMPLATE='/usr/orcl/arc_dest/dbms2/dbms2_arch_%t_%s_%r.log VALID_FOR=(ONLINE_LOGFILES,PRIMARY_ROLE)DB_UNIQUE_NAME=dbmscap'; - ダウンストリームの宛先を有効にします。

ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_2=ENABLE;

ノート:

同一のソース・データベースからデータをキャプチャする(前述の例でデータベースDBMS1の変更をキャプチャするなど)かぎり、ダウンストリーム・マイニング・データベースにリアルタイムExtractモードで実行するExtractを複数作成できます。ケース3: リアルタイム・モードとアーカイブログのみモードが混在する複数ソースからのキャプチャ

次の例では、ダウンストリーム・マイニング・データベースDBMSCAPにExtractをデプロイして、データベースDBMS1、DBMS2およびDBMS3から変更をキャプチャします。

ノート:

この例では、必要なスタンバイREDOログ・ファイルをオンラインREDOログを受信するためのダウンストリーム・マイニング・データベースの準備に記載されているように作成してあるものとします。次のユーザーが存在するものとします。

-

DBMS1にユーザーGGADM1。Extractはこの資格証明を使用して、DBMS1からデータとメタデータをフェッチします。DBMS_GOLDENGATE_AUTH.GRANT_ADMIN_PRIVILEGE()プロシージャをコールして、DBMS1で適切な権限がこのユーザーに付与されているものとします。 -

DBMS2にユーザーGGADM2。Extractはこの資格証明を使用して、DBMS2からデータとメタデータをフェッチします。DBMS_GOLDENGATE_AUTH.GRANT_ADMIN_PRIVILEGE()プロシージャをコールして、DBMS2で適切な権限がこのユーザーに付与されているものとします。 DBMS3にユーザーGGADM3。Extractはこの資格証明を使用して、DBMS3からデータとメタデータをフェッチします。DBMS_GOLDENGATE_AUTH.GRANT_ADMIN_PRIVILEGE()プロシージャをコールして、DBMS3で適切な権限がこのユーザーに付与されているものとします。-

DBMSCAPにユーザーGGADMCAP。Extractはこの資格証明を使用して、論理変更レコードをダウンストリーム・マイニング・データベースのログマイニング・サーバーから取得します。DBMS_GOLDENGATE_AUTH.GRANT_ADMIN_PRIVILEGE()プロシージャをコールして、ダウンストリーム・マイニング・データベースDBMSCAPで適切な権限がこのユーザーに付与されているものとします。

この手順では、ダウンストリーム・マイニング・データベースがアーカイブ・ログ・モードで構成されていることも前提とします。

この例では、DBMS3によって送信されるREDOはリアルタイム・モードでマイニングされ、DBMS1およびDBMS2から送信されるREDOデータはアーカイブログのみモードでマイニングされます。

トピック:

ローカルREDOをアーカイブするためのマイニング・データベースの準備

ローカルREDOをアーカイブするためにマイニング・データベースを準備する手順:

- ダウンストリーム・マイニング・データベースはアーカイブ・ログ・モードである必要があります。これは、次のDDLコマンドを発行して行います。

STARTUP MOUNT; ALTER DATABASE ARCHIVELOG; ALTER DATABASE OPEN; - ダウンストリーム・マイニング・データベースで

log_archive_dest_1をアーカイブ・ローカルREDOに設定します。ALTER SYSTEM SET LOG_ARCHIVE_DEST_1='LOCATION=/home/arc_dest/local VALID_FOR=(ONLINE_LOGFILE, PRIMARY_ROLE)' log_archive_dest_1を有効にします。ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_1=ENABLE

ソース・データベースからREDOを受け入れるためのマイニング・データベースの準備

REDOデータは、ダウンストリーム・マイニング・データベースのスタンバイREDOログに受け入れられるため、正しいサイズに設定されたスタンバイREDOログが適切な数存在する必要があります。スタンバイ・ログを構成していない場合は、「スタンバイREDOログ・ファイルの作成」を参照してください。

- ダウンストリーム・マイニング・データベースで、次の例に示すように、2つ目のアーカイブ・ログの宛先を

LOG_ARCHIVE_DEST_n初期化パラメータに設定します。これは、アーカイブ・スタンバイREDOログを処理するために必要です。ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='LOCATION=/home/arc_dest/srl_dbms3 VALID_FOR=(STANDBY_LOGFILE,PRIMARY_ROLE)' - 次の例に示すように、

LOG_ARCHIVE_DEST_2パラメータに対応するLOG_ARCHIVE_DEST_STATE_2初期化パラメータを有効にします。ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_2=ENABLE - ダウンストリーム・マイニング・データベースですべてのソース・データベースからREDOデータを受け入れるよう

DG_CONFIGを設定します。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='DG_CONFIG=(dbms1, dbms2, dbms3, dbmscap)'

REDOをマイニング・データベースに送信するための最初のソース・データベースの準備

REDOをマイニング・データベースに送信するための最初のソース・データベースを準備する手順:

- DBMS1ソース・データベースが、必要とされる互換性で稼働していることを確認します。

select name, value from v$parameter where name = 'compatible'; DG_CONFIGをDBMS1ソース・データベースで設定します。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='DG_CONFIG=(dbms1, dbmscap)';DBMS1ソース・データベースでREDO転送を設定します。REDOデータをダウンストリーム・マイニング・データベースの外部アーカイブ・ログに直接送信する場合、TEMPLATE句は必須です。ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='SERVICE=DBMSCAP.EXAMPLE.COM ASYNC OPTIONAL NOREGISTER TEMPLATE='/usr/orcl/arc_dest/dbms1/dbms1_arch_%t_%s_%r.log VALID_FOR=(ONLINE_LOGFILES,PRIMARY_ROLE)DB_UNIQUE_NAME=dbmscap';- ダウンストリームの宛先を有効にします。

ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_2=ENABLE;

REDOをマイニング・データベースに送信するための2番目のソース・データベースの準備

REDOをマイニング・データベースに送信するための2番目のソース・データベースを準備する手順::

- DBMS2ソース・データベースが、必要とされる互換性で稼働していることを確認します。

select name, value from v$parameter where name = 'compatible'; - DBMS2ソース・データベースで

DG_CONFIGを設定します。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='DG_CONFIG=(dbms2, dbmscap)'; DBMS2ソース・データベースでREDO転送を設定します。REDOデータをダウンストリーム・マイニング・データベースの外部アーカイブ・ログに直接送信する場合、TEMPLATE句は必須です。ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='SERVICE=DBMSCAP.EXAMPLE.COM ASYNC OPTIONAL NOREGISTER TEMPLATE='/usr/orcl/arc_dest/dbms2/dbms2_arch_%t_%s_%r.log VALID_FOR=(ONLINE_LOGFILES,PRIMARY_ROLE)DB_UNIQUE_NAME=dbmscap';- ダウンストリームの宛先を有効にします。

ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_2=ENABLE;

REDOをマイニング・データベースに送信するための2番目のソース・データベースの準備

REDOをマイニング・データベースに送信するための2番目のソース・データベースを準備する手順::

- DBMS2ソース・データベースが、必要とされる互換性で稼働していることを確認します。

select name, value from v$parameter where name = 'compatible'; - DBMS2ソース・データベースで

DG_CONFIGを設定します。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='DG_CONFIG=(dbms2, dbmscap)'; DBMS2ソース・データベースでREDO転送を設定します。REDOデータをダウンストリーム・マイニング・データベースの外部アーカイブ・ログに直接送信する場合、TEMPLATE句は必須です。ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='SERVICE=DBMSCAP.EXAMPLE.COM ASYNC OPTIONAL NOREGISTER TEMPLATE='/usr/orcl/arc_dest/dbms2/dbms2_arch_%t_%s_%r.log VALID_FOR=(ONLINE_LOGFILES,PRIMARY_ROLE)DB_UNIQUE_NAME=dbmscap';- ダウンストリームの宛先を有効にします。

ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_2=ENABLE;

REDOをマイニング・データベースに送信するための3番目のソース・データベースの準備

REDOをマイニング・データベースに送信するための3番目のソース・データベースを準備する手順:

- DBMS3ソース・データベースが、必要とされる互換性で稼働していることを確認します。

select name, value from v$parameter where name = 'compatible'; NAME VALUE --------- --------------------- compatible 11.1.0.0.0キャプチャに必要な最低限の互換性設定は、11.1.0.0.0です。

- DBMS3ソース・データベースで

DG_CONFIGを設定します。ALTER SYSTEM SET LOG_ARCHIVE_CONFIG='DG_CONFIG=(dbms3, dbmscap)'; - DBMS3ソース・データベースでREDO転送を設定します。DBMS3はオンラインREDOログをダウンストリーム・マイニング・データベースのスタンバイREDOログに送信するソースであるため、

TEMPLATE句は指定しないでください。ALTER SYSTEM SET LOG_ARCHIVE_DEST_2='SERVICE=DBMSCAP.EXAMPLE.COM ASYNC OPTIONAL NOREGISTER VALID_FOR=(ONLINE_LOGFILES,PRIMARY_ROLE)DB_UNIQUE_NAME=dbmscap'; - ダウンストリームの宛先を有効にします。

ALTER SYSTEM SET LOG_ARCHIVE_DEST_STATE_2=ENABLE;

トピック:

ダウンストリーム・マイニング・データベースでのExtractの設定

このステップでは、DBMS1およびDBMS2によって送信されたアーカイブ・ログからキャプチャするようダウンストリーム・データベースでExtractを設定します。

トピック:

DBMS1によって送信されたアーカイブ・ログから変更をキャプチャするためのExtract (ext1)の設定

DBMSCAPダウンストリーム・マイニング・データベースで次のステップを実行します。

- DBMS1ソース・データベース用に

DBMSCAPにExtractを登録します。資格証明ストアでは、ggadm1のエイリアス名はggadm1@dbms1のユーザー接続文字列にリンクされています。ggadmcapのエイリアス名はggadmcap@dbmscapのユーザー接続文字列にリンクされています。DBLOGIN USERIDALIAS ggadm1 MININGDBLOGIN USERIDALIAS ggadmcap REGISTER EXTRACT ext1 DATABASE - Extractをマイニング・データベース

DBMSCAPで追加します。ADD EXTRACT ext1 INTEGRATED TRANLOG BEGIN NOW - Extractパラメータ・ファイル

ext1.prmを編集します。資格証明ストアでは、ggadm1のエイリアス名はggadm1@dbms1のユーザー接続文字列にリンクされています。ggadmcapの別名はggadmcap@dbmscapのユーザー接続文字列にリンクされています。USERIDALIAS ggadm1 TRANLOGOPTIONS MININGUSERALIAS ggadmcap TRANLOGOPTIONS INTEGRATEDPARAMS (downstream_real_time_mine N) - Extractを起動します:

START EXTRACT ext1

DBMS2によって送信されたアーカイブ・ログから変更をキャプチャするためのExtract (ext2)の設定

DBMSCAPダウンストリーム・マイニング・データベースで次のステップを実行します。

- ソース・データベースDBMS2用にマイニング・データベースにExtractを登録します。資格証明ストアでは、

ggadm2のエイリアス名はggadm2@dbms2のユーザー接続文字列にリンクされています。ggadmcapのエイリアス名はggadmcap@dbmscapのユーザー接続文字列にリンクされています。DBLOGIN USERIDALIAS ggadm2 MININGDBLOGIN USERIDALIAS ggadmcap REGISTER EXTRACT ext2 DATABASE - Extractをマイニング・データベースで作成します。

ADD EXTRACT ext2 INTEGRATED TRANLOG, BEGIN NOW - Extractパラメータ・ファイル

ext2.prmを編集します。資格証明ストアでは、ggadm2の別名はggadm2@dbms2のユーザー接続文字列にリンクされています。ggadmcapの別名はggadmcap@dbmscapのユーザー接続文字列にリンクされています。USERIDALIAS ggadm2 TRANLOGOPTIONS MININGUSERALIAS ggadmcap TRANLOGOPTIONS INTEGRATEDPARAMS (downstream_real_time_mine N) - Extractを起動します:

START EXTRACT ext2

DBMS3によって送信されたオンライン・ログからリアルタイム・モードで変更をキャプチャするためのExtract (ext3)の設定

DBMSCAPダウンストリーム・マイニング・データベースで次のステップを実行します。

- ソース・データベースDBMS3用にマイニング・データベースにExtractを登録します。資格証明ストアでは、

ggadm3のエイリアス名はggadm3@dbms3のユーザー接続文字列にリンクされています。ggadmcapのエイリアス名はggadmcap@dbmscapのユーザー接続文字列にリンクされています。DBLOGIN USERID ggadm3 MININGDBLOGIN USERID ggadmcap REGISTER EXTRACT ext3 DATABASE

- Extractをマイニング・データベースで作成します。

ADD EXTRACT ext3 INTEGRATED TRANLOG, BEGIN NOW - Extractパラメータ・ファイル

ext3.prmを編集します。資格証明ストアでは、ggadm3の別名はggadm3@dbms3のユーザー接続文字列にリンクされています。ggadmcapの別名はggadmcap@dbmscapのユーザー接続文字列にリンクされています。USERIDALIAS ggadm3 TRANLOGOPTIONS MININGUSERALIAS ggadmcap TRANLOGOPTIONS INTEGRATEDPARAMS (downstream_real_time_mine N) - Extractを起動します:

START EXTRACT ext3

ノート:

同一のソース・データベースからデータをキャプチャする(前述の例でデータベースDBMS3の変更をキャプチャするなど)かぎり、リアルタイム統合キャプチャ・モードで実行されるExtractをダウンストリーム・マイニング・データベースに複数作成できます。